谷歌DeepMind全新ToT基準:全面評估LLM時間推理能力

大語言模型的時間推理能力怎么樣?

我們先來看一道幼兒園的題目:

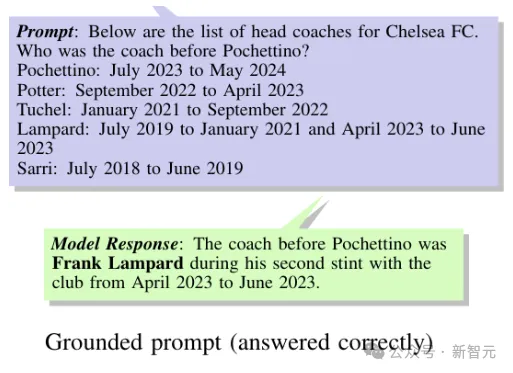

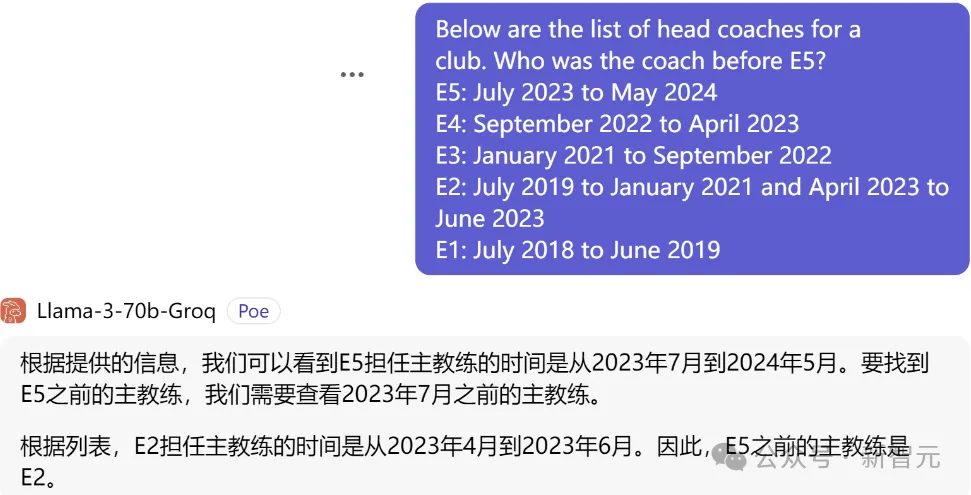

給出切爾西歷年的主教練名單,向模型提問:Pochettino之前的教練是誰?

此時,LLM能夠給出正確的回答(Lampard),——貌似有點實力?

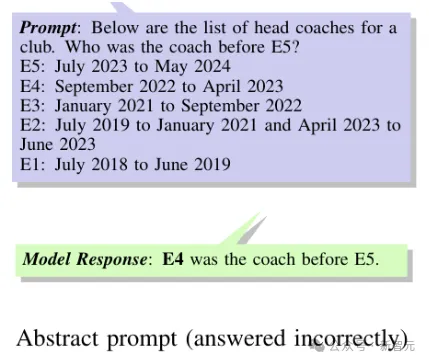

但是,如果我們把人名來個變量代換(E1~E5),其他內容保持不變,LLM瞬間就降智了:

事實上,在第一次的題干里,我們并沒有說明Lampard教練叫什么名字,而答案里直接就出現了Frank。

所以LLM有可能只是碰到了原題?

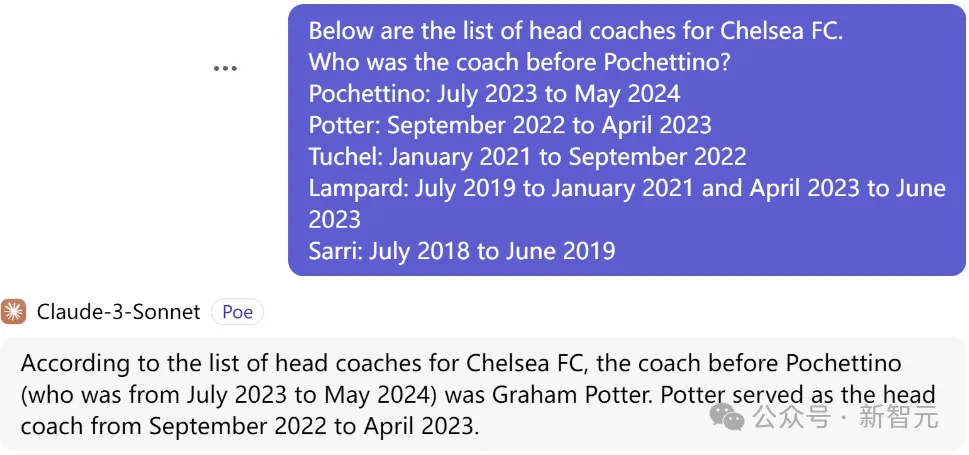

于是小編用這兩道題分別測試了Gemini 1.0 pro、Claude 3 Sonnet、Llama 3和ChatGPT。

從結果來看,上面被公開處刑的應該是ChatGPT。

而Gemini 1.0 pro和Claude 3 Sonnet甚至還不如ChatGPT,兩題全錯(雖然也給出了全名),估計是刷題的時候懈怠了。

相比之下,Llama 3的回答則呈現出智力上的優越:

在如此簡單的問題上,不同的LLM卻「各顯神通」,看來是時候搞個權威的考核指導一下了。

近日,來自谷歌DeepMind的研究人員,推出了專門用于評估大語言模型時間推理能力的基準測試——Test of Time(ToT)。

論文地址:https://arxiv.org/pdf/2406.09170

值得注意的是,ToT是基準測試的名字,不是顏文字表情

ToT由兩門考試組成:

第一關:ToT-semantic,考驗LLM在進行時間推理時,對于語義和邏輯的理解。

第二關:ToT-arithmetic,考驗LLM進行時間相關算術的能力。

ToT-semantic中的問題是合成的,保證LLM在考試中不會遇見原題;

而ToT-arithmetic采取眾包的形式,保證了問題的深度和廣度。

基準測試和數據集:https://huggingface.co/datasets/baharef/ToT

ToT的數據集分為三個子集:ToT-semantic包含1850個示例,ToT-arithmetic包含2800個示例,另外還有一個ToT-semantic-large,包含46480個示例,能夠在更大的尺度上衡量時間理解的語義和邏輯。

ToT的使用方法很簡單,先安裝Huggingface數據集,然后兩行代碼導入即可:

from datasets import load_dataset

dataset = load_dataset("baharef/ToT")

數據格式

ToT-semantic和ToT-semantic-large數據集包含以下字段:

- question:包含問題的文本。

- graph_gen_algorithm:圖生成器算法的名稱。

- question_type:對應于數據集中的7種問題類型之一。

- sorting_type:對應用于事實的排序類型。

- prompt:包含用于評估LLM任務的完整提示文本。

- label: 問題的標準答案。

而ToT-arithmetic數據集包含question、question_type和label三個字段。

Test of Time

LLM的時間推理最近獲得了極大的關注,許多研究集中在增強LLM對時間概念的理解上,通過預訓練和微調策略來提高他們的時間推理能力。

而相應的基準測試則大多以知識圖譜為中心:比如TempTabQA提供了基于維基百科信息框的眾包問題,而TGQA是一個源自YAGO11k知識圖譜的數據集。

為防止數據泄露,TGQA將每個實體名稱更改為GPT3.5生成的名稱,保證名稱與實體類型一致,并且不會以其他方式出現在YAGO11k中。

但這種策略有兩個問題:首先是會引入虛假的實體名稱相關性,其次可能會產生事實不正確或違反常識的聲明。

于是,本文選擇了合成數據的方式來建立LLM的評估基準。

同時,研究人員將時間推理能力拆分成兩個不同的維度:理解時間的語義和邏輯,以及執行準確的時間算術。

兩個維度分別建立任務,獨立進行評估,能夠更好地展現LLM的優勢和劣勢。

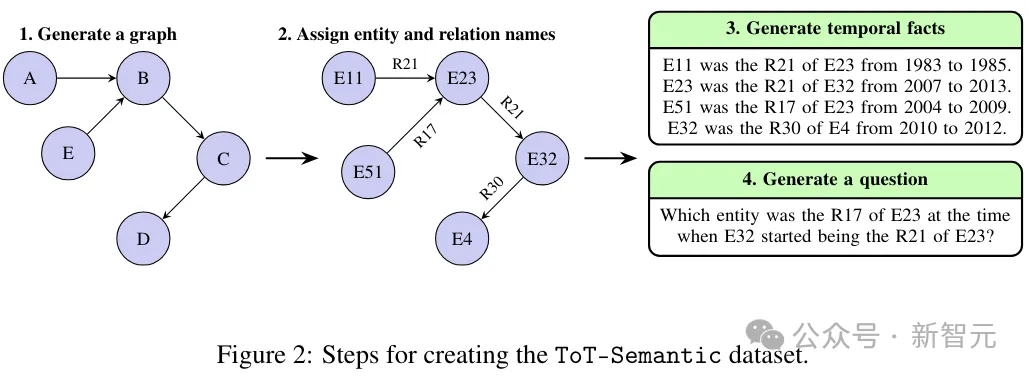

ToT-semantic

ToT-semantic能夠分離和分析一個LLM的核心推理能力,同時避免依賴預先存在的知識。

ToT-semantic的創建過程如下圖所示:

第 1 步:生成隨機結構,然后使用這些結構來創建時間問題。為了確保隨機結構的多樣化,這里參考圖結構的生成。

研究人員采用幾種現有的算法來生成具有不同屬性的圖結構,包括ER圖、無標度網絡(SFN)、遵循BA模型和隨機塊模型(SBM)的圖,以及星形圖。

每種圖生成算法都表現出不同的屬性,對應于不同的應用場景。例如,ER圖通常是稀疏的,平均度數較低,而BA圖是密集的,表現出冪律分布。

建立出世的圖結構之后,我們就為邊緣分配關系。對于每個圖,我們首先確定要分配給邊的多個關系類型,并將這些關系類型中的每個類型分配給一對一、一對多、多對一和多對多之一。

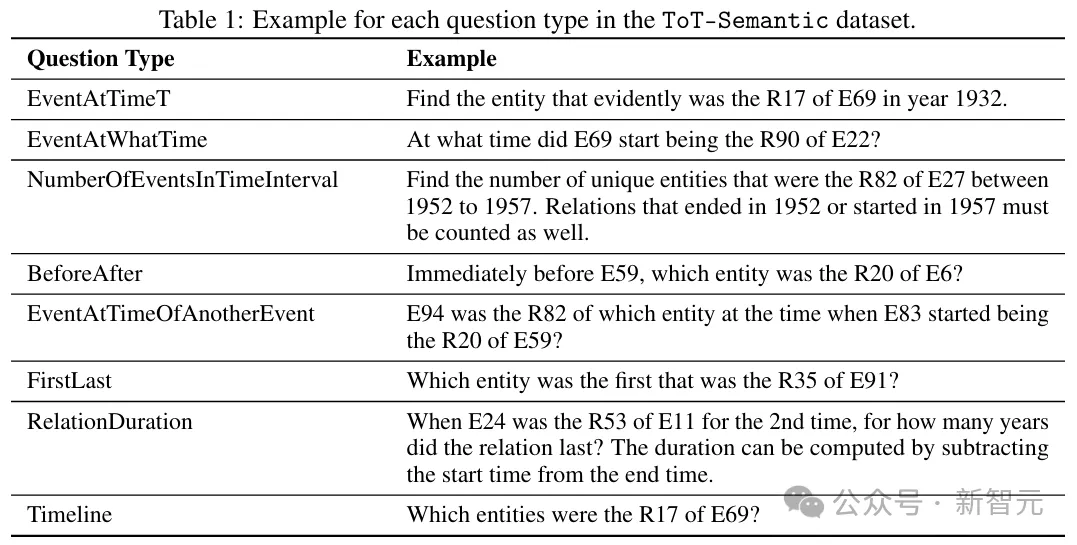

第 2 步:問題生成。這里考慮了以下八種類型的問題,常見于日常生活中,以及各種基準測試中。

EventAtTimeT:詢問在T時刻哪個實體與實體E有某種關系R

EventAtWhatTime:詢問兩個實體E1和E2之間的關系R在什么時間開始/結束

NumberOfEventsInTimeInterval:詢問有多少實體在T1到T2之間與實體E有關系R

BeforeAfter:詢問在E1之前/之后哪個實體與E2有關系R

EventAtTimeOfAnotherEvent:詢問當E1與E2有關系R1時,哪個實體與E3有關系R2

FirstLast:詢問哪個實體是第一個與E建立關系R的實體

RelationDuration:詢問E1和E2之間第k次建立關系R時,持續了多長時間

Timeline:要求按時間順序對與E有關系R的實體進行排序

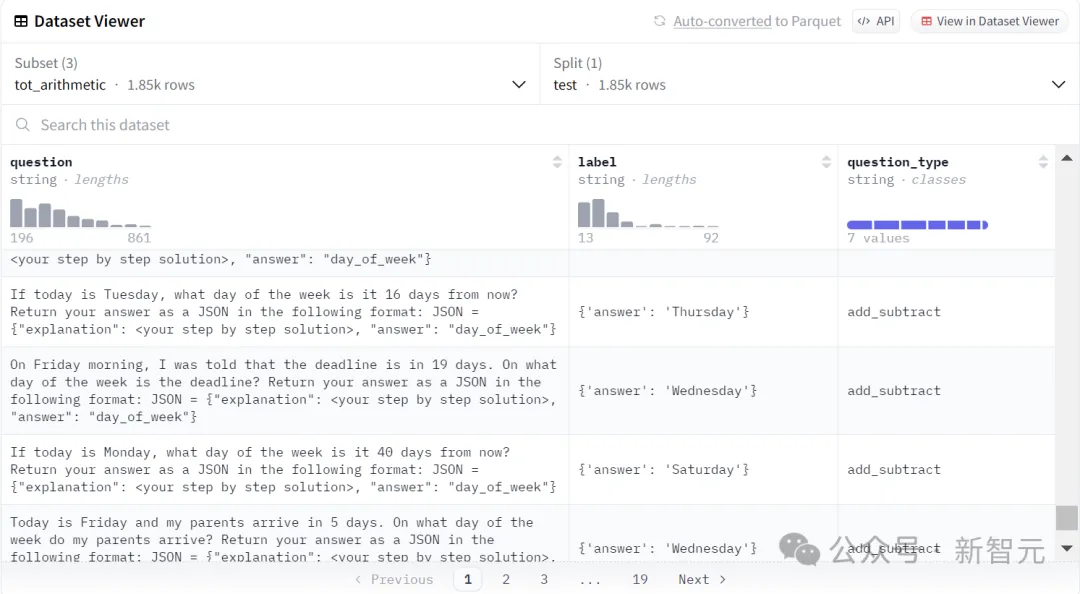

ToT-Arithmetic

ToT-Arithmetic將任務從合成數據轉移到了現實世界。

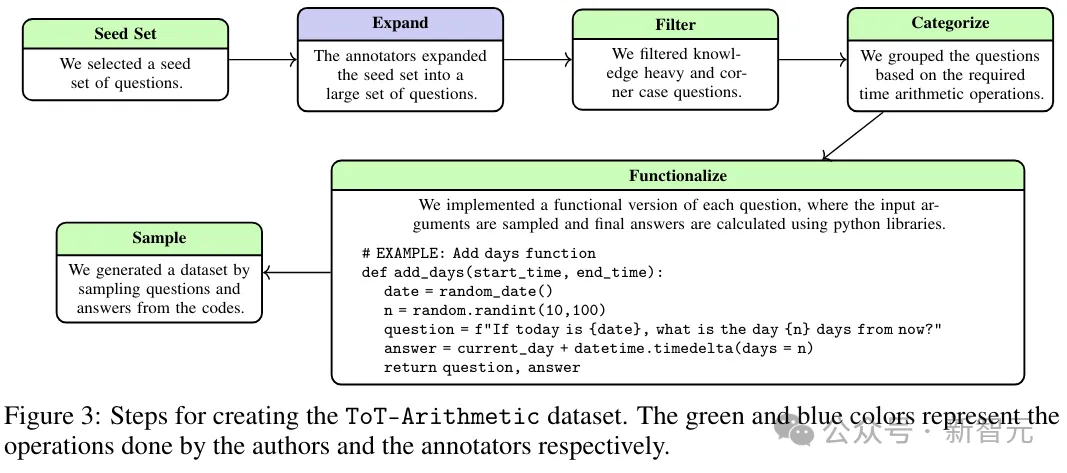

創建ToT-Arithmetic數據集的步驟如下圖所示:

下面分別介紹每個步驟的工作:

種子集:檢查現有基準中出現的時間算術問題類型,并通過網絡搜索,來收集一小部分初始問題。

擴展:向15名注釋者展示種子集,注釋者負責提出不在種子集中的新問題,或者提供與其他場景或問題模板相對應的問題。

過濾器:人工瀏覽所有問題,并過濾那些專注于極端情況、或者需要廣泛知識的問題。

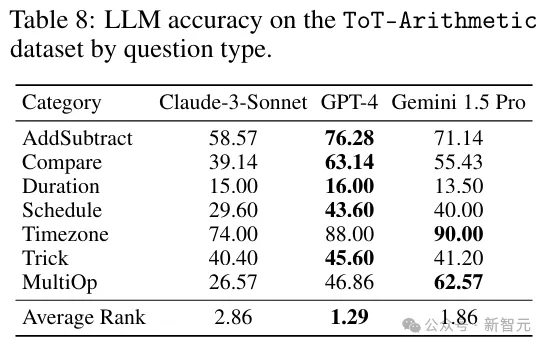

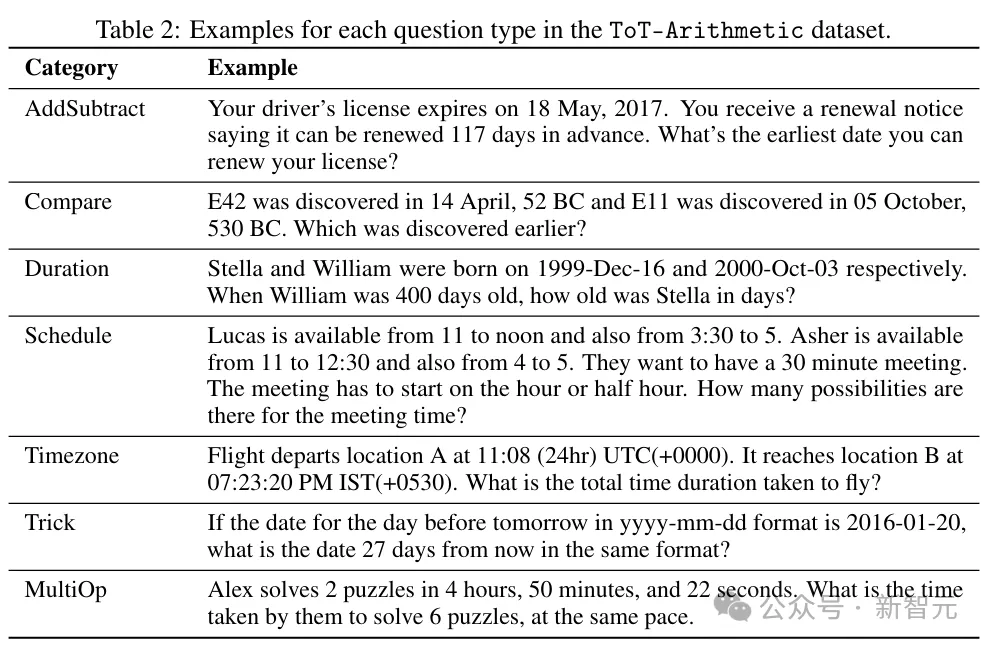

分類:將合格的問題分為七類,如下表所示:

AddSubtract:從日期或時間中添加或減去一個數字

Compare:按時間順序比較以不同格式提供的日期/時間

Duration:計算兩個日期/時間之間的差值

Schedule:在多塊時間內找到相互空閑點

Timezone:涉及處理不同的時區

Trick:有一點腦筋急轉彎

MultiOp:涉及需要上述多個操作的問題

函數化:將問題寫成函數,以便為每個問題抽取不同的值并根據這些值進行求解。

抽樣:從函數中抽取問題和答案,保證樣本數量與屬于每個類別的不同問題的數量成正比。

具體來說,AddSubtract采樣了350個,Compare采樣了350個,Duration采樣了200個,Schedule采樣了250個,Timezone采樣了100個,Trick采樣了250個,MultiOp采樣了350個——構成了總共包含1850個問題的數據集。

實驗分析

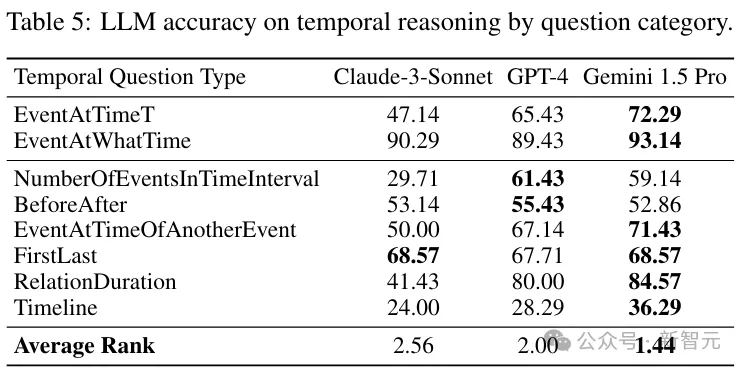

實驗評估了三個前沿的大語言模型,他們是:Claude-3-Sonnet、GPT-4和Gemini 1.5 Pro。

另外,由于ToT-Semantic任務需要較長的上下文,所以使用GPT4-Turbo代為出戰。

通過實驗,我們可以探討以下幾個問題:

1:時間結構對LLM性能有什么影響?

2:什么樣的時間問題更容易/更難回答?

3:模型提示中事實的順序有多重要,對事實進行排序的最佳方式是什么?

4:前沿模型在時間推理的兩個方面(語義和算術)的表現如何?

如下表所示,時間關系的圖結構會顯著影響LLM性能。

比如GPT-4的準確率因圖的類型而異,從完整圖的40.25%到AWE圖的92%。

以前的研究基本上都盯著知識圖譜,而這個實驗結果表明,圖的結構很重要。

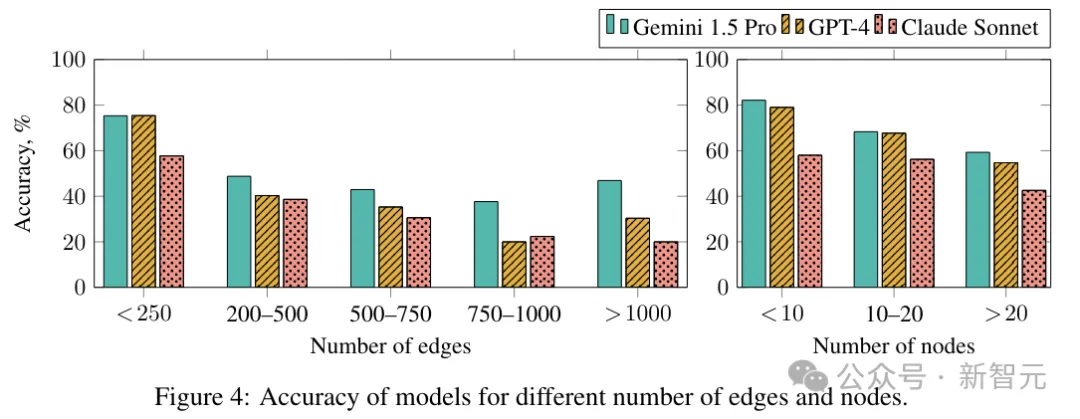

那么,不同的圖大小是否會影響結果呢?

如下圖所示,增加ToT-Semantic數據集中的邊或節點數量會導致LLM性能下降。

下面的實驗研究了不同時間任務(類型)對LLM推理能力的影響。這里通過評估模型在各種任務中的性能來量化這種影響

與需要整合多個事實的任務相比,LLM在需要檢索單個事實的任務上始終表現出卓越的性能。

單事實問題主要依賴于相關信息的識別和提取,而多事實問題則要求對檢索到的信息進行更深入的理解和綜合。

另外,即使在零階推理任務中,LLM也表現出不同程度的性能。例如,EventAtTimeT和EventAtWhatTime在結構上相似,但LLM往往擅長后者。

原因可能是EventAtTimeT需要簡單的時間算術運算來識別時間戳T落在時間間隔 [T1,T2]內,而EventAtWhatTime不需要任何時間算術運算。