編輯 | 伊風

出品 | 51CTO技術棧(微信號:blog51cto)

昨晚十點,Kimi彈了條推送。

大晚上的,他們就這么波瀾不驚地發了一個SOTA 模型出來!

就是這個 k1.5 多模態思考模型,性能實現有多逆天呢:

在 short-CoT 模式下, Kimi k1.5 的多項能力,大幅超越了全球范圍內短思考 SOTA 模型 GPT-4o 和 Claude 3.5 Sonnet 的水平,領先達到 550%;在 long-CoT 模式下,Kimi k1.5 的數學、代碼、多模態推理能力,也達到長思考 SOTA 模型 OpenAI o1 滿血版的水平!

而且,這是Kimi首次發布訓練報告《Kimi k1.5:借助大語言模型實現強化學習的 Scaling》,足足25頁。

圖片

圖片

k 1.5針對強化訓練做了不少工作,尤其是讓k 1.5實現逆天短推理能力的Long2short技術,讓很多技術者眼前一亮。這個報告真的可以說有“壓箱底”的干貨,高效思維鏈也是被很多人認為馬上要引領新風潮了。

(github 鏈接:https://github.com/MoonshotAI/Kimi-k1.5)。

Kimi作為專注產品側的閉源模型,能主動去做很多技術分享,真的很可貴。(點的就是越來越封閉的CloseAI)

再疊加上開源頂流DeepSeek家也推出了推理模型——DeepSeek-R1,這下硅谷AI圈又得死磕著研究咱們的技術報告了。

圖片

圖片

說回k 1.5,Kimi這次也是按慣例,一發測試報告就在C端產品上陸續上線,選這個模型切換就能使用k 1.5模型。

圖片

圖片

比較遺憾的是,目前被灰度到的小伙伴還很少,小編也沒能找到網友們的實測例子。

只能說懷著期待再等一等!

圖片

圖片

1.k1.5到底有多強

作為SOTA 模型,Kimi k1.5 性能上相當能打。

圖片

圖片

首先是短鏈思維鏈,也是k 1.5最大的看點。

短鏈思維鏈的核心,就是簡單高效,讓模型生成一個概括性的中間推理步驟來幫助回答問題。

k1.5 的數學、代碼、視覺多模態和通用能力,大幅超越了全球范圍內短思考 SOTA 模型 GPT-4o 和 Claude 3.5 Sonnet 的水平,領先達到 550%,直接看圖:

圖片

圖片

除了視覺能力(Vision)上弱一點,其他真的是很超前。

k 1.5的長板夠長,其他做得也不弱。在長鏈思維鏈模式下,Kimi k1.5 的數學、代碼、多模態推理能力,依然比肩了長思考 SOTA 模型 OpenAI o1 正式版的水平。

長鏈思維鏈專注的是復雜問題,數學證明、復雜因果關系、推理等等……這些任務需要模型多想幾步,生成更豐富的邏輯推理鏈條。

看報告真的和OpenAI打得有來有回的。

圖片

圖片

而更有含金量的是:

這應該是全球范圍內,OpenAI 之外的公司首次實現 o1 正式版的多模態推理性能。

月之暗面 Kimi

二、SOTA之路:Kimi模型是如何訓練出來的

我感覺,Kimi在強化學習方面找到手感了!真的能說一句越戰越勇。

去年 11 月他們發了 k0-math 數學模型,緊接著下個月又發了 k1 視覺思考模型。

再看年前他們發的k1.5 多模態思考模型,總覺得Kimi下了一盤很大的棋。

我們先說說,Kimi官方給出的k 1.5的幾個關鍵詞,然后再詳細聊聊這次最大的創新技術Long2short。

1.1.5的關鍵詞

k 1.5的三個關鍵詞:長上下文擴展、改進的策略優化、多模態能力。

圖片

圖片

- 長上下文擴展。Kimi 將 RL 的上下文窗口擴展到 128k,并觀察到隨著上下文長度的增加,性能持續提升。這背后的一個關鍵思想是,使用部分展開(partial rollouts)來提高訓練效率——即通過重用大量先前的軌跡來采樣新的軌跡,避免了從頭開始重新生成新軌跡的成本。我們的觀察表明,上下文長度是通過 LLMs 持續擴展RL的一個關鍵維度。

這項突破也意味著強化學習,使得大模型向更復雜和長時記憶任務又邁進了一步。

- 改進的策略優化。Kimi推導出了long-CoT的 RL 公式,并采用在線鏡像下降的變體進行穩健的策略優化。該算法通過我們的有效采樣策略、長度懲罰和數據配方的優化進一步得到改進。

- 多模態能力。我們的模型在文本和視覺數據上聯合訓練,具有聯合推理兩種模態的能力。該模型數學能力出眾,但由于主要支持LaTeX等格式的文本輸入,依賴圖形理解能力的部分幾何圖形題則難以應對。

2.long2short方法

k 1.5找到的long2short方法,絕對值得技術者學習。

這證明:Long-CoT模型的推理先驗知識可以順利轉移到 Short-CoT 模型中。

這樣Short-CoT 模型不僅效果飛升,還不會像Long-CoT那樣燃燒如此多的token。

Kimi這個創新真的可以:利用 Long-CoT 技術來改進 Short-CoT 模型后,在短鏈思維推理方面取得了SOTA成績——例如,在AIME上達到60.8分,MATH500上達到94.6分,LiveCodeBench上達到47.3分——大幅超越了現有的短鏈思維模型,如GPT-4和Claude Sonnet 3.5(提升幅度高達550%)。

圖片

圖片

報告中還進一步披露了Long-CoT改進Short-CoT的實現方法。

引用《ChatGPT原理與實戰》作者對報告的分析,Kimi團隊嘗試了模型合并、最短拒絕采樣、DPO、long2short強化學習多個方法。

這才煉成了如此優秀的SOTA。

圖片

圖片

三、同天之內兩家國產o1絕不是巧合

前腳,DeepSeek-R1 剛發,作為高性能的 AI 推理模型,對標的也是 OpenAI 的 o1 的正式版。

作為開源模型,R1已經開源,模型權重可在 Hugging Face 上獲取。加上之前V3的驚艷,聲量非常大。

開源地址:https://huggingface.co/deepseek-ai/DeepSeek-R1

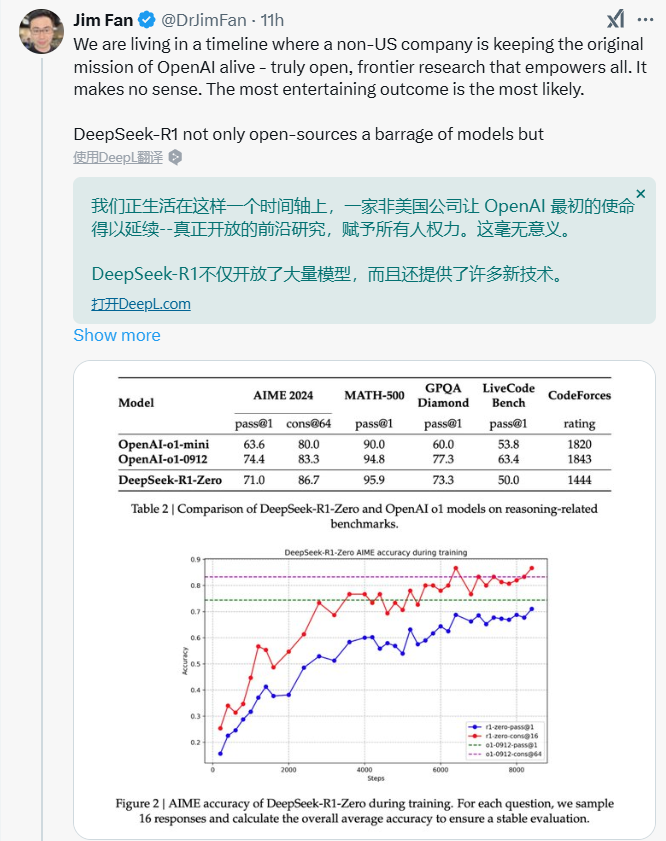

英偉達大佬Jim Fan感嘆說,R1不止是開放了模型,技術的共享也非常重要。

圖片

圖片

就這么你追我趕著,k 1.5也橫空出世了。

看來,如Jim Fan此前預言的,2025強化學習要王者歸來了。

圖片

圖片

最后,Jim Fan還總結了一波兩個模型的不同之處,讓我們一起看看:

- DeepSeek 采用 AlphaZero 方法--純粹通過 RL 引導,無需人工輸入,即 "冷啟動"。

- DeepSeek的權重是MIT許可的(思想領導力!);Kimi還沒有發布模型。

- Kimi在MathVista等基準測試中顯示出強大的多模態性能(!),這些基準測試要求對幾何、智商測試等有直觀的理解。

- Kimi 的論文中有大量關于系統設計的細節:RL 基礎設施、混合集群、代碼沙箱、并行策略;以及學習細節:長上下文、CoT 壓縮、課程、抽樣策略、測試用例生成等!

發布k 1.5之后,Kimi發布了K系列的未來計劃。從k0-math 數學模型,到k1 視覺思考模型,再到k 1.5的多模態推理,感覺Kimi真的是在一路升級打怪。

期待2025年,更多的模型廠跟我們一些驚艷的新東西。

圖片

圖片