剛剛,DeepSeek揭秘R1官方同款部署設(shè)置,溫度=0.6!OpenAI推理指南同時(shí)上線

同一天內(nèi),DeepSeek和OpenAI都發(fā)布了推理模型使用指南!

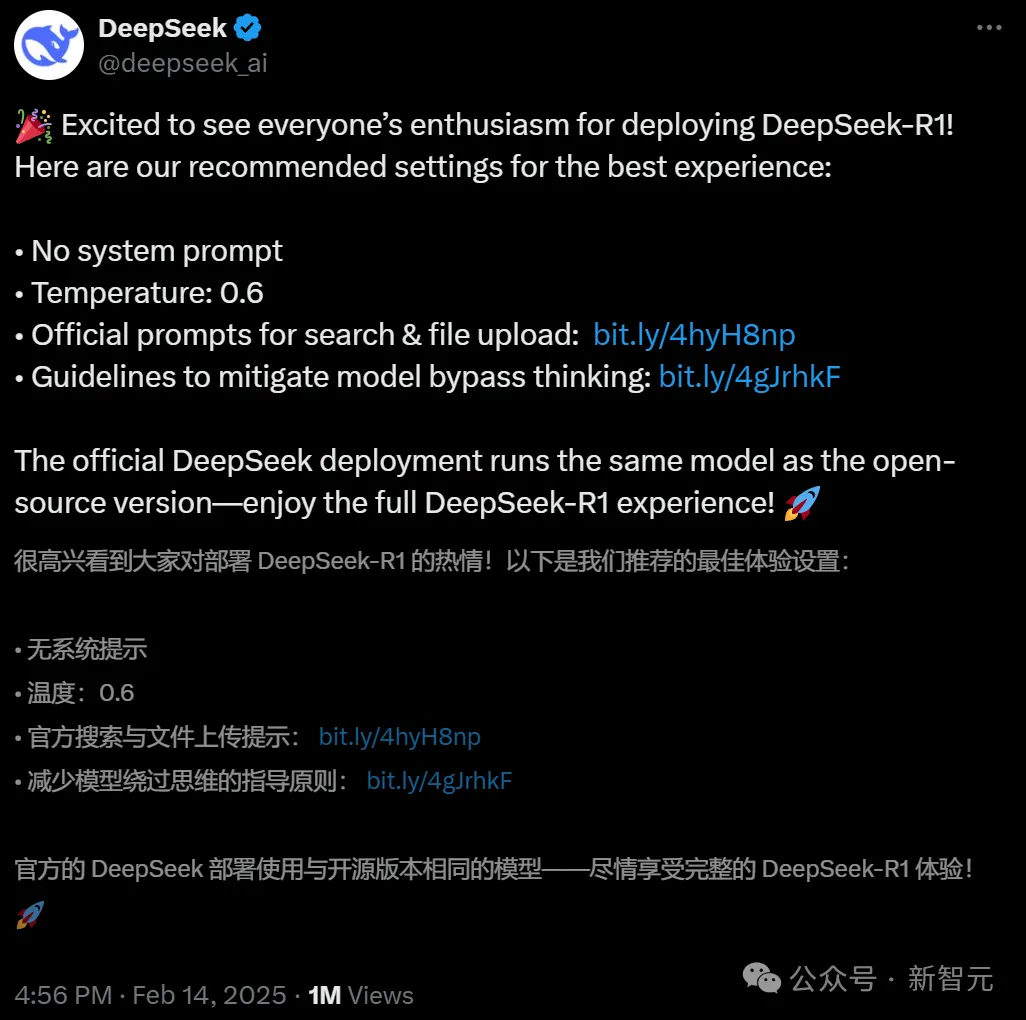

DeepSeek的X賬號(hào)迎來(lái)久違的更新:發(fā)布了官方版本,教大家如何部署DeepSeek-R1的設(shè)置。

最佳方法如下——

- 不使用系統(tǒng)提示

- 采樣溫度:0.6

- 針對(duì)文件上傳和網(wǎng)絡(luò)搜索功能定制prompt

- 每次輸出時(shí)都以<think>\n開(kāi)始,以防模型跳過(guò)思考過(guò)程

注意,官方部署DeepSeek,使用的是跟開(kāi)源版本完全相同的模型。

不過(guò)在留言區(qū)最熱門的呼聲,莫過(guò)于請(qǐng)DeepSeek盡快解決「服務(wù)器繁忙」的問(wèn)題。

巧的是,就在同一天的早些時(shí)候,OpenAI也發(fā)布了官方指南,匯總了使用o系列模型的最佳實(shí)踐。

包括推理模型與非推理模型之間的區(qū)別、何時(shí)使用推理模型、以及如何有效地使用提示來(lái)引導(dǎo)推理模型。

接下來(lái),讓我們?cè)敿?xì)看一下,兩大明星AI機(jī)構(gòu)的官方指南細(xì)節(jié)。

DeepSeek:手把手教你正確用上官方同款

如何部署和官方一樣的DeepSeek-R1?

第一點(diǎn):不要使用系統(tǒng)提示

請(qǐng)勿添加系統(tǒng)提示(system prompt),所有指令都應(yīng)當(dāng)包含在用戶提示(user prompt)中。

第二點(diǎn):將采樣溫度參數(shù)設(shè)置為0.6

將采樣溫度(temperature)設(shè)置在 0.5~0.7 之間(建議使用 0.6),以避免輸出出現(xiàn)重復(fù)循環(huán)或語(yǔ)義不連貫的情況。

第三點(diǎn):使用官方prompt

對(duì)于文件上傳功能,DeepSeek建議按照模板創(chuàng)建提示,其中包含 {file_name}、{file_content} 和 {question} 這些參數(shù)。

```

file_template = \

"""[file name]: {file_name}

[file content begin]

{file_content}

[file content end]

{question}"""

```對(duì)于網(wǎng)絡(luò)搜索功能,則包含 {search_results}、{cur_data} 和 {question} 這些參數(shù)。

對(duì)于中文查詢,使用如下提示:

```

search_answer_zh_template = \

'''# 以下內(nèi)容是基于用戶發(fā)送的消息的搜索結(jié)果:

{search_results}

在我給你的搜索結(jié)果中,每個(gè)結(jié)果都是[webpage X begin]...[webpage X end]格式的,X代表每篇文章的數(shù)字索引。請(qǐng)?jiān)谶m當(dāng)?shù)那闆r下在句子末尾引用上下文。請(qǐng)按照引用編號(hào)[citation:X]的格式在答案中對(duì)應(yīng)部分引用上下文。如果一句話源自多個(gè)上下文,請(qǐng)列出所有相關(guān)的引用編號(hào),例如[citation:3][citation:5],切記不要將引用集中在最后返回引用編號(hào),而是在答案對(duì)應(yīng)部分列出。

在回答時(shí),請(qǐng)注意以下幾點(diǎn):

- 今天是{cur_date}。

- 并非搜索結(jié)果的所有內(nèi)容都與用戶的問(wèn)題密切相關(guān),你需要結(jié)合問(wèn)題,對(duì)搜索結(jié)果進(jìn)行甄別、篩選。

- 對(duì)于列舉類的問(wèn)題(如列舉所有航班信息),盡量將答案控制在10個(gè)要點(diǎn)以內(nèi),并告訴用戶可以查看搜索來(lái)源、獲得完整信息。優(yōu)先提供信息完整、最相關(guān)的列舉項(xiàng);如非必要,不要主動(dòng)告訴用戶搜索結(jié)果未提供的內(nèi)容。

- 對(duì)于創(chuàng)作類的問(wèn)題(如寫論文),請(qǐng)務(wù)必在正文的段落中引用對(duì)應(yīng)的參考編號(hào),例如[citation:3][citation:5],不能只在文章末尾引用。你需要解讀并概括用戶的題目要求,選擇合適的格式,充分利用搜索結(jié)果并抽取重要信息,生成符合用戶要求、極具思想深度、富有創(chuàng)造力與專業(yè)性的答案。你的創(chuàng)作篇幅需要盡可能延長(zhǎng),對(duì)于每一個(gè)要點(diǎn)的論述要推測(cè)用戶的意圖,給出盡可能多角度的回答要點(diǎn),且務(wù)必信息量大、論述詳盡。

- 如果回答很長(zhǎng),請(qǐng)盡量結(jié)構(gòu)化、分段落總結(jié)。如果需要分點(diǎn)作答,盡量控制在5個(gè)點(diǎn)以內(nèi),并合并相關(guān)的內(nèi)容。

- 對(duì)于客觀類的問(wèn)答,如果問(wèn)題的答案非常簡(jiǎn)短,可以適當(dāng)補(bǔ)充一到兩句相關(guān)信息,以豐富內(nèi)容。

- 你需要根據(jù)用戶要求和回答內(nèi)容選擇合適、美觀的回答格式,確保可讀性強(qiáng)。

- 你的回答應(yīng)該綜合多個(gè)相關(guān)網(wǎng)頁(yè)來(lái)回答,不能重復(fù)引用一個(gè)網(wǎng)頁(yè)。

- 除非用戶要求,否則你回答的語(yǔ)言需要和用戶提問(wèn)的語(yǔ)言保持一致。

# 用戶消息為:

{question}'''

```對(duì)于英文查詢,使用如下提示:

```

search_answer_en_template = \

'''# The following contents are the search results related to the user's message:

{search_results}

In the search results I provide to you, each result is formatted as [webpage X begin]...[webpage X end], where X represents the numerical index of each article. Please cite the context at the end of the relevant sentence when appropriate. Use the citation format [citation:X] in the corresponding part of your answer. If a sentence is derived from multiple contexts, list all relevant citation numbers, such as [citation:3][citation:5]. Be sure not to cluster all citations at the end; instead, include them in the corresponding parts of the answer.

When responding, please keep the following points in mind:

- Today is {cur_date}.

- Not all content in the search results is closely related to the user's question. You need to evaluate and filter the search results based on the question.

- For listing-type questions (e.g., listing all flight information), try to limit the answer to 10 key points and inform the user that they can refer to the search sources for complete information. Prioritize providing the most complete and relevant items in the list. Avoid mentioning content not provided in the search results unless necessary.

- For creative tasks (e.g., writing an essay), ensure that references are cited within the body of the text, such as [citation:3][citation:5], rather than only at the end of the text. You need to interpret and summarize the user's requirements, choose an appropriate format, fully utilize the search results, extract key information, and generate an answer that is insightful, creative, and professional. Extend the length of your response as much as possible, addressing each point in detail and from multiple perspectives, ensuring the content is rich and thorough.

- If the response is lengthy, structure it well and summarize it in paragraphs. If a point-by-point format is needed, try to limit it to 5 points and merge related content.

- For objective Q&A, if the answer is very brief, you may add one or two related sentences to enrich the content.

- Choose an appropriate and visually appealing format for your response based on the user's requirements and the content of the answer, ensuring strong readability.

- Your answer should synthesize information from multiple relevant webpages and avoid repeatedly citing the same webpage.

- Unless the user requests otherwise, your response should be in the same language as the user's question.

# The user's message is:

{question}'''

```第四點(diǎn):別讓模型繞過(guò)思考

DeepSeek發(fā)現(xiàn),DeepSeek-R1系列模型在回應(yīng)某些查詢時(shí),可能會(huì)跳過(guò)思考過(guò)程(即直接輸出空的思考標(biāo)簽「<think>\n\n</think>」),這會(huì)影響模型的推理性能。

為確保模型進(jìn)行完整的推理過(guò)程,官方建議:強(qiáng)制要求模型在每次輸出時(shí)都以思考標(biāo)簽「<think>\n」開(kāi)始。

OpenAI:推理模型的最佳實(shí)踐

在這邊,OpenAI也放出使用o系列模型的最佳實(shí)踐指南。

推理模型與GPT模型

OpenAI介紹道,與GPT模型相比,o系列模型在不同任務(wù)上表現(xiàn)出色,且需要使用不同的提示。

這兩類模型沒(méi)有優(yōu)劣之分——它們各有所長(zhǎng)。

o系列模型更像是一個(gè)「規(guī)劃者」,能深入思考復(fù)雜任務(wù);相比之下,GPT模型則是一個(gè)「執(zhí)行者」,能直接執(zhí)行任務(wù),延遲低、性價(jià)比更高。

在不同情況下,具體選擇哪個(gè)模型,推薦如下。

- 速度和成本:選擇GPT模型,因?yàn)樗鼈兲幚硭俣雀欤杀靖?/span>

- 執(zhí)行明確任務(wù):選擇GPT模型,它們?cè)谔幚斫缍ㄇ逦娜蝿?wù)時(shí)表現(xiàn)出色

- 準(zhǔn)確性和可靠性:選擇o系列模型,它們是可靠的決策專家

- 復(fù)雜問(wèn)題解決:選擇o系列模型,它們善于處理模糊和復(fù)雜的問(wèn)題

大多數(shù)AI工作流,可以使用二者的結(jié)合。

何時(shí)使用推理模型

OpenAI列出了一些從客戶和內(nèi)部觀察到的成功使用模式,是一些針對(duì)o系列模型的實(shí)用指導(dǎo)。

1. 處理模糊任務(wù)

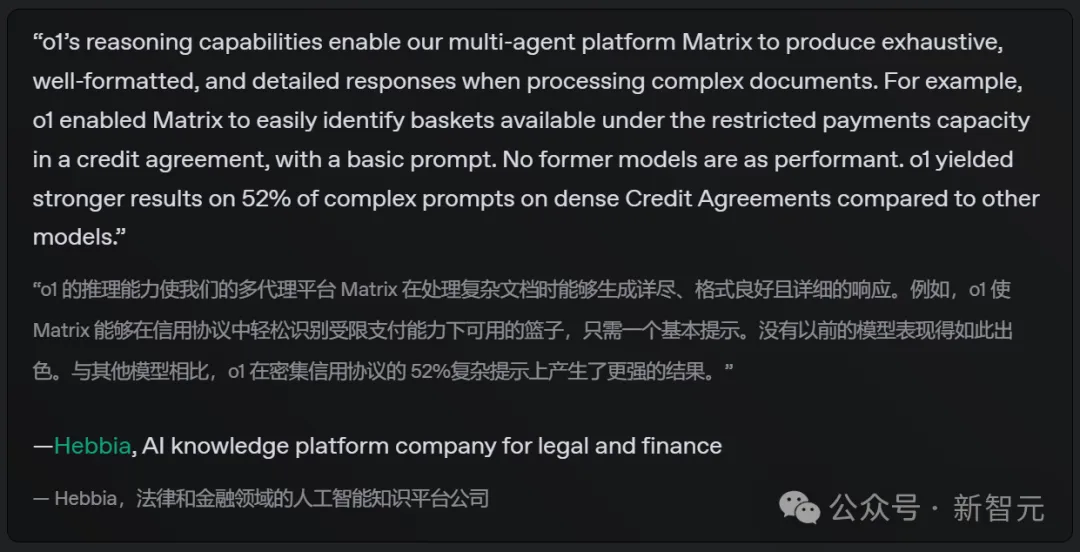

推理模型特別擅長(zhǎng)處理信息有限或零散的情況,只需通過(guò)簡(jiǎn)單的提示詞就能理解用戶意圖并妥善處理指令中的信息缺口。

值得注意的是,推理模型通常會(huì)在做出未經(jīng)驗(yàn)證的猜測(cè)或填補(bǔ)信息空缺之前,主動(dòng)提出澄清性問(wèn)題。

AI知識(shí)平臺(tái)的法律和金融公司表示,只需一個(gè)簡(jiǎn)單提示,o1就能使Matrix輕松識(shí)別信用協(xié)議中受限支付能力下可用的資金籃。此前沒(méi)有任何模型達(dá)到這種性能水平

2. 大海撈針

當(dāng)需要處理大量非結(jié)構(gòu)化信息時(shí),推理模型特別擅長(zhǎng)理解內(nèi)容并精準(zhǔn)提取出回答問(wèn)題所需的關(guān)鍵信息。

比如,AI金融平臺(tái)發(fā)現(xiàn),為了分析一家公司的收購(gòu),o1審查數(shù)十份文件(合同和租賃協(xié)議),找到了可能影響交易的復(fù)雜條款

3. 在大型數(shù)據(jù)集中發(fā)現(xiàn)關(guān)系和細(xì)微差別

推理模型特別擅長(zhǎng)分析包含數(shù)百頁(yè)密集、非結(jié)構(gòu)化信息的復(fù)雜文檔,如法律合同、財(cái)務(wù)報(bào)表和保險(xiǎn)索賠等。這些模型在識(shí)別文檔之間的關(guān)聯(lián)性,并基于數(shù)據(jù)中隱含的事實(shí)做出決策方面,表現(xiàn)尤為突出。

稅務(wù)研究平臺(tái)發(fā)現(xiàn),o1在綜合多個(gè)文檔的推理上表現(xiàn)要好得多

推理模型還特別擅長(zhǎng)理解細(xì)微的政策和規(guī)則,并將其準(zhǔn)確應(yīng)用于具體任務(wù)中以得出合理結(jié)論。

投資管理AI平臺(tái)提問(wèn):融資如何影響現(xiàn)有股東,尤其是在行使反稀釋權(quán)的情況下?o1和o3-mini完美完成任務(wù),而頂級(jí)財(cái)務(wù)分析師需要花20-30分鐘計(jì)算

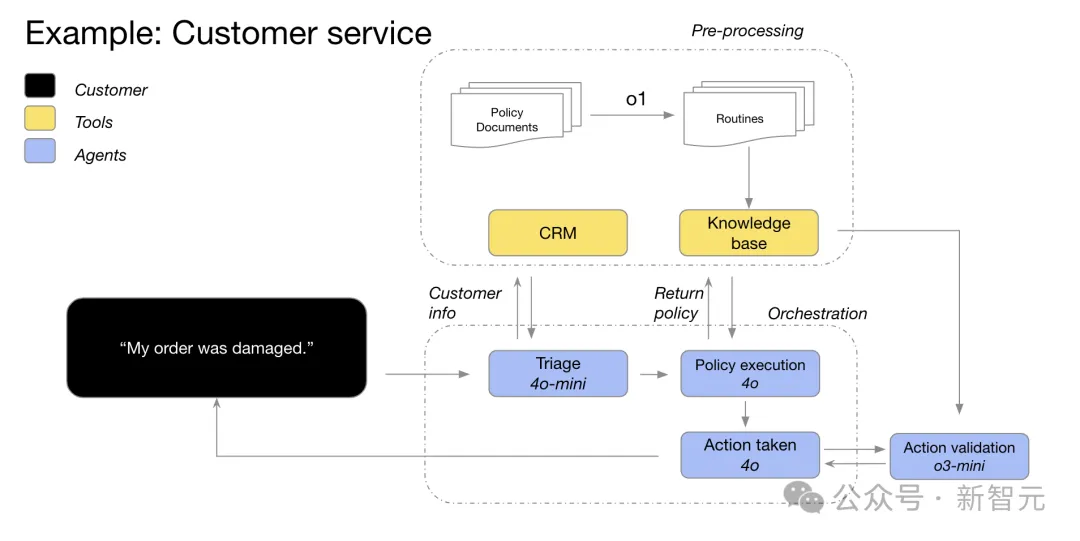

4. 多步驟AI智能體規(guī)劃

推理模型在AI智能體規(guī)劃和策略制定中發(fā)揮著關(guān)鍵作用。

將推理模型作為「計(jì)劃者」時(shí)效果顯著:它能為問(wèn)題制定詳細(xì)的多步驟解決方案,并根據(jù)具體需求(高智能或低延遲)選擇和分配合適的GPT模型(執(zhí)行者)來(lái)完成各個(gè)步驟。

o1很擅長(zhǎng)選擇數(shù)據(jù)類型,將大問(wèn)題分解為小塊

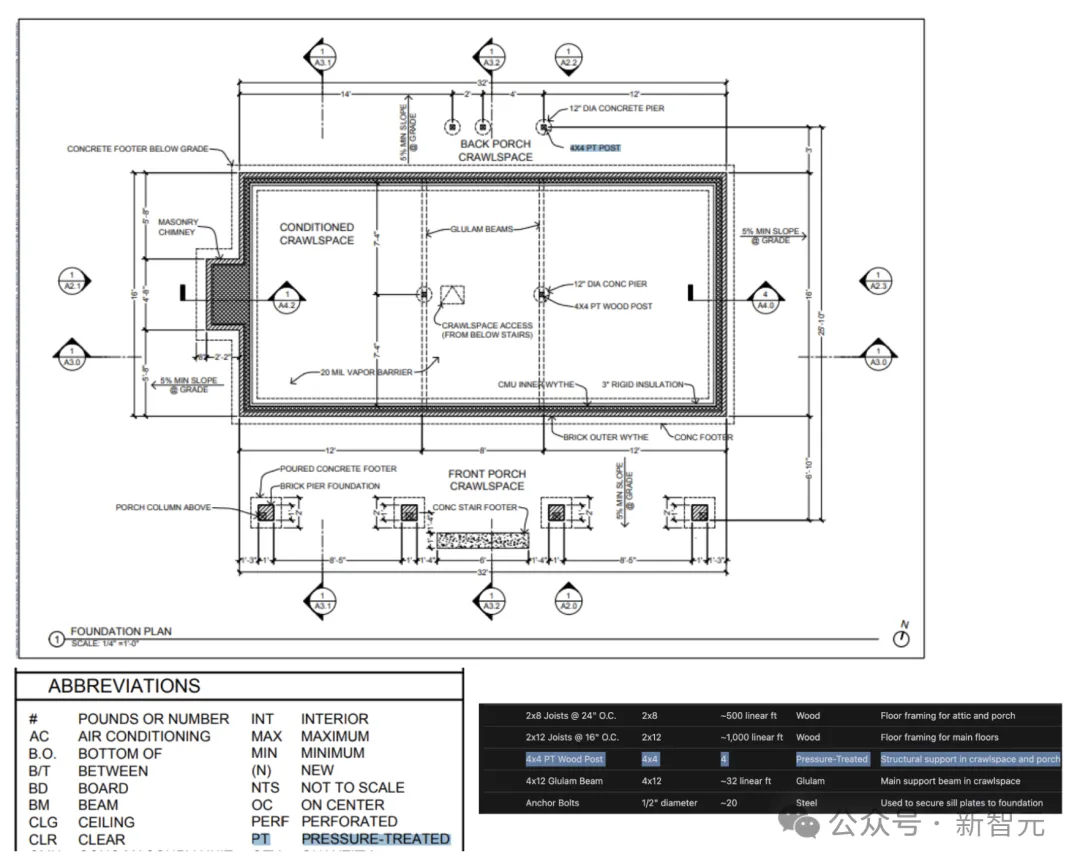

5. 視覺(jué)推理能力

截至目前,o1是唯一一個(gè)具備視覺(jué)處理能力的推理模型。

與GPT-4o相比,o1的獨(dú)特優(yōu)勢(shì)在于它能夠準(zhǔn)確理解最具挑戰(zhàn)性的視覺(jué)內(nèi)容,包括結(jié)構(gòu)不規(guī)則的圖表和表格,以及質(zhì)量欠佳的圖片。

SafetyKit會(huì)自動(dòng)化審核數(shù)百萬(wàn)種產(chǎn)品的風(fēng)險(xiǎn)與合規(guī)性,包括奢侈品仿制品、瀕危物種以及受管制物品。最困難的圖像分類任務(wù)上,o1達(dá)到了88%的準(zhǔn)確性

可以看到,o1能夠從復(fù)雜的建筑工程圖紙中精確識(shí)別各類設(shè)施和材料,并生成完整的工程物料清單(BOM)。

最令人驚喜的發(fā)現(xiàn)是,o1能夠自動(dòng)關(guān)聯(lián)不同圖紙之間的信息:它可以將建筑圖紙某頁(yè)的圖例信息正確應(yīng)用到其他頁(yè)面,而無(wú)需特別指示。

例如,在識(shí)別4x4 PT木柱時(shí),o1 夠根據(jù)圖例自動(dòng)理解「PT」代表壓力處理

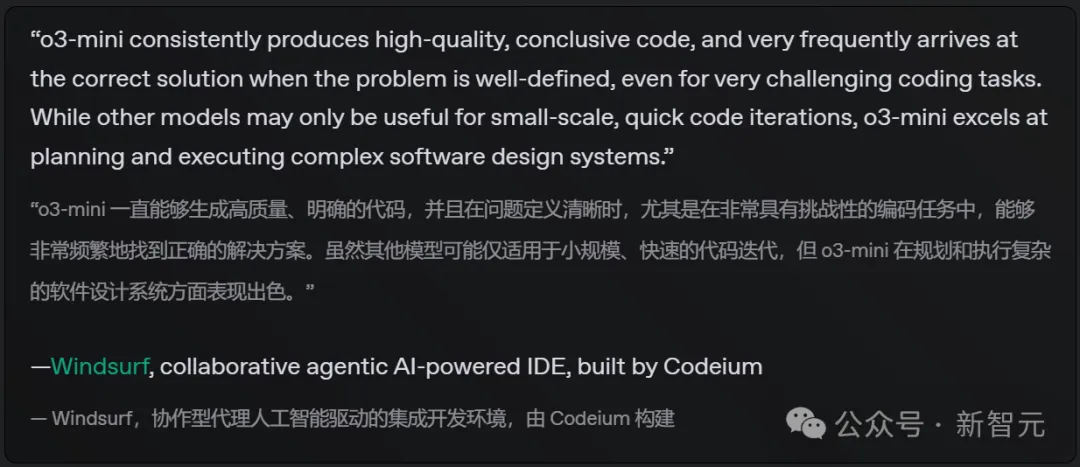

6. 代碼審查、調(diào)試和質(zhì)量改進(jìn)

推理模型在審查和改進(jìn)大規(guī)模代碼方面表現(xiàn)突出。考慮到這類模型的較高延遲特性,通常將代碼審查任務(wù)安排在后臺(tái)運(yùn)行。

雖然GPT-4o和GPT-4o mini憑借較低的延遲可能更適合直接編寫代碼,但在那些對(duì)延遲要求相對(duì)不那么嚴(yán)格的代碼生成場(chǎng)景中,o3-mini表現(xiàn)同樣出色。

Windsurf發(fā)現(xiàn),o3-mini非常擅長(zhǎng)計(jì)劃和只需復(fù)雜的軟件設(shè)計(jì)系統(tǒng)

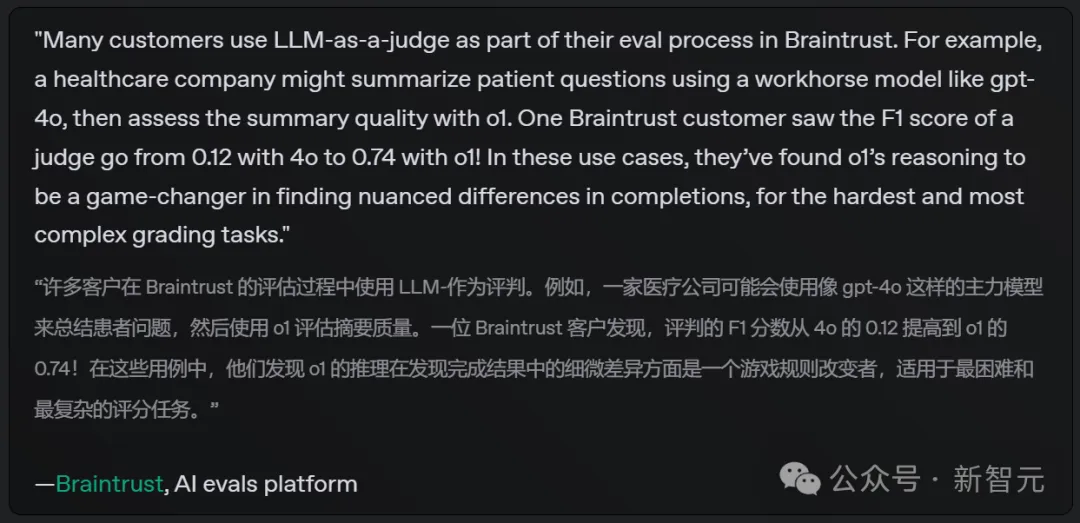

7. 評(píng)估和基準(zhǔn)測(cè)試其他模型的響應(yīng)

OpenAI還發(fā)現(xiàn),推理模型在對(duì)其他模型的輸出進(jìn)行基準(zhǔn)測(cè)試和評(píng)估方面表現(xiàn)優(yōu)異。

數(shù)據(jù)驗(yàn)證對(duì)確保數(shù)據(jù)集的質(zhì)量和可靠性至關(guān)重要,這一點(diǎn)在醫(yī)療保健等敏感領(lǐng)域尤其重要。

傳統(tǒng)驗(yàn)證方法主要依賴預(yù)設(shè)規(guī)則和模式,而o1和o3-mini等先進(jìn)模型則能夠理解上下文并進(jìn)行數(shù)據(jù)推理,從而提供更靈活、更智能的驗(yàn)證方案。

在醫(yī)療應(yīng)用場(chǎng)景中,o1的推理能力能在最困難和最復(fù)雜的評(píng)分任務(wù)中精準(zhǔn)識(shí)別細(xì)微差異,徹底改變?cè)u(píng)估方式

如何編寫推理模型的prompt

推理模型在處理簡(jiǎn)明直接的提示詞時(shí)表現(xiàn)最佳。某些提示工程(如要求模型「一步一步思考」)可能并不會(huì)提升性能,有時(shí)反而會(huì)降低效果。

簡(jiǎn)單來(lái)說(shuō),你可以可以這樣理解:

- 推理模型就像一位經(jīng)驗(yàn)豐富的高級(jí)同事——你只需告訴他們最終目標(biāo),就能相信他們自主完成所有細(xì)節(jié)工作。

- GPT模型則更像一位新手同事——你需要提供明確詳細(xì)的指示,才能讓他們準(zhǔn)確完成特定的輸出任務(wù)。

構(gòu)建prompt的具體建議如下:

- 用開(kāi)發(fā)者消息取代系統(tǒng)消息:自o1-2024-12-17版本起,推理模型開(kāi)始支持開(kāi)發(fā)者消息(developer message)而非系統(tǒng)消息(system message)。

- 保持提示詞簡(jiǎn)潔明確:推理模型最擅長(zhǎng)理解和響應(yīng)簡(jiǎn)短、清晰的指令。

- 避免使用CoT提示:由于模型內(nèi)置推理能力,因此無(wú)需特別提示它們「一步一步思考」或「解釋推理過(guò)程」。

- 善用分隔符增強(qiáng)清晰度:使用Markdown、XML標(biāo)簽和章節(jié)標(biāo)題等分隔符來(lái)明確區(qū)分輸入的不同部分,這有助于模型準(zhǔn)確理解各個(gè)章節(jié)的內(nèi)容。

- 優(yōu)先嘗試零樣本學(xué)習(xí):推理模型通常無(wú)需少樣本示例即可產(chǎn)出優(yōu)質(zhì)結(jié)果,因此建議先嘗試不含示例的提示詞。如果對(duì)輸出結(jié)果有更復(fù)雜的要求,再考慮在提示詞中添加輸入和期望輸出的示例。請(qǐng)注意確保示例與提示詞指令嚴(yán)格匹配,因?yàn)椴灰恢驴赡軐?dǎo)致性能下降。

- 提供明確約束條件:如果需要對(duì)模型的響應(yīng)施加具體限制(例如「提供預(yù)算控制在500美元以內(nèi)的解決方案」),請(qǐng)?jiān)谔崾驹~中明確列出這些約束條件。

- 明確定義目標(biāo):在指令中,請(qǐng)?jiān)敿?xì)說(shuō)明判定響應(yīng)成功的具體參數(shù),并引導(dǎo)模型持續(xù)優(yōu)化推理過(guò)程,直到達(dá)成設(shè)定的成功標(biāo)準(zhǔn)。

- Markdown格式說(shuō)明:從o1-2024-12-17版本開(kāi)始,API中的推理模型默認(rèn)不會(huì)生成帶有Markdown格式的響應(yīng)。如果確實(shí)需要在響應(yīng)中包含Markdown格式,請(qǐng)?jiān)陂_(kāi)發(fā)者消息的首行添加「Formatting re-enabled」字符串。

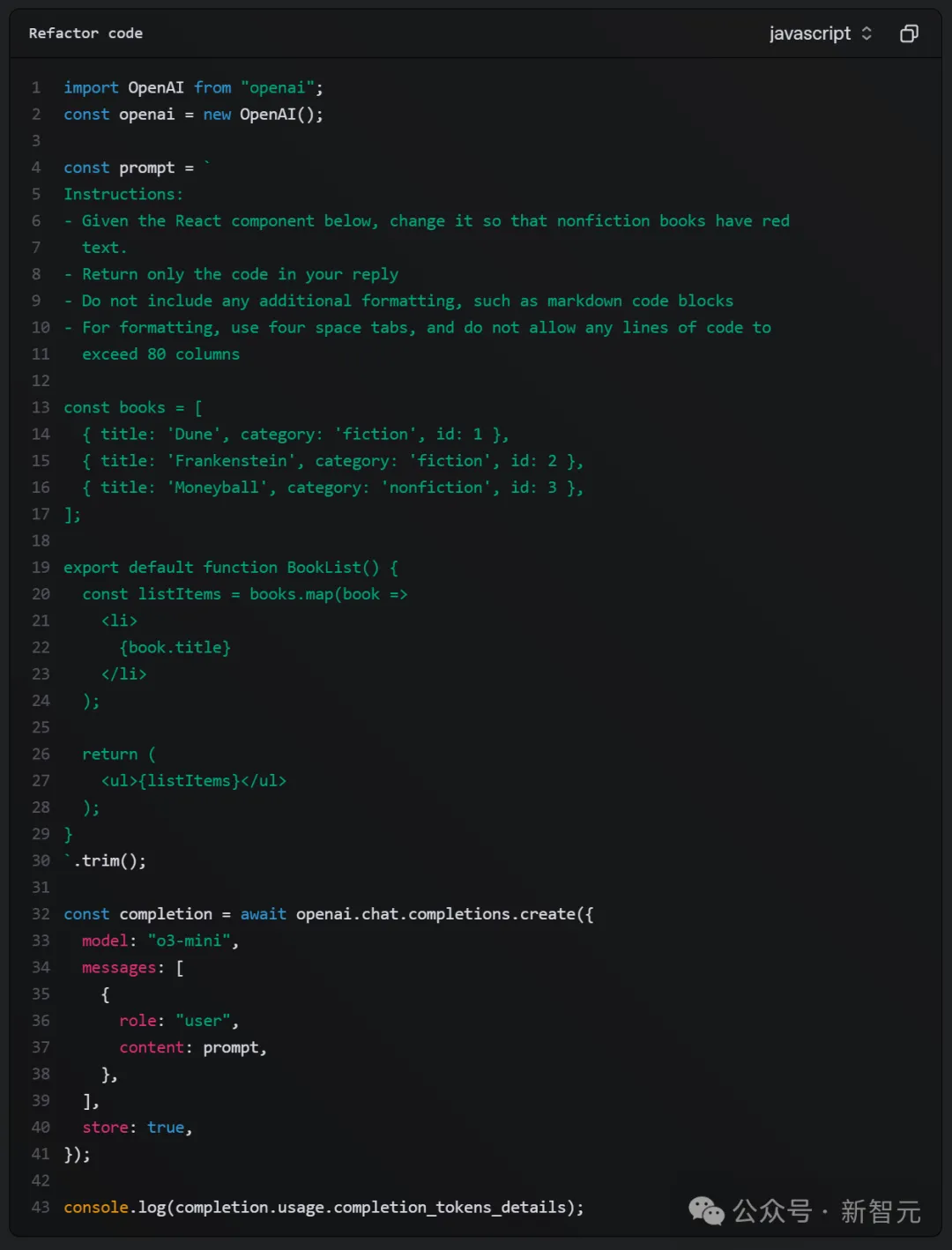

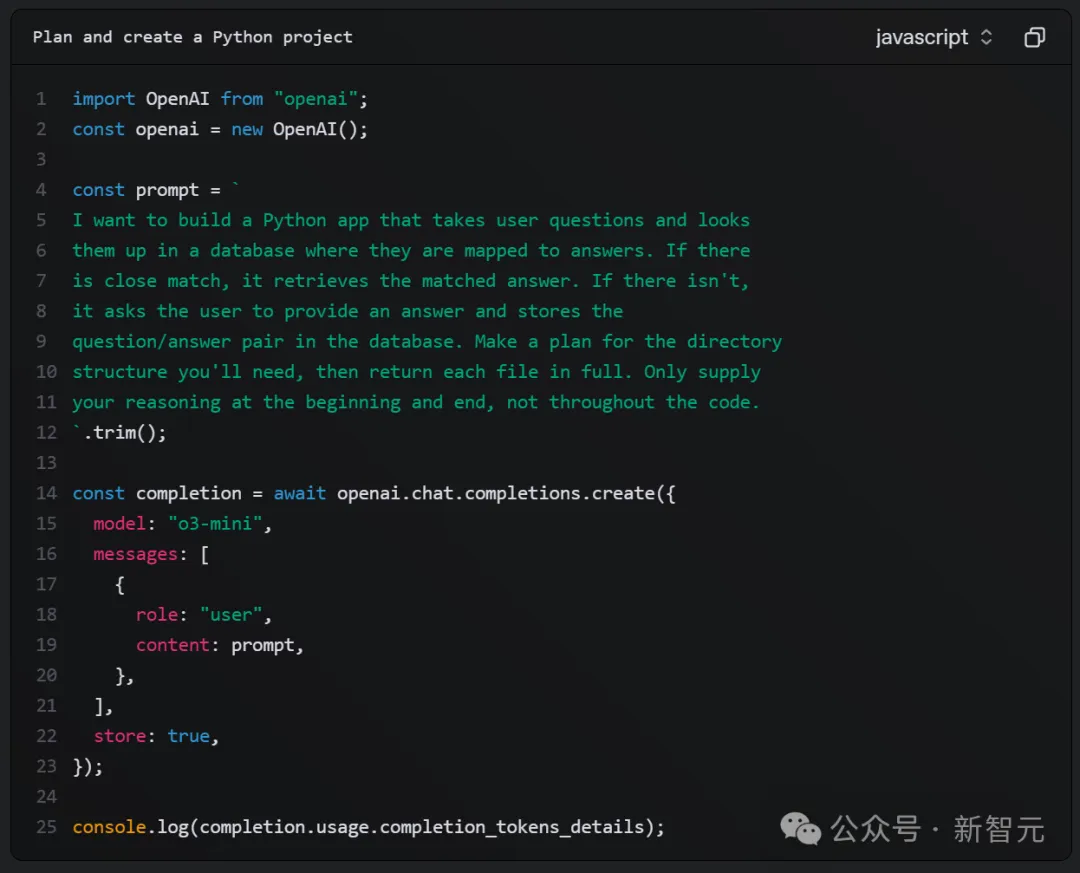

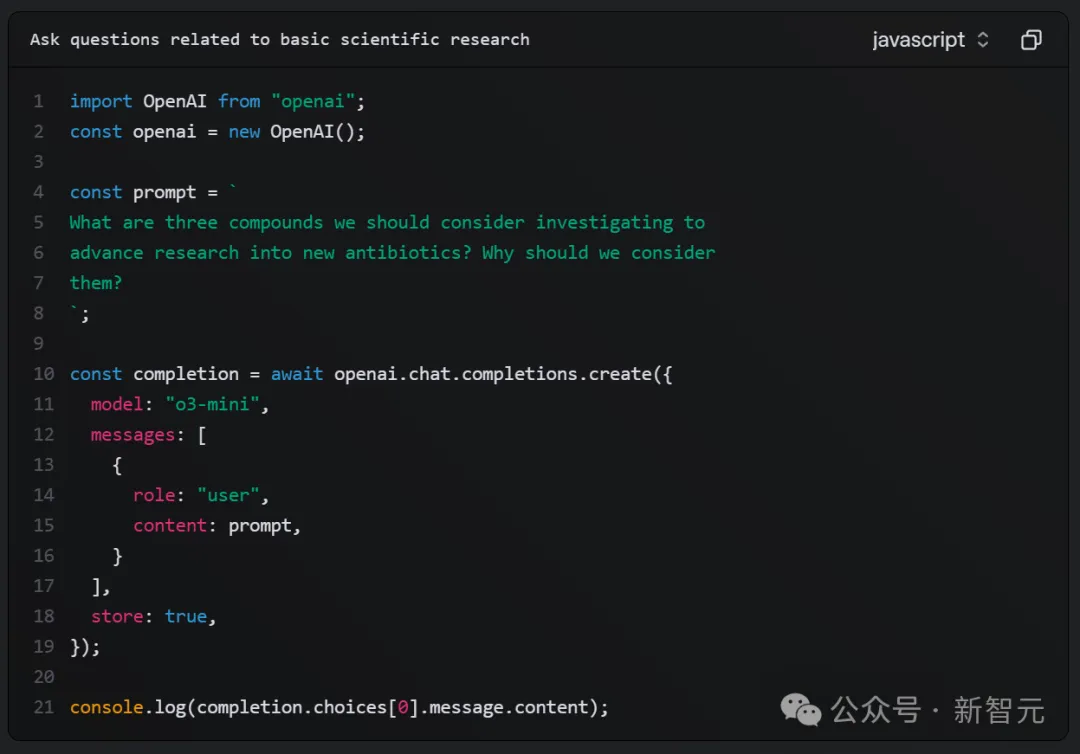

以下是代碼重構(gòu)、執(zhí)行規(guī)劃、STEM研究的prompt示例:

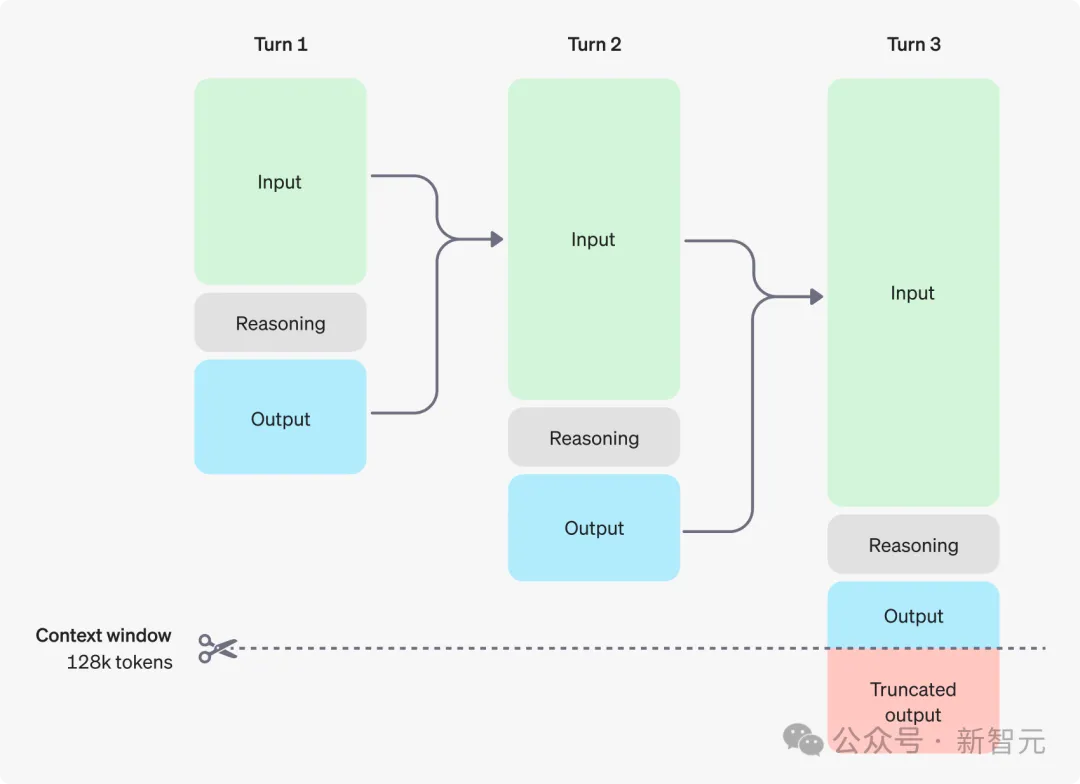

推理工作原理

推理模型在輸入和輸出token之外,還引入了推理token用于「思考」。

在生成推理token后,模型會(huì)生成可見(jiàn)的補(bǔ)全內(nèi)容作為最終答案,同時(shí)從上下文中清除推理token。

下面是用戶與AI助手之間多輪對(duì)話的示例。可以看到,每輪對(duì)話的輸入和輸出token都會(huì)被保留,而推理token則會(huì)被移除。