如何避免交叉驗證中的數(shù)據(jù)泄露?

大家好,我是小寒

在機器學習中,交叉驗證(Cross-Validation)是一種常用的模型評估技術(shù),目的是通過將數(shù)據(jù)集分割為多個子集,反復訓練和驗證模型,以便更好地估計模型的性能。

然而,在交叉驗證過程中,數(shù)據(jù)泄露(Data Leakage) 是一個非常嚴重的問題,它會導致模型的評估結(jié)果過于樂觀,進而使得模型在實際應用中表現(xiàn)不佳。

什么是數(shù)據(jù)泄露

數(shù)據(jù)泄露是指在模型訓練過程中,模型不恰當?shù)亟佑|到了與驗證集或測試集相關(guān)的信息,導致模型的訓練過程中“提前知道”了本應該不在訓練數(shù)據(jù)中的信息。

這種信息泄露會使得模型的評估結(jié)果不真實,產(chǎn)生過擬合,進而影響模型在實際應用中的泛化能力。

交叉驗證中的數(shù)據(jù)泄露

交叉驗證通過將數(shù)據(jù)集分割為多個折(fold),每次選擇其中一部分作為驗證集,其余作為訓練集,進行多次訓練和評估。

然而,在某些情況下,如果交叉驗證的過程處理不當,數(shù)據(jù)泄露就可能發(fā)生。具體表現(xiàn)如下。

1.數(shù)據(jù)預處理泄露

在交叉驗證中,如果對整個數(shù)據(jù)集(包括訓練集和驗證集)進行了數(shù)據(jù)預處理(例如歸一化、標準化、特征選擇等),那么模型在訓練過程中可能會“看到”驗證集的信息,導致評估結(jié)果偏高。

因為標準化或歸一化等處理是基于數(shù)據(jù)的統(tǒng)計特征(如均值、標準差等)計算的,如果這些統(tǒng)計特征包含了驗證集的部分信息,模型就可能通過這種信息進行優(yōu)化。

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import KFold

import numpy as np

X = np.random.randn(1000, 20)

y = np.random.randint(0, 2, 1000)

cv_scores = []

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

kf = KFold(n_splits=5)

for train_idx, val_idx in kf.split(X_scaled):

X_train, X_val = X_scaled[train_idx], X_scaled[val_idx]

y_train, y_val = y[train_idx], y[val_idx]

model = LogisticRegression()

model.fit(X_train, y_train_fold)

fold_score = accuracy_score(y_val_fold, y_pred)

cv_scores.append(fold_score)

print(f"交叉驗證平均準確度: {np.mean(cv_scores):.4f}")防范方法

在交叉驗證的每一折中,必須在訓練集上進行數(shù)據(jù)預處理操作,得到轉(zhuǎn)換參數(shù)(例如均值、標準差等),然后再用這些轉(zhuǎn)換參數(shù)對驗證集進行處理。這樣可以確保驗證集的數(shù)據(jù)不會泄漏到訓練集中。

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import cross_val_score

# Correct approach: scaling inside each fold

pipeline = Pipeline([

('scaler', StandardScaler()),

('classifier', LogisticRegression())

])

# Preprocessing happens inside each fold

scores = cross_val_score(pipeline, X, y, cv=5)

print(f"Cross-validation scores: {scores}")

print(f"Mean CV score: {scores.mean():.3f}")2.處理不平衡數(shù)據(jù)集

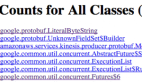

不平衡的數(shù)據(jù)集可能會導致誤導性的性能指標,因為常規(guī)的 k 折交叉驗證可能會創(chuàng)建具有不平衡類別分布的訓練集和驗證集。

這可能會導致模型性能出現(xiàn)偏差,尤其是當少數(shù)類在驗證集中代表性不足時。

為了解決這個問題,我們使用分層 K 折交叉驗證,它確保每個折疊保持與原始數(shù)據(jù)集相同的類分布。

圖片

圖片

import numpy as np

import pandas as pd

from sklearn.model_selection import StratifiedKFold

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 示例數(shù)據(jù)集

np.random.seed(42)

X = np.random.randn(100, 5) # 100個樣本,每個樣本5個特征

y = np.random.choice([0, 1], size=100, p=[0.7, 0.3]) # 目標變量,類別分布不均(70% 類別0,30% 類別1)

# 創(chuàng)建 StratifiedKFold 實例,n_splits=5 表示5折交叉驗證

skf = StratifiedKFold(n_splits=5)

# 用于存儲每一折的評估結(jié)果

accuracy_scores = []

# 循環(huán)每一折

for train_index, test_index in skf.split(X, y):

# 劃分訓練集和測試集

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 初始化并訓練模型

model = LogisticRegression(solver='liblinear')

model.fit(X_train, y_train)

# 進行預測

y_pred = model.predict(X_test)

# 計算準確率

accuracy = accuracy_score(y_test, y_pred)

accuracy_scores.append(accuracy)

# 輸出平均準確率

print(f"Average Accuracy: {np.mean(accuracy_scores):.4f}")3.時間序列交叉驗證

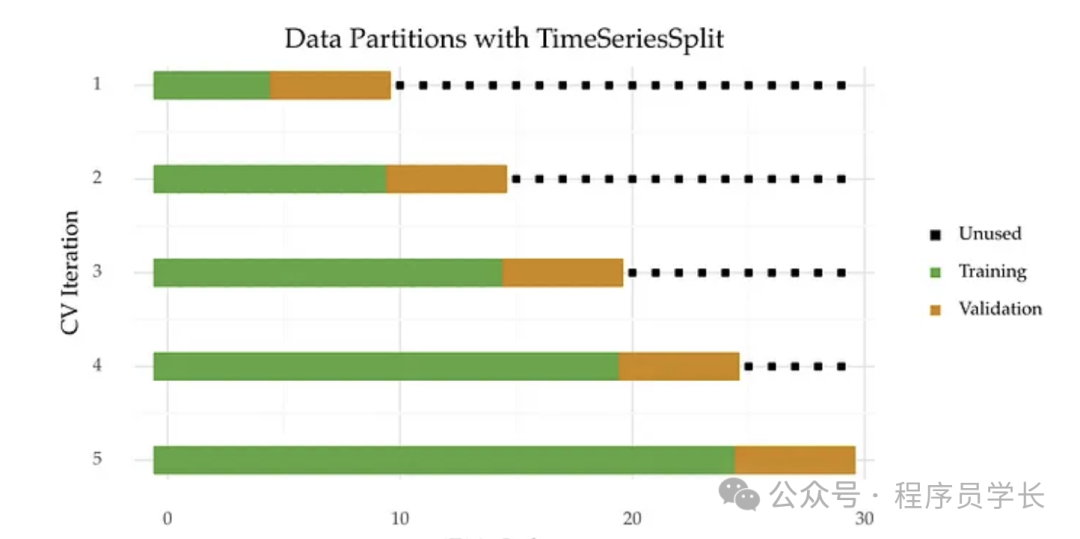

在處理時間序列數(shù)據(jù)時,常常需要遵循時間順序進行模型的訓練和驗證。

如果在交叉驗證過程中沒有正確劃分時間順序,可能導致后期的數(shù)據(jù)泄漏到前期的訓練集中。例如,使用未來的數(shù)據(jù)來訓練模型,這樣模型就能“提前看到”未來的樣本,從而產(chǎn)生不真實的評估結(jié)果。

防范方法

在時間序列的交叉驗證中,應該保持時間順序。例如,采用滑動窗口(sliding window)或擴展窗口(expanding window)等方法,確保訓練集始終在驗證集之前,避免未來信息的泄漏。

圖片

圖片

import numpy as np

import pandas as pd

from sklearn.model_selection import TimeSeriesSplit

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

# 示例時間序列數(shù)據(jù)

np.random.seed(42)

dates = pd.date_range(start='2020-01-01', periods=100, freq='D')

data = pd.DataFrame({

'date': dates,

'target': np.random.randn(100),

'feature': np.random.randn(100)

})

# 目標變量和特征

X = data[['feature']].values # 特征

y = data['target'].values # 目標變量

# 使用 TimeSeriesSplit 進行時間序列交叉驗證

tscv = TimeSeriesSplit(n_splits=5)

# 用于存儲每一折的評估結(jié)果

mse_scores = []

# 循環(huán)每一折

for train_index, test_index in tscv.split(X):

# 劃分訓練集和驗證集

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 初始化并訓練模型

model = LinearRegression()

model.fit(X_train, y_train)

# 進行預測

y_pred = model.predict(X_test)

# 計算均方誤差(MSE)

mse = mean_squared_error(y_test, y_pred)

mse_scores.append(mse)

# 輸出平均MSE

print(f"Average MSE: {np.mean(mse_scores):.4f}")4.重復數(shù)據(jù)泄露

如果數(shù)據(jù)集中存在重復的樣本,交叉驗證可能會導致某些重復樣本出現(xiàn)在訓練集和驗證集中,這樣模型就能“看到”相同的信息,從而導致數(shù)據(jù)泄漏。這種情況尤其在數(shù)據(jù)清洗時需要特別注意。

防范方法

在進行交叉驗證之前,確保數(shù)據(jù)集中的樣本沒有重復,或者采取去重操作,以避免重復樣本對評估結(jié)果的影響。

5.特征泄露

這是一種最常見的數(shù)據(jù)泄露情況,指的是訓練數(shù)據(jù)中包含了模型預測目標的直接或間接線索。例如,假設(shè)預測一個人的收入,而特征中包含了“購買豪華車”這一變量,這顯然與收入有很強的相關(guān)性。

防范方法

在設(shè)計特征時,應當仔細分析哪些特征可能與目標變量直接或間接相關(guān),避免將這些特征作為輸入。

數(shù)據(jù)泄露的后果

- 過度樂觀的評估結(jié)果

由于泄漏的信息,模型在驗證集上的表現(xiàn)看起來非常好,遠高于實際應用中的效果。 - 過擬合

模型可能過度擬合訓練數(shù)據(jù)中的泄漏信息,從而無法在真實的、未見過的數(shù)據(jù)上進行有效的泛化。 - 誤導性的決策

使用存在數(shù)據(jù)泄露的模型進行部署和決策,可能會導致不準確的預測,從而影響實際應用中的效果。

如何避免數(shù)據(jù)泄露?

- 嚴格的數(shù)據(jù)處理順序

數(shù)據(jù)預處理、特征選擇、特征工程等操作必須在每一折的訓練集上獨立進行,避免使用整個數(shù)據(jù)集的信息。 - 分清訓練集和驗證集的角色

確保訓練集和驗證集之間沒有信息共享,訓練集應僅用于訓練,驗證集僅用于評估模型的性能。 - 確保時序一致性

在時間序列任務中,保持時間順序,避免使用未來的數(shù)據(jù)來訓練模型。 - 仔細檢查特征

確保所有輸入特征都與目標變量無關(guān),避免通過目標變量間接獲取信息。 - 去除重復數(shù)據(jù)

在交叉驗證之前進行數(shù)據(jù)去重,避免重復樣本出現(xiàn)在訓練集和驗證集中。