MV-DUSt3R+: 只需2秒!Meta Reality Labs開源最新三維基座模型,多視圖大場景重建

本文一作為唐正綱,目前為博士生,就讀于伊利諾伊大學厄巴納 - 香檳分校,本科畢業于北京大學。通訊作者是嚴志程,Meta Reality Labs 高級科研研究員 (Senior Staff Research Scientist),主要研究方向包括三維基礎模型,終端人工智能 (On-device AI) 和混合現實。

近期,Fei-Fei Li 教授的 World Labs 和 Google 的 Genie 2 展示了 AI 從單圖生成 3D 世界的能力。這技術讓我們能步入任何圖像并以 3D 形式探索,預示著數字創造的新未來。

Meta 也加入了這場構建世界模型的競賽,推出并且開源了全新的世界模型構建基座模型 MV-DUSt3R+。Meta 的技術通過 Quest 3 和 Quest 3S 頭顯,快速還原 3D 場景。只需幾張照片,用戶就能在 Meta 頭顯中體驗不同的混合環境。

在這一領域,DUSt3R 曾是 SOTA 的標桿。其 GitHub 上的 5.5k star 證明了它在 3D 重建領域的影響力。然而,DUSt3R 每次只能處理兩張圖。處理更多圖時,需要使用 bundle adjustment,這非常耗時,限制了它在復雜場景上的應用。

現在,Meta Reality Labs 和伊利諾伊大學厄巴納 - 香檳分校(UIUC)推出了新工作《MV-DUSt3R+: Single-Stage Scene Reconstruction from Sparse Views In 2 Seconds》。這項研究全面提升了 DUSt3R。通過全新的多視圖解碼器塊和交叉視圖注意力塊機制,MV-DUSt3R + 可以直接從稀疏視圖中重建復雜的三維場景。而且重建只需 2 秒鐘!

MV-DUSt3R + 是由 Meta 的嚴志程團隊開發。嚴志程在 Meta 任 Senior Staff Research Scientist 一職,UIUC 博士,目前負責 Meta 的混合現實開發工作。文章的第一作者唐正綱,本科畢業于北京大學,目前在 UIUC 攻讀博士學位,專注于 3D 視覺研究。團隊其他成員在 3D 場景重建和生成模型領域也經驗豐富。

MV-DUSt3R + 的技術貢獻包括:

- 單階段場景重建:2 秒內完成復雜三維場景的重建。

- 多視圖解碼器塊:無需相機校準和姿態估計,處理任意數量的視圖。

- 交叉視圖注意力塊:增強對不同參考視圖選擇的魯棒性。

- 論文鏈接:https://arxiv.org/abs/2412.06974

- 項目主頁:https://mv-dust3rp.github.io/

- 代碼倉庫:https://github.com/facebookresearch/mvdust3r/

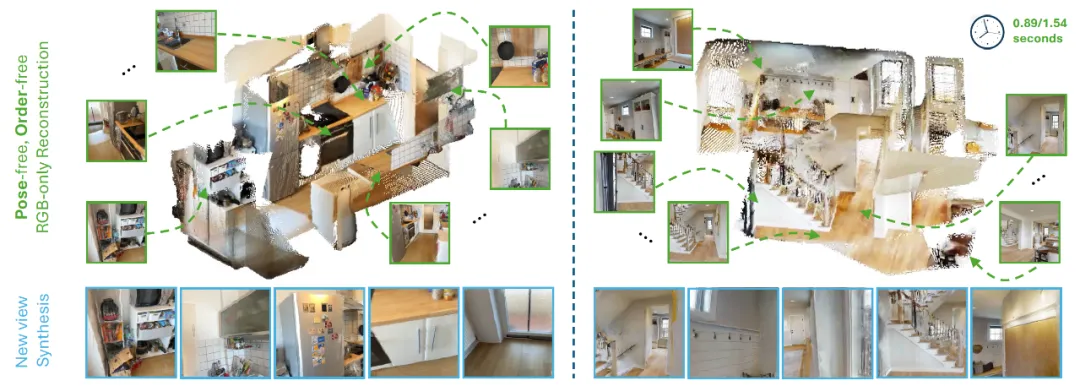

MV-DUSt3R+ 效果演示

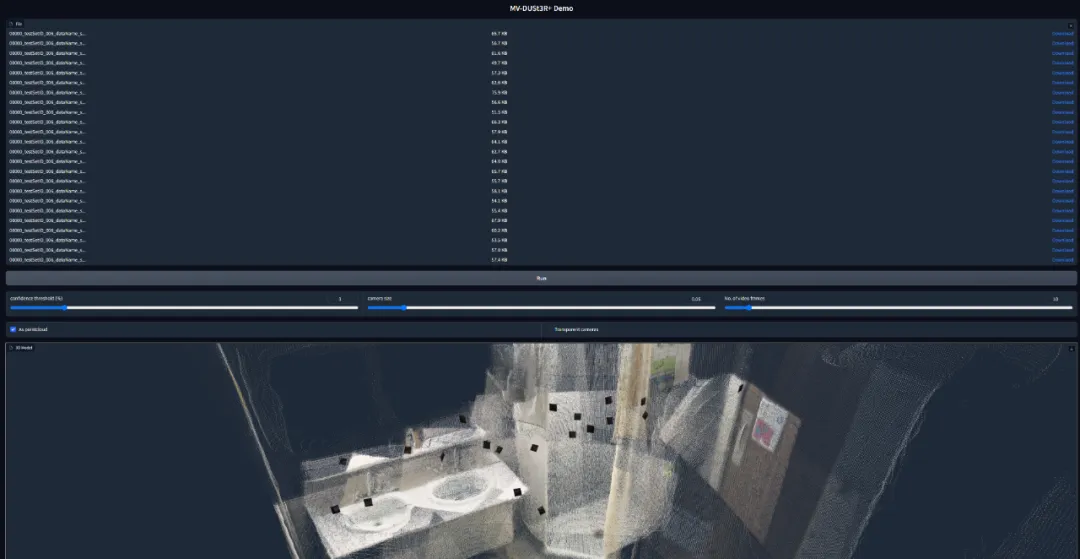

MV-DUSt3R + 的 Github 代碼倉庫里還包含一個基于 Gradio 的互動演示。用戶可以輸入多張視圖或者一個場景視頻。演示能夠顯示由 MV-DUSt3R + 重建的點云和各個輸入視圖的相機姿態。

方法概述

單階段場景重建

2 秒內完成復雜三維場景的重建。傳統方法通常采用分階段處理流程,包括相機姿態估計、局部重建,以及全局優化來對齊各個局部重建結果。這種方法不僅流程繁瑣,而且容易在多個步驟中累積誤差。此外,全局優化步驟需要大量計算資源,尤其在處理大規模場景時,計算時間往往從幾十秒延長到數分鐘,難以滿足實時應用的需求。

為了解決這些問題,MV-DUSt3R+ 提出了單階段場景重建框架,通過一次前向推理即可完成整個重建流程。這種方法完全摒棄了傳統方法中的全局優化步驟,而是通過高效的神經網絡架構直接輸出全局對齊的三維點云。

在實驗中,MV-DUSt3R+ 展現了效率優勢:在處理 12 至 24 個視角輸入時,僅需 0.89 至 1.54 秒即可完成大規模、多房間場景的重建。這一性能比傳統的 DUSt3R 方法快了 48 至 78 倍,同時在重建質量上也顯著提升。單階段的設計不僅提升了計算效率,還降低了硬件資源的消耗,為實時三維場景重建在混合現實、自動駕駛、機器人導航等領域的應用鋪平了道路。

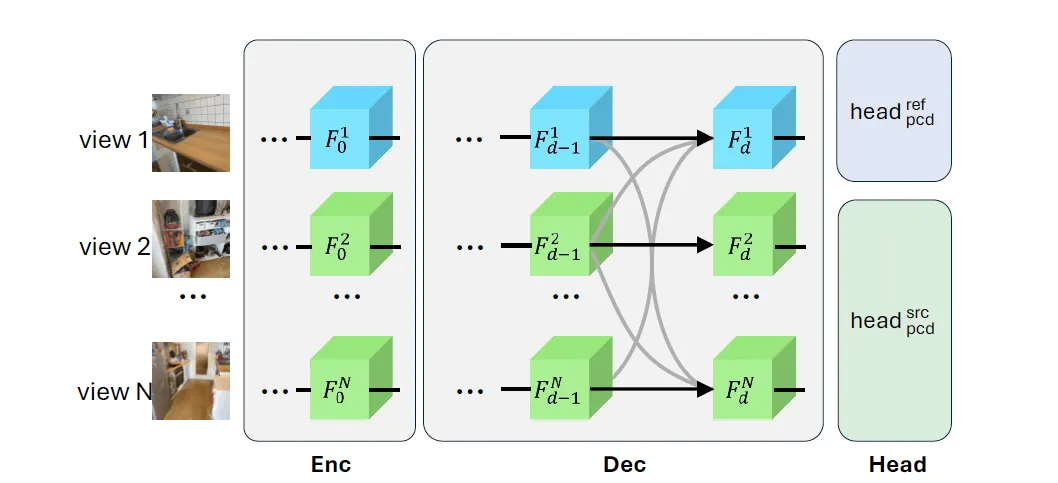

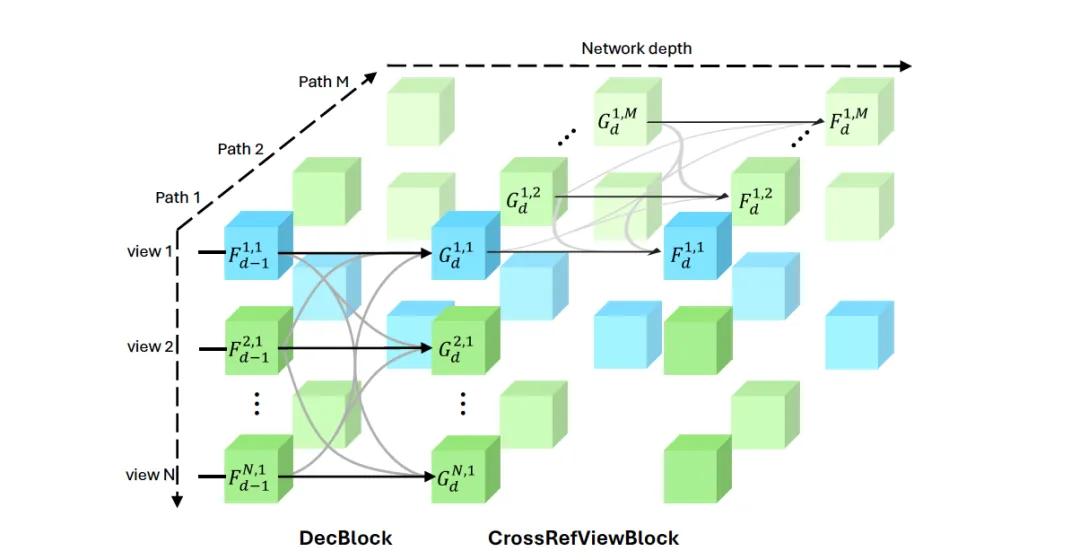

多視圖解碼器塊

無需相機校準和姿態估計,處理任意數量的視圖。在多視角重建任務中,傳統方法通常依賴于相機內參和外參的精確估計,這需要額外的相機校準步驟,增加了系統復雜性和誤差風險。

即便是一些最新的學習方法,如 DUSt3R 和 MASt3R,也只能處理兩視角重建,并需要在后續步驟中進行全局優化來對齊多視角信息。這種方法在處理大場景和稀疏視角輸入時,表現出明顯的局限性。

MV-DUSt3R+ 通過引入多視圖解碼器塊,徹底擺脫了對相機參數的依賴,能夠直接處理任意數量的視角輸入。具體來說,多視圖解碼器塊在網絡中充當信息融合的關鍵角色,通過注意力機制在參考視圖和所有其他視圖之間進行高效信息交換。

與傳統的兩視角方法不同,MV-DUSt3R+ 可以一次性處理多達 24 個視角,并在所有視角之間聯合學習空間關系。這種設計確保了重建結果在全局范圍內的一致性和準確性。

多視圖解碼器塊的設計還具有極高的靈活性:無論輸入視角數量多少,網絡都能保持高效運行,而無需重新訓練或調整參數。這使得 MV-DUSt3R+ 能夠適應各種實際應用場景,從小型單房間到大型多房間甚至室外場景,均能實現高質量的三維重建。

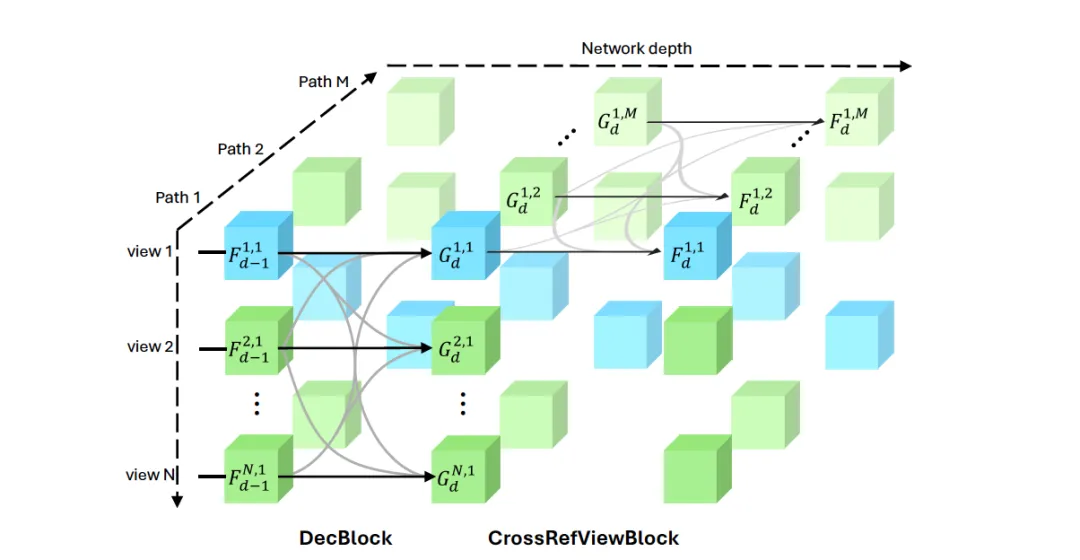

交叉視圖注意力塊

增強對不同參考視圖選擇的魯棒性。在大規模場景重建中,單一參考視圖往往無法覆蓋所有細節,特別是在視角變化較大的情況下,重建質量容易出現區域性偏差。為了克服這一挑戰,MV-DUSt3R+ 在多視圖解碼器的基礎上引入了交叉視圖注意力塊,以增強對不同參考視圖選擇的魯棒性。

交叉視圖注意力塊通過在多個參考視圖之間進行信息融合,有效緩解了單一視圖信息不足的問題。具體而言,該模塊在網絡的多個路徑中運行,每條路徑對應一個不同的參考視圖。通過在不同參考視圖路徑之間交換和融合特征,交叉視圖注意力塊能夠捕獲長距離的幾何信息,確保在大場景重建中,所有區域的重建質量都能保持一致。

這種機制的優勢在于,即使某些輸入視圖與單一參考視圖之間的立體信息較弱,也可以從其他參考視圖中獲取補充信息,從而提高整體重建精度。在實驗中,MV-DUSt3R+ 展現了出色的魯棒性:在多房間和稀疏視角設置下,重建結果的誤差顯著降低,同時在新視角合成任務中生成的圖像也更為精確,真實感更強。

主要實驗結果

大量實驗驗證了 MV-DUSt3R+ 在多視角立體重建、多視角相機位姿估計和新視圖合成任務中的性能提升。請參考文章詳細的實現細節以及表格對比,實驗結果如下所示。

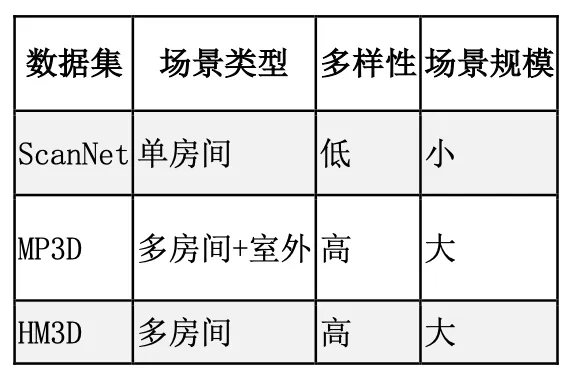

數據集

訓練數據包括 ScanNet、ScanNet++、HM3D 和 Gibson,測試數據為 MP3D、HM3D 和 ScanNet。以下為數據集特性表(表 1):

表 1: 訓練與測試數據集對比

該團隊采用與 DUSt3R 相同的訓練 / 測試劃分,訓練數據為其子集(詳見附錄)。通過隨機選擇初始幀并逐步采樣候選幀(點云重疊率在 [t_min, t_max] 范圍內),生成輸入視圖集合 {I?}。

軌跡采樣

ScanNet 和 ScanNet++ 每場景采樣 1,000 條軌跡,總計 320 萬條;HM3D 和 Gibson 每場景采樣 6,000 條,總計 780 萬條。具體實現細節請參考論文原文。

多視角立體重建

采用 Chamfer Distance (CD)、Normalized Distance (ND) 和 Distance Accuracy@0.2 (DAc) 作為評估指標。結果顯示:

- MV-DUSt3R:在 HM3D 數據集上,與 DUSt3R 相比,ND 降低 1.7 至 2 倍,DAc 提升 1.2 至 5.3 倍。隨著輸入視圖數量增加,重建質量顯著提升。

- MV-DUSt3R+:12 視圖輸入下,ND 降低 1.3 倍,DAc 提升 1.2 倍。24 視圖輸入下,ND 降低 1.6 倍,DAc 提升 1.8 倍,表現更優。

- 零樣本測試:在 MP3D 數據集上,MV-DUSt3R 和 MV-DUSt3R+ 始終優于 DUSt3R,展現了強大的泛化能力。

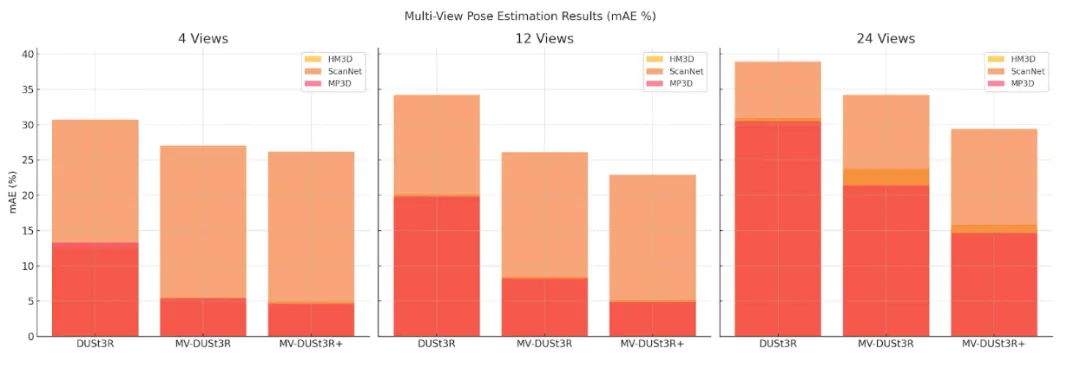

多視角相機位姿估計

MV-DUSt3R 和 MV-DUSt3R+ 在相機位姿估計中顯著優于基線。

- HM3D:MV-DUSt3R 的 mAE 相比 DUSt3R 降低 2.3 至 1.3 倍,MV-DUSt3R+ 降低 2.6 至 2.0 倍。

- 其他數據集:MV-DUSt3R+ 始終優于 DUSt3R,表現最佳。

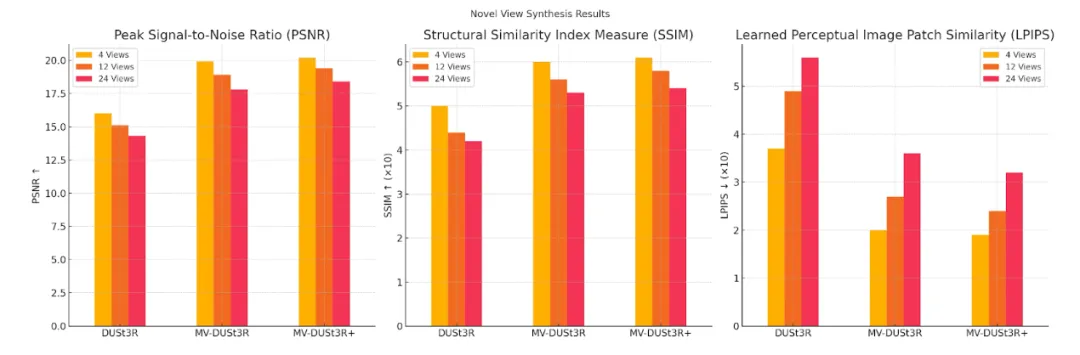

新視圖合成

該團隊采用了 PSNR、SSIM 和 LPIPS 來評估生成質量。

- PSNR:MV-DUSt3R+ 在所有視圖設置下表現最佳,顯著提升重建質量。

- SSIM:MV-DUSt3R+ 結構相似性最高,隨著視圖增加視覺保真度進一步提高。

- LPIPS:MV-DUSt3R+ 感知誤差最低,生成的新視圖最接近真實圖像。

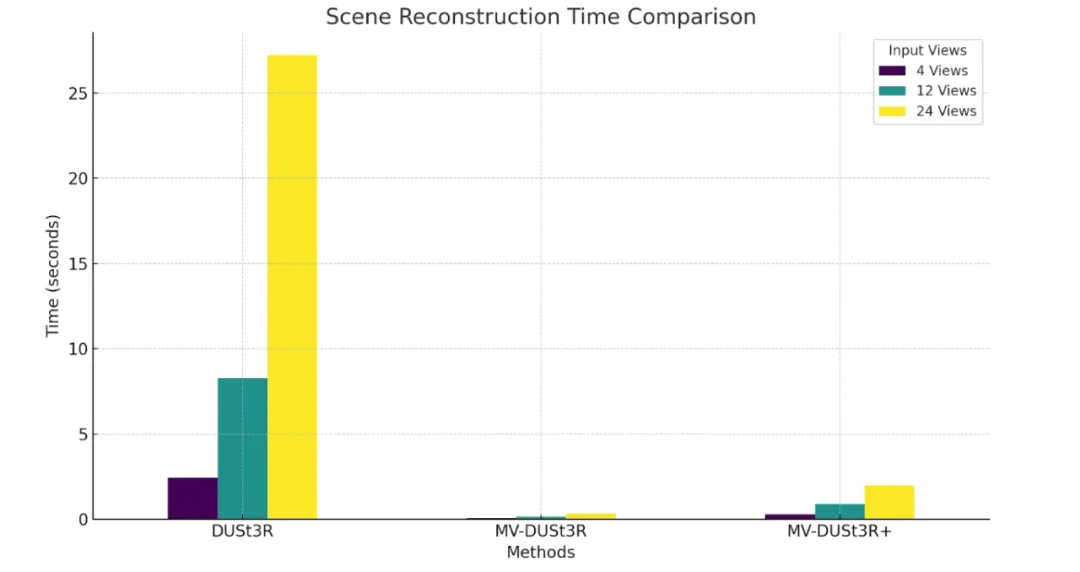

場景重建時間

MV-DUSt3R+ 的單階段網絡在 GPU 上運行,無需全局優化(GO),顯著減少了重建時間。

- MV-DUSt3R+:在 24 視圖輸入下,僅需 1.97 秒,速度比 DUSt3R 快 14 倍。

- MV-DUSt3R:時間更短,僅需 0.35 秒,比 DUSt3R 快 78 倍。

- DUSt3R:重建時間明顯更長,24 視圖輸入需 27.21 秒。

MV-DUSt3R+ 在不到 2 秒內即可完成大場景重建,展現出卓越的效率與實用性。

總結和開放討論

最近一年以來,三維基座模型的新工作層出不窮,包括三維重建(比如 DUSt3R, MASt3R, MASt3R-SfM)和三維生成(比如 World Labs 3D Gen, Stability AI Stable Point Aware 3D)。

這些工作在模型創新上和實際效果上都取得了令人印象深刻的進步,使得三維感知和生成技術更容易在混合現實,自動駕駛,大規模數字城市這些領域被廣泛應用。

在這些工作當中,MV-DUSt3R + 憑借其簡潔有效的模型設計,快速的推理,不依賴于相機參數的先驗知識和顯著提高的重建質量脫穎而出,正在學界和開源社區獲得越來越廣泛的關注。

作者簡介

唐正綱:伊利諾伊大學厄巴納 - 香檳分校博士生,本科畢業于北京大學。研究方向是三維視覺,場景重建,變換和編輯。

嚴志程: Meta 高級科研研究員,博士畢業于美國伊利諾伊大學厄巴納 - 香檳分校,本科畢業于浙江大學。主要研究方向包括三維基礎模型,終端人工智能 (On-device AI) 和混合現實。

范雨晨: Meta 科研研究員,博士畢業于美國伊利諾伊大學厄巴納 - 香檳分校。研究方向包括三維生成,視頻理解和圖像復原。

Dilin Wang: Meta 科研研究員,博士畢業于美國得克薩斯大學奧斯汀分校。研究方向包括場景感知和三維生成。

許弘宇:Meta 科研研究員,博士畢業于美國馬里蘭大學。研究方向包括混合現實和視覺感知。

Alexander Schwing: 副教授,現任教于美國伊利諾伊大學厄巴納 - 香檳分校,博士畢業于瑞士蘇黎世理工學院。主要研究方向包括深度學習中的預測和學習,多變量結構化分布,以及相關應用。

Rakesh Ranjan: Meta 人工智能研究主任(Research Director),主管混合現實和三維生成。