全面超越OccWorld!Occ-LLM:Occ世界模型再度問鼎SOTA

寫在前面&出發點

大語言模型(LLMs)在機器人和自動駕駛領域取得了重大進展。本研究提出了首個基于占用的大語言模型(Occ-LLM),這是將大語言模型與一種重要表示方式相結合的開創性嘗試。為了有效地將占用信息編碼為大語言模型的輸入,并解決與占用相關的類別不平衡問題,研究提出了運動分離變分自編碼器(MS-VAE)。這種創新方法利用先驗知識,在將動態對象和靜態場景輸入定制的變分自編碼器(VAE)之前進行區分。這種分離增強了模型專注于動態軌跡的能力,同時有效地重建靜態場景。Occ-LLM在關鍵任務中的有效性得到了驗證,包括4D占用預測、自車規劃和基于占用的場景問答。綜合評估表明,Occ-LLM顯著優于現有的最先進方法,在4D占用預測任務中,交并比(IoU)提高了約6%,平均交并比(mIoU)提高了4%。這些發現凸顯了Occ-LLM在重塑機器人和自動駕駛當前范式方面的變革潛力。

行業介紹

大語言模型發展迅速,已成為推動各行業人工智能發展的重要力量。最初為自然語言處理設計的大語言模型,因其強大的泛化能力,在自動駕駛等復雜領域也展現出了卓越的適應性。這些能力對于目前缺乏泛化性的機器人或自動駕駛系統而言至關重要。當前,大語言模型在自動駕駛中的應用主要基于圖像輸入,但這種方式缺乏全面理解環境所需的空間感知能力。現有的基于視覺和基于激光雷達的方法,雖然增強了車輛導航和環境理解能力,但計算成本高,且中間推理過程往往缺乏透明度。

在自動駕駛中,占用是一種極具表現力的模態,它通過全面表示場景的前景和背景,提供豐富的空間和語義信息。這種通用表示方式有助于感知物體,無論其具體類別是已知還是未知。值得注意的是,像特斯拉這樣的領先汽車制造商,正逐步在其車輛中采用基于占用的系統,這凸顯了向這種強大的環境解釋方法的轉變。

我們旨在利用大語言模型復雜的分析和泛化能力,開發一種用于自動駕駛各種下游任務的基礎模型,以解釋和利用占用網格。然而,將占用表示直接集成到大語言模型中具有挑戰性,這是由于占用類別不平衡,以及代表空氣的體素占主導地位,導致學習效率低下和內存問題。為了克服這些挑戰,提出了一種名為運動分離變分自編碼器(MS-VAE)的新方法。該方法將占用場景中與可移動物體(如汽車、行人)相關的體素,與不可移動結構(如街道、綠植)相關的體素分離。這樣做增強了模型對動態對象軌跡的關注,并改善了靜態場景的重建,類似于殘差學習。這種分離顯著降低了學習難度,提高了模型的整體性能。

基于占用的大語言模型(Occ-LLM)經過精心設計,可滿足自動駕駛領域的多種應用需求。該模型的主要應用包括4D占用場景預測、自車規劃和基于占用的場景問答,這些應用對于提高自動駕駛系統的安全性、效率和可靠性至關重要。為了驗證模型的有效性,研究人員進行了廣泛的評估,將Occ-LLM與其他最先進的方法進行比較。結果顯示,Occ-LLM性能卓越,在4D占用場景預測中,IoU達到32.52%,mIoU達到20.99%,顯著優于最先進模型(其IoU為26.63%,mIoU為17.14%,3秒平均值)。在自車規劃方面,該模型將3秒平均L2距離降至0.28米,而領先的替代模型為1.17米。此外,在基于占用的場景問答中,Occ-LLM始終能提供準確可靠的回答,從而增強了自動駕駛系統的決策能力。

主要貢獻如下:

- 引入了用于自動駕駛的基于占用的大語言模型Occ-LLM,展示了卓越的場景理解能力。

- 提出運動分離變分自編碼器MS-VAE,通過區分可移動和不可移動元素來管理大量占用網格數據,在各項指標上提升了系統性能。

- 通過在4D占用場景預測、自車規劃和基于占用的場景問答中的應用,展示了Occ-LLM的多功能性,說明了其在自動駕駛多個維度上的優越性。

- 通過接入現有的占用預測方法,展示了Occ-LLM的泛化能力,說明了其在自動駕駛中的實用性。

相關工作

1)多模態大語言模型

多模態大語言模型的最新進展引發了廣泛關注,它將大語言模型的先進推理能力與圖像、視頻和音頻數據相結合。這些模型在零樣本和少樣本圖像分類、分割和目標檢測等任務中表現出色,充分利用了視覺和文本數據之間的協同作用。在自動駕駛領域,大語言模型彌補了關鍵差距,增強了場景理解能力,提供了更豐富的語義上下文,并促進了當前系統所缺乏的決策過程。已經有幾種方法被提出,以在自動駕駛中利用大語言模型。基于視覺的方法,如DriveGPT4,通過解釋視頻輸入生成與駕駛相關的文本響應;而像HiLM-D這樣的模型,則通過高分辨率視覺數據增強危險識別和意圖預測能力。基于激光雷達的方法利用矢量化視覺嵌入,賦予大語言模型環境感知能力,實現對駕駛場景的詳細分析。

2)占用網絡

近年來,3D語義占用通過明確建模3D網格內每個體素的占用狀態,提供了對環境更詳細的表示。SSCNet率先引入語義場景補全任務,整合了幾何和語義信息。隨后的研究通常利用具有明確深度信息的幾何輸入。MonoScene提出了第一種用于語義場景補全的單目方法,使用3D UNet來處理通過視線投影生成的體素特征。基于轉移架構設計了各種網絡。此外,一些同期研究專注于提出用于3D語義占用預測的環視基準,推動了占用領域的快速發展。OccWorld基于3D占用學習世界模型,因其可解釋性和效率備受關注。這里嘗試以大語言模型為橋梁,統一占用任務。

Occ-LLM方法

Occ-LLM框架將大語言模型與占用表示相結合,以改進自動駕駛系統。該框架增強了空間和語義理解能力,有助于場景解釋和決策制定。首先使用現有方法將多視圖圖像轉換為占用表示。下面首先介紹核心的運動分離變分自編碼器MS-VAE,它能夠區分動態和靜態元素,降低計算負載并提高學習效率。MS-VAE的輸出經過進一步處理和展平,輸入到大語言模型中。Occ-LLM專為各種自動駕駛任務設計,支持4D占用預測、自車規劃和基于占用的場景問答,提高了自動駕駛的安全性和有效性。

1)運動分離變分自編碼器

基于已有的多模態大語言模型集成方法,研究旨在訓練一個變分自編碼器,以促進模態融合并降低計算成本。將占用表示直接集成到大語言模型中面臨挑戰,因為占用類別不平衡,且空氣體素占主導,導致數據表示稀疏且低效。為了克服這一問題,研究提出了運動分離變分自編碼器MS-VAE,它可以分離占用網格中的動態和靜態組件。這提高了編碼效率,并將重點轉移到對自主導航至關重要的動態元素上。因此,MS-VAE能夠更平衡、有效地集成到大語言模型框架中。

MS-VAE的核心概念是訓練兩個不同的VQ-VAEs,分別對移動和靜態占用體素進行編碼和解碼。不過研究發現,使用兩個不同的codebook分別處理移動和靜態體素,同時保持單個編碼器和解碼器,也能獲得令人滿意的結果。為了清晰闡述,用數學公式描述該方法。

設表示輸入的占用表示,和分別表示移動和靜態體素。編碼器將輸入映射到潛在空間。對于MS-VAE,為移動和靜態體素定義兩個單獨的潛在變量和:

每個編碼后的潛在變量和在相應的codebook和中搜索,并在輸入解碼器之前,被最相似的codebook entry替換。這個過程表示為:

解碼器從量化后的潛在變量和重建輸入:

為了便于在占用表示中分離運動和靜態元素,基于體素的分類進行變換。設表示可移動類別的集合。在修改后的占用表示中,定義運動和空氣填充的指示函數如下:

定義指示函數,使得:

如果否則

則修改后的運動占用和靜態占用為:

其中,air表示靜態占用網格中空氣的表示,通常編碼為代表未占用空間的占位值。

為了重建原始占用表示,利用來區分活動運動區域。重建后的占用將靜態和運動組件組合如下:

訓練MS-VAE的總體損失函數結合了重建損失和承諾損失,以確保編碼后的潛在變量接近codebook entries:

通過為移動和靜態體素使用單獨的codebook,同時保持統一的編碼器和解碼器,并適當地處理占用表示,MS-VAE有效地捕捉了每種體素類型的獨特特征,從而改善了占用重建和泛化能力。

此外,整體VAE架構參考了OccWorld實現中的方法,具體將占用視為具有16個通道的2D數據,并使用2D VAE進行編碼和解碼。然而,為了保留三維信息的完整性,在編碼器之前和解碼器之后都集成了一層輕量級3D卷積。這種修改尊重了占用表示固有的空間維度,顯著提高了重建占用的質量。與傳統使用2D VAE相比,這種方法顯著提高了占用表示在三維空間中的保真度。

2)占用與大語言模型集成的預處理

Patchify:使用MS-VAE對原始占用表示進行編碼后,得到的潛在表示仍然很大。為了解決這個問題,采用類似于視覺Transformer(ViT)的方法,將占用潛在空間劃分為小網格并展平。研究發現,path大小對占用重建質量有顯著影響。這是因為預測未來占用幀涉及感知和低級視覺任務。例如,感知任務通常受益于較大的patch大小,有助于更好地理解輸入數據的語義信息;相反,低級視覺任務通常采用較小的patch大小,以實現更高質量的數據重建。通過消融研究確定,patch大小為10時可獲得最佳結果。

幀分離:研究發現,每個幀展平后的占用潛在表示相對較長,直接連接多個幀展平后的占用潛在表示會導致生成的占用出現位置漂移。這種漂移表現為一個幀的部分占用出現在后續幀中,從而造成級聯錯位。為了解決這個問題,提出了一個簡單但有效的解決方案:在每個占用潛在幀的開頭和結尾添加特定的文本標記。具體來說,在開頭使用“”,在結尾使用“”。這些標記在推理時界定了幀之間的間隔,有效地消除了漂移問題。

預融合:引入一種預融合方法,以更好地建立占用表示與自車動作之間的聯系。該方法首先通過多個MLP層對自車動作進行編碼。類似于SE-Net的方法,然后使用編碼后的動作潛在變量作為權重,對占用特征進行調制。這種技術增強了占用表示與自車動作之間的一致性,提高了模型的整體性能。

3)下游任務

Occ-LLM框架支持多種對增強自動駕駛系統至關重要的下游任務,包括4D占用預測、自車規劃和基于占用的場景問答。任務切換通過特定提示進行管理:“<4-D occupancy forecasting and self-ego planning>”啟動4D占用預測和自車規劃的組合任務,而“”觸發問答任務。這些任務共同增強了態勢感知和決策能力。4D占用預測用于預測環境動態,這對于預測危險至關重要。自車規劃利用這些預測實現安全、高效的導航。基于占用的場景問答用于解釋復雜情況,有助于做出明智的決策。這些能力共同顯著提高了自動駕駛系統的安全性、可靠性和效率。

實驗分析

我們展示了一系列廣泛的實驗,以評估所提出的Occ-LLM的性能。研究使用Llama2作為基礎模型。使用交并比(IoU)和平均交并比(mIoU)指標評估4D占用預測。使用L2距離指標評估自車規劃能力。

采用Nuscenes數據集,該數據集包含1000個場景。這些場景分為700個用于訓練,150個用于驗證,150個用于測試。每個場景包含大約50幀,對應一個占用場景。占用表示的維度為(200, 200, 16),其中前兩個維度(200, 200)代表長度和寬度,16代表高度。這種數據集配置能夠在各種場景下全面評估和驗證模型的性能。

1)與最先進方法的比較

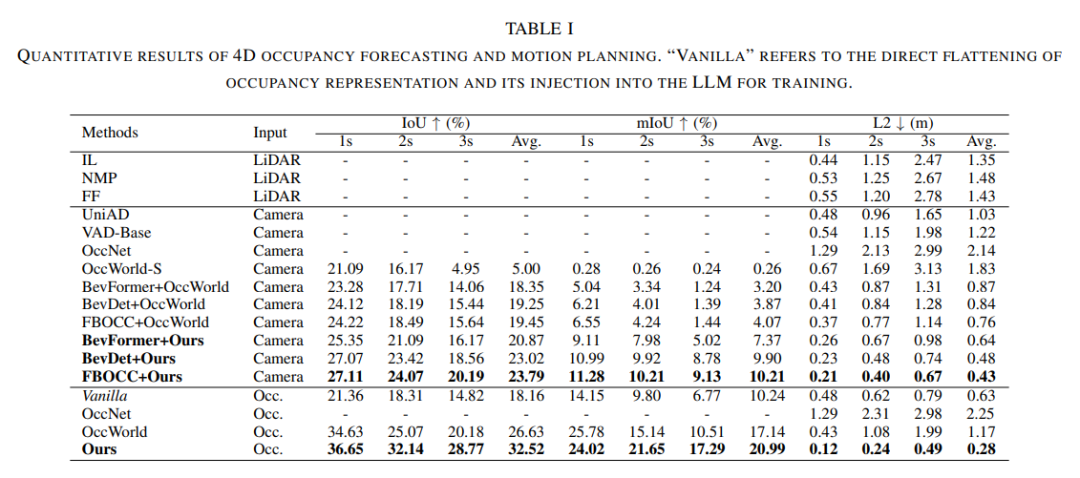

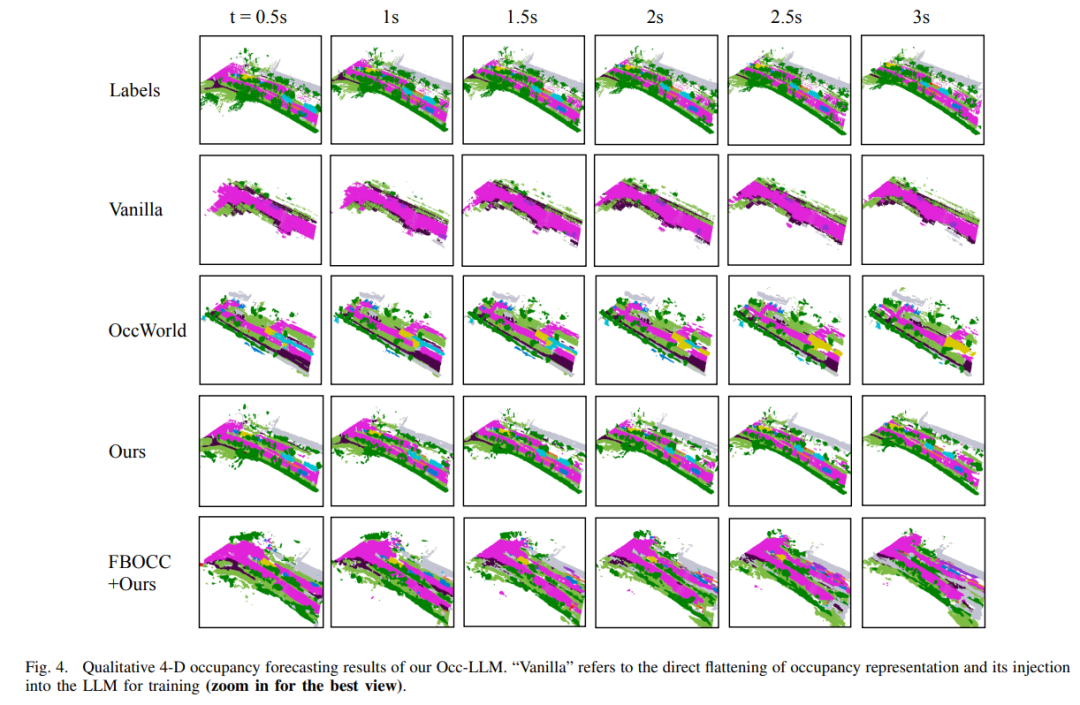

4D占用預測和自車規劃:表1將研究方法與4D占用預測和運動規劃領域的最先進方法進行了比較,提供了1秒、2秒和3秒間隔的IoU、mIoU和L2距離等指標。研究方法在準確性和一致性方面始終優于最先進方法。

評估的方法包括基于激光雷達的方法,如IL、NMP和FF,以及基于攝像頭的方法,如UniAD、VAD-Base和OccNet。研究還將預測的占用數據集成到Occ-LLM框架中,像BevFormer+Ours這樣的模型實現了更高的性能,平均IoU達到23.79%,mIoU達到10.21%,L2距離為0.43米。

與基于占用的方法相比,研究方法超越了OccWorld,平均IoU達到32.52%,mIoU達到20.99%,L2距離為0.28米,展示了在自動駕駛中更高的準確性和可靠性。

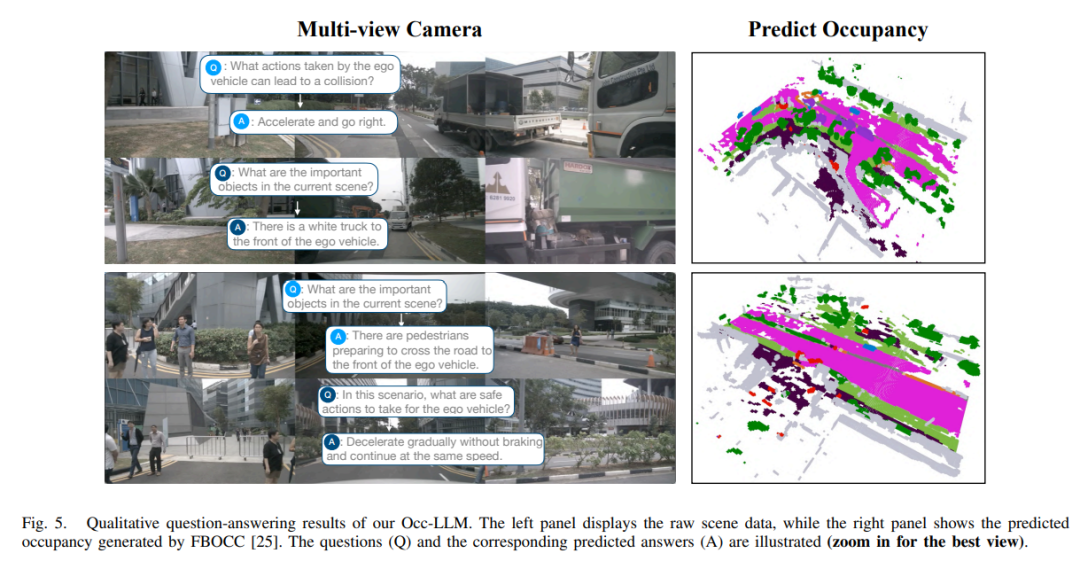

問答:研究提出的方法展示了專為自動駕駛場景定制的先進問答能力。如圖5所示,該系統有效地解釋多視圖相機輸入,以預測占用情況,并對有關駕駛環境的查詢提供準確響應。它可以識別場景中的關鍵對象,為自車推薦安全的操作,并描述潛在的危險,如準備過馬路的行人。

為了定量評估系統的性能,使用標準指標(即BLEU、ROUGE L、CIDEr和GPT Score),將該系統與DriveLM模型進行了對比評估。研究模型在所有指標上均優于DriveLM,獲得了更高的分數。這些結果證實了研究方法在自動駕駛環境中提供準確且上下文相關答案的有效性。

2)消融研究

OccWorld的VAE與MS-VAE的對比分析:表3比較了OccWorld的VAE與研究提出的MS-VAE,結果顯示MS-VAE在重建性能上有顯著提升。添加3D卷積層和運動分離策略提高了IoU和mIoU,MS-VAE的IoU達到62.74%,mIoU達到71.08%,而OccWorld的VAE分別為59.07%和60.50%。

Patchify中不同patch大小的對比分析:表4研究了不同patch大小對重建性能的影響。patch大小為10時表現最佳,在訓練集上IoU為32.48%,mIoU為26.16%,在驗證集上IoU為27.12%,mIoU為26.83%,能夠在細節捕捉和效率之間取得平衡。

Occ-LLM模塊的消融研究:表5展示了Occ-LLM模塊的消融研究。基線模型的IoU為20.