大模型擴(kuò)展新維度:Scaling Down、Scaling Out

本文由悉尼大學(xué)計(jì)算機(jī)學(xué)院王云柯,李言蹊和徐暢副教授完成。王云柯是悉尼大學(xué)博士后,李言蹊是悉尼大學(xué)三年級博士生,徐暢副教授是澳洲ARC Future Fellow,其團(tuán)隊(duì)長期從事機(jī)器學(xué)習(xí)算法、生成模型等方向的研究。

近年來, Scaling Up 指導(dǎo)下的 AI 基礎(chǔ)模型取得了多項(xiàng)突破。從早期的 AlexNet、BERT 到如今的 GPT-4,模型規(guī)模從數(shù)百萬參數(shù)擴(kuò)展到數(shù)千億參數(shù),顯著提升了 AI 的語言理解和生成等能力。然而,隨著模型規(guī)模的不斷擴(kuò)大,AI 基礎(chǔ)模型的發(fā)展也面臨瓶頸:高質(zhì)量數(shù)據(jù)的獲取和處理成本越來越高,單純依靠 Scaling Up 已難以持續(xù)推動(dòng) AI 基礎(chǔ)模型的進(jìn)步。

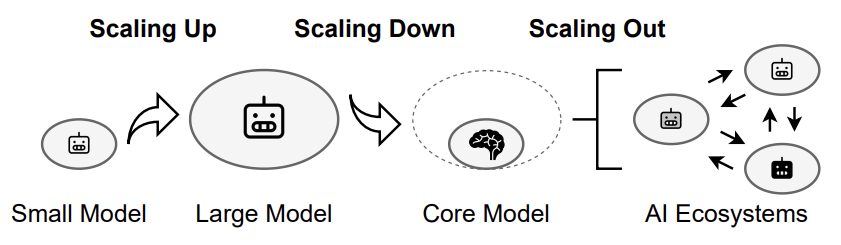

為了應(yīng)對這些挑戰(zhàn),來自悉尼大學(xué)的研究團(tuán)隊(duì)提出了一種新的 AI Scaling 思路,不僅包括 Scaling Up(模型擴(kuò)容),還引入了 Scaling Down(模型精簡)和 Scaling Out(模型外擴(kuò))。Scaling Down 通過優(yōu)化模型結(jié)構(gòu),使其更輕量、高效,適用于資源有限的環(huán)境,而 Scaling Out 則致力于構(gòu)建去中心化的 AI 生態(tài)系統(tǒng),讓 AI 能力更廣泛地應(yīng)用于實(shí)際場景。

- 論文標(biāo)題:AI Scaling: From Up to Down and Out

- 論文鏈接:https://www.arxiv.org/abs/2502.01677

該框架為未來 AI 技術(shù)的普及和應(yīng)用提供了新的方向。接下來,本文將詳細(xì)探討這一框架如何推動(dòng) AI Scaling 從集中化走向分布式,從高資源消耗走向高效普及,以及從單一模型衍生 AI 生態(tài)系統(tǒng)。

Scaling Up: 模型擴(kuò)容,持續(xù)擴(kuò)展基礎(chǔ)模型

Scaling Up 通過增加數(shù)據(jù)規(guī)模、模型參數(shù)和計(jì)算資源,使 AI 系統(tǒng)的能力得到了顯著提升。然而,隨著規(guī)模的不斷擴(kuò)大,Scaling Up 也面臨多重瓶頸。數(shù)據(jù)方面,高質(zhì)量公開數(shù)據(jù)已被大量消耗,剩余數(shù)據(jù)多為低質(zhì)量或 AI 生成內(nèi)容,可能導(dǎo)致模型性能下降。模型方面,參數(shù)增加帶來的性能提升逐漸減弱,大規(guī)模模型存在冗余、過擬合等問題,且難以解釋和控制。計(jì)算資源方面,訓(xùn)練和推理所需的硬件、能源和成本呈指數(shù)級增長,環(huán)境和經(jīng)濟(jì)壓力使得進(jìn)一步擴(kuò)展變得不可持續(xù)。

盡管面臨挑戰(zhàn),規(guī)模化擴(kuò)展仍是推動(dòng) AI 性能邊界的關(guān)鍵。未來的趨勢將聚焦于高效、適應(yīng)性和可持續(xù)性的平衡:

數(shù)據(jù)優(yōu)化:通過課程學(xué)習(xí)、主動(dòng)學(xué)習(xí)等技術(shù),利用更小規(guī)模的高質(zhì)量數(shù)據(jù)集實(shí)現(xiàn)高效訓(xùn)練。同時(shí),處理噪聲數(shù)據(jù)和利用領(lǐng)域?qū)S袛?shù)據(jù)將成為突破點(diǎn)。

高效訓(xùn)練:采用漸進(jìn)式訓(xùn)練、分布式優(yōu)化和混合精度訓(xùn)練等方法,減少資源消耗,提升訓(xùn)練效率,推動(dòng) AI 開發(fā)的可持續(xù)性。

Test-Time Scaling:通過在推理階段動(dòng)態(tài)分配計(jì)算資源,提升模型性能。例如,自適應(yīng)輸出分布和驗(yàn)證器搜索機(jī)制使小型模型在某些任務(wù)上超越大型模型,為高效 AI 提供了新方向。

AI Scaling Up 的未來不僅在于「更大」,更在于「更智能」和「更可持續(xù)」。通過優(yōu)化數(shù)據(jù)、訓(xùn)練和推理流程,AI 有望在突破性能邊界的同時(shí),實(shí)現(xiàn)更廣泛的應(yīng)用和更低的環(huán)境成本。

Scaling Down: 模型精簡,聚焦核心模塊

隨著 Scaling Up 所需的訓(xùn)練、部署和維護(hù)計(jì)算資源、內(nèi)存和能源成本急劇增加,一個(gè)關(guān)鍵問題浮出水面:如何在縮小模型規(guī)模的同時(shí),保持甚至提升其性能?Scaling Down 旨在減少模型規(guī)模、優(yōu)化計(jì)算效率,同時(shí)保持核心能力,使 AI 適用于更廣泛的資源受限場景,如邊緣設(shè)備和移動(dòng)端應(yīng)用。

技術(shù)基礎(chǔ)

1. 減少模型規(guī)模:剪枝,通過移除神經(jīng)網(wǎng)絡(luò)中不重要的部分來簡化模型;量化,將浮點(diǎn)參數(shù)替換為整數(shù),減少權(quán)重和激活的比特寬度;知識蒸餾,將大型復(fù)雜模型的知識遷移到小型高效模型中。

2. 優(yōu)化計(jì)算效率:投機(jī)采樣,通過近似模型生成候選詞,再由目標(biāo)模型并行驗(yàn)證,加速推理過程;KV Caching,存儲注意力機(jī)制的中間狀態(tài),避免重復(fù)計(jì)算;混合專家模型,通過任務(wù)特定的子模型和門控機(jī)制實(shí)現(xiàn)高效擴(kuò)展。例如,DeepSeek-V3 通過專家模型的選擇性激活,顯著降低推理過程中的計(jì)算成本。

未來這一領(lǐng)域的研究可能聚焦以下方向。首先,核心功能模塊的提煉將成為重點(diǎn)。未來的研究將致力于識別大型模型中的關(guān)鍵功能模塊,力求在保留核心功能的前提下,最大限度地減少冗余結(jié)構(gòu)。通過系統(tǒng)化的剪枝和知識蒸餾技術(shù),開發(fā)出更精細(xì)的模型架構(gòu)優(yōu)化方法,從而在縮小規(guī)模的同時(shí)不損失性能。

其次,外部輔助增強(qiáng)將為小模型提供新的能力擴(kuò)展途徑。例如,檢索增強(qiáng)生成(RAG)技術(shù)通過結(jié)合預(yù)訓(xùn)練的參數(shù)化記憶和非參數(shù)化記憶,使模型能夠動(dòng)態(tài)獲取上下文相關(guān)信息;而工具調(diào)用技術(shù)則讓小模型學(xué)會自主調(diào)用外部 API,甚至生成自己的工具以應(yīng)對復(fù)雜任務(wù)。

Scaling Out: 模型外擴(kuò),構(gòu)建 AI 生態(tài)系統(tǒng)

在 Scaling Up 和 Scaling Down 之后,文章提出 Scaling Out 作為 AI Scaling 的最后一步,其通過將孤立的基礎(chǔ)模型擴(kuò)展為具備結(jié)構(gòu)化接口的專業(yè)化變體,將其轉(zhuǎn)化為多樣化、互聯(lián)的 AI 生態(tài)系統(tǒng)。在該生態(tài)系統(tǒng)中,接口負(fù)責(zé)連接專業(yè)化模型與用戶、應(yīng)用程序和其他 AI 系統(tǒng)。這些接口可以是簡單的 API,也可以是能夠進(jìn)行多輪推理和決策的 Agent。

通過結(jié)合基礎(chǔ)模型、專用變體和接口,Scaling Out 構(gòu)建了一個(gè)動(dòng)態(tài)的 AI 生態(tài)系統(tǒng),包含多個(gè) AI 實(shí)體在其中交互、專業(yè)化并共同提升智能。這一生態(tài)促進(jìn)了協(xié)作,能夠?qū)崿F(xiàn)大規(guī)模部署,并不斷拓展 AI 的能力,標(biāo)志著 AI 向開放、可擴(kuò)展、去中心化的智能基礎(chǔ)架構(gòu)轉(zhuǎn)變。

技術(shù)基礎(chǔ)

1. 參數(shù)高效微調(diào):傳統(tǒng)的微調(diào)需要大量計(jì)算資源,但參數(shù)高效微調(diào)技術(shù)如 LoRA 允許在不修改整個(gè)模型的情況下添加任務(wù)特定知識。

2. 條件控制:使基礎(chǔ)模型能夠動(dòng)態(tài)適應(yīng)多種任務(wù),而無需為每個(gè)任務(wù)重新訓(xùn)練。例如,ControlNet 通過結(jié)構(gòu)引導(dǎo)生成上下文感知圖像。

3. 聯(lián)邦學(xué)習(xí):支持在分布式設(shè)備上協(xié)作訓(xùn)練 AI 模型,確保數(shù)據(jù)隱私和安全。聯(lián)邦學(xué)習(xí)允許在多樣化、領(lǐng)域特定的數(shù)據(jù)集上訓(xùn)練專業(yè)化子模型,增強(qiáng)其適應(yīng)能力。

未來這一領(lǐng)域的研究可能聚焦于以下方向。首先,去中心化 AI 和區(qū)塊鏈 。AI 模型商店將像應(yīng)用商店一樣提供多樣化模型,區(qū)塊鏈則作為信任層,確保安全性、透明性和知識產(chǎn)權(quán)保護(hù)。每一次微調(diào)、API 調(diào)用或衍生模型創(chuàng)建都將被記錄在不可篡改的賬本上,確保信用歸屬和防止未經(jīng)授權(quán)的修改。其次,邊緣計(jì)算與分布式智能。邊緣計(jì)算在本地設(shè)備上處理數(shù)據(jù),減少對集中式數(shù)據(jù)中心的依賴。結(jié)合聯(lián)邦學(xué)習(xí),邊緣計(jì)算能夠在保護(hù)隱私的同時(shí),實(shí)現(xiàn)實(shí)時(shí)決策和分布式智能。

應(yīng)用場景設(shè)想

人機(jī)共創(chuàng)社區(qū)如 TikTok 等,將迎來智能內(nèi)容創(chuàng)作的新紀(jì)元。內(nèi)容創(chuàng)作者不再僅限于人類,AI 驅(qū)動(dòng)的 Bots 將成為重要組成部分。這些 Bots 能夠自主生成高質(zhì)量短視頻,與其他用戶互動(dòng),甚至彼此協(xié)作,推動(dòng)內(nèi)容創(chuàng)作的多樣性與復(fù)雜性。

Scaling Up 是整個(gè)體系的基石,通過整合 TikTok 全球用戶的多模態(tài)數(shù)據(jù),開發(fā)出強(qiáng)大的多模態(tài)基礎(chǔ)模型,為 Bots 提供內(nèi)容生成、互動(dòng)和創(chuàng)意的核心能力。然而,僅靠一個(gè)巨型模型難以滿足多樣化需求,Scaling Down 將基礎(chǔ)模型的核心能力提煉為輕量化模塊,使 AI Bots 能夠高效、靈活地執(zhí)行任務(wù),降低計(jì)算成本并適應(yīng)多樣化場景部署。

最終,Scaling Out 將 TikTok 推向智能生態(tài)的全新高度。通過任務(wù)驅(qū)動(dòng)的生成機(jī)制,平臺能夠快速擴(kuò)展出數(shù)以萬計(jì)的專用 Bots,每個(gè) Bot 都針對特定領(lǐng)域(如教育、娛樂、公益)進(jìn)行了深度優(yōu)化。這些 Bots 不僅可以單獨(dú)運(yùn)行,還能通過協(xié)作網(wǎng)絡(luò)共享知識,構(gòu)建實(shí)時(shí)進(jìn)化的內(nèi)容網(wǎng)絡(luò),為用戶提供無窮無盡的創(chuàng)意和互動(dòng)體驗(yàn)。

挑戰(zhàn)與機(jī)遇

此外,文中探討了 AI Scaling 在跨學(xué)科合作、量化標(biāo)準(zhǔn)、開放生態(tài)、可持續(xù)性和公平性方面的機(jī)遇與難點(diǎn)。

AI Scaling 需要跨學(xué)科合作,結(jié)合認(rèn)知科學(xué)、神經(jīng)科學(xué)、硬件工程和數(shù)據(jù)科學(xué),提升計(jì)算效率和適應(yīng)性。同時(shí),需要建立量化標(biāo)準(zhǔn),例如評估模型大小、計(jì)算成本與性能的關(guān)系,為 AI 發(fā)展提供清晰的參考。

開放生態(tài)是 AI Scaling 發(fā)展的關(guān)鍵,輕量級核心模型和開放 API 可以促進(jìn) AI 在醫(yī)療、農(nóng)業(yè)、工業(yè)等行業(yè)的落地應(yīng)用。為了實(shí)現(xiàn)可持續(xù)發(fā)展,Scaling Down 通過輕量化 AI 減少能耗,Scaling Out 則通過分布式和多接口擴(kuò)展,降低對數(shù)據(jù)中心的依賴,從而提升全球可及性。

最終,AI Scaling 將為通用人工智能(AGI)奠定基礎(chǔ)。Scaling Up 提供基礎(chǔ)知識,Scaling Down 提高適應(yīng)性,Scaling Out 構(gòu)建開放、去中心化的 AI 生態(tài)系統(tǒng),該系統(tǒng)中的不同接口相互協(xié)同,共同應(yīng)對復(fù)雜挑戰(zhàn)。