從o1-mini到DeepSeek-R1,萬字長文帶你讀懂推理模型的歷史與技術(shù)

自 OpenAI 發(fā)布 o1-mini 模型以來,推理模型就一直是 AI 社區(qū)的熱門話題,而春節(jié)前面世的開放式推理模型 DeepSeek-R1 更是讓推理模型的熱度達(dá)到了前所未有的高峰。

近日,Netflix 資深研究科學(xué)家 Cameron R. Wolfe 發(fā)布了一篇題為「揭秘推理模型」的深度長文,詳細(xì)梳理了自 o1-mini 開始至今的推理模型發(fā)展史,并詳細(xì)介紹了讓標(biāo)準(zhǔn) LLM 變成推理模型的具體技術(shù)和方法。

機(jī)器之心編譯了這篇文章以饗讀者,同時(shí)我們還在文末梳理了 17 篇我們之前發(fā)布的與推理模型相關(guān)的文章一并奉上。

原文地址:https://cameronrwolfe.substack.com/p/demystifying-reasoning-models

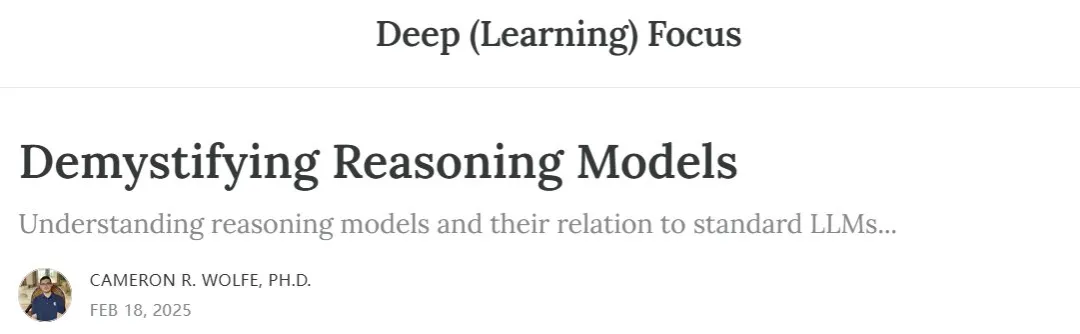

前些年,大型語言模型(LLM)已經(jīng)形成了相對(duì)固定的流程。

首先,在來自互聯(lián)網(wǎng)的原始文本數(shù)據(jù)上預(yù)訓(xùn)練語言模型。之后,對(duì)齊這些模型,也就是讓它們的輸出更符合人類的偏好,這會(huì)用到監(jiān)督微調(diào)(SFT)和基于人類反饋的強(qiáng)化學(xué)習(xí)(RLHF)等技術(shù)。

不管是預(yù)訓(xùn)練還是對(duì)齊,都對(duì)模型質(zhì)量至關(guān)重要,但驅(qū)動(dòng)這一范式發(fā)展的大部分動(dòng)力卻來自 Scaling Law—— 使用更多數(shù)據(jù)訓(xùn)練更大的模型,就能得到更好的結(jié)果。

標(biāo)準(zhǔn) LLM 的訓(xùn)練流程

標(biāo)準(zhǔn) LLM 的訓(xùn)練流程

近段時(shí)間,LLM 研究中出現(xiàn)了一個(gè)全新的范式:推理。與標(biāo)準(zhǔn) LLM 相比,推理模型解決問題的方式完全不同。特別是,它們?cè)谔峁﹩栴}的最終答案之前會(huì)花費(fèi)一些時(shí)間「思考」。訓(xùn)練能夠有效思考(例如,分解問題、檢測(cè)思維中的錯(cuò)誤、探索替代解決方案等)的模型需要新的策略,通常涉及大規(guī)模強(qiáng)化學(xué)習(xí)(RL)。此外,此類模型還會(huì)為通過強(qiáng)化學(xué)習(xí)和推理進(jìn)行訓(xùn)練的范式涌現(xiàn)出新的 Scaling Law。

來自 [4]

本文將介紹有關(guān)推理模型的最新進(jìn)展的更多信息。首先,我們將重點(diǎn)介紹 OpenAI 最早提出的幾種(封閉式)推理模型。我們將在上下文中解釋 LLM 推理能力的基本思想。之后,我們將探索最近提出的(開放式)推理模型,概述從頭開始創(chuàng)建此類模型的必要細(xì)節(jié)。推理模型與標(biāo)準(zhǔn) LLM 不同。但不用擔(dān)心。LLM 的許多關(guān)鍵概念仍然適用于推理模型。我們將在整個(gè)過程中澄清它們之間的重要區(qū)別。

推理時(shí)代

就在 AI 發(fā)展看起來要放緩之際,推理模型開始普及,LLM 的能力開始陡然提升。OpenAI 首先發(fā)布了 o1-preview [4],隨后是一系列蒸餾版(更小)模型,包括 o1-mini 以及 o3 的一些變體版本。其它公司也紛紛跟進(jìn),包括谷歌的 Gemini 2.0 Flash Thinking。這一節(jié)將探討這些最早的封閉式推理模型及其工作原理背后的基本思想。

最早的推理模型:o1 和 o1-mini

OpenAI 發(fā)布 o1-preview [4, 5] 時(shí)明確了兩件事:

- 推理模型可以非常準(zhǔn)確地解決可驗(yàn)證的任務(wù),比如數(shù)學(xué)和編程任務(wù)。

- 推理模型解決這些問題的方法與傳統(tǒng) LLM 的方法截然不同。

長思維鏈。推理模型與標(biāo)準(zhǔn) LLM 的主要區(qū)別在于在回答問題之前會(huì)進(jìn)行「思考」。推理模型的思考就是 LLM 輸出的長思維鏈(有時(shí)也被稱為推理跡線或軌跡)。長思維鏈的生成方式與任何其他文本序列無異。然而,這些推理軌跡表現(xiàn)出了非常有趣的特性 —— 它們更類似于搜索算法而不是原始文本生成。舉個(gè)例子,推理模型可能會(huì):

- 仔細(xì)考慮復(fù)雜問題的每個(gè)部分。

- 將復(fù)雜問題分解為更小的可解決部分。

- 批評(píng)其自身的(部分)解決方案并發(fā)現(xiàn)錯(cuò)誤。

- 探索許多替代解決方案。

有關(guān)這些推理軌跡的一些具體示例,請(qǐng)參閱 OpenAI 博客:https://openai.com/index/learning-to-reason-with-llms/

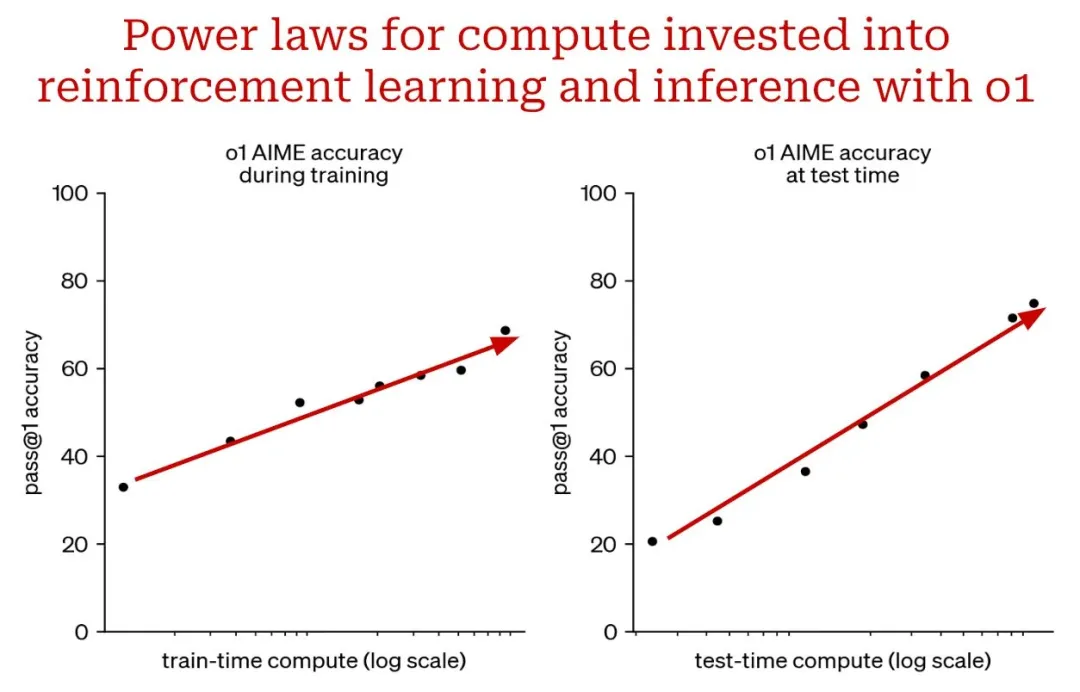

值得注意的是,OpenAI 推理模型使用的長思維鏈隱藏在其內(nèi)部,這意味著在與模型交互時(shí),用戶看不見它們。用戶只能看到模型編寫的長思維鏈摘要,如下所示:

推理模型的長思維鏈輸出為我們提供了一種控制 LLM 推理時(shí)間計(jì)算的簡(jiǎn)單方法。如果我們想花費(fèi)更多計(jì)算來解決問題,我們可以簡(jiǎn)單地生成更長的思維鏈。同樣,不太復(fù)雜的問題可以用較短的思維鏈解決,從而節(jié)省推理時(shí)間的計(jì)算。

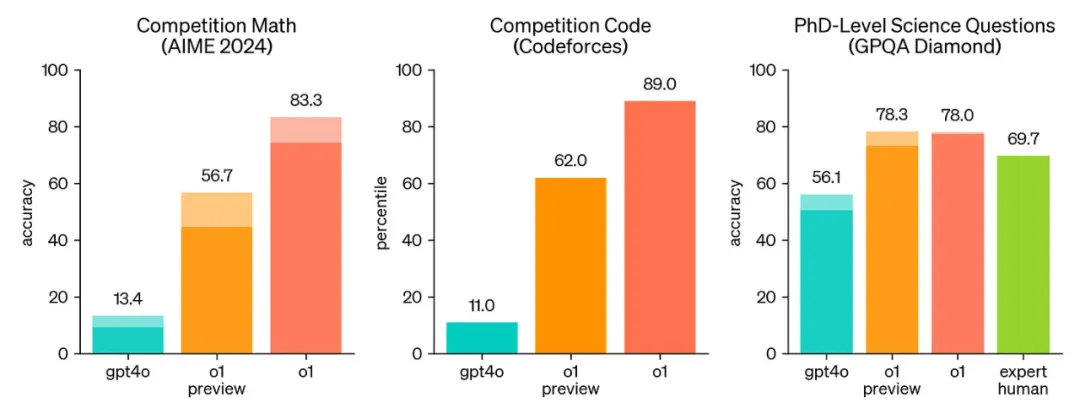

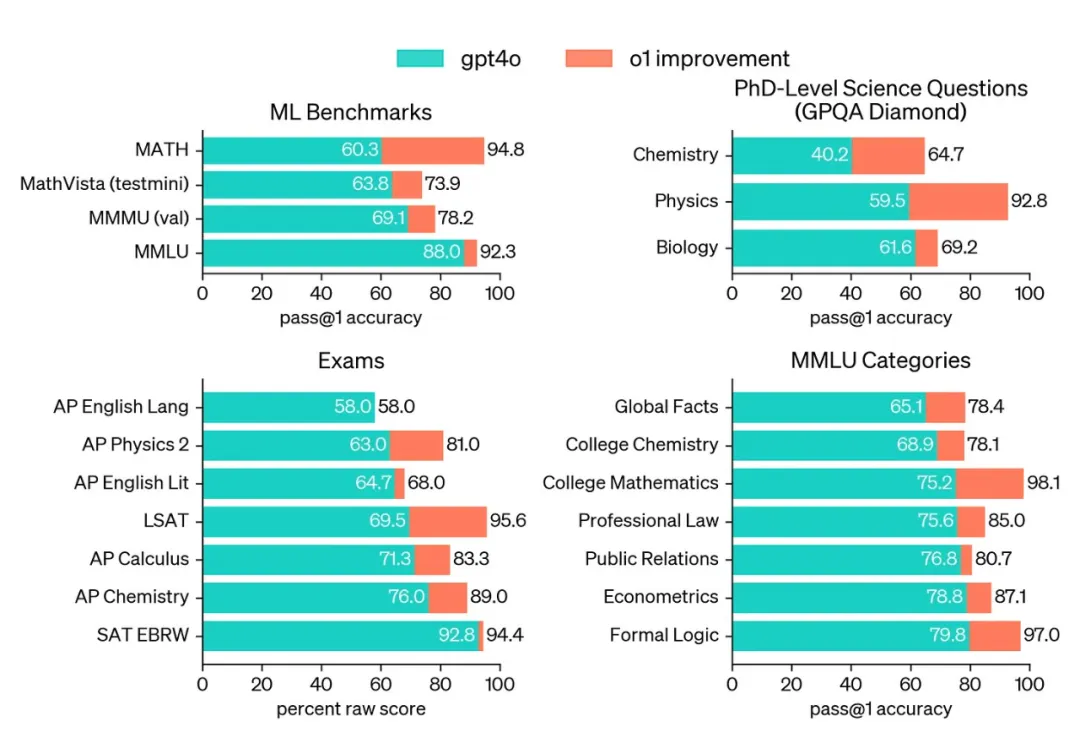

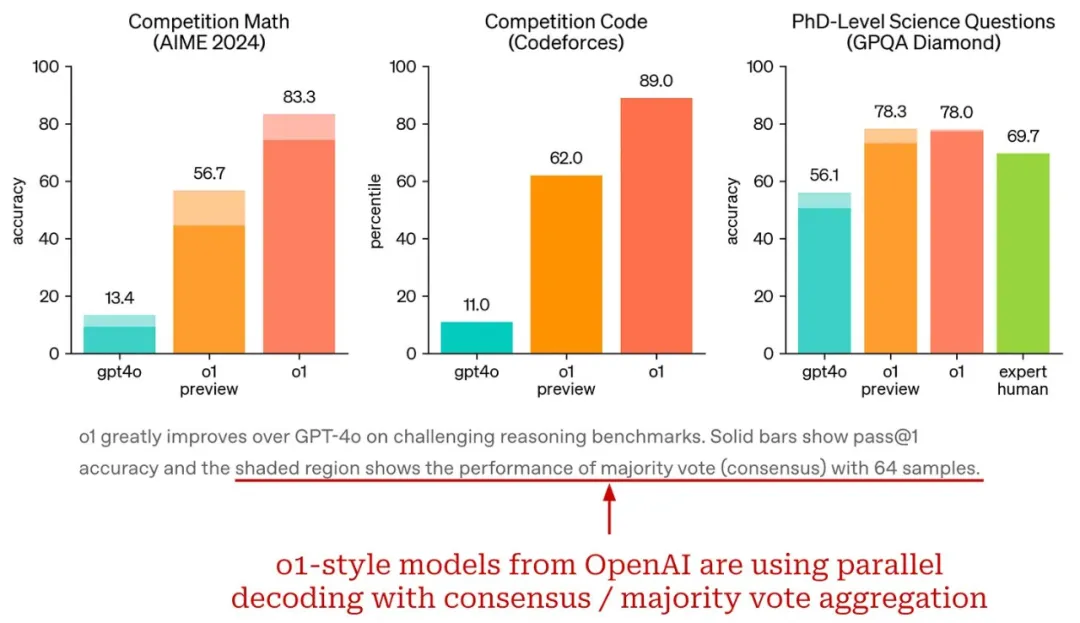

推理能力。最初的推理模型實(shí)際上在許多方面都不如標(biāo)準(zhǔn) LLM,但它們將 LLM 的推理能力提高了幾個(gè)數(shù)量級(jí)。例如,o1-preview 的推理表現(xiàn)總是優(yōu)于 GPT-4o,甚至在大多數(shù)復(fù)雜推理任務(wù)上能與人類專家的表現(xiàn)相媲美。為了實(shí)現(xiàn)這些結(jié)果,o1-preview 使用最大化的推理時(shí)間計(jì)算以及 i) 單個(gè)輸出樣本(柱狀圖主干)或 ii) 64 個(gè)并行輸出樣本中的多數(shù)投票(柱狀圖增高部分)進(jìn)行評(píng)估。

o1 系列模型與 GPT-4o 在多個(gè)推理任務(wù)上的比較,來自 [5]

o1-preview 之后,OpenAI 的 o1(preview 發(fā)布幾個(gè)月后發(fā)布的 o1 的完整版本)在美國數(shù)學(xué)奧林匹克資格考試(AIME 2024)中名列前 500 名,在 Codeforces 上排名在競(jìng)賽人類程序員的第 11 個(gè)百分位之內(nèi)。作為參考,GPT-4o 僅解決了 12% 的 AIME 問題,而 o1 解決了 74% 到 93% 的問題,具體取決于推理設(shè)置。有關(guān) o1 和 GPT-4o 性能的更詳細(xì)比較,請(qǐng)參見下圖。

o1 明顯優(yōu)于 GPT-4o(來自 [5])

同樣,o1-mini(o1 的更便宜、更快的版本)也具有令人印象深刻的推理能力,不過相比于完整版 o1 模型,其成本降低了 80%。雖然與 o1 相比,o1-mini 的世界知識(shí)有限,但它在編程任務(wù)方面尤其出色,而且考慮到其效率,其表現(xiàn)非常出色。

當(dāng)前最佳的推理模型:o3 和 o3-mini

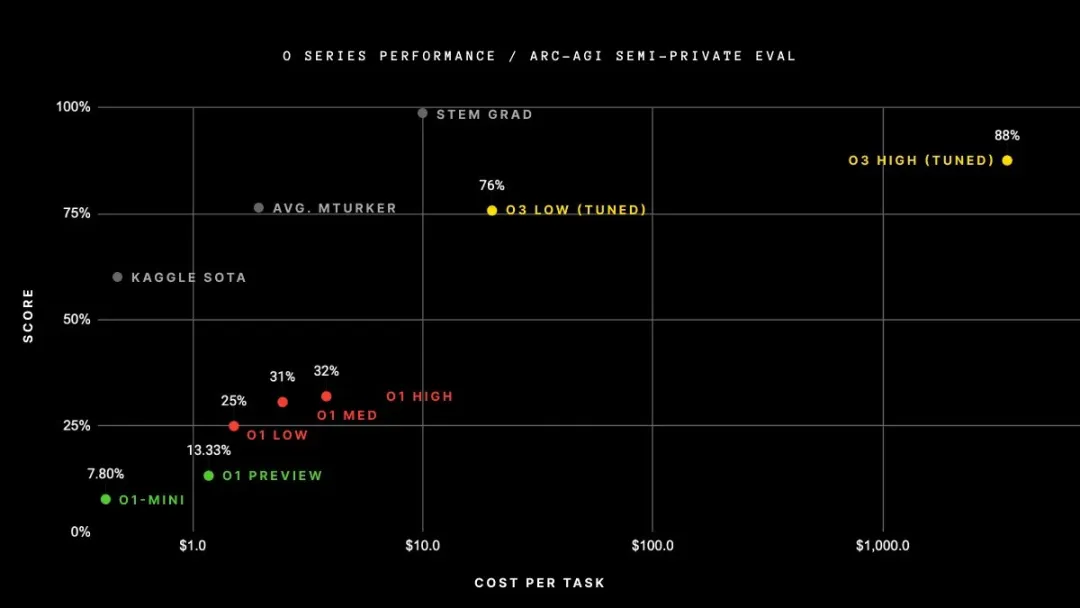

OpenAI o3 在 ARC-AGI 上的性能

在宣布和發(fā)布 o1 模型后不久,OpenAI 宣布了 o3——o1 系列中最新的模型。這個(gè)模型最初只是宣布(未發(fā)布)。我們能夠在幾個(gè)值得注意的基準(zhǔn)上看到該模型的性能(由 OpenAI 測(cè)量),但實(shí)際上無法使用該模型。OpenAI 發(fā)布的指標(biāo)非常驚人。事實(shí)上,o3 的表現(xiàn)讓很多人感到震驚。o3 最顯著的成就是:

- 在 ARC-AGI 基準(zhǔn)測(cè)試中得分為 87.5%——AGI 的「北極星」,五年來一直保持不敗 ——GPT-4o 的準(zhǔn)確率為 5%。o3 是第一個(gè)在 ARC-AGI 上超過人類水平 85% 的模型。

- 在 SWE-Bench Verified 上的準(zhǔn)確率為 71.7%,在 Codeforces 上的 Elo 得分為 2727,使 o3 躋身全球前 200 名競(jìng)爭(zhēng)性程序員之列。

- 在 EpochAI 的 FrontierMath 基準(zhǔn)測(cè)試中的準(zhǔn)確率為 25.2%,相比之前最佳的 2.0% 的準(zhǔn)確率大幅提高。

然而,公眾無法訪問 o3 模型來驗(yàn)證任何這些結(jié)果。在撰寫本文時(shí),完整的 o3 模型仍未發(fā)布,但 OpenAI 最近發(fā)布了該模型的較小版本 ——o3-mini [6]。

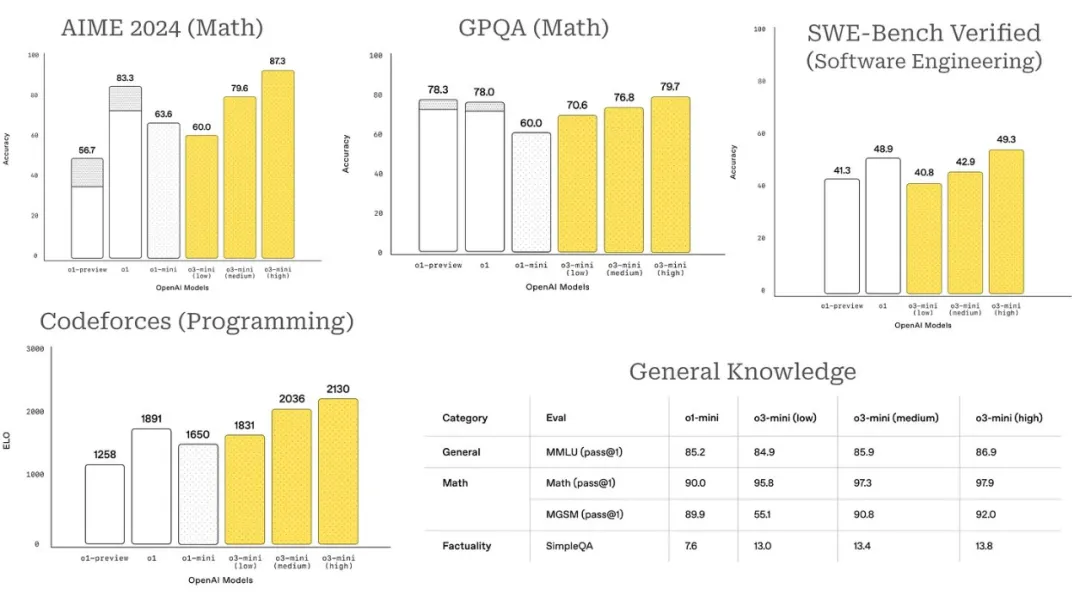

與 OpenAI 的其他推理模型相比,o3-mini 更具成本效益且更易于投入生產(chǎn)。例如,此模型支持函數(shù)調(diào)用、Web 搜索和結(jié)構(gòu)化輸出等功能。o3-mini 還具有多種設(shè)置,包括 low、medium 和 high,這指定了用于解決問題時(shí)執(zhí)行的推理量。此設(shè)置可以直接在 API 請(qǐng)求中指定,并且該模型的表現(xiàn)非常驚人 —— 在許多情況下與 o1 相當(dāng),具體取決于推理工作量的級(jí)別。

o3-mini 性能詳情(來自 [6])

在大多數(shù)情況下,推理工作量 low 的 o3-mini 與 o1-mini 的性能相當(dāng),而推理工作量 high 的 o3-mini 的性能則超過 OpenAI 發(fā)布的所有其他推理模型(包括完整版 o1 模型)。

與之前的推理模型相比,o3-mini 還具有更好的世界知識(shí)(即提高了事實(shí)性),效率明顯更高,并且在人類偏好研究中得分更高。特別是,[6] 中提到,在內(nèi)部 A/B 測(cè)試期間,「o3-mini 的響應(yīng)速度比 o1-mini 快 24%,平均響應(yīng)時(shí)間為 7.7 秒,而 o3-mini 為 10.16 秒。」o3-mini 是 OpenAI 的 o1 式推理模型中(迄今為止)發(fā)布的最高效的模型。

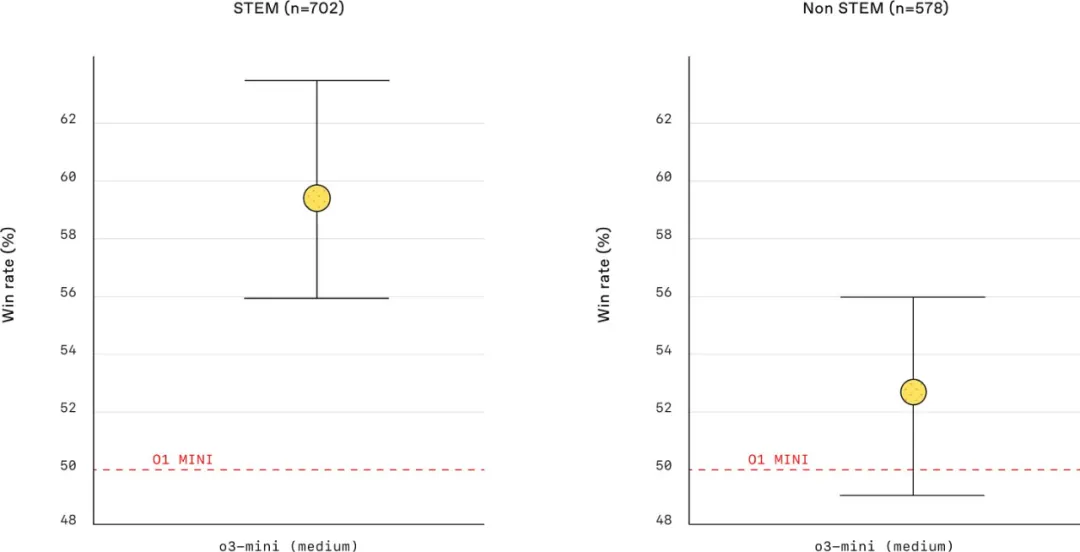

o3-mini 與 o1-mini 在 STEM / 非 STEM 提示詞上的勝率(來自 [6])

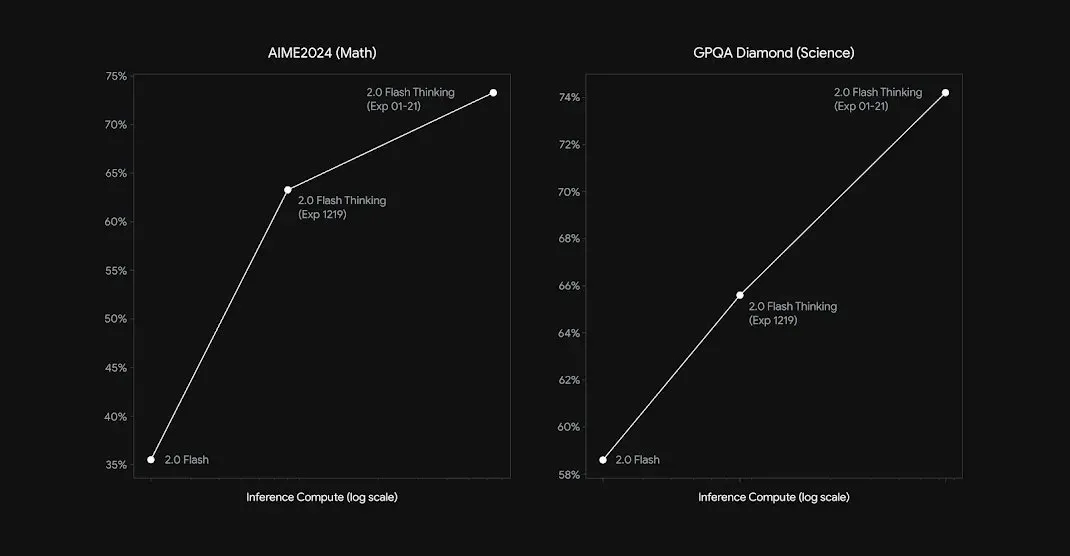

其它模型提供方。OpenAI 發(fā)布 o1 式模型后,其他模型提供方也迅速跟進(jìn)。例如,谷歌最近發(fā)布了實(shí)驗(yàn)性的 Gemini-2.0 Flash Thinking,它保留了 Gemini 模型的標(biāo)志性長上下文 ——1M token 上下文窗口,并在關(guān)鍵可驗(yàn)證任務(wù)(例如 AIME 和 GPQA)上取得了可觀的指標(biāo)。然而,這個(gè)模型的性能仍然落后于 o1 和 o3-mini。

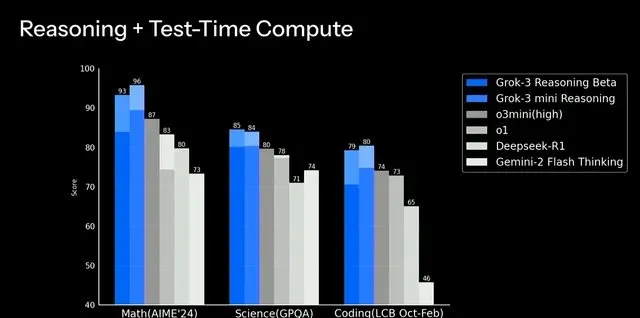

最近,Grok-3 的推理測(cè)試版發(fā)布,非常引人注目。如下所示,Grok-3 推理模型在 high 推理工作量下超過了 o3-mini 的性能,甚至在少數(shù)情況下接近完整的 o3 模型;例如,AIME'24 的準(zhǔn)確率為 96%,而 o3 的準(zhǔn)確率為 97%。使用大型新計(jì)算集群進(jìn)行訓(xùn)練的 Grok-3 令人印象深刻(尤其是考慮到 xAI 的年輕)。在撰寫本文時(shí),Grok-3 的推理測(cè)試版是與 OpenAI 推理模型最接近的競(jìng)爭(zhēng)對(duì)手。

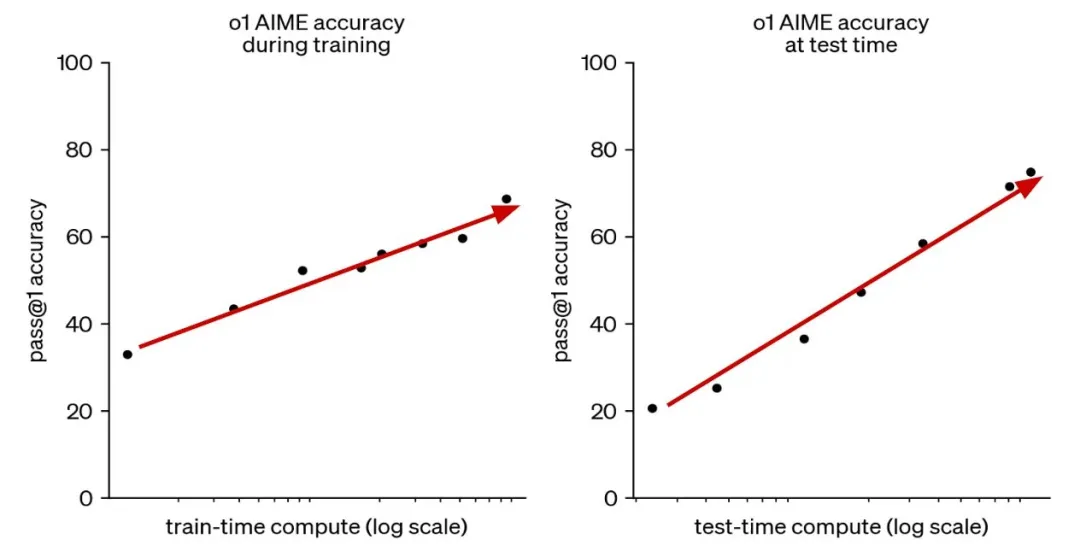

推理模型的基準(zhǔn)

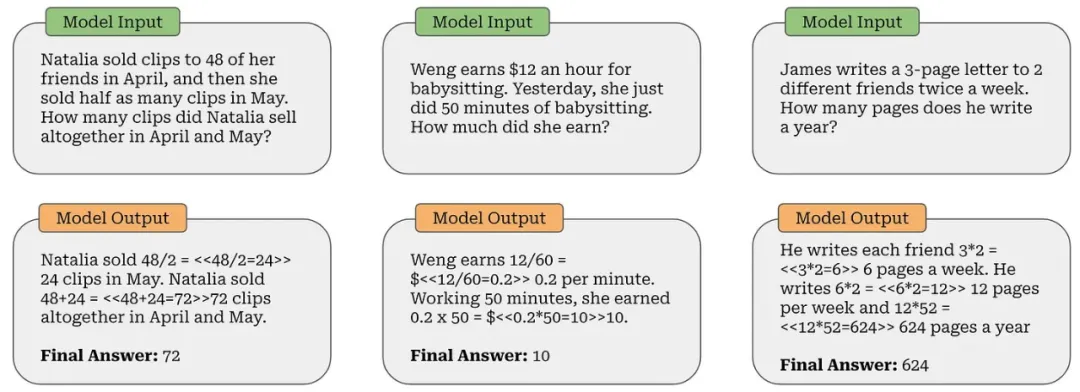

在進(jìn)一步了解推理模型的工作原理之前,讓我們更深入地了解它們的性能。要真正了解這些模型的能力,我們需要做的不僅僅是查看指標(biāo) —— 我們需要檢查這些模型正在解決的問題的具體示例。例如,考慮 GSM8K(如下所示),這是一個(gè)小學(xué)水平的數(shù)學(xué)基準(zhǔn)。這些問題可能看起來微不足道,但 LLM 們多年來一直在努力準(zhǔn)確地解決這個(gè)基準(zhǔn)。

GSM8K 中的示例問題

隨著推理模型的出現(xiàn),這個(gè)基準(zhǔn)已經(jīng)完全飽和 —— 我們不再能用它來有意義地評(píng)估最佳推理模型。相反,我們開始用 LLM 解決更難的問題。

AIME 2024 中的示例問題

例如,考慮 AIME 2024 中的第 15 個(gè)問題,如上所示。這個(gè)問題相當(dāng)復(fù)雜,超過了 GSM8K 中的算術(shù)推理問題。有(至少)六種不同的方法可以解決這個(gè)問題,所有這些方法都需要掌握高級(jí)數(shù)學(xué)技巧(例如導(dǎo)數(shù)、數(shù)論或拉格朗日乘數(shù))。

此外,推理模型正在解決的復(fù)雜基準(zhǔn)還不僅僅是數(shù)學(xué)!例如,GPQA [7] 包含來自多個(gè)科學(xué)領(lǐng)域的數(shù)百道多項(xiàng)選擇題;例如,生物學(xué)、物理學(xué)和化學(xué)。所有這些問題都是由領(lǐng)域?qū)<揖帉懙模?jīng)過驗(yàn)證,它們既非常困難,又無法通過互聯(lián)網(wǎng)搜索找到答案,這意味著即使有足夠的時(shí)間和不受限制的互聯(lián)網(wǎng)訪問,非專家也很難解決這些問題。

「我們確保這些問題是高質(zhì)量且極其困難的:擁有或正在攻讀相應(yīng)領(lǐng)域博士學(xué)位的專家的準(zhǔn)確率達(dá)到 65%,而技能嫻熟的非專家驗(yàn)證者準(zhǔn)確率僅為 34%,并且他們即便可以不受限制地訪問網(wǎng)絡(luò),也平均花費(fèi)了超過 30 分鐘的時(shí)間。」 - 來自 [7]

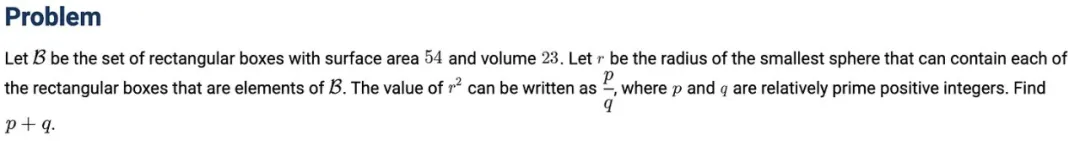

ARC-AGI 基準(zhǔn) —— 被描述為「邁向 AGI 的重要墊腳石」—— 涉及各種基于網(wǎng)格的謎題,其中 LLM 必須在輸入輸出網(wǎng)格中學(xué)習(xí)模式,并在最終輸出示例中完美復(fù)制這種學(xué)習(xí)到的模式。大多數(shù) LLM 都很難解決這些難題(例如,GPT-4o 的準(zhǔn)確率僅為 5%),但推理模型在這個(gè)基準(zhǔn)上表現(xiàn)相當(dāng)不錯(cuò) —— 準(zhǔn)確率可達(dá) 30-90%,具體取決于計(jì)算預(yù)算。

至少可以說,這些是推理 LLM 開始解決的不同級(jí)別的(非平凡)問題。盡管這些基準(zhǔn)測(cè)試難度很大,但現(xiàn)代推理模型的能力也很強(qiáng) —— 據(jù)報(bào)道,OpenAI 的 o3 模型在 AIME 2024 上取得了近 97% 的分?jǐn)?shù)。在人工檢查其中一些問題后,我們可以真正理解這個(gè)結(jié)果的重要性。

推理模型基礎(chǔ)

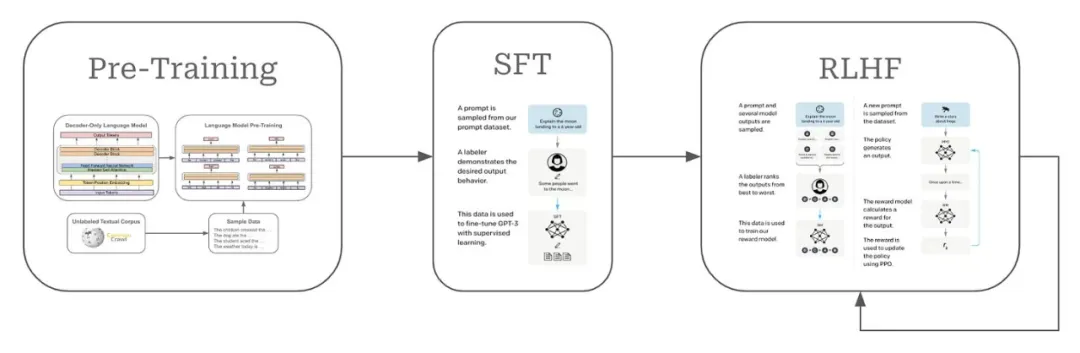

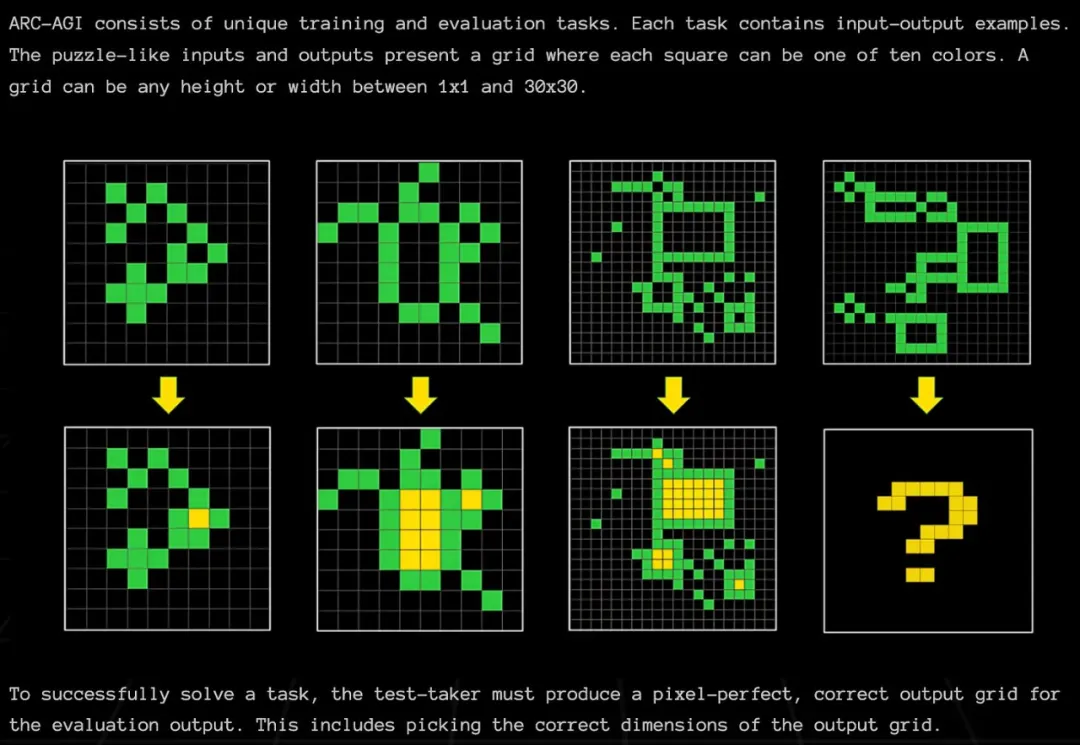

雖然上面介紹的推理模型顯然令人印象深刻,但都是封閉模型。因此,我們不知道它們實(shí)際上是如何工作的。我們得到的唯一信息是上面的引文和如下所示的圖表。

(來自 [5])

然而,從這些有限的信息中,我們可以得出一些有用的結(jié)論。主要而言,擴(kuò)展推理模型涉及兩個(gè)關(guān)鍵組件:

- 通過強(qiáng)化學(xué)習(xí)進(jìn)行更多訓(xùn)練。

- 更多推理時(shí)間計(jì)算(即推理時(shí)間擴(kuò)展)。

盡管 OpenAI 并未透露擴(kuò)展推理模型這兩個(gè)組件的方法背后的許多細(xì)節(jié),但仍有大量關(guān)于此主題的研究發(fā)表。為了提供更多背景信息,讓我們簡(jiǎn)要介紹一下其中一些工作,加上 OpenAI 分享的細(xì)節(jié),可以讓我們大致了解推理模型訓(xùn)練和使用的一些關(guān)鍵概念。

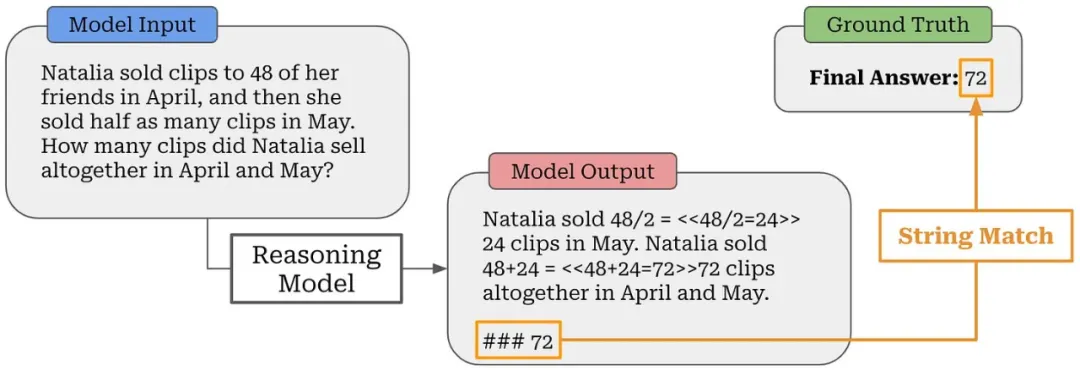

具有可驗(yàn)證獎(jiǎng)勵(lì)的強(qiáng)化學(xué)習(xí)

關(guān)于 o1 式模型,我們應(yīng)該注意到的一個(gè)細(xì)節(jié)是,它們主要用于本質(zhì)上可驗(yàn)證的問題并根據(jù)這些問題進(jìn)行評(píng)估;例如數(shù)學(xué)和編程。但是,在這種情況下,「可驗(yàn)證(verifiable)」到底是什么意思?

首先,我們假設(shè)我們可以獲取 i)問題的基本答案或 ii)可用于驗(yàn)證正確性的某些基于規(guī)則的技術(shù)。

通過精確字符串匹配驗(yàn)證數(shù)學(xué)問題

例如,我們可以為大多數(shù)數(shù)學(xué)問題定義一個(gè)基本答案 —— 在 GSM8K 中,這是使用 #### <answer> 語法完成的。然后,我們可以從 LLM 的輸出中提取最終答案,并使用基本字符串匹配將此答案與 ground truth 答案進(jìn)行比較;見上圖。類似地,如果我們?yōu)榫幊虇栴}準(zhǔn)備了測(cè)試用例,我們可以簡(jiǎn)單地執(zhí)行由 LLM 生成的代碼并檢查提供的解決方案是否滿足所有測(cè)試用例。

「可驗(yàn)證獎(jiǎng)勵(lì)的強(qiáng)化學(xué)習(xí)(RLVR)可以看作是現(xiàn)有引導(dǎo)語言模型推理方法的簡(jiǎn)化形式或具有執(zhí)行反饋的更簡(jiǎn)單形式的強(qiáng)化學(xué)習(xí),其中我們只需使用答案匹配或約束驗(yàn)證作為二進(jìn)制信號(hào)來訓(xùn)練模型。」 - 來自 [13]

說一個(gè)領(lǐng)域是「可驗(yàn)證的」并不意味著我們可以自動(dòng)驗(yàn)證該領(lǐng)域問題的任意解決方案。相反,我們經(jīng)常需要訪問 ground truth 答案(通常從人類那里獲得)進(jìn)行驗(yàn)證。

但是,有些行為可以使用簡(jiǎn)單規(guī)則而不是 ground truth 來驗(yàn)證。例如,我們可以使用一組硬編碼規(guī)則執(zhí)行簡(jiǎn)單檢查來確定推理模型是否具有正確的輸出格式、是否遵循某些指令或是否產(chǎn)生特定長度的輸出(例如,o3-mini 使用的 low、medium 或 high 推理工作量)。

驗(yàn)證復(fù)雜性。根據(jù)我們正在解決的問題,驗(yàn)證 LLM 的輸出可能會(huì)變得非常復(fù)雜。即使對(duì)于數(shù)學(xué)問題,驗(yàn)證 LLM 的答案與基本事實(shí)之間的匹配也很困難。例如,解答可能以不同的形式或格式呈現(xiàn),從而導(dǎo)致假陰性驗(yàn)證。在這些情況下,簡(jiǎn)單的字符串匹配可能還不夠!相反,我們可以提示 LLM,讓其告訴我們這兩個(gè)解是否匹配,這已被發(fā)現(xiàn)可以大大減少不正確的驗(yàn)證 [14]。對(duì)于代碼,實(shí)現(xiàn)驗(yàn)證也很困難 —— 它需要構(gòu)建一個(gè)數(shù)據(jù)管道,并且其要非常有效地在訓(xùn)練設(shè)置中執(zhí)行和驗(yàn)證測(cè)試用例。

神經(jīng)驗(yàn)證。除了上面概述的可驗(yàn)證問題之外,我們還可以考慮較弱的驗(yàn)證形式。例如,創(chuàng)意寫作是一項(xiàng)難以驗(yàn)證的任務(wù)。但是,我們可以:

- 訓(xùn)練神經(jīng)獎(jiǎng)勵(lì)模型或驗(yàn)證器。

- 使用此模型對(duì) LLM 輸出進(jìn)行評(píng)分。

- 使用預(yù)測(cè)分?jǐn)?shù)作為獎(jiǎng)勵(lì)或驗(yàn)證信號(hào)。

這樣的設(shè)置與基于人類反饋的強(qiáng)化學(xué)習(xí)(RLHF)非常相似。在這種情況下,會(huì)訓(xùn)練獎(jiǎng)勵(lì)模型根據(jù)模型響應(yīng)的正確性或質(zhì)量執(zhí)行二元驗(yàn)證。但是,使用神經(jīng)驗(yàn)證器會(huì)有獎(jiǎng)勵(lì) hacking 的風(fēng)險(xiǎn),尤其是在執(zhí)行大規(guī)模強(qiáng)化學(xué)習(xí)時(shí)。模型的訓(xùn)練時(shí)間更長,并且會(huì)對(duì)獎(jiǎng)勵(lì)圖景進(jìn)行更多探索,從而增加了獎(jiǎng)勵(lì) hacking 的風(fēng)險(xiǎn)。因此,許多最近的推理模型都避開了這種方法。

「我們?cè)陂_發(fā) DeepSeek-R1-Zero 時(shí)沒有應(yīng)用神經(jīng)獎(jiǎng)勵(lì)模型,因?yàn)槲覀儼l(fā)現(xiàn)神經(jīng)獎(jiǎng)勵(lì)模型在大規(guī)模強(qiáng)化學(xué)習(xí)過程中可能會(huì)受到獎(jiǎng)勵(lì) hacking 攻擊的影響,而重新訓(xùn)練獎(jiǎng)勵(lì)模型需要額外的訓(xùn)練資源,這會(huì)使整個(gè)訓(xùn)練流程變得復(fù)雜。」 - 來自 [1]

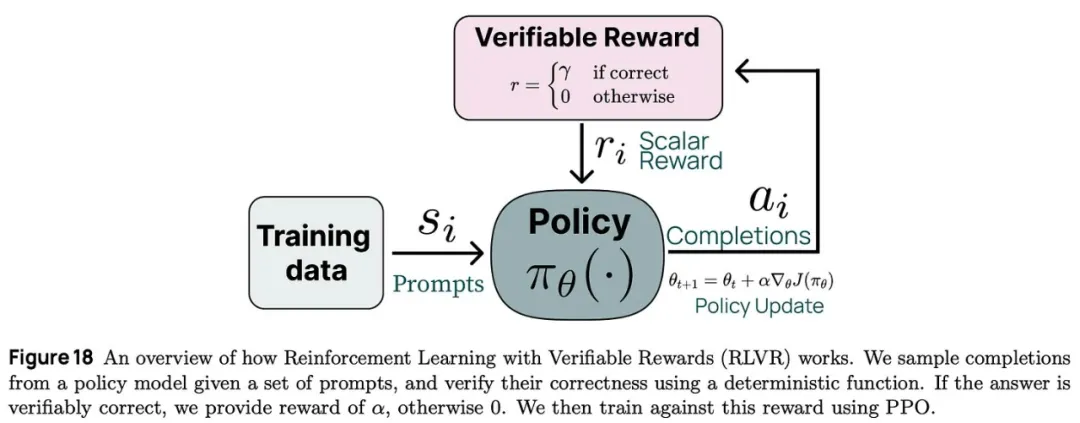

用可驗(yàn)證的獎(jiǎng)勵(lì)學(xué)習(xí)。我們現(xiàn)在了解了驗(yàn)證,但如何使用驗(yàn)證來訓(xùn)練 LLM?思路很簡(jiǎn)單:直接將驗(yàn)證結(jié)果用作使用強(qiáng)化學(xué)習(xí)進(jìn)行訓(xùn)練的獎(jiǎng)勵(lì)信號(hào)。有很多不同的方法可以實(shí)現(xiàn)這個(gè)思路(例如,過程獎(jiǎng)勵(lì)或純強(qiáng)化學(xué)習(xí)),但它們的共同主題是使用強(qiáng)化學(xué)習(xí)根據(jù)可驗(yàn)證的獎(jiǎng)勵(lì)學(xué)習(xí)。這是所有現(xiàn)代推理模型根基的基本概念。

(來自 [13])

對(duì)于使用強(qiáng)化學(xué)習(xí)從可驗(yàn)證的獎(jiǎng)勵(lì)中學(xué)習(xí)的方法,可以參考 Sasha Rush 的這個(gè)視頻:https://youtu.be/6PEJ96k1kiw

推理時(shí)間策略:思路鏈和解碼

我們可以通過兩種基本方法來增加語言模型在推理時(shí)消耗的計(jì)算量:

- 生成更多 token(即更長的輸出序列)。

- 生成多個(gè)輸出。

在本節(jié)中,我們將更詳細(xì)地介紹這些技術(shù),探索如何通過思維鏈和不同的解碼策略(如并行解碼與順序解碼)在 LLM 中實(shí)際實(shí)現(xiàn)它們。

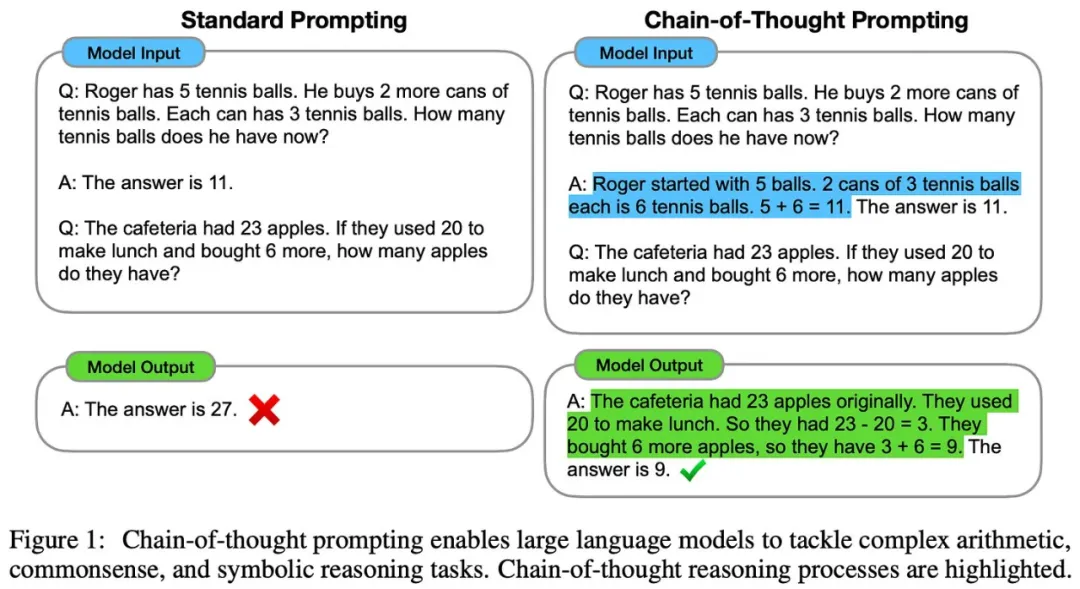

(來自 [8])

思維鏈。我們已經(jīng)知道推理模型使用長思維鏈作為推理媒介。在 [8] 中提出,最簡(jiǎn)單的層面上,思維鏈只是 LLM 為其自身輸出提供的一種解釋。在大多數(shù)情況下,這些解釋是在 LLM 生成最終答案之前編寫的,允許模型在生成答案時(shí)將其解釋用作上下文。

推理模型使用的長思維鏈與標(biāo)準(zhǔn)思維鏈有很大不同。標(biāo)準(zhǔn)思維鏈簡(jiǎn)潔易讀。長思維鏈有幾千個(gè) token。雖然它可以用于解釋模型,但長思維鏈并未針對(duì)人類可讀性進(jìn)行優(yōu)化。相反,它是一種寬泛的推理軌跡,以詳細(xì)的方式解決問題,并包含各種復(fù)雜的推理行為(例如,回溯和自我優(yōu)化)。

「我們決定不向用戶展示原始的思維鏈…… 我們努力通過教導(dǎo)模型從答案中的思維鏈中重現(xiàn)有用的想法來部分彌補(bǔ) [這一決定]。對(duì)于 o1 模型系列,我們會(huì)展示模型生成的思維鏈摘要。」 - 來自 [5]

此外,推理模型會(huì)在邏輯上將其思維鏈與模型的最終輸出分開。例如,OpenAI 不會(huì)向用戶展示長思維鏈,而是提供 LLM 生成的長思維鏈摘要來補(bǔ)充推理模型的最終答案。由于思維鏈的長度,這種邏輯分離是有必要的。大多數(shù)用戶只會(huì)閱讀最終答案 —— 閱讀整個(gè)推理軌跡將非常耗時(shí)。

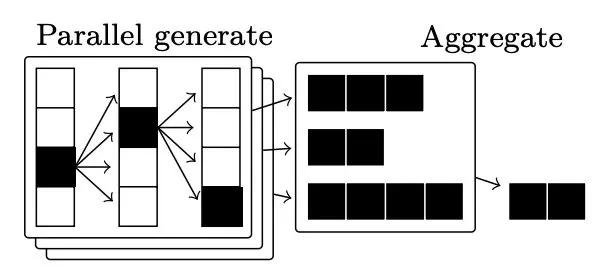

(來自 [15])

并行解碼。為了提高 LLM 最終輸出的準(zhǔn)確性,我們還可以使用并行解碼技術(shù)。思路很簡(jiǎn)單:不使用 LLM 生成單個(gè)輸出,而是生成多個(gè)輸出并聚合這些輸出以形成單個(gè)最終答案。這種聚合可以通過多種方式完成;例如,使用多數(shù)投票或共識(shí)、使用加權(quán)投票、使用神經(jīng)獎(jiǎng)勵(lì)模型或驗(yàn)證器(即也稱為 Best-of-N 或拒絕采樣)或其他特定領(lǐng)域算法找到最佳輸出。

這些方法的主要好處是簡(jiǎn)單又有效。并行解碼很容易擴(kuò)展:我們只需生成、驗(yàn)證和聚合大量輸出,就能得到有意義的性能提升 [9, 10, 11]。o1 式模型顯然使用了并行解碼技術(shù) —— 只需查看其博客中提供的圖表細(xì)節(jié)(如下所示)!但是,并行解碼技術(shù)本身無法解釋最近發(fā)布的推理模型所表現(xiàn)出的一些更復(fù)雜的推理行為。

(來自 [5])

順便說一句,我們還可以將拒絕采樣的思想應(yīng)用于訓(xùn)練(即訓(xùn)練與測(cè)試時(shí)間拒絕采樣)。為此,我們只需:

- 采樣幾個(gè)輸出或軌跡。

- 使用獎(jiǎng)勵(lì)模型(或其他評(píng)分機(jī)制)選擇最佳輸出。

- 使用這些輸出進(jìn)行訓(xùn)練。

在實(shí)踐中,這種方法很常用;例如,LLaMA 模型在應(yīng)用 RLHF 之前,會(huì)在其后訓(xùn)練過程中執(zhí)行幾輪訓(xùn)練時(shí)間拒絕采樣。拒絕采樣在實(shí)踐中非常有效,與基于 PPO 的 RLHF 相比,它更容易實(shí)現(xiàn)和擴(kuò)展。

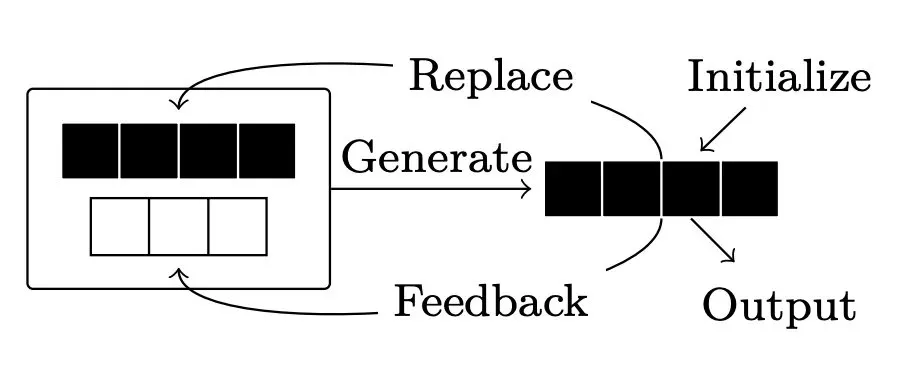

自我優(yōu)化。除了并行解碼之外,還可以考慮為解碼采用批評(píng)或自我優(yōu)化策略。首先,LLM 生成初始響應(yīng)。然后,為響應(yīng)提供反饋(來自 LLM 或某些外部來源),LLM 可以根據(jù)反饋修改其響應(yīng)。此循環(huán)可以重復(fù)任意次數(shù);參見下圖。

(來自 [15])

目前已有不同的優(yōu)化方法,但它們可以大致分為兩類:

- 外部式:反饋來自某些外部驗(yàn)證器或模塊。

- 內(nèi)部式:LLM 為其自身生成提供反饋。

優(yōu)化的結(jié)果和實(shí)際效果有些復(fù)雜。有許多使用外部反饋(例如來自驗(yàn)證器 [16] 或代碼解釋器 [17])來優(yōu)化 LLM 輸出的成功案例。內(nèi)部?jī)?yōu)化是否有效在很大程度上取決于 LLM 提供的反饋質(zhì)量。內(nèi)部?jī)?yōu)化可以很好地完成簡(jiǎn)單任務(wù) [18]。然而,這種方法很難泛化到更復(fù)雜的任務(wù)(例如數(shù)學(xué))[19]。

開放式推理模型:DeepSeek-R1 等

到目前為止,我們已經(jīng)了解了 LLM 獲得推理能力的基本概念。然而,我們所了解的所有模型都是封閉的 —— 我們無法知道這些模型究竟是如何創(chuàng)建的。幸運(yùn)的是,最近發(fā)布了幾個(gè)開放式推理模型。這些模型中最引人注目的是 DeepSeek-R1 [1]。除了與 OpenAI o1 相媲美的性能外,該模型還附帶了一份完整的技術(shù)報(bào)告,其中提供了足夠的細(xì)節(jié),因此完全揭開了創(chuàng)建強(qiáng)大推理模型所需過程的神秘面紗。

(來自 [1])

DeepSeek-R1 背后的核心思想與我們迄今為止學(xué)到的知識(shí)非常吻合。該模型在可驗(yàn)證任務(wù)上使用強(qiáng)化學(xué)習(xí)進(jìn)行訓(xùn)練,它學(xué)習(xí)利用長思維鏈來解決復(fù)雜的推理問題。有趣的是,強(qiáng)化學(xué)習(xí)訓(xùn)練過程是該模型強(qiáng)大推理能力的關(guān)鍵因素。該模型的多個(gè)版本 ——DeepSeek-R1-Zero 和 DeepSeek-R1—— 都已發(fā)布,具有相當(dāng)?shù)耐评砟芰ΑU缥覀儗⒖吹降模沁@類模型中第一個(gè)完全放棄了任何監(jiān)督訓(xùn)練的模型,表明復(fù)雜的推理能力可自然地從使用強(qiáng)化學(xué)習(xí)的大規(guī)模訓(xùn)練中涌現(xiàn)。

「DeepSeek-R1-Zero 是一種通過大規(guī)模強(qiáng)化學(xué)習(xí)(RL)訓(xùn)練的模型,沒有監(jiān)督微調(diào)(SFT)作為初步步驟,它展示了非凡的推理能力。通過強(qiáng)化學(xué)習(xí),DeepSeek-R1-Zero 自然地涌現(xiàn)出了許多強(qiáng)大而有趣的推理行為。」 - 來自 [1]

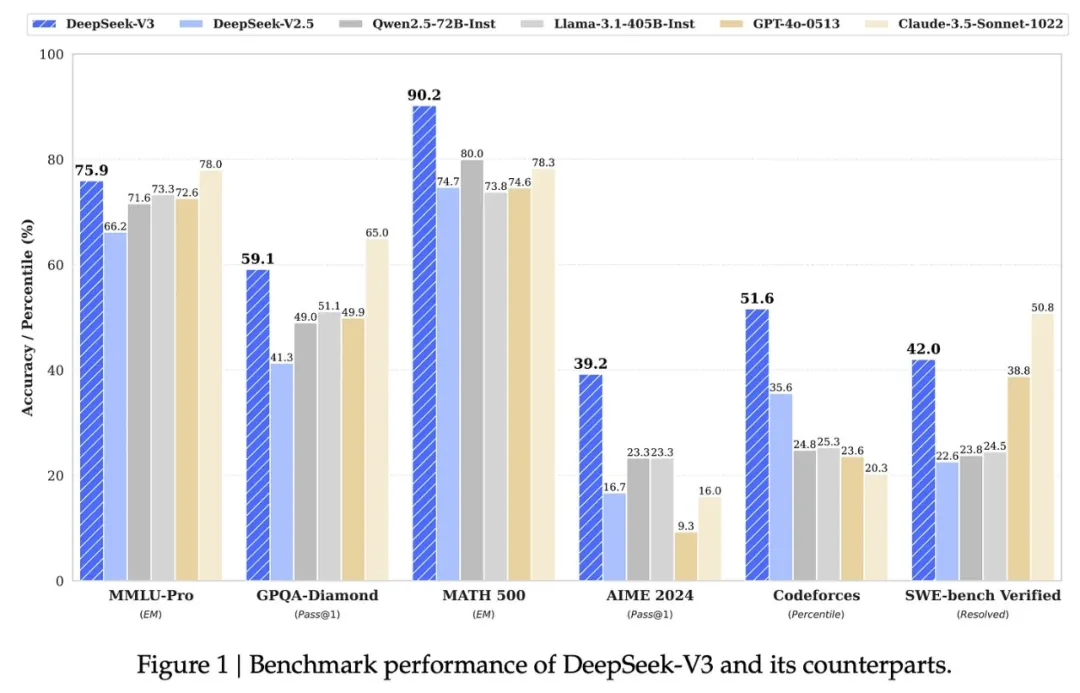

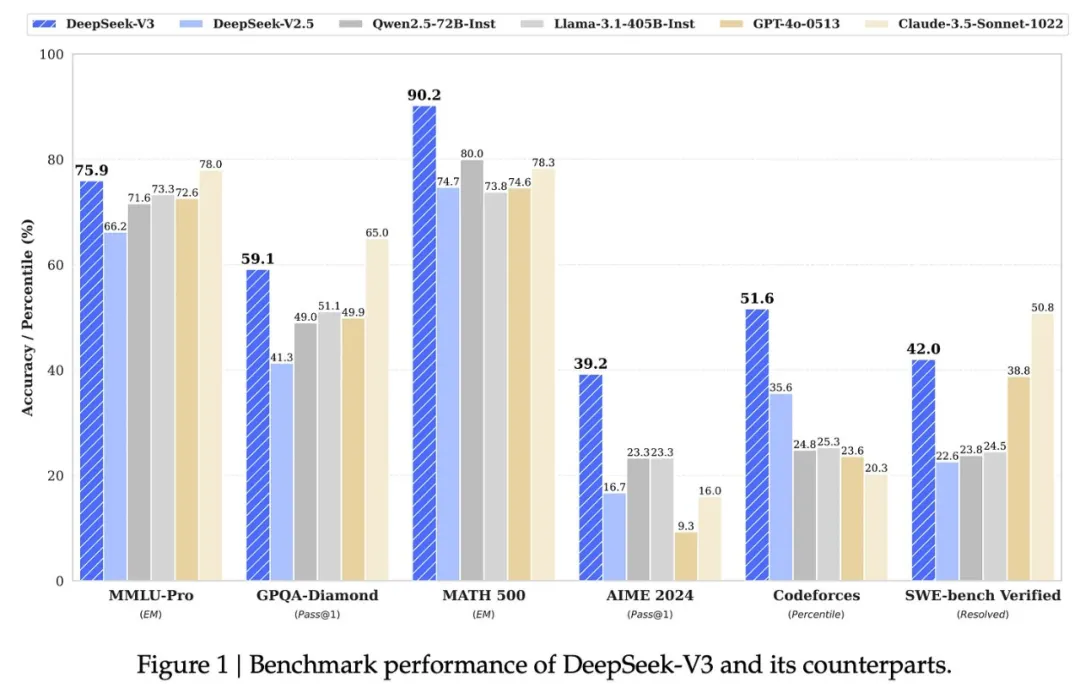

DeepSeek-v3。DeepSeek-R1-Zero 和 DeepSeek-R1 都始于一個(gè)強(qiáng)大的基礎(chǔ)模型:DeepSeek-v3 [2]。除了具有開放權(quán)重和詳細(xì)的技術(shù)報(bào)告 [2] 之外,該模型還超越了之前的開放 LLM 的性能,甚至與封閉模型的質(zhì)量相當(dāng)。

(來自 [2])

DeepSeek-v3 是一個(gè) 6710 億參數(shù)的混合專家(MoE)模型。如果你不熟悉 MoE,可以參看博主的這篇長文解析,其中解釋了 MoE 概念并提供了幾個(gè)實(shí)例,包括 DeepSeek-v3:https://cameronrwolfe.substack.com/p/moe-llms

為了提高推理和訓(xùn)練效率,DeepSeek-v3 做出了以下設(shè)計(jì)選擇:

- 使用多頭隱注意力(MLA)。

- 采用優(yōu)化的 MoE 結(jié)構(gòu)(例如,細(xì)粒度和共享專家)。

- 在預(yù)訓(xùn)練期間使用多 token 預(yù)測(cè)目標(biāo)。

- 放棄通常用于訓(xùn)練 MoE 模型的負(fù)載平衡損失。

- 通過采用 [2] 中提出的新型量化訓(xùn)練策略,在整個(gè)訓(xùn)練過程中將精度降低到 FP8。

出于這些原因,與其他模型相比,DeepSeek-v3 的訓(xùn)練非常經(jīng)濟(jì):該模型在性能和效率方面都表現(xiàn)出色。該模型的幾個(gè)先前版本已經(jīng)發(fā)布,這些版本啟發(fā)了 DeepSeek-v3 做出的一些設(shè)計(jì)決策,例如 DeepSeek-v2 和 DeepSeek-v2.5。

DeepSeek-R1-Zero

DeepSeek 提出的第一個(gè)推理模型是 DeepSeek-R1-Zero。該模型采用了一種有趣的訓(xùn)練策略,即教模型純粹通過大規(guī)模強(qiáng)化學(xué)習(xí)進(jìn)行推理,而無需任何 SFT。該模型會(huì)自然探索并學(xué)習(xí)利用長思維鏈通過強(qiáng)化學(xué)習(xí)解決復(fù)雜的推理問題。DeepSeek-R1-Zero 是第一個(gè)公開的研究成果,表明無需監(jiān)督訓(xùn)練即可開發(fā)推理能力。

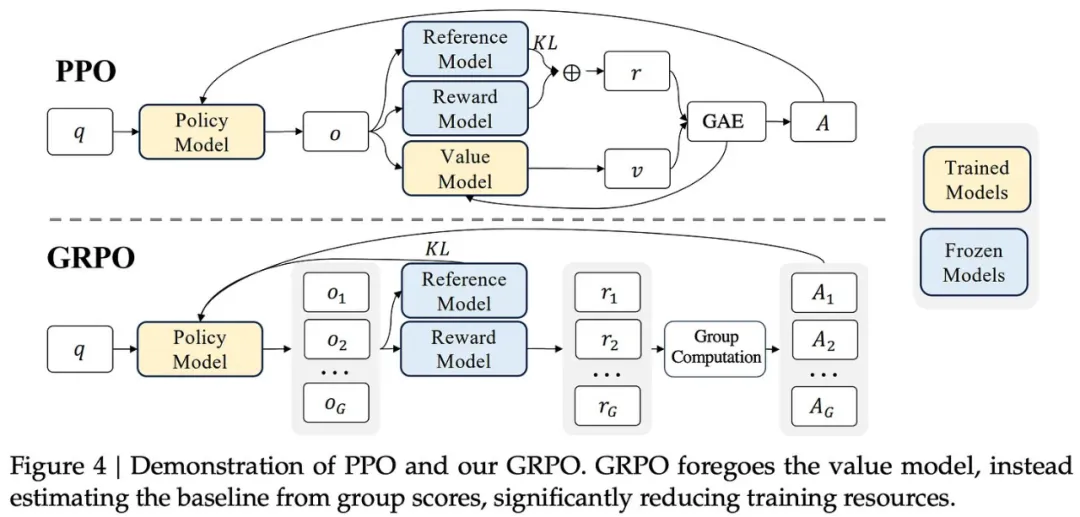

(來自 [22])

使用 GRPO 的強(qiáng)化學(xué)習(xí)。DeepSeek-R1-Zero 的訓(xùn)練從 DeepSeek-v3 [2] 基礎(chǔ)模型開始。他們是直接通過強(qiáng)化學(xué)習(xí)微調(diào)這個(gè)基礎(chǔ)模型。特別是,[1] 中的作者選擇了上圖中所示的組相對(duì)策略優(yōu)化(GRPO)[3] 作為他們的強(qiáng)化學(xué)習(xí)算法。選擇用于 LLM 訓(xùn)練的強(qiáng)化學(xué)習(xí)算法是一個(gè)開放且活躍的研究課題。傳統(tǒng)上,研究人員使用 PPO 來訓(xùn)練 LLM,但最近有一種趨勢(shì)是采用更簡(jiǎn)單的強(qiáng)化學(xué)習(xí)算法(例如 REINFORCE 或 GRPO)進(jìn)行 LLM 訓(xùn)練。[1] 中給出的選擇 GRPO 的主要原因是:

- 降低強(qiáng)化學(xué)習(xí)訓(xùn)練成本。

- 不再需要批評(píng)模型,該模型(通常)與策略模型(即 LLM 本身)大小相同。

定義獎(jiǎng)勵(lì)。與大多數(shù)使用 LLM 的傳統(tǒng)強(qiáng)化學(xué)習(xí)工作不同,DeepSeek-R1-Zero 不使用神經(jīng)獎(jiǎng)勵(lì)模型(即基于 LLM 的獎(jiǎng)勵(lì)模型,這些模型通過偏好數(shù)據(jù)進(jìn)行訓(xùn)練)。相反,作者使用了基于規(guī)則的獎(jiǎng)勵(lì)系統(tǒng),它 i)避免獎(jiǎng)勵(lì) hacking,ii)節(jié)省計(jì)算成本,iii)更易于實(shí)現(xiàn)。特別要指出,目前使用的獎(jiǎng)勵(lì)有兩種:

- 準(zhǔn)確度獎(jiǎng)勵(lì):評(píng)估模型的響應(yīng)是否正確。

- 格式獎(jiǎng)勵(lì):強(qiáng)制模型以一定格式輸出。

DeepSeek-R1-Zero 完全是在可自動(dòng)驗(yàn)證的任務(wù)上進(jìn)行訓(xùn)練的,例如數(shù)學(xué)和編程問題。對(duì)于具有確定性結(jié)果的數(shù)學(xué)問題,該模型可以以指定的格式提供答案,使我們能夠通過基本的字符串匹配進(jìn)行驗(yàn)證。同樣,可以通過在預(yù)定義的測(cè)試用例上執(zhí)行 LLM 在沙箱中生成的代碼來驗(yàn)證編程問題。

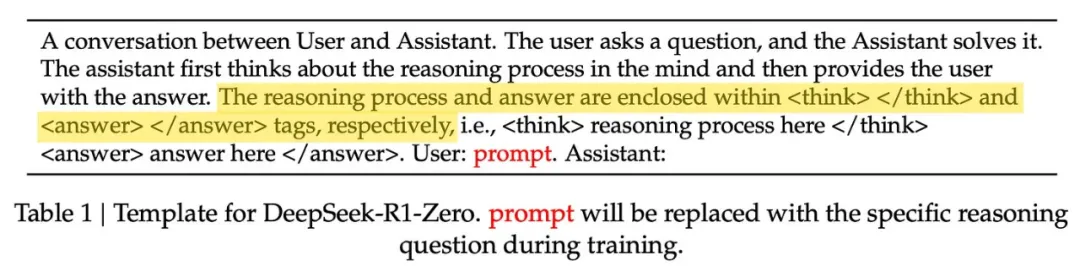

如前所述,當(dāng)模型的輸出格式正確時(shí),格式獎(jiǎng)勵(lì)會(huì)提供積極的訓(xùn)練信號(hào)。[1] 中使用的格式只是將模型的長思維鏈(或思考 / 推理過程)放在兩個(gè)特殊 token 之間:<think> 和 </think>。然后,在推理過程完成后,模型會(huì)在 <answer> 和 </answer> 標(biāo)簽之間單獨(dú)生成答案;如下所示。

(來自 [1])

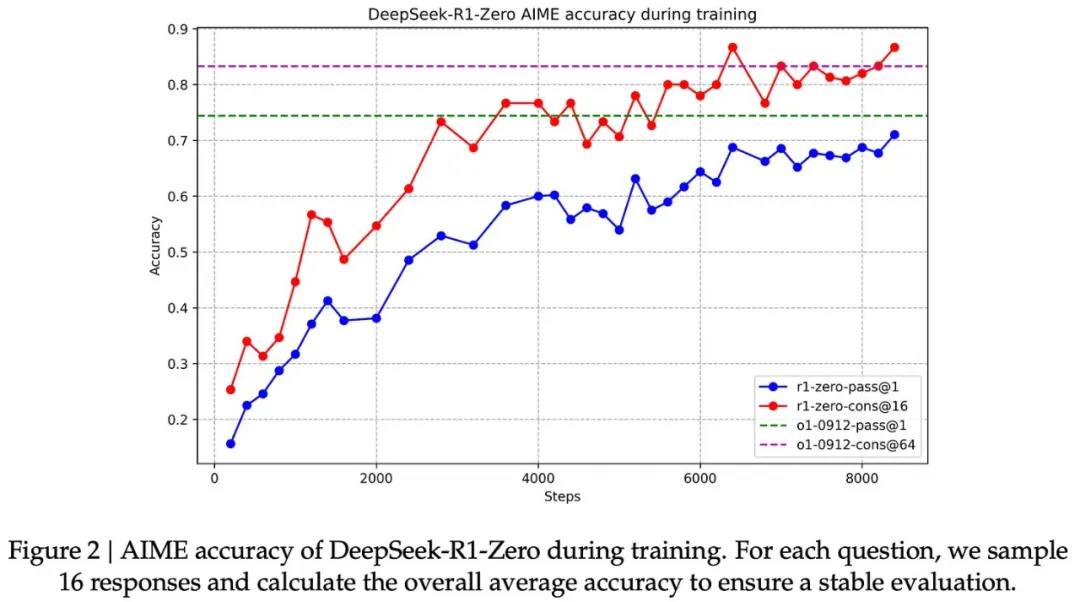

通過強(qiáng)化學(xué)習(xí)進(jìn)行學(xué)習(xí)。盡管沒有使用 SFT,但 DeepSeek-R1-Zero 在整個(gè)強(qiáng)化學(xué)習(xí)訓(xùn)練過程中的推理能力都有了明顯的進(jìn)步。隨著訓(xùn)練的進(jìn)行,模型在 AIME 2024 上的表現(xiàn)如下圖所示。

(來自 [1])

可以看到,模型的性能逐漸提高,最終達(dá)到與 o1-preview 相當(dāng)?shù)乃健S?xùn)練完成后,DeepSeek-R1-Zero 在 AIME 2024 上的表現(xiàn)從最初的 15.6% 提高到了 71.0%(或在使用 16 票多數(shù)投票時(shí)為 86.7%)!這樣的結(jié)果與我們?cè)诜忾]式推理模型中看到的性能趨勢(shì)是一致的 ——DeepSeek-R1-Zero 在強(qiáng)化學(xué)習(xí)訓(xùn)練后實(shí)現(xiàn)了令人印象深刻的性能,并且可以通過并行解碼策略進(jìn)一步提高其性能。

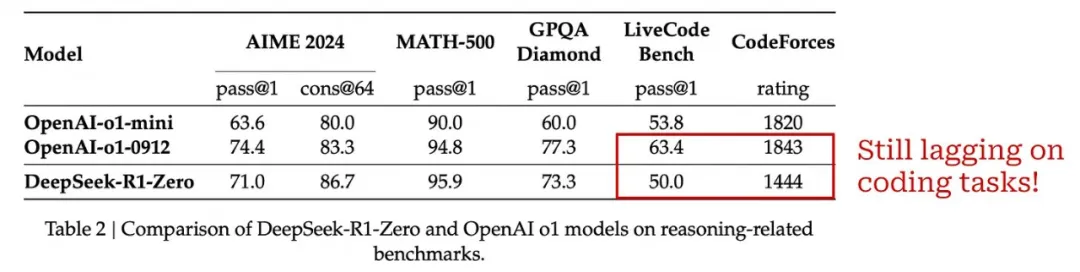

下表給出了 DeepSeek-R1-Zero 和 o1 模型之間的完整性能比較。DeepSeek-R1-Zero 在大多數(shù)情況下與 o1-mini 的性能相當(dāng)或超過 o1-mini,并且在幾個(gè)任務(wù)上的表現(xiàn)與 o1-preview 相當(dāng)。然而,OpenAI 的推理模型在編程領(lǐng)域表現(xiàn)更好 ——DeepSeek-R1-Zero 顯然是一個(gè)較弱的編程模型。我們很快就會(huì)看到,這個(gè)問題在 DeepSeek-R1(后續(xù)模型)中得到了解決。

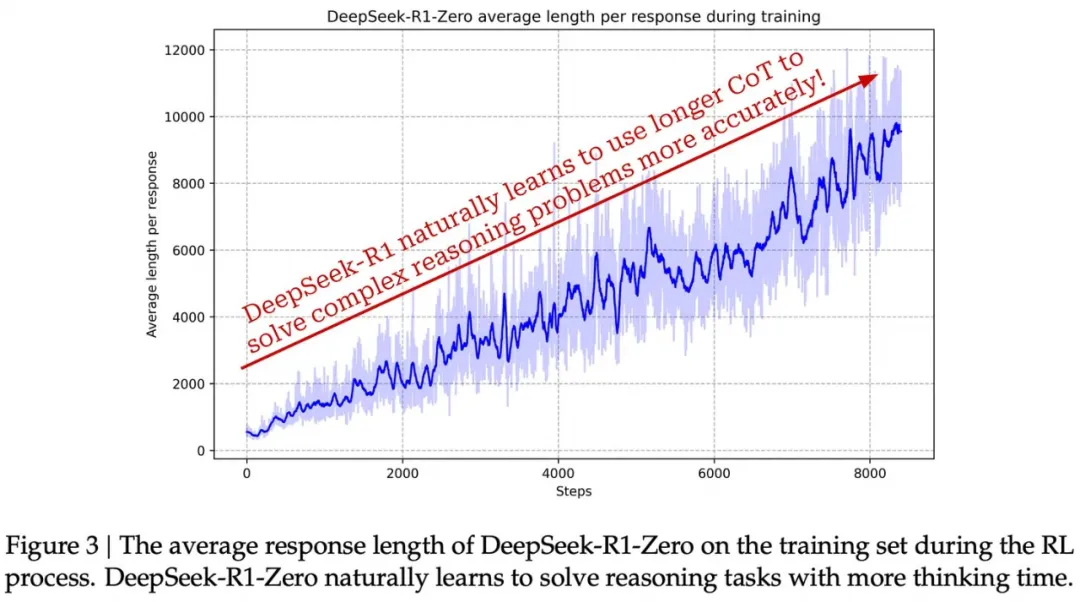

(來自 [1])

發(fā)生了什么?顯然,DeepSeek-R1-Zero 從 [1] 中介紹的強(qiáng)化學(xué)習(xí)訓(xùn)練過程中獲得了出色的推理能力。然而,模型學(xué)習(xí)過程的動(dòng)態(tài)也相當(dāng)明顯!因?yàn)闆]有進(jìn)行 SFT 式訓(xùn)練,所以可以在整個(gè)強(qiáng)化學(xué)習(xí)訓(xùn)練過程中密切監(jiān)控模型推理策略的進(jìn)展。如下所示,DeepSeek-R1-Zero 學(xué)會(huì)了利用更多的「思考時(shí)間」,即生成越來越長的思維鏈,從而可以隨著訓(xùn)練的進(jìn)行改進(jìn)其推理過程。該模型自然學(xué)會(huì)了利用更多的測(cè)試時(shí)間計(jì)算來解決更難的問題!

(來自 [1])

[1] 的作者還觀察到在強(qiáng)化學(xué)習(xí)訓(xùn)練過程中自然涌現(xiàn)的幾種有趣趨勢(shì)。例如,該模型通過重新審視和評(píng)估其推理過程的先前組成部分,發(fā)展出反思自身解決方案的能力。同樣,該模型在解決問題的過程中開始顯式地測(cè)試和探索替代解決方案或方法。這種行為不是現(xiàn)實(shí)編程在模型中的,而是在強(qiáng)化學(xué)習(xí)訓(xùn)練過程中自然涌現(xiàn)的!

在最基本的層面上,[1] 中構(gòu)建的強(qiáng)化學(xué)習(xí)環(huán)境允許模型探索不同的策略來得出正確的(由驗(yàn)證確定的)最終解答。在探索過程中,模型做到以下兩點(diǎn)就能獲得獎(jiǎng)勵(lì):

- 使用了正確的推理模板或結(jié)構(gòu)。

- 給出的最終解答是正確的。

僅憑這些獎(jiǎng)勵(lì),模型就能學(xué)會(huì)如何解決復(fù)雜的推理問題。我們不需要顯式地教模型如何分解問題、尋找解決方案、執(zhí)行回溯或評(píng)估自己的思路。相反,我們只需在訓(xùn)練過程中為模型提供正確的激勵(lì)(或獎(jiǎng)勵(lì))。然后,LLM 可以通過基于強(qiáng)化學(xué)習(xí)的「自我進(jìn)化」過程自主學(xué)習(xí)解決問題所需的行為。

DeepSeek-R1

DeepSeek-R1-Zero 表明,LLM 可以使用沒有 SFT 的純強(qiáng)化學(xué)習(xí)獲得出色的推理能力,但這個(gè)模型有一些小錯(cuò)誤。例如,它的可讀性很差,并且它會(huì)錯(cuò)誤地將語言混合在一起。簡(jiǎn)而言之,DeepSeek-R1-Zero 非常擅長推理,但它缺乏一些已良好對(duì)齊的 LLM 的理想屬性。為了解決這些問題,[1] 中的作者提出了一種新的多階段訓(xùn)練過程,將一些「冷啟動(dòng)」 SFT 數(shù)據(jù)與其他一些技巧整合到了訓(xùn)練中。此訓(xùn)練流程得到的 DeepSeek-R1 是一款既已對(duì)齊又能進(jìn)行復(fù)雜推理的 LLM。

與 DeepSeek-R1-Zero 類似,DeepSeek-R1 的基礎(chǔ)也是 DeepSeek-v3。然后,DeepSeek-R1 經(jīng)歷四個(gè)階段的訓(xùn)練,包括兩個(gè) SFT 階段和兩個(gè)強(qiáng)化學(xué)習(xí)階段。SFT 階段的目的是在每個(gè)強(qiáng)化學(xué)習(xí)階段為探索提供更好的起點(diǎn)。該訓(xùn)練流程是 [1] 的主要貢獻(xiàn)之一 :它提供了一種有效的方法,可將推理式訓(xùn)練與 LLM 的標(biāo)準(zhǔn)后訓(xùn)練方法相結(jié)合。下面更深入地介紹下 DeepSeek-R1 使用的訓(xùn)練方法的每個(gè)階段。

第一階段:冷啟動(dòng)(或面向推理的 SFT)。在進(jìn)行強(qiáng)化學(xué)習(xí)訓(xùn)練之前,R1 通過 SFT 在一小組長思維鏈?zhǔn)纠龜?shù)據(jù)集上進(jìn)行訓(xùn)練,[1] 中將其稱為「冷啟動(dòng)」數(shù)據(jù)。我們可以使用幾種不同的方法來收集這些冷啟動(dòng)數(shù)據(jù):

- 通過提示詞調(diào)用一個(gè)模型(例如 DeepSeek-v3)生成長思維鏈數(shù)據(jù),可以使用少量示例,也可以指示模型生成詳細(xì)答案并進(jìn)行反思和驗(yàn)證。

- 使用 R1-Zero 模型生成大量長思維鏈輸出,然后讓人類進(jìn)行后處理并選擇模型的最佳輸出。

[1] 結(jié)合了這些方法,收集了「數(shù)千個(gè)冷啟動(dòng)數(shù)據(jù)」。基于這些數(shù)據(jù)再使用 SFT 對(duì) DeepSeek-V3 直接進(jìn)行微調(diào)。因?yàn)檫@里使用的是長思維鏈數(shù)據(jù),所以這是一個(gè)面向推理的微調(diào)過程。從這個(gè)冷啟動(dòng)數(shù)據(jù)中,模型可以學(xué)習(xí)一個(gè)可行的(初始)模板來解決推理問題。

用于面向推理的 SFT 的數(shù)據(jù)可將人類先驗(yàn)引入 DeepSeek-R1 的訓(xùn)練過程。我們可以顯式地選擇模型在此階段學(xué)習(xí)的數(shù)據(jù)風(fēng)格和模式。例如,[1] 中提到,他們將這些數(shù)據(jù)結(jié)構(gòu)化為包含每個(gè)長思維鏈的摘要,從而教會(huì)模型在提供最終答案之前總結(jié)其整個(gè)推理過程。這些數(shù)據(jù)是強(qiáng)化學(xué)習(xí)訓(xùn)練過程的種子 —— 模型通過匹配 SFT 訓(xùn)練數(shù)據(jù)的風(fēng)格開始自我探索。

第二階段:面向推理的強(qiáng)化學(xué)習(xí)。在 SFT 之后,就是重復(fù) R1-Zero 提出的大規(guī)模強(qiáng)化學(xué)習(xí)訓(xùn)練過程了,這是為了增強(qiáng)底層模型處理推理密集型任務(wù)的能力。DeepSeek-R1 的唯一變化是增加了語言一致性獎(jiǎng)勵(lì),其在計(jì)算中是作為模型輸出中采用所需目標(biāo)語言編寫的部分。[1] 中發(fā)現(xiàn)這種語言一致性獎(jiǎng)勵(lì)會(huì)略微降低模型的推理能力。但是,語言一致性可提高最終模型與人類偏好的整體對(duì)齊程度 —— 模型的輸出更加流暢和可讀。

第三階段:拒絕采樣。在面向推理的強(qiáng)化學(xué)習(xí)收斂之后,再使用最終模型來收集大量且多樣化的 SFT 數(shù)據(jù)集。然而,與最初的冷啟動(dòng) SFT 階段不同,這里收集的不僅僅是面向推理的數(shù)據(jù)。也就是說是用通用數(shù)據(jù)擴(kuò)充推理數(shù)據(jù),以便模型可以從更廣泛的問題和領(lǐng)域中學(xué)習(xí)。

為了收集更多的推理數(shù)據(jù),DeepSeek-R1 團(tuán)隊(duì):

- 整編一組多樣化的基于推理的提示詞。

- 使用第二階段的模型生成候選軌跡。

- 執(zhí)行拒絕采樣,即根據(jù)每個(gè)軌跡的質(zhì)量和正確性過濾并選擇最佳軌跡。

這與前文介紹的訓(xùn)練時(shí)間拒絕采樣過程相同!有趣的是,在這個(gè)階段,不僅僅是依賴基于規(guī)則的技術(shù)來進(jìn)行驗(yàn)證。還會(huì)通過使用 DeepSeek-v3 作為生成獎(jiǎng)勵(lì)模型或弱驗(yàn)證器來整合來自不可驗(yàn)證域的額外數(shù)據(jù)。在應(yīng)用啟發(fā)式過濾(例如,刪除帶有多語言混合或長段落的輸出)后,他們最終得到了一個(gè)包含 60 萬個(gè)推理軌跡的集合。

此階段的 SFT 數(shù)據(jù)集包含大量非推理數(shù)據(jù)(例如,寫作或翻譯示例)。這些數(shù)據(jù)來自 DeepSeek-v3 所用的相同的訓(xùn)練后數(shù)據(jù)集。但是,通過要求 DeepSeek-v3 生成長思維鏈來解釋復(fù)雜查詢的輸出,這些數(shù)據(jù)得到了增強(qiáng) —— 不過,更簡(jiǎn)單的查詢沒有任何思維鏈。最終,他們總共收集了 20 萬個(gè)非推理示例樣本,加起來得到了一個(gè)包含 80 萬個(gè)樣本的 SFT 數(shù)據(jù)集。

第四階段:通用 RLHF。DeepSeek-R1 最后訓(xùn)練階段的目標(biāo)是使模型與人類偏好對(duì)齊,同時(shí)繼續(xù)磨練其推理能力。與前一階段類似,這里會(huì)使用基于推理的數(shù)據(jù)和通用數(shù)據(jù)的組合來訓(xùn)練模型。具體來說,訓(xùn)練的方法是使用強(qiáng)化學(xué)習(xí)并針對(duì)每種類型的數(shù)據(jù)使用不同的獎(jiǎng)勵(lì)組合:

- 基于規(guī)則的獎(jiǎng)勵(lì)(與 R1-Zero 相同),用于基于推理的問題。

- 針對(duì)一般數(shù)據(jù)使用神經(jīng)獎(jiǎng)勵(lì)模型 —— 使用人類偏好對(duì)進(jìn)行訓(xùn)練,正如 RLHF 一樣。

DeepSeek-R1 經(jīng)過調(diào)整,在通用數(shù)據(jù)上更有幫助且無害。這是 LLM 研究中使用的兩個(gè)非常常用的對(duì)齊標(biāo)準(zhǔn)。每個(gè)標(biāo)準(zhǔn)都使用單獨(dú)的神經(jīng)獎(jiǎng)勵(lì)模型進(jìn)行建模,該模型通過人類偏好的(監(jiān)督)數(shù)據(jù)集進(jìn)行訓(xùn)練。有用性獎(jiǎng)勵(lì)僅針對(duì)模型的最終答案進(jìn)行衡量(即排除長思維鏈),而無害獎(jiǎng)勵(lì)則考慮模型的整個(gè)輸出軌跡。通過結(jié)合規(guī)則和基于偏好的獎(jiǎng)勵(lì),DeepSeek-R1 可以與人類偏好對(duì)齊,同時(shí)保持強(qiáng)大的推理性能。

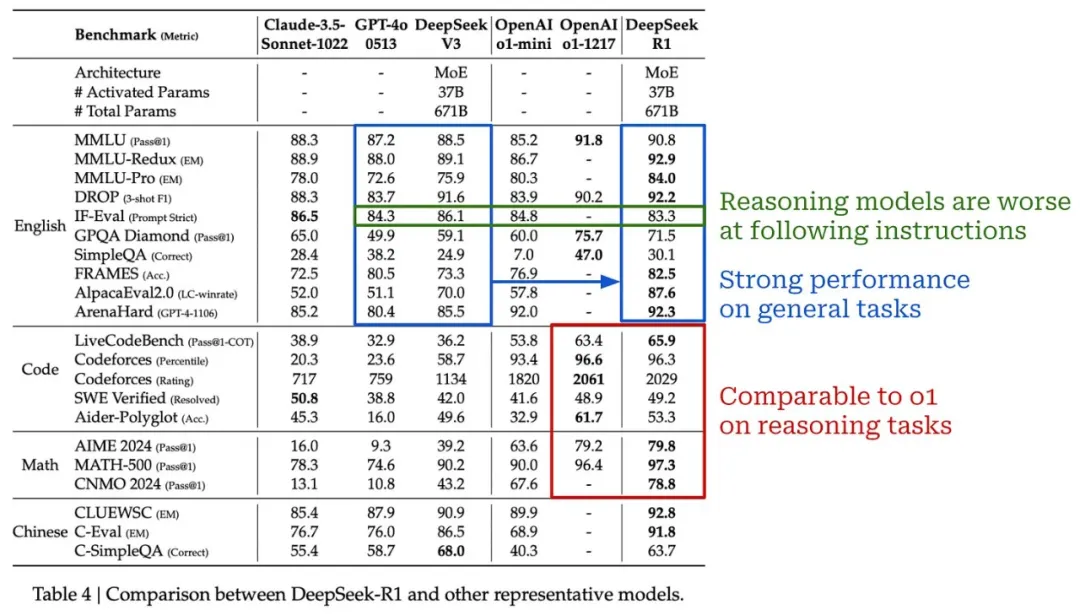

(來自 [1])

它的表現(xiàn)如何?如上所示,R1 在大多數(shù)推理任務(wù)上的表現(xiàn)與 o1 相當(dāng)甚至超過 o1。與 R1-Zero 不同,R1 還具有相當(dāng)強(qiáng)的編程能力。在通用任務(wù)上,由于其混合訓(xùn)練管道,R1 繼續(xù)表現(xiàn)良好。總的來說,R1 是一個(gè)非常強(qiáng)大的模型,似乎與 OpenAI 的 o1 不相上下,并且可以高精度地解決各種任務(wù)(包括傳統(tǒng)任務(wù)和推理導(dǎo)向任務(wù))。

關(guān)于這個(gè)模型(和其他推理模型)的一個(gè)有趣的觀察是,與標(biāo)準(zhǔn) LLM 相比,它在指令遵循基準(zhǔn)(例如 IF-Eval)上表現(xiàn)不佳。目前,推理模型在遵循指令方面似乎比標(biāo)準(zhǔn) LLM 更差。在未來,我個(gè)人認(rèn)為這種趨勢(shì)可能會(huì)逆轉(zhuǎn)。理論上,推理模型應(yīng)該能夠利用它們的思維過程來更好地解釋和遵循人類用戶提供的提示詞。例如,審議對(duì)齊(deliberative alignment)便采用了類似思想的方法。

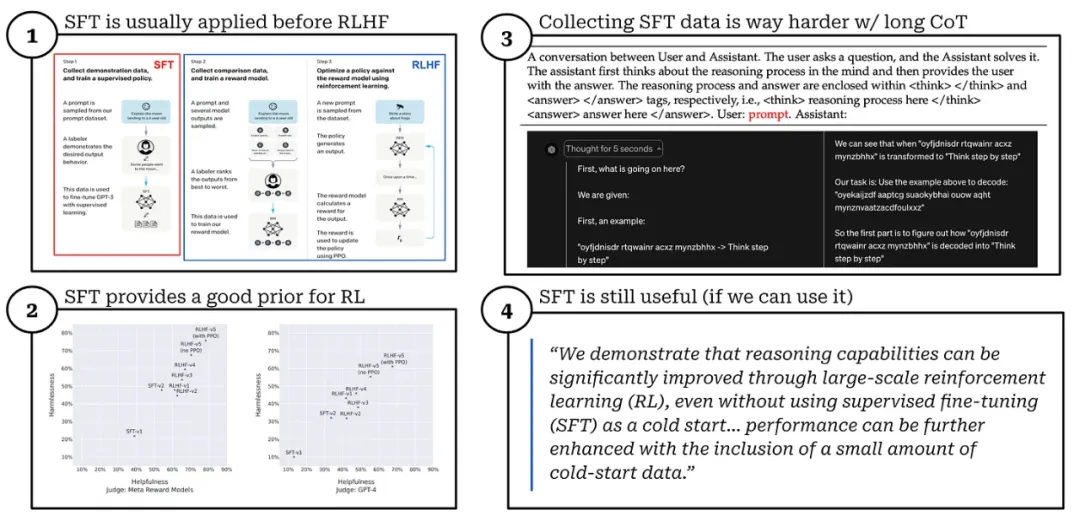

SFT 是必要的嗎?R1-Zero 展現(xiàn)了在沒有 SFT 的情況下訓(xùn)練出強(qiáng)大推理模型的能力,而完整的 R1 模型使用多個(gè) SFT 階段來獲得更強(qiáng)大的最終模型。因此,我們可能會(huì)開始懷疑:我們是否應(yīng)該使用 SFT?

對(duì)推理模型來說,SFT 是否有必要?

對(duì)于標(biāo)準(zhǔn) LLM,SFT 為 RLHF 提供了高質(zhì)量的起點(diǎn)。如果我們將 RLHF 直接應(yīng)用于基礎(chǔ)模型,學(xué)習(xí)過程的效率就會(huì)大大降低。SFT 的數(shù)據(jù)要么是合成的,要么是人類手動(dòng)創(chuàng)建的。通常,收集 SFT 的數(shù)據(jù)是昂貴的(無論是在時(shí)間還是金錢方面)—— 我們必須為 LLM 從頭開始手動(dòng)編寫一個(gè)好的響應(yīng)!

由于它們的思維鏈較長,為推理模型收集此類 SFT 數(shù)據(jù)更加困難。要求人類手動(dòng)創(chuàng)建長思維鏈數(shù)據(jù)將耗時(shí)且昂貴!我們唯一的選擇是合成這些數(shù)據(jù),但是:

- 可能很難使用模型生成這種特定風(fēng)格的輸出。

- 很難正確驗(yàn)證這種長輸出。

考慮到為推理模型收集 SFT 數(shù)據(jù)的額外復(fù)雜性,[1] 中的作者首先嘗試了完全避開 SFT!從這些實(shí)驗(yàn)中,我們看到推理能力自然地從純強(qiáng)化學(xué)習(xí)中涌現(xiàn) —— 這是一個(gè)令人難以置信的發(fā)現(xiàn)!然而,由此產(chǎn)生的模型有幾個(gè)缺點(diǎn)(例如混雜使用多種語言)。

而當(dāng)在強(qiáng)化學(xué)習(xí)之前執(zhí)行一些 SFT 訓(xùn)練(即「冷啟動(dòng)」)時(shí),可為強(qiáng)化學(xué)習(xí)提供更好的先驗(yàn),這 i)可以消除強(qiáng)化學(xué)習(xí)訓(xùn)練初始階段的不穩(wěn)定性,ii)能加快訓(xùn)練速度,iii)能提高模型質(zhì)量。因此,SFT 并非完全必要,但如有數(shù)據(jù),它仍會(huì)很有用!

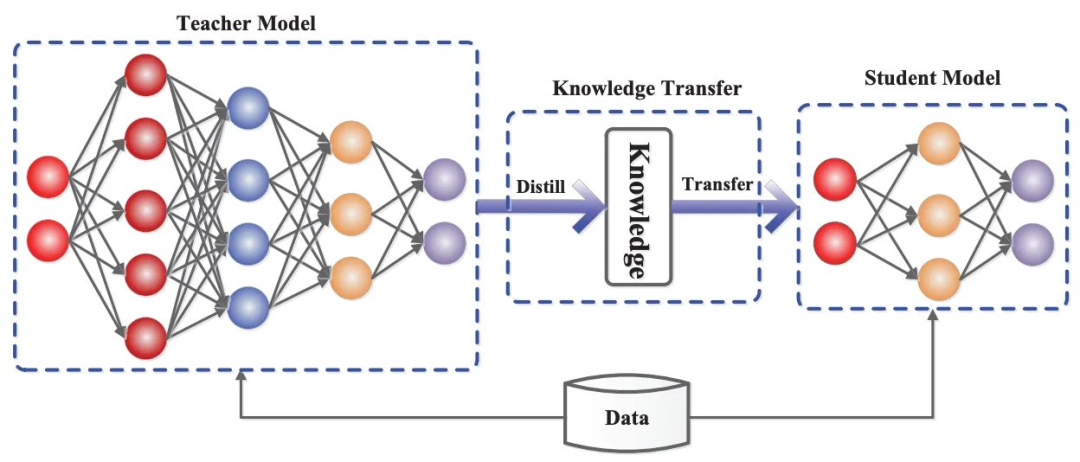

蒸餾模型

知識(shí)蒸餾過程圖示

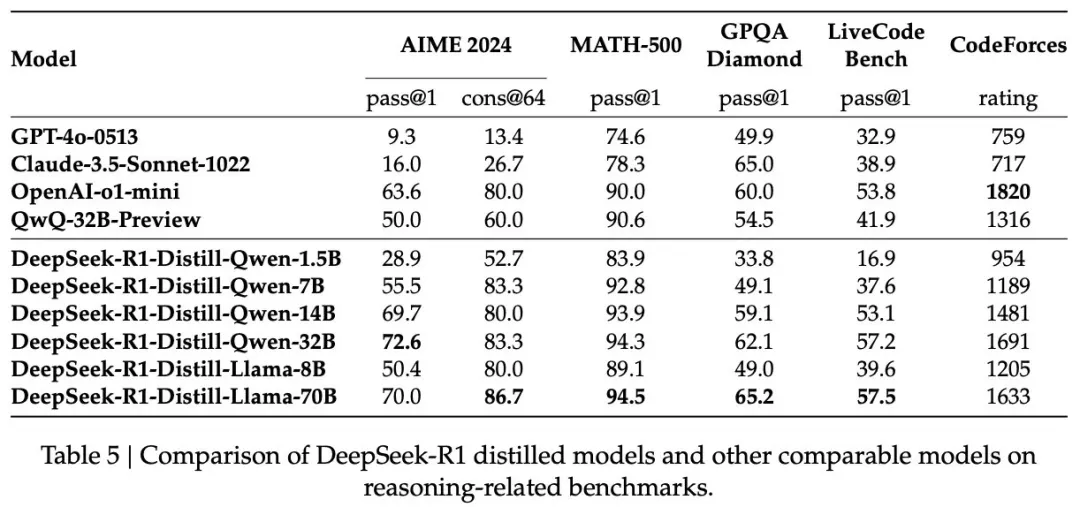

除了 DeepSeek-R1,DeepSeek 還發(fā)布了一系列基于 R1 蒸餾得到的密集模型。人們?cè)缫寻l(fā)現(xiàn),蒸餾過程可以顯著增強(qiáng)更小、更高效的模型的推理能力。完整版 DeepSeek-R1 是有著 6710 億參數(shù)的混合專家模型,非常大,因此這些蒸餾模型在實(shí)踐中非常有用 —— 它們的性能與 R1 相當(dāng),但成本更低且更易于使用。此外,這些蒸餾模型的發(fā)布與封閉推理模型(例如 o1-mini 和 o3-mini)的最新趨勢(shì)一致。

(來自 [1])

蒸餾 R1。為了創(chuàng)建這些模型,他們首先選擇了幾種不同大小的 Qwen-2.5 [20] 和 LLaMA-3 [21] 模型。然后,通過 SFT 使用在 DeepSeek-R1 訓(xùn)練流程第三階段整編的 80 萬個(gè)監(jiān)督訓(xùn)練樣本對(duì)這些基礎(chǔ)模型進(jìn)行訓(xùn)練 —— 就這么簡(jiǎn)單!

這是一個(gè)簡(jiǎn)單的知識(shí)蒸餾流程,但結(jié)果卻非常驚艷。如上所示,經(jīng)過蒸餾的 Qwen2.5-14B 模型的表現(xiàn)優(yōu)于 QwQ-32B-Preview,后者是 R1 發(fā)布之前最好的開放式推理模型。此外,即使是最小的蒸餾模型也比未針對(duì)推理進(jìn)行優(yōu)化的標(biāo)準(zhǔn)封閉式 LLM 表現(xiàn)更好(例如 GPT-4o),而 320 億和 700 億參數(shù)的蒸餾模型在大多數(shù)基準(zhǔn)測(cè)試中的性能都超過了 o1-mini。

蒸餾與強(qiáng)化學(xué)習(xí)。雖然我們?cè)谏厦娴挠懻撝锌吹秸麴s是有效的,但我們可能想知道:如果將 DeepSeek-R1 使用的大規(guī)模強(qiáng)化學(xué)習(xí)訓(xùn)練過程直接應(yīng)用于這些較小的模型,那么能獲得更好的結(jié)果嗎?

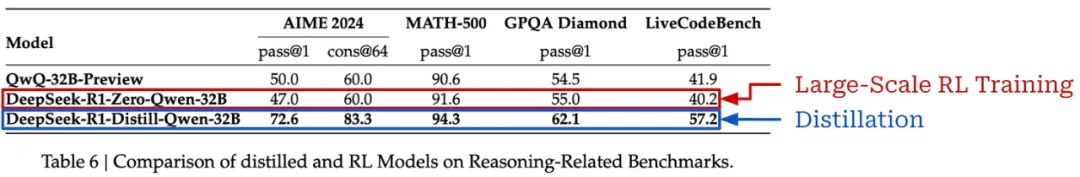

有趣的是,[1] 中提到,使用上述蒸餾方法基于 R1 蒸餾 Qwen2.5-32B 基礎(chǔ)模型比通過大規(guī)模強(qiáng)化學(xué)習(xí)直接訓(xùn)練該模型表現(xiàn)更好,如下所示。

(來自 [1])

換句話說,大型模型發(fā)現(xiàn)的推理模式對(duì)于提高這些較小、密集模型的推理能力至關(guān)重要。但是,[1] 中的作者確實(shí)提出了以下補(bǔ)充觀點(diǎn):

- 通過增加強(qiáng)化學(xué)習(xí)訓(xùn)練,蒸餾模型的性能可能得到進(jìn)一步提升。

- 「超越智能的邊界」,即創(chuàng)建超過 DeepSeek-R1 等模型性能的新推理模型,仍然需要強(qiáng)大的基礎(chǔ)模型和大規(guī)模的強(qiáng)化學(xué)習(xí)訓(xùn)練。

其他蒸餾推理模型。鑒于通過蒸餾訓(xùn)練高質(zhì)量推理模型很簡(jiǎn)單,研究界在 R1 提出后發(fā)布了各種各樣的推理模型。其中一些最吸引人的版本是:

- Sky-T1 和 Sky-T1-Flash:https://novasky-ai.github.io/posts/sky-t1/

- Bespoke Stratos:https://www.bespokelabs.ai/blog/bespoke-stratos-the-unreasonable-effectiveness-of-reasoning-distillation

- LIMO:https://arxiv.org/abs/2502.03387

- S1:https://arxiv.org/abs/2501.19393

- RedStar:https://arxiv.org/abs/2501.11284

當(dāng)然,還不止這些!當(dāng)前推理模型發(fā)布的步伐讓人想起了 LLM 研究的后 LLaMA 時(shí)代。在發(fā)布強(qiáng)大的開放基礎(chǔ)模型(即 LLaMA)之后,我們看到了基于該模型的各種模型變體(例如,Alpaca、Vicuna、Koala 等等)。現(xiàn)在,我們可以使用強(qiáng)大的開放推理模型,因?yàn)槲覀兛吹搅朔浅O嗨频内厔?shì)!該領(lǐng)域的研究非常有趣,值得單獨(dú)寫一篇文章。敬請(qǐng)期待!

主要的新趨勢(shì)

我們現(xiàn)在已經(jīng)了解了各種推理模型,從 o1 或 o3 等封閉模型開始,到 DeepSeek-R1 中對(duì)這些模型的完整復(fù)現(xiàn)。隨著我們對(duì)這項(xiàng)研究的了解,開始出現(xiàn)了一些共同的趨勢(shì)。這些趨勢(shì)對(duì)推理模型和標(biāo)準(zhǔn) LLM 的研究做出了一些重要區(qū)分。羅列如下:

長思維鏈(和推理時(shí)間擴(kuò)展)。推理模型和標(biāo)準(zhǔn) LLM 之間的關(guān)鍵區(qū)別在于它們的輸出結(jié)構(gòu)。推理模型不會(huì)直接生成最終答案(帶有可選的簡(jiǎn)明解釋),而是生成一個(gè)較長的思維鏈,其詳細(xì)描述了模型的推理過程。這個(gè)較長的思維鏈長度不一,從而在推理時(shí)可實(shí)現(xiàn)可控的計(jì)算成本:較長的思維鏈 = 更多的 token = 更多的計(jì)算。這樣,在推理時(shí)使用更多的計(jì)算(生成較長的思維鏈)已成為一種工具,可讓用戶動(dòng)態(tài)調(diào)整模型的推理能力。

通過強(qiáng)化學(xué)習(xí)進(jìn)行自我進(jìn)化。顯然,LLM 使用較長的思維鏈執(zhí)行復(fù)雜推理策略的能力是個(gè)新方向并且激動(dòng)人心。從最近的研究中,這些特殊能力發(fā)展的關(guān)鍵因素是大規(guī)模強(qiáng)化學(xué)習(xí)訓(xùn)練。我們?cè)?[1] 中看到,如果模型得到正確的激勵(lì),這種推理能力就會(huì)在強(qiáng)化學(xué)習(xí)期間自然涌現(xiàn)出來 —— 通常是通過確定性和可靠的基于規(guī)則的獎(jiǎng)勵(lì)。此外,我們可以通過使用更多的計(jì)算進(jìn)行強(qiáng)化學(xué)習(xí)訓(xùn)練來進(jìn)一步提高模型的推理能力 —— 這是我們可以利用的另一個(gè) Scaling Law!

使用更少的監(jiān)督。與標(biāo)準(zhǔn) LLM 相比,推理模型對(duì)人類監(jiān)督的依賴程度較低。特別是,強(qiáng)化學(xué)習(xí)訓(xùn)練期間的獎(jiǎng)勵(lì)主要來自基于規(guī)則的系統(tǒng),而不是依賴于人類的偏好。當(dāng)然,推理模型仍然有幾個(gè)領(lǐng)域依賴于人類的監(jiān)督;例如,基礎(chǔ)模型使用人類整理的數(shù)據(jù)進(jìn)行訓(xùn)練,驗(yàn)證依賴于人類提供的 ground truth 標(biāo)簽。然而,像 R1(尤其是 R1-Zero)這樣的推理模型仍然在大力發(fā)展,證明推理能力可以自主發(fā)展起來。

蒸餾是有效的。我們可以基于強(qiáng)大的大型推理模型,使用簡(jiǎn)單的策略將這些模型的能力蒸餾給更小、更密集的模型!這一發(fā)現(xiàn)導(dǎo)致了該領(lǐng)域研究的爆炸式增長,我們很可能會(huì)在不久的將來看到更多高效和蒸餾的推理模型發(fā)布。該領(lǐng)域的一個(gè)關(guān)鍵問題是較小的模型能否泛化,還是說難以完全匹敵其教師模型的廣度。

需要解決的新問題。最重要的是,推理模型的出現(xiàn)也帶來了各種有趣的新問題。我們還需解決的問題有:

- 如何為長思維鏈實(shí)現(xiàn)安全訓(xùn)練?

- 通用任務(wù)能力 / 推理能力之間的最佳平衡是什么?

- SFT 在訓(xùn)練推理模型中的最佳作用是什么?

- 如何最大限度地減少長思維鏈中的「過度思考」?

- 如何實(shí)現(xiàn)推理模型的高效托管?

正如本文開頭所述,推理模型是一種真正新型的 LLM,它將迫使我們重新思考現(xiàn)有的框架。多年來一直使用的技術(shù)(例如,少樣本提示)對(duì)于這些新模型來說已經(jīng)過時(shí)了。LLM 研究領(lǐng)域正在再次自我重塑。