從想太多到想不透?DeepSeek-R1等長推理模型也存在「思考不足」問題

本文將介紹首個關于長推理模型 “思考不足” 現象的工作。該工作由騰訊 AI Lab 與蘇州大學、上海交通大學團隊共同完成。本文的通訊作者為涂兆鵬,騰訊專家研究員,研究方向為深度學習和大模型,在國際頂級期刊和會議上發表學術論文一百余篇,引用超過 9000 次。擔任 SCI 期刊 NeuroComputing 副主編,多次擔任 ACL、EMNLP、ICLR 等國際頂級會議領域主席。第一作者為蘇州大學博士生王越,騰訊 AI Lab 高級研究員劉秋志、徐嘉豪、梁添,以及上海交通大學博士生陳星宇、何志威。

- 論文題目:Thoughts Are All Over the Place: On the Underthinking of o1-Like LLMs

- 論文地址:https://arxiv.org/pdf/2501.18585

背景與動機

長推理模型(Long Reasoning Models),如 OpenAI o1 [1]、QwQ-32B-Preview [2]、 DeepSeek-R1-671B [3] 和 Kimi K1.5 [4] 等,因其展現出類似人類的深度思考能力而備受關注。這些模型通過長時間推理(Inference-Time Scaling),能夠在解碼階段不斷思考并嘗試新的思路來優化自身的答案質量。然而,長推理模型在推理過程中所有的思考是否高效,這一問題仍未得到充分探索。

此前,騰訊 AI Lab 的研究團隊發現,長推理模型在面對簡單問題時,其思考行為會出現大量重復,從而浪費大量計算資源 [5](o1 也會「想太多」?騰訊 AI Lab 與上海交大揭秘 o1 模型過度思考問題)。而在面對難題時,長推理模型的思考模式是否高效依然是一個疑問。基于此,該研究團隊進一步深入研究,試圖揭示長推理模型在復雜問題上的表現及其潛在問題。

思考不足是長推理模型的 “注意力缺陷多動障礙”

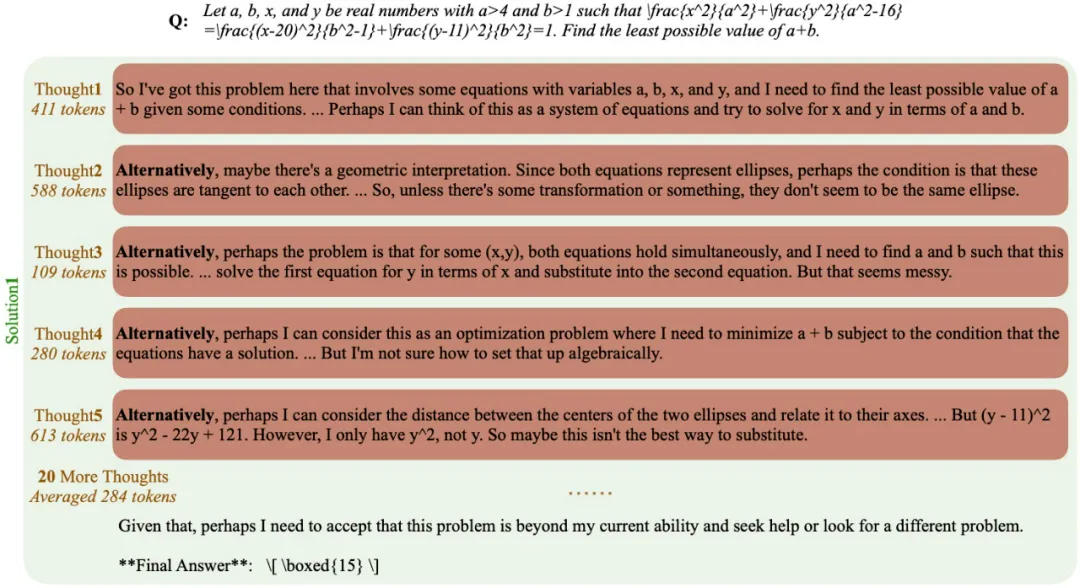

研究團隊的最新研究顯示,長推理模型在推理過程中往往頻繁地進行思路跳轉,無法將注意力集中在一個正確的思路上并深入思考,從而得到正確答案。研究團隊首先將 “思路(thought)” 定義為模型在推理策略中產生的中間認知步驟。長推理模型常常通過使用 “alternatively” 等術語來切換推理思路。例如,在下圖所示的例子中,模型可能會從代數操作轉向幾何解釋,再到優化策略。這種思路切換使得長推理模型能夠更廣泛地探索潛在的解決方案,展示了其在解決復雜問題時的靈活性。

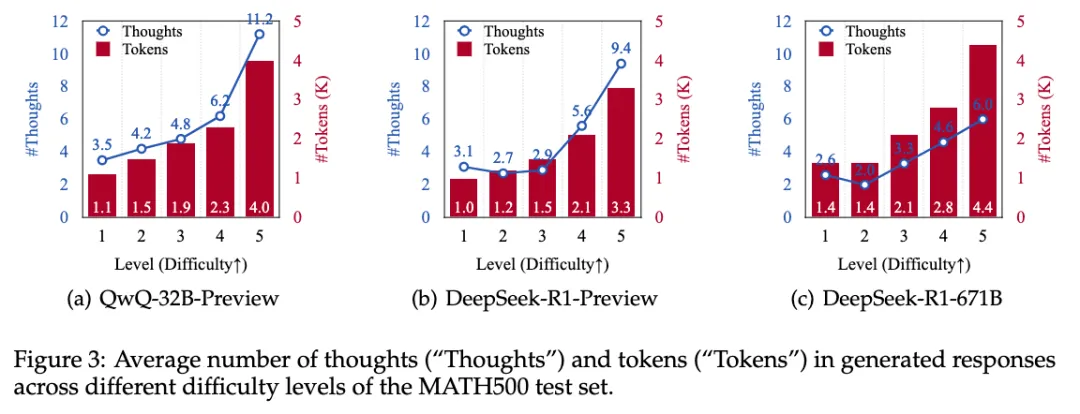

研究人員統計了在 MATH500 測試集的不同難度級別下,生成回答時的平均思路和 token 數量:

顯然,隨著難度增加,所有模型產生的推理思路也有所增多,并且這一趨勢與生成 token 數量的增長一致。這表明,隨著問題復雜性的增加,模型更傾向于頻繁切換思路,從而能夠動態調整推理過程,以應對更具挑戰性的問題。

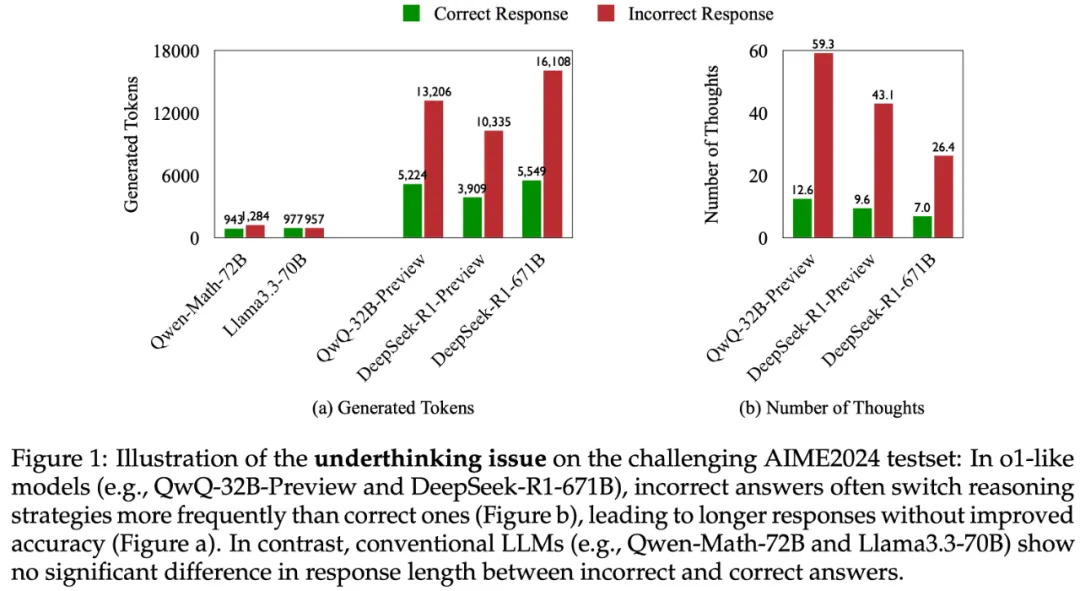

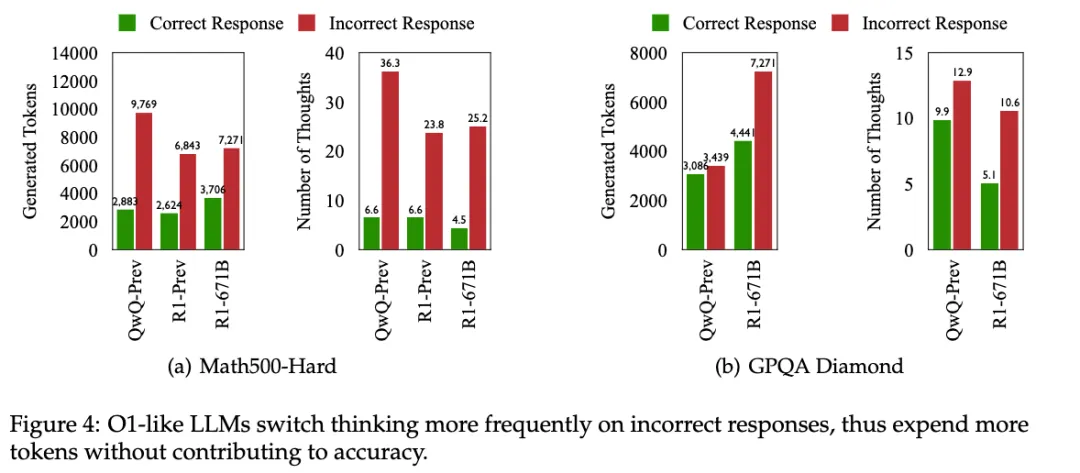

那么,長推理模型是否會在思路切換的過程中提升其準確率呢?圍繞這一問題,研究團隊在 AIME24、Math500-Hard 和 GPQA Diamond 等測試集上,對正確回答和錯誤回答的平均思路數量以及 token 數量進行了深入分析,結果如下圖所示:

相較于正確答案,長推理模型在錯誤回答中往往會出現更多的推理思路切換。這導致了回答長度顯著增長,但準確性卻未能相應提升。平均而言,長推理模型在 AIME24 上的錯誤回答中因頻繁思路切換,生成的 token 數量比正確回答多出 225%,思路數量增加了 418%。相比之下,傳統的 LLM(如 Qwen-Math-72B 和 Llama3.3-79B)在正確與錯誤回答之間的回答長度沒有顯著差異。

這一趨勢表明,盡管模型被設計為動態調整其認知過程來解決問題,但更頻繁的思路切換并不一定能提升準確性。換句話說,在處理難題時,長推理模型也存在 “注意力缺陷多動障礙” 的問題。研究團隊將這種現象命名為 “思考不足”(Underthinking),即長推理模型在推理過程中頻繁地進行思路跳轉,無法將注意力集中在一個正確的思路上并深入思考,從而得到正確答案。實際上,模型可能在消耗額外計算資源(通過增加生成的 token 體現)時,未能提供更精確的解決方案。這些發現表明,在面對復雜問題時,除了探索額外的認知途徑外,更需要以更有針對性和高效的方式進行操作,才能在推理復雜的問題時提升準確性。

量化 “思考不足”

研究團隊認為,頻繁切換思路而得出錯誤答案的行為,可能源于以下兩個原因:一是真正的思考不足,即模型雖然找到了一條有希望的思路,但未能持續深入地堅持下去;二是對問題缺乏深入理解,從而盲目探索各種無效的方法。

為了進一步厘清這些可能性,研究團隊提出了一個評估框架,用于評估一條被放棄的推理路徑是否足以得出正確的答案。通過關注模型是否能夠持續遵循和深化一條 “看起來有希望的思路”,可以識別思考不足的情況。具體而言,研究團隊使用 DeepSeek-R1-Distill-Llama-70B 和 DeepSeek-R1-Distill-Qwen-32B 來判斷一個思路是否能得到正確答案。

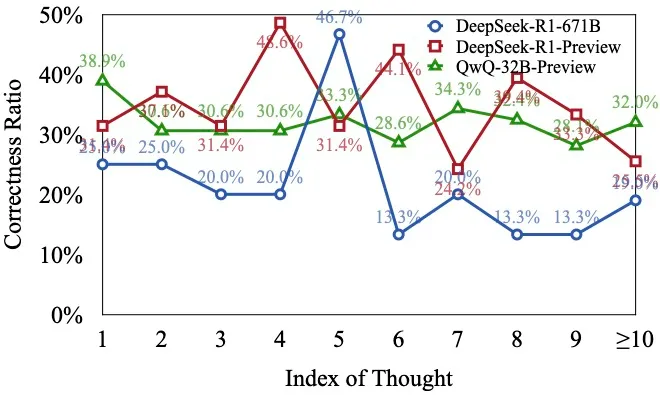

為了驗證模型回答中的初步想法是否正確,下圖展示了在錯誤回答中不同位置思路的正確比例。

結果顯示,在各種模型的初步想法中,相當一部分的解題思路是正確的,但遺憾的是,模型并沒有深入思考這些解題思路,而是過早地放棄了。這一現象表明,模型需要增強持續深入且準確地探索特定推理路徑的能力,而不是輕易轉向其他思路。

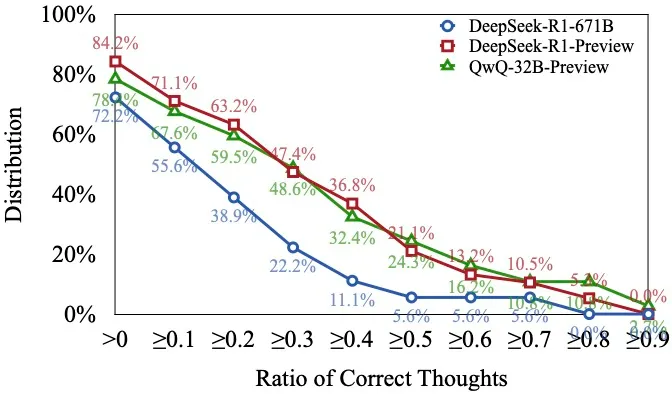

此外,研究團隊還分析了不同模型的錯誤回答中正確思路比例的分布情況,如下圖所示:

觀察發現,超過 70% 的錯誤回答中至少包含一個正確的思路。此外,在這些回答中,有超過 50% 的回答其正確思路的比例達到 10% 以上。這表明,雖然長推理模型能夠成功找到正確的推理思路,但它們往往難以沿著這些路徑持續深入,進而得出正確的結論。這一現象凸顯了鼓勵模型保持并拓展其最初正確思路的重要性,以便將這些正確思路整合為準確的最終答案。

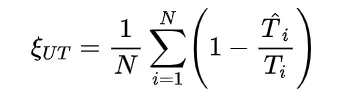

基于上述觀察結果,研究團隊提出了第一個針對長推理模型思考不足的指標(Underthinking Score),表示為 。該指標的計算公式為:

。該指標的計算公式為:

其中,N 是測試集中的錯題數量, 是第 i 個錯題的回答 token 數量,

是第 i 個錯題的回答 token 數量, 是從該回答開始到第一個正確想法為止的 token 數量(包括第一個正確想法)。如果第 i 個回答中沒有正確的思路,則

是從該回答開始到第一個正確想法為止的 token 數量(包括第一個正確想法)。如果第 i 個回答中沒有正確的思路,則  ,表示模型對該問題缺乏理解,因此無法認為是 “思考不足”。直觀地說,如果一個模型在回答過程中最初產生了正確的思路,但隨后轉向其他思路并最終未能得出正確答案,那么此后生成的 token 對于最終達到正確答案并無實質性貢獻。這種情況下,由于缺乏足夠的思考深度,模型的推理過程被認為是低效的。具體而言,

,表示模型對該問題缺乏理解,因此無法認為是 “思考不足”。直觀地說,如果一個模型在回答過程中最初產生了正確的思路,但隨后轉向其他思路并最終未能得出正確答案,那么此后生成的 token 對于最終達到正確答案并無實質性貢獻。這種情況下,由于缺乏足夠的思考深度,模型的推理過程被認為是低效的。具體而言, 值低表示更高的推理效率,這意味著在錯誤回答中,有更大比例的 token 能夠為正確思路的形成提供支持;

值低表示更高的推理效率,這意味著在錯誤回答中,有更大比例的 token 能夠為正確思路的形成提供支持; 值高表示較低的推理效率,意味著有更大比例的 token 未能有效助力于正確思路的生成,即模型可能因頻繁切換思路而生成大量冗余或不相關的 token。

值高表示較低的推理效率,意味著有更大比例的 token 未能有效助力于正確思路的生成,即模型可能因頻繁切換思路而生成大量冗余或不相關的 token。

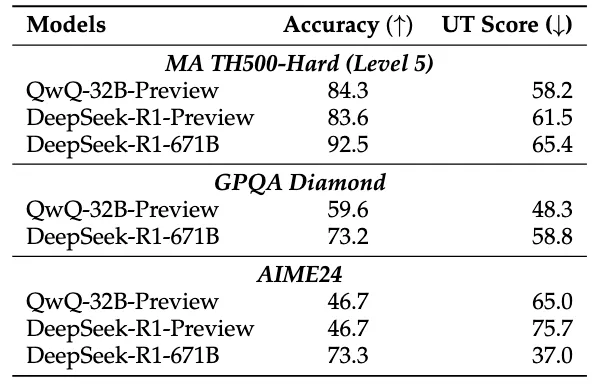

借助這一指標,研究人員能夠定量地評估模型在錯誤回答中的推理效率。下表展示了不同模型的準確率(越高性能越強)和思考不足得分 (越小越能充分思考):

(越小越能充分思考):

結果表明,單純增大模型尺寸并不能避免思考不足,模型準確率的提升也不一定會減少該現象。由此可見,我們需要深入探索思考不足這一復雜現象,從而在訓練模型的過程中,不僅使其能夠給出正確的答案,還能具備高效的推理能力。

緩解思考不足:引入思路轉換懲罰

為了緩解長推理模型的思考不足現象,研究團隊提出了一種懲罰思路轉換的解碼策略,稱為 “Thought Switching Penalty”(TIP)。該策略通過在生成過程中對思路切換施加懲罰,鼓勵模型在深入探索每個推理路徑后再考慮其他替代方案。

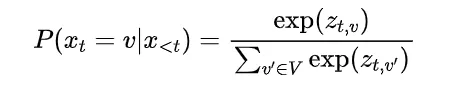

在標準的解碼過程中,在位置 t 生成 token v 的概率是通過對輸出層的 logits 使用 softmax 函數計算的:

其中  是位置 t 關于 token v 的 logit(未歸一化的分數)。為了鼓勵模型在切換思路之前更深入地探索當前思路,研究團隊引入了一個對與思路轉換相關的表達懲罰。具體而言,設

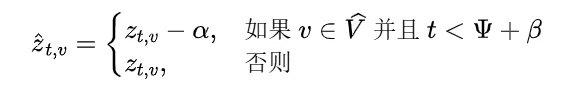

是位置 t 關于 token v 的 logit(未歸一化的分數)。為了鼓勵模型在切換思路之前更深入地探索當前思路,研究團隊引入了一個對與思路轉換相關的表達懲罰。具體而言,設 是與思路切換相關的詞匯集合(例如,“alternatively”),作者們修改了 logits 如下:

是與思路切換相關的詞匯集合(例如,“alternatively”),作者們修改了 logits 如下:

其中: (懲罰強度)是一個控制對思路切換標記施加懲罰強度的參數。較大的

(懲罰強度)是一個控制對思路切換標記施加懲罰強度的參數。較大的 會導致這些詞語的 logits 減少更多,使它們被選中的可能性降低;

會導致這些詞語的 logits 減少更多,使它們被選中的可能性降低; (懲罰持續時間)指定了從思路開始位置

(懲罰持續時間)指定了從思路開始位置  起的懲罰生效的位置數。較大的

起的懲罰生效的位置數。較大的 會延長懲罰的范圍,進一步阻止過早的思路切換;當

會延長懲罰的范圍,進一步阻止過早的思路切換;當 時,懲罰被禁用,解碼過程退化為標準解碼算法。

時,懲罰被禁用,解碼過程退化為標準解碼算法。

調整后的 logits 減少了在指定窗口內生成思路切換標記的概率,從而鼓勵模型在繼續擴展當前思路之前不進行切換。新的概率分布變為:

減少了在指定窗口內生成思路切換標記的概率,從而鼓勵模型在繼續擴展當前思路之前不進行切換。新的概率分布變為:

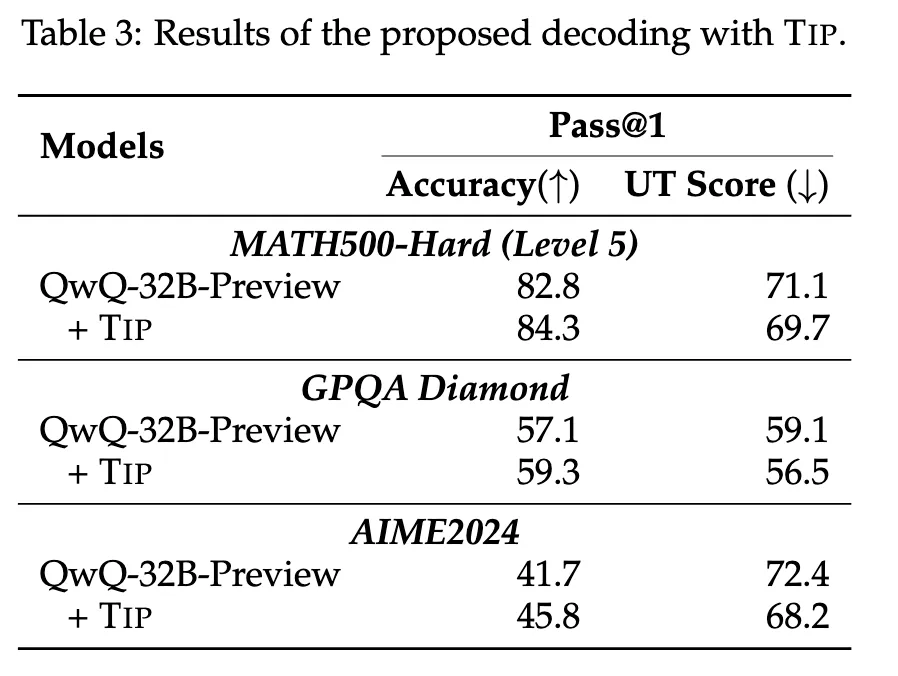

TIP 策略通過懲罰機制抑制模型生成思路轉換相關的詞語,從而鼓勵模型在生成文本時保持其原始的推理路徑,并進行更深入的思考,避免頻繁的策略切換和表面化的推理模式。下圖展示了 QwQ-32B-Preview 在加入了 TIP 策略之后的結果:

結果顯示,通過引入 TIP 策略,即使不進行模型微調也能在 MATH500-Hard、GPQA Diamond 和 AIME2024 上獲得準確率提升并減少思考不足。

總結

騰訊 AI Lab 與蘇州大學、上海交通大學聯合團隊最新發現,長推理模型也存在思考不足問題。具體體現為長推理模型在推理過程中頻繁地進行思路跳轉,無法將注意力集中在一個正確的思路上并深入思考,從而得到正確答案。研究團隊將這種現象命名為 “思考不足”(Underthinking)。

研究團隊首先觀察到長推理模型頻繁切換思路的現象,并進一步發現這一現象由思考不足導致。為了定量評估思路切換的問題,研究團隊引入了一種新穎的思考不足指標,為推理效率低下提供了量化評估框架。同時,研究團隊提出了一種緩解思考不足的簡單有效方案 —— 帶有思路切換懲罰(Thought Switching Penalty,TIP)的解碼方法。該方法鼓勵模型在考慮替代方案之前,徹底探索每一條推理思路,從而無需額外的微調就能提高模型的準確性。

這項研究不僅揭示了長推理模型在推理過程中的不足之處,還提供了一種實用的解決方案,有助于顯著提升模型在處理復雜問題時的表現。展望未來,研究者將繼續探索模型中的自適應機制,以實現對思路轉變的自我調節,進一步提高長推理模型的推理效率。