阿里推理模型一戰封神!32B硬剛671B DeepSeek,1/10成本,蘋果筆記本可跑

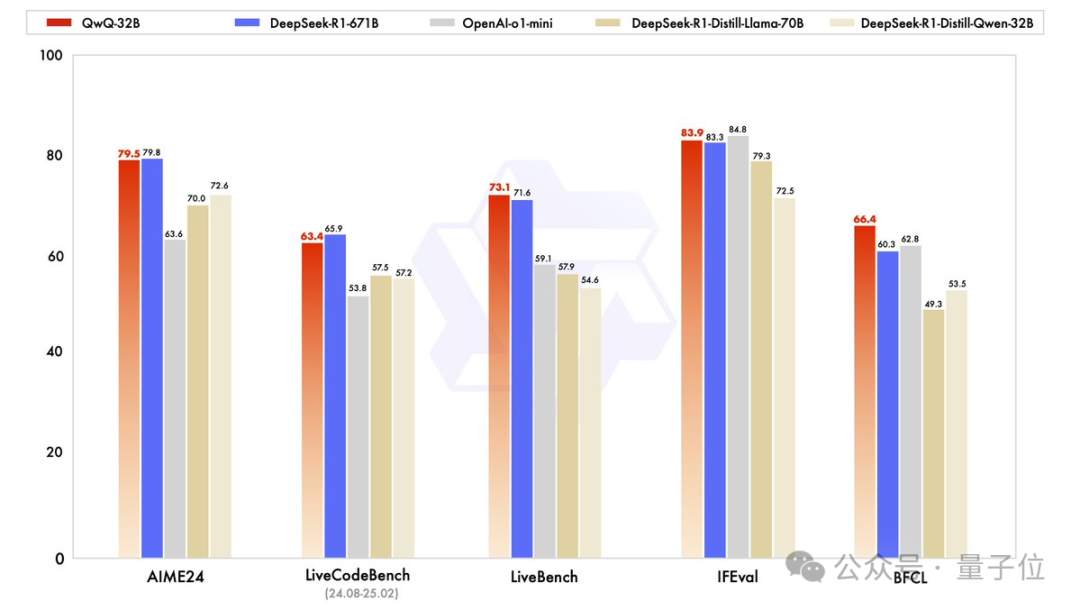

起猛了,Qwen發布最新32B推理模型,跑分不輸671B的滿血版DeepSeek R1。

都是杭州團隊,要不要這么卷。

圖片

圖片

QwQ-32B,基于Qwen2.5-32B+強化學習煉成。

圖片

圖片

之后還將與Agent相關的功能集成到推理模型中:

可以在調用工具的同時進行進行批判性思考,并根據環境反饋調整其思考過程。

圖片

圖片

QwQ-32B的權重以Apache 2.0 許可證開源,并且可以通過Qwen Chat在線體驗。

圖片

圖片

手快的網友直接就是一個本地部署在m4max芯片蘋果筆記本上。

圖片

圖片

也有網友連夜at各大第三方API托管方,趕緊起來干活了。

圖片

圖片

32B不輸DeepSeek R1

目前QwQ-32B還未放出完整技術報告,官方發布頁面對強化學習方法做了簡短說明:

從一個冷啟動檢查點開始,實施了由Outcome Based Reward驅動的強化學習(RL)擴展方法。

在初始階段專門針對數學和編碼任務擴展強化學習,沒有依賴傳統的獎勵模型,而是使用一個數學問題準確性驗證器來確保最終解決方案的正確性,并使用一個代碼執行服務器來評估生成的代碼是否成功通過預定義的測試用例。

隨著訓練輪次的推進,兩個領域的性能都呈現持續提升。

在第一階段之后,為通用能力增加了另一階段的強化學習,它使用來自通用獎勵模型的獎勵和一些基于規則的驗證器進行訓練。

團隊發現,這一階段少量步驟的強化學習訓練可以提高其他通用能力的性能,如遵循指令、符合人類偏好以及智能體性能,同時在數學和編碼方面不會出現顯著的性能下降。

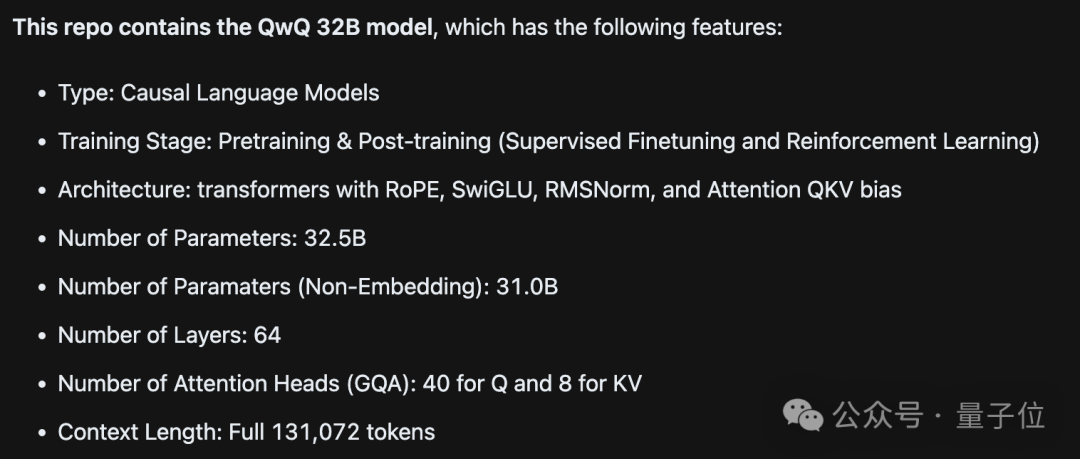

此外在ModelScope頁面,還可以看出QwQ 32B是一個密集模型,沒有用到MoE,上下文長度有131k。

圖片

圖片

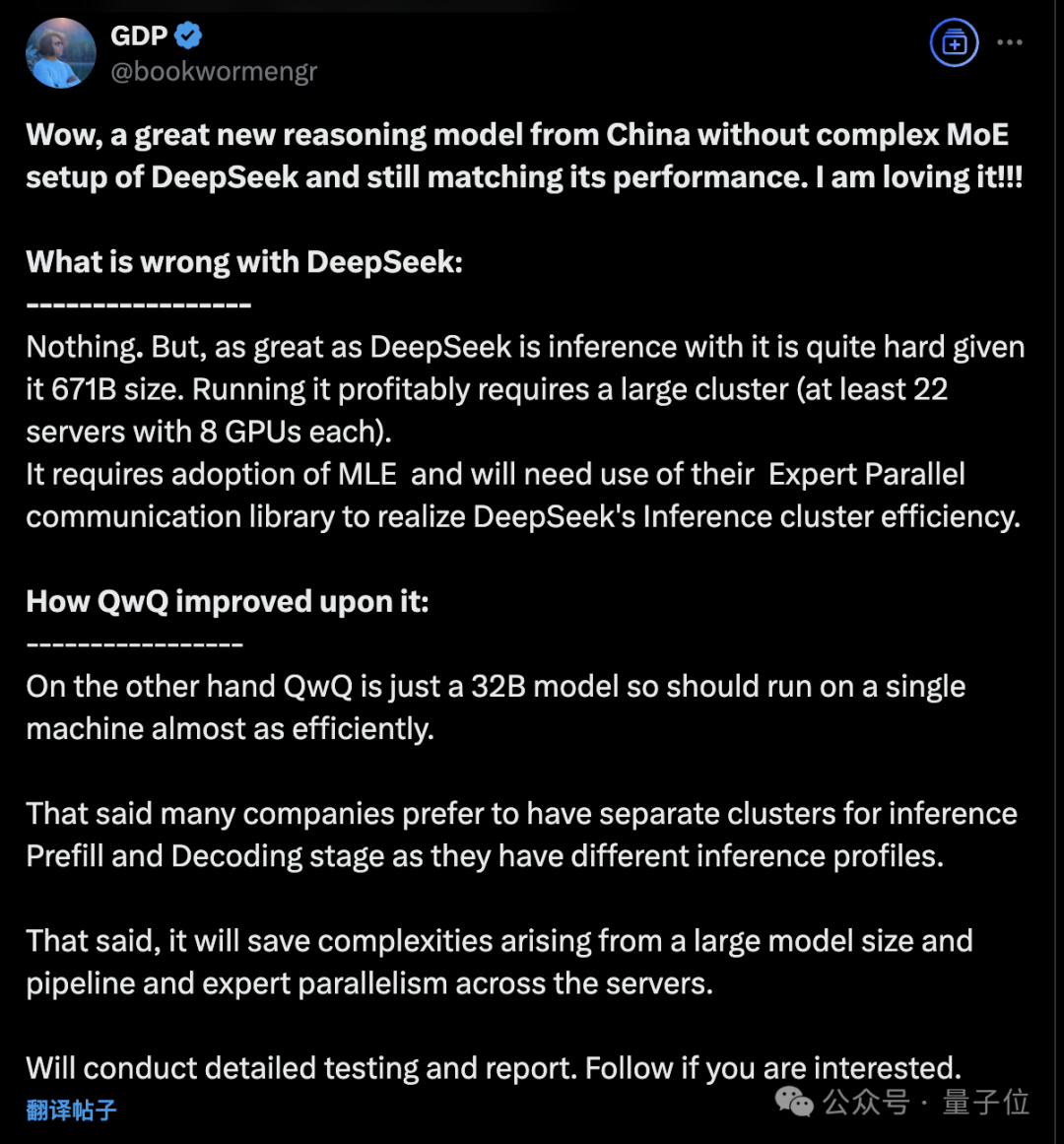

對此,有亞馬遜工程師評價不用MoE架構的32B模型,意味著可以在單臺機器上高效運行。

DeepSeek沒有問題,很強大,但要托管他且盈利需要一個大型集群,還需要使用DeepSeek最近開源的一系列通信庫。

……另一方面QwQ 32B可以減少由流水線并行、專家并行帶來的復雜性。

圖片

圖片

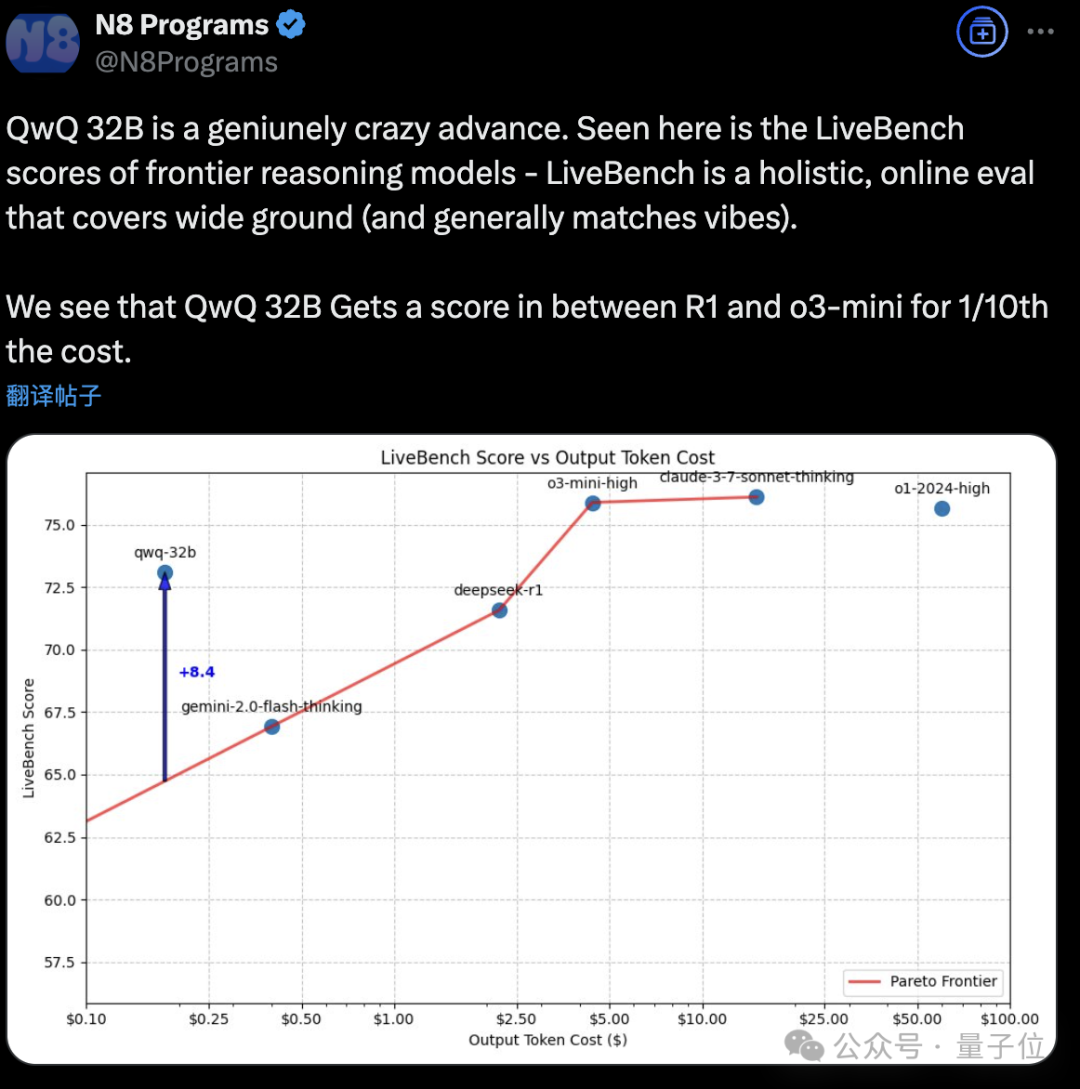

如果將QwQ 32B添加到代碼能力與輸出token成本的圖表中,可以看到它以約1/10的成本達到了DeepSeek-R1與o3-mini-high之間的性能。

圖片

圖片

在線體驗:

https://chat.qwen.ai

https://huggingface.co/spaces/Qwen/QwQ-32B-Demo

參考鏈接:

[1]https://qwenlm.github.io/blog/qwq-32b/

[2]https://x.com/Alibaba_Qwen/status/1897366093376991515