全球首個工業界多模態推理模型開源!38B硬剛DeepSeek-R1,訓練秘籍全公開

剛剛,昆侖萬維正式開源了全球首個工業界多模態推理模型Skywork R1V(以下簡稱「R1V」)!

R1V高效地將DeepSeek-R1這種強大的文本推理能力無縫scaling到了視覺模態,實現了多模態領域的領先表現,并以開源方式推動了技術進步。

由此,多模態推理的新時代即將開啟。

R1V的實力,究竟有多強?

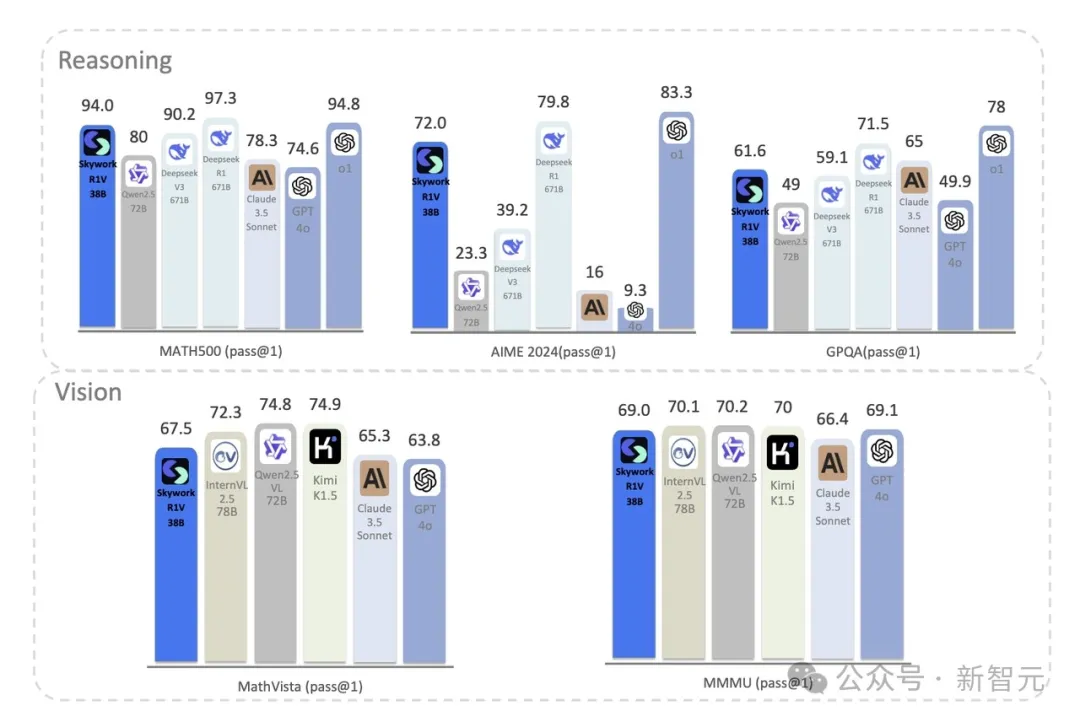

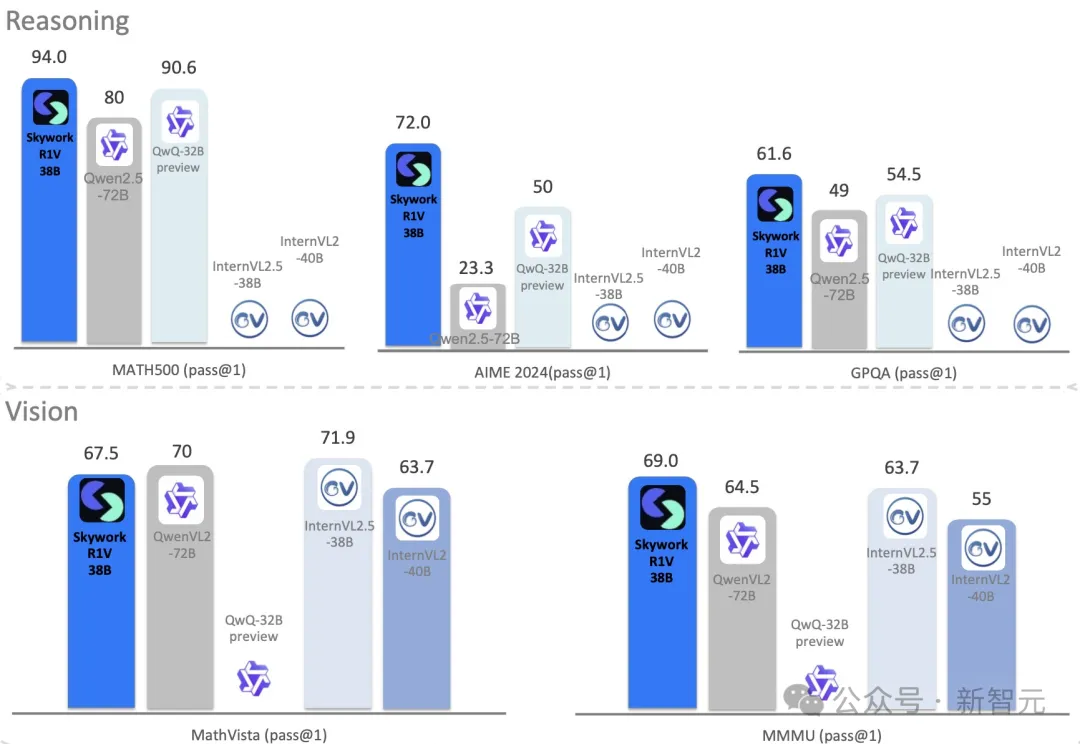

在視覺問答任務中,R1V直接對標Claude 3.5 Sonnet、GPT-4o等閉源模型,同時還保留了頂級文本推理能力。

在MMMU基準測試中,R1V以69分創下同等規模新高,在MathVista上拿下67.5分,達到領先的開源模型水平。

無論是復雜的數學推理,還是圖像中的邏輯分析等,R1V都能輕松駕馭,堪稱多模態領域的「全能戰士」。

總結來說,R1V有以下三大亮點。

1. 全球第一個工業界開源多模態+推理模型

2. 性能接近甚至超越了規模大兩倍的開源模型

3. 通過開源讓技術可以惠及到更多人

這背后的締造者,就是中國的AI科技公司——昆侖萬維。

R1V的問世,更以開放的姿態為全球AI開源社區注入了全新活力。

即日起,模型權重、推理代碼、技術報告全盤開源。

GitHub:https://github.com/SkyworkAI/Skywork-R1V

Hugging Face:https://huggingface.co/Skywork/Skywork-R1V-38B

技術報告:https://github.com/SkyworkAI/Skywork-R1V/blob/main/Skywork_R1V.pdf

這標志著,昆侖萬維成為全球首家開源多模態思考模型的公司,朝著AGI落地邁出重要的一步。

而選擇開源R1V視覺思考模型,也正是昆侖萬維為了更堅定地貫徹AGI的夢想,推動開源社區的技術進步。

R1V:全球首款開源多模態推理模型

此前,OpenAI o1和DeepSeek-R1在全球帶來了長思考模型的熱潮,讓大模型領域進入了全新的技術范式。

而不同于長思考模型專注于多步推理的特點,視覺思考模型則專注于從圖像或視頻中提取信息、進行邏輯推理。

如果要給它下個定義的話,什么是視覺思考模型?

簡單來說,視覺思考模型是一種,能在文本、視覺復雜任務中,展現驚人推理能力的AI。

它不僅能「讀懂」文字,還能「看懂」圖像,并基于此進行深度分析和邏輯推理。

首先來一道數學題:「用圓心角為120°,半徑為6cm的扇形紙片卷成一個圓錐形無底紙帽,則這個紙帽的高是?」

R1V經過短暫糾錯后,給出了清晰完整的解題過程,并得出正確答案,表現出了較強的邏輯推理能力。

圖片

圖片

接下來再來一道更難一些的:「函數f(x)=∣2x?3∣+1在x=2和x=5處的導數關系是?」

可以看到,R1V先找到了絕對值部分∣2x?3∣的零點:令2x-3=0得x=1.5。

然后得出,當x≥1.5時,f(x)=2x-3+1=2x-2,導數f?'(x)=2;當x<1.5時,f(x)=-(2x-3)+1=-2x+4,導數f?'(x)=-2。

由于題目中的x=2和x=5均大于1.5,所以都屬于f(x)=2x-2部分。因此,f?'(2)=2,f?'(5)=2,即兩點處的導數相等。

最后,R1V給出了答案:(B)等于。

圖片

圖片

以上案例中不難看出,R1V在視覺+推理上表現驚艷,所以,它是如何逆襲成功的?

煉丹之道,細節全公開

最新公開的技術報告中,揭秘了三大殺招。

跨模態遷移學習

昆侖萬維的研究者,首次發現了跨模態的遷移學習。

R1V首次實現了將大模型的文本推理能力高效遷移至視覺模態,通過Skywork-VL視覺投影器的有效訓練,顯著保留了原有的推理能力。

整個過程無需從頭重新訓練基座語言模型和視覺編碼器,且有效保留了原有的文本推理能力。

具體來說,研究者提出了一種高效的多模態遷移方法,通過MLP結構,有效地將具有推理能力的語言模型與視覺骨干對齊。

這樣,就大幅減少了對大量多模態推理數據的需求。

這種方法背后的關鍵洞察,就在于將視覺-語言表示的對齊與推理能力的保留解耦。

直接將具有推理能力的語言模型(fl)連接到視覺骨干(fv),會需要大量的 R1風格格式的多模態推理數據,以同時實現這兩個目標。

然而這種做法成本太高,不切實際。因此,研究者采用了一種相反的分階段策略。

首先,他們訓練一個MLP適配器,將fv與具有相同架構但無推理能力的替代語言模型( )對齊;隨后,他們利用

)對齊;隨后,他們利用 和fl之間的潛在相似性,將預訓練的MLP轉移,以使fv與原始的推理能力模型fl對齊。

和fl之間的潛在相似性,將預訓練的MLP轉移,以使fv與原始的推理能力模型fl對齊。

這樣,所需數據量就大幅減少。

所導致的結果就是,正如前文提到的,R1V在權威的數學推理基準測試AIME和MATH500中,分別取得72.0和94.0的高分,展現了強大的推理競爭力。

在同等規模大小模型中的推理能力遙遙領先,并且與閉源模型以及大尺寸模型相比,仍有很強的競爭力。

這樣的優異的文本推理能力,直接「搬家」視覺領域,效率直接拉滿。

混合式訓練策略

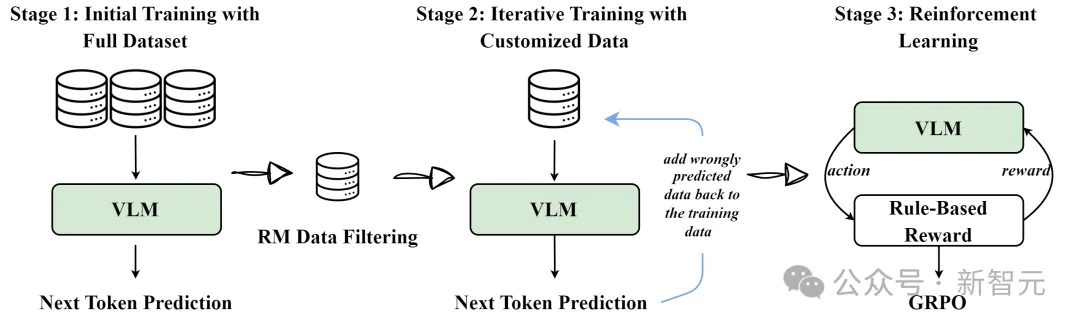

R1V還采用了迭代監督微調(Iterative SFT)和 GRPO強化學習相結合的混合訓練方法,能夠動態調整思維鏈長度。

這個過程,一共分為三個階段。

階段1:使用完整數據集,進行初始訓練;

階段2:使用定制數據,進行迭代訓練;

階段3:強化學習。

混合式訓練策略

具體而言,在SFT階段,研究人員迭代訓練一系列模型M?, ..., M?,其中每個后續模型M???,都在獎勵模型選擇的高質量數據和前一迭代中處理不正確的樣本上進行訓練。

在RL階段,遵循了DeepSeek R1提出的方法,利用基于規則的獎勵系統GRPO,進一步提升模型的泛化能力。

強化學習訓練完成后,研究人員選擇一個在性能和推理合理性之間達到最佳平衡的模型作為最終模型。

經此訓練后的模型,不僅提升了推理效率,還在開源模型中,率先實現SOTA。

經過強化學習訓練,R1V在MMMU基準上達到69分的高分,同時在MathVista上取得67.5分,接近更大規模閉源模型的表現。

自適應長度思維鏈蒸餾

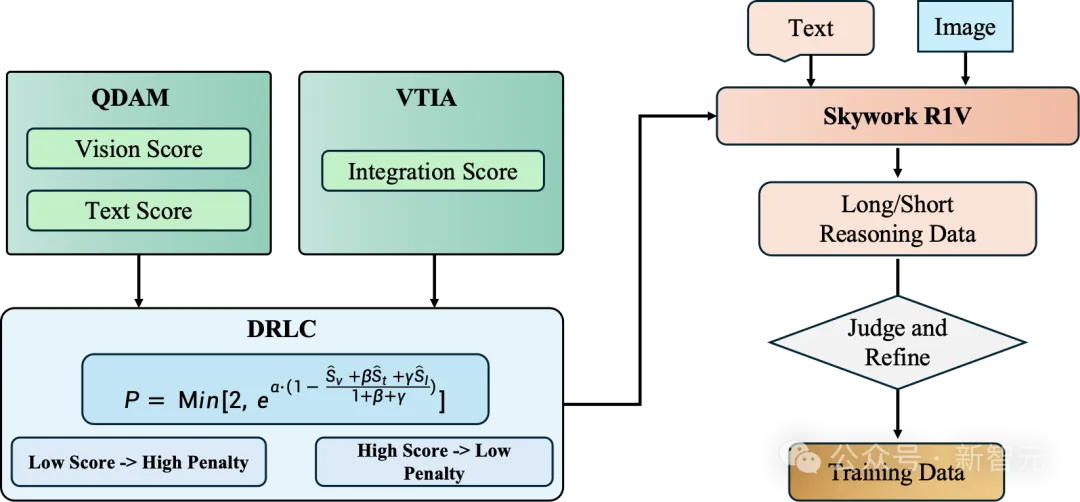

此外,研究團隊還提出了一個自適應長度的思維鏈蒸餾(AL-CoTD)框架。

像o1這樣的推理模型之所以表現出色,很大程度上歸功于,它們在推理時能模擬人類長時間的思考過程。

然而,一個關鍵問題來了——推理模型有時會「過度思考」。

或許你也感同身受:輸入一個問題后,AI有時會反復思考很多遍。

最近,來自UC伯克利CMU、UMass Amherst、上交大等國內外機構也通過研究實證,推理模型「過度思考」會導致計算資源浪費,甚至損害模型本身的性能。

某些情況下, AI生成的序列可能長達數萬個token,收益卻微乎其微。

昆侖萬維提出的AL-CoTD框架,可根據需求動態調整思維鏈長度,有效緩解推理模型「過度思考」的問題,并顯著提升了推理效率。

它一共包含三大核心組件:質量與難度評估模塊(QDAM)、視覺-文本集成分析器(VTIA)、動態推理長度控制器(DRLC)。

自適應長度思維鏈蒸餾

· QDAM

質量與難度評估模塊利用GPT-4o系統性地評估圖文查詢對,從視覺得分(Sv)和文本得分(St)兩個主要維度進行分析。

視覺得分(Sv)會量化圖像的視覺特征,具體包括圖像清晰度和圖像必要性。文本得分(St)則會分析語言特性,主要涵蓋問題質量、難度級別和推理需求。

這個綜合評估框架能夠捕捉多模態查詢中的感知復雜性和認知復雜性,從而能更準確地評估多模態任務的難度。

· VTIA

視覺-文本融合分析器(VTIA) 通過句法分析和語義分析確定跨模態融合的必要深度,并計算融合評分(SI)。

VTIA依靠GPT-4o識別圖文查詢中的模式,并根據查詢的復雜程度動態調整融合需求。

高融合模式常見于科學解釋類問題,涉及多個視覺對象的空間關系理解,需要高階視覺推理能力。低融合模式主要出現在物體識別任務,側重于直接物體識別,不需要復雜推理。

這樣,VTIA就實現了針對查詢復雜度的自適應跨模態融合,確保模型合理分配計算資源。

· DRLC

動態推理長度控制器(DRLC) 通過歸一化的視覺得分( )、文本得分(

)、文本得分( )和融合評分(

)和融合評分( )來動態調節推理鏈的長度。

)來動態調節推理鏈的長度。

這些歸一化得分通過最小-最大縮放歸一化到區間 [0,1]。

推理鏈長度的調節遵循以下兩大原則:

- 降低重復懲罰(促進深入推理):當圖文質量高、認知難度大、視覺場景復雜時,降低重復懲罰,以允許更長的推理鏈。

- 高重復懲罰(減少冗余推理):當查詢涉及低難度任務、簡單視覺識別,且文本-圖像的融合需求較低時,提高重復懲罰,從而縮短推理鏈,避免不必要的復雜推理。

· 多階段自蒸餾管線

在DRLC模塊的基礎上,研究者進一步引入漸進式自蒸餾策略,以提高推理數據的質量。

總結來說,這篇論文的發表,也意味著相較于其他不開源或不免費的模型,昆侖萬維無償把上述技術思路給開源了。

這也就充分體現出R1V和DeepSeek的思路一樣,希望通過開源持續打造技術影響力。

進化全模態

值得一提的是,當前想要打造一個全模態的模型,不僅需要在特定領域獨立訓練多個專業模型,而且還會面臨跨模態協同的算力挑戰。

為實現多模態到全模態的跨越,團隊設計了一種全新的全模態擴展技術,使得R1V在單個模型中具備同時處理圖像、視頻、語音等多種模態信息的能力。

結果顯示,「進化」后的R1V不僅能夠在單個模型中同時實現圖像、視頻、語音的全模態思考能力,而且還能在語音和視覺理解評測中均斬獲多項SOTA成績。

敢為人先,中國AI企業硬核擔當

作為中國AI領軍企業,昆侖萬維始終秉持著——實現AGI,讓每個人更好塑造和表達自我,持續深耕AI前沿技術。

過去3年,這家公司在音樂大模型、文本大模型、視頻模型等領域,取得了一系列突破,并構建起了完整的AI產品矩陣:

- 天工AI搜索

- 全球首個AI音樂創作平臺Mureka

- AI短劇平臺SkyReels

更值得一提的是,上個月,團隊還發布了世界模型系列Matrix-Zero。

當世界模型能夠模擬物理世界時,虛擬實驗、仿真和影視創作都將迎來爆發式增長。

從AI前沿基礎研究,到基座模型,再到AI矩陣產品/應用的完整布局,昆侖萬維正一步步將技術愿景變為現實。

下一步,他們還將陸續開源具有空間推理能力和世界理解能力的視覺思考模型,以及全模態思考模型。

而R1V的誕生,是中國AI向世界發出的洪亮聲音。