國產大模型DeepSeek-V3一夜火爆全球,671B的MoE,訓練成本僅558萬美元

今天,一個國產大模型火遍了世界。

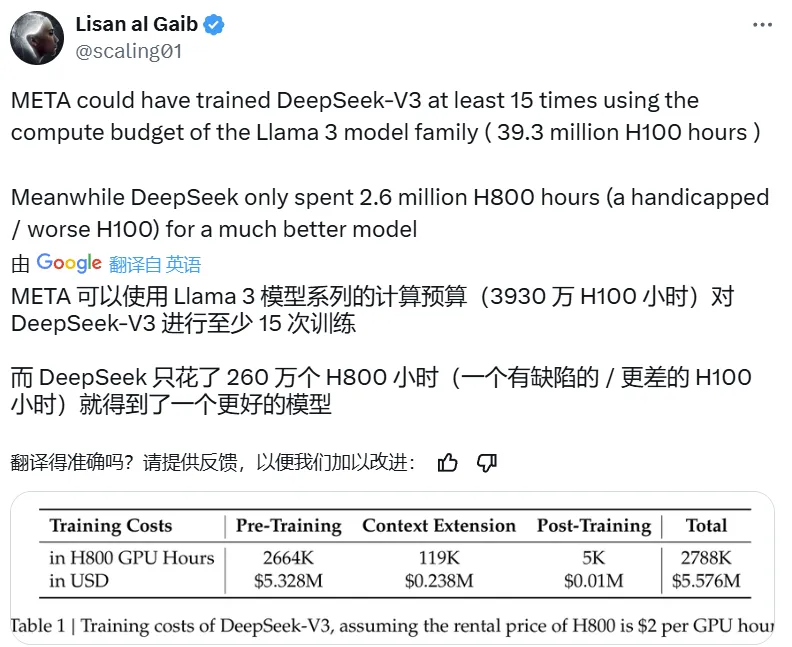

打開 X,滿眼都是討論 DeepSeek-V3 的推文,而其中最熱門的話題之一是這個參數量高達 671B 的大型語言模型的預訓練過程竟然只用了 266.4 萬 H800 GPU Hours,再加上上下文擴展與后訓練的訓練,總共也只有 278.8 H800 GPU Hours。相較之下,Llama 3 系列模型的計算預算則多達 3930 萬 H100 GPU Hours—— 如此計算量足可訓練 DeepSeek-V3 至少 15 次。

雖然相對于其它前沿大模型, DeepSeek-V3 消耗的訓練計算量較少,但其性能卻足以比肩乃至更優。

據最新發布的 DeepSeek-V3 技術報告,在英語、代碼、數學、漢語以及多語言任務上,基礎模型 DeepSeek-V3 Base 的表現非常出色,在 AGIEval、CMath、MMMLU-non-English 等一些任務上甚至遠遠超過其它開源大模型。就算與 GPT-4o 和 Claude 3.5 Sonnet 這兩大領先的閉源模型相比,DeepSeek-V3 也毫不遜色,并且在 MATH 500、AIME 2024、Codeforces 上都有明顯優勢。

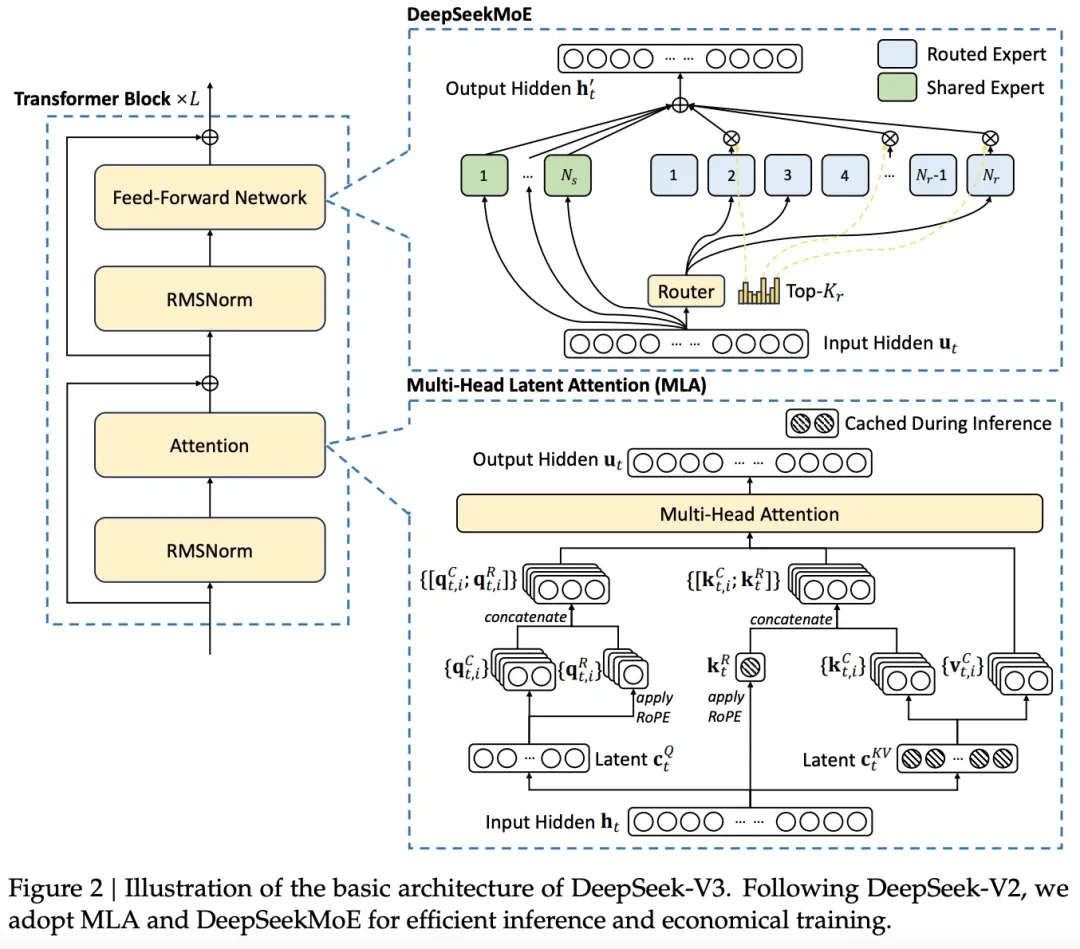

DeepSeek-V3 的驚人表現主要是得益于其采用的 MLA(多頭隱注意力)和 DeepSeekMoE 架構。此前,這些技術已經在 DeepSeek-V2 上得到了驗證,現在也成為了 DeepSeek-V3 實現高效推理和經濟訓練的基石。

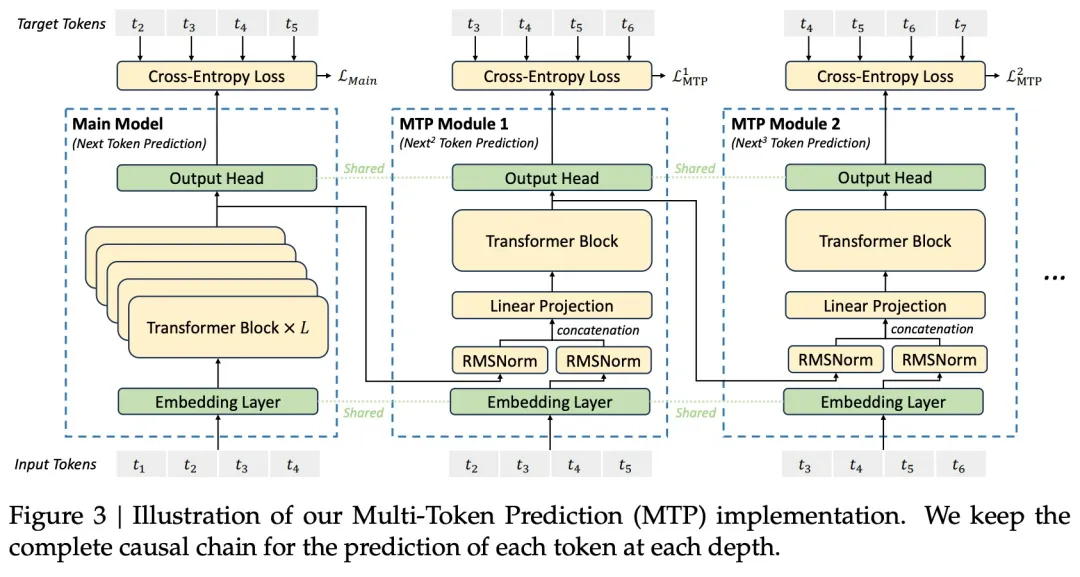

此外,DeepSeek-V3 率先采用了無輔助損失的負載平衡策略,并設定了多 token 預測訓練目標,以實現更強大的性能。他們使用的預訓練 token 量為 14.8 萬億,然后還進行了監督式微調和強化學習。

正是在這些技術創新的基礎上,開源的 DeepSeek-V3 一問世便收獲了無數好評。

Meta AI 研究科學家田淵棟對 DeepSeek-V3 各個方向上的進展都大加贊賞。

著名 AI 科學家 Andrej Karpathy 也表示,如果該模型的優良表現能夠得到廣泛驗證,那么這將是資源有限情況下對研究和工程的一次出色展示。

正在創業(Lepton AI)的著名研究者賈揚清也給出了自己的深度評價。他認為 DeepSeek-V3 的誕生標志著我們正式進入了分布式推理的疆域,畢竟 671B 的參數量已經無法放入單臺 GPU 了。

DeepSeek-V3 再一次引爆了人們對開源模型的熱情。OpenRouter 表示自昨天發布以來,該平臺上 DeepSeek-V3 的使用量已經翻了 3 倍!

一些已經嘗鮮 DeepSeek-V3 的用戶已經開始在網上分享他們的體驗。

接下來我們看技術報告內容。

- 報告地址:https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

- 項目地址:https://github.com/deepseek-ai/DeepSeek-V3

- Hugging Face:https://huggingface.co/collections/deepseek-ai/deepseek-v3-676bc4546fb4876383c4208b

架構

為了高效的推理和經濟的訓練,DeepSeek-V3 采用了用于高效推理的多頭潛在注意力(MLA)(DeepSeek-AI,2024c)和用于經濟訓練的 DeepSeekMoE(Dai et al., 2024),并提出了多 token 預測(MTP)訓練目標,以提高評估基準的整體性能。對于其他細節,DeepSeek-V3 遵循 DeepSeekV2(DeepSeek-AI,2024c)的設置。

與 DeepSeek-V2 相比,一個例外是 DeepSeek-V3 為 DeepSeekMoE 額外引入了輔助無損耗負載平衡策略(Wang et al., 2024a),以減輕因確保負載平衡而導致的性能下降。圖 2 展示了 DeepSeek-V3 的基本架構:

MTP 將預測范圍擴展到每個位置的多個未來 token。一方面,MTP 目標使訓練信號更加密集,并且可以提高數據效率。另一方面,MTP 可以使模型預規劃其表征,以便更好地預測未來的 token。

預訓練

數據構建

與 DeepSeek-V2 相比,V3 通過提高數學和編程樣本的比例來優化預訓練語料庫,同時將多語言覆蓋范圍擴大到英語和中文之外。此外,新版本對數據處理流程也進行了改進,以最大限度地減少冗余,同時保持語料庫的多樣性。DeepSeek-V3 的訓練語料在 tokenizer 中包含 14.8T 個高質量且多樣化的 token。

超參數

模型超參數:本文將 Transformer 層數設置為 61,隱藏層維度設置為 7168。所有可學習參數均以標準差 0.006 隨機初始化。在 MLA 中,本文將注意力頭 ??_? 的數量設置為 128,每個頭的維度 ??_? 設置為 128。

此外,本文用 MoE 層替換除前三層之外的所有 FFN。每個 MoE 層由 1 個共享專家和 256 個路由專家組成,其中每個專家的中間隱藏維度為 2048。在路由專家中,每個 token 將激活 8 個專家,并確保每個 token 最多發送到 4 個節點。

與 DeepSeek-V2 一樣,DeepSeek-V3 也在壓縮潛在向量之后使用了額外的 RMNSNorm 層,并在寬度 bottlenecks 處乘以額外的縮放因子。在這種配置下,DeepSeek-V3 包含總共 671B 個參數,其中每個 token 激活 37B 個。

長上下文擴展

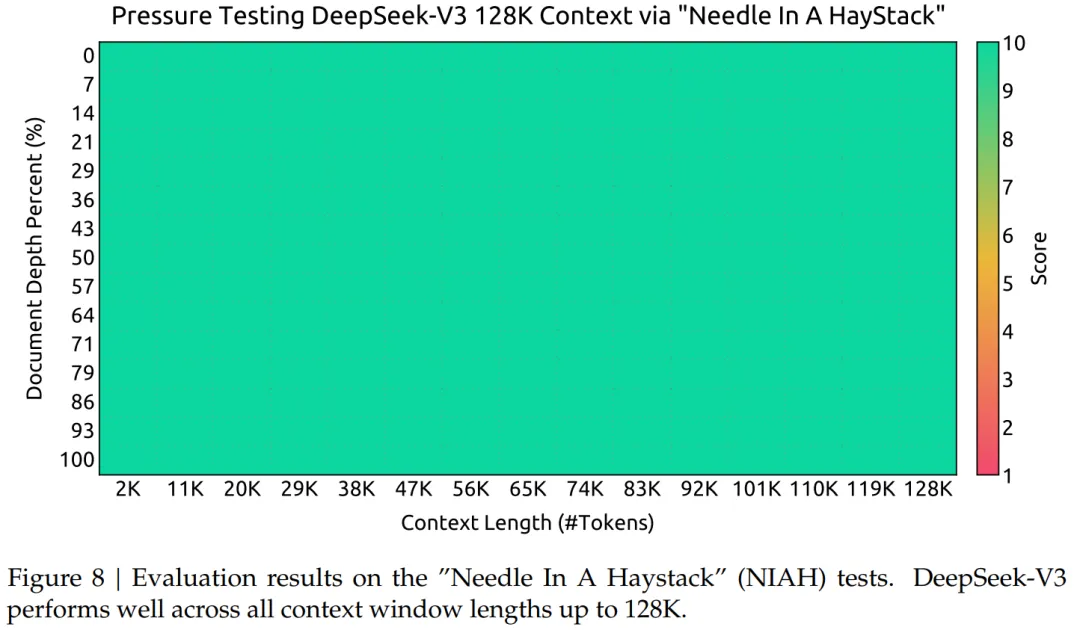

本文采用與 DeepSeek-V2 類似的方法,在 DeepSeek-V3 中啟用長上下文功能。在預訓練階段之后,應用 YaRN 進行上下文擴展,并執行兩個額外的訓練階段,每個階段包含 1000 個 step,以逐步將上下文窗口從 4K 擴展到 32K,然后再擴展到 128K。

通過這種兩階段擴展訓練,DeepSeek-V3 能夠處理長達 128K 的輸入,同時保持強勁的性能。圖 8 表明,經過監督微調后,DeepSeek-V3 在大海撈針 (NIAH) 測試中取得了顯著的性能,在長達 128K 的上下文窗口長度中表現出一致的穩健性。

評估

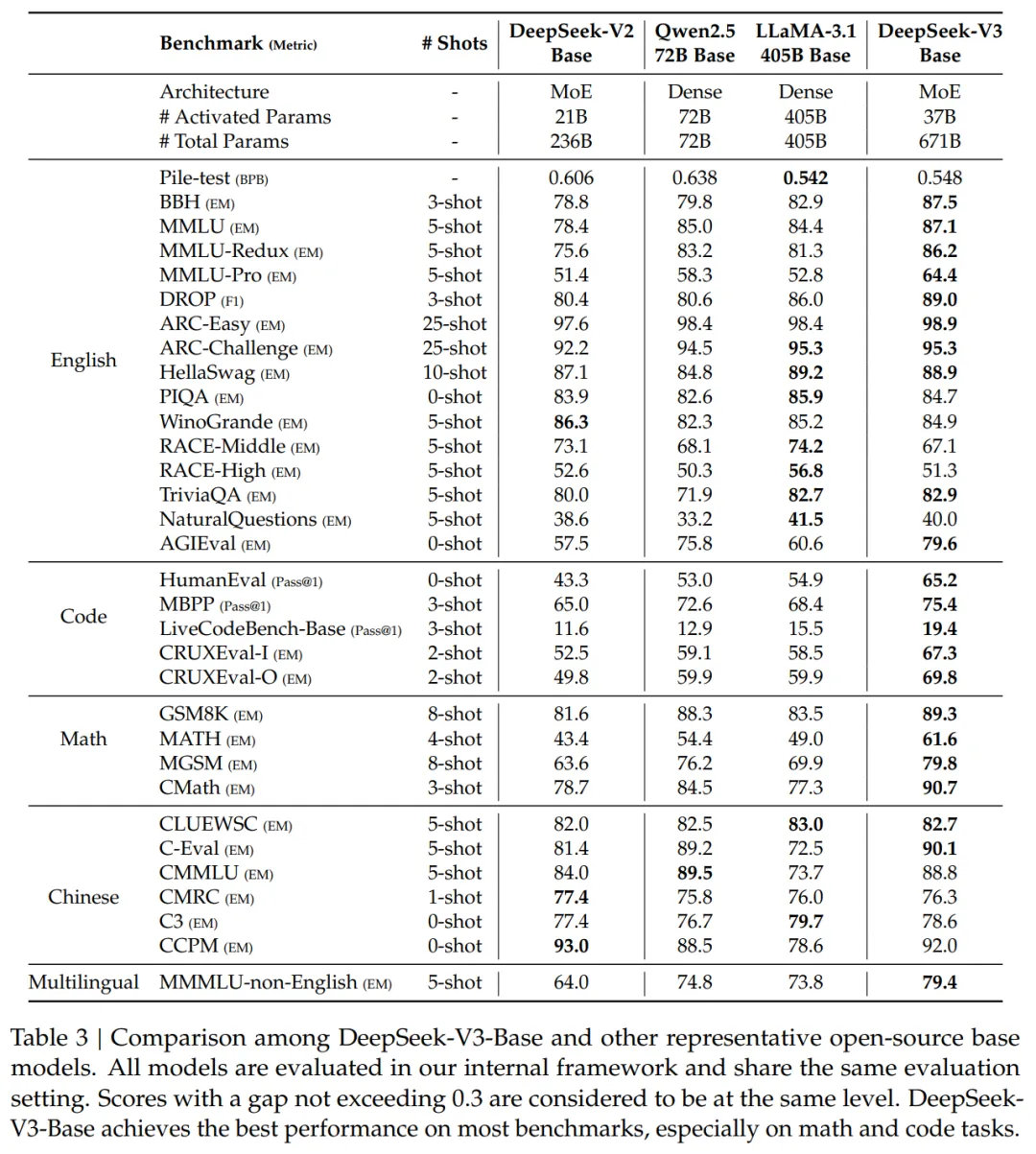

表 3 將 DeepSeek-V3 的基礎模型與 SOTA 性能的開源基礎模型進行了比較,包括 DeepSeek-V2-Base、Qwen2.5 72B Base 和 LLaMA-3.1 405B Base。

總體而言,DeepSeek-V3-Base 全面超越 DeepSeek-V2-Base 和 Qwen2.5 72B Base,并在大多數基準測試中超越 LLaMA-3.1 405B Base,基本上成為最強大的開源模型。

具體來說,本文將 DeepSeek-V3-Base 與其他開源基礎模型分別進行了比較。

(1)與 DeepSeek-V2-Base 相比,由于模型架構的改進,模型大小和訓練 token 的擴大以及數據質量的提升,DeepSeek-V3-Base 取得了預期的、更好的性能。

(2)與目前最先進的中文開源模型 Qwen2.5 72B Base 相比,在激活參數只有其一半的情況下,DeepSeek-V3-Base 也表現出了明顯的優勢,尤其是在英文、多語言、代碼和數學基準測試中。對于中文基準測試,除了中文多學科多項選擇題 CMMLU 之外,DeepSeek-V3-Base 也取得了優于 Qwen2.5 72B 的性能。

(3)與目前最大的開源模型 LLaMA-3.1 405B Base(激活參數量是其 11 倍)相比,DeepSeek-V3-Base 在多語言、代碼和數學基準測試中也表現出了更好的性能。在英語和中文基準測試中,DeepSeek-V3-Base 表現出了相當或更好的性能,尤其是在 BBH、MMLU-series、DROP、C-Eval、CMMLU 和 CCPM 上表現優異。

由于高效的架構和全面的工程優化,DeepSeekV3 實現了極高的訓練效率。基于訓練框架和基礎設施,在 V3 上訓練每萬億個 token 只需要 180K H800 GPU 小時,這比訓練 72B 或 405B 密集模型便宜得多。

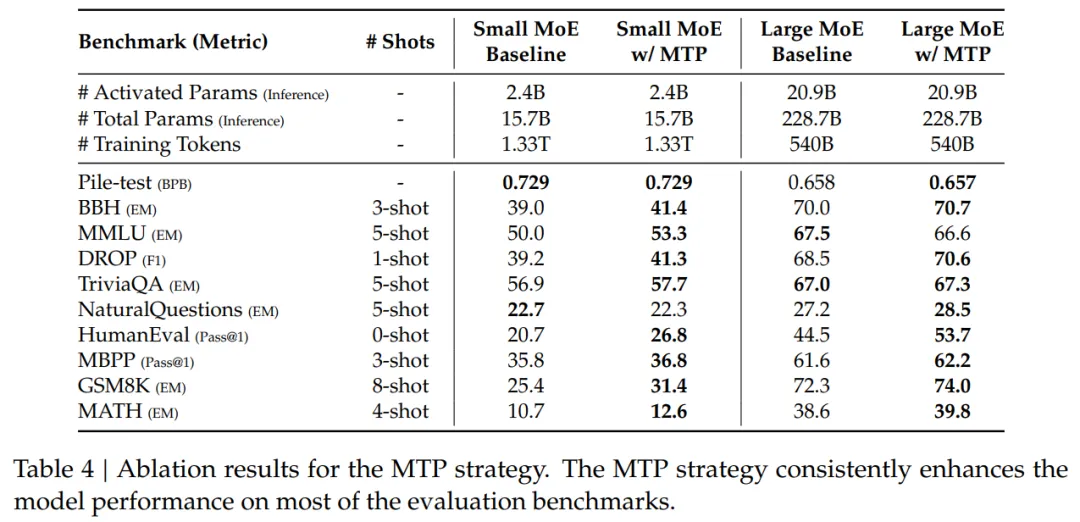

表 4 展示了 MTP 策略的消融結果,作者在兩個不同規模的基線模型上驗證了 MTP 策略。從表中我們可以觀察到,MTP 策略在大多數評估基準上持續提高了模型性能。

在接下來的文章中,作者介紹了后訓練,包括監督微調、強化學習等內容。

了解更多內容,請參考原論文。