讓SFT重新偉大!CMU等華人學者提出全新「批判式微調」,媲美復刻版DeepSeek

模仿是傳統語言模型訓練的主要方式。LLM在解決現實世界問題方面之所以表現出前所未有的性能,其中一項核心技術是監督微調(SFT)。

在SFT的過程中,模型被要求模仿人類標注或合成的高質量回復,以增強通用指令遵循能力。這類SFT數據集通常使用Self-Instruct和Evol-Instruct等方法進行構建。

然而,這種方法存在明顯的局限性。隨著數據集規模和質量的提升,SFT面臨著邊際收益遞減的問題,尤其是在訓練本身效果就不錯的基礎模型時,使用SFT甚至可能會導致性能下降。

最近,CMU、滑鐵盧大學等機構的3名華人學者就發表了一篇論文,針對SFT做出了更進一步的改進,提出批判式監督微調方法(CFT,Critique Fine-Tuning),旨在讓模型更有效地模仿模仿數據集。

論文鏈接:https://arxiv.org/pdf/2501.17703

批判式監督微調:讓SFT重新偉大

CFT將重點從簡單模仿轉向基于批判的學習,核心思想是讓模型學會批判,而不是簡單地模仿,其靈感來源于人類的學習過程。

學霸們在學習過程中,不僅僅是復制提供的答案,而是分析、批判和改進它們。同樣,CFT數據集中為錯誤響應提供相應的批評供模型學習,讓LLM能夠識別響應中存在的缺陷,進而提出改進建議并驗證正確性。

這種方法不僅能夠提升推理能力,還能使模型在面對復雜任務時表現出更強的適應性和靈活性。

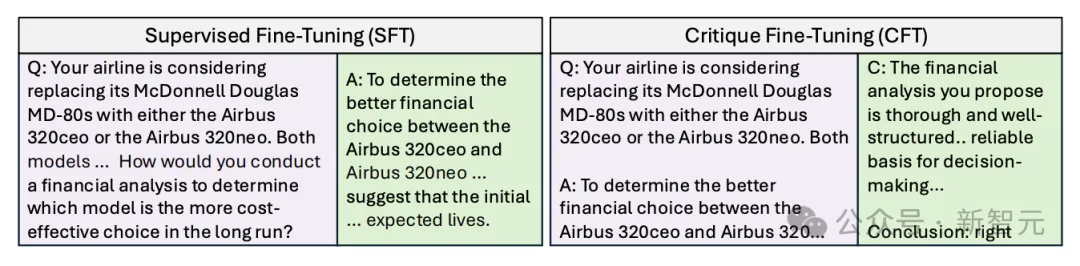

比如,針對這個問題:在直角三角形的直角邊長分別為3個單位和4個單位的情況下,構造一個正方形。求五邊形$ABCDE$的面積(單位:平方單位)。

在SFT模式下,模型會一步步的進行運算,先運用勾股定理計算斜邊長度為5,再計算正方形的面積為25,以及三角形面積6,之后模型給出回答25-6。

而在CFT模式下,會由模型對上述回答給出批評,指出錯誤點是應該加上而非減去三角形的面積,并給出正確答案31。

下圖展示了典型的SFT和CFT數據樣例。

SFT讓大模型直接模仿答案,CFT讓大模型模仿對錯誤回答的批評

CFT的高訓練效率

那么,如何獲得CFT訓練所需的數據呢?

論文基于WebInstruct,構建了一個50K個帶批評意見的問答對作為訓練數據集,其中的批評由GPT-4o等高級模型生成,上述的題目是其中一個例子。這些問題主要聚焦數學領域(65%),也包括物理、化學、商業等主題。

CFT數據集與其他SFT數據集對比

之后在CFT數據集上訓練7B大小的、沒有經過指令微調的LLM,如DeepSeekMath-base、Qwen2.5和Qwen2.5-Math。

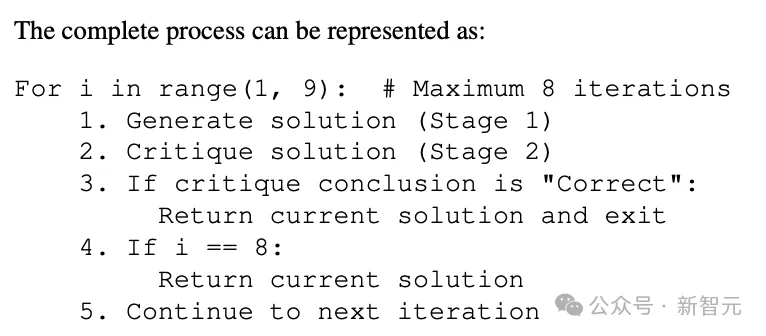

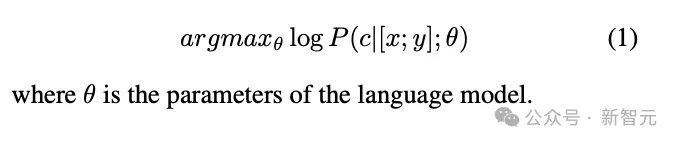

CFT方法的訓練目標相當直接:將問題x和錯誤響應y拼接為作為輸入,然后優化模型參數以生成評論c ,相當于訓練模型學會批判性思維。

實驗中,作者考察了LLM在經過指令微調與批判性微調后,在數學相關基準上的性能提升。結果顯示:CFT訓練的模型可以持續優于SFT訓練的最佳模型。

相比SFT,CFT的準確率平均高出4-10個百分點。不僅如此,訓練效率也更高,能在更少的訓練數據上實現更快的收斂,因此有望成為開發數學推理模型的一種更有效的方法。

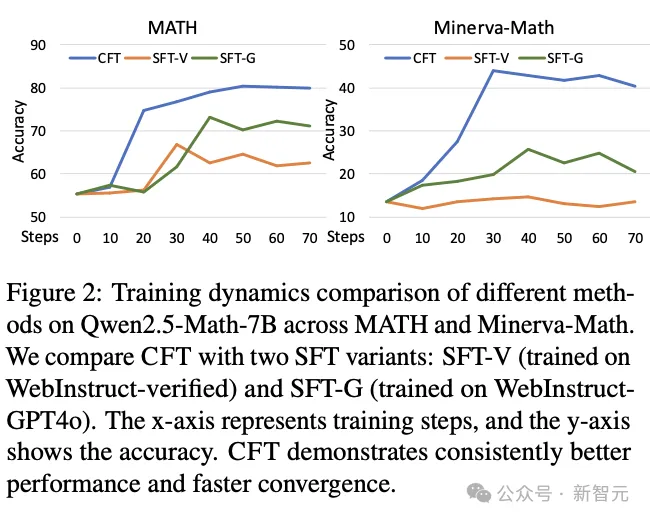

Qwen2.5-Math-7B在MATH和Minerva-Math上不同方法的訓練動態比較,包括CFT與兩種SFT變體,橫軸代表訓練步數,縱軸顯示準確率

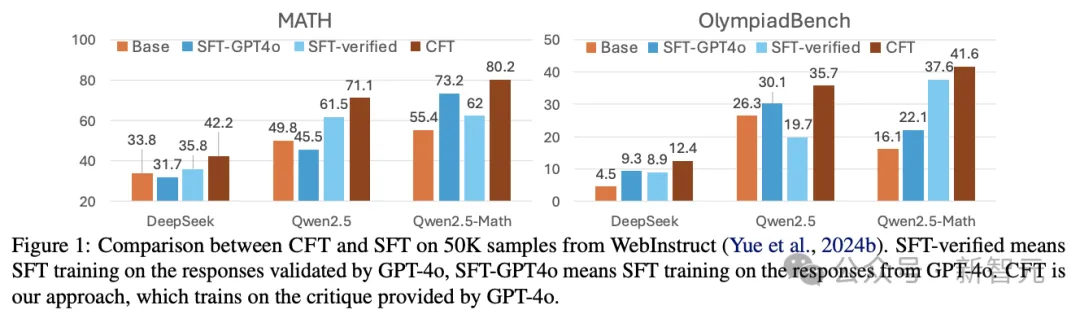

在同樣是50k個樣本上時,不同的基座模型使用CFT和SFT訓練后的性能提升

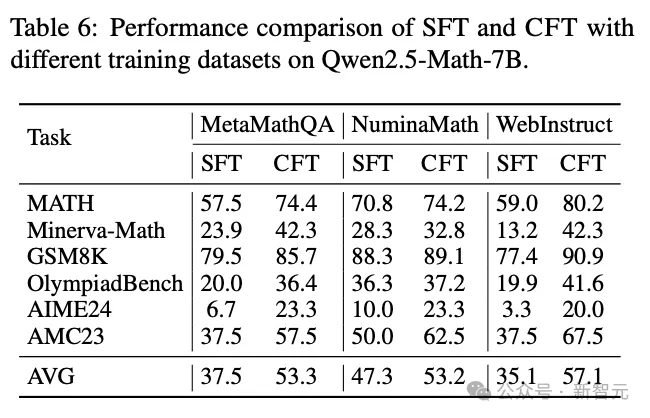

如果只聚焦于Qwen2.5-Math-7B這一個模型就可以看到,在各種數據集和任務上,CFT的訓練效果都能全方位超越SFT。

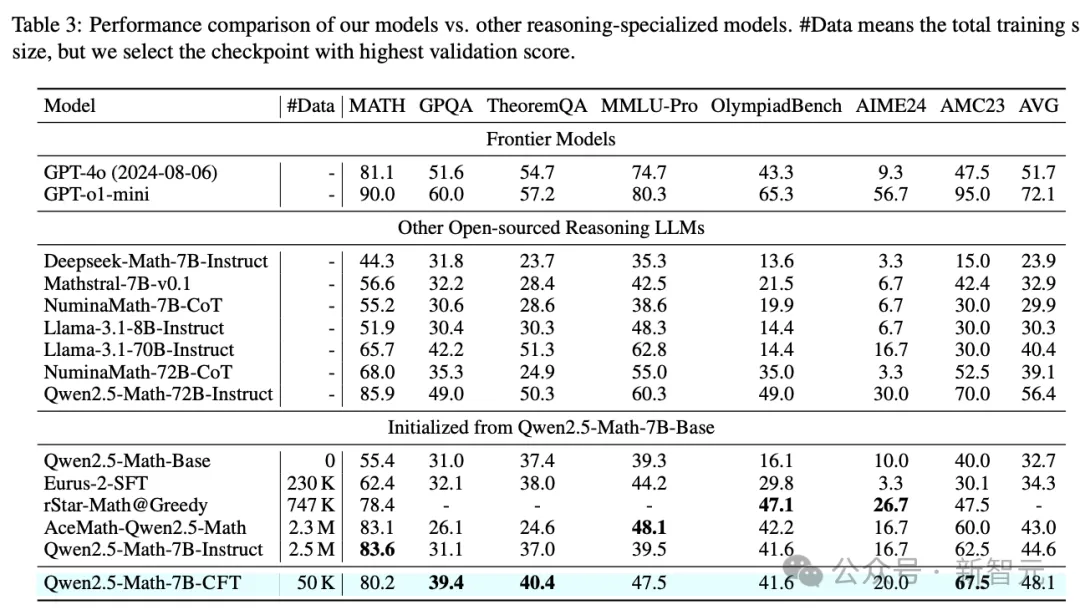

論文將訓練后的Qwen2.5-Math-7B-CFT與知名的Llama、GPT系列,以及尤其擅長推理的Deepseek、Mathstral、Numina等系列模型進行了對比,結果如下表所示。

Qwen2.5-Math-7B-CFT的平均性能(48.1%)甚至優于參數量10倍的Llama-3.1-70B-Instruct(40.4%)和 NuminaMath-72B-CoT(39.1%),與Qwen2.5-Math-72B-Instruct(56.4%)相近。

此外,CFT訓練的模型在性能上也能夠與使用140倍計算資源訓練的SimpleRL模型(Deepseek R1的公開復制版)相媲美,使用的GPU時長降低到144分之一,相當于大幅削減了計算成本。

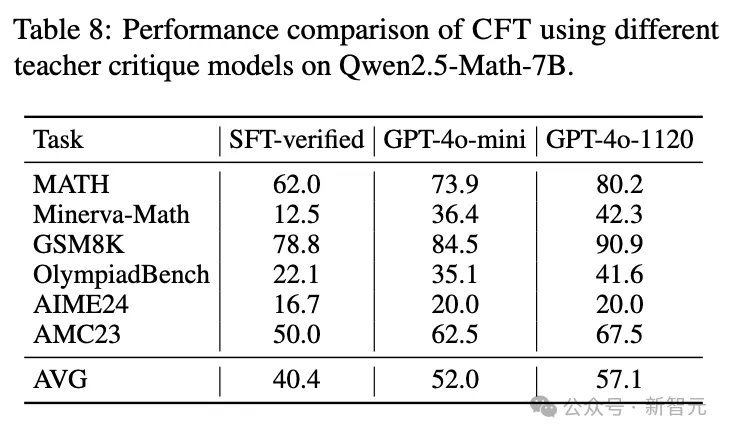

研究人員還對 CFT 的多個因素進行了消融研究。結果表明,CFT對于數據集來源、噪聲響應來源以及教師批判模型的選擇都具有較強的魯棒性。

例如,即使使用較弱的GPT-4o-mini模型生成批評意見,CFT仍然能夠取得顯著的性能提升。

局限與擴展

CFT訓練數據集中,作為gold standard的批評數據是由LLM生成的。作者手動檢查其中50個后,發現其中20%的批評意見本身就包含錯誤。這些錯誤可能會對模型的訓練產生一定的干擾,影響其最終性能。

此外,CFT訓練的模型目前還無法進行自我批評,因此尚未觀察到自我改進的效果。

該研究使用的數據集也存在代表性不足的問題,目前只是集中在數學問題上,而在編程以及科學,甚至人文相關的推理問題上,是否仍能采用類似的CFT模式進行訓練,有待研究。

CFT的優勢在于其對模型推理能力的顯著提升以及對訓練數據的高效利用。通過讓模型學會批判,等效于讓大模型進行單次的強化學習。

與現有的自我修正(Self-Correction)、獎勵模型(Reward Models)等方法相比,CFT的目標是通過批判學習來提升模型對問題的深入理解,而不是直接估計獎勵分數或進行自我修正。這種方法在推理任務中表現出了更強的適應性和靈活性。

更為關鍵的是,CFT的數據集構建和訓練過程相對簡單,計算成本較低,因此在實際應用中具有較高的可行性和經濟性。未來的研究可能會在提升批判數據質量和探索模型自我批判機制方面取得突破。

首先是開發自動驗證工具或創建人類驗證的批判數據集,提升批判數據的質量;而要發展出自我批判和自我改進的能力,則需要讓大模型通過用戶的反饋,實現模型的持續優化。

進一步的研究也可能包括將CFT與其他訓練范式,如SFT和RL相結合,擴展到多模態環境,并研究其理論基礎。