首創(chuàng)GRPO方案!AlphaDrive:VLM+RL破解自動(dòng)駕駛長(zhǎng)尾難題

寫在前面 & 筆者的個(gè)人理解

OpenAI o1 和 DeepSeek R1 在數(shù)學(xué)和科學(xué)等復(fù)雜領(lǐng)域達(dá)到了或甚至超越了人類專家的水平,強(qiáng)化學(xué)習(xí)(RL)和推理在其中發(fā)揮了關(guān)鍵作用。在自動(dòng)駕駛領(lǐng)域,最近的端到端模型極大地提高了規(guī)劃性能,但由于常識(shí)和推理能力有限,仍然難以應(yīng)對(duì)長(zhǎng)尾問(wèn)題。

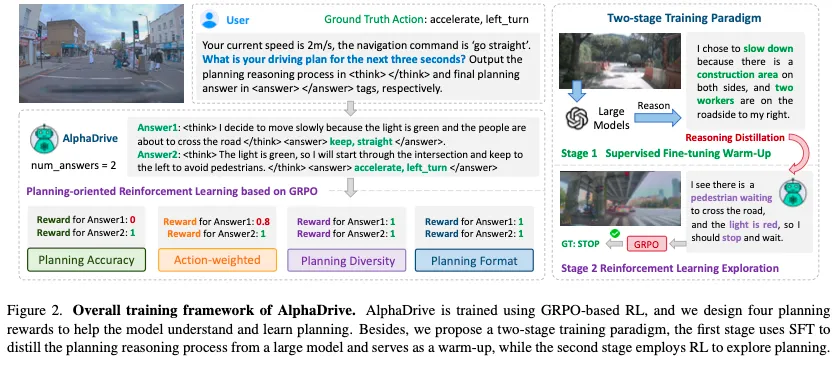

一些研究將視覺-語(yǔ)言模型(VLMs)集成到自動(dòng)駕駛中,但它們通常依賴于預(yù)訓(xùn)練模型,并在駕駛數(shù)據(jù)上進(jìn)行簡(jiǎn)單的監(jiān)督微調(diào)(SFT),沒有進(jìn)一步探索專門為規(guī)劃設(shè)計(jì)的訓(xùn)練策略或優(yōu)化方法。本文提出了 AlphaDrive,一個(gè)針對(duì)自動(dòng)駕駛中 VLMs 的 RL 和推理框架。AlphaDrive 引入了四個(gè)基于 GRPO 的 RL 獎(jiǎng)勵(lì),專門用于規(guī)劃,并采用結(jié)合 SFT 與 RL 的兩階段規(guī)劃推理訓(xùn)練策略。結(jié)果表明,與僅使用 SFT 或不進(jìn)行推理相比,AlphaDrive 顯著提升了規(guī)劃性能和訓(xùn)練效率。此外,我們還興奮地發(fā)現(xiàn),在 RL 訓(xùn)練之后,AlphaDrive 展現(xiàn)出了一些新興的多模態(tài)規(guī)劃能力,這對(duì)提高駕駛安全性和效率至關(guān)重要。據(jù)我們所知,AlphaDrive 是首個(gè)將基于 GRPO 的 RL 與規(guī)劃推理集成到自動(dòng)駕駛中的框架。代碼將被發(fā)布以促進(jìn)未來(lái)的研究。

- 論文鏈接:https://arxiv.org/abs/2503.07608

- 代碼鏈接:https://github.com/hustvl/AlphaDrive

引言

近年來(lái),自動(dòng)駕駛技術(shù)取得了快速進(jìn)展,端到端自動(dòng)駕駛成為最具代表性的模型之一。這些模型以傳感器數(shù)據(jù)為輸入,利用可學(xué)習(xí)的神經(jīng)網(wǎng)絡(luò)規(guī)劃車輛未來(lái)軌跡。得益于大規(guī)模駕駛演示數(shù)據(jù),端到端模型通過(guò)擴(kuò)展訓(xùn)練數(shù)據(jù)和增加模型參數(shù)持續(xù)改進(jìn)規(guī)劃能力。然而,由于其黑箱特性與常識(shí)推理能力的缺失,端到端模型在處理復(fù)雜和長(zhǎng)尾駕駛場(chǎng)景時(shí)仍面臨重大挑戰(zhàn)。例如,當(dāng)前方車輛攜帶交通錐行駛時(shí),端到端模型可能無(wú)法理解前車與交通錐的關(guān)系,誤判道路施工不可通行,從而做出錯(cuò)誤的制動(dòng)決策。因此,僅依賴端到端模型實(shí)現(xiàn)高級(jí)別自動(dòng)駕駛?cè)源嬖陲@著局限性。

隨著GPT的成功,大型語(yǔ)言模型(LLMs)展現(xiàn)出卓越的理解與推理能力,并逐步從單模態(tài)文本理解擴(kuò)展到多模態(tài)視覺-語(yǔ)言處理。視覺-語(yǔ)言模型(VLMs)的常識(shí)與推理能力為緩解端到端模型的缺陷提供了潛在解決方案。

近期,OpenAI o1通過(guò)集成推理技術(shù),在編程等領(lǐng)域達(dá)到甚至超越人類專家水平。DeepSeek R1則利用強(qiáng)化學(xué)習(xí)(RL),不僅展現(xiàn)出“涌現(xiàn)能力”并取得頂尖性能,且訓(xùn)練成本顯著低于其他模型。這些進(jìn)展凸顯了推理技術(shù)與強(qiáng)化學(xué)習(xí)在大型模型開發(fā)中的巨大潛力。

現(xiàn)有將VLMs應(yīng)用于自動(dòng)駕駛的研究可分為兩類:

- 駕駛場(chǎng)景理解:利用VLMs解析場(chǎng)景語(yǔ)義;

- 規(guī)劃決策:部分研究將VLMs作為端到端系統(tǒng),直接根據(jù)輸入圖像生成軌跡。然而,與專為軌跡規(guī)劃設(shè)計(jì)的端到端模型不同,VLMs的輸出空間為離散語(yǔ)言符號(hào),難以直接生成精確數(shù)值預(yù)測(cè),可能導(dǎo)致性能不足或安全隱患。

部分研究嘗試通過(guò)自然語(yǔ)言描述高層動(dòng)作(如“減速右轉(zhuǎn)”)規(guī)避上述問(wèn)題,但仍缺乏對(duì)訓(xùn)練方法的深入探索。多數(shù)工作僅依賴監(jiān)督微調(diào)(SFT),忽視了不同訓(xùn)練策略對(duì)規(guī)劃性能與訓(xùn)練效率的影響。

本文探討以下核心問(wèn)題:如何將強(qiáng)化學(xué)習(xí)與推理技術(shù)(在通用大模型中取得顯著成功的方法)應(yīng)用于自動(dòng)駕駛規(guī)劃,以提升VLMs的性能并降低訓(xùn)練成本?

通過(guò)初步實(shí)驗(yàn),我們發(fā)現(xiàn)直接應(yīng)用現(xiàn)有RL與推理技術(shù)效果欠佳,主要?dú)w因于以下三方面:

- 獎(jiǎng)勵(lì)設(shè)計(jì)不匹配:通用任務(wù)的RL獎(jiǎng)勵(lì)(如視覺計(jì)數(shù)任務(wù)的正確性判斷)難以適應(yīng)規(guī)劃需求。自動(dòng)駕駛中,不同駕駛行為的重要性差異顯著(如制動(dòng)與加速),需設(shè)計(jì)權(quán)重差異化的獎(jiǎng)勵(lì)機(jī)制。

- 多解性挑戰(zhàn):規(guī)劃問(wèn)題通常存在多個(gè)合理解(如直行道路可選擇勻速或加速),需避免強(qiáng)制對(duì)齊單一真值標(biāo)簽。

- 推理數(shù)據(jù)匱乏:自動(dòng)駕駛?cè)狈ΜF(xiàn)成的規(guī)劃推理數(shù)據(jù)集,人工標(biāo)注成本高昂,直接應(yīng)用現(xiàn)有推理技術(shù)困難。

針對(duì)上述挑戰(zhàn),本文提出AlphaDrive——首個(gè)將基于GRPO的強(qiáng)化學(xué)習(xí)與規(guī)劃推理集成到自動(dòng)駕駛的框架。具體貢獻(xiàn)如下:

- GRPO強(qiáng)化學(xué)習(xí)策略:采用Group Relative Policy Optimization(GRPO),相比PPO和DPO,其組間相對(duì)優(yōu)化策略更適配規(guī)劃的多解性,實(shí)驗(yàn)表明GRPO訓(xùn)練的模型展現(xiàn)出涌現(xiàn)的多模態(tài)規(guī)劃能力。

- 四維獎(jiǎng)勵(lì)設(shè)計(jì):

- 規(guī)劃準(zhǔn)確性獎(jiǎng)勵(lì):基于F1分?jǐn)?shù)評(píng)估橫向(方向)與縱向(速度)決策一致性;

- 動(dòng)作加權(quán)獎(jiǎng)勵(lì):根據(jù)安全關(guān)鍵性為不同動(dòng)作分配權(quán)重(如制動(dòng)權(quán)重高于勻速);

- 規(guī)劃多樣性獎(jiǎng)勵(lì):鼓勵(lì)生成多樣化可行解,防止模式坍縮;

- 格式規(guī)范獎(jiǎng)勵(lì):強(qiáng)制輸出結(jié)構(gòu)化格式(如

<answer>標(biāo)簽),提升訓(xùn)練穩(wěn)定性。

- 兩階段訓(xùn)練范式:

階段一(SFT知識(shí)蒸餾):利用大模型(如GPT-4o)生成高質(zhì)量規(guī)劃推理數(shù)據(jù),通過(guò)SFT實(shí)現(xiàn)推理過(guò)程蒸餾;

階段二(RL探索):在SFT基礎(chǔ)上進(jìn)行RL微調(diào),緩解早期訓(xùn)練的不穩(wěn)定性和幻覺問(wèn)題。

實(shí)驗(yàn)表明,與僅使用SFT或無(wú)推理的模型相比,AlphaDrive在規(guī)劃準(zhǔn)確率上提升25.52%,且在僅20%訓(xùn)練數(shù)據(jù)下性能超越SFT模型35.31%。此外,RL訓(xùn)練后模型涌現(xiàn)出多模態(tài)規(guī)劃能力(如復(fù)雜場(chǎng)景生成多個(gè)合理決策),為提升駕駛安全與效率提供了新方向。據(jù)我們所知,AlphaDrive是首個(gè)將GRPO-based RL與規(guī)劃推理結(jié)合的自動(dòng)駕駛框架,代碼將開源以推動(dòng)后續(xù)研究。

相關(guān)工作回顧

視覺-語(yǔ)言模型自GPT發(fā)布以來(lái),大型模型的能力已從單模態(tài)擴(kuò)展到多模態(tài)。大型視覺-語(yǔ)言模型(VLMs)在視覺理解與推理任務(wù)中展現(xiàn)出卓越性能。早期研究嘗試將視覺模型與大型語(yǔ)言模型(LLMs)結(jié)合:Flamingo通過(guò)視覺編碼器處理視覺信號(hào),并在LLM解碼器中引入注意力層以實(shí)現(xiàn)跨模態(tài)交互;BLIP提出Q-Former架構(gòu)和跨模態(tài)對(duì)比學(xué)習(xí)任務(wù),以橋接視覺編碼器與LLMs;LLaVA采用簡(jiǎn)單的MLP作為視覺與語(yǔ)言模塊的連接器,僅用有限數(shù)據(jù)即實(shí)現(xiàn)強(qiáng)大的視覺理解能力。QwenVL系列進(jìn)一步優(yōu)化了視覺模塊,支持高分辨率和動(dòng)態(tài)分辨率圖像輸入,并在多語(yǔ)言任務(wù)和空間感知中表現(xiàn)優(yōu)異。

強(qiáng)化學(xué)習(xí)與推理自回歸學(xué)習(xí)是LLMs的主流預(yù)訓(xùn)練策略,而強(qiáng)化學(xué)習(xí)(RL)與推理技術(shù)進(jìn)一步增強(qiáng)了模型能力。例如,GPT采用基于人類反饋的強(qiáng)化學(xué)習(xí)(RLHF),將人類意圖和偏好融入訓(xùn)練過(guò)程;直接偏好優(yōu)化(DPO)通過(guò)優(yōu)化偏好反饋提升模型性能。Group Relative Policy Optimization(GRPO)引入組間相對(duì)優(yōu)化策略,通過(guò)多組輸出的相對(duì)優(yōu)劣提升訓(xùn)練穩(wěn)定性和效果。

DeepSeek R1基于GRPO訓(xùn)練時(shí)經(jīng)歷了“頓悟時(shí)刻”(Aha Moment),模型在無(wú)顯式引導(dǎo)下自主增加問(wèn)題思考并重新評(píng)估初始方案,展示了RL在推動(dòng)模型從模仿轉(zhuǎn)向涌現(xiàn)智能中的潛力。本實(shí)驗(yàn)中,我們同樣觀察到,經(jīng)過(guò)GRPO-based RL訓(xùn)練后,AlphaDrive展現(xiàn)出多模態(tài)規(guī)劃能力,可生成多組合理駕駛方案,為提升駕駛安全與效率提供了可能。在推理領(lǐng)域,Chain-of-thought通過(guò)分步分解復(fù)雜問(wèn)題顯著提升解決能力。OpenAI o1基于該方法,結(jié)合推理時(shí)擴(kuò)展(如蒙特卡洛樹搜索MCTS和集束搜索Beam Search),在科學(xué)和編程等需復(fù)雜推理的領(lǐng)域取得突破,表明除擴(kuò)展模型參數(shù)與數(shù)據(jù)外,提升推理時(shí)計(jì)算量亦是重要方向。

自動(dòng)駕駛規(guī)劃規(guī)劃是自動(dòng)駕駛的核心任務(wù)。早期基于規(guī)則的算法通用性與效率受限。近期,端到端模型通過(guò)統(tǒng)一神經(jīng)網(wǎng)絡(luò)直接從傳感器數(shù)據(jù)輸出軌跡或控制信號(hào),利用大規(guī)模駕駛演示數(shù)據(jù)驅(qū)動(dòng)訓(xùn)練,顯著提升規(guī)劃性能。然而,端到端模型因缺乏常識(shí)與推理能力,仍難以應(yīng)對(duì)長(zhǎng)尾場(chǎng)景。

VLM在自動(dòng)駕駛中的應(yīng)用VLM的常識(shí)與推理能力可有效彌補(bǔ)端到端模型的不足。在機(jī)器人領(lǐng)域,視覺-語(yǔ)言-動(dòng)作(VLA)模型通過(guò)理解指令執(zhí)行復(fù)雜動(dòng)作,VLM生成規(guī)劃指令后由動(dòng)作模型轉(zhuǎn)換為控制信號(hào)。

自動(dòng)駕駛領(lǐng)域亦有相關(guān)探索:DriveGPT4以視頻為輸入,直接預(yù)測(cè)控制信號(hào);ELM利用跨領(lǐng)域視頻數(shù)據(jù)提升VLM在駕駛?cè)蝿?wù)中的性能;OmniDrive提出稀疏3D令牌表征場(chǎng)景,輸入VLM進(jìn)行理解與規(guī)劃。

部分研究結(jié)合VLM與端到端模型:DriveVLM首次將VLM用于低頻軌跡預(yù)測(cè),端到端模型生成高頻軌跡;Senna提出VLM負(fù)責(zé)高層規(guī)劃、端到端模型執(zhí)行低層軌跡預(yù)測(cè)的框架。此外,多數(shù)據(jù)集與基準(zhǔn)推動(dòng)了VLM在自動(dòng)駕駛中的應(yīng)用。然而,現(xiàn)有工作多依賴預(yù)訓(xùn)練模型與簡(jiǎn)單SFT,缺乏針對(duì)規(guī)劃的訓(xùn)練策略探索,需進(jìn)一步將RL與推理技術(shù)引入自動(dòng)駕駛領(lǐng)域。

詳解AlphaDrive

概述

AlphaDrive 是專為自動(dòng)駕駛規(guī)劃設(shè)計(jì)的視覺-語(yǔ)言模型(VLM)。與以往僅依賴監(jiān)督微調(diào)(SFT)的方法不同,我們探索了強(qiáng)化學(xué)習(xí)(RL)與推理技術(shù)的結(jié)合,以更好地適配駕駛規(guī)劃的獨(dú)特特性:

- 不同駕駛行為的重要性差異(如制動(dòng)比勻速行駛更關(guān)鍵);

- 多解性(如直行道路可選擇加速或保持速度);

- 規(guī)劃推理數(shù)據(jù)的匱乏。

為此,我們提出四個(gè)基于GRPO的RL獎(jiǎng)勵(lì)函數(shù),并設(shè)計(jì)結(jié)合SFT與RL的兩階段規(guī)劃推理訓(xùn)練策略。實(shí)驗(yàn)表明,與僅使用SFT或無(wú)推理的模型相比,AlphaDrive在規(guī)劃性能與訓(xùn)練效率上均顯著提升。以下詳細(xì)闡述各模塊的設(shè)計(jì)。

面向規(guī)劃的強(qiáng)化學(xué)習(xí)

強(qiáng)化學(xué)習(xí)算法

當(dāng)前主流RL算法包括PPO、DPO和GRPO。給定查詢,GRPO從舊策略中采樣一組輸出,并通過(guò)最大化以下目標(biāo)優(yōu)化新策略:

其中,,和為超參數(shù),優(yōu)勢(shì)通過(guò)組內(nèi)獎(jiǎng)勵(lì)歸一化計(jì)算。

選擇GRPO的原因:

- DeepSeek R1[14]驗(yàn)證了GRPO在通用領(lǐng)域的有效性,其訓(xùn)練穩(wěn)定性與效率優(yōu)于PPO和DPO;

- GRPO的組間相對(duì)優(yōu)化策略天然適配規(guī)劃的多解性。實(shí)驗(yàn)進(jìn)一步表明,GRPO訓(xùn)練的模型展現(xiàn)出更強(qiáng)的規(guī)劃能力。

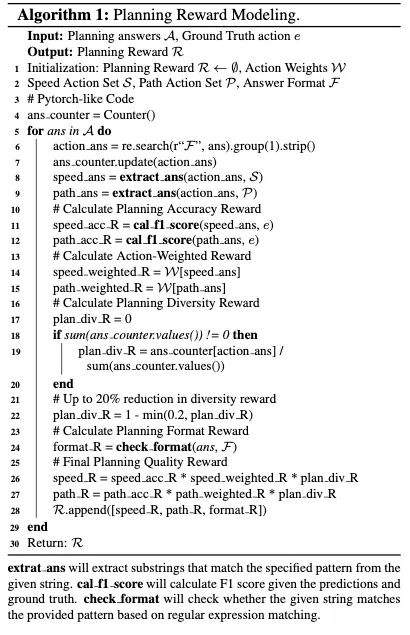

規(guī)劃獎(jiǎng)勵(lì)建模

規(guī)劃準(zhǔn)確性獎(jiǎng)勵(lì)數(shù)學(xué)或編程領(lǐng)域可通過(guò)最終答案是否正確直觀判定獎(jiǎng)勵(lì),但規(guī)劃需同時(shí)考慮橫向(方向)與縱向(速度)決策。我們采用F1分?jǐn)?shù)分別評(píng)估兩者的準(zhǔn)確性。初期直接匹配真實(shí)標(biāo)簽導(dǎo)致訓(xùn)練不穩(wěn)定,最終采用F1分?jǐn)?shù)以避免模型學(xué)習(xí)“輸出所有可能動(dòng)作”的捷徑策略。

動(dòng)作加權(quán)獎(jiǎng)勵(lì)不同動(dòng)作對(duì)安全的重要性不同(如制動(dòng)權(quán)重高于勻速)。為此,我們?yōu)閯?dòng)作分配權(quán)重,將其作為獎(jiǎng)勵(lì)的加權(quán)分量。

規(guī)劃多樣性獎(jiǎng)勵(lì)規(guī)劃本質(zhì)為多模態(tài)任務(wù)。為避免模型收斂到單一解,我們鼓勵(lì)生成多樣化可行解:當(dāng)輸出差異較大時(shí)提高獎(jiǎng)勵(lì),反之降低獎(jiǎng)勵(lì)。

規(guī)劃格式獎(jiǎng)勵(lì)要求輸出嚴(yán)格遵循<answer>標(biāo)簽格式(如<answer> decelerate, left_turn</answer>),未遵循則獎(jiǎng)勵(lì)為0。

獎(jiǎng)勵(lì)計(jì)算流程詳見算法1。最終,規(guī)劃質(zhì)量獎(jiǎng)勵(lì)(準(zhǔn)確性×權(quán)重×多樣性)與格式獎(jiǎng)勵(lì)共同用于GRPO損失計(jì)算。

推理:大模型知識(shí)蒸餾

自動(dòng)駕駛?cè)狈ΜF(xiàn)成的規(guī)劃推理數(shù)據(jù),人工標(biāo)注成本高昂。為此,我們利用大模型(如GPT-4o)從少量駕駛片段生成高質(zhì)量推理數(shù)據(jù):

- 輸入:真實(shí)駕駛動(dòng)作、車輛狀態(tài)與導(dǎo)航信息;

- 輸出:簡(jiǎn)潔的決策過(guò)程(如“前方綠燈,但行人待穿行,故減速”)。

經(jīng)人工篩選后,通過(guò)SFT將推理過(guò)程蒸餾至AlphaDrive,顯著提升其推理能力。

訓(xùn)練:SFT預(yù)熱與RL探索

RL依賴稀疏獎(jiǎng)勵(lì)信號(hào),而SFT基于稠密監(jiān)督更適配知識(shí)蒸餾。此外,僅使用RL易導(dǎo)致訓(xùn)練初期不穩(wěn)定。因此,我們采用兩階段訓(xùn)練:

- 階段一(SFT預(yù)熱):使用少量數(shù)據(jù)蒸餾大模型推理過(guò)程;

- 階段二(RL探索):在全量數(shù)據(jù)上微調(diào),提升模型魯棒性與多模態(tài)規(guī)劃能力。

實(shí)驗(yàn)結(jié)果分析

實(shí)驗(yàn)設(shè)置

數(shù)據(jù)集我們采用MetaAD作為訓(xùn)練與評(píng)估基準(zhǔn)。該數(shù)據(jù)集包含12萬(wàn)段真實(shí)駕駛片段(每段3秒),覆蓋多傳感器數(shù)據(jù)與感知標(biāo)注,并保持各類駕駛環(huán)境與規(guī)劃動(dòng)作的平衡分布。其中11萬(wàn)段用于訓(xùn)練,1萬(wàn)段用于驗(yàn)證。此外,我們從訓(xùn)練集中采樣3萬(wàn)段數(shù)據(jù)生成規(guī)劃推理過(guò)程。

訓(xùn)練細(xì)節(jié)以Qwen2VL-2B為基模型,輸入包括前視圖像與包含當(dāng)前車速、導(dǎo)航信息的提示詞(如“直行100米后右轉(zhuǎn)”)。訓(xùn)練使用16塊NVIDIA A800 GPU。

評(píng)估指標(biāo)

- 元?jiǎng)幼饕?guī)劃準(zhǔn)確性:計(jì)算橫向(直行/左轉(zhuǎn)/右轉(zhuǎn))與縱向(保持/加速/減速/停止)動(dòng)作的F1分?jǐn)?shù),并綜合為整體規(guī)劃準(zhǔn)確率;

- 推理質(zhì)量:通過(guò)BLEU-4、CIDEr、METEOR評(píng)估生成推理過(guò)程與標(biāo)注的相似度。

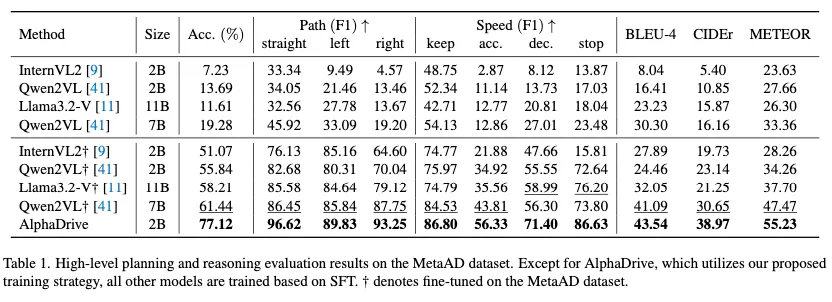

主要結(jié)果

表1顯示,AlphaDrive在MetaAD上的規(guī)劃準(zhǔn)確率達(dá)77.12%,較次優(yōu)模型Qwen2VL-7B提升25.5%。關(guān)鍵動(dòng)作(如轉(zhuǎn)向與加減速)的F1分?jǐn)?shù)顯著提高,推理質(zhì)量亦優(yōu)于其他模型,驗(yàn)證了兩階段訓(xùn)練策略的有效性。

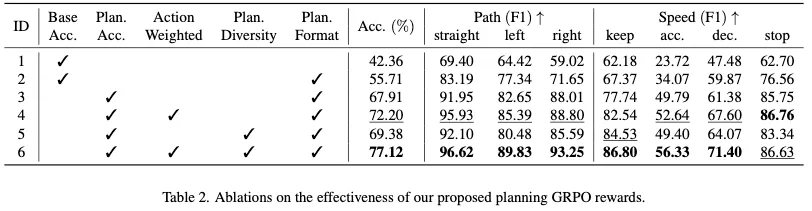

表2的消融實(shí)驗(yàn)表明:

- 基礎(chǔ)準(zhǔn)確性獎(jiǎng)勵(lì)(ID1)因格式不匹配導(dǎo)致性能偏低;

- 格式獎(jiǎng)勵(lì)(ID2)小幅提升穩(wěn)定性;

- 動(dòng)作加權(quán)獎(jiǎng)勵(lì)(ID3-4)顯著優(yōu)化關(guān)鍵決策;

- 多樣性獎(jiǎng)勵(lì)(ID5-6)進(jìn)一步防止模式坍縮。

表3對(duì)比不同訓(xùn)練策略:

- SFT+RL在復(fù)雜動(dòng)作(如減速)上的F1分?jǐn)?shù)提升15%以上,推理能力優(yōu)于純SFT或RL模型;

- RL訓(xùn)練在數(shù)據(jù)量有限時(shí)(如20K樣本)表現(xiàn)更優(yōu),僅需20%數(shù)據(jù)即可超越SFT模型35.31%(表4)。

消融實(shí)驗(yàn)

獎(jiǎng)勵(lì)函數(shù)設(shè)計(jì)

- 規(guī)劃準(zhǔn)確性獎(jiǎng)勵(lì)(F1分?jǐn)?shù))避免模型學(xué)習(xí)“輸出所有動(dòng)作”的捷徑策略;

- 動(dòng)作加權(quán)獎(jiǎng)勵(lì)提升安全關(guān)鍵動(dòng)作(如制動(dòng))的權(quán)重;

- 多樣性獎(jiǎng)勵(lì)通過(guò)懲罰重復(fù)輸出,鼓勵(lì)生成多組可行解;

- 格式獎(jiǎng)勵(lì)確保輸出結(jié)構(gòu)化,提升訓(xùn)練穩(wěn)定性。

訓(xùn)練策略

- SFT預(yù)熱緩解RL早期訓(xùn)練的不穩(wěn)定性;

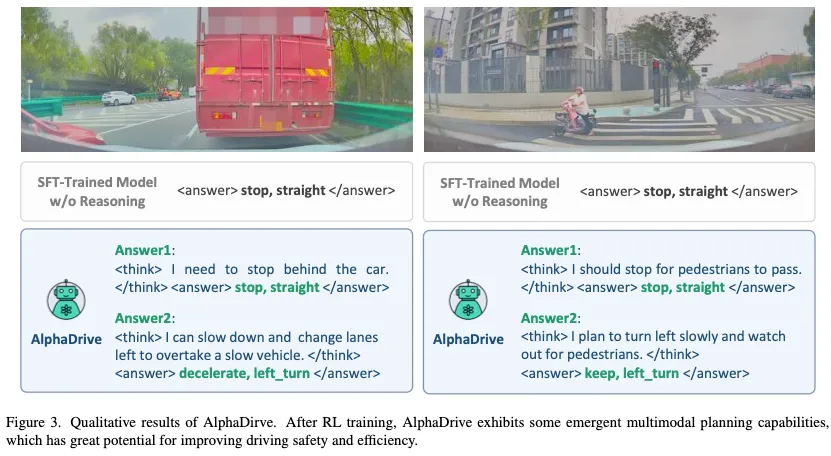

- RL探索通過(guò)GRPO優(yōu)化多解性與安全性,實(shí)驗(yàn)顯示模型在復(fù)雜場(chǎng)景中涌現(xiàn)出多模態(tài)規(guī)劃能力(圖3)。

多模態(tài)規(guī)劃能力涌現(xiàn)

如圖3所示,AlphaDrive在復(fù)雜場(chǎng)景(如前方車輛緩慢行駛)中可生成多個(gè)合理決策(如減速左轉(zhuǎn)超車或停車等待),而SFT模型僅輸出單一動(dòng)作。此能力可與下游動(dòng)作模型結(jié)合,動(dòng)態(tài)選擇最優(yōu)方案,提升駕駛安全性與效率。

結(jié)論與局限性

結(jié)論本研究提出了AlphaDrive——一種面向自動(dòng)駕駛規(guī)劃的視覺-語(yǔ)言模型(VLM)。與以往僅依賴監(jiān)督微調(diào)(SFT)的方法不同,我們探索了強(qiáng)化學(xué)習(xí)(RL)與推理技術(shù)在規(guī)劃任務(wù)中的結(jié)合。具體而言,AlphaDrive引入了基于GRPO的規(guī)劃導(dǎo)向RL策略,并設(shè)計(jì)了兩階段規(guī)劃推理訓(xùn)練范式。據(jù)我們所知,AlphaDrive是首個(gè)將RL與推理技術(shù)應(yīng)用于自動(dòng)駕駛規(guī)劃的框架,顯著提升了性能與訓(xùn)練效率。

局限性當(dāng)前版本仍存在以下不足:

- 復(fù)雜行為標(biāo)注數(shù)據(jù)不足:由于缺乏豐富的標(biāo)注數(shù)據(jù),AlphaDrive尚無(wú)法輸出車道變換或繞行等復(fù)雜駕駛行為;

- 偽標(biāo)簽質(zhì)量依賴:規(guī)劃推理數(shù)據(jù)來(lái)自大模型基于真實(shí)駕駛動(dòng)作生成的偽標(biāo)簽,其感知準(zhǔn)確性可能影響數(shù)據(jù)質(zhì)量,需進(jìn)一步閉環(huán)驗(yàn)證以提升性能上限。

未來(lái)工作將聚焦于通過(guò)數(shù)據(jù)增強(qiáng)與系統(tǒng)驗(yàn)證優(yōu)化模型能力,推動(dòng)自動(dòng)駕駛規(guī)劃技術(shù)的實(shí)際應(yīng)用。