譯者 | 李睿

審校 | 重樓

在人工智能時代,大型語言模型(LLM)的應用正在迅速增長。這些模型提供了大量的機會,但同時也帶來了新的隱私和安全挑戰。應對這些挑戰的基本安全措施之一是保護對LLM的訪問,以確保只有經過授權的人員才能訪問數據和執行任何操作的權限。這可以通過身份和訪問管理(IAM)來實現。

身份和訪問管理(IAM)就像關鍵數據和系統的安全衛士。這種方法就像大廈的保安,可以決定誰可以進入,誰又能訪問安全攝像頭等敏感區域。當某人試圖進入大廈時,保安會仔細詢問其身份、住址等詳細信息。一旦發現任何可疑行為,保安便會密切關注他在大廈內外的一舉一動。同樣,IAM確保只有經過授權的個人才能進入和訪問大型語言模型。IAM還保存用戶活動日志,以識別可疑行為。

那IAM是大型語言模型安全問題的解決方案嗎?本文將探討IAM在保護LLM方面的作用,但首先需要了解LLM是什么以及它們的用途。

語言建模

學習一門新語言并非易事。人類必須學習詞匯、語法規則和表達,才能完全學習一門語言。然而,對于機器來說,學習一門新語言并不難,只要給機器提供大量正確的文本數據。通過這些數據,機器可以學習語言的語法規則以及詞匯和表達方式。

教授機器一門語言被稱為語言建模。語言建模主要有兩種類型:

- 統計語言模型。這些模型是基于概率和統計進行訓練的。在大型數據集中,他們觀察單詞的模式以及它們如何做出預測。

- 神經語言模型。這些模型使用人工神經連接(像人類大腦一樣)來學習一門新語言。他們不僅要學習單詞和句型,還學習整個句子的表達方式和含義。

神經語言模型還可以細分為多個其他類別,其中一個被稱為基于Transformer的模型或簡稱為Transformer模型。這些模型非常擅長理解人類語言,因為它們不是逐字處理信息,而是使用并行處理,這使得處理速度更快。當處理句子時,這些系統可以理解表達并使用并行處理。它們最適合用于機器翻譯、理解查詢和生成響應。

什么是LLM?

LLM基于Transformer神經語言模型。LLM是一種在大型數據集上訓練的人工智能,因此它可以理解人類語言(自然語言處理)并根據查詢(問答)生成響應。如今,人們不僅將大型語言模型用于研究目的,還將其用于日常任務。LLM最著名的例子是聊天生成預訓練轉換器(ChatGPT)。

LLM是如何工作的?

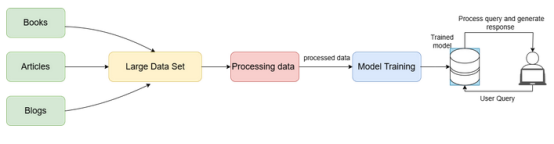

來自書籍、文章和研究論文等來源的數據被收集成一個大型數據集。然后將這些數據集處理成精細數據。LLM在這些數據集上進行訓練,并通過觀察語法、含義等來學習人類互動。

一旦對LLM進行了訓練,就可以將其作為服務嵌入,以處理用戶查詢并生成適當的響應。這些用戶交互產生更多的數據,這些數據用于進一步訓練模型,以獲得更好和增強的語言模型。

LLM的安全風險

LLM的工作方式與其他產品或服務不同,因此面臨不同的安全挑戰。以下討論LLM面臨的一些安全風險:

- 命令注入。這也被稱為提示黑客攻擊或輸入操縱。由于LLM是在包含敏感信息的大型數據集上訓練的,攻擊者可以操縱輸入以獲取敏感信息或獲得未經授權的訪問。

- 數據損壞。因為LLM在數據集上進行訓練,如果攻擊者破壞了這些數據集中的數據,他們可能會導致模型為用戶輸入生成不準確的響應。

- 服務中斷。攻擊者可以通過提交一個非常復雜的輸入來使用模型的大部分資源,從而使服務對其他用戶不可用或速度變慢。這可能會給合法用戶帶來糟糕的用戶體驗。這也稱為拒絕服務,因為LLM將拒絕為實際用戶提供服務。

- 易受攻擊的插件結構。LLM使用第三方插件,使其容易受到數據泄露或通過這些插件遠程運行的惡意代碼等風險的影響。

- 知識產權盜竊。當有人未經授權訪問LLM的專有信息時,他們可以竊取數據集以及新的用戶輸入和算法。然后,他們可以使用這些來創建自己的模型,從而訪問其他敏感信息。

以上這些是LLM面臨的一些關鍵安全風險。現在討論如何使用IAM來降低這些風險。

IAM在保護LLM安全中的作用

想象一下,一個家庭將食譜秘方記錄在一本日記本中,為了確保只有家庭成員或親朋好友能夠查看,他們為日記本配備了一把鎖,并為每位成員提供了一把獨一無二的鑰匙。這樣,這些食譜秘方就得到了妥善保護,只有持有唯一鑰匙并經過認證的人員才有權查閱這本日記。

IAM對數字數據起著同樣的作用。它為受信任的用戶分配一個身份,并且只允許這些用戶進行訪問,它允許系統保證數據的安全。

以下深入地了解一下身份和訪問管理在LLM中的含義:

- 身份管理。這有助于系統通過創建帳戶、分配唯一的用戶名和密碼以及添加其他個人數據來建立個人身份,以便在整個系統中進行跟蹤。它還可以在需要時刪除帳戶。

- 訪問管理。在每個系統中,都有多種類型的用戶。并非所有用戶都可以訪問所有資源。訪問管理有助于驗證用戶身份以及所述用戶是否對其試圖訪問的資源具有訪問權限。這保證了只有授權用戶才能訪問敏感信息并執行特定操作。

確保LLM的安全

以上討論了LLM所面臨的各種安全風險。當IAM在LLM的安全策略中實現時,它有助于最大限度地降低這些安全風險。這些風險可以通過以下方式得到解決:

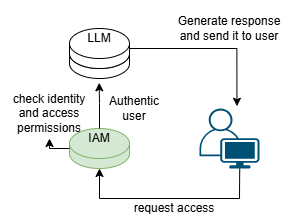

- 通過身份檢查:當用戶請求使用LLM時,IAM檢查用戶是否可信。它可以使用多種方法來檢查,例如生物識別或多因素身份驗證。

- 通過提供訪問控制:當用戶嘗試訪問資源或執行操作時,IAM將檢查該用戶是否具有訪問資源或執行特定操作的權限。IAM還可以根據用戶的角色分配權限。例如,管理員將擁有比普通用戶或訪客更多的訪問權限。

- 觀察和發現:IAM記錄用戶訪問的內容以及訪問任何資源的時間。然后分析這些記錄,發現并報告任何可疑活動。

IAM框架與LLM的工作流程

IAM框架與LLM的工作流程

- 部署挑戰。在系統中部署IAM并不總是那么容易。對于沒有多余資源的系統尤其如此,因為IAM可能會消耗大量資源,并且可能很耗時。

- 用戶體驗。用戶體驗對于任何基于用戶的產品都是至關重要的。IAM將添加額外的步驟來標識用戶,這有時會加重某些用戶的負擔。

- 成本高昂。使用IAM可能成本高昂,因為它需要額外的技術(軟件或硬件)和訓練。它還需要維護才能有效工作,這可能很耗時。

- 技術挑戰。用戶可能需要一些時間來適應新的身份識別系統。與已經工作的系統的集成也可能是棘手的。

IAM可以保護LLM。IAM確保只有經過授權的人員才能訪問和使用這些模型。這一安全策略和其他安全策略是安全和負責任地使用人工智能技術的必要條件。如果成功實施,這些策略將促進這些創新LLM的安全有效使用。

原文標題:Identity and Access Management Solution to Safeguard LLMs,作者:Anant Wairagade