一張圖,快速生成可拆分3D角色!騰訊清華新SOTA | CVPR 2025

任意一張立繪,就可以生成可拆分3D角色!

來自騰訊AI Lab、清華提出StdGEN。與以往方法在分拆能力有限、質量不理想和優化時間過長等問題上表現不佳不同,它具備高質量、高效性和可分拆性,能夠在3分鐘內生成具有精細細節的3D角色(粗粒度模型僅需1分鐘),并分離出語義組件,如身體、衣服和頭發。

可以預見到它能夠為虛擬現實、游戲和電影制作等領域注入新的活力!該研究成果接收于CVPR 2025,代碼和在線Gradio Demo已開源。

StdGEN的核心是語義感知大規模重建模型 (S-LRM),這是一個基于Transformer的可泛化模型,以前饋方式從多視角圖像中聯合重建幾何、顏色和語義信息。

此外,還引入了一種可微分的多層語義表面提取方案,用于從S-LRM重建的混合隱式場中獲取網格。

在流程中,還集成了專門設計的多視角擴散模型和迭代式的多層優化模塊,以促進高質量、可分解的3D角色生成。

大量實驗表明,他們在3D動漫角色生成方面達到了最先進的性能,在幾何、紋理和分解性方面顯著超越了現有基線,并在真人數據等風格具有泛化性。

StdGEN 提供了可直接使用的語義分解的3D角色模型,為廣泛的應用場景提供了靈活的定制能力。

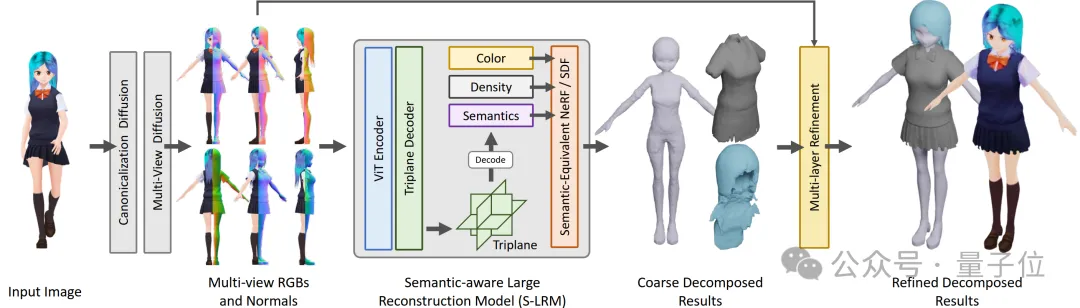

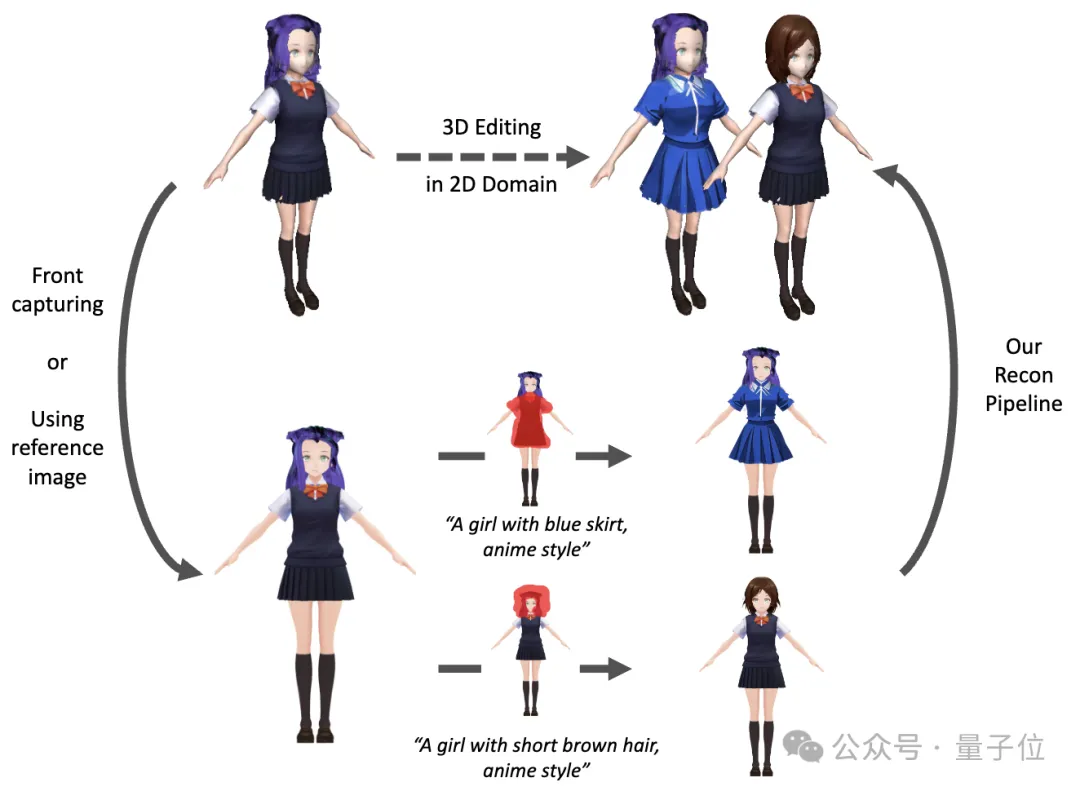

△圖1 StdGEN應用流程

單圖生成可解耦3D角色StdGEN

StdGEN首先從參考角色圖像生成多視角標準角色圖像。為了從多視角圖像重建可分解的3D角色,他們在LRM(大型重建模型)的基礎上擴展了語義場,從而實現基于語義的分層生成。最后通過多層優化過程來增強結果,改進幾何結構并提供更精細的紋理。

由于直接從任意姿態參考圖重建3D角色模型可能會受到不同視角下自遮擋的影響,本方法首先將參考角色圖像轉化為多視角的標準姿態角色圖像。

這一過程包括兩個步驟:

(1)將任意參考圖像規范化為A-pose角色,通過訓練擴散模型+圖像條件的ReferenceNet,在生成過程中不斷引入角色參考圖信息,生成A-pose下的標準角色圖像;

(2)從A-pose圖像生成多視角RGB圖像和法線貼圖(共6個視角),通過訓練多視角擴散模型完成,為后續3D重建和優化提供充足信息。

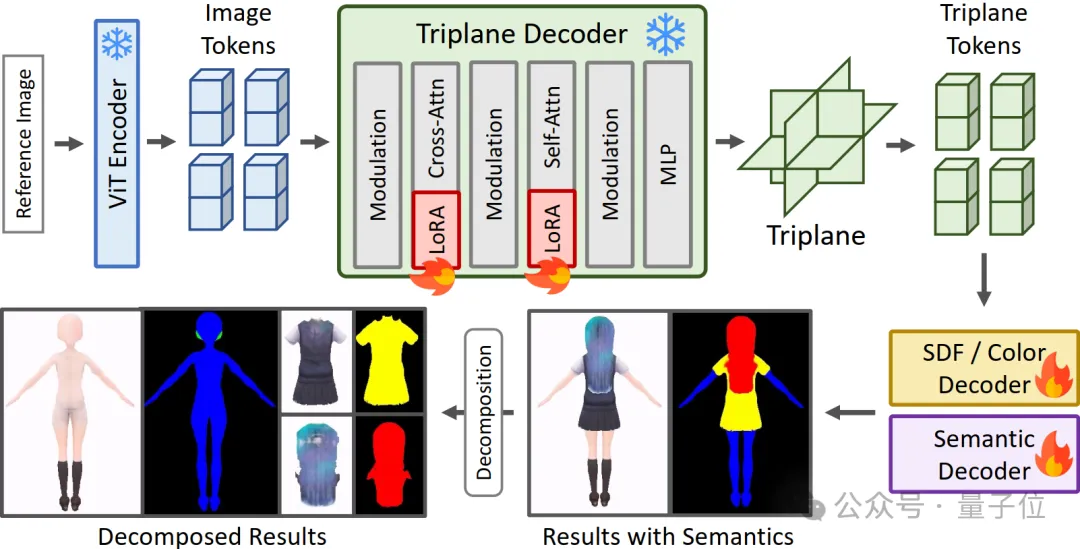

△圖2 帶語義感知的大型重建模型(S-LRM)示意圖

接下來將上一階段生成的圖像提取為特征并輸入帶語義感知的大型重建模型(S-LRM),得到基于Triplane的三維隱式特征,該特征被進一步解碼為顏色、體密度、語義和帶符號距離場(SDF)等顯式三維信息,為了實現語義解耦的三維角色生成,他們提出了一種新的語義等價神經隱式場和帶符號距離場公式,用于根據特定語義提取角色的不同部分,能夠實現角色各部分的語義分解,得到拆分后的粗糙三維模型。

△圖3 帶語義感知的大型重建模型(S-LRM)通過指定語義提取三維信息示意圖

為了訓練該模型學習多層語義信息的能力,團隊提出了三階段訓練流程,通過在已有大型重建模型的權重以及添加LoRA的方式使訓練更快進行:

(1)訓練單層語義的神經輻射場(NeRF),學習足夠可靠的三維表面及其語義信息,用于更好的引導后續訓練;

(2)訓練多層語義的神經輻射場(NeRF),通過屏蔽隨機數量的語義及其對應的三維信息部分引導物體內部的語義、幾何和顏色信息生成;

(3)訓練多層語義的帶符號距離場(SDF),通過在重建模型的后面加入FlexiCubes模塊,實現更高分辨率的監督和更貼合實際應用的三維Mesh網格輸出。

由于大型重建模型在幾何結構和紋理細節上的表現有限,重建后的網格通常需要進一步優化以提高細節精度。他們采取了分階段、多層次的方法,通過多視角標準化角色生成模塊生成的法線圖以及多視角一致性約束對于生成的分層三維角色結果進行迭代式優化——

首先通過指定不同的語義,提取網格的不同部分,并僅優化基礎的人體模型;優化完成后,將衣服部分疊加至人體上,固定人體基礎模型,僅優化衣服部分;最后添加頭發部分,固定之前已優化的兩層,僅優化頭發部分,實現所有模型的精細化處理。

實驗結果

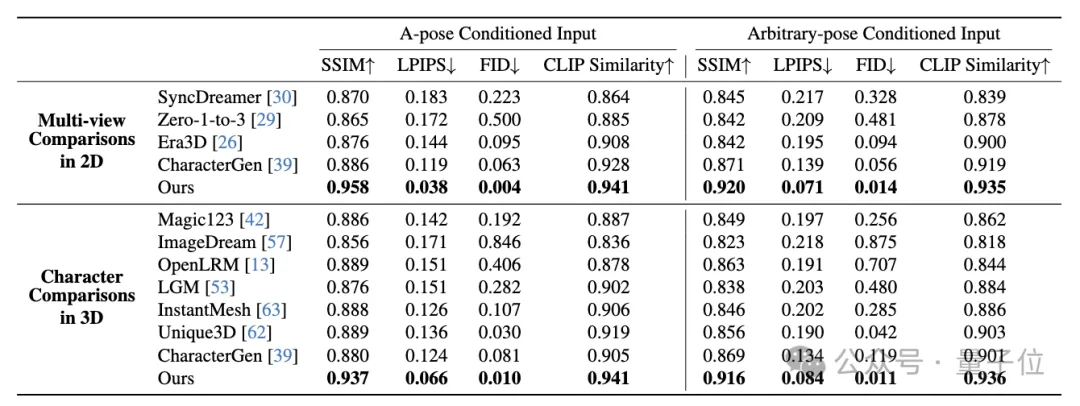

首先在Anime3D++數據集上進行了定量測試,包括2D多視角生成能力和3D角色生成能力。考慮到其他方法不具備從單張任意姿態圖像生成可解耦的3D模型的能力,與其他方法對比他們的非分層結果,并在A-pose圖像和任意姿態圖像輸入上均進行測試以保證公平性。

結果表明在所有定量指標上他們的方法均優于現有方法。

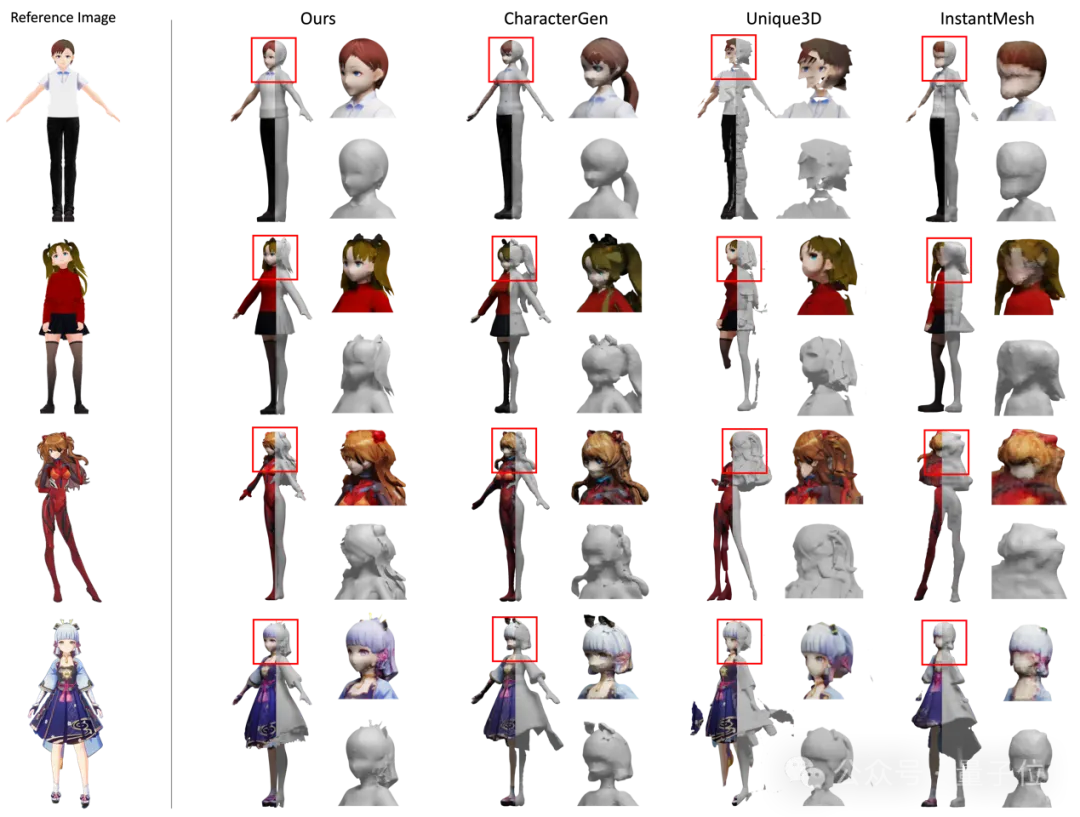

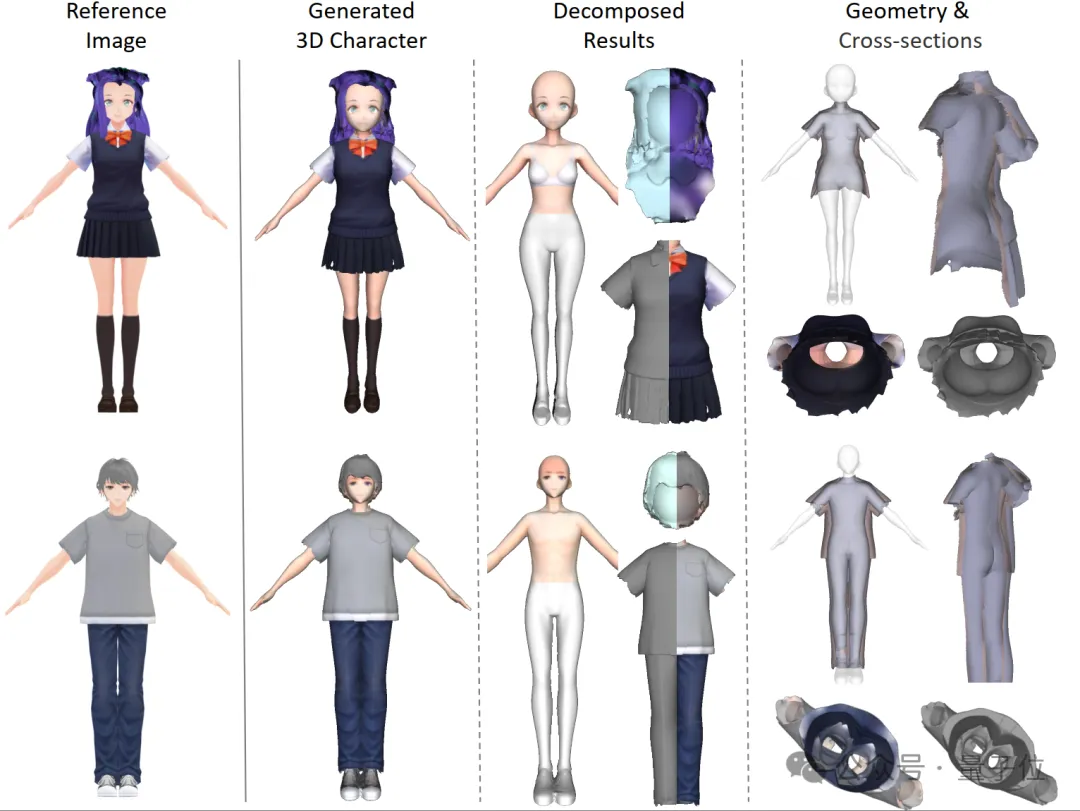

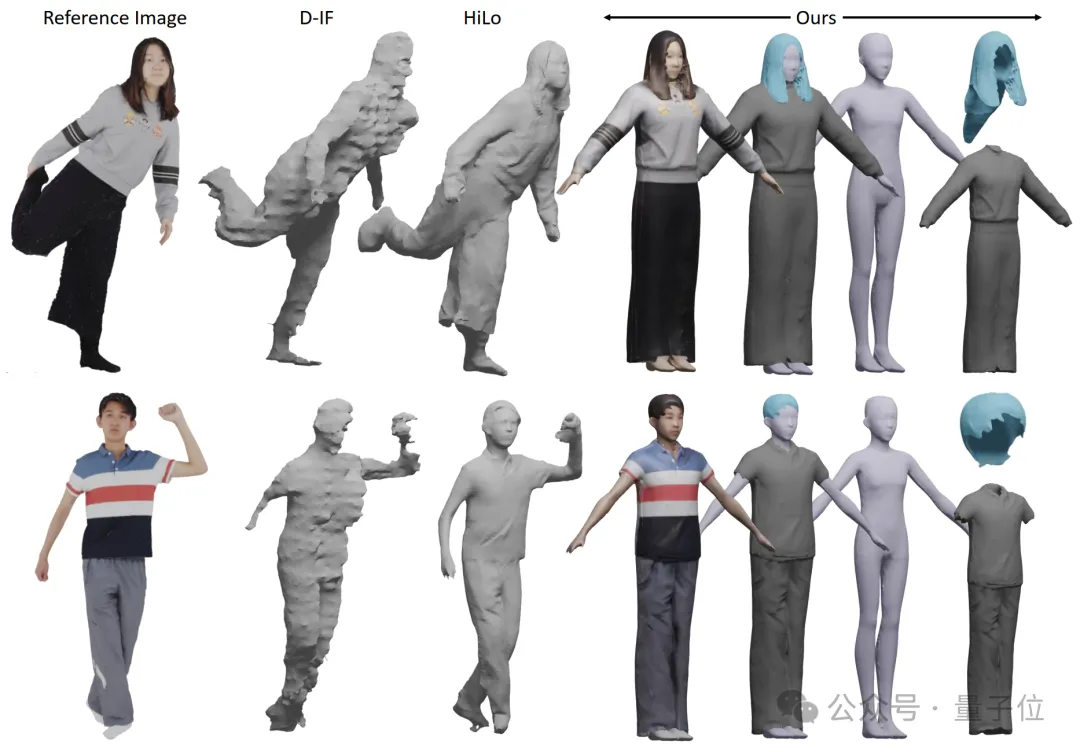

與其他先進方法的定性比較結果(包含數據集域外的測例、真人測例等)與3D解耦模型結果如下。

△表1 StdGEN及其他先進方法在Anime3D++數據集上的評價結果

△圖3 StdGEN及其他先進方法的主觀質量對比

△圖4 StdGEN的3D解耦生成能力展示

△圖5 StdGEN在真人測例上的泛化能力展示(THuman2.0 數據集)

實際應用

隨著游戲、虛擬現實和影視制作等行業的不斷發展,用戶對角色定制化的需求日益增加。現有游戲、虛擬現實等應用場景中要求三維角色模型的各個部分可拆分、單獨綁定動畫。

StdGEN基于語義解耦的設計,能夠生成每個部分(如人體、衣服、頭發等)獨立的三維組件,使得生成的3D角色不僅具有更高的質量,還能更好地應用于現有的游戲和虛擬現實等場景,確保其可用性和靈活性,彌補了先前工作的不足。

△圖6 StdGEN 僅需用戶進行2D Inpainting實現可拆分3D編輯

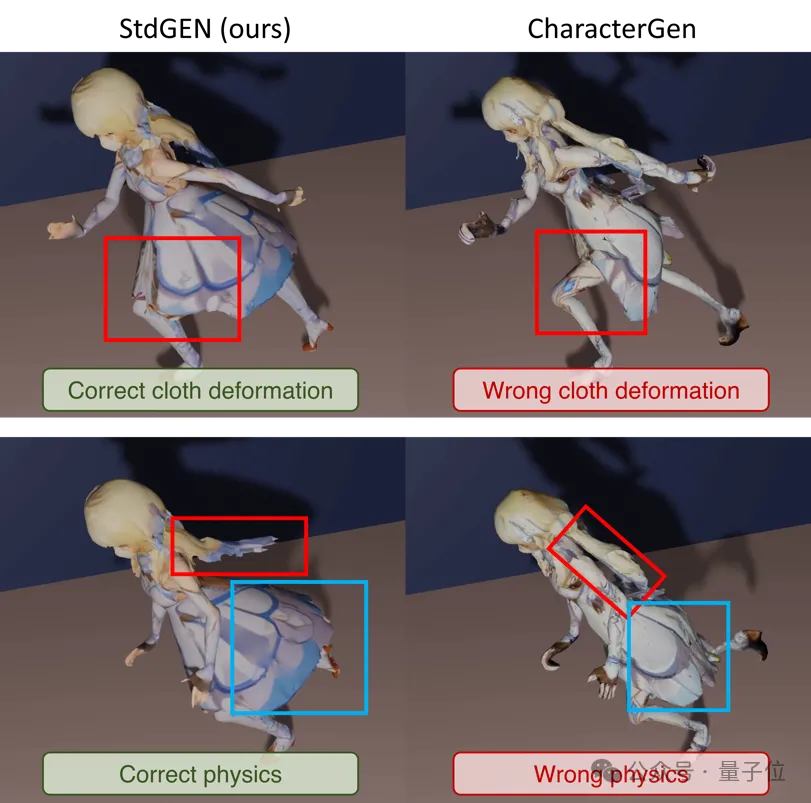

△圖7 StdGEN 的3D可拆分結果能夠實現更符合人類觀感和物理特性的動畫

論文鏈接:

https://arxiv.org/abs/2411.05738

在線 Gradio Demo: https://huggingface.co/spaces/hyz317/StdGEN

GitHub 代碼倉庫: https://github.com/hyz317/StdGEN

HuggingFace 模型倉庫: https://huggingface.co/hyz317/StdGEN