預測誤差降低12.3%,多車協同預測框架CMP,破解自動駕駛「視線盲區」

2025 年 3 月,加州大學河濱分校與密歇根大學、加州大學伯克利分校以及華盛頓大學聯合團隊在機器人領域頂級期刊《IEEE Robotics and Automation Letters》發表最新研究成果 ——CMP(Cooperative Motion Prediction),首次提出一種面向車聯網(V2X)的協同運動預測框架,通過多車信息共享與融合,顯著提升自動駕駛車輛的軌跡預測精度與場景適應能力。該技術已在真實場景數據集 V2V4Real 和仿真平臺 OPV2V 中驗證其高效性,相比現有最優模型,預測誤差降低 12.3%,為復雜交通環境下的自動駕駛安全決策提供了全新解決方案。

- 論文標題:CMP: Cooperative Motion Prediction with Multi-Agent Communication

- 論文鏈接:https://arxiv.org/pdf/2403.17916

- 項目網站:https://cmp-cooperative-prediction.github.io

- 代碼開源:https://github.com/tasl-lab/CMP

技術亮點:感知 - 預測一體化協同,破解自動駕駛 “視線盲區”

傳統自動駕駛系統依賴單車傳感器,易受遮擋或極端天氣影響,導致感知與預測能力受限。CMP 通過多車協同感知與預測的深度融合,打破單車信息孤島,實現 “全局視野” 與 “動態推理” 的雙重突破:

1. 高效協同感知

- LiDAR 數據共享與壓縮:利用 256 倍壓縮率的鳥瞰圖(BEV)特征傳輸,帶寬需求從 82.5 MB/s 降至 0.32 MB/s,兼顧通信效率與感知精度。

- 延遲魯棒性:支持 100ms 內通信延遲,通過時空對齊與多幀同步處理,確保數據在動態場景下的有效性。

2. 動態軌跡預測

- 多模態預測解碼器:基于 Transformer 架構,結合高斯混合模型(GMM),生成多樣化的未來軌跡假設,覆蓋車輛轉向、避讓等多種行為模式。

- 實時預測聚合:通過注意力機制動態整合多車預測結果,優先采納鄰近車輛的可靠預測,進一步提升長時預測(5 秒)的準確性。

一.研究背景

自動駕駛技術的核心在于對環境的精準感知與未來軌跡的可靠預測。然而,傳統系統依賴單車傳感器(如 LiDAR、攝像頭),存在視野受限、易受遮擋的固有缺陷 —— 例如,城市路口被建筑物遮擋的車輛、高速場景中的突然切入目標,僅憑單車感知極易出現漏檢或誤判,導致決策延遲甚至安全事故。為突破這一限制,協同感知(Cooperative Perception)應運而生。通過車聯網(V2X)技術,車輛可共享傳感器數據,構建全局環境認知。現有研究(如 V2VNet、CoBEVT)已證明,多車協同能顯著提升目標檢測精度,但這類工作多局限于感知層的信息融合,未深入挖掘協同數據對運動預測的價值。與此同時,單車軌跡預測模型如 MTR,并未考慮多車交互,協同預測。在此背景下,CMP(Cooperative Motion Prediction)應勢而生。作為首個感知 - 預測一體化協同框架,CMP 不僅通過高效 BEV 特征共享與壓縮技術擴展感知邊界,更創新性地引入預測聚合模塊,動態融合多車預測結果,在真實通信約束下實現 “全局感知 - 精準預測 - 協同決策” 的閉環,為復雜動態場景中的自動駕駛安全樹立新標桿。

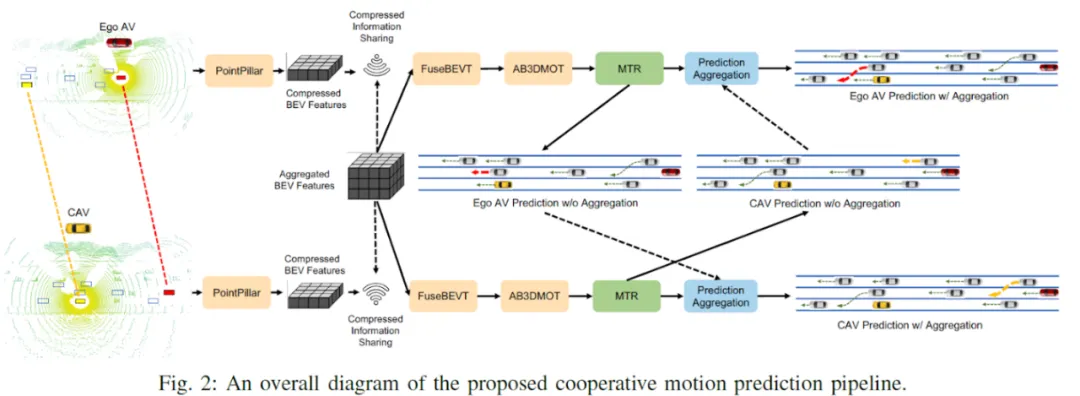

二.研究方法:感知 - 預測 - 聚合三階協同框架

CMP 以多車協同感知為基礎、動態軌跡預測為核心、預測聚合優化為閉環,構建了一套完整的三階協同框架,其技術路徑如下:

1. 協同感知:多車 LiDAR 數據的高效融合

目標:突破單車感知盲區,構建全局環境表征。

- BEV 特征提取與壓縮:

采用改進版 CoBEVT 作為骨干網絡,將每輛車的 LiDAR 點云轉換為鳥瞰圖(BEV)特征(分辨率 0.4m×0.4m),通過卷積自編碼器進行 256 倍壓縮,帶寬需求從 82.5 MB/s 降至 0.32 MB/s,滿足車規級通信要求。

- 時空對齊與延遲補償:

基于 GPS 同步時鐘,設計 100ms 通信窗口,通過可微分空間變換算子(STO)對齊多車坐標系,動態丟棄超時數據,解決車輛運動與通信延遲導致的特征錯位問題。

- 跨車特征融合:

利用 FuseBEVT 模塊聚合多車 BEV 特征,結合輕量化檢測頭輸出 3D 目標框,檢測精度(AP@0.7)達 0.82,較單車間步長提升 24%。

- 多物體跟蹤:

對于檢測出的物體,場景中每一臺 CAV 獨自使用基于 AB3DMOT 的跟蹤算法進行跟蹤。

2. 軌跡預測:多模態 Transformer 解碼器

目標:基于歷史軌跡與場景上下文,生成多樣化的未來軌跡假設。

- 場景編碼與意圖建模:

引入 MTR 模型框架,通過 Polyline 編碼器提取車輛軌跡特征,ViT 編碼器提取高精地圖語義,結合 Transformer 融合局部交互與全局意圖。

- 動態意圖點聚類:

采用 k-means 對歷史軌跡終點聚類,生成 64 個意圖點(Intention Points),表征轉向、直行、停車等多模態目標。

- 高斯混合軌跡生成:

通過 Transformer 解碼器迭代優化軌跡,輸出高斯混合模型(GMM)參數,覆蓋未來 5 秒內位置分布(均值 μ、方差 σ、相關性 ρ),支持概率化多模態預測。

3. 預測聚合:注意力驅動的協同優化

目標:整合多車預測結果,抑制單視角誤差,提升全局一致性。

- 跨車預測對齊:

將各車的 GMM 參數、局部地圖與 BEV 特征拼接為統一輸入,通過 MLP 編碼為聯合特征向量。

- 多層注意力融合:

設計 8 頭 - 5 層 Transformer 架構,動態加權多車預測置信度(如鄰近車輛預測權重更高),自適應補償通信丟包或遮擋導致的預測缺失。

- 端到端聯合訓練:

采用多任務損失函數,同步優化檢測(Focal Loss + L1 Loss)、預測(NLL + L2 Loss)與聚合模塊,避免誤差跨階段累積。

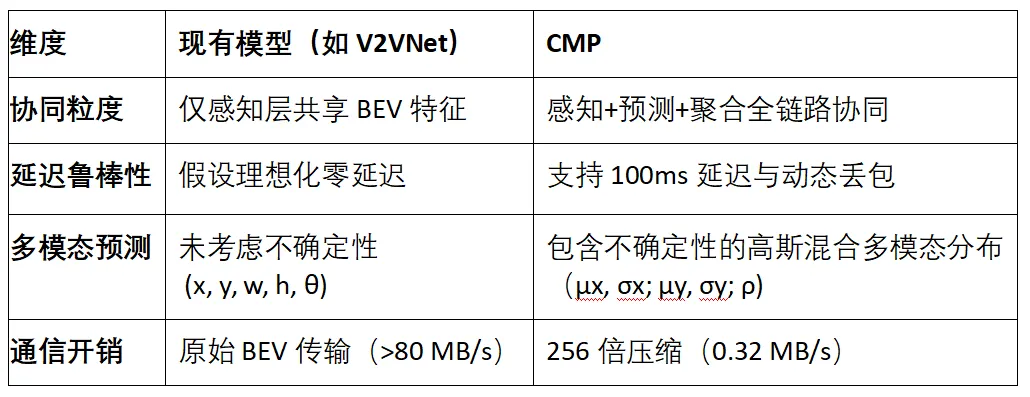

技術對比:CMP 的創新突破

CMP 通過感知 - 預測聯合建模與輕量化通信設計,首次在真實車聯網約束下實現多車協同運動預測,為復雜動態場景的自動駕駛決策提供了可靠技術底座。

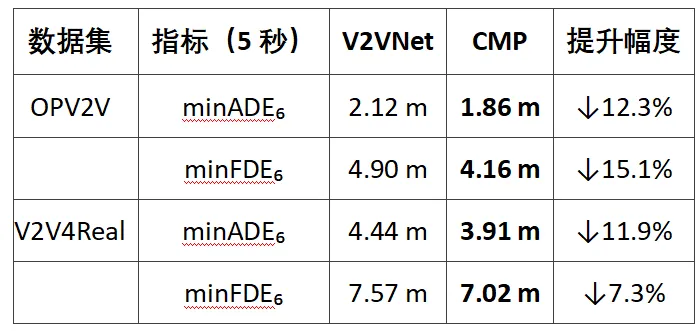

三.實驗結果和分析:協同驅動預測精度全面突破

CMP 在 OPV2V(仿真)與 V2V4Real(真實場景)兩大數據集上進行了系統性驗證,涵蓋感知、跟蹤、預測全鏈路性能評估,并與 V2VNet、CoBEVT 等前沿模型對比,核心結論如下:

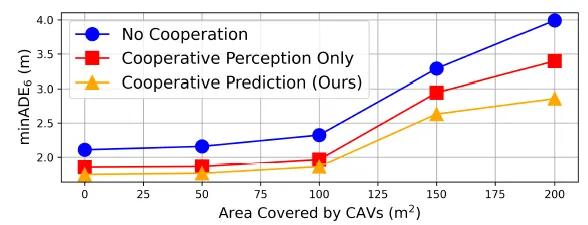

1. 運動預測:長時誤差降低 19%

在 5 秒長時預測任務中,CMP 憑借協同感知 - 預測聯合優化,顯著優于現有方案 V2VNet:

關鍵發現:

- 協同感知貢獻顯著:僅啟用協同感知(不疊加預測聚合),預測誤差較無協同降低 10%-15%,證明多車數據融合可有效擴展感知邊界。

- 預測聚合增益突出:引入跨車預測聚合模塊后,誤差進一步降低 5%-8%,凸顯多視角預測互補的價值。

- 真實場景優勢更大:V2V4Real 中 CMP 的 minFDE?相對提升達 19%,表明其對遮擋、復雜交互的強適應能力。

- 大范圍場景效果更明顯:進一步根據 CAV 在場景中的散布顯示,隨著協同車輛覆蓋區域擴大(>200 m2),CMP 的預測精度提升高達 28.4%,充分驗證其在大范圍復雜場景中的優勢。

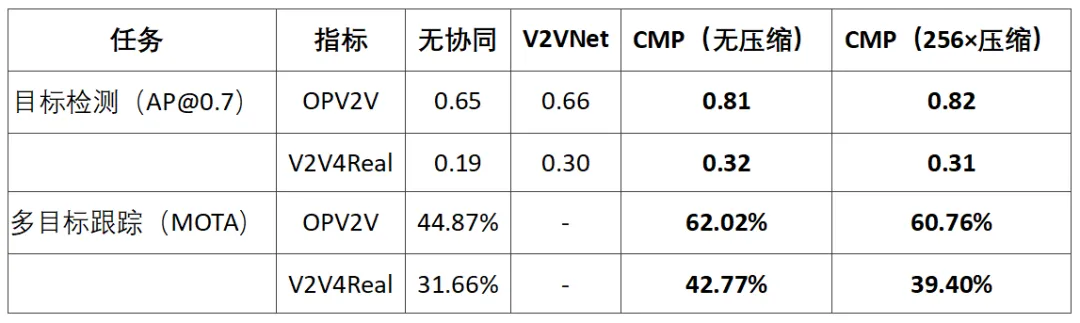

2. 感知與跟蹤:高壓縮率下的精度保持

CMP 在保證通信效率的同時,維持了高精度感知與穩定跟蹤:

關鍵發現:

- 高效壓縮可行性:256 倍 BEV 特征壓縮幾乎不會導致檢測精度下降,驗證輕量化通信設計的有效性。

- 跟蹤魯棒性提升:多車協同減少漏檢與 ID 切換,MOTA 提升 15%-25%,為長時預測提供更完整的歷史軌跡輸入。

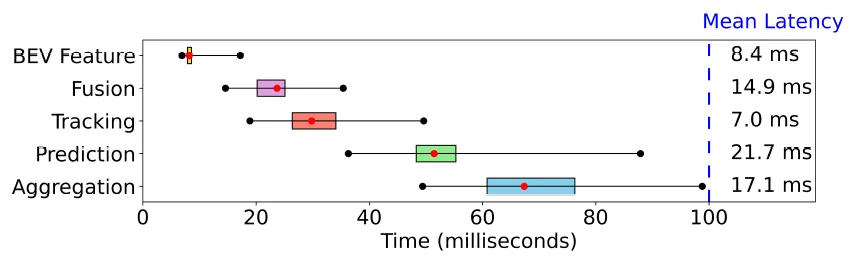

3. 通信效率與延遲魯棒性

CMP 在真實通信約束下仍保持穩定性能:

- 計算速度:CMP 中所有計算部分可以在 100ms 完成,符合業界無人駕駛需求。

- 帶寬需求:單車間 BEV 傳輸帶寬從 82.5 MB/s(原始)降至 0.32 MB/s(256× 壓縮),支持 10 車協同場景實時通信。

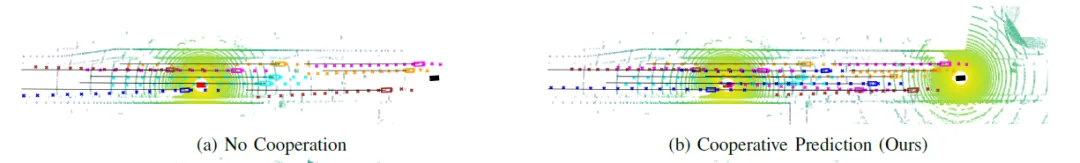

4. 可視化分析:遮擋場景預測優勢

如圖所示,單車(紅色)感知因視野受限漏檢右側車輛,導致缺少對于一些車輛的軌跡。而 CMP 通過協同感知補全被遮擋目標,且預測軌跡與真值高度吻合。

四.總結:協同預測開啟自動駕駛新范式

CMP 通過感知 - 預測 - 聚合全鏈路協同,在通信效率、延遲魯棒性、預測精度三大維度實現突破,為復雜動態場景下的自動駕駛提供了可靠技術方案。未來,團隊將進一步探索端到端可微分架構與多模態融合,推動協同自動駕駛邁向更高階智能。隨著 V2X 技術的普及,CMP 有望成為下一代自動駕駛系統的核心模塊,為智慧交通與無人駕駛規模化落地奠定技術基石。