駛向未來,首個多視圖預測+規劃自動駕駛世界模型來了

近期,世界模型的概念引發了火熱浪潮,而自動駕駛領域豈能隔岸觀「火」。來自中科院自動化所的團隊,首次提出了一種名為 Drive-WM 的全新多視圖世界模型,旨在增強端到端自動駕駛規劃的安全性。

網站:https://drive-wm.github.io

論文鏈接:https://arxiv.org/abs/2311.17918

首個多視圖預測和規劃的自動駕駛世界模型

在 CVPR2023 自動駕駛的研討會上,特斯拉和 Wayve 兩大科技巨頭狂秀黑科技,一種名為「生成式世界模型」的全新概念隨之火爆自動駕駛領域。Wayve 更是發布了 GAIA-1 的生成式 AI 模型,展示了令人震撼的視頻場景生成能力。而最近,中科院自動化所的研究者們也提出了一個新的自動駕駛世界模型 ——Drive-WM,首次實現了多視圖預測的世界模型,與當下主流的端到端自動駕駛規劃器無縫結合。

Drive-WM 利用了 Diffusion 模型的強大生成能力,能夠生成逼真的視頻場景。

想象一下,你正在開車,而你的車載系統正在根據你的駕駛習慣和路況預測未來的發展,并生成相應的視覺反饋來指導軌跡路線的選擇。這種預見未來的能力和規劃器相結合,將極大地提高自動駕駛的安全性!

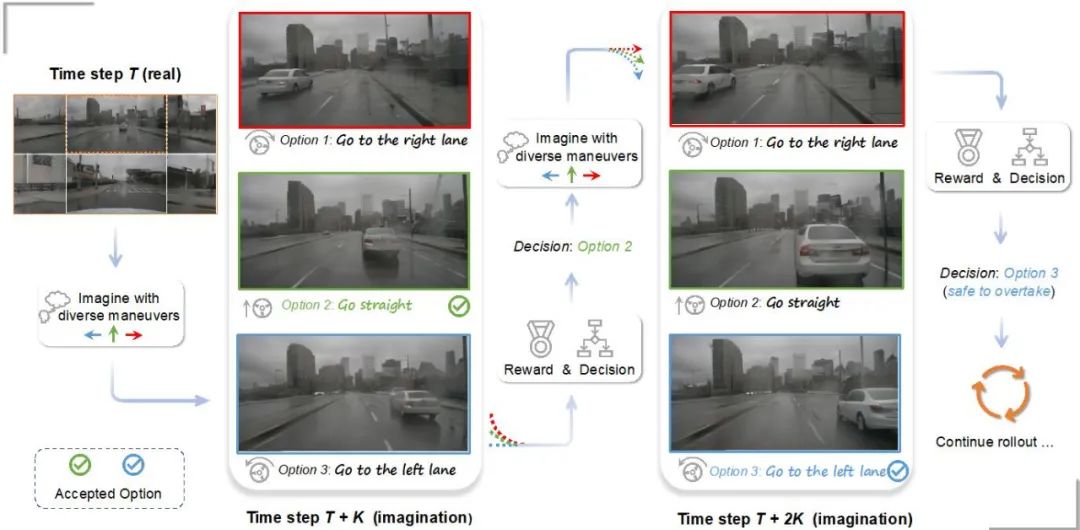

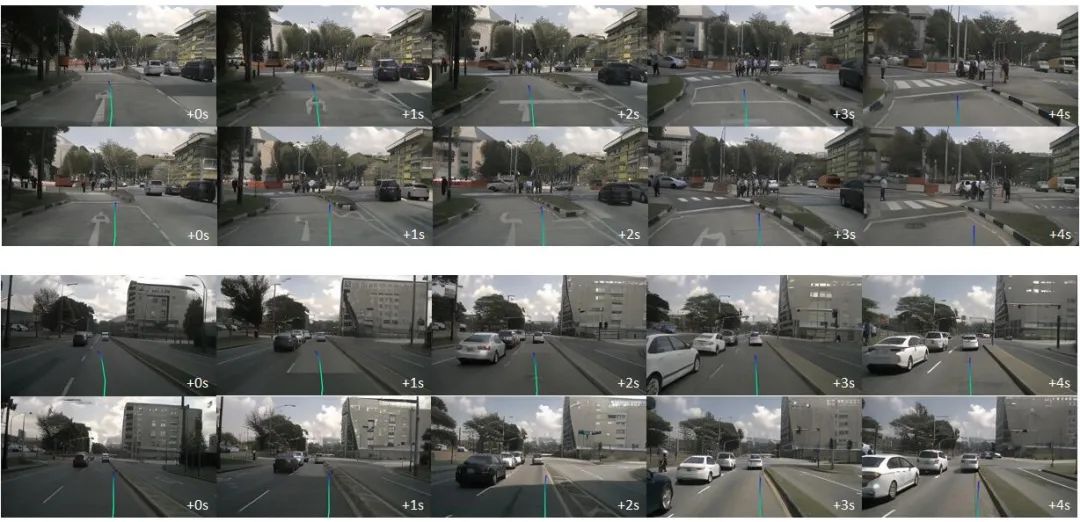

基于多視圖世界模型的預測和規劃。

世界模型與端到端自動駕駛的結合提升駕駛安全性

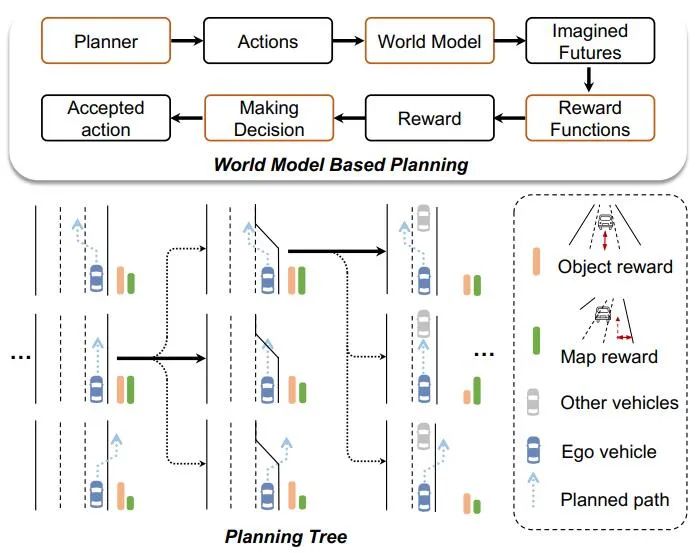

Drive-WM 模型首次將世界模型與端到端規劃相結合,為端到端自動駕駛的發展打開了新的篇章。在每個時間步上,規劃器可以借助世界模型預測未來可能發生的情景,再利用圖像獎勵函數全面評估。

基于世界模型的端到端軌跡規劃樹

選擇最優估計,擴展規劃樹,實現更安全、有效的規劃。

Drive-WM 開創性地探索了世界模型在端到端規劃中的兩種應用:

1. 展示了世界模型在面對 OOD 場景時的魯棒性。作者通過對比實驗發現了目前的端到端規劃器在面對 OOD 情況時的表現并不理想。

作者給出了以下圖片,當對初始位置進行輕微的橫向偏移擾動后,目前的端到端規劃器就難以輸出合理的規劃路線。

端到端規劃器在面對 OOD 情況時難以輸出合理的規劃路線。

Drive-WM 的強大生成能力為解決 OOD 問題提供了新的思路。作者利用生成的視頻來微調規劃器,從 OOD 數據中進行學習,使得規劃器在面對這樣的場景時可以擁有更好的性能。

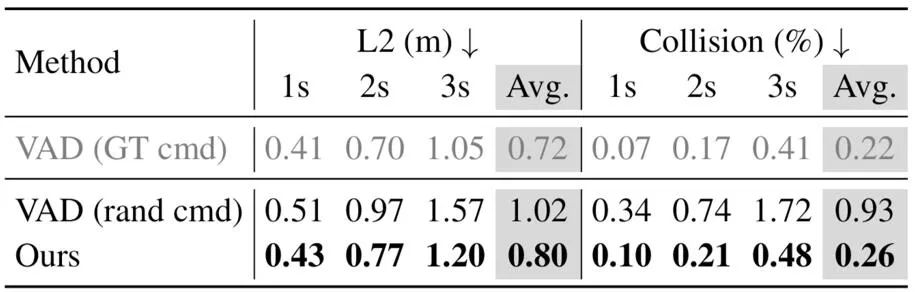

2. 揭示了引入未來場景評估對于端到端規劃的提升作用

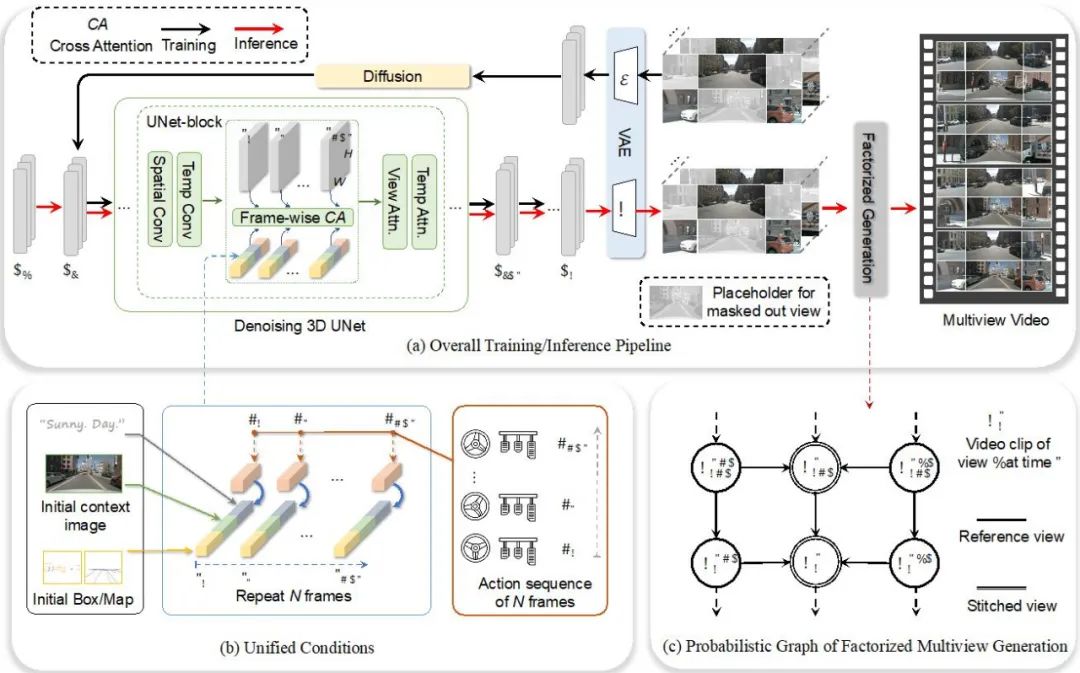

如何構建多視圖的視頻生成模型

多視圖視頻生成的時空一致性一直以來都是一個具有挑戰性的問題。Drive-WM 通過引入時序層的編碼來擴展視頻生成的能力,并通過視圖分解建模的方式實現多視圖的視頻生成。這種視圖分解的生成方式可以極大地提升視圖之間的一致性。

Drive-WM 整體模型設計

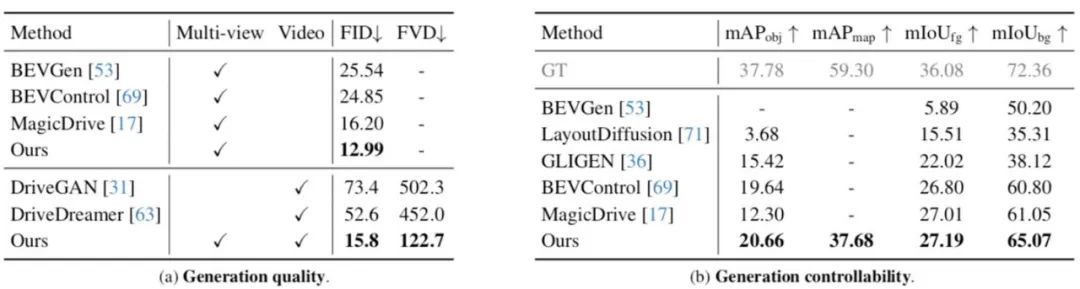

高質量的視頻生成與可控性

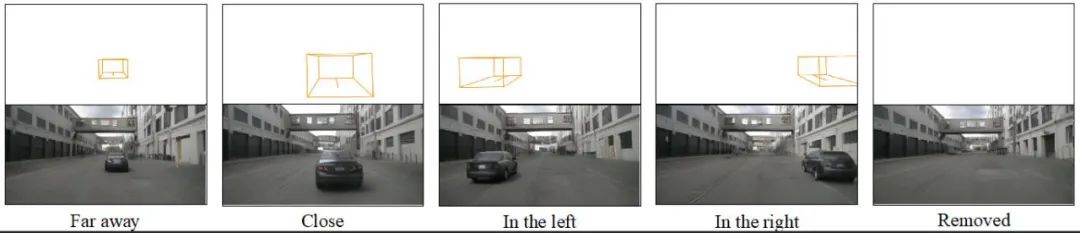

Drive-WM 不僅實現了高質量的多視圖視頻生成,而且具有出色的可控性。Drive-WM 還提供了多種控制選項,可以通過文本、場景布局、運動信息來控制多視圖視頻的生成,也為將來的神經仿真器提供了新的可能性。

比如使用文本來改變天氣和光照:

比如行人的生成和前景的編輯:

利用速度和方向的控制:

稀有事件的生成,例如路口掉頭和開進側方草叢:

結語

Drive-WM 不僅展示了其強大的多視圖視頻生成能力,也揭示了世界模型與端到端駕駛模型相結合的巨大潛力。相信在未來,世界模型可以幫助實現更安全、穩定、可靠的端到端自動駕駛系統。