推理延展到真實(shí)物理世界,英偉達(dá)Cosmos-Reason1:8B具身推理表現(xiàn)超過OpenAI ο1

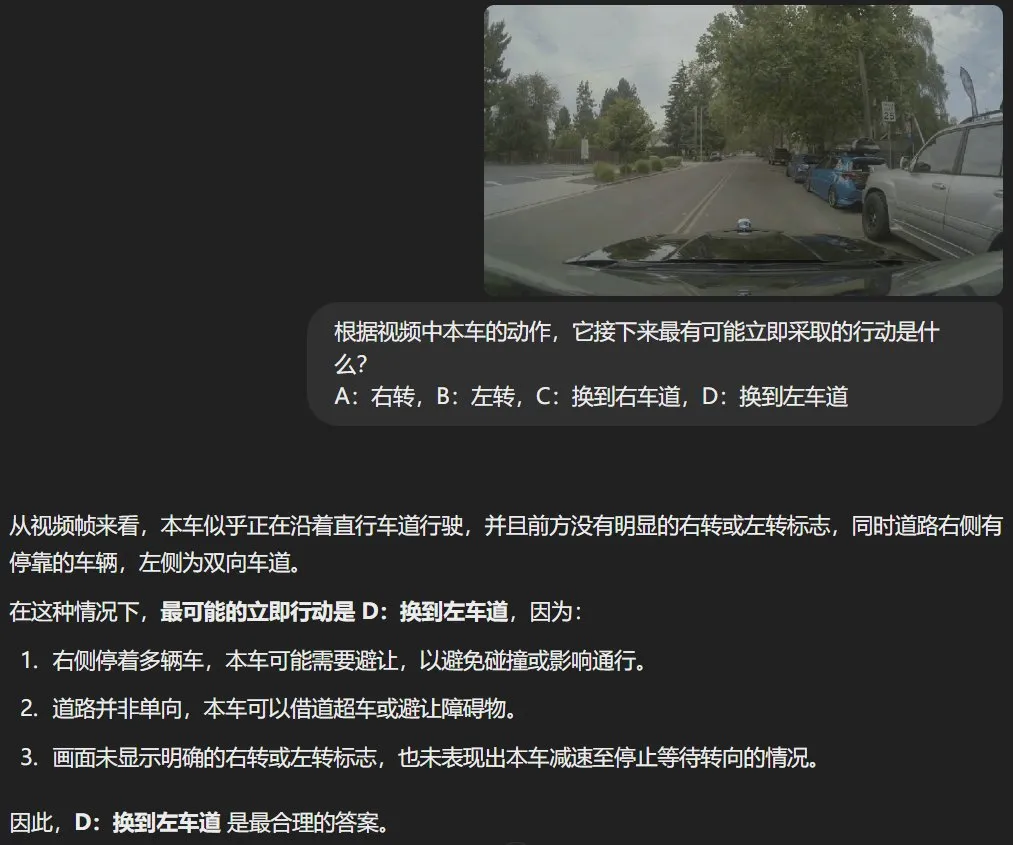

在基于物理世界的真實(shí)場景進(jìn)行視覺問答時,有可能出現(xiàn)參考選項(xiàng)中沒有最佳答案的情況,比如以下例子:

根據(jù)視頻中本車的動作,它接下來最有可能立即采取的行動是什么?

A:右轉(zhuǎn),B:左轉(zhuǎn),C:換到右車道,D:換到左車道

很顯然,這里最佳的答案應(yīng)該是直行,但預(yù)先提供的 4 個選項(xiàng)中并沒有這個答案。也因此,目前的大多數(shù) AI 在面臨這個問題時往往并不能識別題中陷阱,會試圖從選項(xiàng)中找到正確答案。比如下面展示了 ChatGPT 的回答:

當(dāng)然,在日常的視覺問答任務(wù)中,這樣的錯誤無傷大雅,但一旦涉及到真實(shí)的任務(wù)場景(比如真正的自動駕駛),這樣的錯誤就是無法容忍的了。

而要正確解答這類問題,物理常識必不可少。

近日,英偉達(dá)發(fā)布了一系列針對物理常識推理進(jìn)行了專門優(yōu)化的新模型:Cosmos-Reason1。從實(shí)際結(jié)果看,該模型的表現(xiàn)確實(shí)不錯。比如針對以上問題,該模型經(jīng)過一番推理后,認(rèn)為給出的選項(xiàng)都不對,因此沒有給出選擇。

Cosmos-Reason1 針對以上視覺問答問題輸出的思考過程和答案。

據(jù)介紹,Cosmos-Reason1 不僅包含模型,更是英偉達(dá)開發(fā)的一個包含模型、本體(ontologies)和基準(zhǔn)的套件,其目標(biāo)是讓多模態(tài) LLM 能夠生成有物理依據(jù)的響應(yīng)。

目前他們已經(jīng)發(fā)布了兩個多模態(tài) LLM:Cosmos-Reason1-8B 和 Cosmos-Reason1-56B。

這兩個模型都經(jīng)過了四個階段的訓(xùn)練:視覺預(yù)訓(xùn)練、通用 SFT、物理 AI SFT 和物理 AI 強(qiáng)化學(xué)習(xí)。此外,他們還為物理常識和具身推理定義了本體,并構(gòu)建了用于評估多模態(tài) LLM 的物理 AI 推理能力的基準(zhǔn)。

下面我們就來具體看看英偉達(dá)的這項(xiàng)研究成果。

- 論文標(biāo)題:Cosmos-Reason1: From Physical Common Sense To Embodied Reasoning

- 論文地址:https://arxiv.org/abs/2503.15558

- 代碼地址:https://github.com/nvidia-cosmos/cosmos-reason1

物理 AI 推理

物理 AI(Physical AI)并不是一個新概念,但肯定算是英偉達(dá)近段時間最為推崇的發(fā)展方向之一 —— 在黃仁勛前些天的 GTC 2025 大會 Keynote 演講中,物理 AI 也是核心關(guān)鍵詞之一。

根據(jù)英偉達(dá)官網(wǎng)的定義:物理 AI 是指使用運(yùn)動技能理解現(xiàn)實(shí)世界并與之進(jìn)行交互的模型,它們通常封裝在機(jī)器人或自動駕駛汽車等自主機(jī)器中。

在今天介紹的這篇論文中,英偉達(dá)首先定義了物理常識(physical common sense)的本體論(ontology)。

可以看到,其中包含三大類別:空間、時間和其它基本物理。這三大類又被進(jìn)一步分為 16 類,如下表 1 所示。

此外,該團(tuán)隊(duì)也定義了具身推理的本體論,其中涉及處理復(fù)雜的感官輸入、預(yù)測動作效果、尊重物理約束、從互動中學(xué)習(xí);詳見下表。

Cosmos-Reason1

下面將介紹 Cosmos-Reason1 的多模態(tài)架構(gòu)以及 LLM 主干選擇。

多模態(tài)架構(gòu)

為了構(gòu)建多模態(tài) LLM,現(xiàn)在已經(jīng)有多種不同的架構(gòu)選擇。常用的架構(gòu)是僅解碼器架構(gòu)(例如 LLaVA)和基于交叉注意力的架構(gòu)(例如 Flamingo 和 Llama 3-V)。

英偉達(dá)采用了類似于 LLaVA 和 NVLM-D 的僅解碼器架構(gòu),因?yàn)樗唵吻铱赏ㄟ^將其它模態(tài) token(圖像或視頻)對齊到文本 token 嵌入空間來統(tǒng)一處理所有模態(tài)。

具體來說,該模型的架構(gòu)首先是一個視覺編碼器,然后是包含下采樣兩層 MLP 的 projector,然后是僅解碼器的 LLM 主干。

具體選擇上,英偉達(dá)這里使用了 InternViT-300M-V2.5 作為 Cosmos-Reason1-8B 和 Cosmos-Reason1-56B 的視覺編碼器。

對于每張輸入圖像,該架構(gòu)會動態(tài)調(diào)整圖像以達(dá)到預(yù)定義的寬高比,并將其分割成 1 到 12 個圖塊,每個圖塊的尺寸為 448 × 448 像素,具體取決于圖像的分辨率。此外,還會生成一個縮略圖圖塊 —— 完整圖像的縮小版本,以保留全局上下文。

對于每段輸入視頻,則以最高每秒 2 幀的速率均勻采樣最多 32 幀,并將每幀的大小調(diào)整為 448 × 448 像素。對于每個 448×448 視頻幀輸入,視覺編碼器會生成 1,024 個視覺 token,其圖塊大小為 14×14,然后使用 PixelShuffle 將其下采樣 2×2 倍,通過將空間維度轉(zhuǎn)換為通道維度將其減少到 256 個 token。

來自多個圖塊的圖像 token 與交錯的圖塊 ID 標(biāo)簽連接在一起,而來自多個幀的視頻 token 則會直接連接在一起。

Cosmos-Reason1 的 LLM 主干采用了混合 Mamba-MLP-Transformer 架構(gòu)設(shè)計(jì)。

表 3 總結(jié)了其模型配置:

混合 Mamba-MLP-Transformer 主干

最近英偉達(dá)發(fā)布了不少 Mamba-Transformer 混合架構(gòu)的研究成果,事實(shí)上我們昨天就正巧介紹過其中兩個:Nemotron-H 和 STORM。

而今天我們介紹的 Cosmos-Reason1 系列模型則采用了 Mamba-MLP-Transformer 混合架構(gòu),如下圖所示。

在訓(xùn)練時,Cosmos-Reason1-8B 模型采用了 4 的張量并行化(TP=4),而 Cosmos-Reason1-56B 模型則采用了 8 的張量并行化和 2 的管道并行化(TP=8, PP=2)—— 可支持更長視頻的訓(xùn)練。

實(shí)驗(yàn)表現(xiàn)

下面我們簡單看看 Cosmos-Reason1 系列模型的實(shí)驗(yàn)表現(xiàn)。有關(guān)實(shí)驗(yàn)的更多詳細(xì)設(shè)置和討論請閱讀原論文。

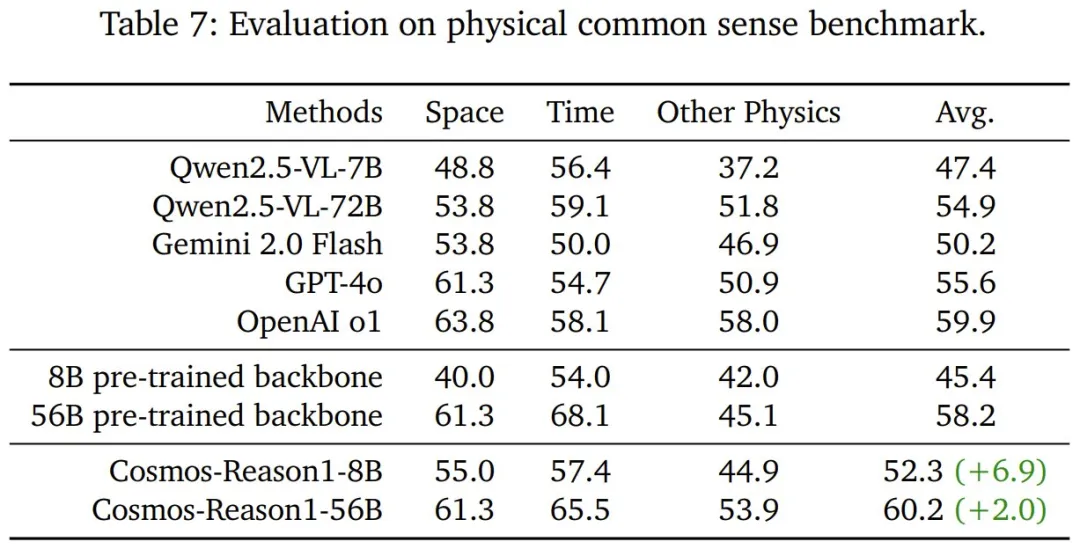

物理 AI 監(jiān)督式微調(diào)的效果

首先來看經(jīng)過物理 AI 監(jiān)督式微調(diào)后,Cosmos-Reason1 的物理常識表現(xiàn)。如表 7 所示,Cosmos-Reason1-8B 和 Cosmos-Reason1-56B 在各自的主干網(wǎng)絡(luò)基礎(chǔ)上都有明顯提升,其中 56B 版本的準(zhǔn)確度表現(xiàn)最好,甚至略微超過了 OpenAI ο1。

要知道,這個結(jié)果是在強(qiáng)化學(xué)習(xí)訓(xùn)練之前取得的。這彰顯了該團(tuán)隊(duì)精心挑選的常識數(shù)據(jù)集的有效性,為進(jìn)一步的 RL 改進(jìn)奠定了堅(jiān)實(shí)的基礎(chǔ)。

接下來看看經(jīng)過物理 AI 監(jiān)督式微調(diào)后,Cosmos-Reason1 的具身推理表現(xiàn)。從表 8 可以看到,Cosmos-Reason1 模型在此基準(zhǔn)上取得了比所有基線模型明顯更好的結(jié)果,8B 和 56B 變體與各自的主干 VLM 相比均有超過 10% 的提升。

那 Cosmos-Reason1 的直覺物理理解能力如何呢?該團(tuán)隊(duì)觀察到,許多 VLM 在基本物理推理方面存在困難。該團(tuán)隊(duì)針對三個任務(wù)對模型的能力進(jìn)行了測試,包括時間箭頭、空間拼圖和物體持久性。

表 10 展示了測試結(jié)果,可以看到在時間箭頭和物體持久性任務(wù)上,現(xiàn)有模型的表現(xiàn)和胡亂猜測差不多。而在空間拼圖任務(wù)上,GPT-4o 和 OpenAI o1 的表現(xiàn)卻比隨機(jī)亂猜好得多。

這表明當(dāng)前的多模態(tài)模型在推理空間關(guān)系方面比推理時間動態(tài)方面更熟練。鑒于這些模型通常在 MMMU 等標(biāo)準(zhǔn)基準(zhǔn)上表現(xiàn)良好,這說明現(xiàn)有評估其實(shí)無法體現(xiàn)它們對物理世界的理解能力。

然而,該團(tuán)隊(duì)精心設(shè)計(jì)的直覺物理數(shù)據(jù)集可使 8B 模型能夠在所有三個任務(wù)上有顯著提升,就展現(xiàn) Cosmos-Reason1 在直覺物理推理方面的基本能力。

物理 AI 強(qiáng)化學(xué)習(xí)的效果

對于上面得到的模型,該團(tuán)隊(duì)又進(jìn)行了進(jìn)一步的后訓(xùn)練,以進(jìn)一步增強(qiáng)它們的物理 AI 推理能力。為此,該團(tuán)隊(duì)構(gòu)建了自己的 RL 基礎(chǔ)設(shè)施,并基于其針對物理常識、具身推理和直覺物理推理任務(wù)對模型進(jìn)行了后訓(xùn)練。注意,這里并沒有使用復(fù)雜獎勵,都是簡單的、基于規(guī)則的可驗(yàn)證獎勵。

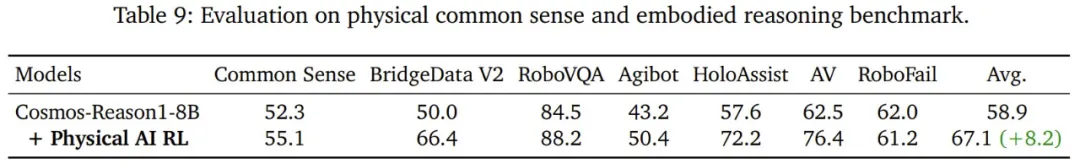

首先來看在物理常識和具身推理任務(wù)上的結(jié)果,如表 9 所示。

可以看到,物理 AI RL 后訓(xùn)練可以提高模型在大多數(shù)基準(zhǔn)上的性能,但 RoboFail 是個明顯的例外。

不過該團(tuán)隊(duì)表示這并不奇怪,因?yàn)?RoboFail 是經(jīng)過精心設(shè)計(jì)的人工整編的基準(zhǔn),具有測試「動作可供性(action affordance)」和「任務(wù)完成驗(yàn)證」的高難度現(xiàn)實(shí)場景。該基準(zhǔn)的難度源于幾個因素:(1) 需要高度觀察的感知或全面的時間上下文處理的樣本,(2) 與 RoboVQA 中的問題不同,可供性問題涉及動作執(zhí)行中的復(fù)雜物理約束。

該團(tuán)隊(duì)認(rèn)為,在 RoboFail 上的表現(xiàn)不提升的主要原因是代表性訓(xùn)練數(shù)據(jù)不足。

該團(tuán)隊(duì)還發(fā)現(xiàn)了一個有趣現(xiàn)象:新提出的模型學(xué)會了仔細(xì)評估所提供的選項(xiàng),如果問題不明確,則會全部拒絕。如本文開始時舉的例子所示,該模型會評估每個選項(xiàng)的可行性,并在出現(xiàn)歧義時采取不在選擇范圍內(nèi)的保守行動。

最后,在直覺物理推理任務(wù)上,如上表 10 所示,通過精心的監(jiān)督式微調(diào)數(shù)據(jù)整編和針對性訓(xùn)練,Cosmos-Reason1-8B 在所有任務(wù)上都取得了顯著的進(jìn)步,而物理 AI RL 能夠進(jìn)一步增強(qiáng)模型的空間拼圖和物體持久性能力。然而,推理時間箭頭仍然很困難。

整體來說,物理 AI RL 可以提升模型在空間、時間和物體持久性方面的推理能力。

圖 9 展示了在 RL 前后 Cosmos-Reason1 的時間推理能力的差異。可以看到,該模型能夠識別反物理的運(yùn)動 —— 例如粉末違背重力上升到碗中,同時不受視頻中靜止干擾物的影響。這表明它的推理不僅僅是感知。

類似地,在圖 10 中可以看到,有 RL 的模型傾向于將空間問題與時間推理混淆。雖然他們可以感知到第二幀與第一幀缺乏相似性,但它們固有的偏見會導(dǎo)致它們遵循默認(rèn)的視頻順序,這表明它們更多地依賴于時間線索而不是真正的空間理解。

使用空間謎題來進(jìn)行 RL 可讓模型從第一幀中提取關(guān)鍵特征,并在多幀之間系統(tǒng)地比較它們,從而準(zhǔn)確地確定空間關(guān)系。

最后,圖 11 表明,即使 CoT 較長,沒有物理 AI RL 的模型也會難以理解物體持久性,經(jīng)常難以推理物體的出現(xiàn)和消失。相比之下,經(jīng)過 RL 的模型可通過直接而簡潔的推理快速得出結(jié)論。