ACL 2024 | 讓純LLM實現(xiàn)類人的符號邏輯推理能力,開源框架SymbCoT來了

徐俊東,本文第一作者。本科畢業(yè)于倫敦大學(xué)學(xué)院(UCL),碩士就讀于新加坡國立大學(xué)(NUS)計算機系。主要研究方向為大語言模型的推理能力。

個人主頁:https://aiden0526.github.io/JundongXu/

不使用外部工具也能讓大語言模型(LLMs)實現(xiàn)嚴(yán)謹(jǐn)可信的推理,新國立提出 SymbCoT 推理框架:結(jié)合符號化邏輯(Symbolic Logical)表達(dá)式與思維鏈,極大提升推理質(zhì)量,魯棒性與可信度。

LLMs 已表現(xiàn)出強大的語義理解能力。但現(xiàn)有的 LLMs 在實行嚴(yán)密的邏輯符號推理方面還存在很大的不足,依然需要依賴不同的思維提示方法與外部的符號推理工具進(jìn)行邏輯推理。如何能讓 LLMs 本身具備強大的符號邏輯推理能力,是目前讓 LLMs 變得更強大的重要研究方向。

最近,新加坡國立大學(xué)聯(lián)合加州大學(xué)圣芭芭拉分校與奧克蘭大學(xué)的研究人員共同提出全新的符號邏輯推理框架 SymbCoT(Symbolic Chain-of-Thought),在推理質(zhì)量,魯棒性與可信度都要超越現(xiàn)有的方法。該工作已被 ACL 2024 錄用。

- 論文:Faithful Logical Reasoning via Symbolic Chain-of-Thought

- 論文地址:https://arxiv.org/pdf/2405.18357.pdf

- 代碼地址:https://github.com/Aiden0526/SymbCoT

當(dāng)前有效的邏輯推理方法還存在一些缺陷。比如說 CoT 在嚴(yán)密的邏輯推理過程中經(jīng)常會產(chǎn)生邏輯謬誤。引入外部工具的方法,比如 Logic-LM,使用 LLM 來翻譯前提,然后使用外部推理工具如 Prover9 來進(jìn)行邏輯推導(dǎo),但這種方法在翻譯的過程中容易出現(xiàn)信息損失或翻譯錯誤導(dǎo)致外部推理工具無法執(zhí)行。

因此,作者提出 SymbCoT,一個既可以引入嚴(yán)密邏輯推理,又能避免翻譯造成的信息損失 / 錯誤導(dǎo)致外部推理工具失效的框架。通過實驗證明,SymbCoT 與直接提示,傳統(tǒng) CoT 和使用外部推理工具相比,SymbCoT 分別在三個復(fù)雜邏輯推理數(shù)據(jù)集上提升 22.08%、9.31% 和 7.88%。并且在復(fù)雜場景推理、可信度、魯棒性等方面優(yōu)于現(xiàn)有方法。

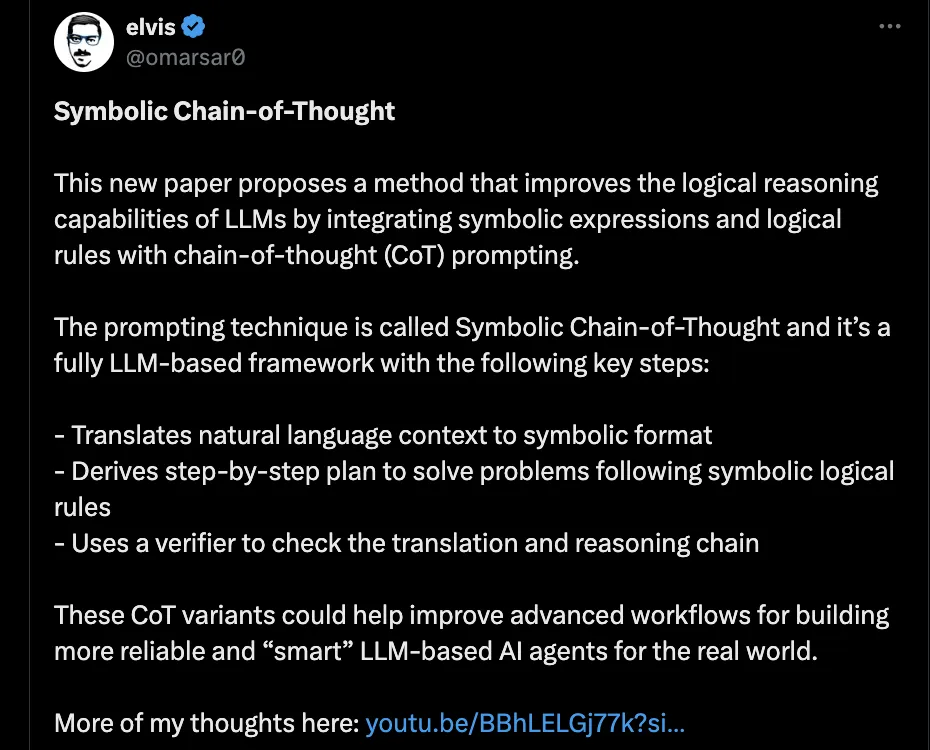

推特知名人工智能博主隨后轉(zhuǎn)發(fā)了這篇論文,認(rèn)為這種方法有助于改進(jìn)高級工作流程,構(gòu)建更可靠和智能的 LLM AI 代理。該推文僅發(fā)布一天,已獲得 6w + 瀏覽量和超過 1200 + 點贊與收藏。

A.SymbCoT 框架介紹

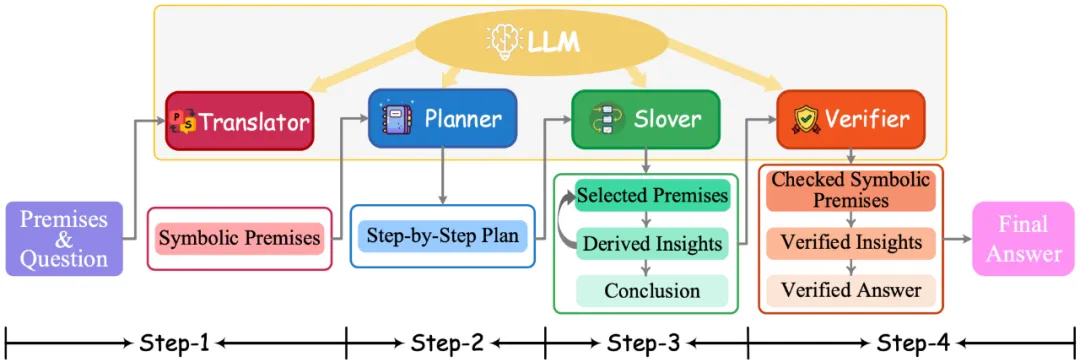

總體來說,SymbCoT 包含四個部分:

1. 翻譯:將邏輯推理任務(wù)中的前提與結(jié)論翻譯成對應(yīng)的符號化表達(dá)。

2. 規(guī)劃:根據(jù)結(jié)合翻譯前后的自然語言與符號化表達(dá),生成符合邏輯推理的計劃。

3. 執(zhí)行:嚴(yán)格按照對應(yīng)的邏輯推理規(guī)則去驗證結(jié)論的邏輯正確性。

4. 驗證:驗證翻譯與執(zhí)行是否存在錯誤。通過對比翻譯前后的語義信息,去驗證翻譯過程中存在的錯誤并矯正,同時驗證執(zhí)行過程中是否存在不符合邏輯推理規(guī)則的步驟。

以下結(jié)合具體的使用示例進(jìn)行介紹。

- 任務(wù)定義:

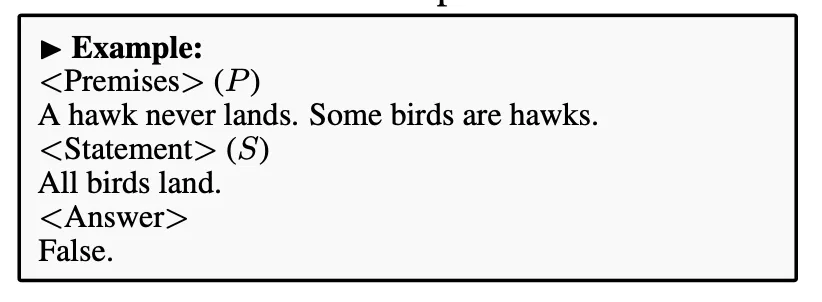

作者提出的 SymbCoT 來解決邏輯推理任務(wù)。該任務(wù)需要從一系列給定的前提中,判斷給定的聲明是否正確

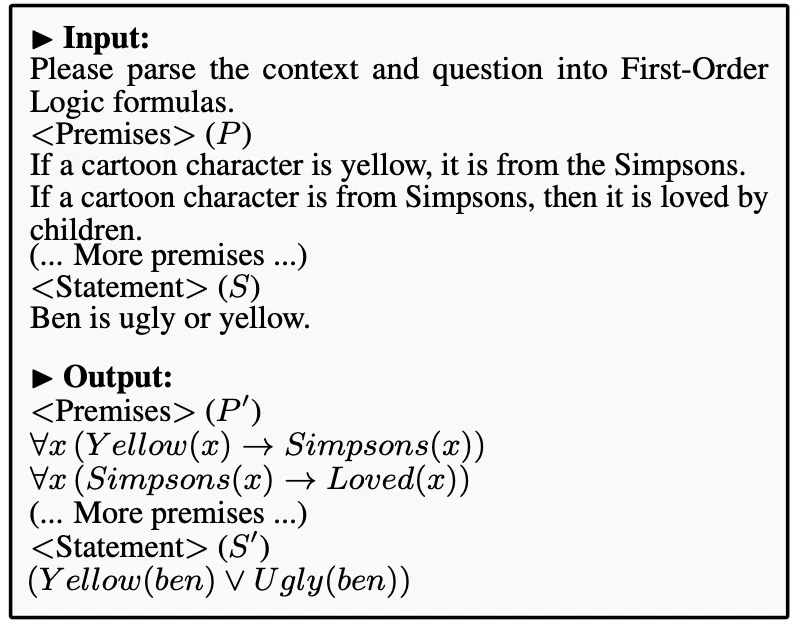

- 翻譯:

首先,SymbCoT 中的翻譯模塊會將給定的前提 P,聲明 S,翻譯成對應(yīng)的符號化表達(dá) P' 和 S'

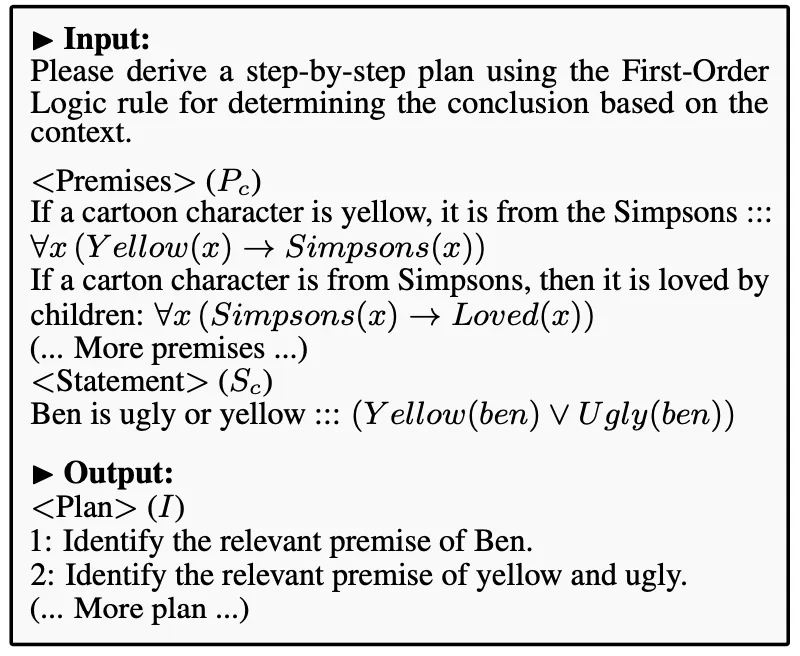

- 規(guī)劃:

結(jié)合翻譯前后的自然語言與符號化信息,規(guī)劃模塊會基于相關(guān)的邏輯規(guī)則去生成一個可執(zhí)行的邏輯推理計劃

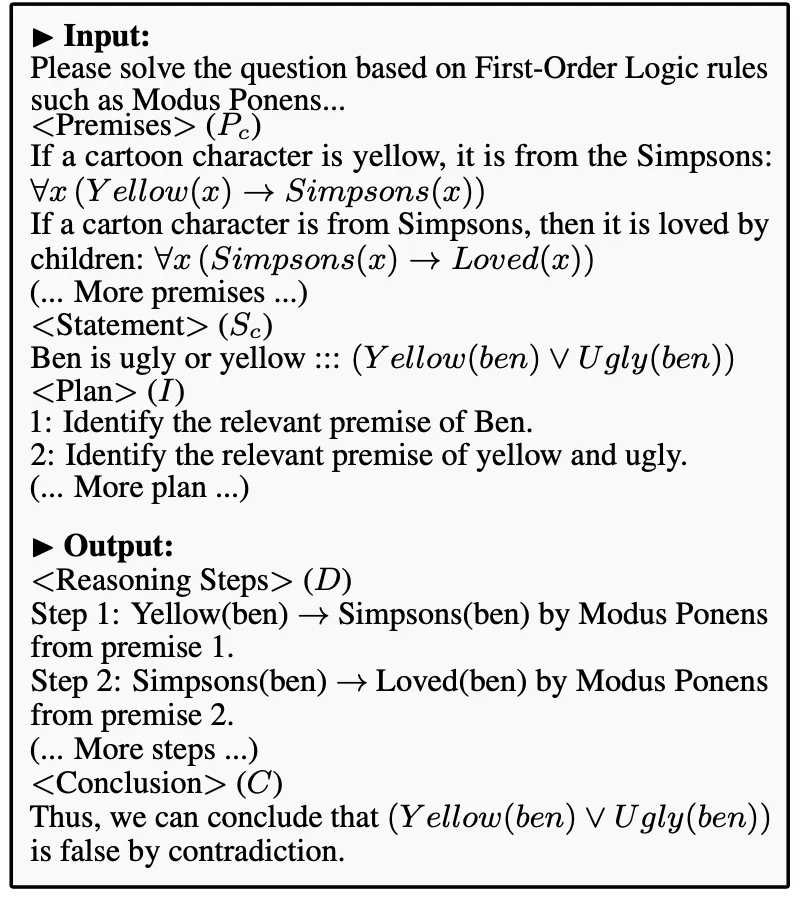

- 執(zhí)行:

根據(jù)翻譯前后結(jié)合的信息,配合規(guī)劃模塊生成的執(zhí)行計劃,SymbCoT 會嚴(yán)密地遵守邏輯推理規(guī)則去執(zhí)行計劃,對聲明的正確性得出一個初步結(jié)論

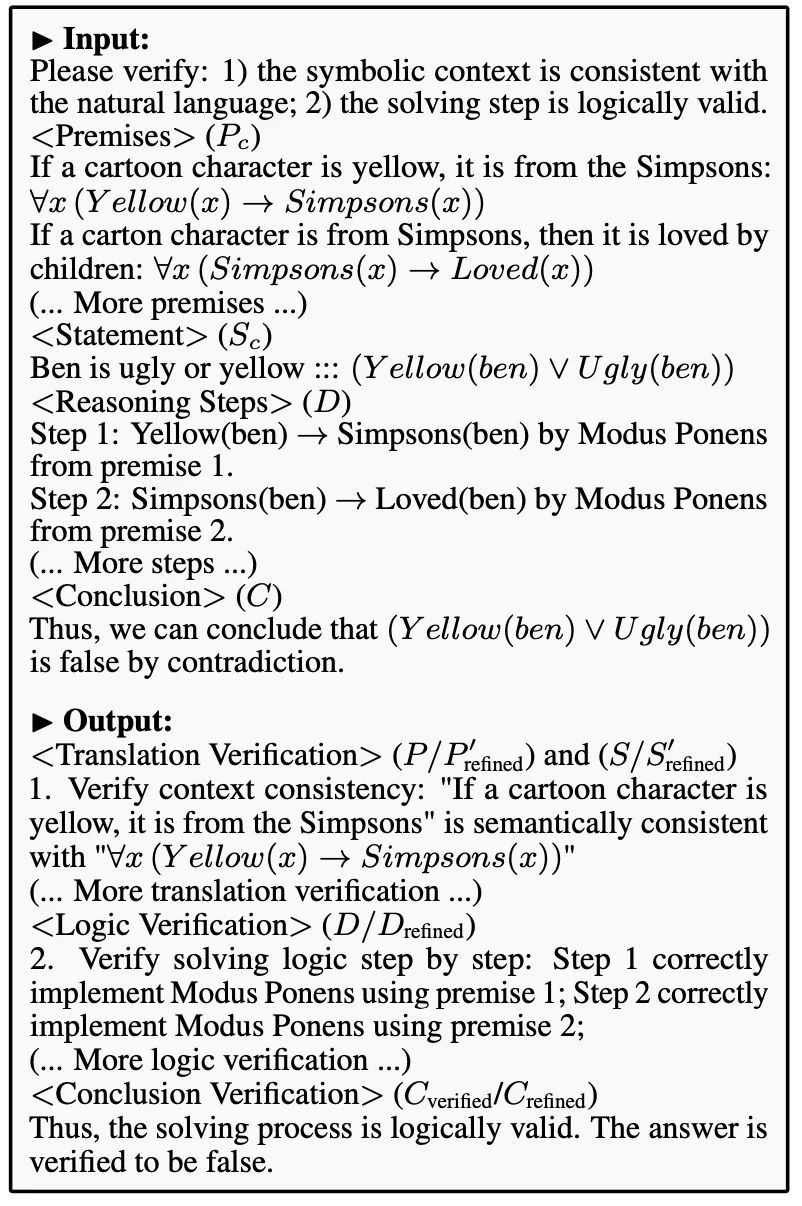

- 驗證:

該模塊主要有兩個功能。第一:通過比對翻譯前后的語義信息,驗證翻譯中是否存在錯誤;第二:檢查執(zhí)行過程中的每一步是否遵守了嚴(yán)謹(jǐn)?shù)倪壿嬕?guī)則。若任何一個步驟中存在錯誤,驗證模塊會更正發(fā)現(xiàn)的錯誤并給出正確的推理步驟與結(jié)果

B. 實驗結(jié)果

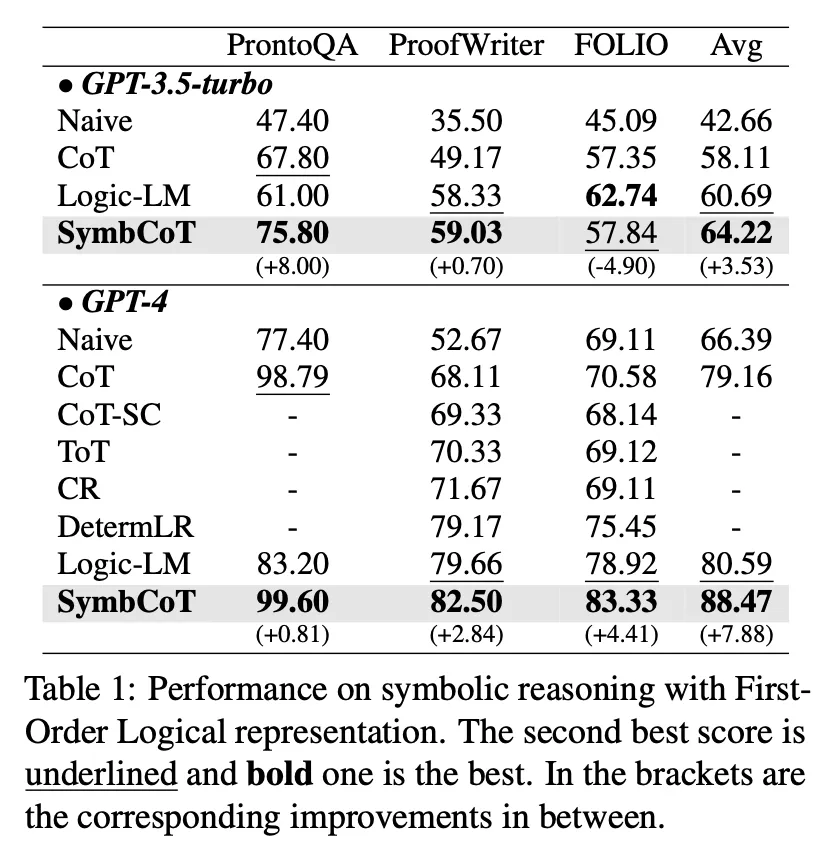

作者首先使用 First-order logic 的規(guī)則,在三個邏輯推理數(shù)據(jù)集上進(jìn)行了測試。實驗證明 SymbCoT 在 GPT3.5-turbo 與 GPT-4 上均能大幅超越傳統(tǒng) CoT 的性能,甚至超越了使用外部工具的框架(Logic-LM)。

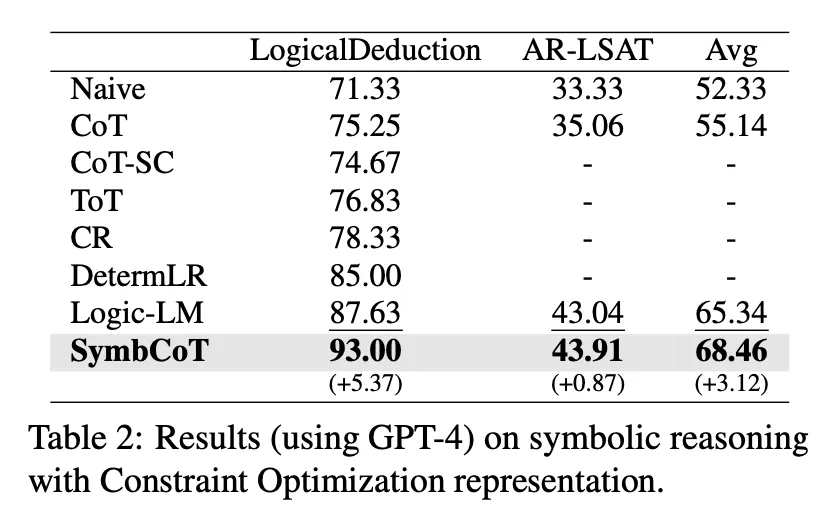

為了驗證該框架的普適性,作者隨后使用 Constraint Optimization 符號表達(dá)的推理規(guī)則在另外兩個數(shù)據(jù)集上進(jìn)行了測試。實驗證明使用不同的邏輯規(guī)則也能帶來更好的性能。

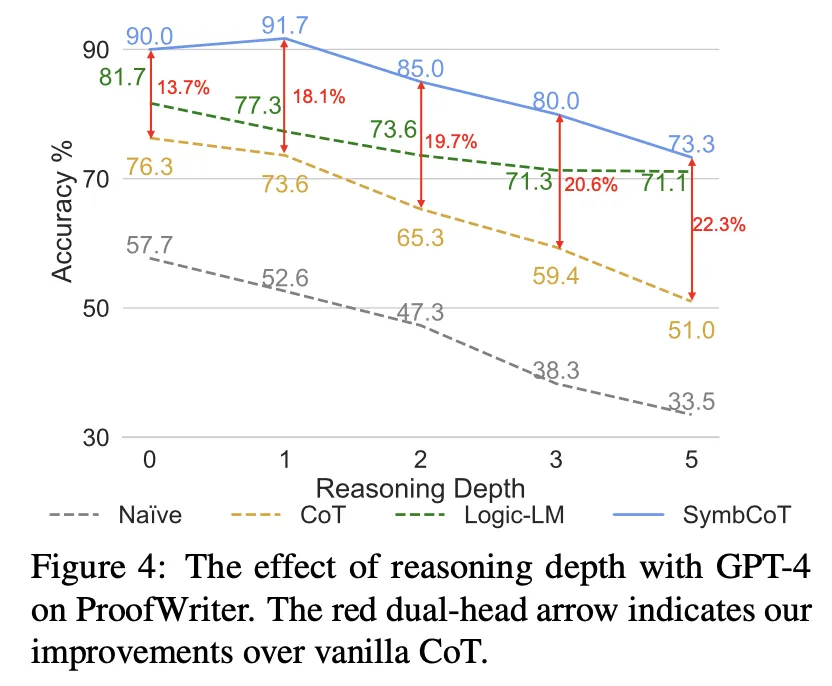

- 復(fù)雜推理能力:

作者分析了不同方法在不同推理深度上的表現(xiàn),發(fā)現(xiàn)隨著推理深度的增加,SymbCoT 相對于 CoT 的改進(jìn)變得更加明顯,表明 SymbCoT 在處理更復(fù)雜問題上的優(yōu)勢。

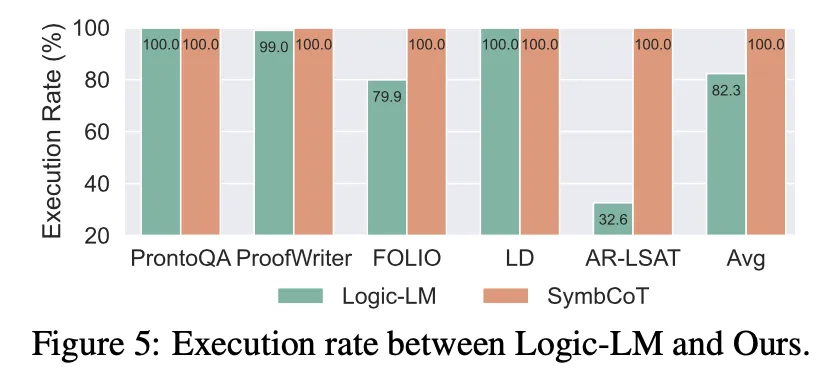

- 魯棒性:

作者比較了完全基于 LLM 的推理器與依賴外部解析器的方法(如 Logic-LM)在執(zhí)行符號表達(dá)式語法時的成功率,發(fā)現(xiàn) SymbCoT 在語法執(zhí)行上的成功率顯著提高,展示了對語法錯誤的顯著魯棒性。

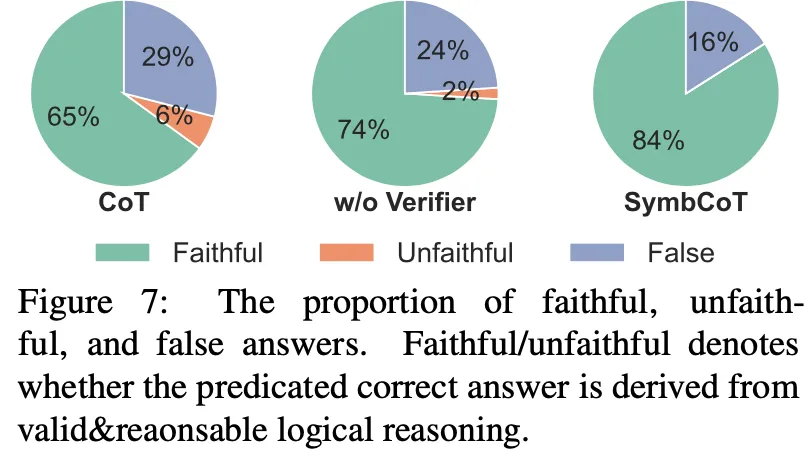

- 可信的邏輯推理:

傳統(tǒng) CoT 在邏輯推理的時候有時候會基于錯誤的推理過程得到正確的答案,這種情況會誤導(dǎo)使用者從而造成不好的后果。SymbCoT 基于嚴(yán)密邏輯推理與驗證,有效消除了傳統(tǒng) CoT 中過程不可信的缺陷。

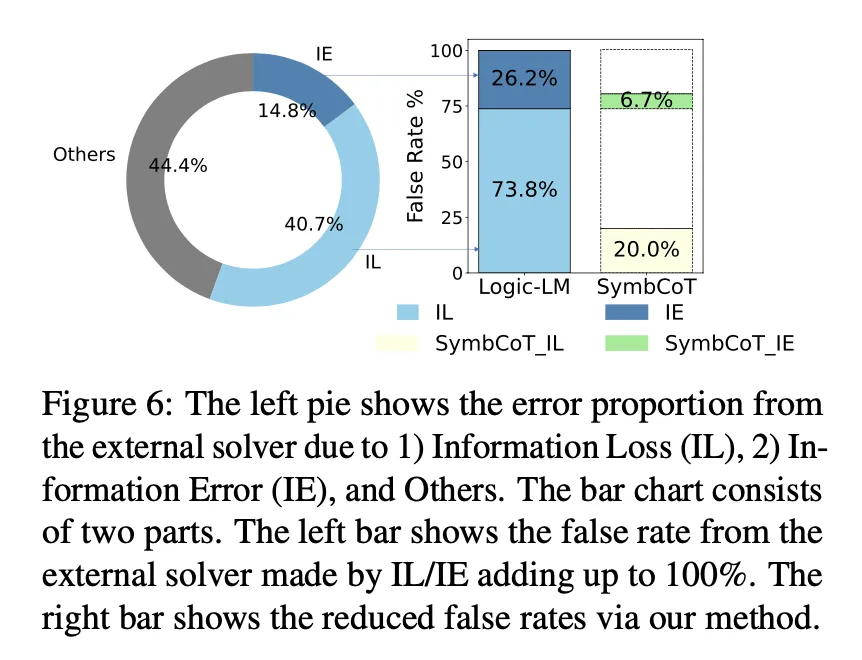

- 符號與自然語言混合表達(dá)的優(yōu)勢:

作者分析了 LLM 從自然語言到符號語言的轉(zhuǎn)換過程中可能遺漏的關(guān)鍵信息或引入的不準(zhǔn)確性,發(fā)現(xiàn) SymbCoT 通過結(jié)合符號和自然語言表達(dá)來糾正翻譯錯誤并增強邏輯推理的有效性。

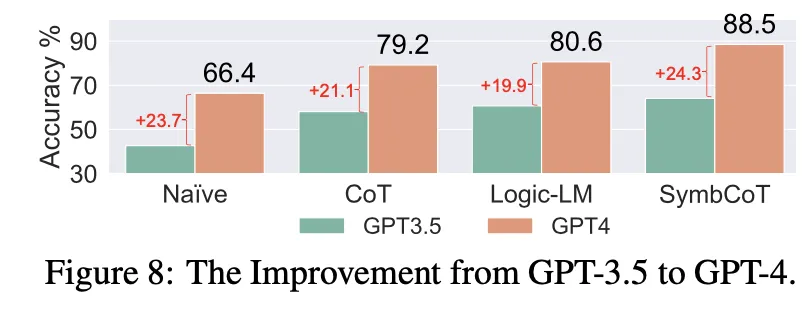

- 不同 LLM 的影響:

作者還比較了 GPT-3.5 和 GPT-4 在三個 FOL 數(shù)據(jù)集上的表現(xiàn),發(fā)現(xiàn)在升級模型后,SymbCoT 方法的性能提升最為顯著,強調(diào)了 SymbCoT 方法與更先進(jìn)模型之間的協(xié)同效應(yīng)。

總體來說,SymbCoT 是一個更準(zhǔn)確、更可信且更魯棒的邏輯推理框架,適合用于要求復(fù)雜且精確的邏輯推理任務(wù)。

本文轉(zhuǎn)自 機器之心 ,作者:機器之心