突破大語言模型的邏輯瓶頸:Logic-of-Thought方法讓LLM更懂"推理" | 用外部數據增強大語言模型:RAG全面解

親愛的讀者,感謝您閱讀到這里。正如我們探討的語言模型一樣,每個人都有自己的潛力和價值。認清自己,要么接受平凡,要么踏踏實實從 0 到 1 去積累資源。這世上從來沒有簡單的、一蹴而就的成功。無論是AI的發展還是個人的成長,都需要持續不斷的努力和積累。如果您也對科技、人工智能和個人發展感興趣,歡迎關注我們的微信公眾號"AI帝國"。在這里,我們將為您揭示AI世界的帝國格局,帶來最前沿的技術洞察和行業趨勢,助您在這個AI驅動的時代中找準定位,開拓屬于自己的疆土。讓我們攜手探索AI的無限疆界,在這個充滿機遇與挑戰的帝國中,共同成長,共創輝煌!

大模型領域的發展日新月異,每天都有許多有趣的論文值得深入品讀。下面是本期覺得比較有意思的論文:

1、突破大語言模型的邏輯瓶頸:Logic-of-Thought方法讓LLM更懂"推理"

2、用外部數據增強大語言模型:RAG及其他技術的全面解析

1、突破大語言模型的邏輯瓶頸:Logic-of-Thought方法讓LLM更懂"推理"

論文標題:Logic-of-Thought: Injecting Logic into Contexts for Full Reasoning in Large Language Models

論文鏈接:https://arxiv.org/abs/2409.17539

近年來,大語言模型(LLMs)在自然語言處理領域取得了令人矚目的成就。然而,在數學和復雜邏輯推理任務中,即使是最先進的LLMs也表現出明顯的局限性。為了解決這一問題,研究人員提出了一種名為Logic-of-Thought (LoT)的創新方法,旨在提升AI的邏輯推理能力。

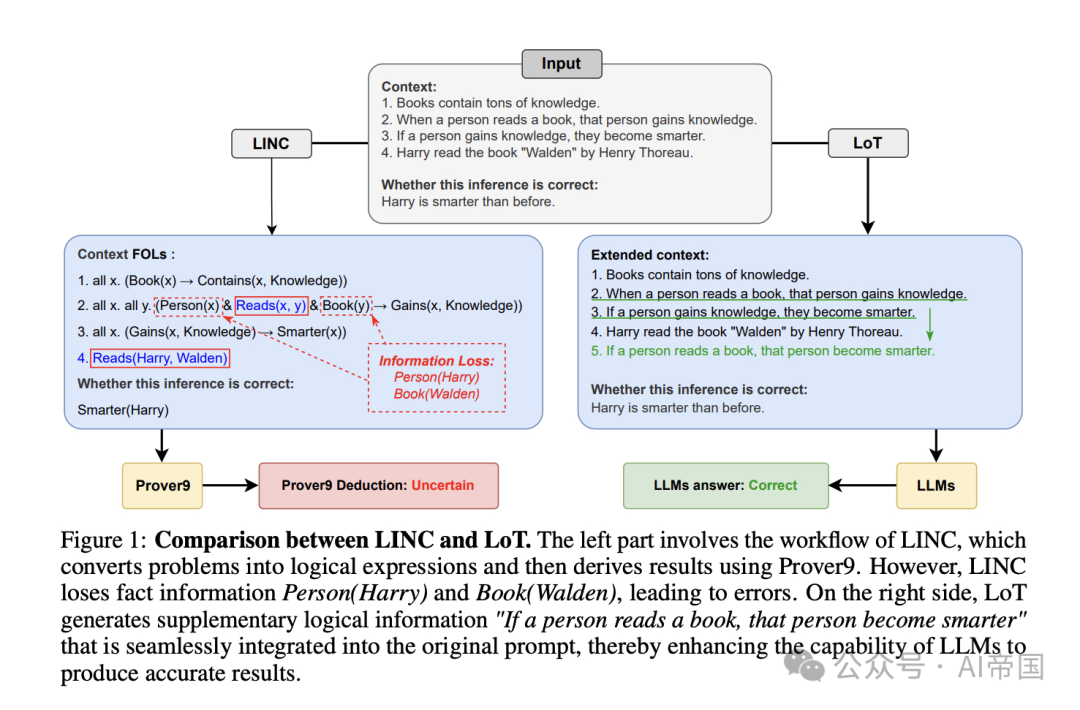

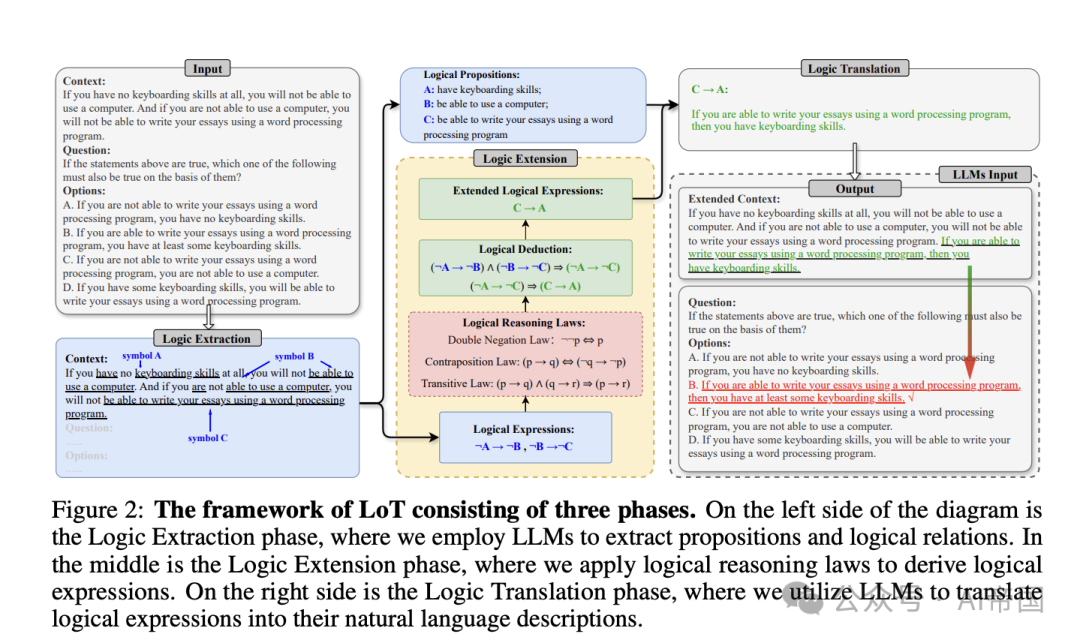

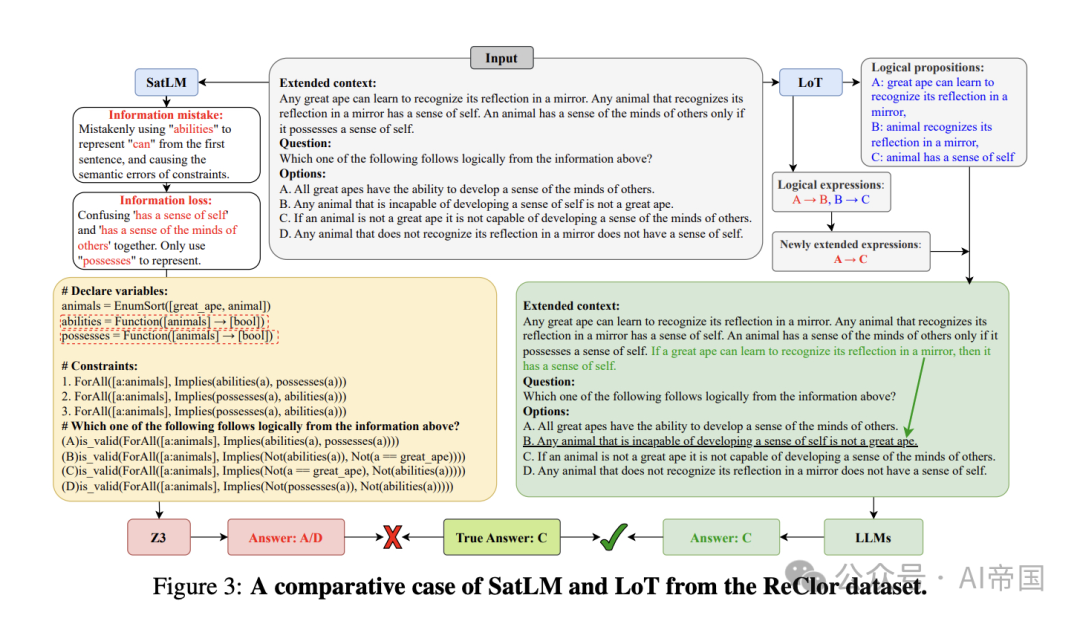

LoT的核心思想是在不改變原始輸入的基礎上,通過提取邏輯表達式并將其擴展回自然語言描述,為LLMs提供額外的邏輯信息指導。這種方法巧妙地避免了現有神經符號方法中常見的信息丟失問題,同時保持了與其他提示方法(如Chain-of-Thought、Self-Consistency等)的兼容性。

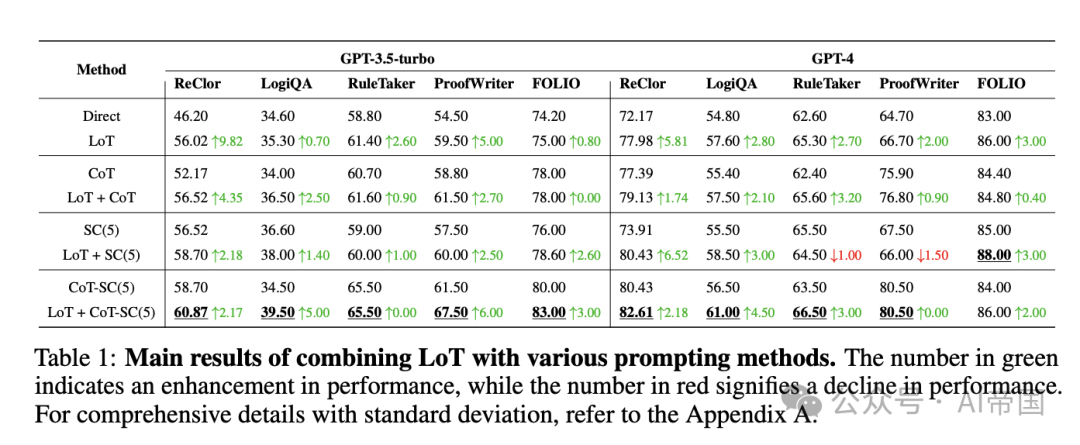

實驗結果令人振奮:在多個邏輯推理數據集上,LoT顯著提升了各種提示方法的性能。例如,在ReClor數據集上,LoT使Chain-of-Thought的準確率提高了4.35%,Self-Consistency的準確率更是提升了驚人的6.52%。在ProofWriter數據集上,結合Tree-of-Thoughts方法的準確率提高了8%。

這項研究不僅為提升AI的邏輯推理能力開辟了新的途徑,也為解決大語言模型在復雜任務中的局限性提供了寶貴的思路。隨著LoT方法的進一步發展和應用,我們有理由期待未來的AI系統將在處理需要嚴謹邏輯思維的任務時展現出更接近人類的智能水平。

2、用外部數據增強大語言模型:RAG及其他技術的全面解析

論文標題:Retrieval Augmented Generation (RAG) and Beyond: A Comprehensive Survey on How to Make your LLMs use External Data More Wisely

?論文鏈接:??https://arxiv.org/abs/2409.14924??

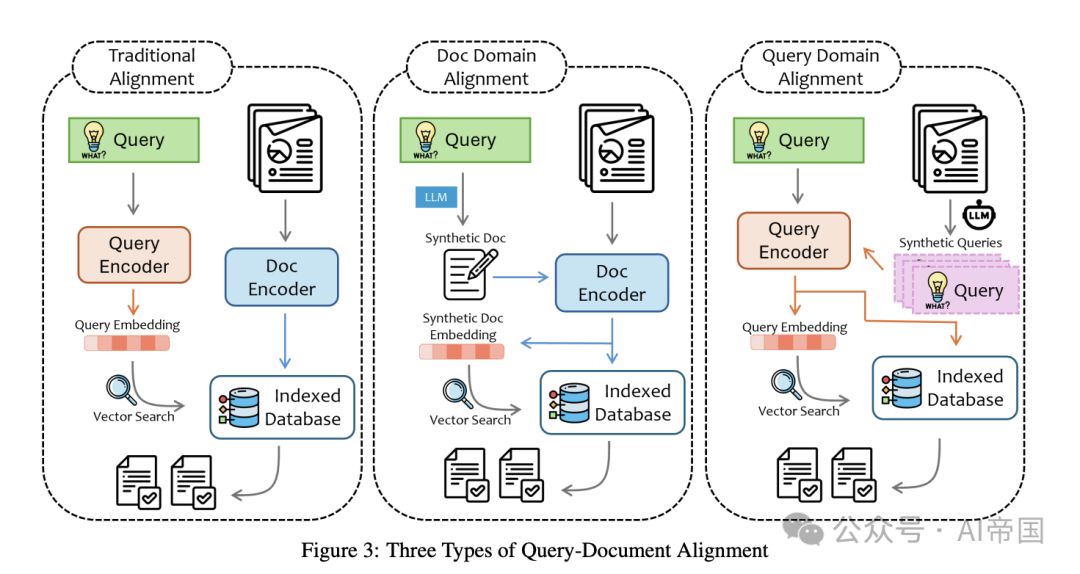

LLMs雖然擁有驚人的能力,但在專業領域應用時仍面臨諸多挑戰,如幻覺、知識偏差等。為解決這些問題,研究者提出了檢索增強生成(RAG)等數據增強技術,旨在讓LLMs更智慧地利用外部數據。這篇綜述全面探討了如何讓LLMs更有效地利用外部數據,以提升其在專業領域的應用效果。

數據增強LLM應用相比傳統LLM有顯著優勢:提高專業性和時效性、與領域專家知識對齊、減少幻覺、提升可控性和可解釋性。然而,開發者在實踐中仍面臨諸多挑戰,如數據處理、復雜推理、理解多模態數據等。本文深入分析了不同應用場景的獨特需求和難點,強調數據增強LLM應用并非一刀切的解決方案。

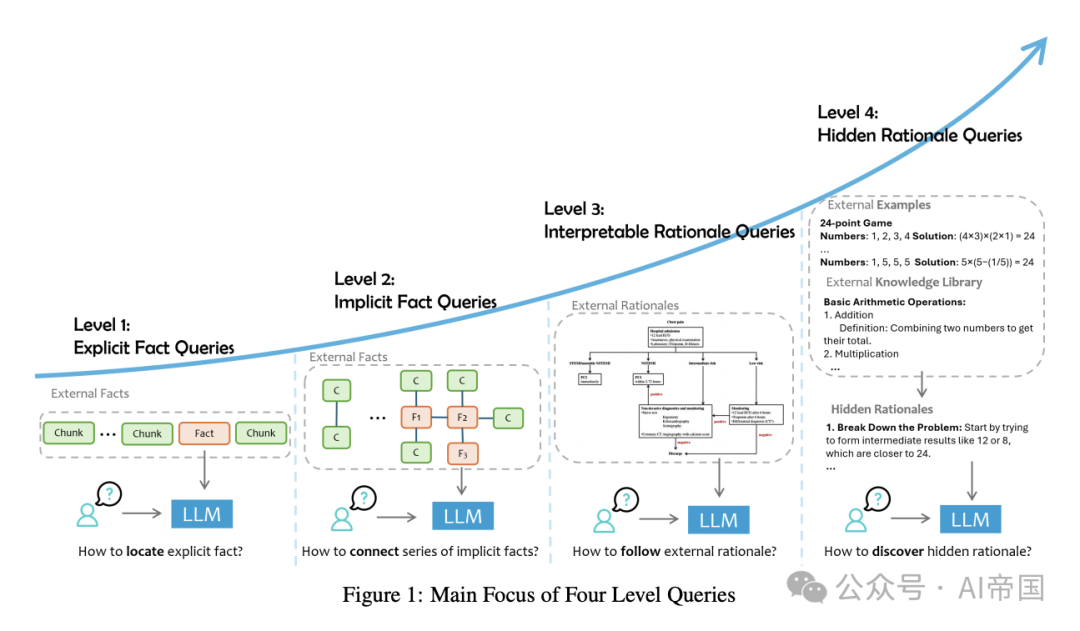

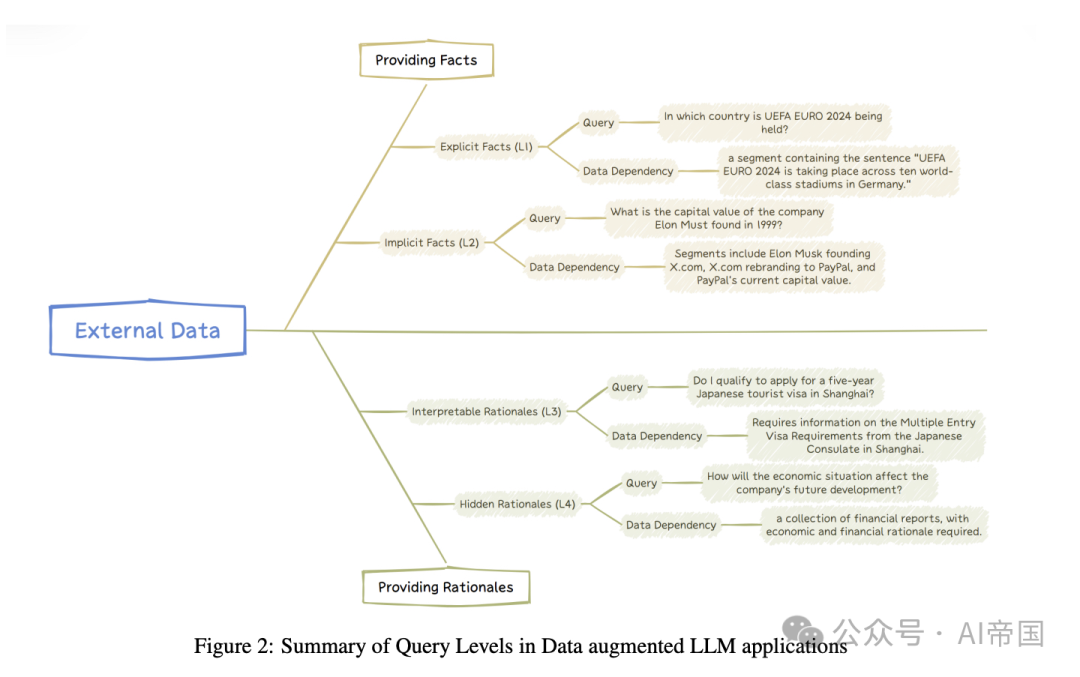

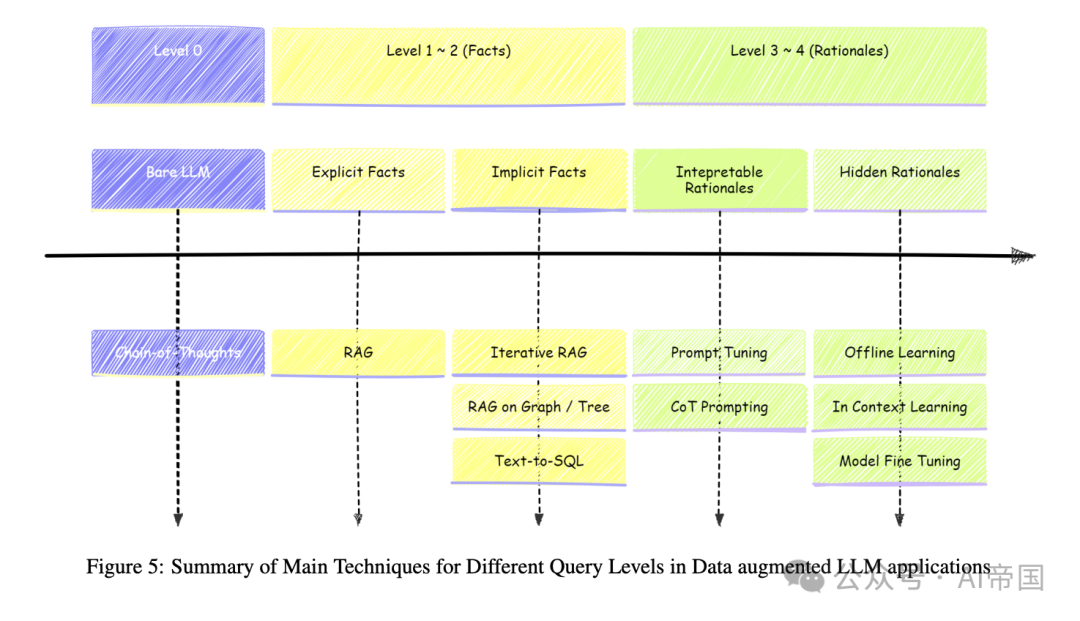

這篇綜述的獨特之處在于它提供了一個全面的框架,幫助讀者構建數據增強LLM應用的全局視角。文章不僅定義了不同層次的查詢需求,還識別了每個層次的獨特挑戰,并列舉了相關的研究工作。這為開發者提供了一個系統性的指南,幫助他們更有效地構建和改進數據增強LLM應用。

對于希望深入了解如何讓AI更智能地利用外部數據的研究者和開發者來說,這篇綜述無疑是一份寶貴的資源。它不僅概述了當前技術的現狀,還為未來的研究和應用指明了方向,有望推動LLMs在各個專業領域的更廣泛應用。

本文轉載自 ??AI帝國??,作者: 無影寺