支持合成一分鐘高清視頻,華科等提出人類跳舞視頻生成新框架UniAnimate 精華

人類跳舞視頻生成是一項引人注目且具有挑戰性的可控視頻合成任務,旨在根據輸入的參考圖像和目標姿勢序列生成高質量逼真的連續視頻。隨著視頻生成技術的快速發展,特別是生成模型的迭代演化,跳舞視頻生成任務取得了前所未有的進展,并展示了廣泛的應用潛力。

現有的方法可以大致分為兩組。第一組通常基于生成對抗網絡(GAN),其利用中間的姿勢引導表示來扭曲參考外觀,并通過之前扭曲的目標生成合理的視頻幀。然而,基于生成對抗網絡的方法通常存在訓練不穩定和泛化能力差的問題,導致明顯的偽影和幀間抖動。

第二組則使用擴散模型(Diffusion model)來合成逼真的視頻。這些方法兼具穩定訓練和強大遷移能力的優勢,相較于基于 GAN 的方法表現更好,典型方法如 Disco、MagicAnimate、Animate Anyone、Champ 等。

盡管基于擴散模型的方法取得了顯著進展,但現有的方法仍存在兩個限制:一是需要額外的參考網絡(ReferenceNet)來編碼參考圖像特征并將其與 3D-UNet 的主干分支進行表觀對齊,導致增加了訓練難度和模型參數;二是它們通常采用時序 Transformer 來建模視頻幀之間時序依賴關系,但 Transformer 的復雜度隨生成的時間長度成二次方的計算關系,限制了生成視頻的時序長度。典型方法只能生成 24 幀視頻,限制了實際部署的可能性。盡管采用了時序重合的滑動窗口策略可以生成更長的視頻,但團隊作者發現這種方式容易導致片段重合連接處通常存在不流暢的轉換和外貌不一致性的問題。

為了解決這些問題,來自華中科技大學、阿里巴巴、中國科學技術大學的研究團隊提出了 UniAnimate 框架,以實現高效且長時間的人類視頻生成。

- 論文地址:https://arxiv.org/abs/2406.01188

- 項目主頁:https://unianimate.github.io/

方法簡介

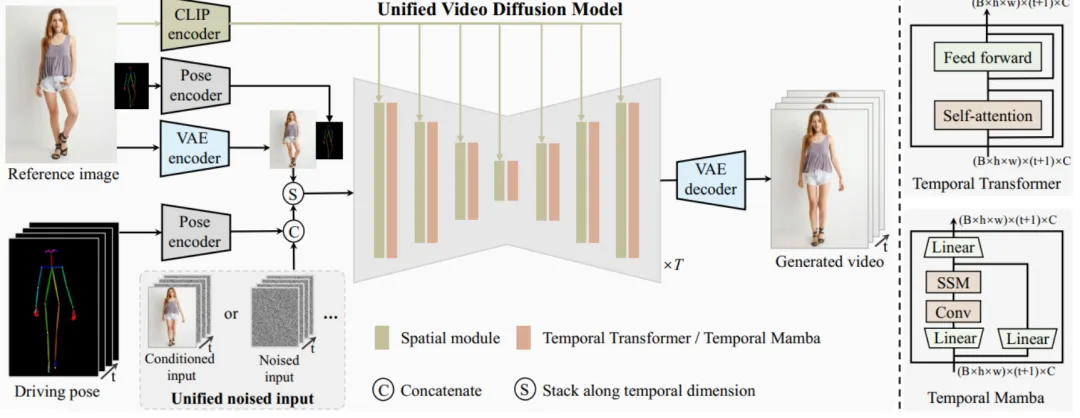

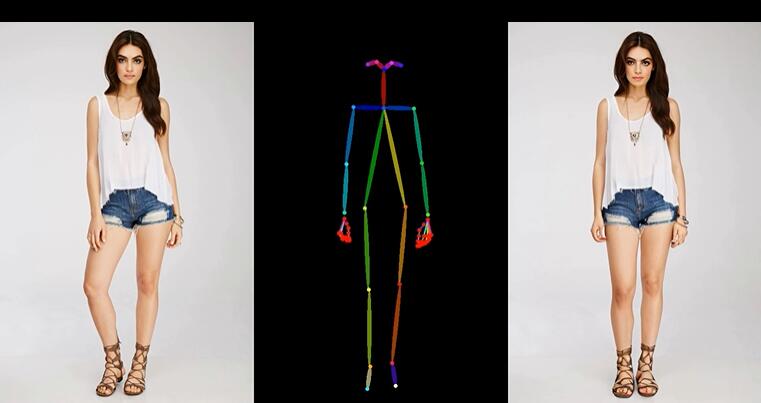

UniAnimate 框架首先將參考圖像、姿勢指導和噪聲視頻映射到特征空間中,然后利用統一的視頻擴散模型(Unified Video Diffusion Model)同時處理參考圖像與視頻主干分支表觀對齊和視頻去噪任務,實現高效特征對齊和連貫的視頻生成。

其次,研究團隊還提出了一種統一的噪聲輸入,其支持隨機噪聲輸入和基于第一幀的條件噪聲輸入,隨機噪聲輸入可以配合參考圖像和姿態序列生成一段視頻,而基于第一幀的條件噪聲輸入(First Frame Conditioning)則以視頻第一幀作為條件輸入延續生成后續的視頻。通過這種方式,推理時可以通過把前一個視頻片段(segment)的最后一幀當作后一個片段的第一幀來進行生成,并以此類推在一個框架中實現長視頻生成。

最后,為了進一步高效處理長序列,研究團隊探索了基于狀態空間模型(Mamba)的時間建模架構,作為原始的計算密集型時序 Transformer 的一種替代。實驗發現基于時序 Mamba 的架構可以取得和時序 Transformer 類似的效果,但是需要的顯存開銷更小。

通過 UniAnimate 框架,用戶可以生成高質量的時序連續人類跳舞視頻。值得一提的是,通過多次使用 First Frame Conditioning 策略,可以生成持續一分鐘的高清視頻。與傳統方法相比,UniAnimate 具有以下優勢:

- 無需額外的參考網絡:UniAnimate 框架通過統一的視頻擴散模型,消除了對額外參考網絡的依賴,降低了訓練難度和模型參數的數量。

- 引入了參考圖像的姿態圖作為額外的參考條件,促進網絡學習參考姿態和目標姿態之間的對應關系,實現良好的表觀對齊。

- 統一框架內生成長序列視頻:通過增加統一的噪聲輸入,UniAnimate 能夠在一個框架內生成長時間的視頻,不再受到傳統方法的時間限制。

- 具備高度一致性:UniAnimate 框架通過迭代利用第一幀作為條件生成后續幀的策略,保證了生成視頻的平滑過渡效果,使得視頻在外觀上更加一致和連貫。這一策略也使得用戶可以生成多個視頻片段,并選取生成結果好的片段的最后一幀作為下一個生成片段的第一幀,方便了用戶與模型交互和按需調整生成結果。而利用之前時序重合的滑動窗口策略生成長視頻,則無法進行分段選擇,因為每一段視頻在每一步擴散過程中都相互耦合。

以上這些特點使得 UniAnimate 框架在合成高質量、長時間的人類跳舞視頻方面表現出色,為實現更廣泛的應用提供了新的可能性。

生成結果示例

1. 基于合成圖片進行跳舞視頻生成。

2. 基于真實圖片進行跳舞視頻生成。

3. 基于粘土風格圖片進行跳舞視頻生成。

4. 馬斯克跳舞。

5. Yann LeCun 跳舞。

6. 基于其他跨域圖片進行跳舞視頻生成。

7. 一分鐘跳舞視頻生成。

獲取原始 MP4 視頻和更多高清視頻示例請參考論文的項目主頁 ???https://unianimate.github.io/??。

實驗對比分析

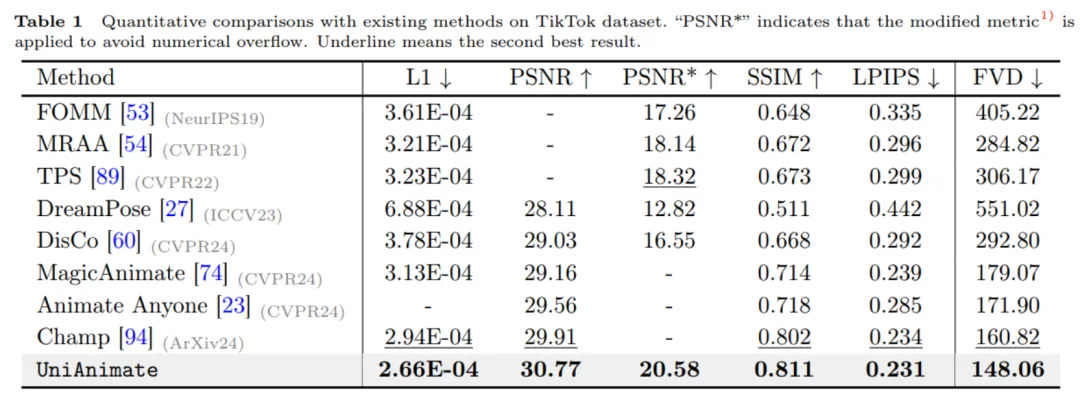

1. 和現有方法在 TikTok 數據集上的定量對比實驗。

如上表所示,UniAnimate 方法在圖片指標如 L1、PSNR、SSIM、LPIPS 上和視頻指標 FVD 上都取得了最好的結果,說明了 UniAnimate 可以生成高保真的結果。

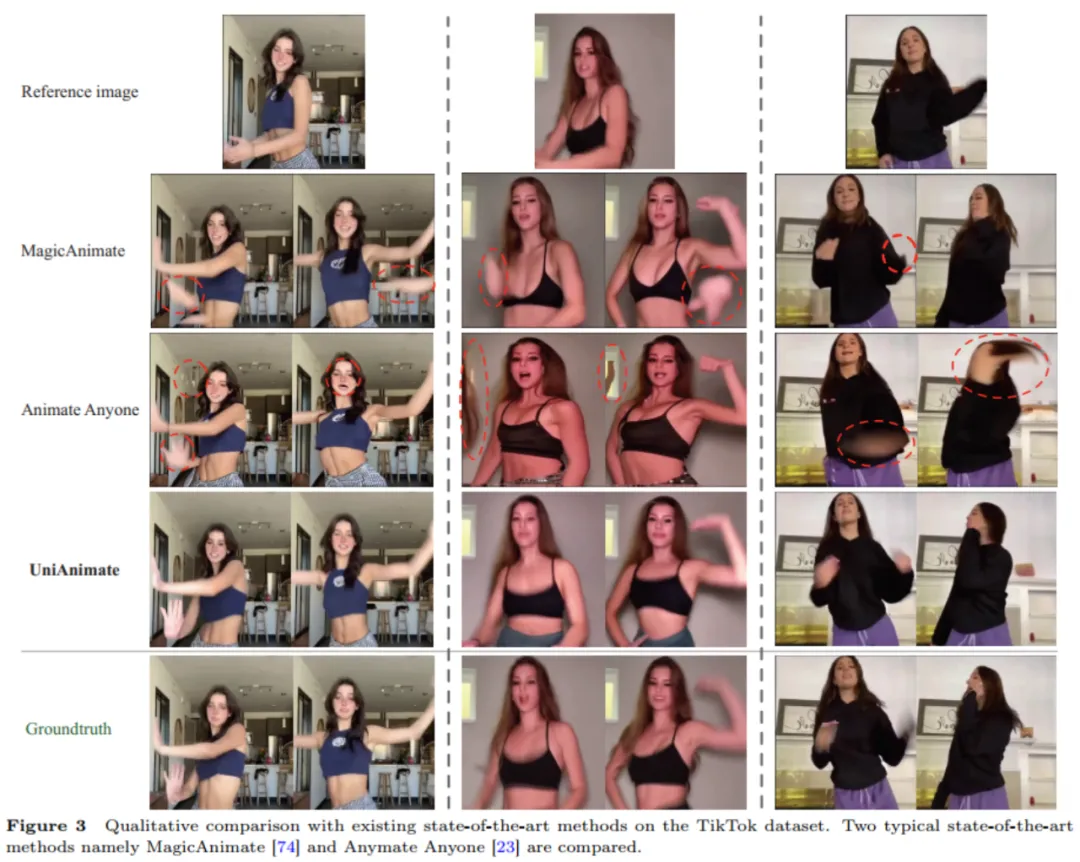

2. 和現有方法的定性對比實驗。

從上述定性對比實驗也可以看出,相比于 MagicAnimate、Animate Anyone, UniAnimate 方法可以生成更好的連續結果,沒有出現明顯的 artifacts,表明了 UniAnimate 的有效性。

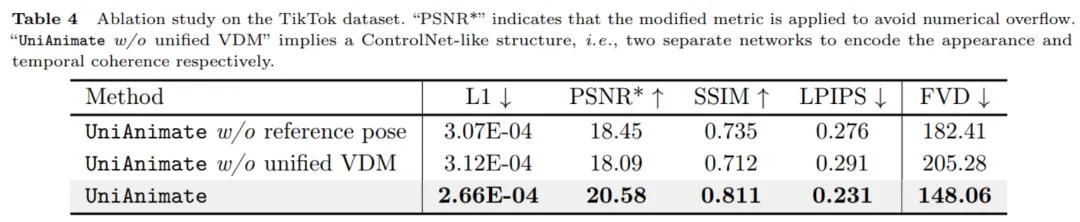

3. 剝離實驗。

從上表的數值結果可以看出,UniAnimate 中用到的參考姿態和統一視頻擴散模型對性能提升起到了很關鍵的作用。

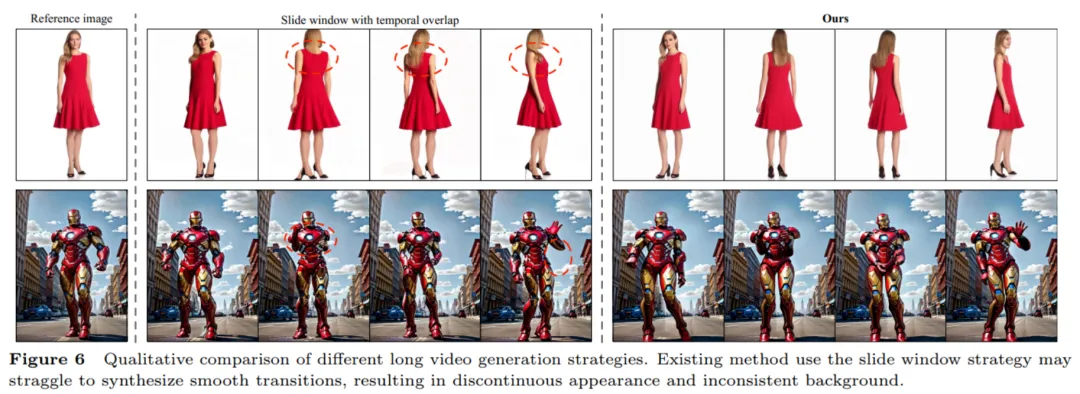

4. 長視頻生成策略對比。

從上圖可以看出之前常用的時序重合滑動窗口策略生成長視頻容易導致不連續的過渡,研究團隊認為這是因為不同窗口在時序重合部分去噪難度不一致,使得生成結果不同,而直接平均會導致有明顯的變形或者扭曲等情況發生,并且這種不一致會進行錯誤傳播。而本文利用的首幀視頻延續生成方法則可以生成平滑的過渡。

更多的實驗對比結果和分析可以參考原論文。

總而言之,UniAnimate 的示例結果表現和定量對比結果很不錯,期待 UniAnimate 在各個領域的應用,如影視制作、虛擬現實和游戲產業等,為用戶帶來更為逼真、精彩的人類形象動畫體驗。

本文轉自 機器之心 ,作者:機器之心