OCR小模型仍有機會!華科等提出VIMTS:零樣本視頻端到端識別新SOTA

文本端到端識別是一項從圖像或視頻序列中提取文本信息的任務,雖然取得了一些進展,但跨領域文本端到端識別仍然是一個難題,面臨著圖像到圖像和圖像到視頻泛化等跨域自適應的挑戰。

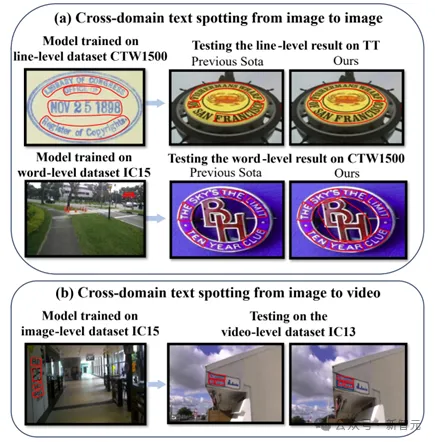

圖1 圖(a)和圖(b)是兩種跨域文本端到端識別,包括圖像到圖像和圖像到視頻。TT表示TotalText,IC15代表ICDAR2015,IC13代表視頻ICDAR2013。

圖像級跨域文本端到端識別面臨樣式、字體、背景等差異挑戰,模型需要具備極強的泛化能力。

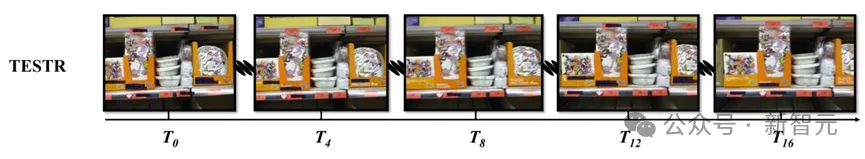

不同數據集間的格式差異也是跨域文本端到端識別重要的問題,如Total-Text和ICDAR2015使用詞級注釋,CTW1500使用行級注釋。視頻級跨域文本端到端識別中,由于視頻文本中存在著如遮擋、場景變化和文本快速運動等因素,現有靜態圖像的方法在視頻環境通常表現不佳,如圖2所示。

圖2 將靜態文本識別方法應用于視頻,即使是那些運動最小的視頻,也會導致邊界框召回和識別準確性方面的性能不足。T_n表示視頻的第n_th幀。

另外,視頻文本端到端識別中非常缺乏數據。一些研究者嘗試使用光流估計進行數據合成,但這種方法存在扭曲、標簽錯誤和偏見等挑戰,且無開源合成數據供公眾使用。

針對上述問題,華中科技大學、華南理工大學及浙江大學的研究人員提出了一種新的方法VimTS,通過實現不同任務之間更好的協同來增強模型的泛化能力,包括一個提示查詢生成模塊和一個任務感知適配器,僅使用較少參數便可有效地將原始的單任務模型轉換為適合圖像和視頻場景的多任務模型。

論文鏈接:https://arxiv.org/pdf/2404.19652

代碼地址:https://vimtextspotter.github.io

提示查詢生成模塊促進不同任務之間的顯式交互,而任務感知適配器幫助模型動態地學習適合每個任務的特性。

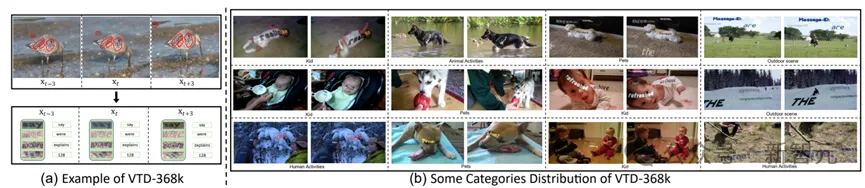

此外,為了進一步使模型能夠以更低的成本學習時間信息,研究人員提出了一個利用內容變形場(CoDeF)算法的合成視頻文本數據集(VTD-368k)。

實驗結果顯示,該方法在六個跨域基準測試(如TT-to-IC15、CTW1500-to-TT和TT-to-CTW1500)中比最先進的方法平均高出2.6%

對于視頻級跨域自適應,該方法甚至超過了ICDAR2015視頻和DSText v2中之前的端到端視頻識別方法,在MOTA指標上平均高出5.5 %,僅使用圖像級數據。

通過進一步實驗證明,與文中提出的VimTS模型相比,現有的大型多模態模型在生成跨域場景文本識別方面存在局限性,Vim模型需要的參數和數據要少得多。

方法原理簡述

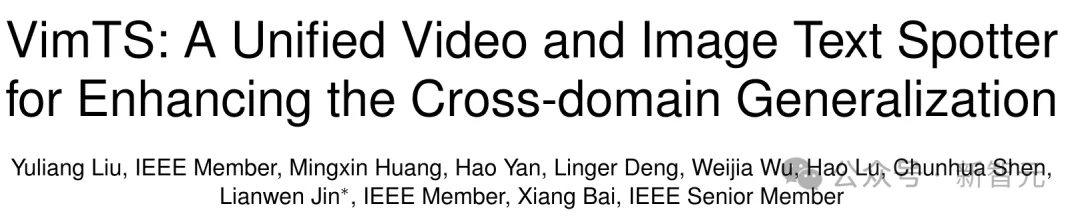

圖3 網絡整體框架圖

總體結構

VimTS是一個旨在利用各種任務之間的協同作用的統一框架,以提高文本端到端識別的泛化能力,其整體架構如圖3所示,使用一組任務感知查詢表示各種任務。

首先,通過特征提取過程獲得圖像特征。

然后,使用Query Initialization模塊生成任務感知查詢,包括檢測和識別查詢。

隨后,這些查詢被饋送到任務感知解碼器中,以顯式捕獲判別和交互特性,同時進行文本檢測、識別和跟蹤。

接著,使用提示查詢生成模塊(PQGM)和任務感知適配器實現分層任務之間的交互,包括單詞級和行級文本端到端識別,以及視頻級文本端到端識別。

在訓練階段,大多數參數被凍結。然后,任務感知適配器和PQGM學習多任務特性。首先,將要執行的任務提示輸入到PQGM中。

然后,PQGM生成提示查詢,并將其發送給Transformer編碼器和任務感知解碼器,以指導模型完成相應的任務。

我們的方法不僅適用于圖像級的跨域,還可以學習視頻級的跨域自適應。

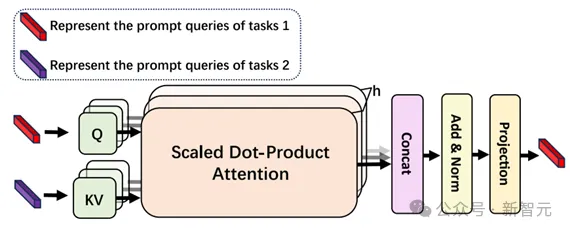

提示查詢生成模塊

為了提高模型處理多任務的能力,我們引入了提示查詢生成模塊(PQGM),用于生成指導模型運行的提示查詢。該模塊的結構如圖4所示。

圖4 提示查詢生成模塊

我們使用可學習的嵌入作為每個任務的提示查詢,其維度與Transformer隱藏特征的維度相匹配。在將這些提示查詢輸入模型之前,我們使用注意機制促進不同任務之間的信息交換。隨后,我們將提示查詢輸入模型,以指導其學習特定于任務的特征。使用PQGM,VimTS可以同時處理多個任務,并促進它們之間的顯式交互,從而促進不同任務之間的協同作用。

在交互之后,我們將提示查詢傳輸到Transformer編碼器,使其能夠學習任務特定的特性。然后,利用這些特性來協助查詢初始化,并指導解碼器輸出相應任務的結果。

為了進一步增強對任務特定特性的學習,我們將提示查詢與任務感知查詢集成在一起。我們通過向任務感知查詢添加提示查詢來實現這種融合,從而引導模型更有效地完成相應的任務。

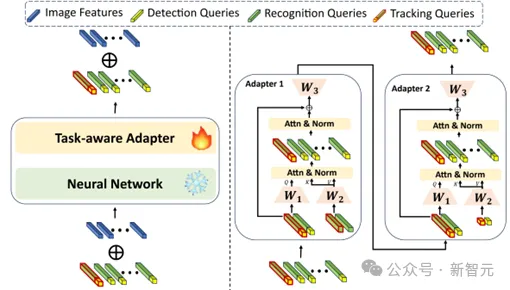

任務感知適配器

受Adapter的啟發,我們提出了一個任務感知適配器來動態地為不同的任務選擇合適的特性。帶有PQGM的任務感知適配器有效地將原始的單任務模型轉換為適合圖像和視頻場景的多任務模型,所需的額外參數最少。

任務感知適配器采用級聯適配器結構,其中一個適配器編碼檢測信息,另一個適配器編碼識別信息。

為了實現這一點,我們首先凍結預訓練文本觀測者的大多數參數。接下來,我們將適配器集成到神經網絡中,例如一個Transformer層。

在多任務訓練過程中,適配器學習不同任務的特征。值得注意的是,任務感知適配器不僅可以應用于圖像級場景,還可以學習時間信息,從而幫助預訓練模型過渡到涉及視頻文本端到端識別的任務。

總體結構如圖5所示。

圖5 任務感知適配器結構圖

最初,我們使用兩個線性層將組查詢的維數降為原本的四分之一,從而降低了后續模塊的參數。然后,任務感知查詢通過注意機制聚合檢測信息。

在對檢測特征進行聚合后,對圖像級文本端到端識別采用注意機制學習不同文本實例之間的關系,對視頻級文本端到端識別采用注意機制對時間信息進行建模。

第二個適配器遵循類似的過程,但側重于聚合識別信息。使用任務感知適配器,可以有效地學習交互和判別特征,所需的額外參數最少。

跟蹤查詢

受MOTR啟發,我們采用跟蹤查詢使模型支持文本跟蹤,從而使VimTS能夠動態適應圖像和視頻等不同輸入。

由于同一文本實例在前后幀之間表現出很強的相關性,我們利用前一幀的檢測和識別查詢作為跟蹤查詢,對當前幀中的文本實例進行定位、識別和跟蹤。對于新生文本實例,我們繼續使用檢測和識別查詢來定位和識別。

不同的查詢在單個解碼器中顯式地建模不同任務的判別和交互特征,并同時輸出檢測、識別和跟蹤結果。

相比之前的視頻文本端到端識別方法,我們的方法通過統一框架和組合查詢,在跟蹤過程中更有效地利用不同幀的識別信息。這樣,我們可以利用前一幀的識別信息來幫助后一幀中的文本實例識別,實現之前方法無法做到的效果。

視頻數據合成方法

視頻文本識別數據是非常昂貴的。BOVText報告說,注釋2,021個視頻需要30名工作人員在三個月的時間內全力以赴。

此外,數據集版權也僅限于視頻文本端到端識別數據的大規模構建。因此,采用低成本的合成數據是緩解視頻文本識別模型數據需求的有效方法。數據合成的一個解決方案是使用光流估計,但它帶來了幾個挑戰,包括失真、標記錯誤和對靜態對象的偏見。

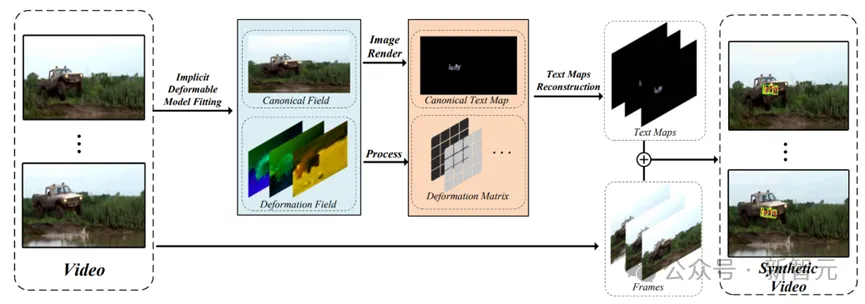

為了應對這些挑戰,我們引入了一種新的方法,該方法利用CoDeF來促進實現真實和穩定的文本流傳播,以構建合成視頻文本數據集。

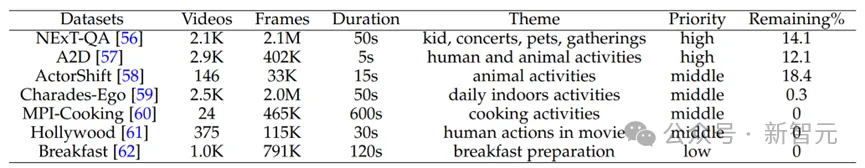

我們從NExT-QA, Charades-Ego, Breakfast, A2D, MPI-Cooking, ActorShif和Hollywood手動收集和過濾無文本,開源和無限制的視頻。

然后,我們將它們按優先順序排列,這是由過渡的穩定性,高分辨率和視頻中廣泛的平面區域的流行所決定的。每個數據集的統計信息顯示在表1。

為了實現分布式處理和減少GPU內存,我們將視頻分成包含368K幀的片段進行數據合成。合成數據稱為VTD-368K。

表1 VTD-368k的源視頻數據集統計。時長表示視頻的平均時長。Remaining表示所選幀的比例

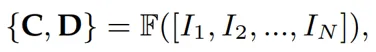

在介紹合成方法以前,我們先簡單介紹一下CoDef。CoDeF是使用扁平規范圖像C和變形場D表示由幀

組成的視頻V的有效方法。總體過程可以秒速為:

式中, 為隱式模型的擬合過程。通過使用ControlNet、SAM或R-ESRGAN等特定的工具,將規范圖像C轉換為C',并將此轉換與變形場 同時集成,可以實現視頻風格轉換、視頻對象跟蹤和視頻超分辨率。視頻V’的重構過程可表述為

式中,C為隱式模型的重構過程,V′為重構后的視頻。

我們提出了一種新的合成方法。具體如圖6所示,我們首先使用SAM-Track和RAFT分別獲得所有幀的光流圖和分割圖。然后,CoDeF用于有效地重建視頻中的剛性和非剛性對象,同時精心恢復運動細節的微妙復雜性。

經CoDeF處理后,輸入視頻被表示為規范圖像C和變形場D

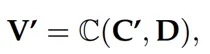

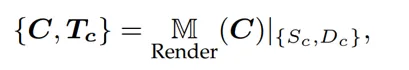

其中,C作為通過Synthtext放置文本的基礎,而D封裝了從觀察到每個幀的規范化表示的轉換。隨后,可以生成嵌入文本地圖Tc,如下所示:

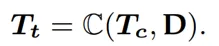

式中,Sc和Dc分別為規范圖像 的分割圖和深度圖。然后,將Tc作為公式五的輸入,與D結合,重構視頻文本映射Tt,使用下式:

訓練的隱式可變形模型生成文本幾何形狀,但不保留其共線性和筆畫順序。為了解決這一問題,在隱式可變形模型重建后引入了投影變換。具體來說,我們收集一組點對(pc, pt)

其中pc是規范圖像中形成文本幾何圖形的點,pt是它們在重構幀中的對應點。然后,我們用RANSAC估計投影矩陣H_{c, t}以魯棒擬合這些點對。

最后,我們應用該投影矩陣來轉換文本映射中的每個文本幾何形狀。

圖6 基于CoDef的合成方法總體框架。

圖7 合成數據的樣例。

主要實驗結果及可視化結果

圖片級別跨域端到端識別的實驗結果

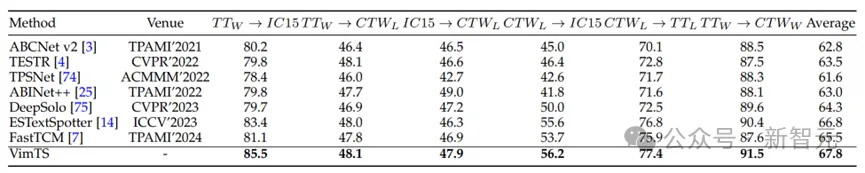

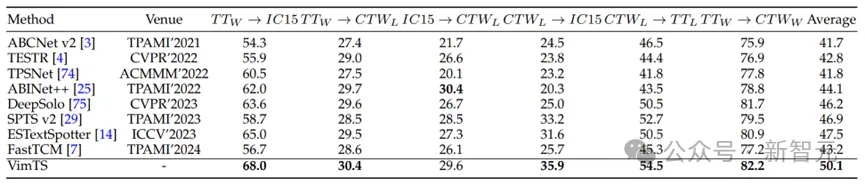

為了更好的評估我們方法的有效性,我們對TotalText和CTW1500進行了新的標注。對TotalText的測試集重標注行級別文本的標注。對CTW1500的測試集重標注單詞級別文本的標注。

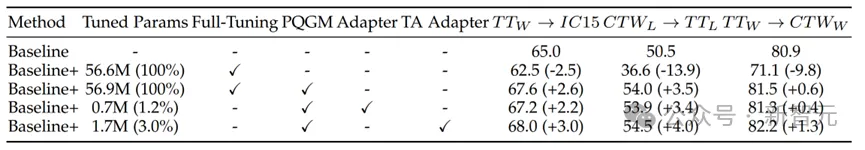

表2 跨域文本檢測的性能。 表示單詞級別的TotalText。 表示行級TotalText。 表示字級CTW1500。 表示行級CTW1500。加粗表示SOTA。

表3 跨域文本端到端識別的性能。

消融實驗

表4 消融實驗結果

在場景文本識別方法上進行了實景自適應測試。表中接結果是端到端識別在“None”字典下的結果。Full-Tuning表示對模型的所有參數進行調優。PQGM表示提示查詢生成模塊。

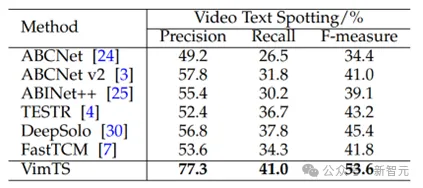

視頻級別跨域端到端識別的實驗結果

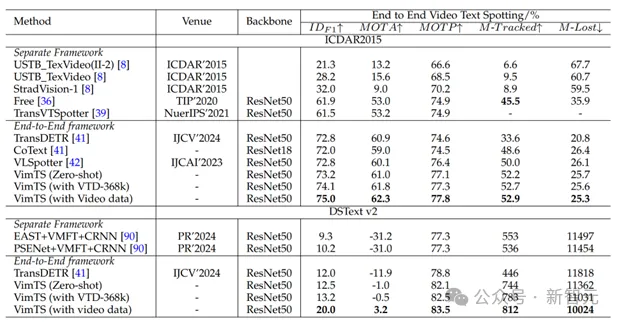

表5 視頻文本識別結果,' M-Tracked '和' M-Lost '分別表示' most Tracked '和' most Lost '。

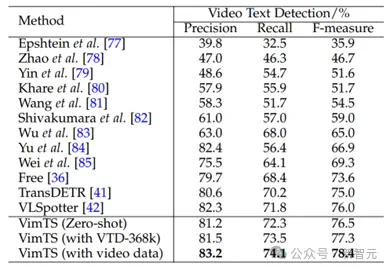

表6 在ICDAR2013上的視頻文本檢測結果。

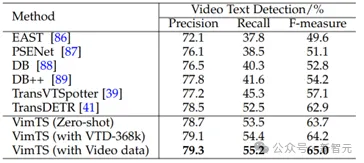

表7 在DSText v2上的視頻文本檢測結果。

表8 在ICDAR2013上零樣本視頻端到端識別的結果。所有方法都使用相同的圖片級別的訓練集,并對視頻的每一幀評估端到端識別的結果。

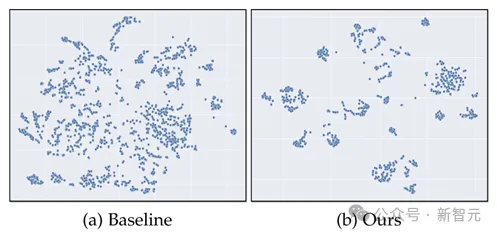

圖8 通過t-SNE在不同幀中文本實例的分布。

可以看出,在本文提出的方法中,同一文本在不同幀間的特征相似度更高。因此,在我們的方法中,使用前一幀的特征作為當前幀的輸入查詢,即使只使用圖像級訓練數據,也可以有效地定位、識別和跟蹤相同的文本實例。

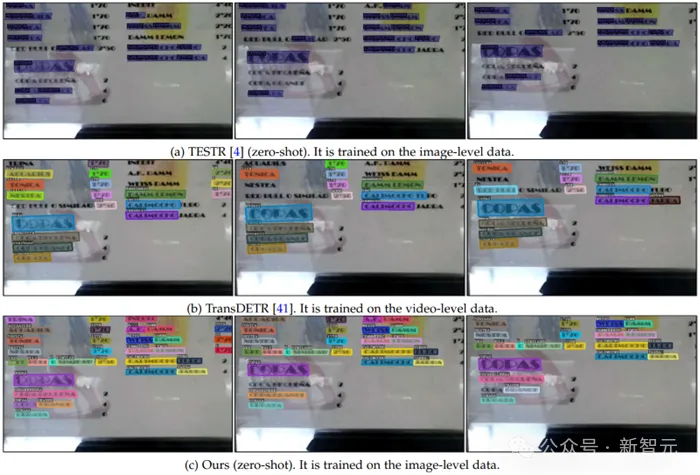

可視化

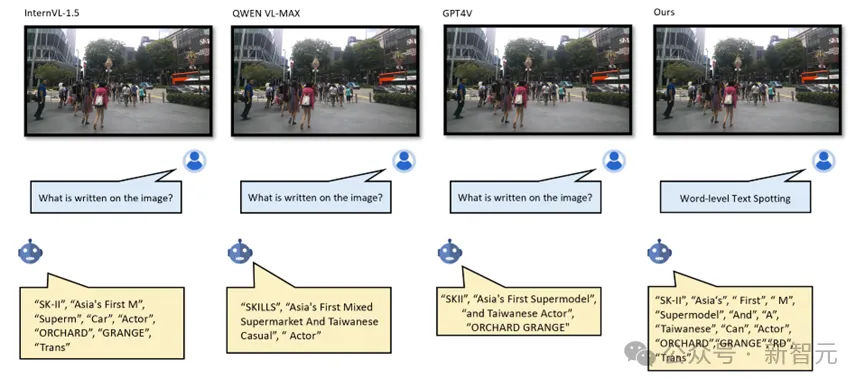

圖9 與其他方法在文字視頻上的對比

討論

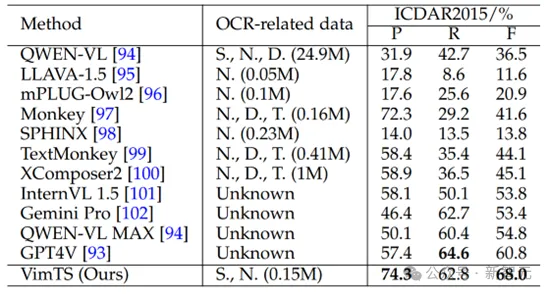

近年來,大型多模態模型因其強大的泛化能力而備受關注。為了進一步證明我們的方法的有效性,我們在ICDAR2015上進行了跨域實驗,與大型多模態模型進行了比較。評估過程參考GPT-4V_OCR[2]。

結果顯示在表9中。研究結果表明,為特定任務開發場景文本識別方法的重要性。與大型多模態模型的廣泛應用相比,這種專門的方法不僅在需要更少的參數方面更有效,而且需要更少的訓練數據。

表9 ICDAR2015上的跨域文本識別與mlms的比較。所有結果都在“None”詞典上進行測試。OCR相關數據表示與OCR相關的訓練數據。S.、N.、D.和T.分別代表合成、自然、文檔和表格數據。

圖10 與多模態大模型的可視化分析

總結

在本文中,我們介紹了VimTS,它通過發揮不同粒度文本識別任務(包括詞級,行級和視頻級文本識別)之間的協同作用來提高跨域文本識別性能。VimTS通過聯合優化不同場景下的不同任務來增強模型的泛化能力。

在廣泛的跨領域基準測試上進行的廣泛實驗一致表明,我們的方法比以前的最先進的方法性能要好得多。值得一提的是,我們的方法證明了靜態文本圖像可以很好地轉化為視頻文本圖像是可行的。

由于與視頻圖像相比,靜態圖像需要的注釋工作要少得多,因此探索彌合領域差距的方法將是非常有價值的。

此外,我們證明了當前的大型多模態模型在跨域文本識別方面仍然存在局限性,利用更少的參數和更少的數據來提高大型多模態模型在文本識別中的泛化,值得進一步探索。

本文轉自 新智元,作者:新智元