北大快手攻克復雜視頻生成難題!新框架輕松組合各種細節,代碼將開源

如何生成高難度、指令超復雜的視頻呢?

北大與快手AI有解了,他們提出新框架VideoTetris,就像拼俄羅斯方塊一樣,輕松組合各種細節~

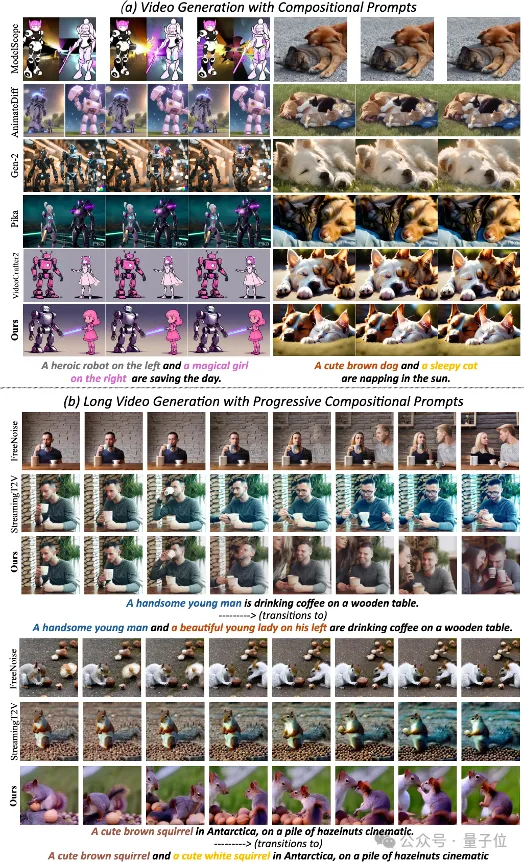

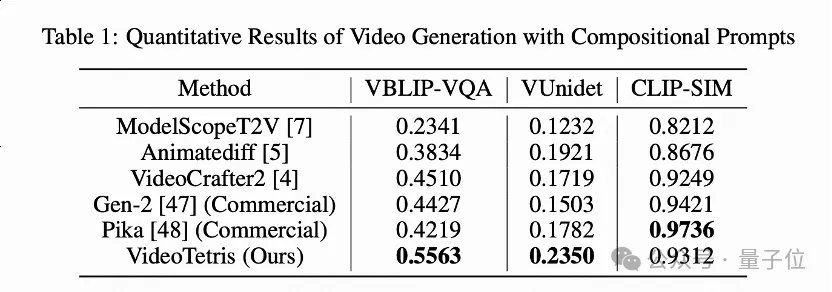

在復雜視頻生成任務中,超過了Pika,Gen-2等一眾商用模型。

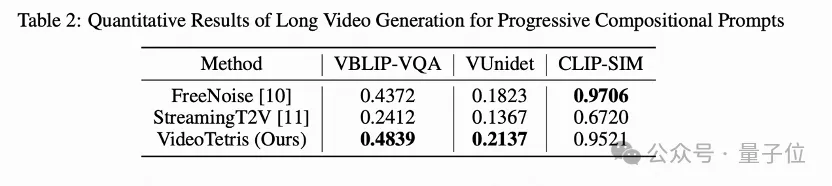

這個框架不僅能夠直接增強現有模型的組合生成,還能夠支持涵蓋多復雜指令、多場景變更等更高難度的長視頻生成。

首次定義組合視頻生成

在文生圖領域,RPG、Omost等項目已經實現了復雜的組合式多物體多場景圖片生成。而在文生視頻領域,組合生成自然地擴展到時間和空間維度,這樣的場景還未被廣泛探索。

團隊首次定義了組合視頻生成任務,包括兩個子任務:

1、跟隨復雜組合指令的視頻生成。2、跟隨遞進的組合式多物體指令的長視頻生成。

目前經團隊測試發現,幾乎所有開源模型,包括商用模型在內都未能生成正確的視頻。

比如輸入“左邊一個可愛的棕色狗狗,右邊一只打盹的貓在陽光下小憩”,結果生成的都是融合了兩個物體信息的奇怪視頻。

而使用VideoTetris,生成出的視頻是這樣,成功保留了所有的位置信息和細節特征。

在長視頻生成中,目前的方法支持的可變指令目前還停留在“春夏秋冬”的轉化,或單物體從走到跑到騎馬的場景變化階段。

團隊輸入一個簡單的多指令:“從一只可愛的棕色松鼠在一堆榛子上過渡到一只可愛的棕色松鼠和一只可愛的白色松鼠在一堆榛子上”。

結果VideoTetris成功搞定,出現順序也與Prompt一致,最后兩只松鼠還在自然地交換食物。

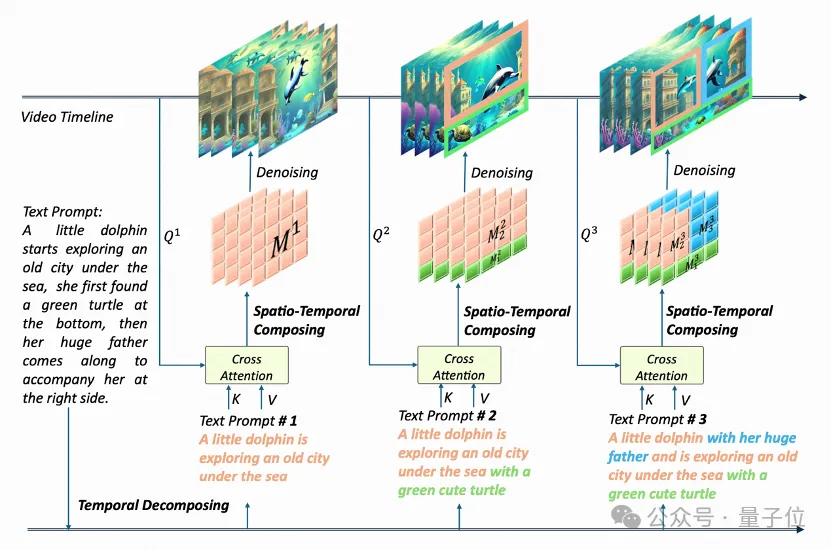

使用了時空組合擴散方法

這樣的效果是如何做到的呢?該團隊的 VideoTetris 框架使用了時空組合擴散方法

他們將一個提示詞首先按照時間解構,為不同的視頻幀指定好不同的提示信息。

隨后,在每一幀上進行空間維度的解構,將不同物體對應不同的視頻區域。

最后,通過時空交叉注意力進行組合,通過這個過程實現高效的組合指令生成。

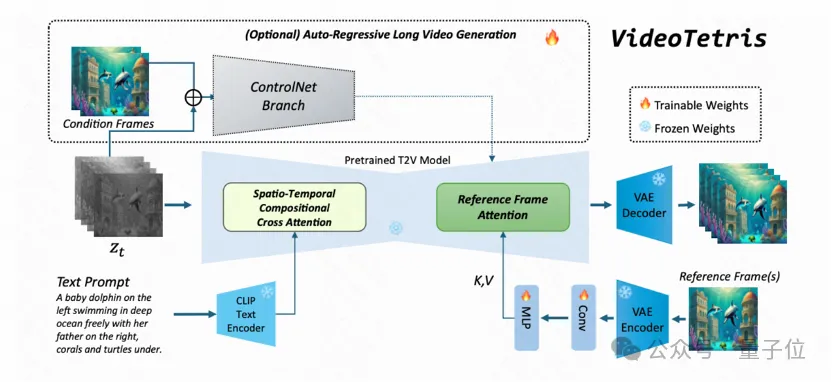

而為了生成更高質量的長視頻,該團隊還提出了一種增強的訓練數據預處理方法。使得長視頻生成更加動態穩定。

此外,還引入了一個參考幀注意力機制,使用原生VAE對之前的幀信息編碼,區別于StreamingT2V,Vlogger,IPAdapter等使用CLIP 編碼的方式,這樣使得參考信息的表示空間和噪聲完全一致,輕松獲取更好的內容一致性。

這樣優化的結果是,長視頻從此不再有大面積偏色的現象,能夠更好地適應復雜指令,并且生成的視頻更具有動感,更符合自然。

對于這種組合生成的結果評測工作,該團隊引入了新的評測指標VBLIP-VQA和VUnidet,將組合生成評價方法首次擴展到視頻維度。

實驗測試表明,在組合視頻生成能力上,該模型的表現超過了所有開源模型,甚至是商用模型如Gen-2和Pika。

據介紹,該代碼將完全開源。

論文地址:

???https://arxiv.org/abs/2406.04277???

項目主頁:

???https://videotetris.github.io/???

GitHub地址:https://github.com/YangLing0818/VideoTetris

本文轉自 量子位 ,作者:量子位

原文鏈接:??https://mp.weixin.qq.com/s/nsSTckp5xsk1VhyV--t_Sw??