Meta NLLB團隊:將神經機器翻譯擴展到200種語言,問鼎Nature! 原創

神經技術的發展為機器翻譯的研究開辟了新的途徑。如今,神經機器翻譯(NMT)系統可以利用高度多語言能力,甚至進行零翻譯,提供了有希望的語言覆蓋和質量結果。然而,擴展高質量的NMT需要大量平行雙語數據,而這些數據對世界上7000多種語言并不平等地可用。將重點放在改進相對較少數量的高資源語言的翻譯質量上,將導致研究關注低資源語言的不足,從而加劇了數字不平等。為了打破這一模式,研究人員在這里介紹了No Language Left Behind——一個利用跨語言轉移學習的單一大規模多語言模型。研究人員開發了一個基于稀疏門專家混合架構的條件計算模型,該架構是基于針對低資源語言量身定制的新挖掘技術獲得的數據進行訓練的。此外,團隊設計了多種架構和訓練改進方法,以抵消在數千個任務上進行訓練時的過擬合。使用專門為此目的創建的工具評估了該模型在40,000個翻譯方向上的性能——一個自動基準(FLORES-200),一個人工評估指標(XSTS)和一個涵蓋模型中每種語言的毒性檢測器。與以前的最先進模型相比,該模型在BLEU度量下平均達到了44%的翻譯質量改進。通過展示如何將NMT擴展到200種語言,并且將此工作中的所有貢獻免費提供給非商業用戶使用,該工作為通用翻譯系統的發展奠定了重要的基礎。

最近,神經機器翻譯(NMT)的出現推動了翻譯技術的發展,但其好處并不均衡分布。絕大多數改進主要受益于高資源語言,許多低資源語言被落下了。為了研究目的,研究人員將高資源語言定義為至少具有100萬句對齊文本數據(或雙語文本)的語言。這種差距主要可以歸因于數據缺口:NMT模型通常需要大量數據才能產生高質量的翻譯,而這些數據在低資源語言中并不可用。"無語言被遺忘"(NLLB-200)項目旨在通過利用以前未知的方法構建具有跨語言轉移能力的大規模多語言模型,使相關語言能夠相互學習,從而克服這一限制。

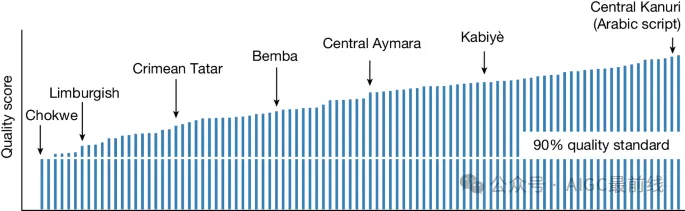

目前已廣泛認可,多語言模型相比雙語模型表現出有希望的性能改進。然而,一個問題仍然存在,即大規模多語言模型是否能夠在不損害質量的情況下表示數百種語言。結果表明,在機器翻譯中增加支持的語言數量并保持輸出質量并不是互相排斥的努力。最終模型包括200種語言,低資源語言數量是高資源語言數量的三倍,平均性能比之前的最先進系統提高了44%。本文介紹了實現這一目標所使用的一些最重要的數據收集、建模和評估技術。

首先,與高資源語言相比,低資源語言的訓練數據在成本和物流方面都具有挑戰性。公開可用的數字資源或者數量有限,或者對于自動化系統來說難以檢測(尤其是在大型公共網絡數據集,如CommonCrawl中)。無論是否需要收集關鍵質量的人工翻譯種子數據,足夠的數據獲取依賴于大規模數據挖掘和單語數據流水線。后者的技術通常受到噪聲和偏差的影響,因此驗證它們生成的數據集的質量是繁瑣的。在NLLB-200中,研究人員展示了一種基于蒸餾的句子編碼技術LASER3,它有助于有效地挖掘低資源語言的平行數據。

其次,在建模方面,研究人員使用一系列的種子、挖掘、開源和回譯數據集來訓練多語言條件計算模型(更具體地說,稀疏門控專家混合模型),這些模型可以在相關語言之間實現跨語言轉移,而不增加無關語言之間的干擾。研究人員展示了如何在跨語言轉移和干擾之間取得最優的性能平衡,并提高低資源語言的性能。

最后,為了進行質量評估,研究人員創建了FLORES-200,這是一個大規模多語言基準,可以衡量NLLB-200模型涵蓋的近40,000個翻譯方向的翻譯質量。除了自動評估指標,還創建了跨語義文本相似度(XSTS)和毒性評估(ETOX)。XSTS是一個人工評估協議,可以在不同語言之間提供一致性;ETOX是一個使用毒性詞匯列表檢測翻譯中添加毒性的工具。

除了創建這些模型,研究人員還反思了NLLB的潛在社會影響。為了增強工作在服務低資源語言社區方面的實際適用性,Meta將在此努力中描述的所有基準、數據、代碼和模型作為資源免費提供給非商業用戶使用,地址如下:

???https://github.com/facebookresearch/fairseq/tree/nllb???

論文地址:https://www.nature.com/articles/s41586-024-07335-x

本文轉載自公眾號AIGC最前線

原文鏈接:??https://mp.weixin.qq.com/s/1HLOGEd3MjtS3WPjht1ogw??