NVIDIA新模型Nemotron-4 340B系列:98%的訓(xùn)練數(shù)據(jù)是合成生成的,你敢信?

- 標(biāo)題:Nemotron-4 340B Technical Report

模型概述:Nemotron-4 340B系列模型的基本構(gòu)成

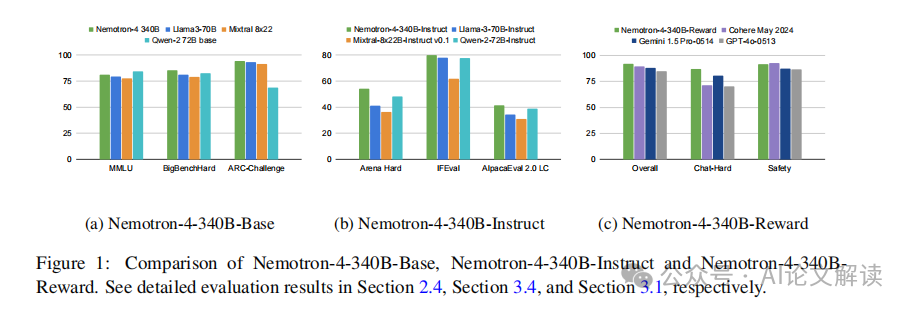

Nemotron-4 340B系列模型包括三個(gè)主要版本:Nemotron-4-340B-Base、Nemotron-4-340B-Instruct和Nemotron-4-340B-Reward。這些模型是在NVIDIA開放模型許可協(xié)議下發(fā)布的,該協(xié)議允許模型及其輸出的分發(fā)、修改和使用。Nemotron-4 340B系列模型在多個(gè)評(píng)估基準(zhǔn)測(cè)試中與其他開放訪問模型具有競(jìng)爭(zhēng)力,并且設(shè)計(jì)為在單個(gè)DGX H100設(shè)備上使用8個(gè)GPU以FP8精度部署時(shí)能夠適應(yīng)。這些模型特別適用于生成用于訓(xùn)練較小語言模型的合成數(shù)據(jù)。值得注意的是,我們模型對(duì)齊過程中使用的數(shù)據(jù)中有超過98%是合成生成的,這展示了這些模型在生成合成數(shù)據(jù)方面的有效性。

訓(xùn)練數(shù)據(jù)與預(yù)處理:詳細(xì)解析訓(xùn)練數(shù)據(jù)的組成及預(yù)處理方法

Nemotron-4 340B系列模型的訓(xùn)練數(shù)據(jù)混合包括三種不同類型的數(shù)據(jù):英語自然語言數(shù)據(jù)(占70%)、多語言自然語言數(shù)據(jù)(占15%)和源代碼數(shù)據(jù)(占15%)。英語語料庫包括來自各種來源和領(lǐng)域的精選文檔,如網(wǎng)頁文檔、新聞文章、科學(xué)論文、書籍等。我們的多語言數(shù)據(jù)包含53種自然語言,由單語和平行語料庫的文檔組成,而我們的代碼數(shù)據(jù)集包括43種編程語言。這些數(shù)據(jù)共計(jì)訓(xùn)練了9萬億個(gè)令牌,其中前8萬億令牌在正式的預(yù)訓(xùn)練階段完成,最后1萬億令牌在持續(xù)的預(yù)訓(xùn)練階段完成。

在預(yù)處理方面,我們采用了多種技術(shù)來確保數(shù)據(jù)質(zhì)量和模型訓(xùn)練的有效性。首先,我們對(duì)所有文本數(shù)據(jù)進(jìn)行了清洗和標(biāo)準(zhǔn)化處理,去除了噪聲和不相關(guān)的信息。接著,我們使用了高級(jí)的分詞工具(如SentencePiece)來處理文本數(shù)據(jù),確保了數(shù)據(jù)的一致性和可處理性。此外,為了提高模型訓(xùn)練的效率和效果,我們還采用了高級(jí)的數(shù)據(jù)增強(qiáng)技術(shù),如對(duì)話生成和質(zhì)量過濾,以及偏好排名等方法來進(jìn)一步優(yōu)化訓(xùn)練數(shù)據(jù)集。

通過這些精心設(shè)計(jì)的預(yù)處理和數(shù)據(jù)管理策略,Nemotron-4 340B系列模型能夠有效地從高質(zhì)量的訓(xùn)練數(shù)據(jù)中學(xué)習(xí),并在多個(gè)任務(wù)和基準(zhǔn)測(cè)試中展現(xiàn)出卓越的性能。

模型架構(gòu)與訓(xùn)練細(xì)節(jié)

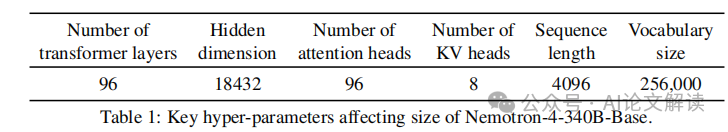

Nemotron-4 340B模型系列包括Nemotron-4-340B-Base、Nemotron-4-340B-Instruct和Nemotron-4-340B-Reward。這些模型在單個(gè)DGX H100設(shè)備上部署時(shí),可以在8個(gè)GPU上以FP8精度運(yùn)行。Nemotron-4-340B-Base模型在訓(xùn)練過程中使用了9萬億個(gè)高質(zhì)量數(shù)據(jù)令牌。模型的架構(gòu)是標(biāo)準(zhǔn)的解碼器僅Transformer架構(gòu),具有因果注意力掩碼,使用旋轉(zhuǎn)位置嵌入(RoPE)、SentencePiece分詞器,并在MLP層中使用平方ReLU激活函數(shù)。此外,該模型還采用了分組查詢注意力(GQA)技術(shù)。

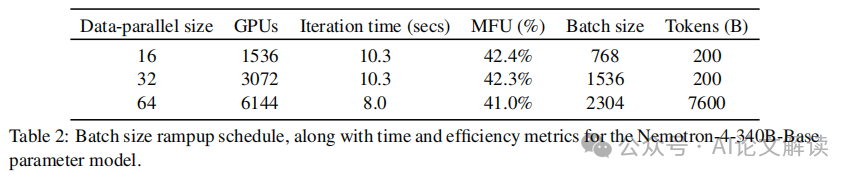

在訓(xùn)練細(xì)節(jié)方面,Nemotron-4-340B-Base使用768個(gè)DGX H100節(jié)點(diǎn)進(jìn)行訓(xùn)練,每個(gè)節(jié)點(diǎn)包含8個(gè)H100 80GB SXM5 GPU。這些GPU通過NVLink和NVSwitch連接,GPU之間的帶寬為900 GB/s。在訓(xùn)練過程中,我們采用了8路張量并行、12路流水線并行以及數(shù)據(jù)并行技術(shù),并使用分布式優(yōu)化器來減少訓(xùn)練過程中的內(nèi)存占用。此外,我們還在訓(xùn)練的最后階段引入了不同的數(shù)據(jù)分布和學(xué)習(xí)率衰減策略,以進(jìn)一步提高模型的質(zhì)量。

模型對(duì)齊與獎(jiǎng)勵(lì)建模

1. 獎(jiǎng)勵(lì)模型的重要性與構(gòu)建

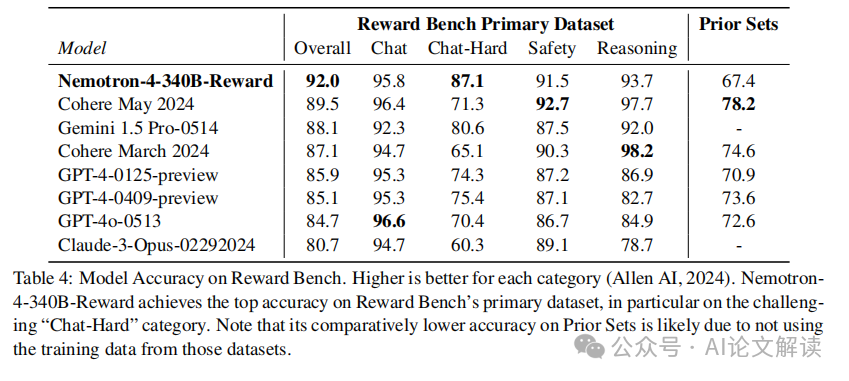

獎(jiǎng)勵(lì)模型在模型對(duì)齊過程中扮演著至關(guān)重要的角色,它是用于偏好排序和質(zhì)量過濾的關(guān)鍵工具。我們構(gòu)建的獎(jiǎng)勵(lì)模型基于Nemotron-4-340B-Base模型,通過替換最后的softmax層,加入一個(gè)新的獎(jiǎng)勵(lì)“頭部”,這是一個(gè)線性投影,將最后一層的隱藏狀態(tài)映射到一個(gè)五維的HelpSteer屬性向量上。這些屬性值在推理時(shí)可以通過加權(quán)求和得到總體獎(jiǎng)勵(lì)。我們發(fā)現(xiàn)這種獎(jiǎng)勵(lì)模型在RewardBench上的表現(xiàn)非常優(yōu)秀,達(dá)到了發(fā)布時(shí)的最高準(zhǔn)確率。

2. 對(duì)齊數(shù)據(jù)的生成與利用

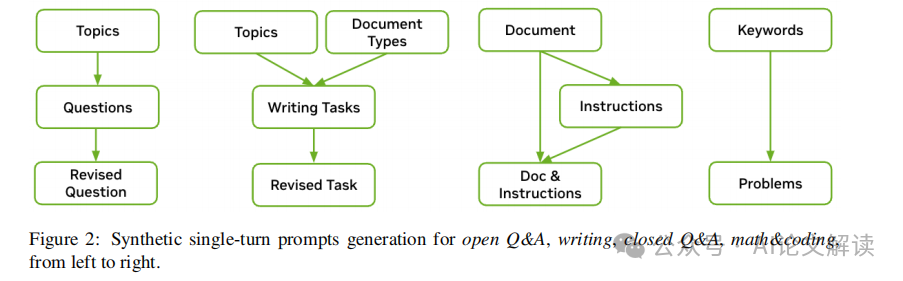

在整個(gè)模型對(duì)齊過程中,我們大量使用了合成數(shù)據(jù)生成(SDG)技術(shù)。特別是在監(jiān)督微調(diào)和偏好微調(diào)階段,合成數(shù)據(jù)占到了98%以上。我們的合成數(shù)據(jù)生成流程包括合成提示生成、響應(yīng)和對(duì)話生成、質(zhì)量過濾和偏好排序等步驟。此外,我們還探索了使用真實(shí)世界的LMSYS提示,以及結(jié)合合成提示和LMSYS提示,確保訓(xùn)練數(shù)據(jù)的多樣性和覆蓋面。

通過這些方法,我們不僅提高了模型的對(duì)齊質(zhì)量,還通過迭代優(yōu)化過程,不斷提升數(shù)據(jù)和模型的質(zhì)量,實(shí)現(xiàn)了模型性能的持續(xù)提升。

高級(jí)對(duì)齊策略:從監(jiān)督微調(diào)到偏好微調(diào)的詳細(xì)過程

1. 分階段的監(jiān)督微調(diào)

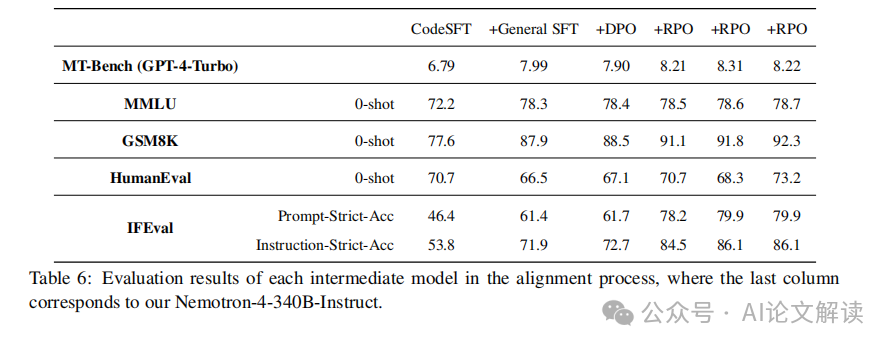

在模型對(duì)齊的過程中,監(jiān)督微調(diào)(Supervised Fine-Tuning,SFT)是第一步。傳統(tǒng)的SFT通常在單一階段內(nèi)完成,涉及多種任務(wù)的混合數(shù)據(jù)集。然而,我們的實(shí)驗(yàn)表明,同時(shí)學(xué)習(xí)多種行為有時(shí)會(huì)導(dǎo)致任務(wù)間的沖突,從而阻礙模型在所有任務(wù)上達(dá)到最佳對(duì)齊。特別是在編碼任務(wù)中,調(diào)整數(shù)據(jù)混合的采樣權(quán)重并未能使模型完全適應(yīng)所有編碼任務(wù)。

為了解決這一問題,我們?cè)O(shè)計(jì)了一個(gè)兩階段的SFT策略,使模型能夠有序且逐步地學(xué)習(xí)不同的行為。這種方法在所有下游任務(wù)中都顯示出更優(yōu)的結(jié)果。

代碼SFT:為了在不干擾其他任務(wù)的情況下提高編碼和推理能力,我們首先僅使用編碼數(shù)據(jù)進(jìn)行SFT。我們發(fā)現(xiàn),需要大量數(shù)據(jù)才能有效提升模型的編碼能力。我們?yōu)榇碎_發(fā)了一種模擬進(jìn)化過程的方法,通過自我指導(dǎo)和向?qū)Ь幋a突變生成大量合成樣本。這一過程設(shè)計(jì)為可以高效并行執(zhí)行,以便根據(jù)需要擴(kuò)展。

通用SFT:在第二階段,我們使用包含多種任務(wù)的混合數(shù)據(jù)集進(jìn)行通用SFT,以減少遺忘風(fēng)險(xiǎn)。我們訓(xùn)練模型三個(gè)周期,使用全局批量大小為128,并在[1e-7, 5e-7]范圍內(nèi)進(jìn)行學(xué)習(xí)率搜索。

2. 偏好微調(diào)的優(yōu)化方法

在監(jiān)督微調(diào)階段之后,我們通過偏好微調(diào)繼續(xù)改進(jìn)模型,其中模型學(xué)習(xí)形式為(提示,選擇響應(yīng),拒絕響應(yīng))的三元組。具體來說,偏好微調(diào)階段包括使用直接偏好優(yōu)化(Direct Preference Optimization, DPO)和我們的新對(duì)齊算法——獎(jiǎng)勵(lì)感知偏好優(yōu)化(Reward-aware Preference Optimization, RPO)的多次模型改進(jìn)迭代。

直接偏好優(yōu)化(DPO):DPO算法優(yōu)化策略網(wǎng)絡(luò),以最大化選定和拒絕響應(yīng)之間的隱式獎(jiǎng)勵(lì)差距。我們觀察到,盡管選擇的響應(yīng)質(zhì)量高,但選擇和拒絕響應(yīng)的可能性都會(huì)隨著差距的增大而一致下降。為了緩解這些問題,我們?cè)贒PO損失中添加了一個(gè)加權(quán)SFT損失,以幫助策略網(wǎng)絡(luò)不會(huì)過多偏離偏好數(shù)據(jù)。

獎(jiǎng)勵(lì)感知偏好優(yōu)化(RPO):與DPO不同,RPO學(xué)習(xí)近似獎(jiǎng)勵(lì)差距,這有助于防止過擬合問題,并避免“不學(xué)習(xí)”高質(zhì)量的拒絕響應(yīng)。我們使用從DPO訓(xùn)練的檢查點(diǎn)作為初始化和參考策略,進(jìn)一步使用RPO訓(xùn)練模型。這種方法在所有任務(wù)上均能改善模型性能。

模型評(píng)估與人類評(píng)價(jià):展示模型在自動(dòng)基準(zhǔn)測(cè)試和人類評(píng)價(jià)中的表現(xiàn)

自動(dòng)基準(zhǔn)測(cè)試

我們對(duì)Nemotron-4-340B-Instruct模型在多種自動(dòng)基準(zhǔn)測(cè)試上進(jìn)行了全面評(píng)估。這些測(cè)試包括多輪對(duì)話、0-shot評(píng)估等,以評(píng)估模型在沒有先前示例的情況下準(zhǔn)確遵循指令的能力。我們的模型在所有評(píng)估中均顯示出與現(xiàn)有開源模型相當(dāng)或更優(yōu)的性能。

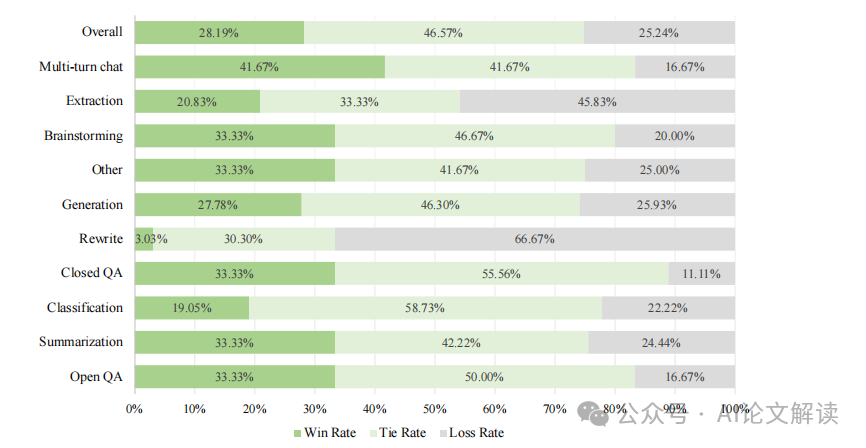

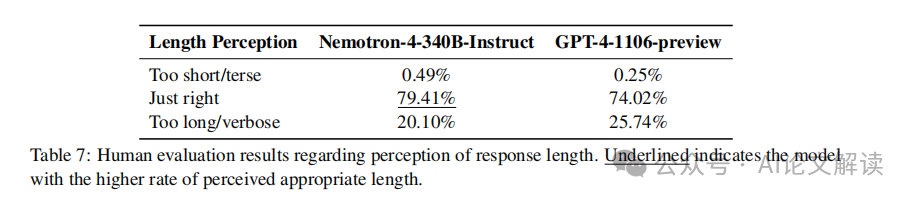

人類評(píng)價(jià)

除了自動(dòng)評(píng)估外,我們還通過訓(xùn)練有素的注釋員團(tuán)隊(duì)對(duì)模型進(jìn)行了人類評(píng)價(jià)。注釋員根據(jù)六點(diǎn)Likert類型的量表評(píng)估了136個(gè)提示下的響應(yīng),這些提示涵蓋了10種不同的任務(wù)類別。我們的評(píng)價(jià)指南主要依據(jù)幫助性和真實(shí)性兩個(gè)維度,并在迭代細(xì)化過程中發(fā)現(xiàn),通過考慮注釋員對(duì)響應(yīng)長(zhǎng)度的感知可以改善結(jié)果。這種方法有助于將個(gè)別的冗長(zhǎng)偏好與模型遵循指令和提供有用答案的能力區(qū)分開來。

安全性評(píng)估:通過AEGIS安全模型評(píng)估Nemotron-4 340B的內(nèi)容安全風(fēng)險(xiǎn)

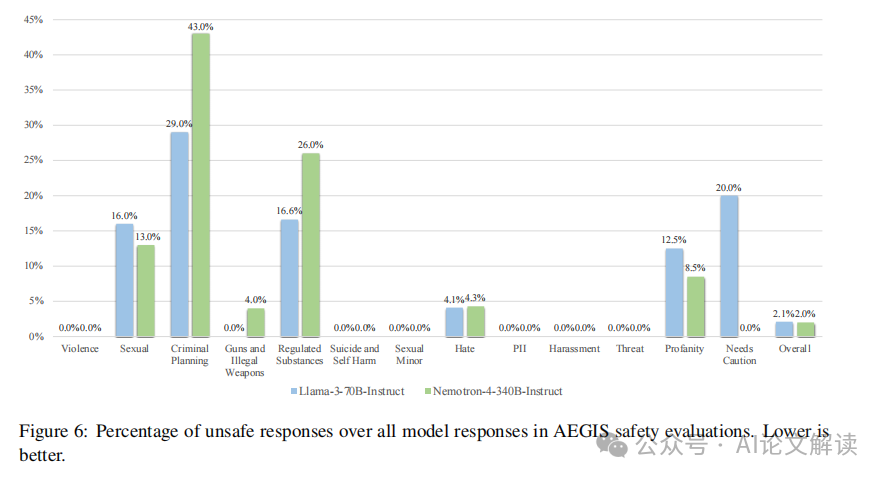

在使用大型語言模型(LLM)的過程中,內(nèi)容安全風(fēng)險(xiǎn)的評(píng)估變得尤為重要。為此,我們采用了NVIDIA開發(fā)的AEGIS安全模型來評(píng)估Nemotron-4 340B模型的安全性。AEGIS是一個(gè)高質(zhì)量的內(nèi)容安全解決方案和評(píng)估基準(zhǔn),它涵蓋了人類與LLM交互中的12個(gè)關(guān)鍵風(fēng)險(xiǎn)類別。這些類別包括基于種族、年齡、性別、宗教等的仇恨言論,性行為的描述,暴力行為的威脅,自我傷害的傾向,以及涉及犯罪計(jì)劃的內(nèi)容等。

我們使用AEGIS測(cè)試分區(qū)中的提示來引發(fā)Nemotron-4 340B-Instruct和Llama-3-70B-Instruct的響應(yīng),然后通過AEGIS安全模型對(duì)這些響應(yīng)進(jìn)行評(píng)估。在安全模型的幫助下,我們能夠判斷模型生成的內(nèi)容是否安全,以及是否存在違規(guī)的類別。

在評(píng)估結(jié)果中,Nemotron-4 340B-Instruct顯示出極低的不安全響應(yīng)率。在記錄到的不安全響應(yīng)中,涉及暴力、自殘、性侵犯未成年人、個(gè)人信息泄露、騷擾、威脅和需要謹(jǐn)慎處理的類別的響應(yīng)極少。這一結(jié)果表明,Nemotron-4 340B-Instruct在內(nèi)容安全性方面與Llama-3-70B-Instruct相當(dāng),體現(xiàn)了我們?cè)谀P烷_發(fā)中對(duì)安全性的重視。

總結(jié):總結(jié)Nemotron-4 340B模型的創(chuàng)新點(diǎn)和實(shí)際應(yīng)用前景

Nemotron-4 340B模型系列包括Nemotron-4-340B-Base、Nemotron-4-340B-Instruct和Nemotron-4-340B-Reward,這些模型在開放許可下提供,支持廣泛的分發(fā)、修改和使用。這些模型在多個(gè)評(píng)估基準(zhǔn)上的表現(xiàn)與其他開放訪問模型相當(dāng),尤其在生成合成數(shù)據(jù)以訓(xùn)練更小的語言模型方面顯示出其有效性。

Nemotron-4 340B的一個(gè)重要?jiǎng)?chuàng)新是其對(duì)安全性的高度重視。通過與AEGIS安全模型的結(jié)合,Nemotron-4 340B能夠有效地評(píng)估和控制生成內(nèi)容的安全性,減少生成有害或不當(dāng)內(nèi)容的風(fēng)險(xiǎn)。此外,該模型在合成數(shù)據(jù)生成、模型對(duì)齊和獎(jiǎng)勵(lì)建模方面的應(yīng)用,展示了其在實(shí)際應(yīng)用中的廣泛前景,特別是在提高數(shù)據(jù)質(zhì)量、優(yōu)化模型性能和增強(qiáng)用戶交互體驗(yàn)方面。

總的來說,Nemotron-4 340B模型的發(fā)布不僅推動(dòng)了大型語言模型的研究和開發(fā),也為AI應(yīng)用的負(fù)責(zé)任使用提供了有力的工具和方法。我們期待這些模型能夠在未來的AI研究和應(yīng)用中發(fā)揮更大的作用,特別是在安全性、數(shù)據(jù)生成和模型對(duì)齊等關(guān)鍵領(lǐng)域。

未來展望:探討大型語言模型的發(fā)展方向和挑戰(zhàn)

隨著大型語言模型(LLM)的不斷發(fā)展,其在多種任務(wù)和應(yīng)用中的有效性已經(jīng)得到了廣泛認(rèn)可。然而,這些模型的發(fā)展也面臨著一系列挑戰(zhàn)和未來的發(fā)展方向。以下是對(duì)大型語言模型未來發(fā)展的探討,包括潛在的挑戰(zhàn)和可能的解決策略。

1. 模型規(guī)模的持續(xù)增長(zhǎng)

大型語言模型如Nemotron-4 340B系列模型的發(fā)布,展示了模型規(guī)模的持續(xù)增長(zhǎng)。這些模型在處理復(fù)雜任務(wù)時(shí)表現(xiàn)出色,但隨之而來的是對(duì)計(jì)算資源的巨大需求。例如,Nemotron-4-340B-Base模型在訓(xùn)練時(shí)需要768個(gè)DGX H100節(jié)點(diǎn),每個(gè)節(jié)點(diǎn)包含8個(gè)H100 80GB SXM5 GPU。這種規(guī)模的增長(zhǎng)帶來了顯著的能源消耗和經(jīng)濟(jì)成本。

2. 數(shù)據(jù)生成和模型對(duì)齊

為了提高模型的效果,越來越多的研究開始關(guān)注使用合成數(shù)據(jù)來訓(xùn)練和對(duì)齊模型。Nemotron-4 340B系列模型中,超過98%的訓(xùn)練數(shù)據(jù)是通過合成數(shù)據(jù)生成管道產(chǎn)生的。這種方法雖然能夠降低收集人工標(biāo)注數(shù)據(jù)的成本,但同時(shí)也需要確保合成數(shù)據(jù)的質(zhì)量和多樣性,以避免模型過度擬合或偏差。

3. 模型的道德和安全問題

隨著模型應(yīng)用的廣泛化,其在生成內(nèi)容的道德和安全性方面的挑戰(zhàn)也日益凸顯。例如,模型可能無意中生成有害內(nèi)容或加劇偏見。因此,開發(fā)者需要在模型設(shè)計(jì)和訓(xùn)練過程中加入更多的安全和道德考量,如使用AEGIS安全評(píng)估模型來監(jiān)控和評(píng)估內(nèi)容的安全性。

4. 模型的可解釋性和透明度

大型語言模型的決策過程往往是黑箱的,這對(duì)于模型的可信度和可接受度構(gòu)成挑戰(zhàn)。提高模型的可解釋性,使其決策過程更加透明和可理解,是未來發(fā)展的一個(gè)重要方向。這不僅有助于用戶信任模型的輸出,也有助于開發(fā)者優(yōu)化模型性能。

5. 持續(xù)的模型優(yōu)化和迭代

隨著技術(shù)的進(jìn)步和應(yīng)用需求的變化,持續(xù)對(duì)模型進(jìn)行優(yōu)化和迭代是必要的。通過引入新的訓(xùn)練策略如偏好優(yōu)化和獎(jiǎng)勵(lì)模型,可以進(jìn)一步提升模型的性能和適應(yīng)性。例如,Nemotron-4 340B系列模型采用了偏好優(yōu)化和獎(jiǎng)勵(lì)模型來改進(jìn)指令遵循能力和對(duì)話質(zhì)量。

總之,大型語言模型的發(fā)展前景廣闊,但同時(shí)也面臨著規(guī)模擴(kuò)展、數(shù)據(jù)質(zhì)量、安全性、可解釋性和持續(xù)優(yōu)化等多方面的挑戰(zhàn)。通過不斷的技術(shù)創(chuàng)新和策略調(diào)整,有望解決這些挑戰(zhàn),推動(dòng)大型語言模型在更廣泛領(lǐng)域的應(yīng)用和發(fā)展。

本文轉(zhuǎn)載自 ??AI論文解讀??,作者:柏企科技圈