谷歌推出V2A,可為視頻大模型自動(dòng)匹配語音

谷歌Deepmind在官網(wǎng)推出了視頻轉(zhuǎn)音頻模型V2A。

用戶可以用視頻+文本提示的方式,通過V2A為視頻模型自動(dòng)匹配語音。例如,為緊張、恐怖、驚悚的片段自動(dòng)匹配語音,可以進(jìn)一步節(jié)省制作時(shí)間和提高效率。同時(shí)可以與谷歌的視頻模型Veo相結(jié)合使用。

目前,Sora、可靈、Gen-3、Dream Machine等知名模型生成的視頻沒有任何聲音,用戶如果想使用這些視頻還需要二次加工配音。

但在嘴型、音軌匹配方面就比較麻煩,而V2A可以生成無限數(shù)量的音軌,用戶可以根據(jù)實(shí)際需求來選擇最貼近的內(nèi)容。

例如,為一個(gè)騎馬的牛仔視頻配上音樂,提示詞,草原上夕陽西下時(shí),悠揚(yáng)柔和的口琴聲響起。

水下游動(dòng)的水母、海洋生物、海洋

電影、驚悚片、恐怖片、音樂、緊張、氛圍、混凝土上的腳步聲

音樂會(huì)舞臺(tái)上的鼓手,周圍是閃爍的燈光和歡呼的人群。

一只狼對(duì)著月亮嚎叫

下面這個(gè)視頻短片的人物嘴型,就通過AI語音進(jìn)行了精準(zhǔn)匹配。

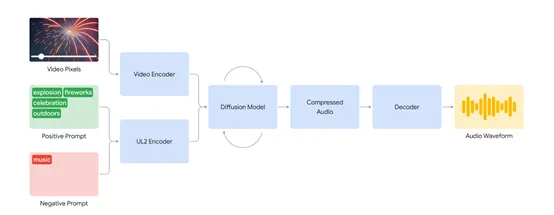

模型架構(gòu)方面,V2A首先將視頻和音頻提示輸入編碼,生成初始的壓縮表示。然后,通過迭代的方式,擴(kuò)散模型不斷優(yōu)化音頻,從而使其與視覺信息和文本提示同步。

這一步驟確保生成的音頻不僅具有高逼真度,還能準(zhǔn)確反映視頻中的場景和動(dòng)作。最后,生成的音頻被解碼,轉(zhuǎn)換為音頻波形,并與視頻數(shù)據(jù)結(jié)合。

為了提高音頻質(zhì)量并增加對(duì)特定聲音生成的控制,V2A技術(shù)在訓(xùn)練過程中加入了多種訓(xùn)練數(shù)據(jù),包括AI生成的詳細(xì)音頻描述和對(duì)話的轉(zhuǎn)錄。

通過這些額外的注釋,V2A系統(tǒng)能夠?qū)W習(xí)將特定的音頻事件與各種視覺場景關(guān)聯(lián)起來,并根據(jù)提供的注釋或轉(zhuǎn)錄做出響應(yīng)。

使得V2A技術(shù)在處理視頻像素和生成音頻時(shí),不需要手動(dòng)調(diào)整生成的聲音與視頻的對(duì)齊,從而避免了繁瑣的聲音、視覺和時(shí)間元素的調(diào)整,為生成逼真的音效奠定了堅(jiān)實(shí)的基礎(chǔ)。

此外,V2A在改進(jìn)頻中語音的口型同步方面進(jìn)行了大量優(yōu)化,會(huì)從視頻輸入和文字轉(zhuǎn)錄中抽取信息,生成初步的音頻表示并通過擴(kuò)散模型不斷細(xì)化。

為了進(jìn)一步提升口型同步的準(zhǔn)確性,V2A在訓(xùn)練過程中加入了更多的信息,包括AI生成的詳細(xì)音頻描述和對(duì)話轉(zhuǎn)錄。可幫助V2A能夠?qū)W習(xí)將特定的音頻事件與各種視覺場景關(guān)聯(lián)起來,并根據(jù)提供的注釋或轉(zhuǎn)錄做出響應(yīng)。這不僅改善了語音與口型的同步,還提高了整體音頻生成的質(zhì)量。

本文轉(zhuǎn)自 AIGC開放社區(qū) ,作者: AIGC開放社區(qū)