谷歌推出多模態(tài)視頻模型,自動(dòng)生成豐富動(dòng)作視頻

谷歌的研究人員推出了一款多模態(tài)擴(kuò)散模型——VLOGGER。

用戶(hù)只需要向VLOGGER輸入圖像、語(yǔ)音,就能生成帶語(yǔ)音、豐富動(dòng)作的人物視頻。VLOGGER基于擴(kuò)散模型開(kāi)發(fā)而成,并提出了一種全新的架構(gòu),將文本生成圖像模型與空間、時(shí)間控制相結(jié)合,提升視頻生成的逼真效果和豐富動(dòng)作。

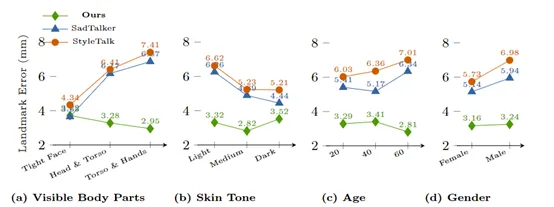

研究人員在HDTF、TalkingHead-1KH和MENTOR等多個(gè)數(shù)據(jù)集對(duì)VLOGGER進(jìn)行了綜合測(cè)試。結(jié)果顯示,VLOGGER在視頻質(zhì)量、物體還原性和時(shí)序一致性等方面表現(xiàn)出色,同時(shí)還能生成豐富的上半身和手勢(shì)動(dòng)作。

技術(shù)報(bào)告:https://enriccorona.github.io/vlogger/paper.pdf

隨著數(shù)字化經(jīng)濟(jì)的飛速發(fā)展,各行業(yè)對(duì)虛擬數(shù)字人的需求越來(lái)越多。但要制作出逼真的人物動(dòng)畫(huà)視頻需要大量的人工調(diào)整和修補(bǔ)才能獲得真實(shí)感,不然會(huì)出現(xiàn)動(dòng)作缺失、肢體動(dòng)作僵硬、五官不協(xié)調(diào)等問(wèn)題。

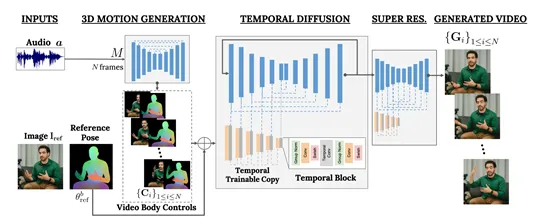

VLOGGER模型的創(chuàng)新之處在于,提出了全新的多階段擴(kuò)散模型架構(gòu):首先,通過(guò)使用隨機(jī)擴(kuò)散模型,根據(jù)輸入語(yǔ)音生成對(duì)應(yīng)的人體運(yùn)動(dòng)軌跡,包括表情、姿勢(shì)、視線(xiàn)和眨眼細(xì)節(jié)。

然后,使用創(chuàng)新的時(shí)空擴(kuò)散架構(gòu),將生成的人體運(yùn)動(dòng)軌跡及參考圖像作為條件實(shí)現(xiàn)完整的人物視頻合成。

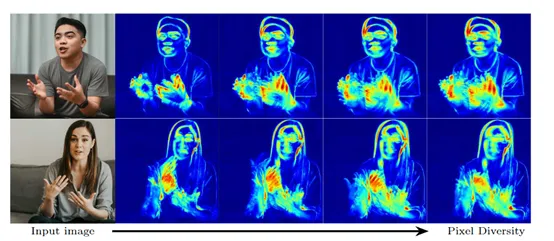

此外,VLOGGER無(wú)需針對(duì)每個(gè)新人物重新訓(xùn)練模型,不依賴(lài)人臉檢測(cè)框選區(qū)域,而是直接生成完整目標(biāo)圖像。更重要的是,VLOGGER考慮到了現(xiàn)實(shí)中復(fù)雜的交流場(chǎng)景,例如,可見(jiàn)軀干、不同身份等,這對(duì)正確合成有效交流的人物動(dòng)作至關(guān)重要。

語(yǔ)音生成

第一階段,VLOGGER使用了Transformer的神經(jīng)網(wǎng)絡(luò)用于接收音頻波形輸入,并生成一系列3D面部表情和身體姿勢(shì)參數(shù),用于控制虛擬人物在視頻中的動(dòng)作。

為了獲得逼真的運(yùn)動(dòng)效果,該模型利用了一種統(tǒng)計(jì)的3D人體模型,能夠精確捕捉面部表情、頭部運(yùn)動(dòng)、眼球轉(zhuǎn)動(dòng)、眨眼以及手勢(shì)等細(xì)節(jié)。通過(guò)預(yù)測(cè)基于參考圖像的姿勢(shì)殘差,該模型可以針對(duì)特定身份生成個(gè)性化的運(yùn)動(dòng)序列。

為了與基于CNN的架構(gòu)相兼容,該模型將預(yù)測(cè)的3D參數(shù)渲染為密集的2D表示,包括身體的語(yǔ)義區(qū)域掩碼和部分參考圖像的扭曲視圖。這些2D控制信號(hào)將在下一階段用于指導(dǎo)視頻生成過(guò)程。

人物生成

第二階段,VLOGGER在空間和時(shí)間上進(jìn)行條件控制,以生成高質(zhì)量、任意長(zhǎng)度的視頻。該模塊接收了來(lái)自第一階段的2D控制信號(hào)作為輸入,并以參考圖像中的人物身份為條件,生成逼真的運(yùn)動(dòng)視頻幀序列。

VLOGGER基于成熟的文本到圖像擴(kuò)散模型,并通過(guò)一種新穎的架構(gòu)對(duì)其進(jìn)行擴(kuò)展,增加了時(shí)域卷積層,使其能夠處理時(shí)序數(shù)據(jù)。此外,VLOGGER還引入了一種"時(shí)序外推"的技術(shù),允許模型迭代生成任意長(zhǎng)度的視頻片段,同時(shí)保持時(shí)序一致性。

為了提高生成效果,VLOGGER采用了級(jí)聯(lián)擴(kuò)散方法,對(duì)基礎(chǔ)分辨率的視頻進(jìn)行超分辨重建,生成高達(dá)512x512分辨率的高質(zhì)量影像。

VLOGGER數(shù)據(jù)集

為提高VLOGGER的泛化能力和安全性,研究人員構(gòu)建了一個(gè)大規(guī)模訓(xùn)練數(shù)據(jù)集MENTOR。該數(shù)據(jù)集包含80萬(wàn)名不同身份的人物視頻,視頻長(zhǎng)度總計(jì)超過(guò)2200小時(shí),覆蓋了不同年齡、膚色、體型和文化背景的人群。

值得一提的是,數(shù)據(jù)集中的視頻均捕捉了單個(gè)人物在相機(jī)前交流的場(chǎng)景,并提供了相應(yīng)的3D姿勢(shì)和表情標(biāo)注,這對(duì)于訓(xùn)練VLOGGER的多模態(tài)能力發(fā)揮了重要作用。

本文轉(zhuǎn)自 AIGC開(kāi)放社區(qū) ,作者:AIGC開(kāi)放社區(qū)