在消費級硬件上微調 DeepSeek-R1

本篇是 DeepSeek 相關系列的第一篇,對 DeepSeek-R1 等大型 AI 模型進行微調可能需要大量資源,但使用正確的工具,可以在消費級硬件上進行高效訓練。讓我們探索如何使用 LoRA(低秩自適應)和 Unsloth 優化 DeepSeek-R1 微調,從而實現更快、更具成本效益的訓練。

DeepSeek 最新推出的 R1 模型在推理性能方面樹立了新的行業標桿,其表現可與許多專有模型相媲美,但與此同時,它依然保持了開源的特性,使得更多的開發者和研究者能夠訪問并基于這一平臺進行創新。DeepSeek-R1 的一個特別值得注意的特點是其精簡版本,該版本是在 Llama 3 和 Qwen 2.5 兩個先進的基礎模型之上訓練而成的。這種設計不僅保留了原始模型的強大功能,還通過優化進一步提高了效率。更令人興奮的是,這個精簡版的 DeepSeek-R1 已經針對 Unsloth 框架進行了高度優化。Unsloth 是一個專門為促進高效模型調整而開發的工具集,它允許用戶以更低的成本、更快的速度對模型進行個性化定制。這意味著無論是學術界還是工業界的從業者,都可以利用 Unsloth 來快速地根據特定應用場景的需求對 DeepSeek-R1 進行微調,從而實現更好的性能或滿足特殊需求。總之,通過結合最新的研究成果以及強大的技術支持,DeepSeek R1 正引領著新一輪的人工智能技術革新。??????

在這篇博文中,我們將逐步指導如何在消費級 GPU 上使用LoRA(低秩自適應)和Unsloth對DeepSeek-R1 進行微調。??????

理解 DeepSeek-R1

DeepSeek-R1 是由 DeepSeek 團隊開發的一款開源推理模型,它在多個領域展現出了卓越的能力。該模型特別擅長處理需要復雜邏輯推理、數學問題解決以及實時決策的任務。這些特性使得 DeepSeek-R1 成為了科學研究、工程設計、教育等多個行業的寶貴工具。?????與傳統的大型語言模型(LLM)相比,DeepSeek-R1 的一大亮點在于其推理過程的高度透明性。這意味著用戶不僅能夠得到最終的結果,還可以清晰地了解模型是如何一步步得出這個結論的。這種透明度極大地提高了模型輸出結果的可信度,并且對于那些對算法可解釋性有著嚴格要求的應用場景來說至關重要。例如,在醫療診斷支持系統中,醫生們希望能夠清楚地知道人工智能建議背后的理由;在金融風險管理領域,監管機構也需要能夠審核和理解自動決策系統的運作機制以確保合規性和公平性。

此外,由于是開源項目,DeepSeek-R1 也鼓勵社區內的開發者參與到模型的持續改進過程中來。這不僅有助于發現并修復潛在的問題,還能促進新功能的研發,從而讓整個生態系統變得更加豐富多樣。總之,無論是從性能表現還是開放合作的角度來看,DeepSeek-R1 都是一款非常值得關注和探索的先進推理模型。

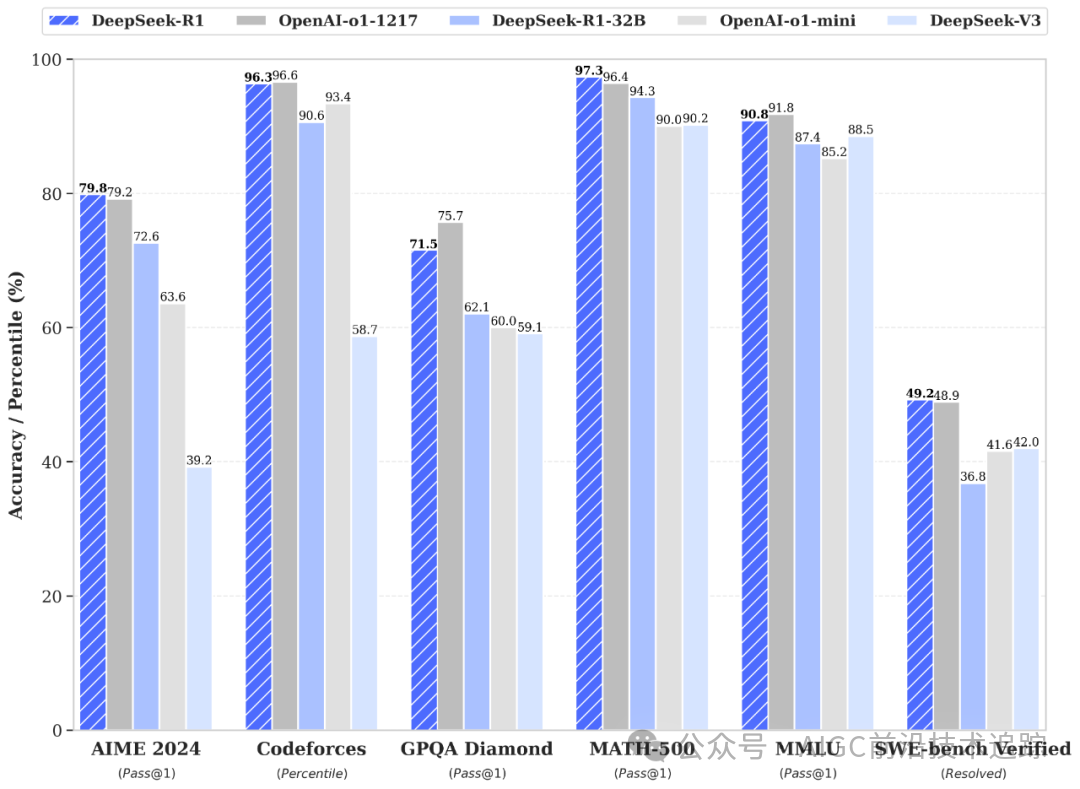

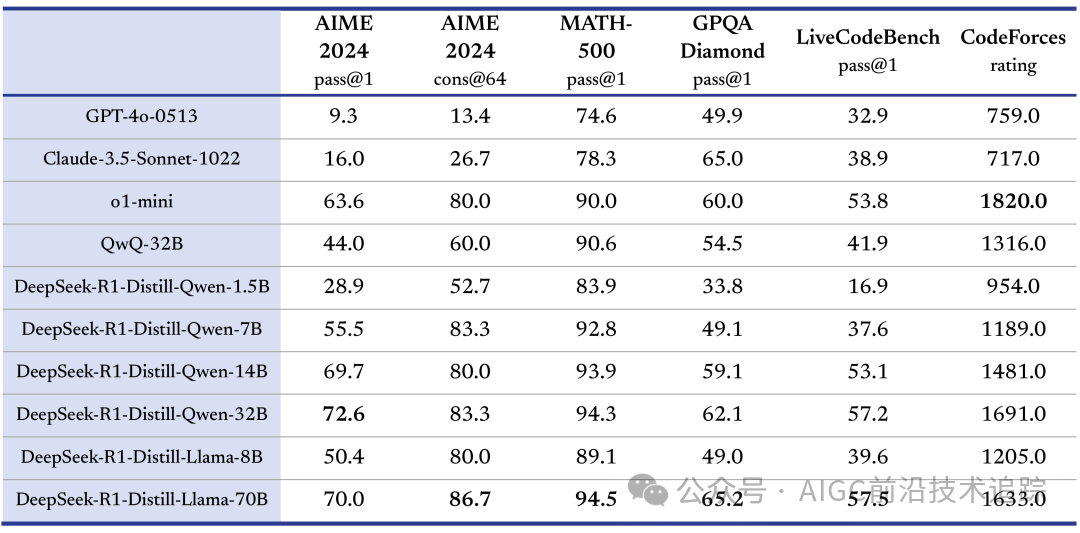

蒸餾小模型超越 OpenAI o1-mini

深度求索在開源 DeepSeek-R1-Zero 和 DeepSeek-R1 兩個 660B 模型的同時,通過 DeepSeek-R1 的輸出,蒸餾了 6 個小模型開源給社區,其中 32B 和 70B 模型在多項能力上實現了對標 OpenAI o1-mini 的效果。??????

HuggingFace 鏈接: ??https://huggingface.co/deepseek-ai??

為什么需要微調???????

微調是將 DeepSeek-R1 等通用語言模型適應特定任務、行業或數據集的關鍵步驟。

這就是為什么微調很重要:

- 領域特定知識:預訓練模型是在大量通用知識的基礎上進行訓練的。微調可實現醫療保健、金融或法律分析等特定領域的專業化。??????

- 提高準確性:自定義數據集可幫助模型理解小眾術語、結構和措辭,從而獲得更準確的響應。?????

- 任務適應:微調使模型能夠更高效地執行聊天機器人交互、文檔摘要或問答等任務。??????

- 減少偏差:根據特定數據集調整模型權重有助于減輕原始訓練數據中可能存在的偏差。??????

通過對 DeepSeek-R1 進行微調,開發人員可以根據自己的特定用例進行定制,從而提高其有效性和可靠性。??????

微調中的常見挑戰以及如何克服它們??????

微調大規模人工智能模型面臨著多項挑戰。

以下是一些最常見的問題及其解決方案:

1. 計算限制

挑戰:對大型語言模型(LLM)進行微調通常需要具備大量視頻隨機存取存儲器(VRAM)和內存資源的高端圖形處理單元(GPU)。解決方案:為降低計算需求,可以采用低秩適應(LoRA)技術與4位量化方法。此外,將部分處理任務卸載至中央處理器(CPU)或利用云服務(例如 Google Colab、Amazon Web Services、阿里云等)也是有效策略之一。

2. 小數據集上的過度擬合

挑戰:在規模較小的數據集上進行模型訓練時,可能會遇到過擬合的問題,即模型傾向于記憶訓練數據中的特定模式,而非學習到能夠泛化至未見數據的一般規律。解決方案:為緩解這一問題,可以采用數據增強技術以擴充訓練樣本的多樣性,并結合正則化策略(例如Dropout或提前停止Early Stopping)來進一步控制模型復雜度,從而提高其對新數據的泛化能力。

3. 長時間訓練????

挑戰:依據硬件配置及數據集規模的不同,微調過程可能耗時數日至數周不等。解決方案:通過采用梯度檢查點技術和低秩適應(LoRA)方法,可以在顯著縮短訓練時間的同時,確保模型的性能不受影響。

4. 災難性遺忘??????

挑戰:在微調過程中,模型有可能會喪失其在預訓練階段所獲得的一般性知識。解決方案:為解決這一問題,建議采用一種混合數據集進行微調,該數據集不僅包含了領域特定的數據樣本,還融合了一定量的通用知識相關的數據。這種方法有助于維持模型對廣泛知識的理解能力,同時也能增強其針對特定領域的性能,從而保證整體模型的準確性和泛化能力。

5. 微調模型中的偏差??????

挑戰:微調模型可能繼承訓練數據集中的偏見。解決方案:構建一個多樣化且無偏的數據集,采用去偏技術,并利用公平性指標對模型進行評估。

有效應對這些挑戰可確保穩健、高效的微調過程。??????

設置環境

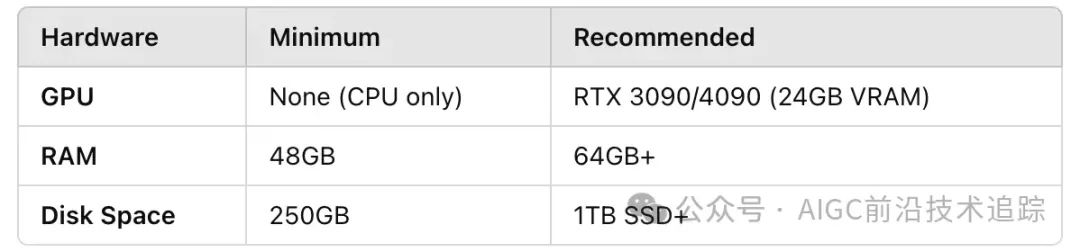

硬件要求

微調大型語言模型 (LLM) 需要大量計算資源。以下是推薦的配置:???????

軟件安裝

確保你擁有Python 3.8+并安裝必要的依賴項:???????

pip install unsloth torch transformers datasets accelerate bitsandbytes加載預先訓練的模型和標記器???????

使用Unsloth ,我們可以高效地以4-bit量化加載模型,以減少內存使用量。??????

from unsloth import FastLanguageModel

model_name = "unsloth/DeepSeek-R1-Distill-Llama-8B-unsloth-bnb-4bit"

max_seq_length = 2048

model, tokenizer = FastLanguageModel.from_pretrained(

model_name=model_name,

max_seq_length=max_seq_length,

load_in_4bit=True,

)準備你的數據集

微調需要結構化的輸入輸出對。讓我們假設一個用于指令跟蹤任務的數據集:???????

{"instruction": "What is the capital of France?", "output": "The capital of France is Paris."}

{"instruction": "Solve: 2 + 2", "output": "The answer is 4."}

# {"指令":"法國的首都是哪里?","輸出":"法國的首都是巴黎。"}

# {"指令":"解答:2 + 2", "輸出":"答案是 4。"}使用Hugging Face 的??datasets??庫加載數據集:??????

from datasets import load_dataset

dataset = load_dataset("json", data_files={"train": "train_data.jsonl", "test": "test_data.jsonl"})使用聊天樣式的提示模板格式化數據集:??????

prompt_template = """Below is an instruction that describes a task. Write a response that appropriately completes the request.

### Instruction:

{instruction}

### Response:

"""

def preprocess_function(examples):

inputs = [prompt_template.format(instructinotallow=inst) for inst in examples["instruction"]]

model_inputs = tokenizer(inputs, max_length=max_seq_length, truncatinotallow=True)

return model_inputs

tokenized_dataset = dataset.map(preprocess_function, batched=True)應用 LoRA 進行高效微調??????

LoRA 允許通過僅訓練模型的特定部分進行微調,從而顯著減少內存使用量。??????

model = FastLanguageModel.get_peft_model(

model,

r=16, # LoRA 等級

target_modules=["q_proj", "v_proj"], # 微調關鍵注意層

lora_alpha=32,

lora_dropout=0.05,

bias="none",

use_gradient_checkpointing=True,

)訓練模型

配置訓練參數:??????

初始化并開始訓練:???????

from transformers import Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset["train"],

eval_dataset=tokenized_dataset["test"],

tokenizer=tokenizer,

)

trainer.train()評估并保存模型

訓練后,評估并保存微調后的模型:???????

# 評估模型

eval_results = trainer.evaluate()

print(f"Perplexity: {eval_results['perplexity']}")

# 保存模型和標記器

model.save_pretrained("./finetuned_deepseek_r1")

tokenizer.save_pretrained("./finetuned_deepseek_r1")部署模型進行推理

微調完成后,使用模型進行推理:??????

對于使用llama.cpp進行本地部署,請運行:???????

./llama.cpp/llama-cli \

--model unsloth/DeepSeek-R1-Distill-Llama-8B-GGUF/DeepSeek-R1-Distill-Llama-8B-Q4_K_M.gguf \

--cache-type-k q8_0 \

--threads 16 \

--prompt '<|User|>What is 1+1?<|Assistant|>' \ # 1+1等于多少?

--n-gpu-layers 20 \

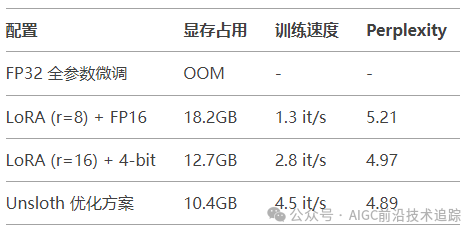

-no-cnv性能基準測試

在 RTX 4090 上的實驗數據:

典型問題排查指南

- CUDA 內存不足:

- 減少 ?

?per_device_train_batch_size?? - 啟用 ?

?gradient_checkpointing?? - 添加 ?

?--optim adafactor?? 使用內存優化器

- 損失震蕩劇烈:

- 降低學習率(建議初始值 3e-5)

- 增加 ?

?gradient_accumulation_steps?? 至 16-32 - 添加 ?

?lr_scheduler_type="cosine"??

- 生成結果重復:

- 在 ?

?generate()??? 中設置 ??no_repeat_ngram_size=3?? - 增加 ?

?repetition_penalty=1.2??

結論

通過利用LoRA和Unsloth ,我們成功地在消費級 GPU 上對DeepSeek-R1進行了微調,大大降低了內存和計算要求。這使得更快、更易于訪問的 AI 模型訓練成為可能,而無需昂貴的硬件。

本文轉載自??AIGC前沿技術追蹤??,作者:AIGC前沿技術追蹤