打開黑盒神經網絡!港大推出全新「會說話」的推薦系統大模型XRec,從黑盒預測到可解釋

傳統推薦系統雖然能給出準確的推薦結果,但缺乏對推薦過程的透明解釋,難以讓系統更好地理解其興趣偏好是如何被捕捉和建模的。

最近,香港大學數據智能實驗室推出了一款名為 XRec 的全新智能大模型,旨在為傳統推薦系統注入可解釋性的新動力。XRec 利用大語言模型(LLM)的強大自然語言處理能力,為推薦系統賦予了可解釋性,讓系統不僅能給出精準的推薦結果,還能用通俗易懂的語言向用戶闡述其推薦依據。

代碼鏈接: ??https://github.com/HKUDS/XRec??

論文鏈接: ??https://arxiv.org/pdf/2406.02377??

實驗室鏈接: ??https://sites.google.com/view/chaoh??

XRec旨在通過整合大語言模型的語義理解能力和協同過濾的用戶偏好建模,構建一種「可解釋推薦」框架,使推薦系統具備深入洞察用戶需求、生成清晰解釋的智能化水平。

這種融合自然語言處理和推薦系統的創新嘗試,不僅能大幅提升用戶體驗,增強他們對推薦結果的理解和信任,也將為推薦技術的發展注入新的動力。通過人機協作,XRec能為用戶提供更優質的智能服務,為推薦系統的未來發展開辟新的可能性。

通過這種融合語義理解與結構建模的方式,XRec為推薦系統注入了前所未有的智能化。不僅能夠生成個性化、貼合用戶需求的推薦結果,還能為用戶提供富有洞見的背景解釋,讓他們真正理解推薦的邏輯。這種創新性的范式無疑為未來的個性化服務發展帶來了全新的可能。

總的來說,XRec的提出標志著推薦系統正朝著更加智能化和可解釋的方向邁進。這一創新成果不僅能滿足用戶對推薦系統更高的期望,也將為整個推薦技術領域的發展帶來新的啟示和動力,為推薦系統的未來發展指明新的方向。

模型方法

XRec通過巧妙地融合強大的大型語言模型(LLMs),為推薦系統的輸出注入了豐富多彩的自然語言解釋。該框架巧妙地整合了協作信號,并采用輕量級的推薦信號適配器,能夠深入洞悉用戶復雜多變的偏好模式,以及他們與各類物品間錯綜復雜的交互細節。

值得一提的是,XRec在面臨零樣本場景時也展現出了出色的泛化能力,能夠為前所未見的用戶和物品生成富有見地且富有意義的推薦解釋。

協同行為關系建模

XRec巧妙地融合了圖神經網絡(GNNs)技術,以強大的表征學習能力彌補了自然語言在捕捉用戶-商品協作關系方面的不足。

在我們的系統中,GNN作為一種"協作信號的tokenizer",將復雜的用戶-商品交互模式高效地編碼到潛在的嵌入空間中,從而實現了對用戶復雜偏好的有效建模。

具體來說,基于圖神經網絡的消息傳遞機制,我們的協作圖tokenizer在用戶-商品交互圖上進行信息的傳播和聚合,促進了用戶和商品節點表征的學習。這不僅能夠更好地捕捉節點之間的關聯,還能夠反映出交互過程中蘊含的復雜模式。

行為與文本語義空間的對齊

表征空間對齊的映射器

XRec的創新之一在于,它配備了一個輕量級但大有作為的適配器模塊,用于協調融合不同語義模態間的差異。

我們注意到,用戶-商品的交互行為所反映的協同信息,其潛在語義表達空間可能與基于文本的用戶/商品語義存在一定差異。

為此,這個適配器模塊的作用就是對這些不同的語義模態進行精準對齊,使我們的模型能夠高效地整合利用協同信號和文本語義,從而提升整體的建模性能。

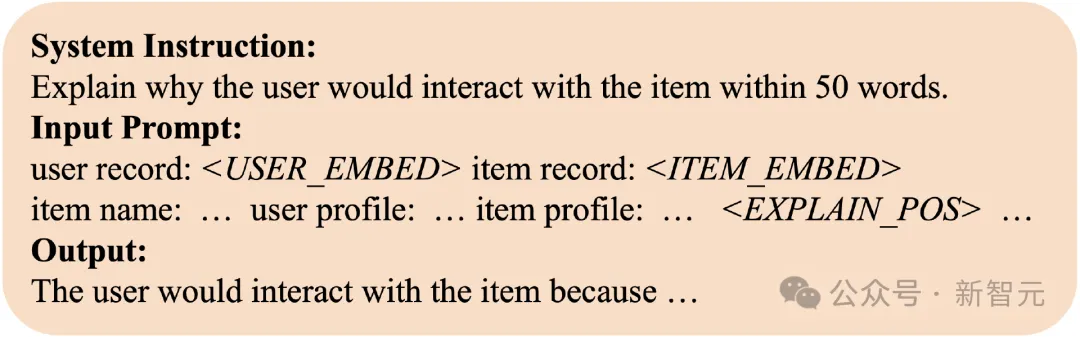

向大語言模型(LLM)注入行為信號

XRec的另一大創新點在于,它能夠巧妙地融合協同過濾(CF)技術和大語言模型(LLM)的優勢。

在完成前述的語義模態對齊后,我們的系統已做好將豐富的協同信號融入LLM的準備工作。

具體來說,我們會在輸入提示中預留特殊標記(tokens),然后將提示轉換為token嵌入,最后將已適配的協同信息嵌入注入到這些保留位置中。

XRec的另一個創新之處,在于它采用了一種獨特的機制來避免協同信息在融合過程中的損失。我們注意到,隨著輸入提示長度的增加,分配給每個嵌入token的注意力權重(attention weight)不可避免地會有所減弱,這可能導致本就稀疏的協同信號被稀釋。

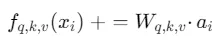

為了解決這一問題,我們將適配后的協同嵌入不僅注入到LLM的初始輸入提示中,還擴展到LLM每一個隱藏層的保留位置。具體來說,我們對LLM內部的query、key和value投影函數進行了專門的修改,以更好地促進這一融合過程。

具體來說,我們不僅在LLM的輸入階段注入適配后的協同嵌入a_i,還將其擴展到整個網絡的各個隱藏層中。我們運用了LLM內部的查詢(query)、鍵(key)和值(value)投影矩陣W_{q, k, v} ,確保模型能夠在整個計算過程中持續訪問和整合這些豐富的協同信息。

這不僅保持了協同上下文的強大表征,還使得梯度在回傳到專家混合(MoE)模塊時更為有效。這種融合設計,充分發揮了LLMs在深層語義理解方面的優勢,同時又能充分吸收GNN在捕捉結構模式方面的專長。

模型優化

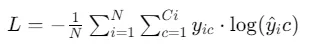

在XRec的模型優化部分,我們著重于提升大型語言模型(LLMs)在生成語境和句法連貫解釋方面的能力。我們的核心目標,是最小化預測下一個token的概率與實際下一個token之間的差距。

為此,我們采用了負對數似然(Negative Log Likelihood, NLL)作為訓練損失函數,具體公式如下:

其中, N表示每個樣本所需生成的解釋數量, Ci代表每個解釋中的字符數。

和

分別代表實際和預測的token。

這種加權形式的損失函數,能夠確保模型在優化預測準確性的同時,也能夠關注生成解釋的整體連貫性。通過按字符數進行歸一化,我們確保了各個解釋在損失計算中獲得公平的權重,從而推動模型學習生成更加流暢自然的解釋文本。

為了降低訓練復雜度,我們選擇凍結了LLMs內部的所有參數,僅在基于專家混合(Mixture of Experts, MoE)的適配器模型中進行參數更新。這種策略確保了模型能夠充分利用LLMs龐大的知識儲備,同時又能夠靈活地針對特定任務進行優化和精細調整。

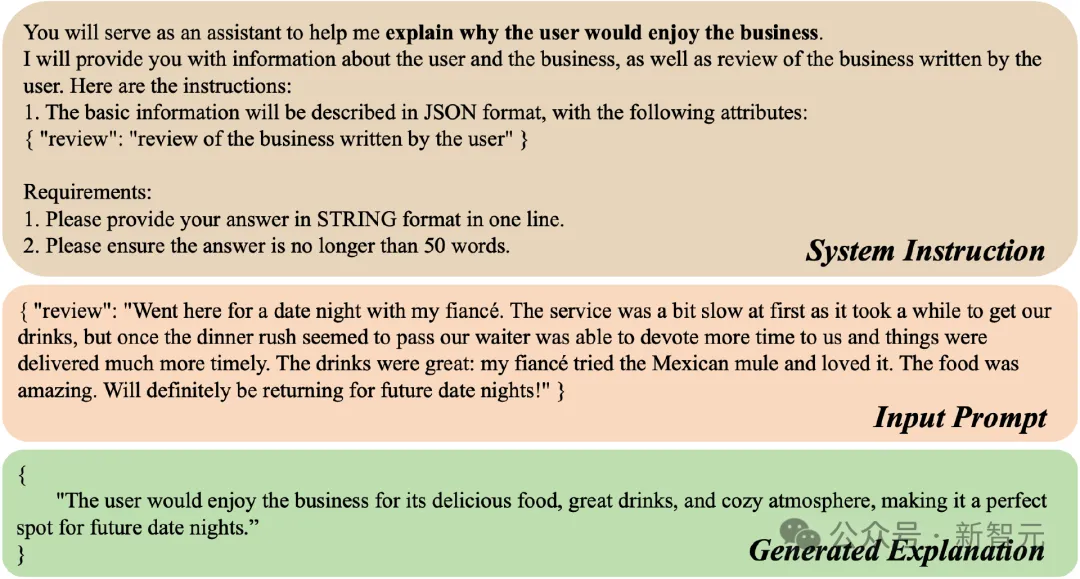

解釋文本的優化

基于大型語言模型(LLM)的創新解決方案,XRec能夠從原始用戶評論中提取出更加明確清晰的用戶意圖和需求特征,大幅提升基準解釋的質量和可解釋性。

與簡單使用原始評論文本相比,這種基于LLM的分析方法能夠洞悉隱藏在表面字面之下的語義內涵,更加深入地捕捉用戶的潛在偏好。

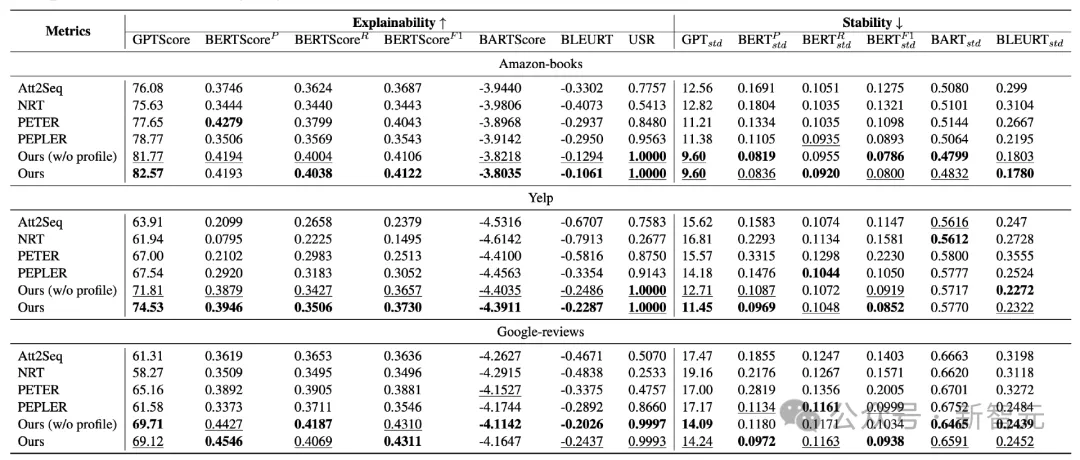

模型驗證

XRec模型在多個公開數據集上的驗證實驗取得了出色表現。我們利用GPTScore、BERTScore等可解釋性指標對模型進行評估,結果顯示XRec在可解釋性和穩定性方面均明顯優于基準模型(Att2Seq、NRT、PETER和PEPLER)。

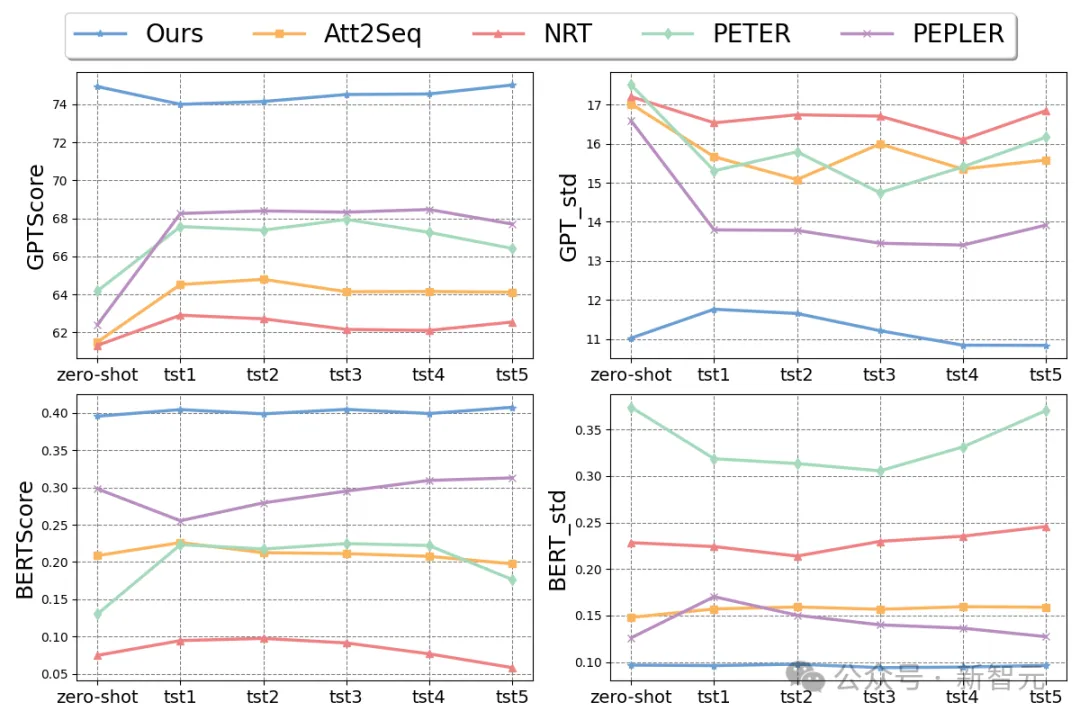

模型魯棒性的探索

為了更全面地檢驗模型的泛化能力,我們在不同數據稀疏性的場景下進行了實驗。將測試集劃分為五個子集(tst1至tst5),涵蓋了從罕見到頻繁不等的用戶群體。

結果表明,XRec不僅在常規用戶群體中表現卓越,在零樣本場景下(僅包含訓練期間未遇到的新用戶)也優于基準模型,與其他子集的性能基本持平。這種在冷啟動場景下的出色表現,體現了XRec強大的泛化能力,對于新用戶的推薦應用具有重要價值。

總的來說,XRec在可解釋性、穩定性以及對新舊用戶的適應性等方面的優異表現,充分證明了該模型在實際應用中的廣泛適用性。無論是用戶行為還是項目目錄發生變化的動態環境,XRec都能夠保持高水平的性能,為推薦系統的智能化升級提供可靠的技術支撐。

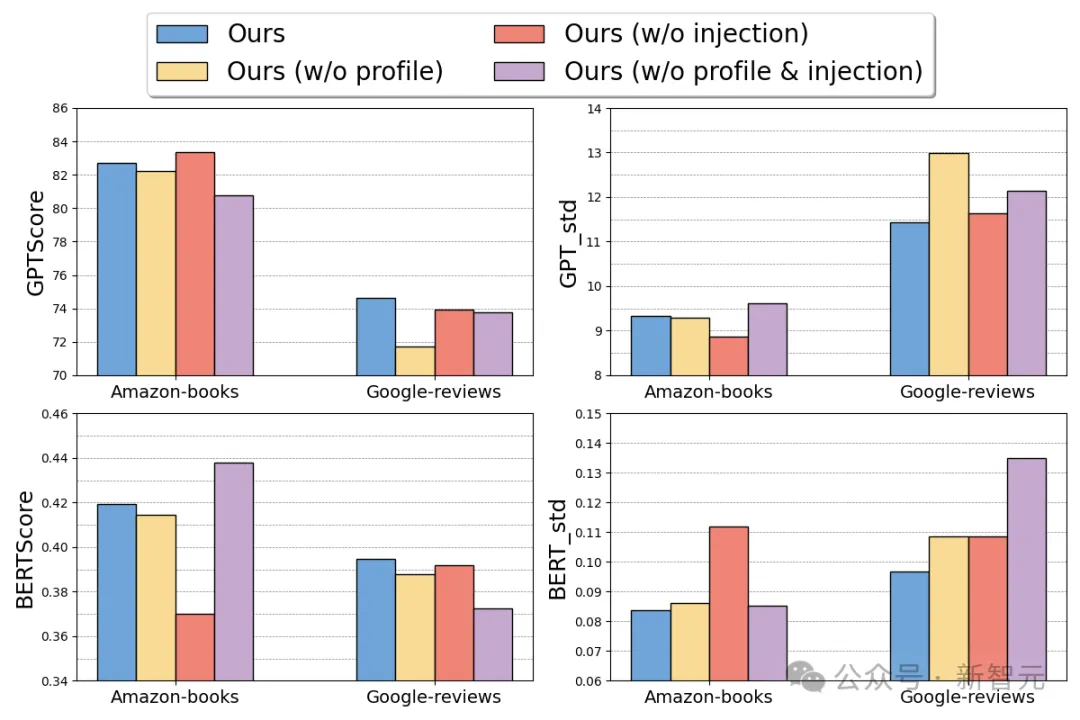

模型消融實驗

為了深入探究模型關鍵組件的影響,我們進行了一系列消融實驗。具體來說,我們比較了包含所有特性的完整模型(Ours)與三種變體:

1. 無Profile(Ours w/o profile): 省略了用戶和項目屬性

2. 無協同信號注入(Ours w/o injection): 保留對齊嵌入在提示中,但未將其注入到LLM層

3. 無屬性&協同信號注入(Ours w/o profile & injection): 同時缺少屬性和基于協同信號嵌入的注入

我們在Amazon-books和Google-reviews兩個數據集上,使用GPTScore和BERTScore這兩個可解釋性指標對這些變體進行了嚴格的評估,并比較了它們的標準差。

結果顯示,我們的完整模型(Ours)在可解釋性和穩定性方面均優于其他變體。這突出了每個組件在推動模型性能和能力方面的關鍵作用。用戶/項目屬性以及協同信息的注入,都為模型的出色表現做出了重要貢獻。

結語

本研究提出了一種全新的XRec框架,它實現了基于圖的協同過濾方法與大語言模型(LLM)技術的有機融合。這種創新設計使得XRec能夠為推薦輸出生成全面而見解深刻的解釋說明。

通過利用用戶-商品交互圖中蘊含的內在協同關系,XRec有效捕捉到了構成用戶偏好和項目關聯的高階依賴性。關鍵在于,XRec配備了專門的協同信息適配器模塊,作為協同信號(collaborative signal)與LLM語義空間之間的關鍵連接紐帶。

廣泛的實驗結果充分證明了XRec框架的顯著優勢。它不僅提升了推薦過程的可解釋性,而且在具有挑戰性的零樣本場景中展現出了出色的泛化能力和魯棒性。這意味著XRec能夠更好地滿足用戶個性化需求,為下一代智能推薦系統開辟新的可能。

本文轉自 新智元 ,作者:新智元