優(yōu)雅談大模型:神經(jīng)網(wǎng)絡(luò)與矩陣

1.向量與矩陣

上個(gè)章節(jié)的神經(jīng)網(wǎng)絡(luò)是為了解Transformer或者M(jìn)amba做好鋪墊,在和后輩交流過程中發(fā)現(xiàn)有個(gè)障礙,那就是向量和矩陣。其實(shí)向量和矩陣的表達(dá)方式不是所有人都很習(xí)慣。在繼續(xù)下面的章節(jié)之前小編認(rèn)為有必要將向量、矩陣和神經(jīng)網(wǎng)絡(luò)做下補(bǔ)充解釋。

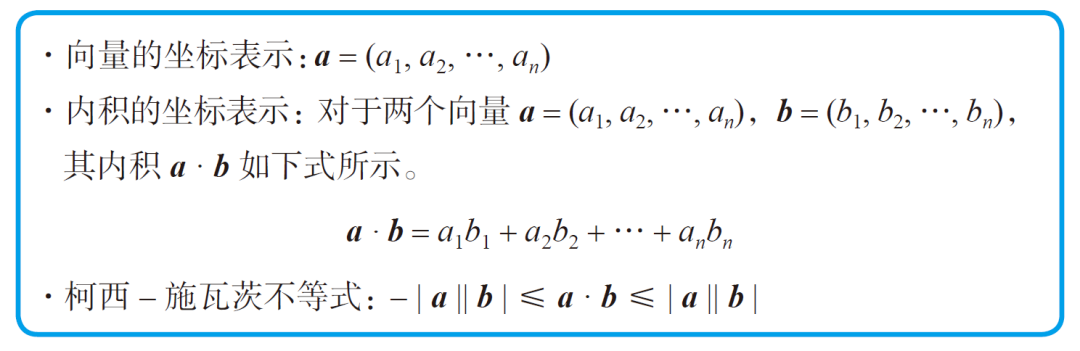

向量是具有方向和大小的量,用箭頭表示。向量具有下面的性質(zhì):

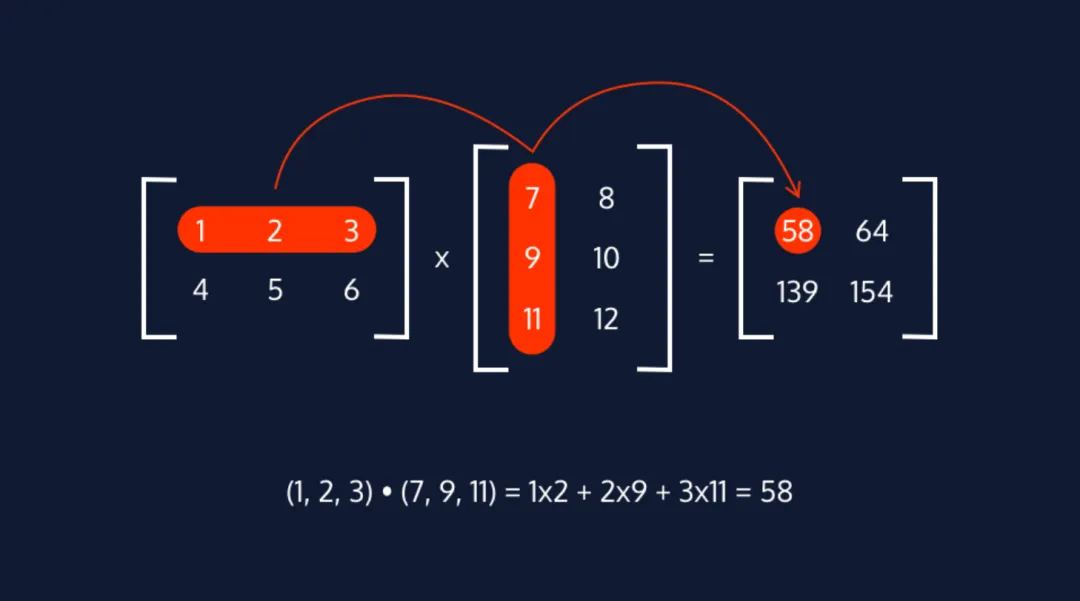

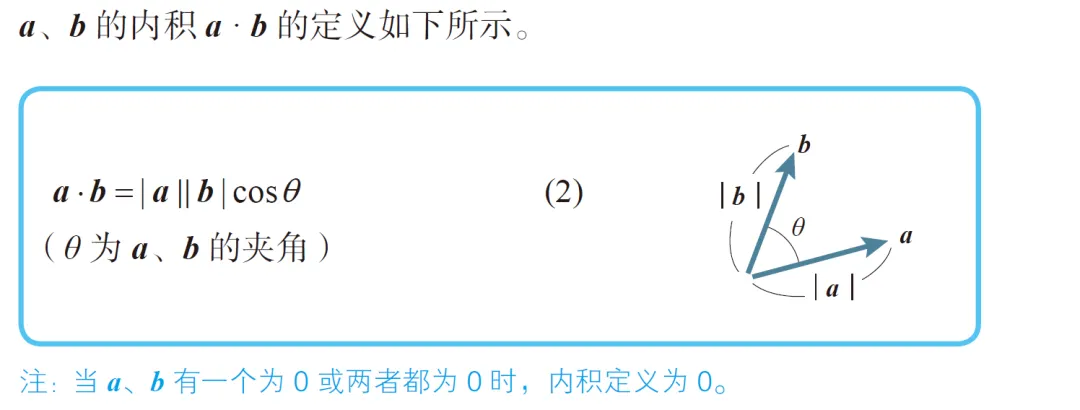

有好事者翻出來內(nèi)積的幾何含義,其實(shí)就是兩個(gè)向量的長(zhǎng)度乘以它們的夾角,那么上面代數(shù)的表達(dá)方式和下面的帶有cosθ的表達(dá)式一樣么。是一樣的,推導(dǎo)過程略過一千字。

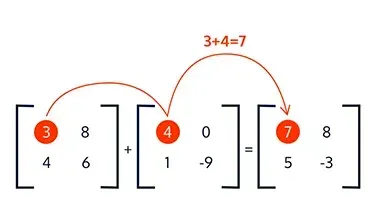

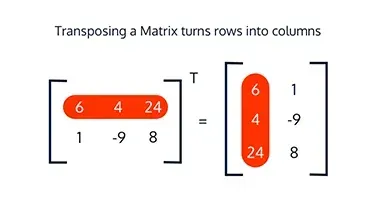

下圖則為矩陣運(yùn)算,請(qǐng)讀者快速溫習(xí)一下。m*n和n*p的矩陣相乘之后一定是m*p維度的。

|

|

|

|

2.神經(jīng)網(wǎng)絡(luò)的矩陣表示

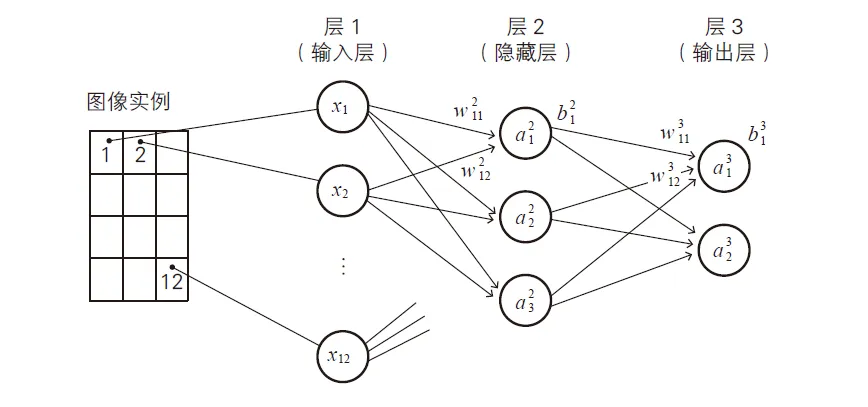

先來看一個(gè)例子,上圖一個(gè)簡(jiǎn)單的神經(jīng)網(wǎng)絡(luò),這套變量的標(biāo)識(shí)方式小編比較認(rèn)可,上標(biāo)l代表第幾層,下面代表某一層的第幾個(gè)神經(jīng)元。w的兩個(gè)下標(biāo)mn分別代表第m個(gè)輸出節(jié)點(diǎn)和第n個(gè)下游節(jié)點(diǎn)的權(quán)重。一般用z代表沒有經(jīng)過激活函數(shù)的數(shù)值,而a(ctivation)代表經(jīng)過激活函數(shù)的輸出。

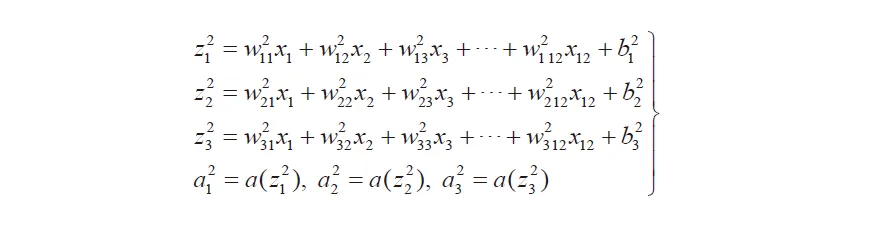

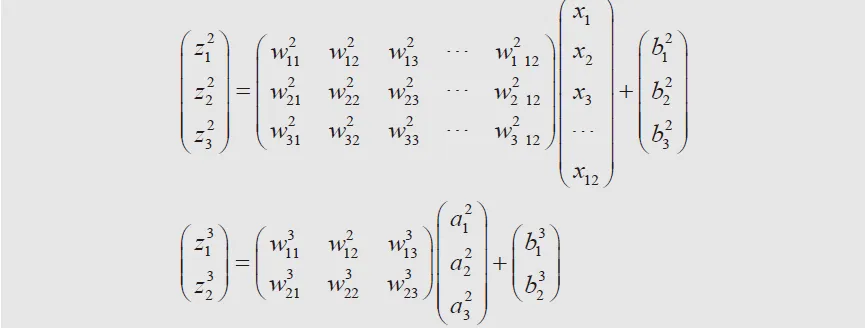

上圖是層1到層2的計(jì)算公式,可以將這樣的運(yùn)算直接轉(zhuǎn)化為矩陣表示。矩陣表達(dá)方式十分簡(jiǎn)潔清爽,而下圖中的w矩陣就是傳說中的參數(shù),這些矩陣通過樣本訓(xùn)練而得到。

于是到了這里,基本上從較為抽象的角度,將基于神經(jīng)網(wǎng)絡(luò)的大模型做了簡(jiǎn)單的抽象。大模型其實(shí)就是多層級(jí)深度的神經(jīng)網(wǎng)絡(luò),通過不斷地累加參數(shù),不斷地優(yōu)化結(jié)構(gòu),不斷地調(diào)整樣本,讓神經(jīng)網(wǎng)絡(luò)的信息編碼和激活更加的合理和高效。從另一個(gè)側(cè)面來看深度學(xué)習(xí),其實(shí)也是一種復(fù)雜的概率轉(zhuǎn)移矩陣。

3.損失函數(shù)

為了評(píng)估每個(gè)訓(xùn)練之后,真實(shí)值和預(yù)測(cè)值之間的差異,需要一個(gè)函數(shù)來評(píng)估差異化。這個(gè)函數(shù)有很多種稱呼,比如“誤差函數(shù)”、“損失函數(shù)”、“代價(jià)函數(shù)”等。代價(jià)函數(shù)是深度學(xué)習(xí)的重要組成部分,因?yàn)樗峁┝松窠?jīng)網(wǎng)絡(luò)在給定任務(wù)上執(zhí)行情況的衡量標(biāo)準(zhǔn)。訓(xùn)練深度學(xué)習(xí)模型的最終目標(biāo)是最小化損失函數(shù),這意味著模型能夠做出更準(zhǔn)確的預(yù)測(cè)并更好地泛化到新數(shù)據(jù)。

例如在回歸問題中采用的MSE來評(píng)估代價(jià)函數(shù)。

假定在某個(gè)批次的數(shù)據(jù)輸入,得到預(yù)測(cè)數(shù)據(jù)

[7.6, 8.0, 6.8, 8.9, 7.2, 8.3, 7.0, 8.8, 7.0, 7.6]。

而真實(shí)的數(shù)據(jù)為

[7.8, 8.2, 6.5, 9.1, 7.0, 8.5, 6.9, 8.7, 7.2, 7.8]。

兩者其實(shí)相當(dāng)?shù)慕咏?/p>

采用MSE(Mean squared error loss)的評(píng)估模式,MSE=(1/n)*Σ(yi - ?i)^2。yi為正確值,?i為預(yù)測(cè)值,cost = (1/20) * Σ(yi - ?i)^2 = 0.045

損失函數(shù)一方面指導(dǎo)訓(xùn)練過程,用于計(jì)算預(yù)測(cè)輸出與真實(shí)輸出之間的誤差。神經(jīng)網(wǎng)絡(luò)使用該誤差信號(hào)來調(diào)整其權(quán)重和偏差,以減少損失。這個(gè)過程稱為反向傳播,它允許神經(jīng)網(wǎng)絡(luò)從錯(cuò)誤中學(xué)習(xí)并在未來做出更好的預(yù)測(cè)。另一方面它有助于避免過度擬合,當(dāng)模型的過度擬合則無法泛化到新數(shù)據(jù)。通過選擇合適的損失函數(shù),可以防止過度擬合并確保模型能夠很好地泛化到未見過的數(shù)據(jù)。最后損失函數(shù)的選擇會(huì)對(duì)模型的性能產(chǎn)生重大影響。通過使用相同損失函數(shù)比較不同模型的性能,可以確定哪個(gè)模型對(duì)于給定任務(wù)最有效。深度學(xué)習(xí)的不同類型任務(wù)則采用不同的損失(評(píng)估)函數(shù)。下面展示的這些代價(jià)函數(shù)將會(huì)在LLM背后的基礎(chǔ)模型專欄中展開詳細(xì)的講解。

- 回歸問題一般為均方誤差(MSE)、平均絕對(duì)誤差(MAE)損失、Huber loss和Log-cosh loss。

- 二元分類問題一般為Binary cross-entropy loss二元交叉熵?fù)p失、Hinge loss、Focal loss和Dice loss。

- 多類分類問題則為分類交叉熵?fù)p失、稀疏分類交叉熵?fù)p失、Kullback-Leibler (KL)散度損失和Sparsemax loss。

- 自動(dòng)編碼器問題:均方誤差(MSE)損失、二元交叉熵?fù)p失和Perceptual loss感知損失。

- 生成對(duì)抗網(wǎng)絡(luò)損失則一般采用Adversarial loss、L1 or L2 loss、Wasserstein loss和Least squares loss。

- 物體檢測(cè)問題對(duì)應(yīng)的有Intersection over Union (IoU) loss、Focal loss、Smooth L1 loss、GIoU loss。

- Embedding問題則采用Triplet loss、Contrastive loss、Center loss和Angular loss。

本文轉(zhuǎn)載自 ??魯班模錘??,作者: 龐德公