大模型神經(jīng)網(wǎng)絡(luò)之注意力機(jī)制——attention 原創(chuàng)

“ 注意力機(jī)制是Transformer的核心,而注意力的目的卻是特征提取 ”

Transformer架構(gòu)對從事大模型領(lǐng)域的人來說應(yīng)該不是一個(gè)陌生的詞匯,而且大家應(yīng)該都知道Transformer架構(gòu)的核心點(diǎn)就在于其self-attention自注意力機(jī)制;雖然說Transofrmer架構(gòu)的自注意力機(jī)制大名鼎鼎, 但真正了解注意力機(jī)制的人好像并不是很多,所以今天我們就來簡單了解一下注意力機(jī)制。

注意這里說的是注意力機(jī)制,不是自注意力機(jī)制。

注意力機(jī)制

先來思考一個(gè)問題,什么是注意力機(jī)制?

說到注意力機(jī)制可能有些人顧名思義就知道是什么意思了;而有些人可能還沒明白什么是注意力機(jī)制。

就像神經(jīng)網(wǎng)絡(luò)是模仿我們?nèi)祟惔竽X神經(jīng)元一樣,注意力機(jī)制也是模仿我們?nèi)祟惖男畔⑻幚頇C(jī)制——那就是注意力。

我們經(jīng)常會(huì)走神,比如說某人問你問題或和你講話,你說你沒注意,沒聽到等等;這個(gè)就是注意力。而注意力機(jī)制,就是用一種數(shù)學(xué)辦法來為注意力進(jìn)行建模,用來處理大模型對待不同數(shù)據(jù)所產(chǎn)生的注意力大小。

下面我們來舉個(gè)例子:

如上圖所示,你第一眼看到的是什么?就代表著你的注意力在哪里,然后間接忽略其它次要內(nèi)容。

再比如說,如果問你這張圖片的背景是什么?這時(shí)你的注意力會(huì)在哪里?

如果問你這個(gè)小姐姐可能會(huì)在什么地方,大概處于一個(gè)什么樣的環(huán)境?這時(shí)你的注意力又會(huì)在哪里?

現(xiàn)在明白什么是注意力了吧?就是在不同的前提和關(guān)注點(diǎn)下,你的注意力會(huì)集中在不同的地方。

人在觀察事物時(shí)會(huì)有選擇性的關(guān)注較為重要的信息,稱其為注意力。通過持續(xù)關(guān)注這一關(guān)鍵位置以獲得更多的信息,而忽略其他的無用信息,這種視覺注意力機(jī)制大大提高了我們處理信息的效率和準(zhǔn)確性。深度學(xué)習(xí)中的注意力機(jī)制和人類視覺的注意力機(jī)制類似,就是在更多信息中把注意力集中放在重要的點(diǎn)上,選出關(guān)鍵信息,而忽略其他不重要的信息。

那為什么需要注意力機(jī)制,注意力機(jī)制解決了哪些問題?

注意力機(jī)制被提出來的原因就是解決傳統(tǒng)機(jī)器學(xué)習(xí)模型中的長距離依賴信息丟失問題。什么是長距離依賴信息丟失問題?

比如傳統(tǒng)的RNN網(wǎng)絡(luò)——循環(huán)神經(jīng)網(wǎng)絡(luò);它需要把全部文本輸入到神經(jīng)網(wǎng)絡(luò)模型中,雖然這種處理方式并沒有什么錯(cuò);但它存在一個(gè)問題,就是當(dāng)文本過長時(shí),會(huì)丟失前面文本的信息,原因就在于模型的處理能力有限。

這個(gè)就類似于我們?nèi)祟惖挠洃浺粯樱x你時(shí)間越久遠(yuǎn)的東西,你的記憶越模糊。

而注意力機(jī)制就恰巧能解決這個(gè)問題;舉個(gè)簡單的例子:

如果讓你背一篇幾十個(gè)字的文章,你可能用一會(huì)時(shí)間就背下來了;即使忘了,隨便看一下也能記得起來;但是如果給你一個(gè)萬字長文,這時(shí)你想把它完全背下來并做到不容易忘就很難了。

所以,注意力機(jī)制是怎么解決的呢?

一篇萬字長文總不可能所有的內(nèi)容都很重要,它總有一個(gè)中心思想,其它的內(nèi)容都是為了這個(gè)表述這個(gè)中心思想準(zhǔn)備的;因此,在注意力機(jī)制中,我不需要把萬字長文都背下來,只需要記住其中的中心思想即可。

而這篇萬字長文中的中心思想,才是我們需要注意的點(diǎn),也就是注意力需要集中的地方。

那注意力機(jī)制是怎么實(shí)現(xiàn)的呢?

其實(shí)注意力三個(gè)字已經(jīng)給我們講的很明白了,你的注意力在哪;哪里就需要注意。但在數(shù)學(xué)模型中沒有注意力這個(gè)東西啊,那應(yīng)該怎么做呢?

這時(shí)權(quán)重的作用就出現(xiàn)了,所謂的注意力就是對同一個(gè)目標(biāo)的不同點(diǎn)的關(guān)注度不一樣;而這個(gè)關(guān)注度就可以用權(quán)重來表示。注意力集中的地方,權(quán)重就越大,注意力不集中的地方,注意力就越小。

雖然理論上說起來比較簡單,但具體實(shí)現(xiàn)應(yīng)該怎么做呢?

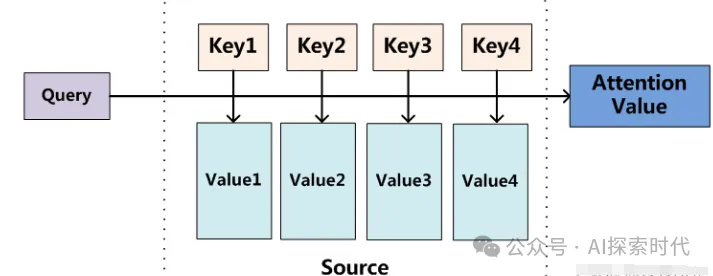

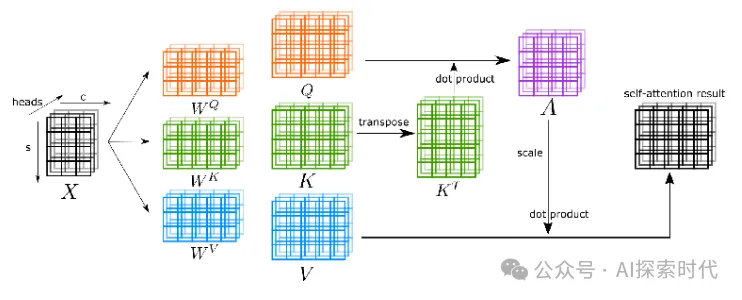

在注意力機(jī)制中,有三個(gè)比較重要的參數(shù)——Q,K,V;Q就是你的查詢參數(shù),K就是唯一標(biāo)識(shí),V就是實(shí)際值。

舉個(gè)例子來說,以淘寶或等電商平臺(tái)的搜索功能來說;Query就是我們在輸入框中輸入的參數(shù),比如鞋子,衣服等等;然后系統(tǒng)就會(huì)給我們返回很多有關(guān)鞋子,衣服的店鋪,商品等——Key;而我們點(diǎn)進(jìn)這些店鋪或商品詳情——Value,就能看到更多關(guān)于衣服鞋子等商品的信息。

在注意力機(jī)制中,通過把Q,K,V三個(gè)參數(shù)乘以一個(gè)W系數(shù),再進(jìn)行相加等操作就可以獲取到某個(gè)數(shù)據(jù)的權(quán)重;而通過這種計(jì)算方式,就可以獲取到整個(gè)輸入數(shù)據(jù)的不同權(quán)重,也就產(chǎn)生了多種不同的注意力。

當(dāng)然,不論是長距離依賴,還是注意力機(jī)制,其唯一的目的就是特征提取,以更小的代價(jià),提取更加準(zhǔn)確的數(shù)據(jù)特征。

本文轉(zhuǎn)載自公眾號(hào)AI探索時(shí)代 作者:DFires

原文鏈接:??https://mp.weixin.qq.com/s/XHZsR6CW7GvbOqoJwcJsWA??