將圖像自動文本化,圖像描述質量更高、更準確了

皮仁杰:香港科技大學博士三年級學生,師從張潼教授和周曉方教授。于 2024 年獲得蘋果獎學金。目前主要研究方向是多模態大語言模型和數據為中心的 AI。

?

張鑒殊:武漢大學本科三年級學生,目前在張潼教授的指導下擔任研究實習生,主要研究方向是大語言模型,多模態大語言模型以及持續學習。當下在尋找 2025 fall 博士入學機會。

在當今的多模態大模型的發展中,模型的性能和訓練數據的質量關系十分緊密,可以說是 “數據賦予了模型的絕大多數能力”。

在這其中,圖像 - 文本數據集發揮著至關重要的作用,在圖像理解、文本生成和圖像檢索等多個領域發揮著關鍵作用。

然而,現有的圖像描述數據集主要來源于網絡抓取和人工標注,存在著質量參差不齊、細節缺失、描述噪音多等問題。盡管人類可以為圖像提供詳細的描述,但高昂的標注成本限制了其規模和可行性。因此,迫切需要一種高效、可擴展的方法來生成準確且詳細的圖像描述。

為了應對上述挑戰,來自香港科技大學、武漢大學、浙江大學、UIUC的研究者聯合提出了一種創新的自動化框架 ——Image-Textualization(IT),該框架通過整合多模態大語言模型(MLLMs)和多種視覺專家模型的協作,將圖片信息進行文本化,最后利用擁有強大的推理能力的純文本大語言模型將這些文本化的信息轉化為高質量的圖像描述。

- 論文:Image Textualization: An Automatic Framework for Creating Accurate and Detailed Image Descriptions

- 論文地址:https://arxiv.org/pdf/2406.07502v1

- 項目地址:https://github.com/sterzhang/image-textualization/

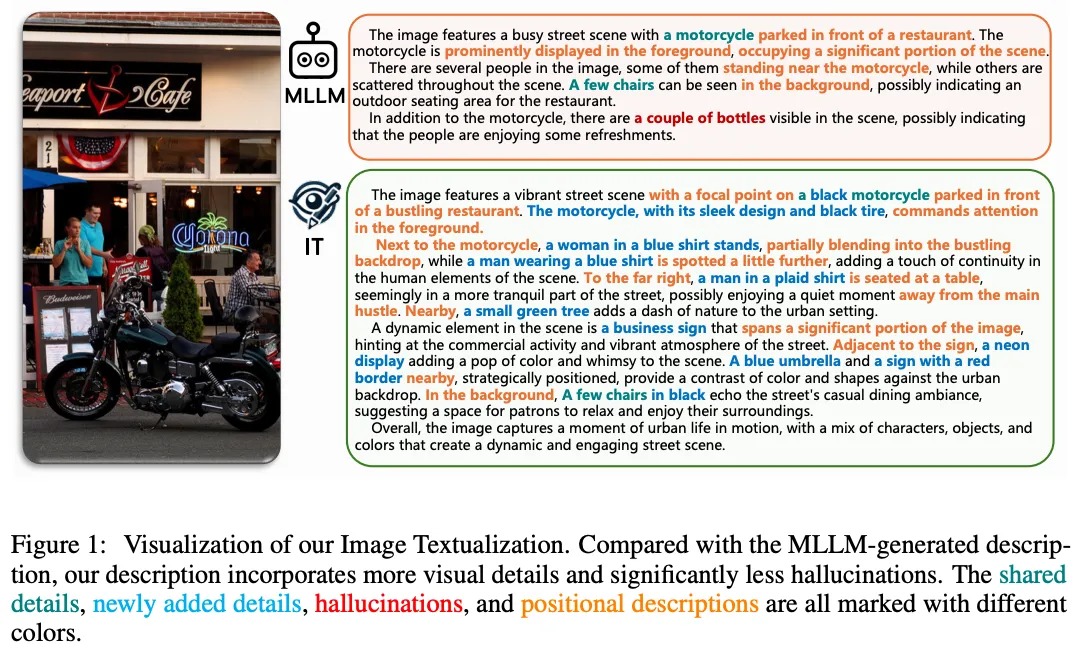

利用多模態模型造的圖片描述 vs 利用 IT 生成的圖片描述

總的來說,本文貢獻包括:

- 創新框架:我們提出了圖像文本化框架,利用多模態大模型的的粗粒度圖像理解能力,視覺專家模型的精細感知能力,以及純文本大語言的模型的推理能力去自動生成細節豐富且語言表達清晰的圖像描述。

- 評估基準與實驗:提出了多個評估細節豐富的圖片描述的基準,通過廣泛的實驗驗證了框架的有效性。

- 數據集與代碼發布:利用我們的圖像文本化框架,我們生成了一個大規模高質量的圖像描述數據集(IT-170K)。為了促進未來的研究,我們已將所有源代碼和生成的數據集公開發布。

Image Textualization 方法

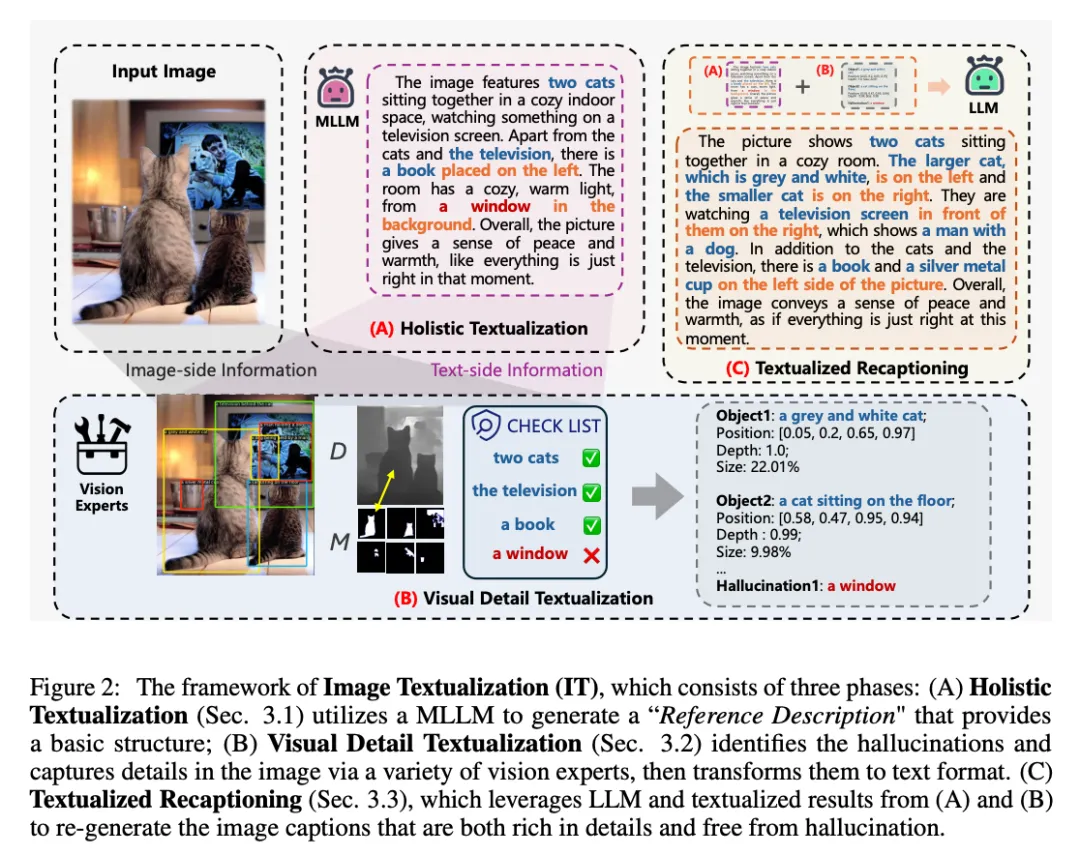

Image-Textualization(IT)框架包括以下三個階段:

1. 粗粒度的圖片文本化(Holistic Textualization):首先利用多模態大語言模型對圖片生成參考描述,盡管這些描述可能存在細節缺失和幻覺,但它們為圖像的視覺信息和語言表達提供了基本結構。這里視覺的結構主要體現在參考描述中往往會包含一些大的,核心的物體,這個可以為后續的細節提供類似 “錨點” 的作用,能夠使得最后的文本化重述(Textualized Recaptioning)更好的添加細節。另外,語言表達上的結構主要體現在多模態大模型包含的純文本大語言模型使得其擁有較強的語言能力,這使得這里生成的參考描述能夠在語言上有良好的組織,比如會先說出這個圖片大概描述了些什么,然后展開細節,最后總結,這種描述風格較為偏向人類的偏好。這也能夠使得最后的文本化重述(Textualized Recaptioning)能夠在一個語言能力較好的模板上進行加工。

2. 視覺細節文本化(Visual Detail Textualization):這個階段我們同時從圖片端和文本端進行細節的提取。

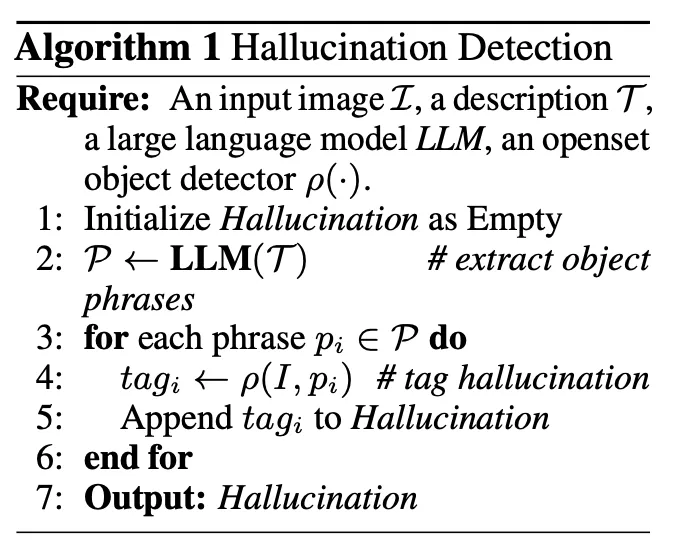

首先是文本端,由于在上一階段中我們利用多模態大模型生成的參考描述可能含有幻覺,所以這里首先做的是 “幻覺檢測”。我們首先利用 LLM 去抓取參考描述中含有的實體,再利用了一個開集檢測器去圖片里對這個實體進行匹配,如果沒有被檢測出來,則將這個實體判斷為幻覺。這里我們把檢測出來的幻覺也進行了文本化,在最后的文本化重述(Textualized Recaptioning)進行刪除。

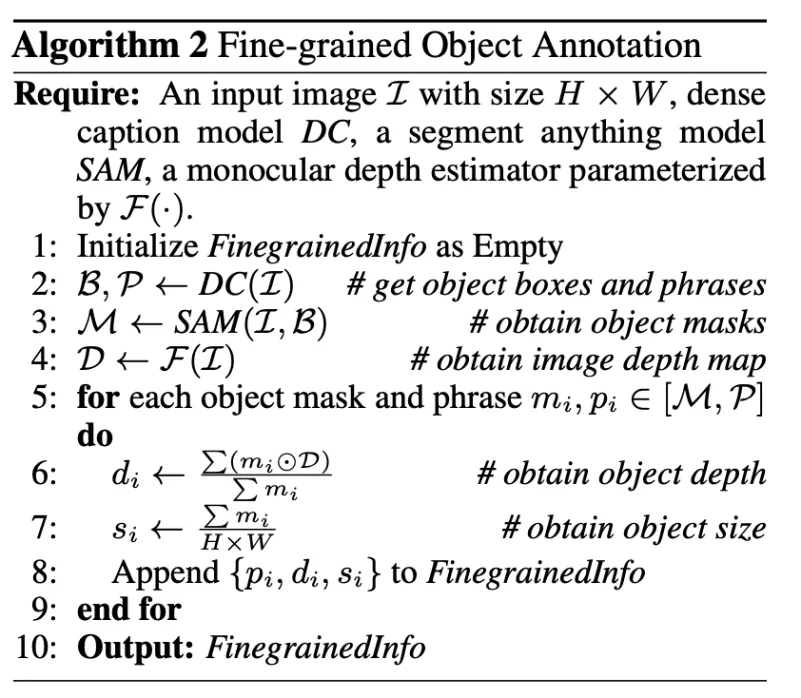

在視覺端,我們利用在高分辨率圖片上訓練出來的各個任務上的視覺專家模型提取圖像中的細節信息。想要將一個圖片上的物體的細節信息利用文本表達出來僅僅用物體的 caption 是不夠的,我們首先利用提取這些物體的 bounding box 來把這些物體的左右關系給用文本的方式體現出來。但圖片中的物體不僅僅有左右信息,還有前后信息。對此,我們首先利用分割模型將這些物體的 mask 給提取出來,再將原本的圖片轉化為深度圖,通過計算深度圖中特定物體 mask 對應的深度分數來將深度信息由文本體現出來。至此,我們能利用文本還原出圖片中各個物體的大小,左右位置,前后關系等細節信息。

3. 文本化重述(Textualized Recaptioning):結合前兩個階段的圖片信息文本化的結果,加上我們通過精心設計的改寫 prompt,純文本的大語言模型能夠很好的通過純文本還原出圖片的信息,并通過強大理解和推理能力生成詳細且準確的圖像描述。

全面評估與實驗驗證

為了驗證我們框架的有效性,我們構建了三個評估基準,分別是 DID-Bench(詳細圖像描述基準)、D2I-Bench(描述到圖像基準)和 LIN-Bench(語言基準)。我們進行了廣泛的實驗,結果表明 IT 框架生成的圖像描述在細節豐富度和準確性方面顯著優于現有方法。尤其是,通過我們的 IT 框架生成的數據集訓練的 MLLMs,如 LLaVA-7B,展現出了更強的圖像描述能力,減少了幻覺現象。

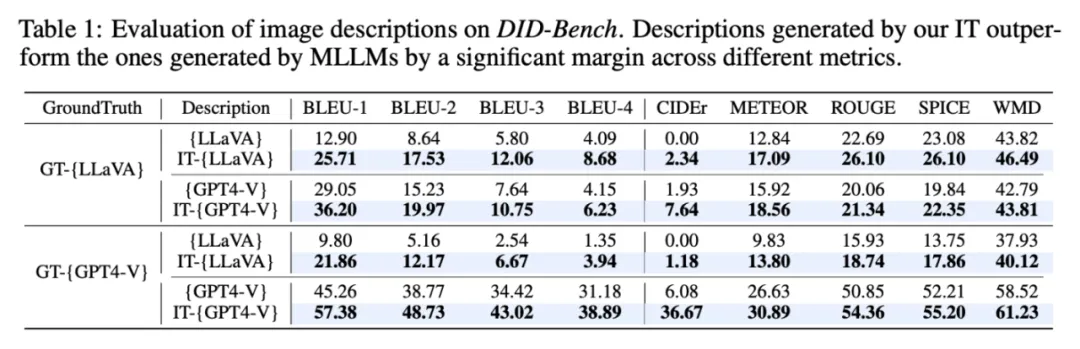

DID-Bench(詳細圖像描述基準):用于評估圖片描述和人類手動標的詳細的圖片描述的相似性。可以看到我們的修改后的 IT-{LLaVA} 和 IT-{GPT4-V} 圖片描述都比修改前的要更詳細和準確,更貼合人類標注出來的描述。

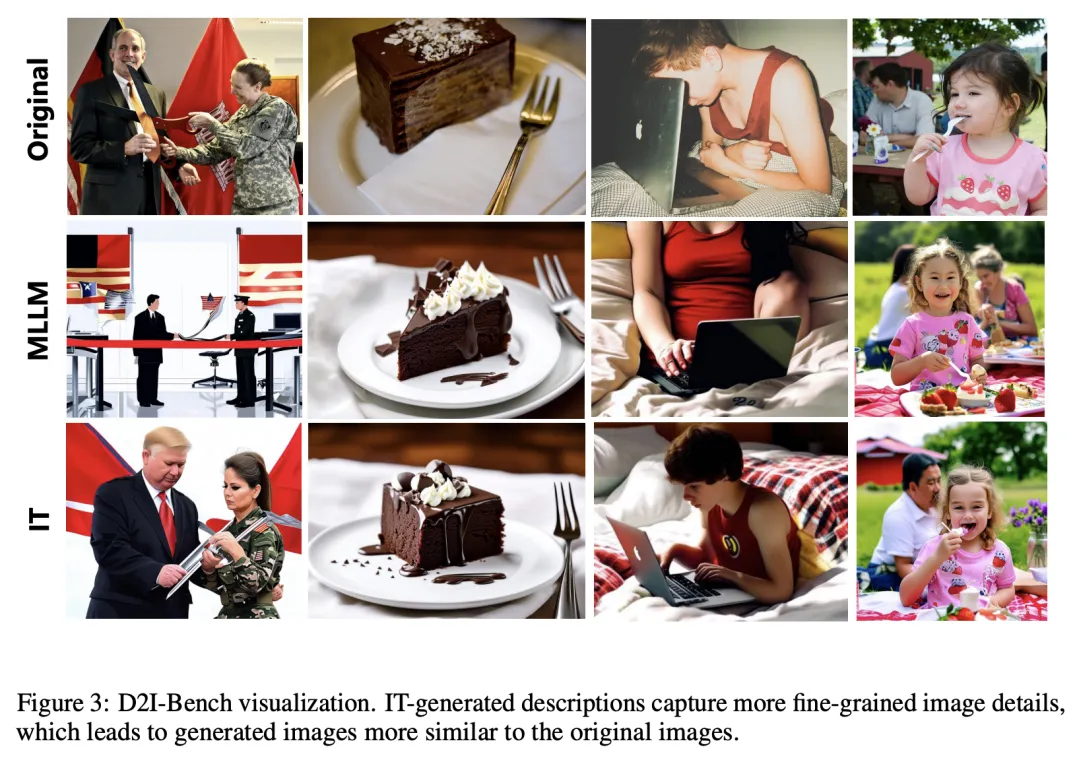

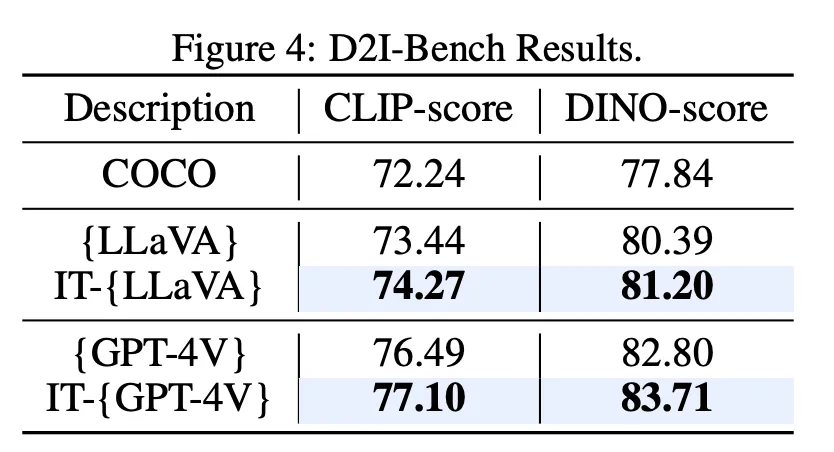

D2I-Bench(描述到圖像基準):利用文生圖模型將生成的描述轉化為圖片,和原圖進行相似度的對比,這里我們選取了 CLIP-score 和 DINO-score 進行評估,都能達到更高的分數。

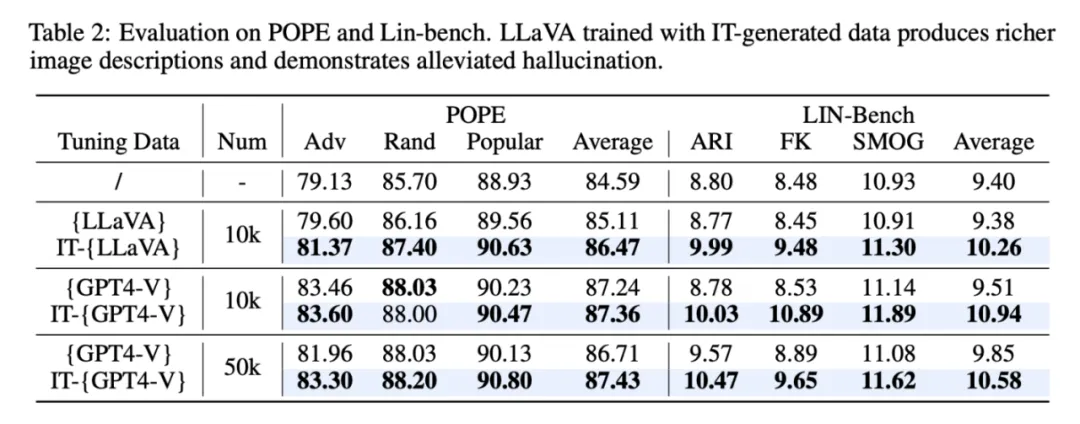

另外我們還在 POPE 和 LIN-Bench 上驗證了利用我們框架生成數據進行訓練的 LLaVA-7B 能夠在生成描述更詳細更復雜的情況下(表右側 LIN-Bench),還能降低幻覺(表左側 POPE 基準)。

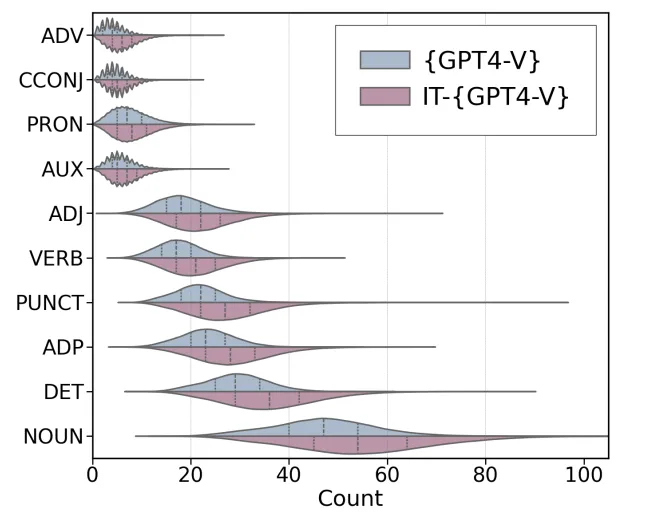

最后,我們對生成出的數據進行了統計上的對比,可以看到我們修改后的描述中各個詞性的數量上都能有較大的提升。

未來展望

我們的工作不僅解決了現有圖像描述數據集的局限性,也為設計更高效、可擴展的方法提供了靈感。我們期待 IT 框架在更多應用領域中展示其潛力,推動圖像理解和生成技術的進一步發展。

本文轉自 機器之心 ,作者:機器之心