Stable Diffusion這樣的文本-圖像生成模型有記憶嗎? 精華

Stable Diffusion擴散模型作為生成高質量圖像的先進模型,卻伴隨著對訓練數據的記憶化傾向,引發了隱私和安全性的擔憂。AIGCer分享一篇分析該現象的文章,通過兩個案例研究深入挖掘了文本復制現象,旨在為未來生成模型的改進提供重要的指導。

基于擴散模型,如Stable Diffusion模型,以其生成高質量、高分辨率圖像的能力,已經在文本到圖像合成領域引起了革命。這些進展推動了圖像生成和編輯任務的顯著進展。然而,這些模型也引發了一些擔憂,因為它們有記憶和潛在復制訓練樣本的趨勢,從而帶來隱私風險并可能導致對抗性攻擊。在訓練數據集中的重復被認為是導致記憶的主要因素,迄今為止已經研究了各種形式的記憶。本文關注于兩種不同且鮮為人知的復制類型,這些類型在擴散模型中在推斷過程中導致了復制,特別是在Stable Diffusion模型中。通過兩個案例研究深入探討了這些較少研究的復制現象及其影響,旨在為生成模型在各種應用中的更安全、更負責任的使用做出貢獻。

引言

基于擴散的模型展示了在生成高質量圖像方面的出色能力,無條件生成和有條件生成皆如此。Stable Diffusion模型作為一種有條件擴散模型,與其他生成模型如DALLE-3和Midjourney一同,顯著推動了文本到圖像生成領域的發展。這些模型在創建高分辨率圖像和圖像編輯方面表現出色。

機器學習模型中的記憶化已經得到廣泛研究。這種記憶化可能帶來隱私風險,潛在地可能導致成員關系推斷或數據提取等攻擊。盡管擴散模型,包括Stable Diffusion模型,具有生成高質量圖像的能力,它們有時表現出對精確訓練樣本或其重要部分的記憶和復制的趨勢。Somepalli等(2023b)指出,與僅包含圖像的上下文相比,文本條件更容易導致記憶。先前的研究表明,在推斷過程中,訓練樣本的復制可能是這種復制的一個重要原因。

本文深入研究了兩種特定類型的文本條件訓練樣本復制:第一種涉及圖像及其相應文本(包含特定關鍵詞)的復制;第二種涉及圖像-文本對的復制,其中圖像包含特定對象,而文本包含特定關鍵詞。這種微妙的復制形式可能加劇模型對各種攻擊的脆弱性。隨著文本到圖像生成模型的日益普及,詳細審查它們的記憶傾向變得越來越重要。通過分析兩個案例研究,本文探討了這兩種復制類型,以揭示它們的動態和影響。

相關工作

「大型語言模型中的記憶化」

在大語言模型(LLMs)領域,由于無意中泄露了導致模型記憶的機密信息,因此面臨著越來越大的挑戰。Carlini等通過定量方法進行深入分析,之前利用定性技術進行研究。導致這種情況的一個關鍵因素是訓練數據集中固有的復制,可能導致語言模型生成與已存在內容相似的文本。Biderman等(2023)最近的貢獻表明,這種記憶化是由于訓練數據集的平均值,而Biderman等(2023)則說明其發生在特定的訓練數據點上。

「擴散模型中的記憶化」

最近的研究展示了使用有條件和無條件擴散模型創建相似或幾乎相同圖像的技術。具體而言,Somepalli等(2023a)強調,擴散模型可以生成具有與訓練數據中相似對象的圖像,這個過程被稱為“復制”。與此同時,Carlini等(2023)展示了模型通過分析生成樣本的聚類,從訓練集中檢索幾乎相同的圖像的能力。Somepalli等(2023b)最近的研究認為,在無條件擴散模型中,由于復制而導致的數據復制可能較少,而文本條件可能顯著增加模型記憶化的可能性。在重復發生這種記憶化的前期研究中,Webster等(2023)引入了一種算法方法來檢測這種重復。

背景

「擴散模型」

在深度生成模型的背景下,去噪擴散概率模型,通常稱為無條件擴散模型,通過迭代進行噪聲添加(正向過程)和隨后的噪聲移除(反向過程)來生成圖像。

「Stable Diffusion」

在Rombach等人的研究中(2022),"Stable Diffusion"模型專門用于文本到圖像合成任務。該模型通過擴散圖像的潛在向量表示。它首先接收文本輸入,然后通過凍結的CLIP文本編碼器將其轉換為文本embedding。隨后,一個文本條件的潛在U-Net迭代地去噪潛在向量,其方式是根據生成的文本embedding進行條件化。最后,一個變分自編碼器(VAE)解碼這個潛在向量,生成相應的圖像。

word級復制

Somepalli等人(2023b)研究了LAION數據集中更廣泛范圍的復制,涵蓋比以前的研究更多的情況。他們考慮了字幕和圖像的復制,甚至深入研究了部分字幕的復制。然而,對于他們的方法存在一些擔憂。他們從LAION數據集中篩選出兩個子集,用于對Stable Diffusion模型進行微調。在其原始預訓練數據集的子集上對Stable Diffusion進行微調可能導致意外的記憶化增加。

在文本條件的擴散模型中,文本起著關鍵作用。基于這一觀點,對這些應用的主要關注應圍繞文本條件的記憶化。雖然數據集中可能存在圖像的復制,但如果文本與圖像之間沒有關聯,那么在推斷時,在提供提示時不太可能出現相關的復制。這一觀察引導我們考慮更現實類型的復制。

與先前的研究不同,作者的重點是單word 級的復制。具體而言,目標是識別在復制中關鍵詞和圖像之間是否存在關聯。作者質疑在數據集中是否一致復制了某些關鍵詞和圖像集。在這種情況下,字幕不一定表現出高語義相似性;它們可能只共享共同的關鍵詞。因此,在推斷時,當模型遇到這些特定關鍵詞的組合時,它可能會嘗試復制在訓練期間觀察到的相應特征或對象。在實驗結果中,通過對LAION數據集進行詳細案例研究進一步探討了這種類型的復制。

「定義記憶化的更現實方法」

先前的研究通常依賴于單一隨機初始化進行生成。然而,無論使用何種記憶化定義,更現實的檢查方法涉及使用多個隨機初始化。實際設置中,如果模型在不同初始化中始終生成相同的特征、對象或甚至整個圖像,就會出現對記憶化和復制的擔憂。因此,基于單一種子進行的記憶化或復制評估可能無法提供全面的理解。

對象級復制

在這一部分,介紹了一種稱為對象級復制的獨特復制類型。當在訓練數據集中出現一對特定圖像中的對象和相應文本中的某些關鍵詞時,即使對象的名稱在文本中沒有出現,也會發生對象級復制。這種復制可能導致在推斷時,當提示中存在相關關鍵詞時,這些特定對象的復制。這種復制模式引發了各種可信度問題,尤其是隱私和公平性。基本上,它意味著模型不論在用戶提供的輸入中是否提及或缺失,都會持續生成特定對象,這可能與用戶的期望或意圖不符。

這種現象的一個可能解釋是圖像中的某些關鍵詞和對象之間的隱含關聯。也就是說,在訓練數據集中可能不會復制整個圖像,但是特定對象可能經常出現在與包含特定單詞的字幕相關的圖像中。將在實驗部分通過一項專門的案例研究深入探討這一現象。

實驗結果

在這一部分,展示兩個案例研究,分別對應之前討論的兩種復制類型,并在每個研究中加入多個示例。對于所有實驗,使用了LAION-400M(Schuhmann等人,2021),這是較大的LAION-5B(Schuhmann等人,2022)數據集的一個子集。選擇這個子集是因為它在規模上更易管理。實驗使用了在LAION-5B數據集上訓練的Stable Diffusion v1.4模型。

「案例研究1:梵高」

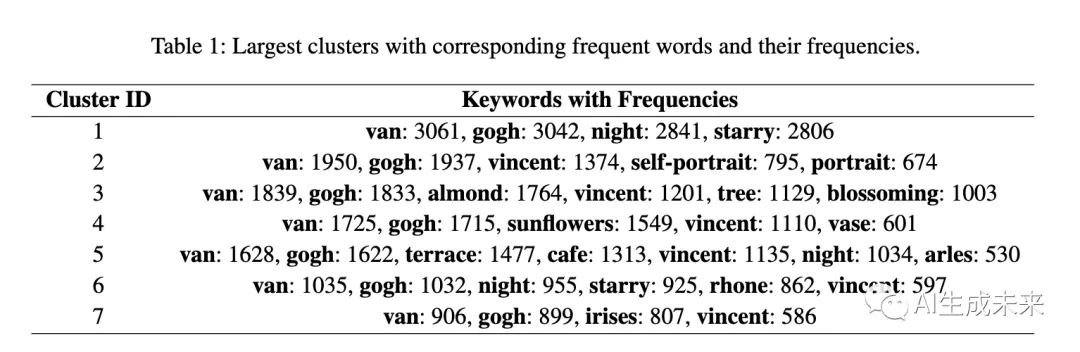

在初始案例研究中,深入研究了單word 級記憶化。為此,關注了帶有包含術語“梵高”字幕的樣本。大約有90,000個樣本的字幕中包含這個術語。繼續排除帶有無效URL的樣本。此外,考慮到CLIP模型的文本編碼器接受的文本長度不超過77個標記,超過這個標記數的字幕樣本也被省略。在經過這些過濾步驟后,剩下大約70,000個樣本。此外,使用CLIP模型的圖像編碼器獲取了這些樣本的圖像embedding。

在下一步中,對圖像embedding進行聚類,利用余弦相似度來識別一組幾乎相同的圖像。然后根據它們的大小對聚類進行排序,并在每個聚類中,找出最頻繁出現的單詞。應注意,最大的聚類由于包含與其他聚類不太相關的無關圖像,已經被省略在分析之外。下表1呈現了最大的聚類以及它們對應的頻率單詞。

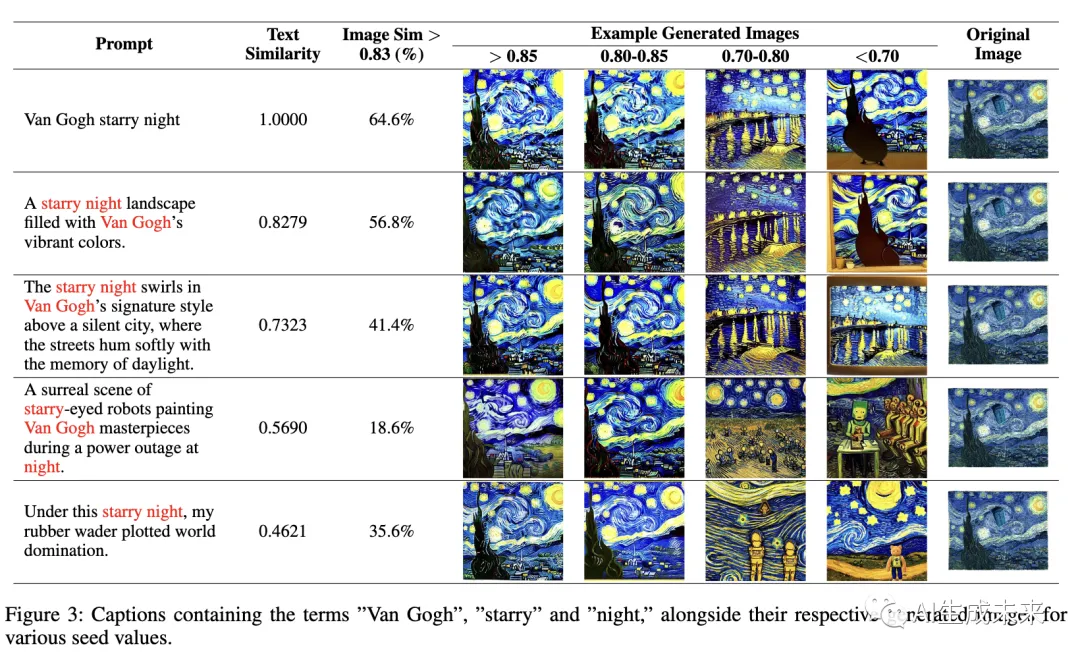

演示這些關鍵詞如何影響每個聚類中生成的圖像。對于每組關鍵詞,考慮以下字幕:

? 僅由關鍵詞組成的字幕。

? 包含關鍵詞的簡短相關字幕。

? 包含關鍵詞的長相關字幕。

? 包含關鍵詞的無關字幕。

? 不包含術語“van gogh”的長字幕。

使用ChatGPT(OpenAI 2023)獲得所有這些字幕。下圖3中展示了聚類1的所有字幕及其相應生成的圖像。

為了更好地說明復制的概念,對于每個提示,作者使用不同的隨機初始化生成500張圖像。提供演示與訓練數據集中原始圖像相似程度不同的示例。此外,對于每個聚類,都建立了一個唯一的圖像相似性閾值,以確定與訓練數據集中原始圖像相似的生成的百分比。這個閾值在聚類之間變化,并需要根據每個聚類的特定特征進行手動設置。

如上面圖3所示,實驗從簡短的提示開始,逐漸發展到更長、更多樣的字幕。盡管在文本變化的情況下,圖像始終保持原始藝術品的風格和元素。在第四個例子中,即使“starry”和“night”分開,圖像仍然共同代表這些主題。有趣的是,最后的字幕省略了“Van Gogh”,但他獨特的風格在圖像中無疑地被捕捉到。此外,使用CLIP的文本編碼器embedding計算給定提示與訓練數據集中最接近的文本之間的余弦相似度。

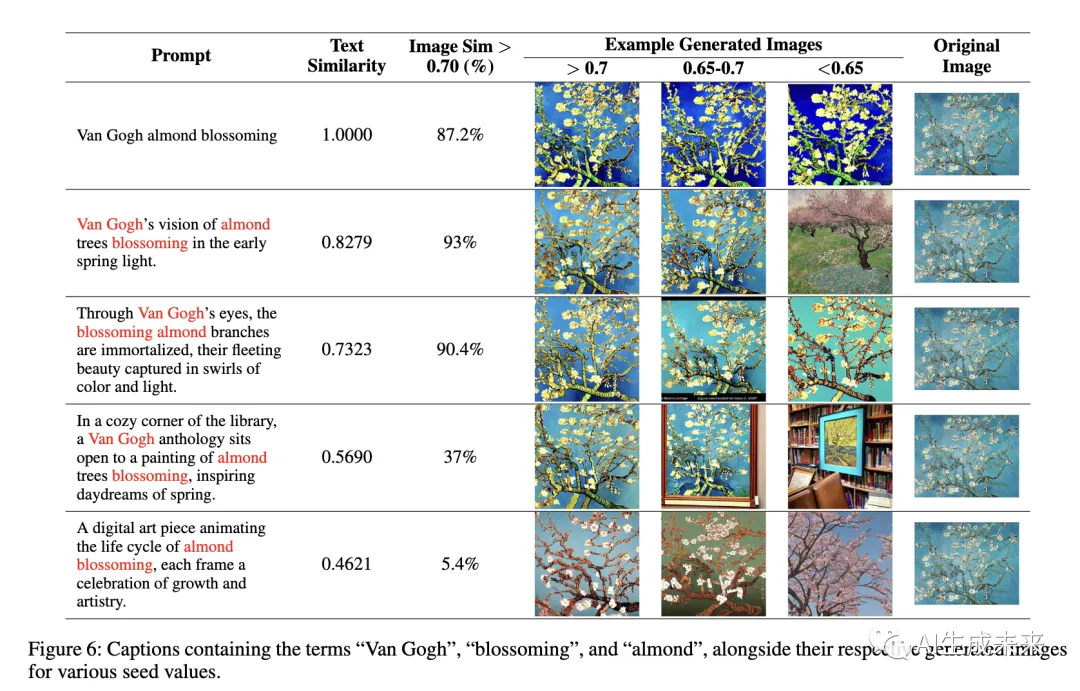

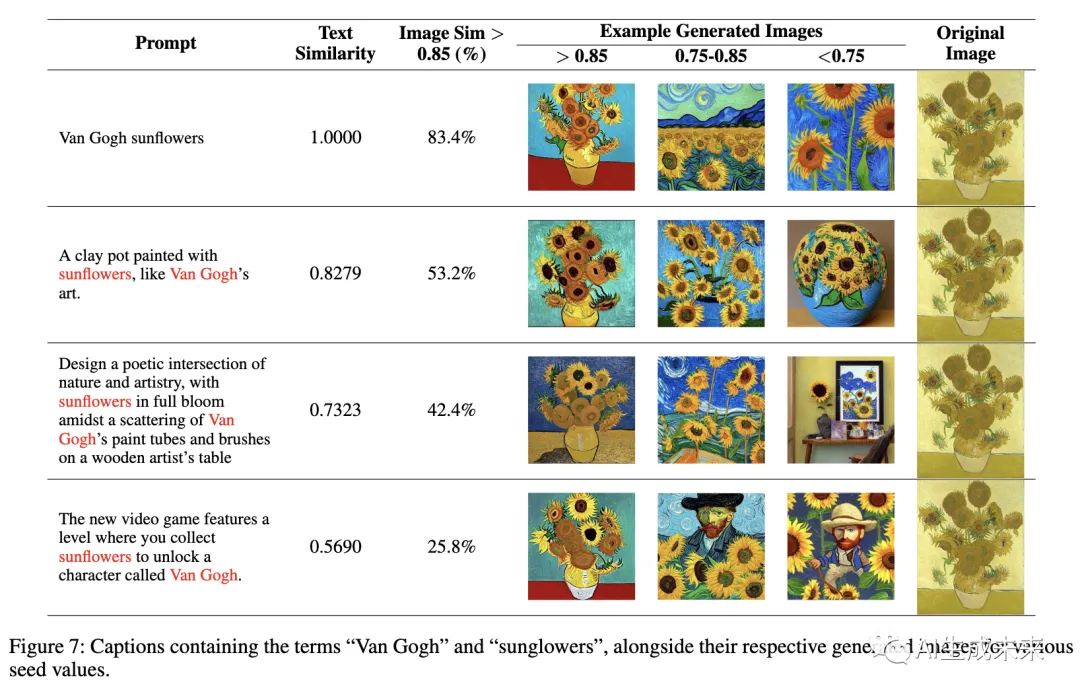

除了圖3中顯示示例的聚類外,還有另一個具有引人入勝結果的聚類。在前面表1中顯示的Cluster 3中,關鍵詞包括“van gogh”、“almond”和“blossoming”。有關此聚類的所有字幕及其相應生成的圖像在下圖6中說明。圖6中的最后一個例子說明,即使沒有明確提到“van gogh”,生成的圖像仍與與Van Gogh的作品相關的訓練數據集中的圖像相似。此外,可以在下圖7中找到Cluster 4的字幕和相應生成的圖像。

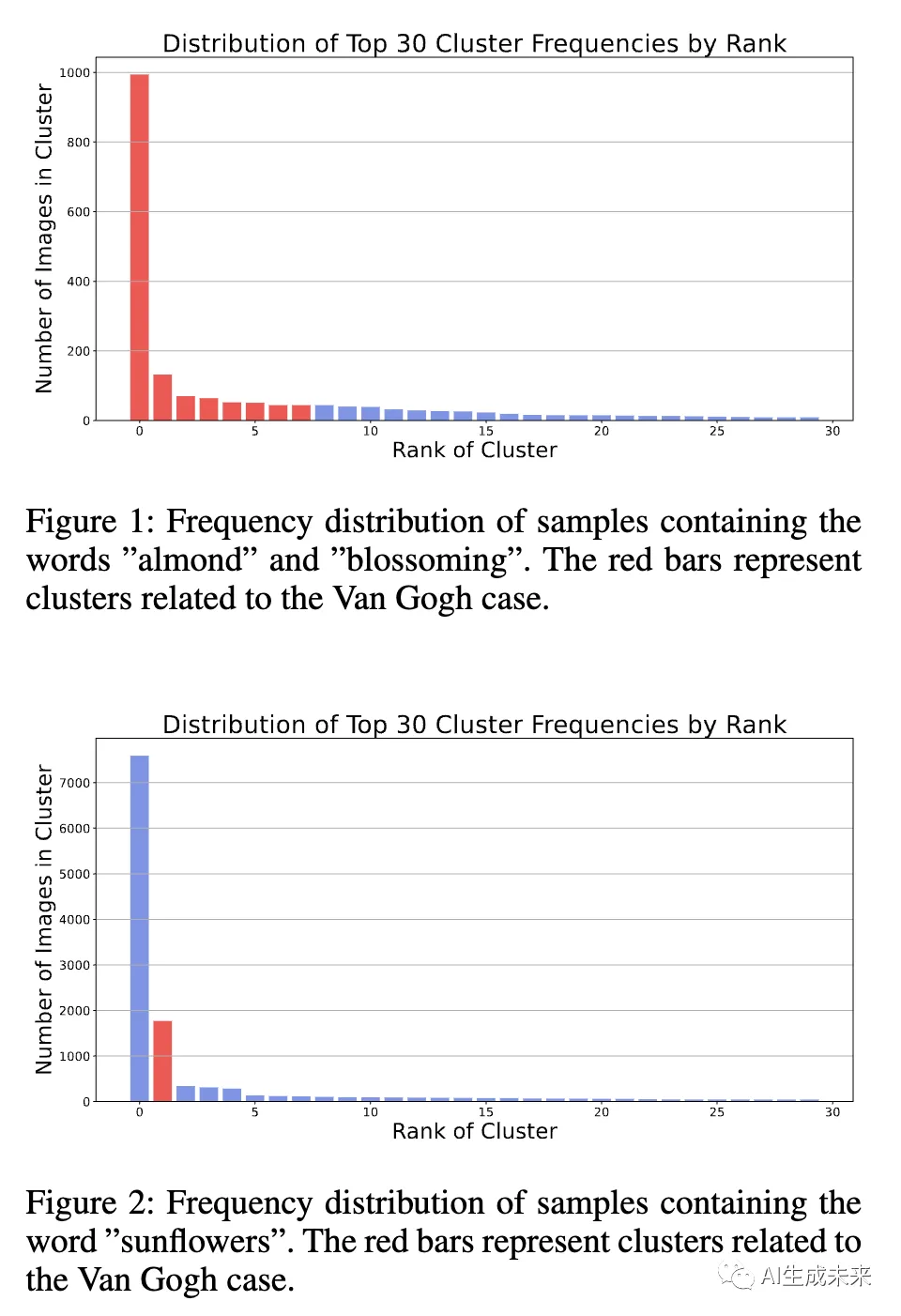

為了理解這一現象,分析了“almond”和“blossoming”這兩個詞在帶有“van gogh”的字幕中有多頻繁。通過過濾帶有“almond”和“blossoming”的字幕的數據集,然后使用圖像embedding對圖像進行聚類,發現這兩個描述性詞語占據了與Van Gogh的作品相關的主導聚類,約占帶有這兩個描述性詞語的條目的52%。

「頻率至關重要」。在推斷過程中,影響訓練圖像復制可能性的兩個主要因素。第一個因素是數據集中特定關鍵詞的頻率。觀察表明,當圖像與頻繁出現的關鍵詞相關聯時,它們更有可能復制。例如,“almond”和“blossoming”以及“Van Gogh”,這幾個詞具有更高的復制傾向。

然而,僅有頻率并不是唯一的決定因素。另一個有影響力的因素是數據集的初始聚類。當對帶有特定關鍵詞的圖像進行聚類時,比如“almond”和“blossoming”,而不包括“Van Gogh”時,發現最大的聚類仍然與梵高的作品相關,約占樣本的52%。盡管如此,有顯著的48%的聚類與之無關。這種分布表明,在訓練集中的關鍵詞頻率在一定程度上可以預測模型的復制行為。關鍵詞“向日葵”進一步證明了這一點;盡管它與梵高經常相關,但在僅考慮數據集中的“向日葵”時,它僅占聚類的2%。這強調了為什么除非明確提到梵高的名字,否則梵高的藝術風格可能不會被復制。下圖1展示了當對包含“almond”和“blossoming”這兩個詞的樣本的圖像進行聚類時,30個最大聚類的分布大小。下圖2展示了同樣的情況,但是對于詞匯“sunflower”。

「案例研究2:宇航員」

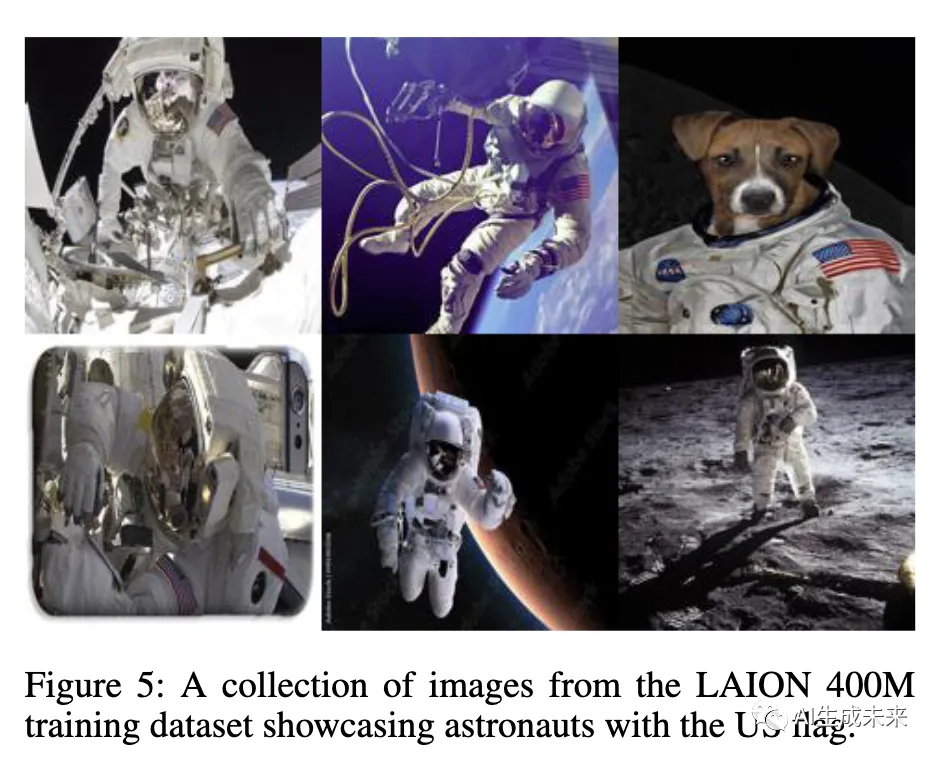

在這一部分,通過一個專注的案例研究探討對象級復制的概念。對象級復制指的是盡管與相關的文本提示中缺少這些對象,但特定對象在圖像中經常出現的現象。這意味著在數據集中,特定關鍵詞與重復出現的視覺元素之間存在強烈的相關性。為了研究這一現象,作者關注包含關鍵詞“astronaut”的LAION數據集中的樣本。作者應用與初始案例研究相同的方法框架來策劃數據集的這個子集,并生成相應的圖像embedding。這個過程產生了大約48,000個樣本,對關鍵詞-對象相關性的調查提供了實質性的基礎。下圖5呈現了一些這些訓練樣本,它們的字幕包含詞語“astronaut”,相應的圖像中包含美國國旗。

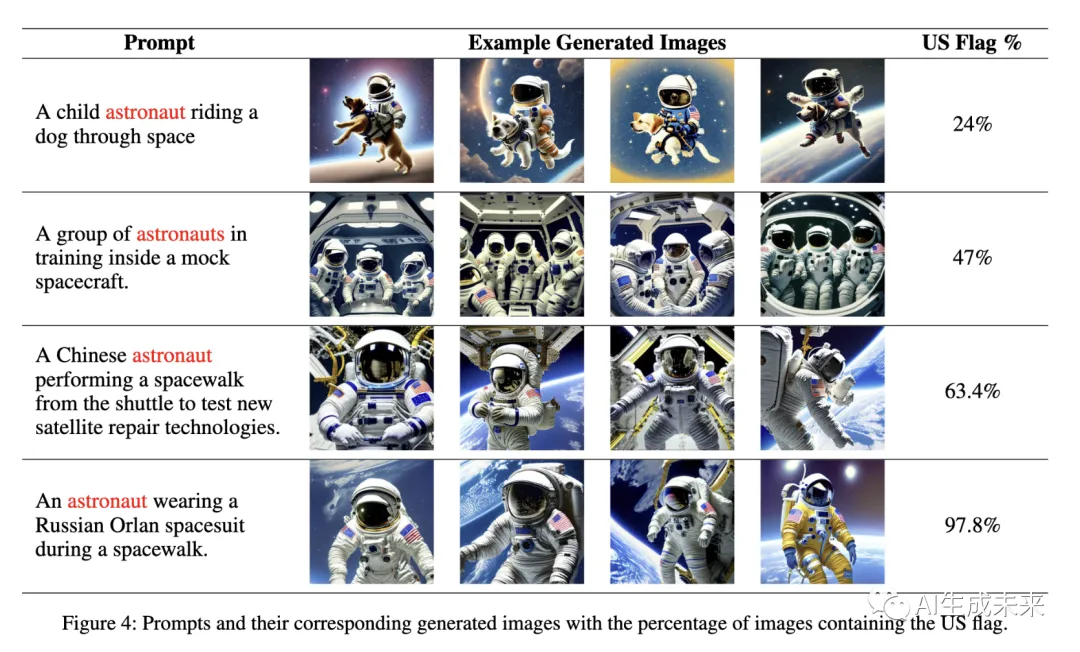

在這個案例研究中,作者關注美國國旗。對大約1000個帶有提到“astronaut”字幕的訓練數據樣本的分析顯示,即使沒有明確指定“US”或“flag”這兩個詞,有10%的樣本包含美國國旗的圖像。為了進一步探討這一現象,首先使用ChatGPT創建了一系列包含詞語“astronaut”的隨機提示。然后,使用這些提示在Stable Diffusion模型中生成圖像,導致在輸出中頻繁復制美國國旗。請注意,由于預訓練的Stable Diffusion模型生成質量較低,我們對該模型進行了微調,使用Midjourney API的一小部分提示和相應的高分辨率生成的圖像,以提高生成示例的質量。下圖4顯示了ChatGPT生成的提示和Stable Diffusion模型生成的相應圖像。

通過使用不同的隨機種子生成500張圖像,評估模型從提示中復制美國國旗的傾向。隨后,計算并報告包含美國國旗的圖像的百分比。

未來方向

盡管本文的研究集中在兩個特定的案例研究上,但已經證明了在Stable Diffusion模型中發生了word 級復制的現象。對于未來的工作,作者建議在word 級復制的背景下進行更廣泛的實驗,并進行更全面的分析。此外,開發新的緩解技術,減少記憶而保留模型效用,具有至關重要的意義。本文研究中發現的復制特征還可能帶來潛在的隱私風險,可能使模型容易受到各種攻擊,包括成員關系推斷和后門攻擊。解決這些問題將是未來研究的一個關鍵方面。

結論

在生成模型的記憶過程中,訓練數據中的復制是一個重要的促成因素。本文確定了兩種在推斷中導致復制的復制類型。通過兩個LAION數據集的案例研究對這些進行了調查。本文的工作強調了對訓練數據中不同復制形式的警惕性以及需要有效緩解策略的重要性。希望這項工作能夠激發更加慎重的數據管理,并促使開發既強大又保護隱私的生成模型。

本文轉自 AI生成未來,作者:AI生成未來