視頻生成更高質量,更連貫!關鍵幀插值創新技術——Generative Inbetweening開源

文章鏈接:https://arxiv.org/pdf/2408.15239

git鏈接:https://svd-keyframe-interpolation.github.io/

亮點直擊

- 關鍵幀插值的創新方法:提出了一種基于現有預訓練圖像到視頻模型的適應方案,以解決關鍵幀插值問題,即在兩個輸入關鍵幀之間生成連貫的視頻序列。

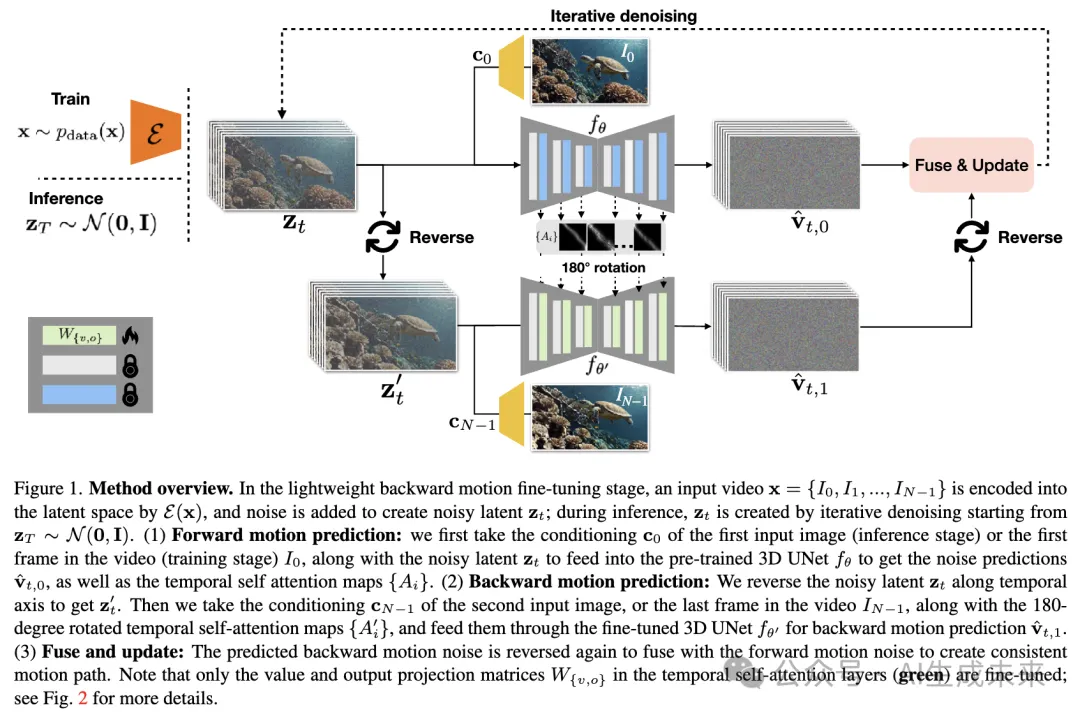

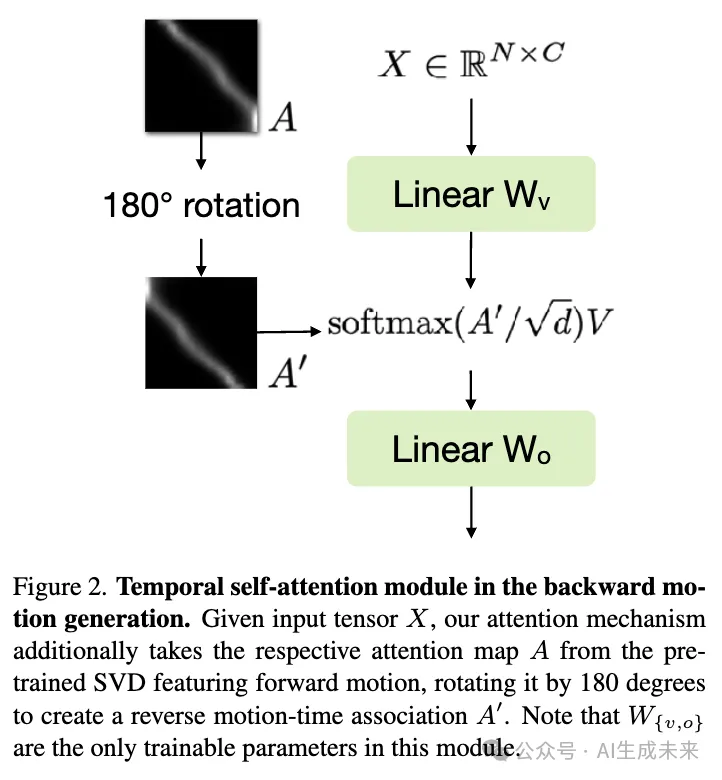

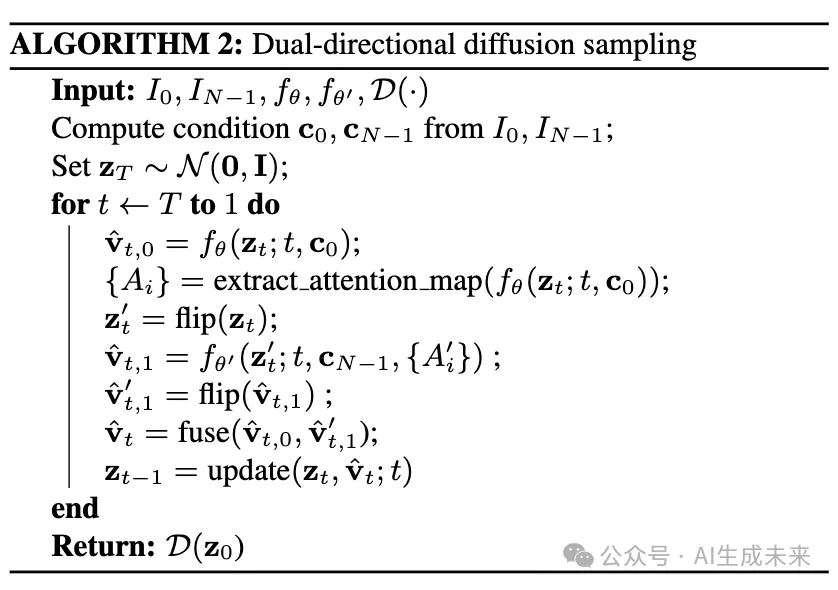

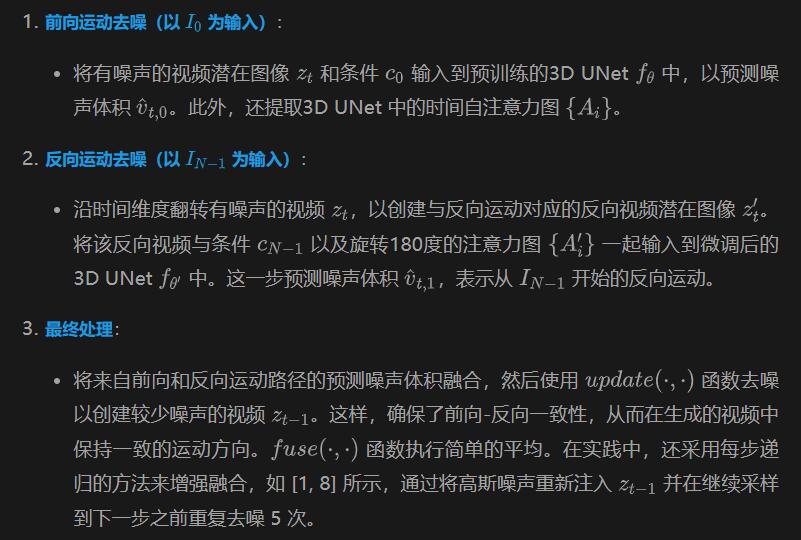

- 雙向運動預測機制:開發了一種新的方法,通過將現有圖像到視頻模型微調為能夠生成反向運動的視頻,實現了從單一圖像生成反向運動的視頻。提出了一種輕量級的微調機制,通過旋轉時間自注意力圖來逆轉時間流,從而在現有模型中引入反向運動的能力。

- 雙向采樣融合:提出了一個雙向采樣機制,將前向和反向運動的預測結果融合,以生成一個一致的、連貫的插值視頻。這個機制通過共享的旋轉時間自注意力圖實現前后運動的一致性(“前向-反向運動一致性”)。

- 高質量視頻生成:通過對比定性和定量的實驗結果,證明了該方法在關鍵幀插值任務中比現有方法和傳統技術生成的動態效果更高質量,更具連貫性。

總結速覽

解決的問題

在給定的兩個關鍵幀之間生成具有連貫運動的視頻序列。

提出的方案

通過對一個預訓練的大規模圖像到視頻擴散模型進行輕量級微調,將其適應為關鍵幀插值模型。這種適應使得模型可以生成在兩個輸入幀之間的視頻序列。具體而言,將模型調整為從單一輸入圖像預測反向運動的視頻,并結合原始前向運動模型,使用雙向擴散采樣過程來融合從兩個關鍵幀出發的模型估計結果。

應用的技術

- 預訓練大規模圖像到視頻擴散模型:原本用于從單一輸入圖像生成前向運動的視頻。

- 輕量級微調:將預訓練模型調整為能夠生成從單一輸入圖像反向運動的視頻。

- 雙向擴散采樣過程:結合前向和反向運動模型的估計結果來生成最終的視頻序列。

達到的效果

該方法在生成視頻序列時,比現有的擴散方法和傳統的幀插值技術表現更好,能夠在兩個關鍵幀之間生成更連貫的運動。

方法

通過自注意力圖旋轉逆轉運動時間關聯

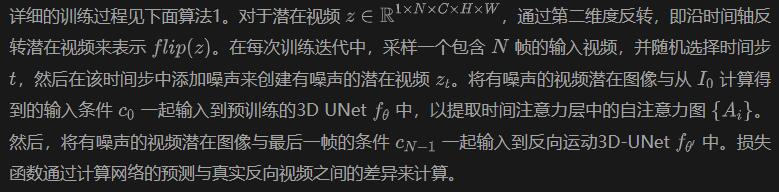

輕量級反向運動微調

雙向采樣與前向-反向一致性

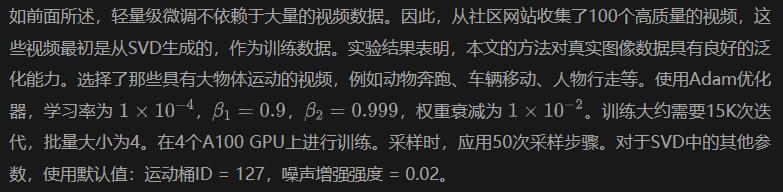

實施細節

實驗

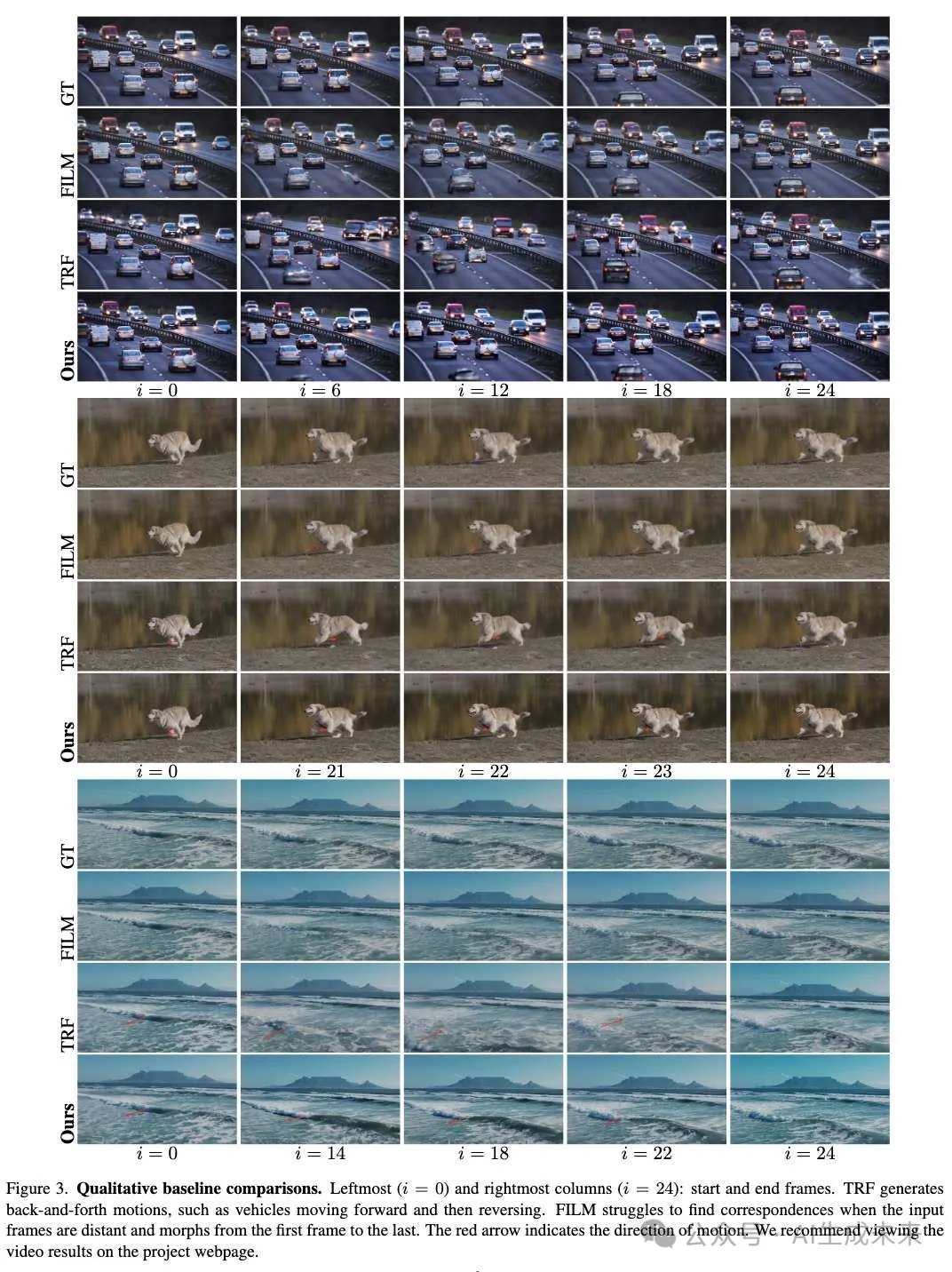

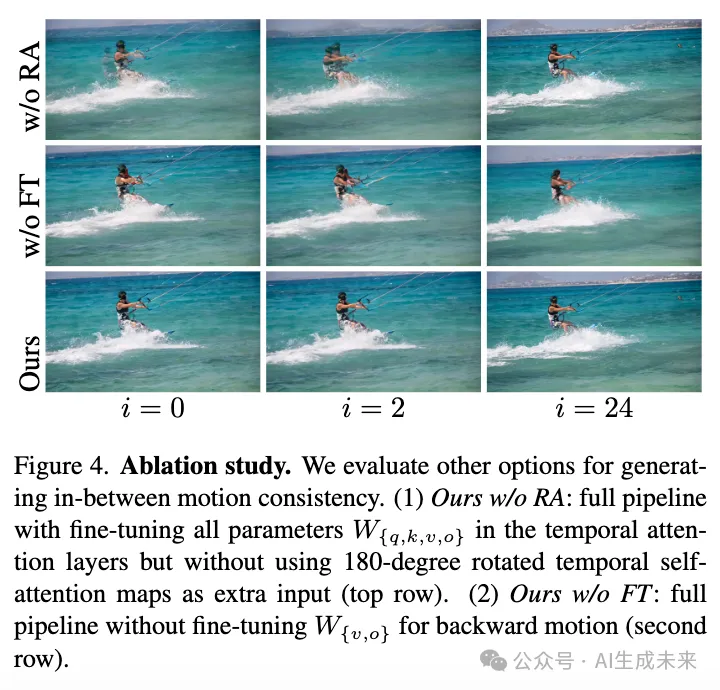

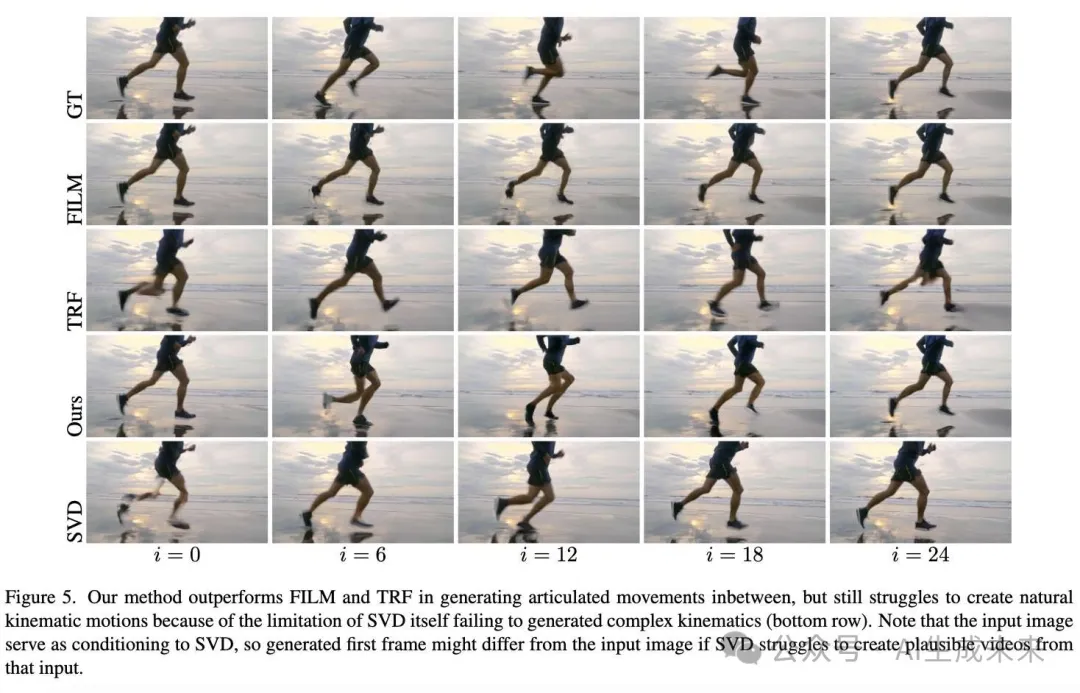

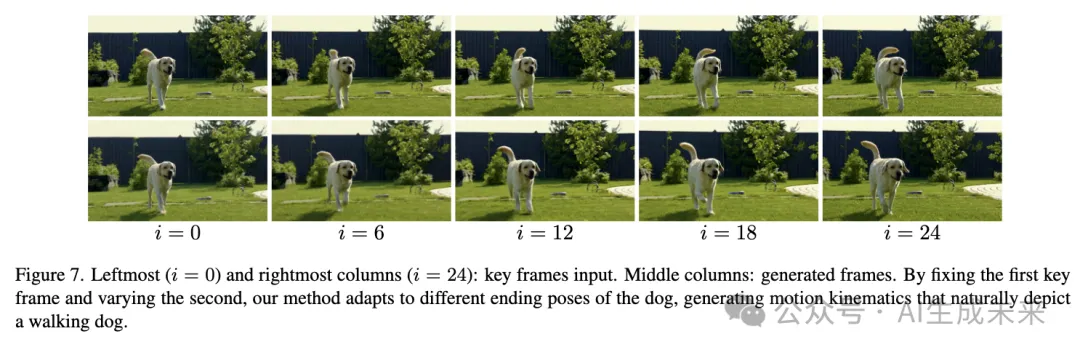

在下面圖3、圖4、圖5、圖7中,展示了本文的方法成功生成了高質量的視頻,并且在不同時間捕捉動態場景的關鍵幀之間運動一致。強烈建議在項目頁面上查看視頻結果,以更清晰地看到結果。本章節先描述了用來評估本文的方法和基線的數據。再展示了本文的方法如何優于傳統的幀插值方法FILM,以及最近的工作TRF,該工作也利用SVD進行視頻生成。通過消融研究證明了本文的設計決策。以及討論了本文的方法在最佳場景下的表現以及在亞最佳場景下的表現,即雖然優于基線但仍受SVD本身的限制。展示了本文的方法的適應性,通過固定第一個關鍵幀并變化第二個關鍵幀。最后討論了失敗案例。

評估數據集

使用了兩個高分辨率(1080p)數據集進行評估:

- Davis數據集,從所有視頻中創建了總共117對輸入。這些數據集主要特征是對象的關節運動,例如動物或人類動作。

- Pexels 數據集,從Pexels上的高分辨率視頻中收集了總共45對輸入關鍵幀對,特征包括方向性的動態場景運動,例如車輛移動、動物、人物奔跑、沖浪、波浪運動和延時視頻。所有輸入對之間至少相隔25幀,并具有相應的真實視頻片段。

Baseline比較

將本文的方法與FILM進行比較,FILM 是當前大規模運動幀插值方法的最新進展,和TRF,TRF 也適配了SVD進行有限生成。在上面圖3和圖5中展示了代表性的定性結果。此外,還包括了近期工作DynamiCrafter 的關鍵幀插值特性結果——這是一個大規模的圖像到視頻模型。關鍵幀插值特性經過修改,并特別訓練以接受兩個結束幀作為條件,而研究者們則專注于如何以輕量級的方式適配預訓練的圖像到視頻模型,使用較小的訓練視頻集合和更少的計算資源。該特性生成分辨率為512X320的16幀視頻,而生成分辨率為 1024X576。

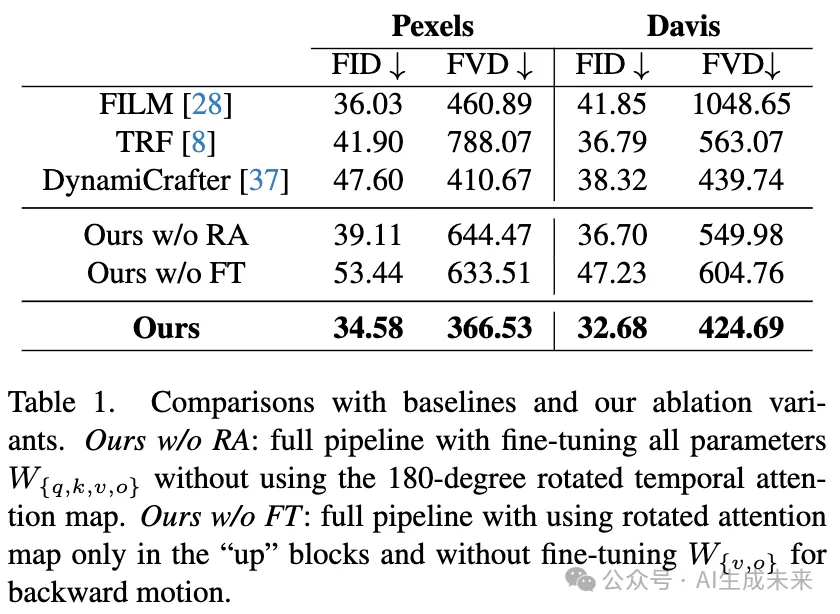

定量評估對于每個數據集,使用FID和 FVD來評估生成的視頻。這兩個指標用于衡量生成幀/視頻與實際幀/視頻之間的分布距離。結果如下表1所示,本文的方法在所有baseline方法中均顯著優于其他方法。

與FILM的比較基于流的幀插值方法FILM面臨兩個主要問題。首先,它在處理大運動場景時很難找到對應關系。例如,在上面圖3的第二行中,FILM在高速公路場景中無法找到移動汽車在輸入關鍵幀之間的對應關系,導致中間幀的運動不自然。例如,一些汽車在第一幀中消失,在中間幀中消失,最后在結束時重新出現。其次,FILM生成的運動不明確,會沿最短路徑在結束幀之間移動。在上圖5中的示例中,給定兩個看起來相似的幀,捕捉到的是一個人跑步的不同狀態,FILM生成的運動僅僅是將人平移到幀之間,喪失了自然的腿部運動。

與TRF的比較 TRF結合了從第一幀開始的前向視頻生成和從第二幀開始的反向視頻生成,這兩者都使用原始的SVD。第二幀的反向前向視頻生成了一個反向運動視頻,結束于第二幀。將這些生成路徑融合在一起會導致生成的視頻中出現往返運動。觀察到TRF生成的視頻有一個顯著的效果,就是視頻先向前推進,然后反向到結束幀。例如,在前面圖3的第三行中,可以看到紅色卡車隨著時間的推移向后移動;在第七行中,狗的腿向后移動,導致不自然的運動。相比之下,本文的方法通過對SVD進行微調,從第二幀生成反向視頻,與從第一幀生成的前向視頻方向相反。這種前向-反向運動一致性導致生成的視頻中運動保持一致。

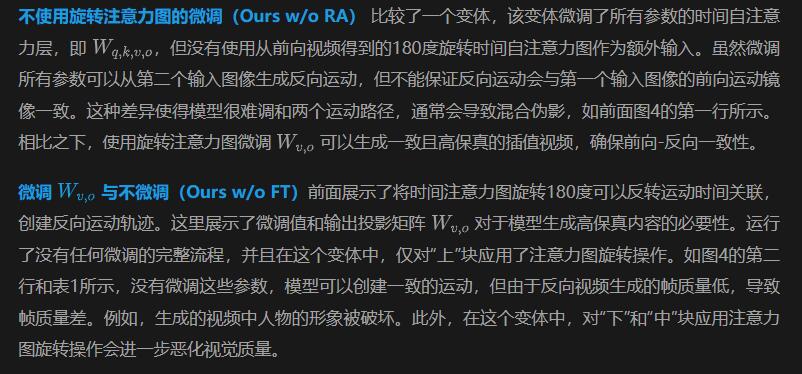

消融實驗

在前面圖4和表1中,展示了本文方法的簡化版本的視覺和定量比較,以評估本文方法關鍵組件的效果。

最佳和次佳場景

本文的方法受限于SVD所學習的運動質量和先驗知識。首先,實驗證明,SVD在生成剛性運動方面表現良好,但在處理非剛性、關節運動時表現不佳。它在準確渲染動物或人的肢體運動方面存在困難。在前面圖5中,盡管本文的方法相比FILM和TRF有了顯著改進,但與真實運動相比仍顯得不自然。底部行展示了僅使用第一個輸入幀生成的序列,確認了SVD本身在生成自然的跑步運動方面存在困難。

自適應中間幀生成

給定相同的第一個關鍵幀,并變化第二個關鍵幀,本文的方法仍能生成合理的視頻,這得益于大規模圖像到視頻模型的豐富運動空間(見前面圖7)。

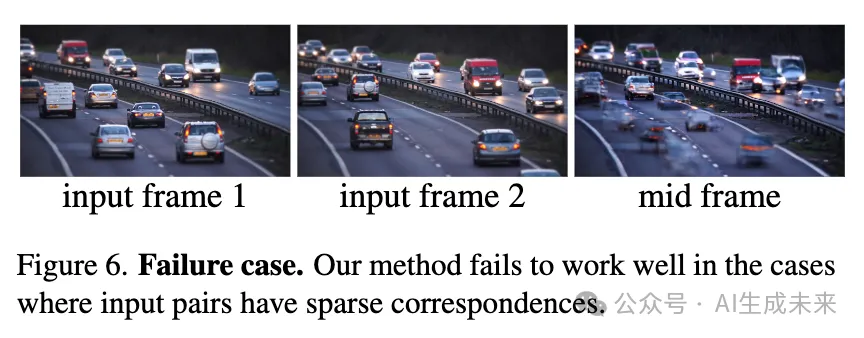

失敗情況

當輸入對的拍攝間隔過大,導致它們之間的對應關系稀疏時,如下圖6所示,僅有一小部分汽車出現在兩個輸入幀中,本文的方法很難融合前向和反向運動。在重疊區域最小的情況下,會導致中間幀出現偽影。

討論與局限性

本文的方法受限于SVD中的運動質量。另一個局限性是,SVD具有從輸入圖像中得出的強運動先驗,往往只生成特定的運動。因此,連接輸入關鍵幀所需的實際運動可能不會在SVD的運動空間中體現,從而使得合成合理的中間視頻變得具有挑戰性。然而,隨著大型圖像到視頻模型如SoRA3的進展,對未來能夠解決這些局限性持樂觀態度。另一種潛在的改進是使用輸入關鍵幀之間的運動啟發式,以引導圖像到視頻模型生成更準確的中間運動。

本文轉自 AI生成未來 ,作者:AI生成未來