首個多模態視頻競技場Video-MME來了!Gemini全面超越GPT-4o,Jeff Dean連轉三次

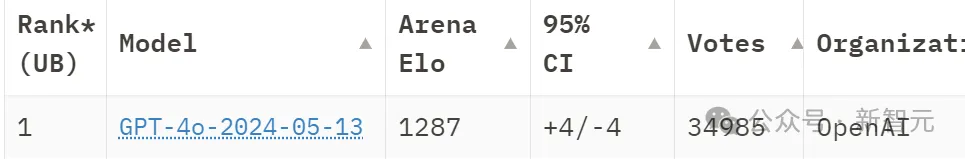

大模型性能哪家強?GPT-4一家常霸榜。

基準測試全擅長,競技場上見真章。

不過近日,谷歌的Gemini終于揚眉吐氣了一把,在全新的、更復雜的多模態考試中大獲全勝,全面超越了GPT-4o。

Jeff Dean表示:已閱,很贊。

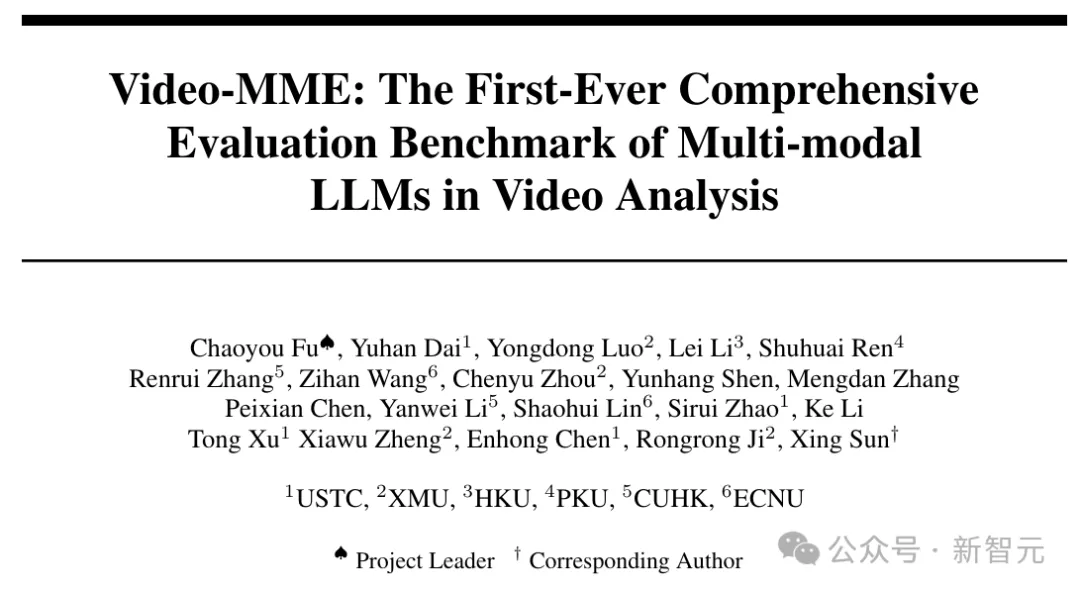

這就是來自中科大,廈大,港大,北大,港中文和華師大的研究者聯合奉獻的,世界上首個多模態LLM視頻分析綜合評估基準——Video-MME。

論文地址:https://arxiv.org/pdf/2405.21075

項目地址:https://video-mme.github.io/

在前往AGI的道路上,多模態大語言模型(MLLM)顯然成為當前的焦點。

不久前出世的GPT-4o,就在多模態的表現上技驚四座;同時,偏愛谷歌「雙子座」的網友也不在少數。

不過之前的相關基準測試,主要關注LLM在靜態圖像理解方面的能力。

而對于現實世界來說,處理連續視覺數據,也就是視頻的能力,是至關重要的。

Video-MME是有史以來第一個為視頻分析精心設計的,綜合多模態基準測試,幫助我們全面評估MLLM捕捉現實世界動態性質的能力。

Video-MME涵蓋了廣泛的視覺域、時長和數據模式,包括900個視頻,總時長256小時,還人工注釋了2700個高質量的問答對(多項選擇題,每個視頻3個)。

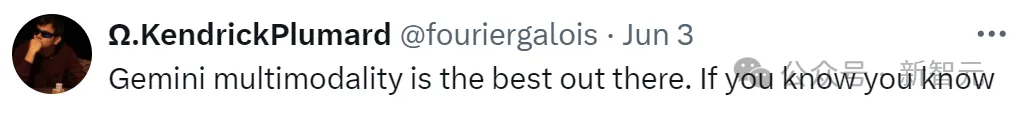

下圖是其中一個例子:

準確回答該問題需要同時從視頻幀、字幕or語音中同時獲取信息,并且信息直接的跨度達30分鐘

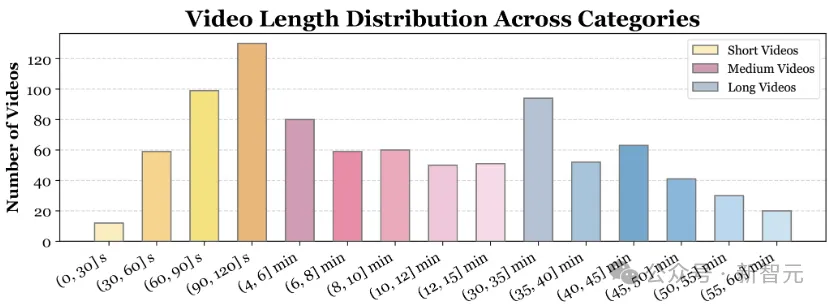

在時間維度上,Video-MME中收集了各種不同時長的視頻。

包括短視頻(< 2分鐘)、中視頻(4分鐘~15分鐘)和長視頻(30分鐘~60分鐘),總體時長從11秒到1小時不等。

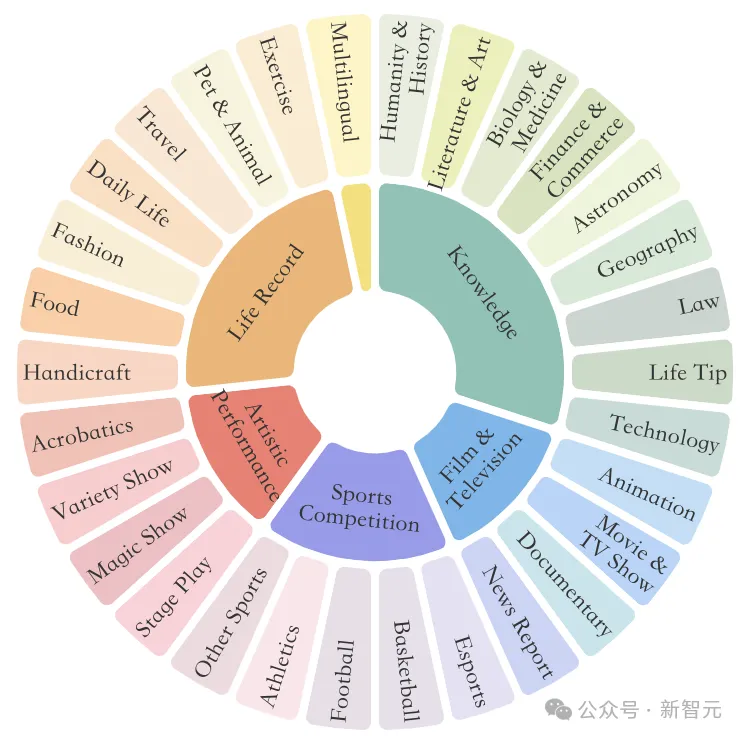

從視頻類型多樣性來看,Video-MME跨越了6個主要視覺領域:知識、影視、體育比賽、生活記錄和多語言,包含有30個子領域,以確保廣泛的場景泛化性。

在數據模式的廣度上,Video-MME整合了視頻幀以外的多模態輸入,包括字幕和音頻,以評估MLLM的全方位能力。

此外,Video-MME中所有數據都是由人類新收集和標注,而不是來自任何現有的視頻數據集,以確保數據的多樣性和質量。

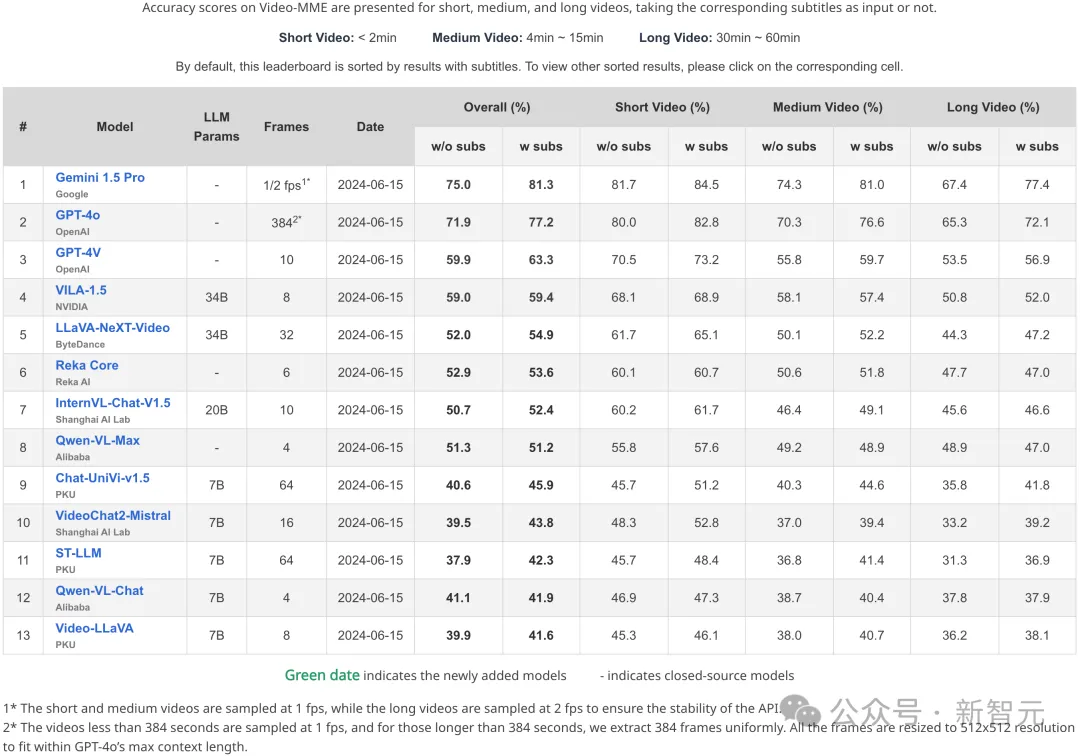

研究人員使用Video-MME,對各種最先進的MLLM進行了基準測試,包括GPT-4V、GPT4o和Gemini 1.5 Pro,以及開源圖像模型InternVL-Chat-V1.5和視頻模型LLaVA-NeXT-Video等。

實驗表明,Gemini 1.5 Pro是目前性能最高的商用MLLM,平均準確率為75%,GPT系列的最好成績是GPT-4o的71.9%。

相比之心,開源MLLM仍有巨大差距,表現最好的VILA-1.5以及LLaVA-NeXT-Video的總體準確率分別只有59和52%,開源社區還有相當大的提升空間。

此外,通過將輸入擴展到多幀圖像,Video-MME也可用來評估基于圖像的MLLM,例如Qwen-VL-Max和InternVL-Chat-V1.5。

兩種模型的準確度均達到51%左右,接近視頻專用模型LLaVA-NeXT-Video,這表明圖像理解是視頻理解的基礎,所以Video-MME在MLLM評估領域具有廣泛的適用性。

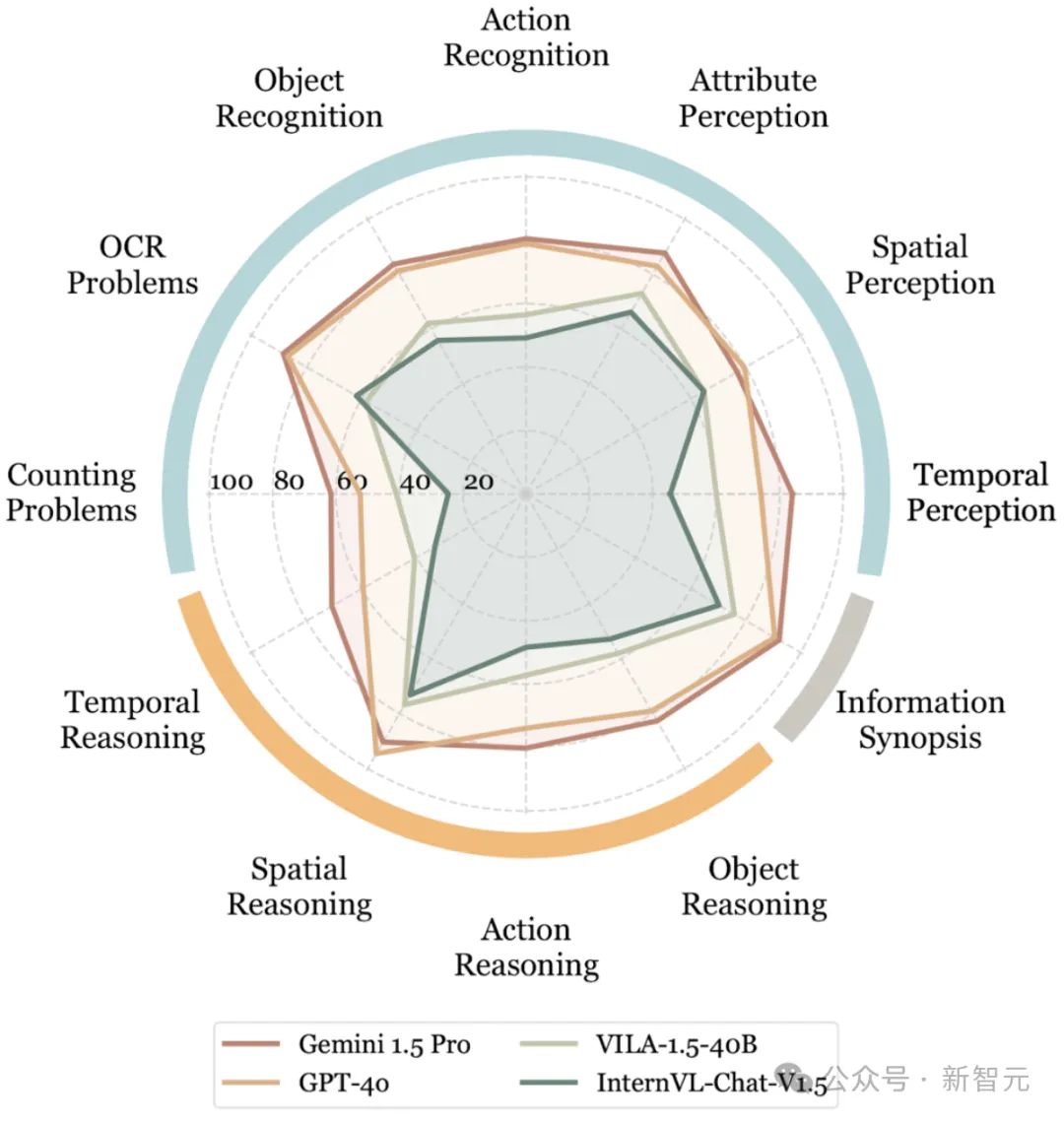

下面,換個視角,看看這些MLLM在不同任務類型下的表現:

——Gemini 1.5 Pro 最終還是壓制住了 GPT-4o!

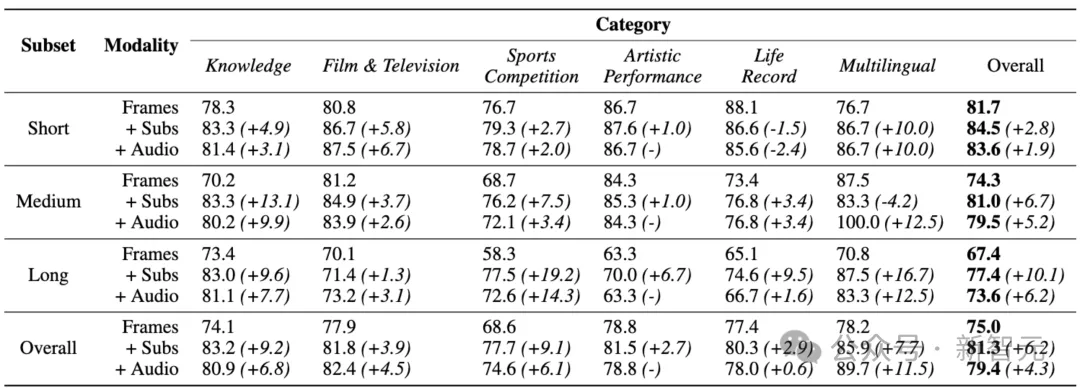

我們再把Gemini 1.5 Pro單獨拉出來開個小灶,詳細給出不同視頻時長和不同視頻類型下的評估結果:

通過對上表的進一步觀察,我們還可以發現,整合字幕和音頻可以顯著增強LLM的視頻理解能力。

Gemini 1.5 Pro在加入字幕和音頻之后,準確度分別提高了6.2%和4.3%,長視頻則更為明顯。

對任務類型的細粒度分析表明,字幕和音頻對于需要大量領域知識的視頻特別有益。

當然了,隨著視頻長度的增加,MLLM性能普遍下降,所以處理長視頻仍然是件困難的事情。

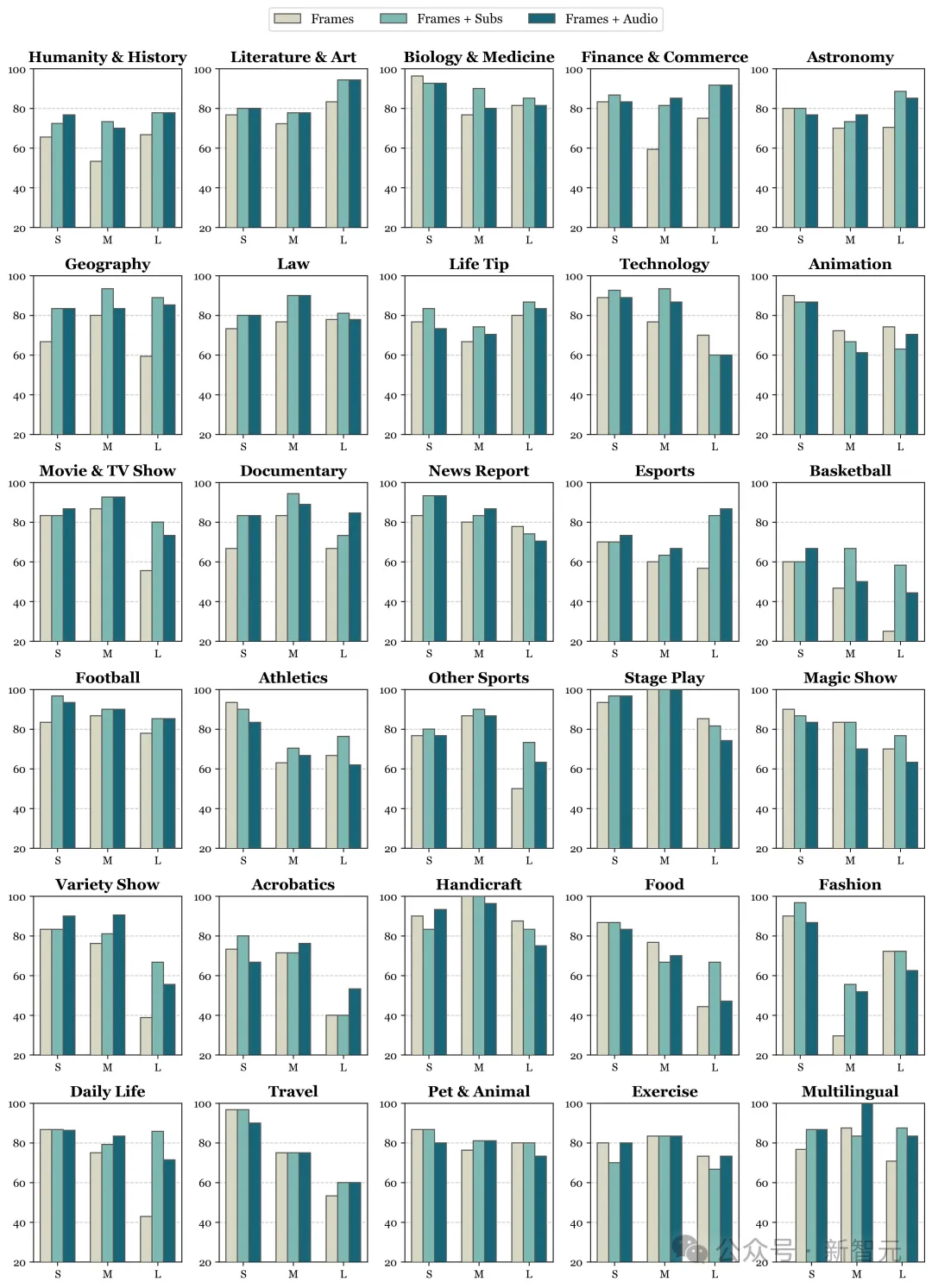

下面給出Gemini 1.5 Pro在不同視頻子類型上的評估結果,包括天文學、技術、紀錄片、新聞報道、電子競技、魔術表演和時尚等30個子類別。

Video-MME

數據集構建

Video-MME的數據集構建過程包括視頻采集、問答對標注、質量審核三個步驟。

視頻采集

為了全面覆蓋不同的視頻類型,研究人員創建了一個域層次結構,用于從網絡上收集原始視頻。

首先定義6個關鍵領域:知識、電影和電視、體育比賽、生活記錄和多語言。

每個領域進一步劃分為詳細的標簽,例如體育比賽包含足球和籃球,從而產生總共30個細粒度的視頻類。

對于每個類型,收集不同持續時間的視頻:短視頻(少于2分鐘)、中視頻(4-15分鐘)和長視頻(30-60分鐘)。

此外,還會獲取相應的元信息,例如字幕和音頻,用于進一步研究。最終的數據集由900個視頻組成,這些視頻跨越各個領域,持續時間長度相對平衡。

問答標注

在收集原始視頻數據后,研究者對以問答對的形式對其進行注釋,以評估MLLM在解釋視頻內容方面的熟練程度。

這里采用多項選擇題的QA格式,參與標注的作者都精通英語,在視覺語言學習方面具有豐富的研究經驗。

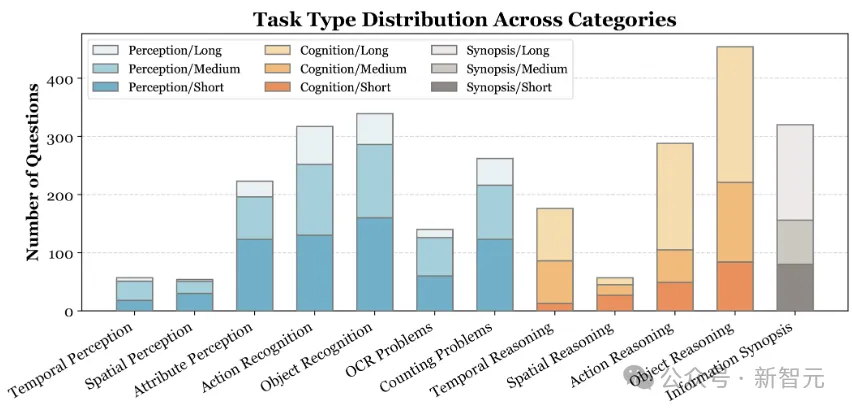

標注者通過反復觀看視頻來提出3個相關的問題,每個問題有4個潛在選項。這2700個QA對包含12種任務類型,比如感知、推理和信息概要。

質量審核

為了保證數據集的質量,作者還進行了嚴格的人工審查流程。

首先,指派不同的標注者來檢查每個QA對,確保語言表達正確且明確,以及問題可回答(候選選項和正確選項都是合理的)。

此外,為了確保問題足夠具有挑戰性,要求多模態模型看了視頻才能回答,研究人員向Gemini 1.5 Pro提供了純文本問題,并過濾掉可以僅根據文本問題回答的QA對。

最后,Gemini 1.5 Pro在僅使用文本提問的情況下,準確率低于 15%。

數據集統計

視頻和元信息

Video-MME總共包含900個視頻、713個字幕和869個音頻文件。

從任務類型的分布來看,較短的視頻主要涉及與感知相關的任務,例如動作和物體識別。

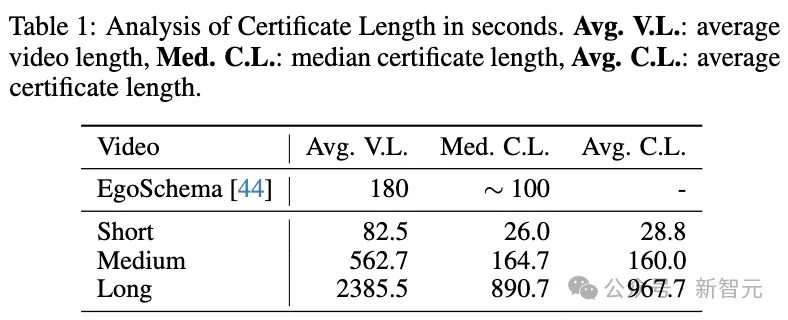

相比之下,較長的視頻主要以與時間推理相關的任務為特色。從下表中可以看到,Video-MME的有效時長(Certificate Length準確回答問題所需的時間跨度)非常長,表明了其挑戰性。

問答數據

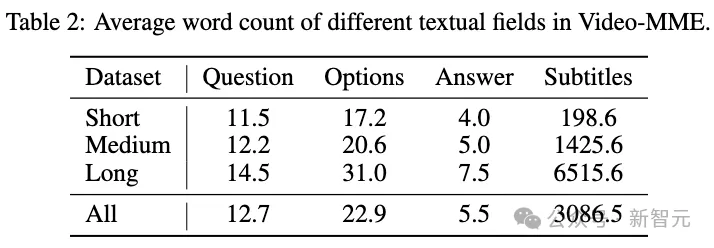

關于問題和答案的語言多樣性,下表列出了數據集中文本字段的平均字數。

問題、選項和答案的字數在不同視頻長度上顯示出顯著的一致性,這表明Video-MME中的QA對風格一致。

另一方面,字幕的字數隨著視頻長度的增加而顯著增加,短視頻的平均字數為198.6,而長視頻子集的字數高達6.5K。這一趨勢表明,較長的視頻包含的信息更多。

此外,問題對應的正確答案選項(A/B/C/D)的分布接近均勻(25.2%/27.2%/25.2%/22.3%),確保了無偏的評估。

本文轉自 新智元 ,作者:新智元