預訓練大語言模型對時間序列預測真的有用嗎?去掉預訓練LLM效果反而提升

今天給大家介紹一篇關于大模型在時間序列應用探討的工作。這篇文章質疑大語言模型在時間序列預測中是否有效,并對目前最先進的3個基于大語言模型的時間序列預測模型進行實驗,發現去掉大語言模型部分,改成一個attention網絡,也能取得相同甚至更優的效果。

論文標題:Are Language Models Actually Useful for Time Series Forecasting?

下載地址:??https://arxiv.org/pdf/2406.16964v1??

1、背景

隨著大語言模型的興起,一些工作也將其應用到時間序列預測領域。這類方法一般基于預訓練好的NLP領域的語言模型,將時間序列轉換成文本形式輸入其中,通過finetune大模型,產出預測結果。典型的代表工作包括OneFitsAll、Time-LLM、LLaTA等工作。

本文質疑的點就是大語言模型在時間序列預測中是否真的有效。通過一系列的對目前先進的大語言模型的實驗來看,引入大語言模型并不和提升效果,甚至會降低效果,并且白白浪費了更多的計算資源。

2、實驗方法

本文對3個目前業內最先進的基于大語言模型的時間序列預測方法進行實驗,分別是OneFitsAll、Time-LLM、LLaTA。

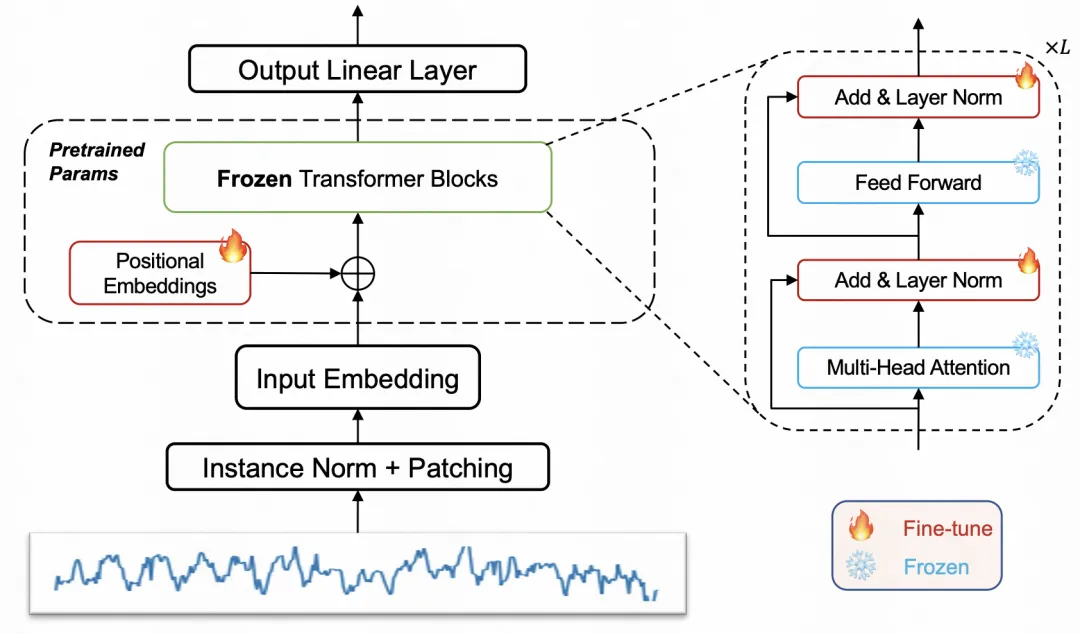

OneFitsAll:OneFitsAll是基于GPT4的時序預測模型,將時間序列歸一化并進行patch處理后,輸入預訓練GPT4中,finetune其中的position embedding和layer norm參數,其他參數freeze;

Time-LLM:Time-LLM將時間序列轉換成token后映射到低維表征,和數據集描述等信息拼接后輸入到預訓練大模型中,大模型的輸出結果再輸入到一個線性層進行生成預測結果;

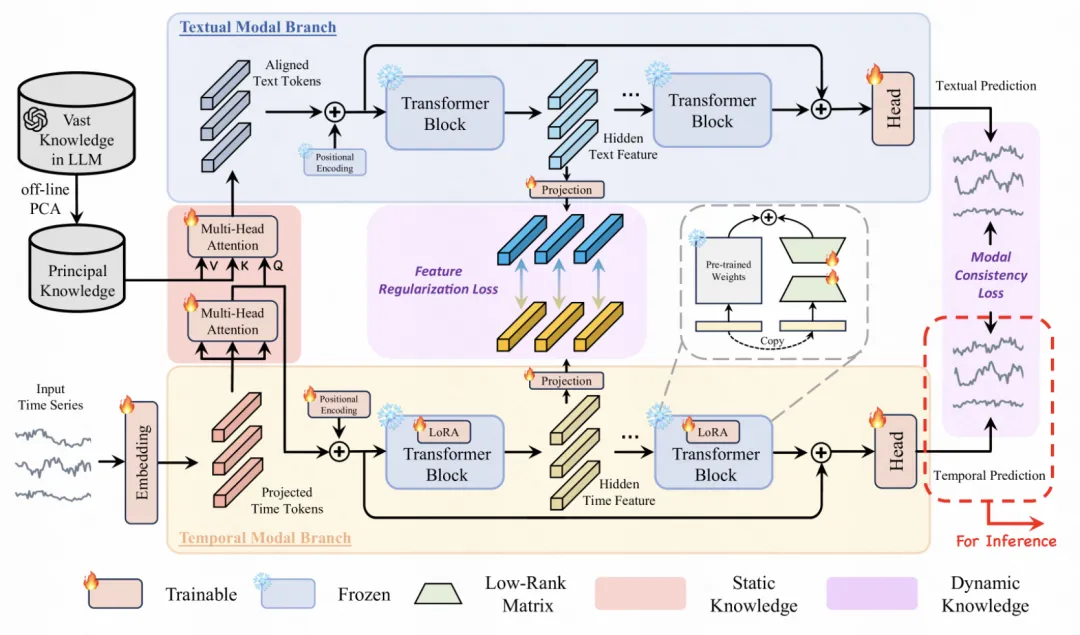

LLaTA:模型分為文本分支和時序分支,文本分支部分將原始時間序列和大模型的word embedding對齊后,輸入到大模型中,生成文本表征。時序分支基于原始時間序列數據,使用一個adpater對預訓練大模型進行finetune,同時將時序分支和文本分支的表征拉近作為輔助任務。

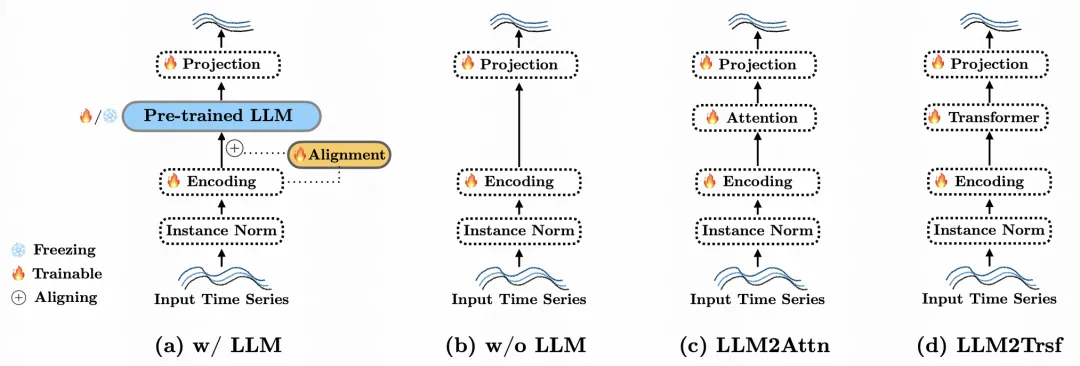

在實驗方法上,針對上述3個大模型時序預測模型,采用如下方法進行消融實驗,鑒別大模型在其中的作用。第一種是w/o LLM,直接將大模型部分去掉。第二種是LLM2Attn,將大模型改成一個參數隨機初始化multi-head attention結構。第三種是LLM2Trsf,將大模型部分改成一個隨機初始化的Transformer結構。通過對比這三種方式和原始模型的效果,就可以分辨出大模型的參數是否對時間序列預測起到作用。

3、實驗結果

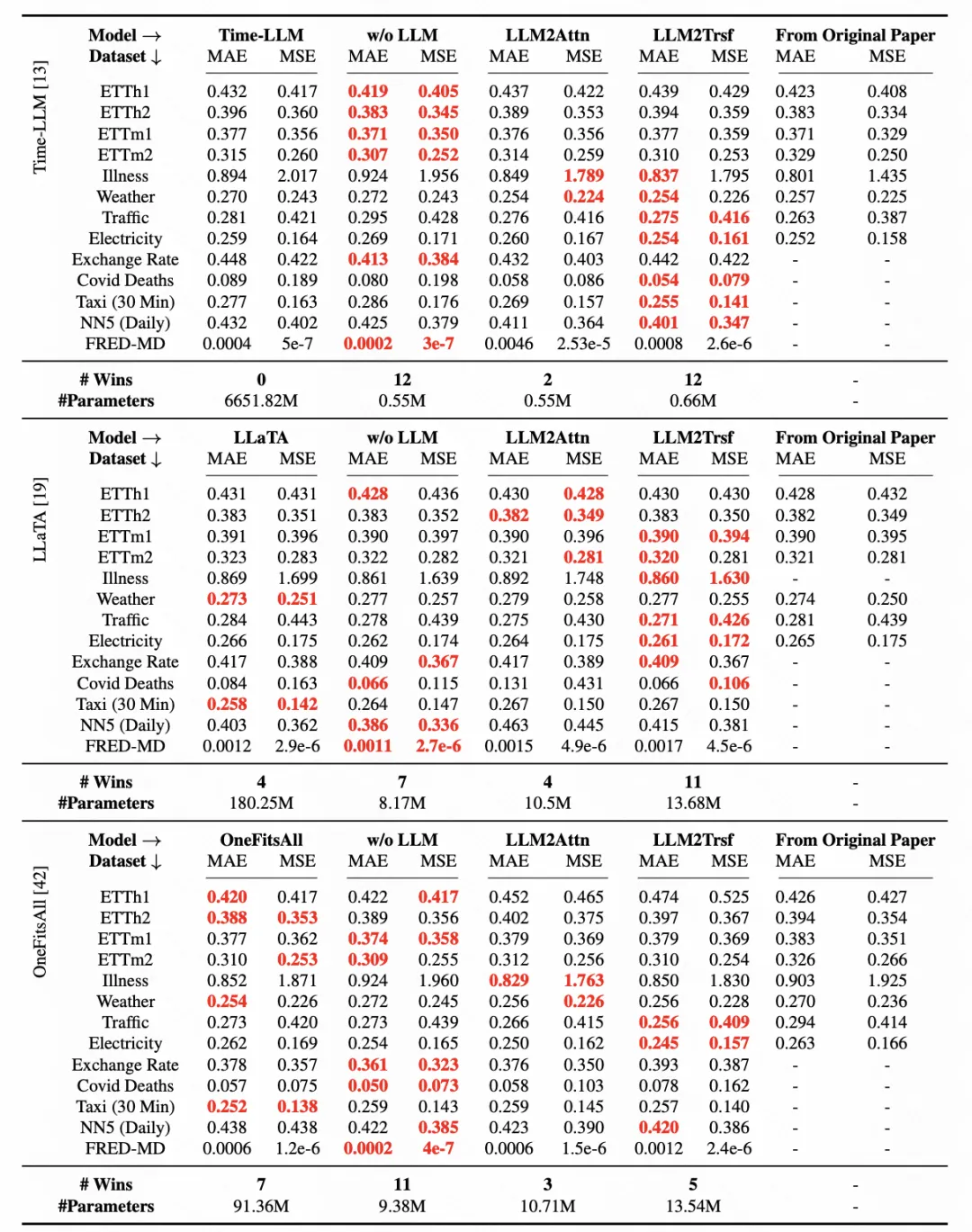

下表展示了一個基礎的消融實驗效果圖。從圖中可以看出,Time-LLM、LLaTA、OneFitsALL等模型中,將大語言模型部分直接改成Transformer,在不同的數據集上效果并沒有明顯下降。在一些數據集上效果反而提升了。消融模型的效果,所有case上都超過了Time-LLM,22個case超過了Time-LLM,19個數據集超過了OneFitsALL。這說明在這些方法中,預訓練的大語言模型并沒有發揮什么特別重要的作用。

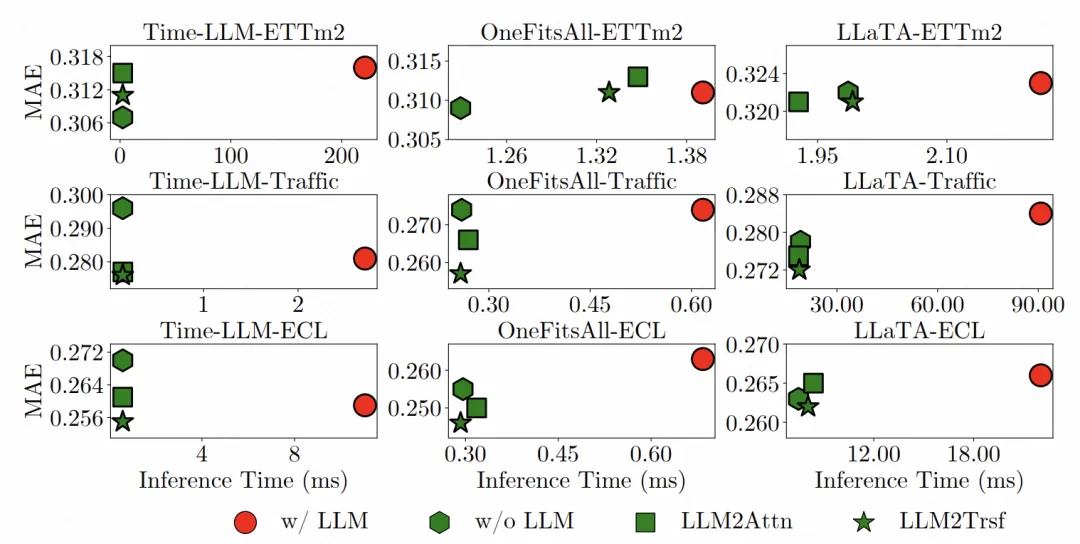

除了預訓練參數外,文中對比了大模型所增加的計算開銷,性價比是否足夠高。文中的消融實驗的模型參數量要小于大模型本身的參數量。通過實驗對比來看,大模型耗費更多的inference時間,但是效果卻不如消融實驗的效果。

本文轉載自 ??圓圓的算法筆記??,作者: Fareise