打破視覺-語言預訓練的瓶頸:新算法解決噪聲和標注問題 精華

引言:探索視覺-語言對比預訓練中的噪聲和低質量標注問題

在視覺-語言對比預訓練中,噪聲和標注質量被認為是影響訓練效果的重要因素。本文通過深入研究和分析訓練過程中的兩個主要問題——錯誤的負樣本對分配和低質量及多樣性不足的標注——揭示了通過解決這些問題來提高訓練質量的潛力尚未被完全實現。

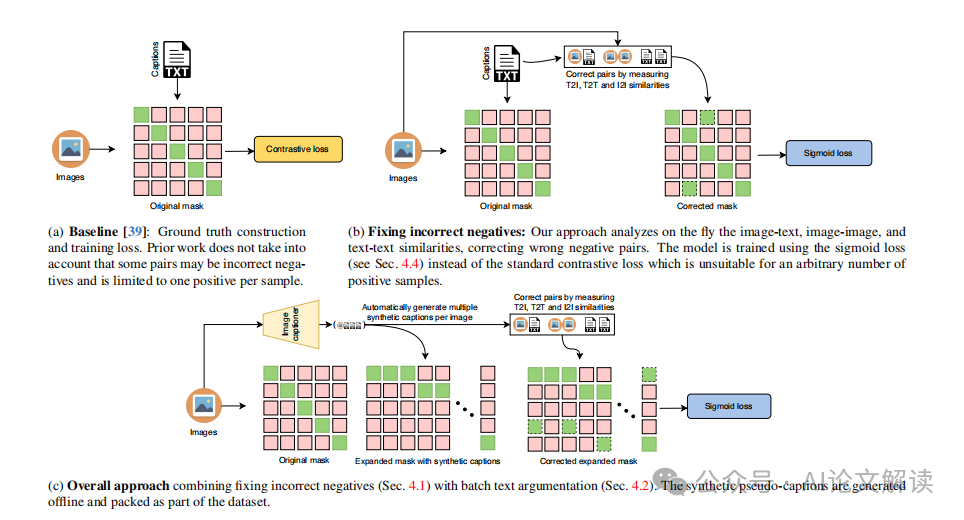

首先,我們研究了影響對比學習的噪聲問題,即在一個批次中可能會發現語義相似甚至相同的圖像/標注被錯誤地視為負樣本對。其次,我們探討了標注的低質量和多樣性不足問題,標注可能簡短且缺乏細節,嘈雜,或與圖像完全無關。

為了解決第一個問題,我們提出了一種算法,通過圖像-文本、圖像-圖像和文本-文本的相似性來挖掘新的正樣本對,以減少因語義相似的圖像/標注而產生的錯誤負樣本。對于第二個問題,我們首先使用最先進的圖像描述生成技術為每個訓練圖像生成偽標注,這些偽標注將作為給定圖像的新真實正樣本。然后,我們提出在同一批次中使用多個偽標注進行訓練,以有效增加標注的多樣性。

通過應用所提出的解決方案,我們最終獲得了每個圖像的多個正樣本對,這意味著我們需要使用一種能夠適應多個正樣本的損失函數來訓練我們的模型。在這里,我們提出使用sigmoid損失來滿足這一需求,該損失允許每個樣本和每個批次動態變化的正樣本數量,且對噪聲具有魯棒性。

- 論文標題:FFF: Fixing Flawed Foundations in contrastive pre-training results in very strong Vision-Language models

- 機構:Samsung AI Center Cambridge, UK; Technical University of Iasi, Romania; Queen Mary University of London, UK

論文鏈接:https://arxiv.org/pdf/2405.10286.pdf

問題分析:錯誤負樣本對和低質量標題的影響

1. 錯誤負樣本對的識別與修正

在大規模對比圖像-文本預訓練中,錯誤地將近似重復的樣本視為負樣本對是一個常見問題。這種錯誤的負樣本對會顯著阻礙訓練過程和模型質量。為了解決這一問題,我們提出了一種算法,通過計算圖像-文本、圖像-圖像和文本-文本的相似性,來重新分配這些錯誤的負樣本對為正樣本。這種方法可以有效減少訓練數據中由于語義相似的圖像或標題而產生的錯誤負樣本。

2. 標題質量與多樣性的提升策略

低質量和多樣性不足的標題會影響模型的訓練效果。為了提高標題的質量和多樣性,我們首先使用先進的圖像描述生成技術(如BLIP2)為每個訓練圖像生成偽標題,這些偽標題將作為給定圖像的新真正正樣本。然后,我們提出在同一批次中使用多個偽標題(例如,每個圖像選擇五個標題)進行批量文本增強,以有效增加標題的多樣性。

解決方案:新正樣本的挖掘與偽標題的批量文本增強

1. 基于相似性挖掘新的正樣本對

我們提出的算法不僅修正了錯誤的負樣本對,還能夠基于圖像和文本特征的余弦相似性挖掘新的正樣本對。這一過程通過動態調整正樣本的數量來適應模型訓練,從而提高了訓練的準確性和效率。

2. 使用偽標題進行批量文本增強

為了進一步提高模型對圖像描述的準確性,我們采用批量文本增強的策略,將多個偽標題納入同一批次的訓練中。這種方法不僅增加了文本的多樣性,還通過集成多個偽標題來改善了單個錯誤標題可能帶來的負面影響,從而提高了模型的魯棒性和描述能力。

模型訓練:采用sigmoid損失函數

1. Sigmoid損失函數的選擇與優勢

在處理視覺-語言對比預訓練中,特別是在面對數據質量和噪聲問題時,傳統的對比損失函數(如InfoNCE)可能不足以處理多個正樣本的情況。這是因為這些損失函數通常假設每個樣本只有一個正樣本。為了解決這一問題,我們采用了sigmoid損失函數。Sigmoid損失函數的主要優勢在于它能夠自然地處理每個樣本動態變化的正樣本數量,且對噪聲具有較強的魯棒性。

在我們的設置中,每個圖像不僅與其原始標注配對,還可能與通過算法生成的多個偽標注配對,這些偽標注是通過高級圖像標題生成技術(如BLIP2)創建的。這種方法增加了訓練過程中的正樣本數量,有助于模型更好地理解和描述圖像內容。sigmoid損失函數能夠有效地處理這種多正樣本的情況,而不會引入額外的計算成本。

2. 多正樣本對訓練的實現

為了增加訓練數據的多樣性和質量,我們采用了批量文本增強技術,即在同一批次中為每個圖像生成多個偽標注。這些偽標注作為正樣本輸入模型,通過sigmoid損失函數進行訓練。這種方法不僅提高了標注的多樣性,還通過集成多個偽標注來減少單個錯誤標注對模型訓練的影響。

此外,我們還采用了一種新的正樣本挖掘算法,通過分析圖像-文本、圖像-圖像和文本-文本之間的相似性來動態地識別和校正錯誤的負樣本對,將其轉換為正樣本。這一策略進一步增加了正樣本的數量和質量,為模型訓練提供了更豐富的學習信號。

實驗驗證:數據集和實驗設置

我們的模型在多個公開可用的視覺-語言數據集上進行了預訓練和測試,包括YFCC15M-v2、CC3M和CC12M等。這些數據集包含大量的圖像-文本對,適用于視覺-語言對比學習的大規模訓練。

在實驗中,我們使用了與CLIP相同的模型架構和設置,采用AdamW優化器,學習率設置為1e-3,權重衰減為0.1。圖像通過隨機縮放和裁剪至224×224像素,應用隨機翻轉、高斯模糊和顏色抖動等增強技術。文本數據則被截斷至77個令牌。

所有模型均在8塊NVIDIA A100 GPU上訓練32個周期。我們的實驗設置旨在公平地與先前的工作進行比較,并展示我們方法在處理多正樣本和噪聲數據時的優勢。通過這些實驗,我們證明了采用sigmoid損失函數和多正樣本策略的有效性,實現了在多個基準測試上的顯著性能提升。

實驗結果與分析:模型性能的顯著提升

1. 圖像識別與檢索的改進

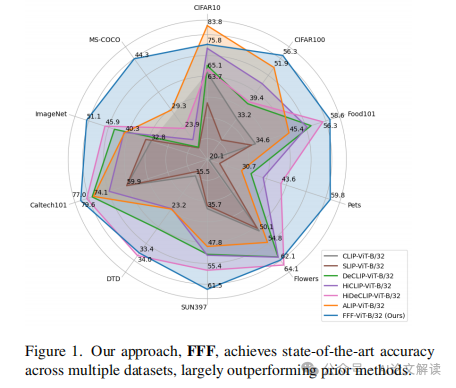

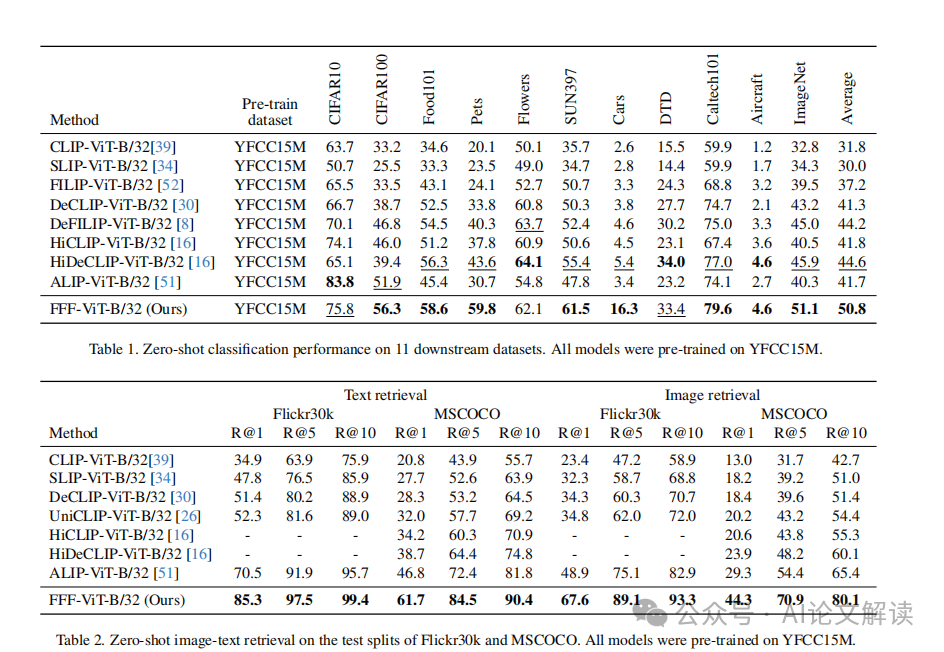

在圖像識別和檢索方面,通過對比訓練數據中的噪聲和低質量標注的處理,我們的方法在多個數據集上都顯示出了顯著的性能提升。具體來說,我們的模型在11個數據集上的圖像識別平均提升了約6%,在Flickr30k和MSCOCO的圖像檢索任務上分別提升了約19%和15%。這一成績的提升歸功于我們對錯誤負樣本對的糾正以及對訓練數據質量的改進。

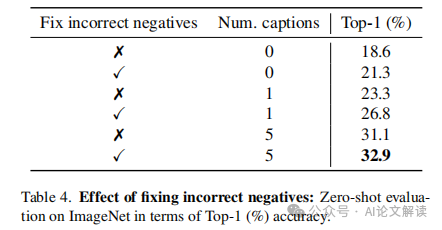

2. 不同組件的影響分析

我們的方法包括兩個主要的技術改進:錯誤負樣本對的糾正和批量文本增強。通過對這些組件的單獨分析,我們發現圖像-文本相似度矩陣(Sit)是最有影響力的,因為它不僅幫助過濾掉錯誤的配對,還調整了語義上相似的樣本。此外,我們還觀察到,使用多個偽標題進行訓練可以顯著提高模型的準確性,這驗證了批量文本增強的有效性。

結論與展望:多正樣本對策略的前景與挑戰

通過本研究,我們展示了在視覺-語言對比預訓練中處理多個正樣本對的潛力和效果。我們的方法不僅顯著提高了模型在圖像識別和檢索任務上的性能,而且還提出了一種新的損失函數——sigmoid損失,以適應訓練樣本中正樣本數量的動態變化。

盡管我們的方法取得了顯著的進步,但在實際應用中仍面臨一些挑戰。例如,如何有效地從大規模噪聲數據中挖掘和利用真正的正樣本對,以及如何進一步優化模型以處理更大規模的數據集。此外,多正樣本對策略在不同類型的視覺-語言任務中的普適性和效果還有待進一步研究。

總之,多正樣本對策略為視覺-語言模型的訓練提供了新的視角和可能性,預示著在自動圖像標注、圖像檢索以及其他相關領域的廣泛應用前景。

總結:視覺-語言預訓練的新方向及其潛在影響

在視覺-語言預訓練領域,最新的研究提出了一種新的方法,通過解決錯誤的負樣本配對和低質量的圖像描述問題,顯著提高了模型的性能。這些問題一直是影響訓練質量的關鍵因素,而現有的解決方案尚未完全發揮其潛力。通過深入分析和新算法的應用,研究者們成功地推動了這一領域的發展。

1. 錯誤的負樣本配對問題

在傳統的對比學習中,每個批次中可能會錯誤地將語義相近的樣本視為負樣本對。這種現象在數據集中普遍存在,尤其是在大規模的圖像-文本數據集中。為了解決這一問題,研究者提出了一種新的算法,通過分析圖像-圖像、文本-文本和圖像-文本之間的相似性,動態地重新分配正負樣本對。這種方法有效減少了因語義近似而產生的錯誤負樣本,從而提高了模型的訓練效果。

2. 圖像描述的質量和多樣性問題

傳統的數據集中的圖像描述往往質量不高,缺乏詳細信息,這嚴重影響了模型的學習效果。為了提高描述的質量和多樣性,研究者采用了最先進的圖像描述生成技術,為每張圖像生成多個偽描述。這些偽描述作為新的正樣本參與訓練,顯著增加了描述的多樣性和質量。此外,通過批量文本增強技術,同一批次中的多個偽描述可以同時用于訓練,進一步提升了模型的性能。

3. 新的損失函數

由于引入了多個正樣本對,傳統的對比損失函數已不再適用。研究者提出使用sigmoid損失函數,這種損失函數可以靈活地處理每個樣本的動態正樣本數量,且對噪聲具有較強的魯棒性。這一改進使得模型訓練更加高效,同時也減少了因錯誤標注帶來的負面影響。

通過這些創新方法的應用,研究者在多個標準數據集上取得了顯著的性能提升,不僅在圖像識別任務上平均提高了約6%,在圖像檢索任務上也分別在Flickr30k和MSCOCO數據集上提高了約19%和15%。這些成果不僅展示了處理錯誤負樣本配對和提高圖像描述質量的重要性,也為未來的視覺-語言預訓練研究提供了新的方向。

本文轉載自 ??AI論文解讀??,作者:柏企