哈佛、麻省推出面向醫學多模態助手—PathChat

哈佛醫學院、麻省理工學院、俄亥俄州立大學韋克斯納醫學等研究人員聯合推出了,面向醫學領域的多模態AI助手——PathChat。

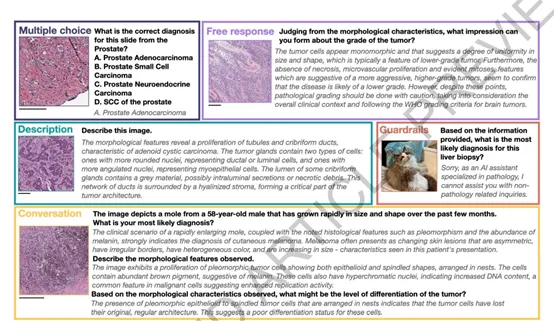

PathChat不僅能理解、分析復雜的醫學圖像,還能基于多輪文本對話,為臨床醫生、醫護人員提供精準和個性化的病理學指導。

論文地址:https://www.nature.com/articles/s41586-024-07618-3

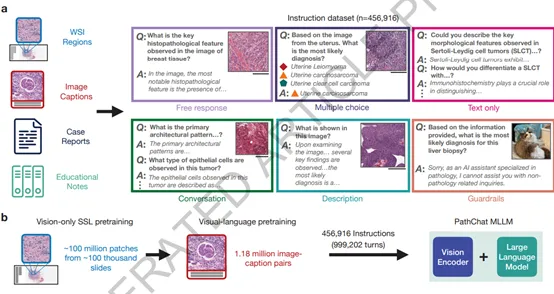

為了提升PathChat的多功能處理能力,使用了一個多模態架構由視覺編碼器、多模態投影和大語言模型三大塊組成。

視覺編碼器充當PathChat的“眼睛”也是整個架構的核心模塊之一,可將高分辨率的病理學圖像轉換成機器可以處理的低維特征表示,使得視覺信息能夠被語言模型理解和處理。視覺編碼器使了自監督學習方法,可以從未標記的圖像中學習。

多模態投影模塊作為視覺與語言的橋梁,接收了圖像特征的進一步處理。該模塊通過注意力池化層和多層感知器(MLP)來實現,將視覺特征圖轉換為固定長度的圖像標記序列。這些圖像標記隨后被映射到與語言模型的嵌入維度相同的空間,為后續的語言模型處理做好了準備。

大語言模型方面,PathChat使用的是Meta開源的Llama 2家族的130億參數變體作為其核心模型。

這是一個基于Transformer架構的自回歸語言模型,包含40層Transformer,每層有40個注意力頭,嵌入維度為5,120,隱藏維度為13,824,并采用了旋轉位置編碼,能夠處理長達4,096的上下文序列。不僅能夠處理文本,還能在接收到視覺特征后,給出準確的文本回應。

PathChat的訓練過程分為兩個階段。在預訓練階段,大語言模型的權重被凍結,只有多模態投影模塊接收參數更新。

該階段的目的是讓投影模塊學會如何將視覺編碼器的輸出即圖像的低維特征表示——映射到與大語言模型的文本嵌入空間相同的維度,使用了大約100,000對圖像和字幕對。

隨后,進入PathChat指令微調階段,大語言模型和投影模塊共同接受端到端的訓練,以生成對多樣化指令的響應。

這些指令包括了自然語言和視覺輸入,反映了病理學領域內的真實查詢。通過這種方式,PathChat能夠學習如何理解和生成與病理學相關的復雜響應。

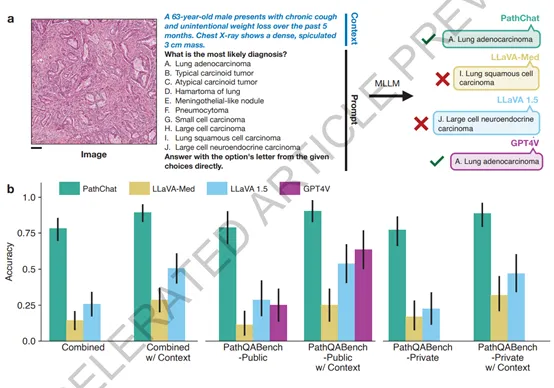

為了驗證其性能,PathChat在多項選擇診斷問題和開放性問答場景中接受了測試。結果顯示,在面對公開和私有病例的診斷測試時,PathChat相比LLaVa-1.5、GPT-4V等模型具有顯著優勢,尤其在綜合考量了圖像和臨床情境的診斷問題上,其準確率超出20%以上。

除了在測試中的優異表現,PathChat還展現了其在多種應用場景中的潛力。例如,它能分析不同器官部位的病理圖像,參與人機交互的鑒別診斷過程,尤其在資源有限或處理如未知原發性癌癥等復雜情況時,PathChat通過與病人的多輪深度對話,逐步縮小鑒別范圍,輔助醫生作出更精確的診斷。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區