300億參數!蘋果推出多模態大模型MM1,能解釋圖像和文本數據

在過去的一年里,LLM 因其先進的 AI 能力而備受關注。值得注意的是,蘋果(Apple)公司卻缺席了。

目前,蘋果公司正在談判將谷歌的 Gemini 人工智能引擎植入 iPhone。而蘋果一直致力于開發下一代 LLM,一種可以解釋圖像和文本數據的 LLM。

近日,蘋果的計算機科學家和工程師團隊開發了一種 LLM 模型,聲稱該模型可以解釋圖像和數據。

蘋果構建了一個多模態模型系列——MM1,包括高達 30B 的 dense 變體和高達 64B 的專家混合 (MoE) 變體,它們在預訓練指標中是 SOTA,并在對一系列已建立的多模態基準進行監督微調后獲得具有競爭力的性能。

該研究以《MM1:多模態 LLM 預訓練的方法、分析和見解》(MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training)為題,發表在 arXiv 預印上,描述了他們新的 MM1 系列多模態模型和測試結果。

論文鏈接:https://arxiv.org/abs/2403.09611

論文鏈接:https://arxiv.org/abs/2403.09611

多模態 AI 的工作原理是集成和處理不同類型的數據輸入,例如視覺、聽覺和文本信息。這種集成使人工智能能夠更全面地理解復雜數據,從而比單模態人工智能系統做出更準確和上下文感知的解釋。

蘋果的研究團隊聲稱,他們在 MM1 模型中使用多模態 AI 方面取得了重大進展,該模型集成了文本和圖像數據,以提高圖像字幕、視覺問答和查詢學習的能力。他們的 MM1 是他們所描述的多模態模型系列的一部分,每個模型都包含多達 300 億個參數。

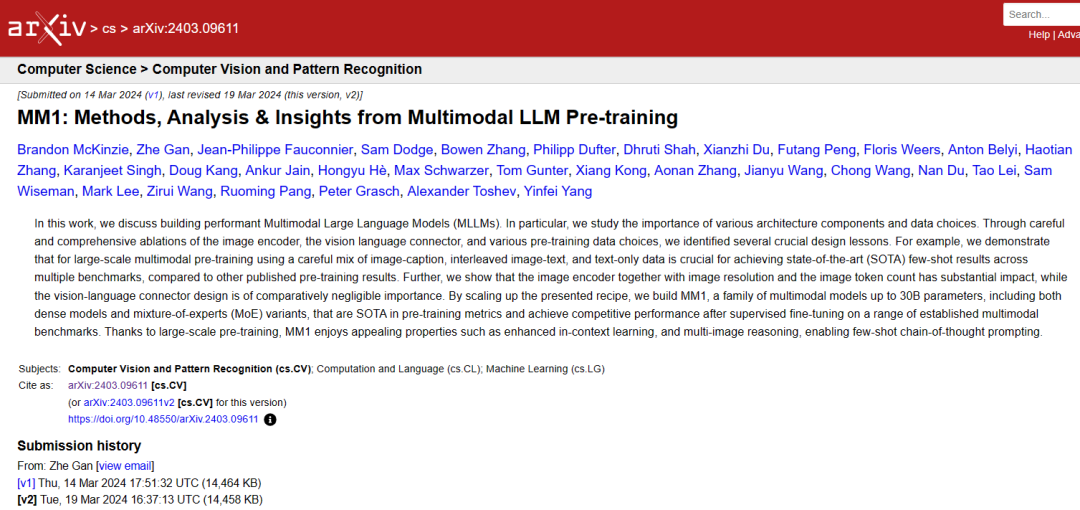

圖 1:在 MLLM 基準測試中與 SOTA 模型的比較。

圖 1:在 MLLM 基準測試中與 SOTA 模型的比較。

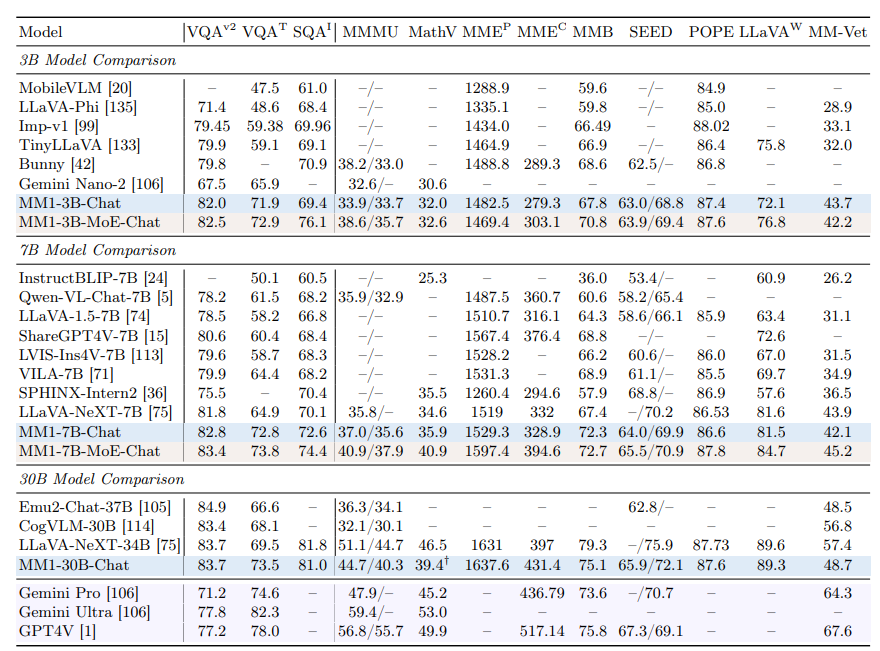

圖 2:MM1 憑借其大規模多模態預訓練可以執行上下文預測。

圖 2:MM1 憑借其大規模多模態預訓練可以執行上下文預測。

研究人員指出,此類模型利用由圖像捕獲對、包含圖像和純文本文檔的文檔組成的數據集。

研究人員進一步聲稱,他們的多模態 LLM (MLLM) 可以計算對象、識別圖像中的對象,并利用日常對象的常識為用戶提供有關圖像所呈現內容的有用信息。

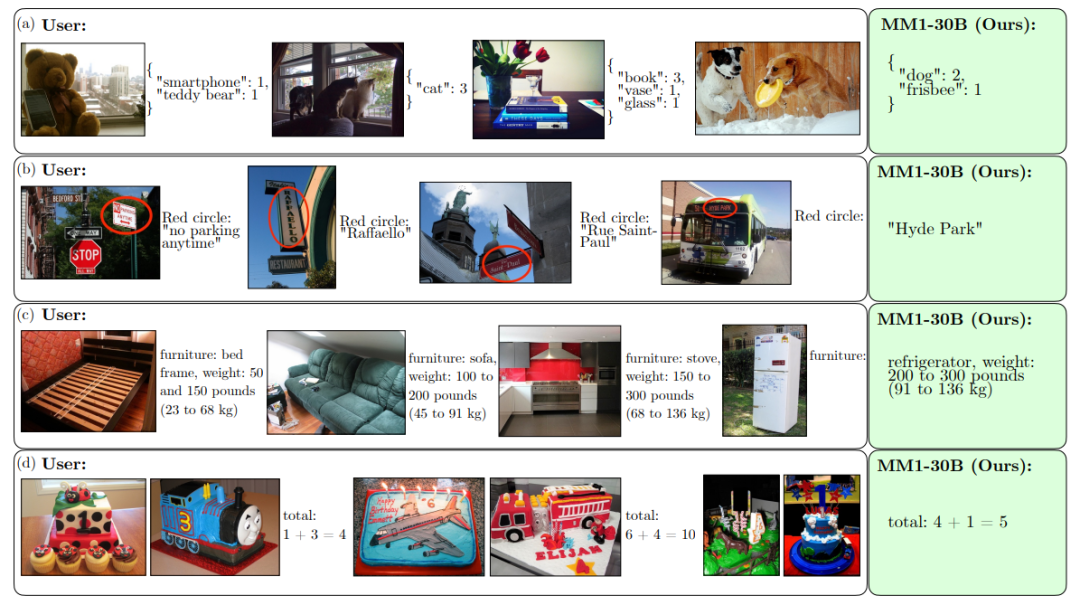

圖 3:MM1 可以跨圖像執行指令和推理。

圖 3:MM1 可以跨圖像執行指令和推理。

研究人員還聲稱,他們的 MLLM 能夠進行情境學習,這意味著它不需要每次提出問題時都重新開始;它使用在當前對話中學到的知識。

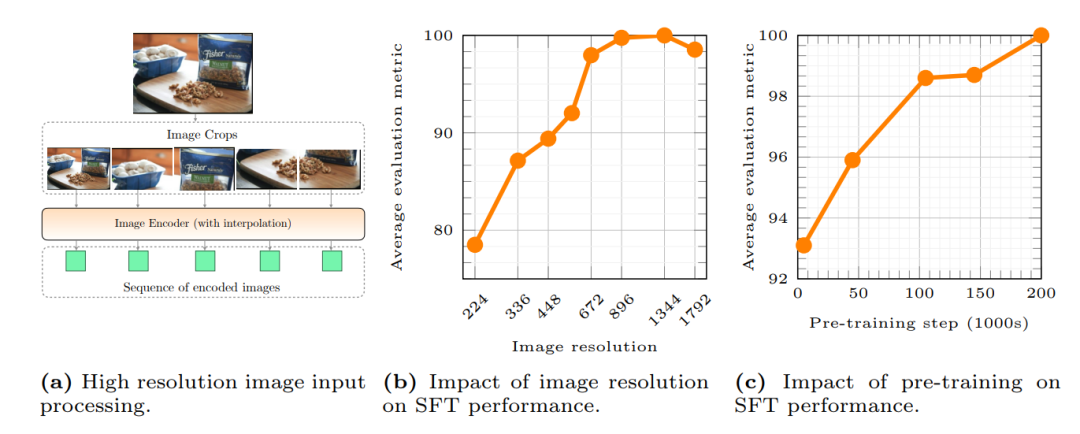

圖 4:研究了圖像分辨率和預訓練對監督微調(SFT)性能的影響。

圖 4:研究了圖像分辨率和預訓練對監督微調(SFT)性能的影響。

該團隊提供了模型高級功能的示例,其中包括上傳一群朋友在酒吧拿著菜單的圖像,并詢問模型根據菜單中列出的價格為每個人購買一杯啤酒需要多少錢。

研究人員表示,“我們希望所確定的經驗教訓將幫助社區構建超越任何單一特定模型架構或數據策略的強大模型。”