PWM: 基于世界模型的策略學習 原創

強化學習(RL)在復雜任務上取得了令人矚目的成果,但在具有不同實施方式的多任務設置中存在困難。世界模型通過學習環境的模擬來提供可伸縮性,但它們通常依賴于低效的無梯度優化方法。近日,佐治亞理工學者聯合英偉達、加州大學圣地亞哥分校等學者提出了基于大世界模型的策略學習(PWM),這是一種新穎的基于模型的RL算法,它從大型多任務世界模型中學習連續控制策略。通過對離線數據進行世界模型的預訓練,并將其用于一階梯度策略學習,PWM有效地解決了具有多達152個動作維度的任務,并且勝過使用真實動力學的方法。此外,PWM在80個任務設置中進行了擴展,相比于現有基準方法,其獎勵提高了高達27%,而無需昂貴的在線規劃。

方法概述

PWM是一種新穎的基于模型的RL(MBRL)算法和框架,旨在從大型多任務世界模型中得出有效的連續控制策略。利用預訓練的TD-MPC2世界模型,在每個任務中以小于10分鐘的時間高效地學習控制策略。對復雜的運動任務進行的實證評估表明,PWM不僅在獎勵上超過了基準方法,還勝過了使用真實模擬動力學的方法。

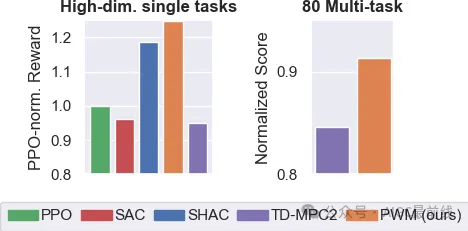

PWM的預告結果

對高維連續控制任務上的PWM進行評估(左圖),發現它不僅勝過了無模型的基準方法SAC和PPO,還在獎勵上超過了直接使用模擬器動力學和獎勵函數的SHAC方法。在一個包含80個任務的設置中(右圖),使用了一個龐大的4800萬參數的世界模型,PWM能夠持續勝過使用相同世界模型的TD-MPC2方法,而無需在線規劃。

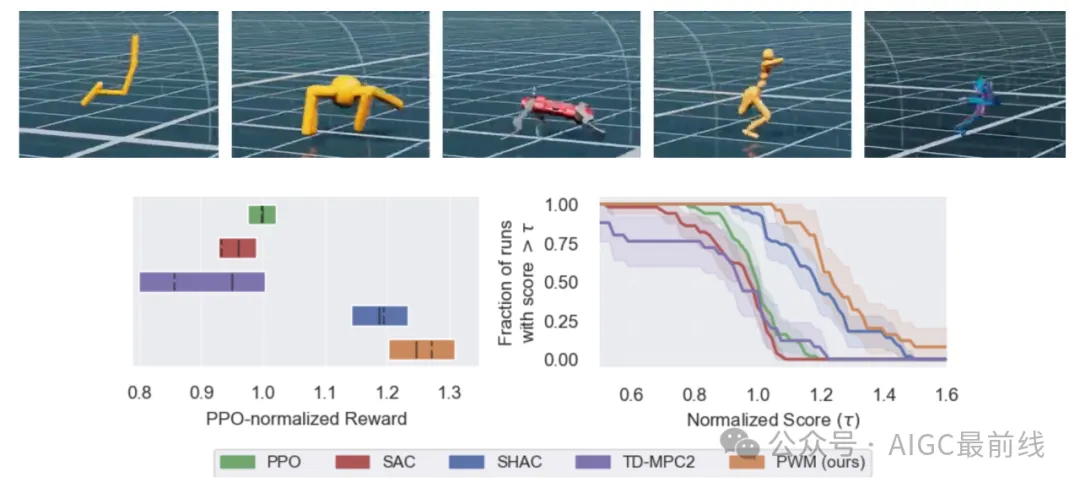

單任務結果

圖中顯示了50%的IQM(實線)、均值(虛線)和所有5個任務和5個隨機種子的95%置信區間。PWM能夠獲得比無模型的基準方法PPO和SAC、使用與PWM相同世界模型的TD-MPC2以及使用真實動力學和獎勵函數的SHAC更高的獎勵。這些結果表明,經過良好正則化的世界模型可以平滑優化空間,從而實現更好的一階梯度優化。

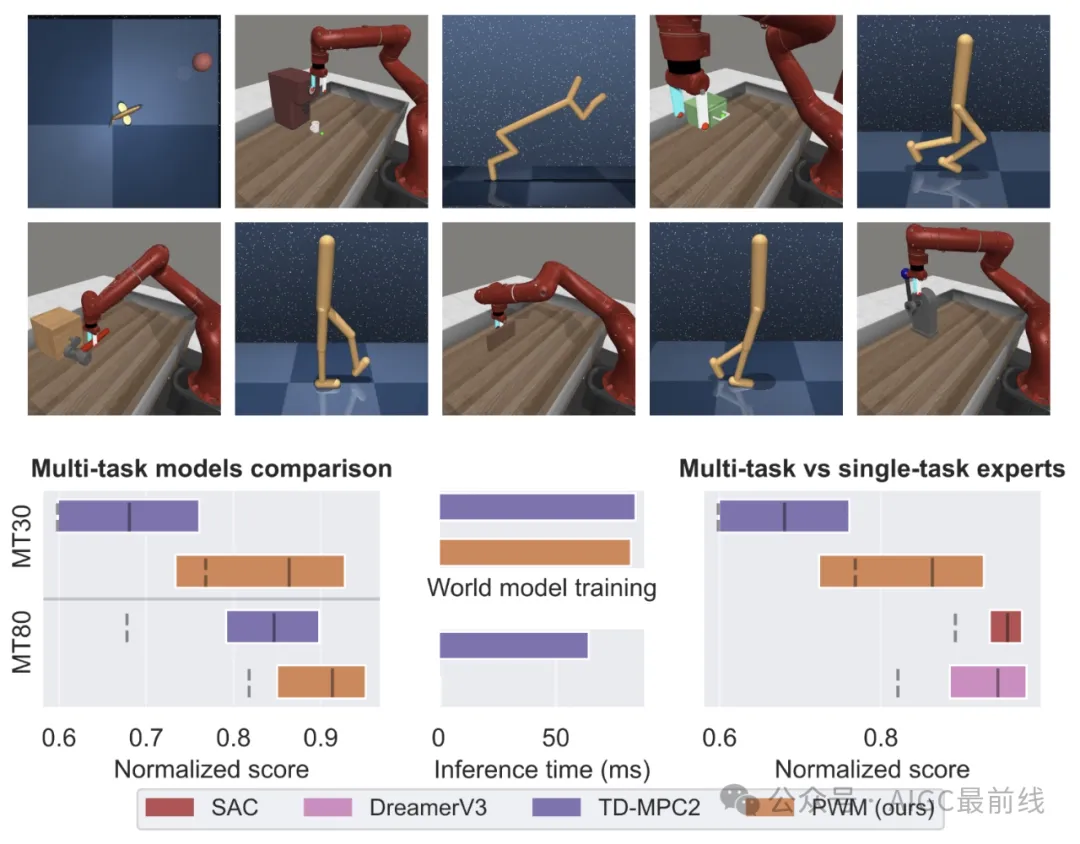

多任務結果

圖中顯示了PWM和TD-MPC2在30個和80個多任務基準測試上的性能,結果基于10個隨機種子。PWM能夠在使用相同世界模型且無需任何形式的在線規劃的情況下勝過TD-MPC2,這使其成為大型世界模型更可擴展的方法。右圖將PWM(多任務策略)與單任務專家SAC和DreamerV3進行了比較。令人印象深刻的是,PWM能夠在多任務情況下與它們的性能相匹配,同時只使用離線數據進行訓練。

譯自(有刪改):https://www.imgeorgiev.com/pwm

本文轉載自公眾號AIGC最前線

原文鏈接:??https://mp.weixin.qq.com/s/UQqEdQl1YIuwqp-3ytCMpA??