基于擴散模型的,開源世界模型DIAMOND

日內瓦大學、微軟研究院和愛丁堡大學的研究人員聯合開源了,基于擴散模型的世界模型—DIAMOND。

研究人員之所以選擇擴散模型作為基礎,是因為可以更好地捕捉視覺細節,同時具有建模復雜多模態分布的能力,以便在不同的環境下進行訓練和細致的行為觀察。

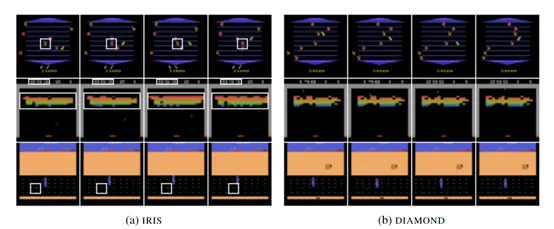

DIAMOND主要用于智能體訓練、世界建模、多模態分布建模等多種強化學習應用。為了評估其性能,研究人員在Atari 100k上進行了綜合測試。

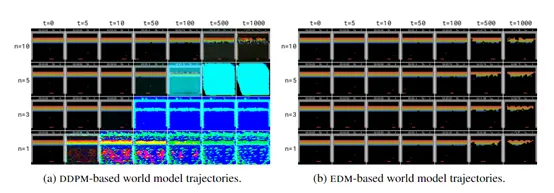

結果顯示,DIAMOND不僅在視覺復雜度高的環境中能夠生成連貫且高質量的軌跡,還取得了平均為1.46的測試分數,在訓練智能體方面非常強。

論文地址:https://arxiv.org/abs/2405.12399

Github地址:https://github.com/eloialonso/diamond

最近幾年,強化學習在游戲、機器人控制和自動駕駛等領域得到了應用,但其樣本、訓練效率低的問題仍是擴大應用范圍的關鍵難點。

為了克服這一困難 “世界模型”作為一種輔助工具應運而生,使智能體能夠在模擬環境中學習規劃、決策等擬人化思維。

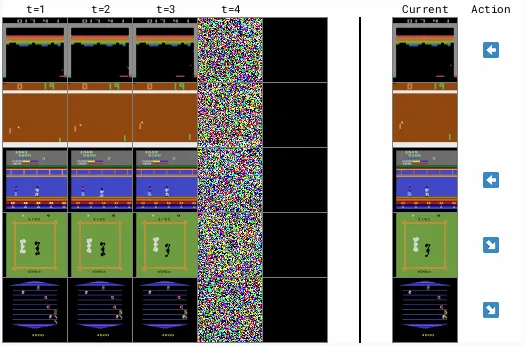

但現有世界模型多依賴于序列化的離散潛變量,來模擬環境動態,這可能導致視覺細節的損失,而這些細節對于強化學習至關重要。所以,DIAMOND使用了一種基于擴散模型的創新架構,可以捕捉更豐富的視覺信息。

擴散模型

?

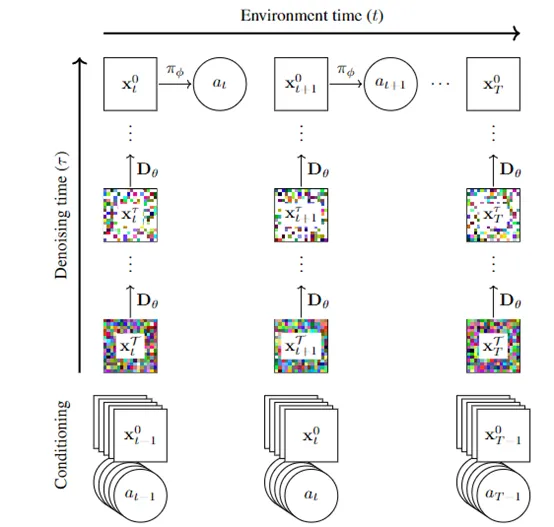

擴散模型是DIAMOND的核心模塊,主要通過逆向學習噪聲過程來生成高質量的視覺數據。這種模型與傳統的基于離散潛在變量的方法有顯著不同,因為它能夠生成更加豐富和細致的視覺信息。

擴散模型不僅能生成數據,還構成了世界模型的基礎,負責模擬環境的動態變化。這意味著,給定過去的觀察和動作,DIAMOND能夠預測未來的觀察、獎勵和終止狀態。

DIAMOND通過擴散模型可以生成連續的潛在變量序列,這些序列捕捉了環境狀態的細微變化。對于強化學習智能體來說至關重要,因為它們需要準確地理解環境的動態,才能制定有效的策略。

獎勵模型

?

在強化學習中,智能體的行為是由環境提供的獎勵信號來引導的,可預測智能體在執行特定動作后所獲得的獎勵。獎勵模型使得智能體能夠評估其行為,并據此調整其決策能力。

在DIAMOND中,獎勵模型可以采用多種不同的形式,如神經網絡或其他機器學習模型。這些模型通過學習大量的交互數據,能夠捕捉到觀察和動作與獎勵之間的復雜映射關系。

終止模型

?

終止模型的作用是可以幫助智能體,識別何時一個任務已經完成或需要重新開始。例如,在自動駕駛的場景中,智能體需要知道何時到達了目的地。

終止模型的工作原理基于對智能體歷史行為和觀察的分析。它通過學習智能體與環境交互的數據來預測,何時結束當前執行的各種事件。

終止模型通常采用機器學習算法來實現,如決策樹、邏輯回歸或神經網絡等。這些算法能夠從歷史數據中學習事件結束的模式,并據此進行預測。

例如,在一個游戲場景中,智能體需要再失去所有生命時來預測結束。而終止模型便能夠識別導致游戲結束的行為和狀態,并預測未來可能出現的類似情況。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區