使用“反事實(shí)任務(wù)”評(píng)估大型語(yǔ)言模型

?LLMs的智能本質(zhì)是什么?

在之前的文章中,我談到了評(píng)估大型語(yǔ)言模型能力的困難。這些模型在許多基準(zhǔn)測(cè)試中表現(xiàn)出色,但我們通常不知道基準(zhǔn)測(cè)試中的測(cè)試項(xiàng)目,或足夠相似的項(xiàng)目,是否出現(xiàn)在訓(xùn)練數(shù)據(jù)中。這些模型是在進(jìn)行一般性的理解和推理,還是在進(jìn)行AI研究員Subbarao Kambhampati所說(shuō)的“近似檢索”——依賴(lài)于模型訓(xùn)練數(shù)據(jù)中包含的文本模式?

反事實(shí)任務(wù)范式

反事實(shí)任務(wù)范式可以幫助回答這個(gè)問(wèn)題。在這個(gè)范式中,模型在成對(duì)的任務(wù)上進(jìn)行評(píng)估,這些任務(wù)需要相同類(lèi)型的抽象和推理,但對(duì)于每一對(duì)任務(wù),第一個(gè)任務(wù)的內(nèi)容可能與訓(xùn)練數(shù)據(jù)相似,而第二個(gè)任務(wù)(“反事實(shí)任務(wù)”)的內(nèi)容被設(shè)計(jì)成不太可能與訓(xùn)練數(shù)據(jù)相似。

例如,論文《Reasoning or Reciting: Exploring the Capabilities and Limitations of Language Models Through Counterfactual Tasks》(《推理還是背誦:通過(guò)反事實(shí)任務(wù)探索語(yǔ)言模型的能力和局限性》)研究了GPT-4在判斷一組四步開(kāi)局棋是否合規(guī)時(shí)的表現(xiàn)。GPT-4似乎對(duì)國(guó)際象棋有很好的理解;當(dāng)給出以下提示時(shí),它能夠以接近90%的準(zhǔn)確率回答“是”或“否”:

你是一名國(guó)際象棋棋手。給定一個(gè)開(kāi)局,確定這個(gè)開(kāi)局是否合法。開(kāi)局不需要是一個(gè)好的開(kāi)局。如果所有棋步都合法,則回答“是”。如果開(kāi)局違反任何國(guó)際象棋規(guī)則,則回答“否”。新的開(kāi)局“1.e4 e6 2.Be2 Bc5”是否合法?讓我們一步一步來(lái)思考。

作者的這個(gè)任務(wù)的反事實(shí)版本是要求GPT-4想象一個(gè)新的國(guó)際象棋變體,其中一切都相同,除了騎士和主教交換了初始位置。以下是該任務(wù)的示例提示:

你是一名國(guó)際象棋棋手。你正在玩一個(gè)國(guó)際象棋變體,其中每種顏色的騎士和主教的起始位置互換。騎士放在主教以前的位置,主教放在騎士以前的位置。給定一個(gè)開(kāi)局,確定這個(gè)開(kāi)局是否合法。開(kāi)局不需要是一個(gè)好的開(kāi)局。如果所有棋步都合法,則回答“是”。如果開(kāi)局違反任何國(guó)際象棋規(guī)則,則回答“否”。在這種自定義變體下,新的開(kāi)局“1.e4 e6 2.Nfe2 Nc5”是否合法?讓我們一步一步來(lái)思考。

這種國(guó)際象棋版本的例子在GPT-4的訓(xùn)練數(shù)據(jù)中出現(xiàn)的可能性要小得多。作者(以及我自己的)直覺(jué)是,理解國(guó)際象棋的人類(lèi)可以很容易地將他們的知識(shí)適應(yīng)這種新版本。然而,GPT-4在這個(gè)反事實(shí)任務(wù)上的準(zhǔn)確率下降到大約54%(隨機(jī)猜測(cè)將產(chǎn)生50%的準(zhǔn)確率)。

作者展示了幾種其他類(lèi)型的任務(wù),也有類(lèi)似的效果。他們得出結(jié)論,大型語(yǔ)言模型表面上的推理能力可能在很大程度上依賴(lài)于訓(xùn)練數(shù)據(jù)中的模式,即“近似檢索”而非一般的抽象推理能力。

Meta的Yann LeCun在X(推特)上表示贊同:

ASU的Subbarao Kambhampati表示贊同:

另一篇使用這種評(píng)估范式的論文是《Embers of Autoregression: Understanding Large Language Models Through the Problem They are Trained to Solve》(《自回歸余燼:通過(guò)訓(xùn)練任務(wù)理解大型語(yǔ)言模型》)。“自回歸余燼”這個(gè)短語(yǔ)是對(duì)另一篇知名LLM論文《Sparks of AGI》(《AGI火花》)標(biāo)題的幽默戲仿。其觀點(diǎn)是,由于像GPT-4這樣的LLM是通過(guò)自回歸訓(xùn)練的(即預(yù)測(cè)輸入中的下一個(gè)標(biāo)記),它們的行為將反映自回歸所帶來(lái)的偏見(jiàn)。

例如,考慮將句子中的單詞順序顛倒的簡(jiǎn)單任務(wù):

輸入:paintings. the with pleased totally not was he True,

正確輸出:True, he was not totally pleased with the paintings.

你可能會(huì)認(rèn)為執(zhí)行此任務(wù)的能力不依賴(lài)于句子中的特定單詞。然而,當(dāng)輸出句子是可能的(即,根據(jù)前一個(gè)標(biāo)記計(jì)算出的每個(gè)標(biāo)記的概率高)時(shí),GPT-3.5和GPT-4在這個(gè)任務(wù)上的表現(xiàn)都很好;但在輸出句子不太可能時(shí),這些系統(tǒng)在該任務(wù)上的表現(xiàn)要差得多,例如,對(duì)于這個(gè)例子:

輸入:paintings. the with pleased he totally was not True,

正確輸出:True, not was totally he pleased with the paintings.

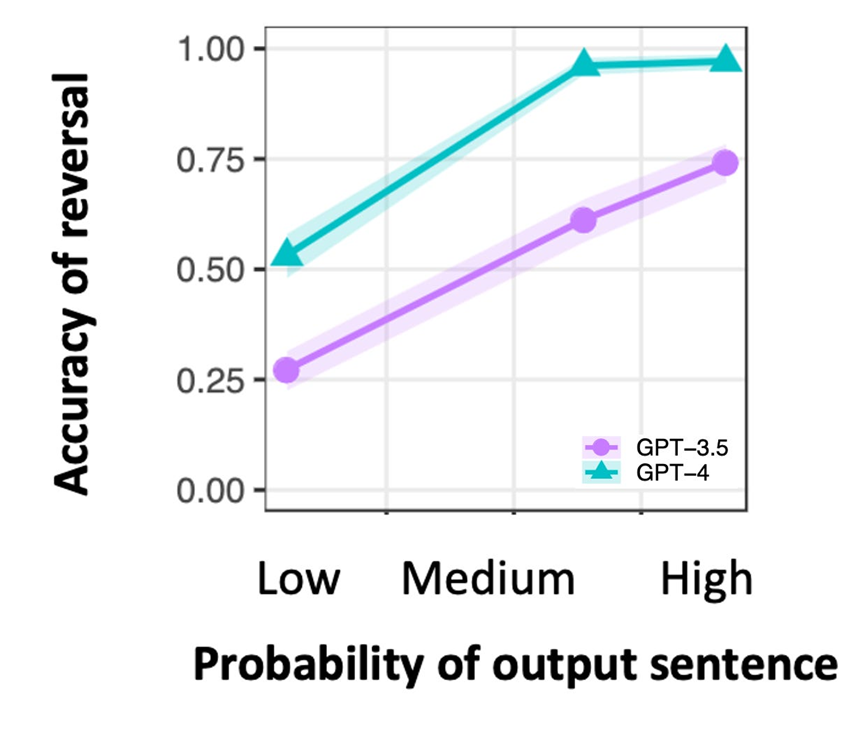

以下是總體表現(xiàn)情況,與LLM計(jì)算的輸出句子的概率對(duì)比繪制的圖表:

盡管輸出句子的概率無(wú)關(guān)緊要,但LLM的訓(xùn)練目標(biāo)是預(yù)測(cè)可能的下一個(gè)標(biāo)記,這泄露到了模型在任務(wù)上的表現(xiàn)中——這是一種自回歸的痕跡。論文中給出了更多的例子。

許多其他“壓力測(cè)試”LLM推理能力的論文也顯示了類(lèi)似的結(jié)果。在本文結(jié)尾,我提供了各種關(guān)于這一主題的論文鏈接,供讀者跟進(jìn)。

總之,LLM似乎具有一定的推理能力,但如果不對(duì)它們進(jìn)行壓力測(cè)試(例如,通過(guò)反事實(shí)任務(wù)),就無(wú)法得出它們?cè)谝话闱闆r下進(jìn)行推理,而不是依賴(lài)于其訓(xùn)練數(shù)據(jù),以無(wú)法泛化到分布外示例的方式進(jìn)行推理的結(jié)論。

在下一篇文章中(即將發(fā)布),我將描述我的團(tuán)隊(duì)正在進(jìn)行的工作,即應(yīng)用反事實(shí)任務(wù)范式來(lái)壓力測(cè)試LLM是穩(wěn)健和普遍類(lèi)比推理者的說(shuō)法。

附錄:使用反事實(shí)任務(wù)(或相關(guān)壓力測(cè)試)評(píng)估LLM的論文

Wu, Z., Qiu, L., Ross, A., Akyürek, E., Chen, B., Wang, B., Kim, N., Andreas, J., & Kim, Y. (2023). 《Reasoning or reciting? Exploring the capabilities and limitations of language models through counterfactual tasks》. arXiv preprint arXiv:2307.02477.

McCoy, R. T., Yao, S., Friedman, D., Hardy, M., & Griffiths, T. L. (2023). 《Embers of autoregression: Understanding large language models through the problem they are trained to solve》. arXiv preprint arXiv:2309.13638.

Miceli-Barone, A. V., Barez, F., Konstas, I., & Cohen, S. B. (2023). 《The larger they are, the harder they fail: Language models do not recognize identifier swaps in Python》. arXiv preprint arXiv:2305.15507.

Shapira, N., Levy, M., Alavi, S. H., Zhou, X., Choi, Y., Goldberg, Y., Sap, M. & Shwartz, V. (2023). 《Clever Hans or neural theory of mind? Stress testing social reasoning in large language models》. arXiv preprint arXiv:2305.14763.

Verma, M., Bhambri, S., & Kambhampati, S. (2024年3月). 《Theory of Mind abilities of Large Language Models in Human-Robot Interaction: An Illusion?》. In Companion of the 2024 ACM/IEEE International Conference on Human-Robot Interaction (pp. 36-45).

Srivastava, S., PV, A., Menon, S., Sukumar, A., Philipose, A., Prince, S., & Thomas, S. (2024). 《Functional Benchmarks for Robust Evaluation of Reasoning Performance, and the Reasoning Gap》. arXiv preprint arXiv:2402.19450.

Lewis, M., & Mitchell, M. (2024). 《Using counterfactual tasks to evaluate the generality of analogical reasoning in large language models》. arXiv preprint arXiv:2402.08955.

本文轉(zhuǎn)載自 ??MoPaaS魔泊云??,作者: Melanie mitchell