速看!AI大模型性能最新排名 原創

大家好,我是橙哥!今天我們來盤點一下主流AI大模型各方面性能的最新排名,分別從質量、速度、價格、對話能力、推理能力、編碼、響應時間等能力來進行對比。

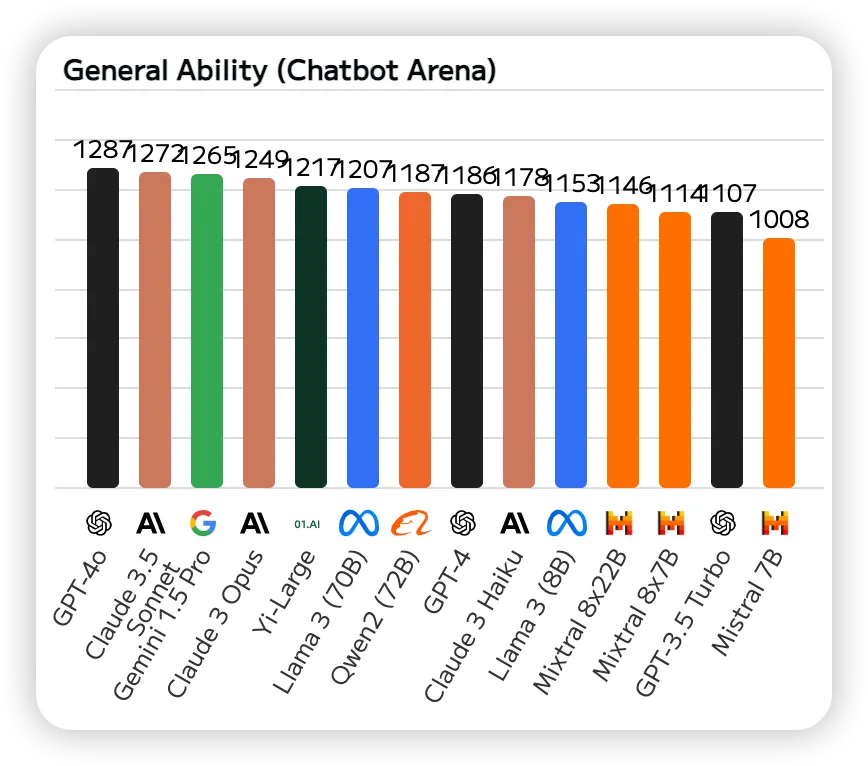

一、對話能力

Chatbot Arena是一個基于眾包的大型模型評測基準。它為開發者和研究者提供了一個平臺,在這里可以發布、測試和比較各種類型的聊天機器人,下面是根據Chatbot Arena的榜單排名。我們可以看出前三名是:GPT-4o、Claude 3.5 Sonnet、Gemini 1.5 Pro。

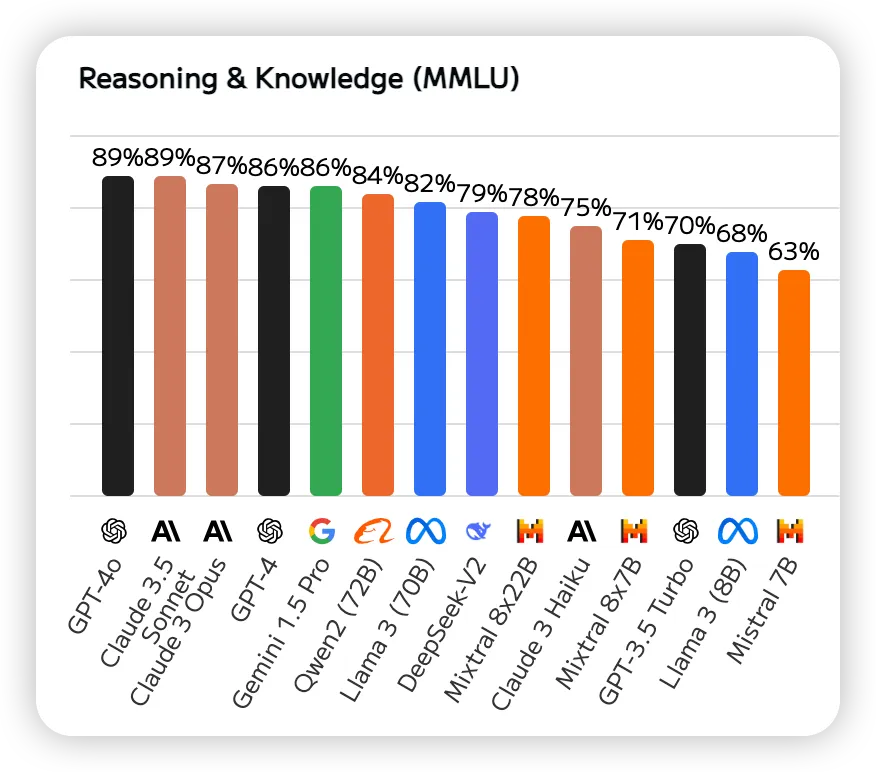

二、推理能力

MMLU(大規模多任務語言理解)是一項綜合評估,MMLU 涵蓋基礎數學、美國歷史、計算機科學和法律等 57 項任務。它需要模型來展示廣泛的知識基礎和解決問題的能力,下面是AI大模型根據MMLU的最新排名。我們可以看出前三名是GPT-4o、Claude 3.5 Sonnet、Claude 3 Opus。

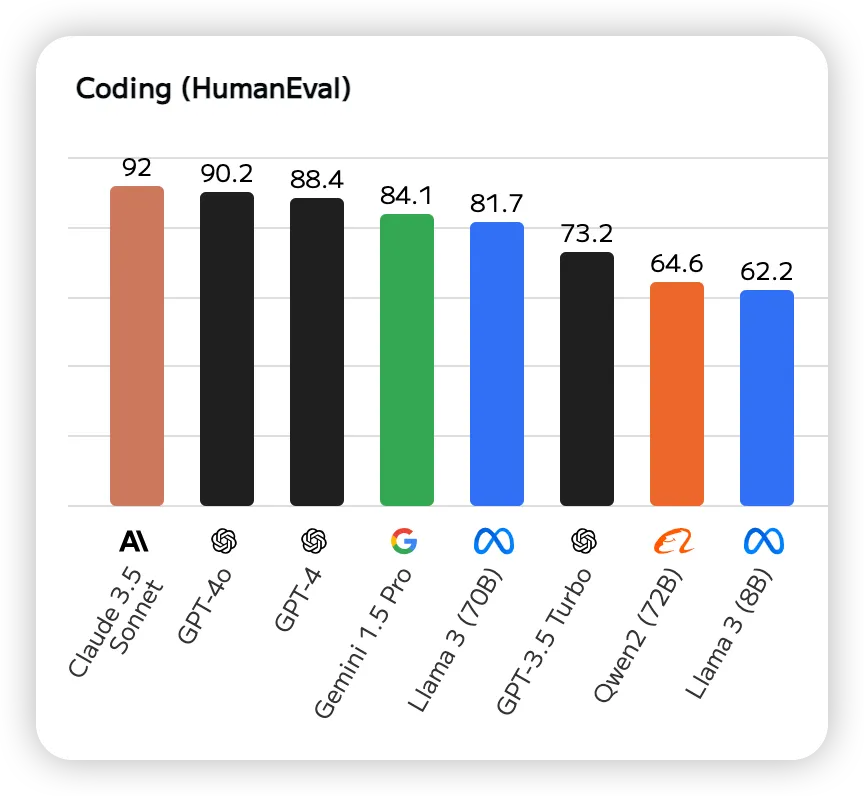

三、編程能力

HumanEval是一個用于評估代碼生成模型性能的數據集,包含164個編程問題,每個問題都包括一個函數簽名、文檔字符串(docstring)、函數體以及幾個單元測試。這些問題涵蓋了語言理解、推理、算法和簡單數學等方面。下面是根據HumanEval排名的最新榜單。前三名是:Claude 3.5 Sonnet、GPT-4o、GPT-4。

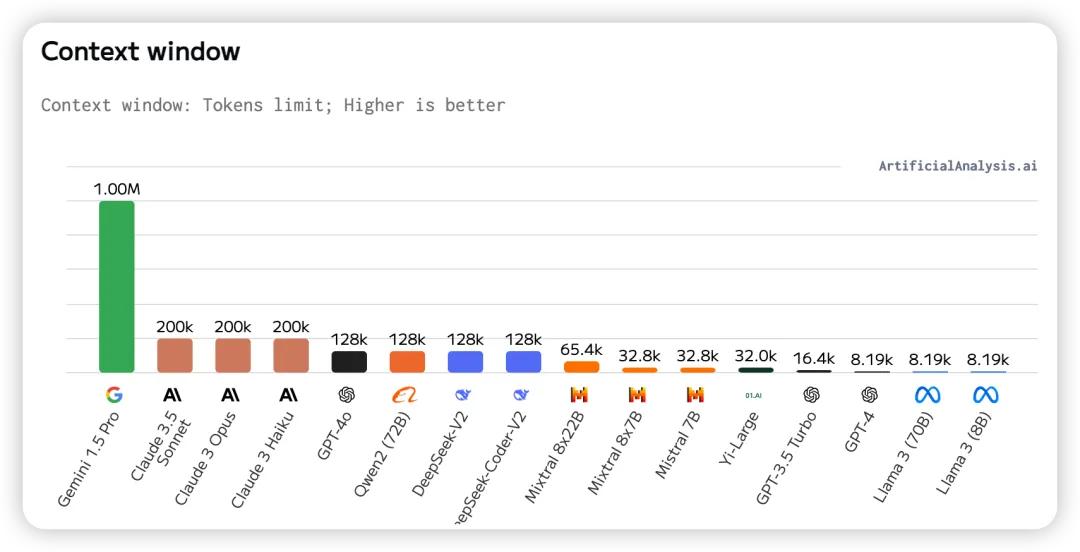

四、上下文窗口

上下文窗口指的是輸入和輸出標記的最大組合數量。當涉及到 RAG(檢索增強生成)和大模型的工作流時,更大的上下文窗口變得非常重要,這些工作流通常需要對大量數據進行推理和信息檢索。我們可以看到前三名是:Gemini 1.5 Pro、Claude 3.5 Sonnet、Claude 3 Opus。

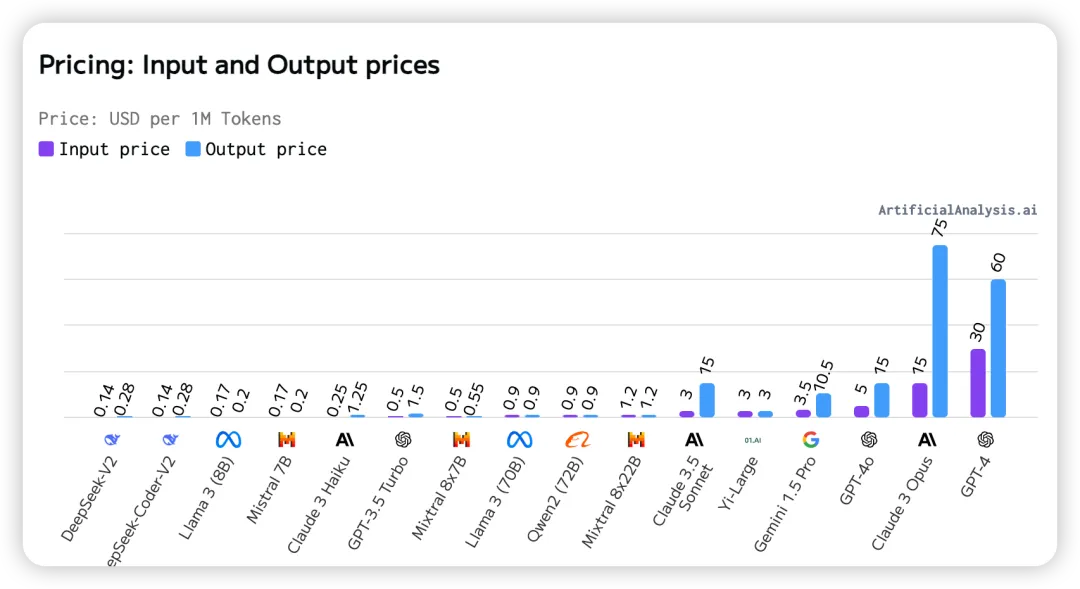

五、輸入輸出的價格

每百萬tokens的美元價格,排名越靠前越便宜。在這里我們可以看到國內的DeepSeek大模型價格最低,價格最高的是GPT-4。

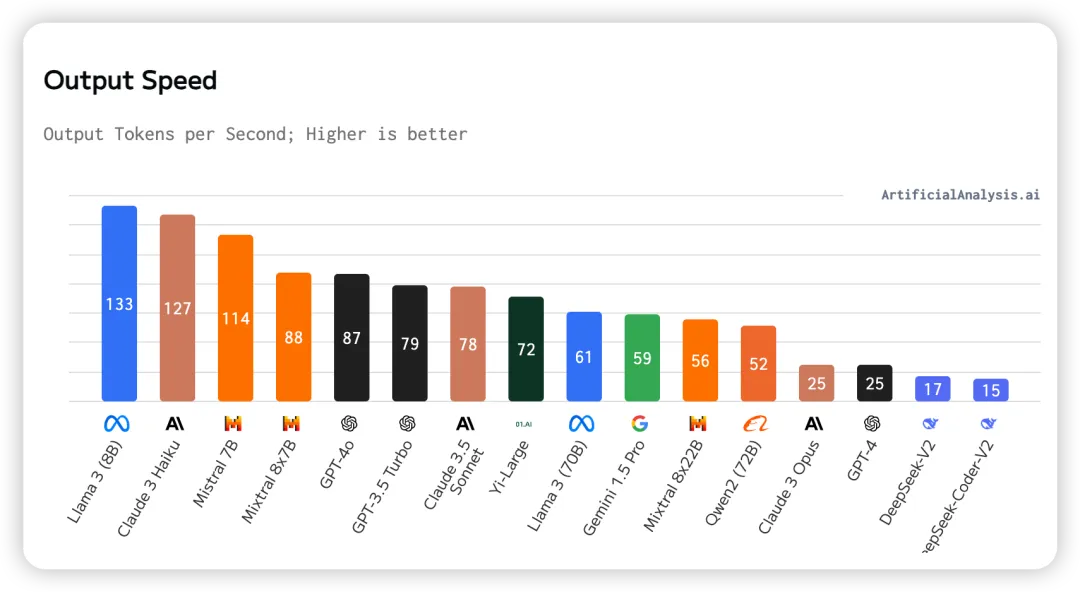

六、輸出速度

模型生成token時每秒輸出的token數量。 在這里我們可以看到輸出速度最快的是Llama 3(8B),輸出最慢的是DeepSeek-Coder-V2。

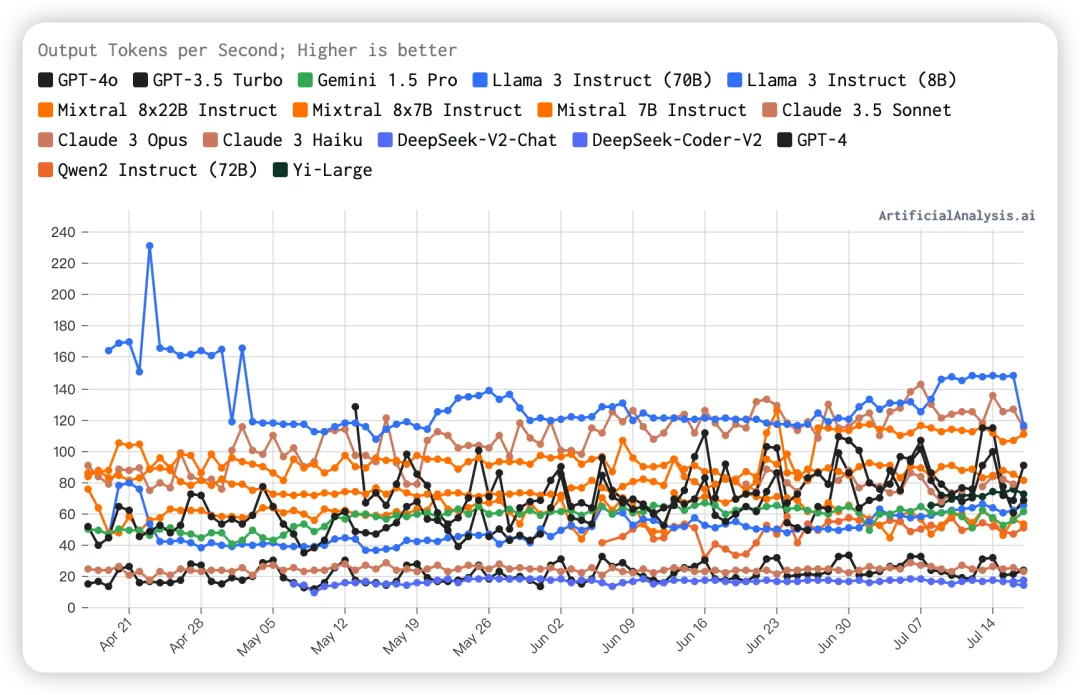

七、隨時間變化的輸出速度

我們從圖中可以看出Llama3 Instruct(8B)的輸出速度一直保持較高水平,不過最近有點下降。

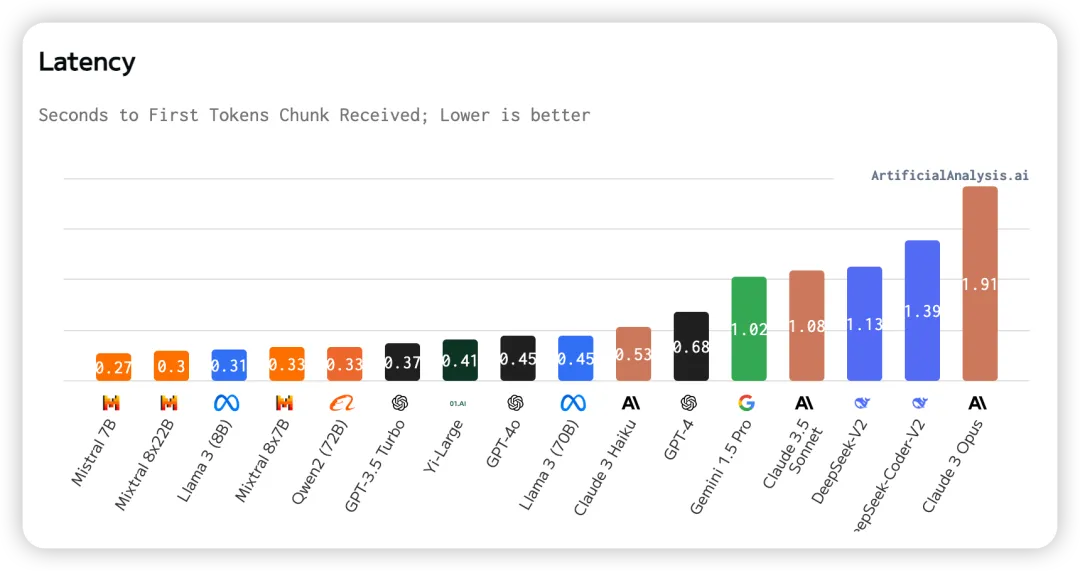

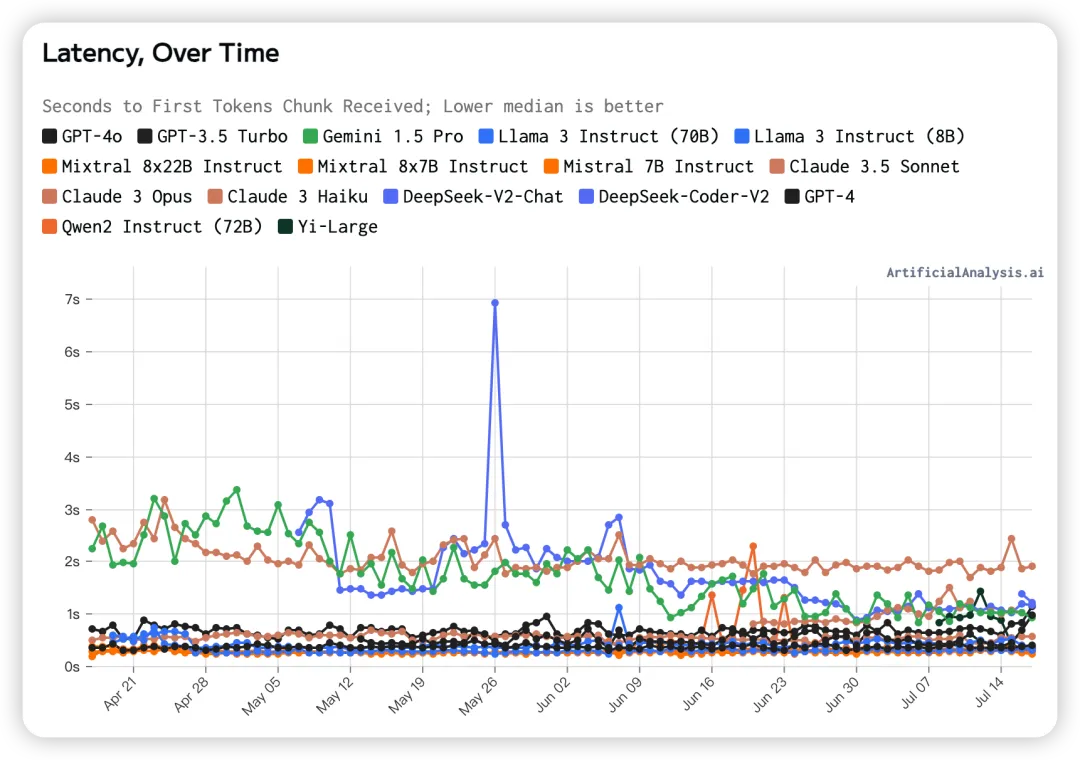

八、延遲

延遲的定義為發送 API 請求后,接收到第一個token所需的時間。在圖中我們可以看到Mistral 7B的延遲最低,Claude 3 Opus的延遲最高。

九、隨時間變化的延遲

從圖中我們可以清晰地看出Claude 3 Opus的延遲一直較高,而Gemini 1.5 Pro的延遲有明顯的改善。其他大模型的延遲都較低。

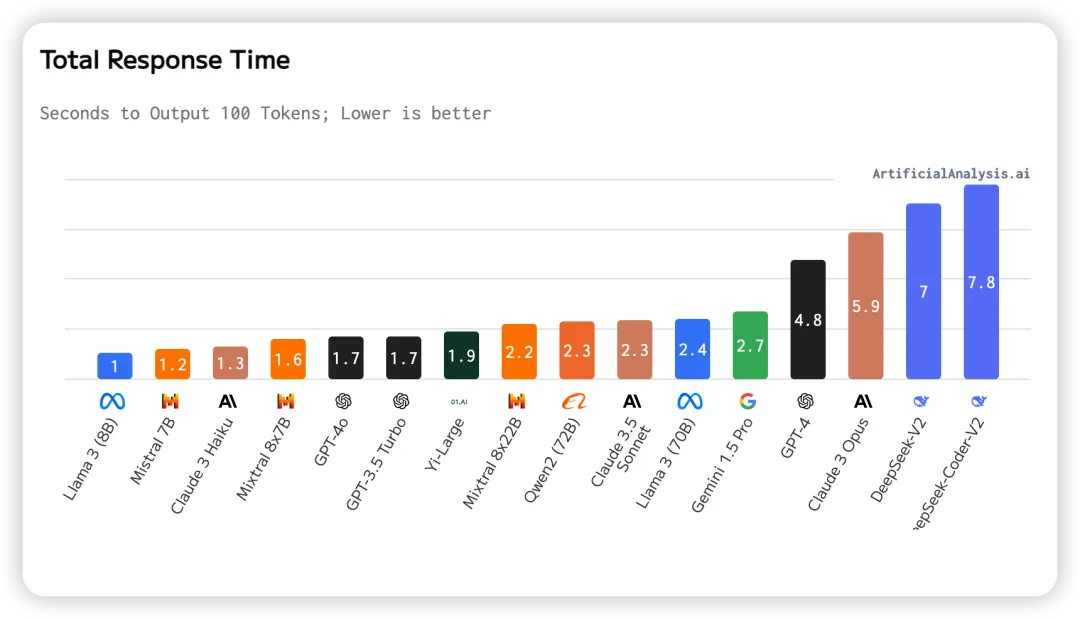

十、總響應時間

總響應時間為接收 100 個tokens所需的時間。根據延遲(接收第一個token的時間)和輸出速度(每秒輸出token數量)估算得出。從圖中我們可以看出Llama3(8B)的總響應時間最短,而DeepSeek-Coder-V2的總響應時間最長。

大模型各方面的性能對我們開發AI產品的應用場景至關重要,對大模型各方面的性能進行測評可以幫助我們選擇合適的選擇合適的大模型和API提供商。無論是優化質量、提升速度、控制成本,還是需要特定的應用能力,這些大模型都為我們提供了豐富的選擇。

本文轉載自公眾號AIGC開發者,作者:阿橙AIGC

原文鏈接:??https://mp.weixin.qq.com/s/d0DNuxivD4YZSOSYEufVrA??