SpreadsheetLLM:微軟對Excel編碼的“攤膀伏” 原創 精華

1.SpreadsheetLLM

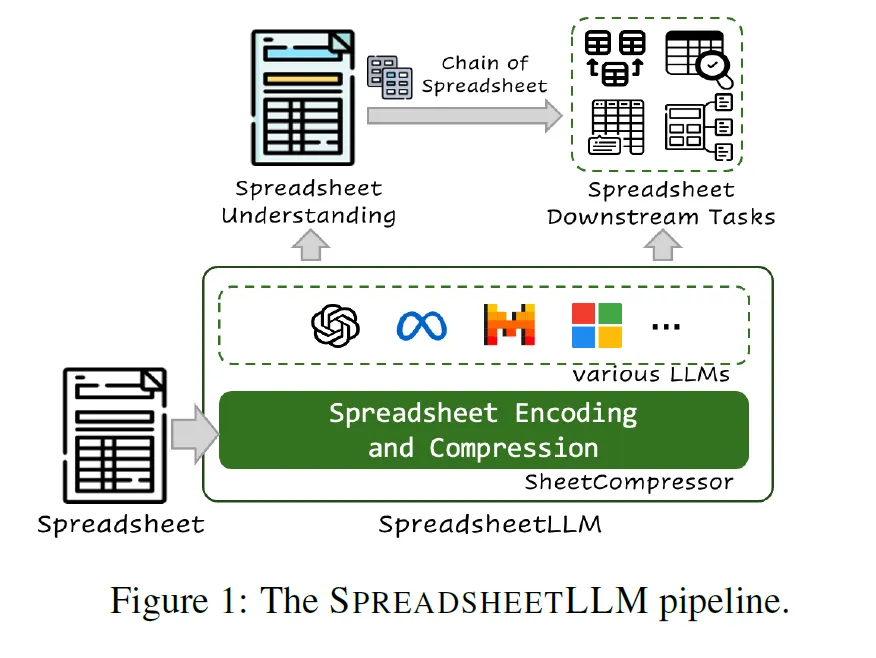

Excel的特點是二維數據格式、靈活的布局和多樣化的格式選項。微軟最近引入了SpreadsheetLLM,開創了一種高效的編碼方法,用于釋放和優化LLMs在電子表格上的強大理解和推理能力。最初研究人員提出一種包含單元格地址、值和格式的普通序列化方法。但是這種方法受到LLMs 上下文長度的約束,為此微軟推出了SheetCompressor(下圖綠色部分),它是一種創新的編碼框架,可以有效地壓縮電子表格。

左邊為文檔輸入,經過SheetCompressor的壓縮編碼,之后將編碼輸入到現有的大模型,進而加深大模型對電子表格的深入理解,最后利用chain of Spreadsheet完成下游任務。

SSLLM最終在GPT4的上下文學習中比普通方法高出25.6%。此外,利用SheetCompressor進行微調的平均壓縮比為25×,卻達到了最先進的 78.9%F1 分數,比目前的優等生高出12.3%。

最后研究人員還提出了電子表格鏈,用于電子表格理解的下游任務,事實證明SpreadsheetLLM在各種電子表格任務中非常有效。

2.SheetCompressor

SheetCompressor是這次研究的靈魂,本文重點來看看它的實現模式。它主要由三個模塊組成:基于結構錨點的壓縮、逆索引轉換和數據格式感知聚合。

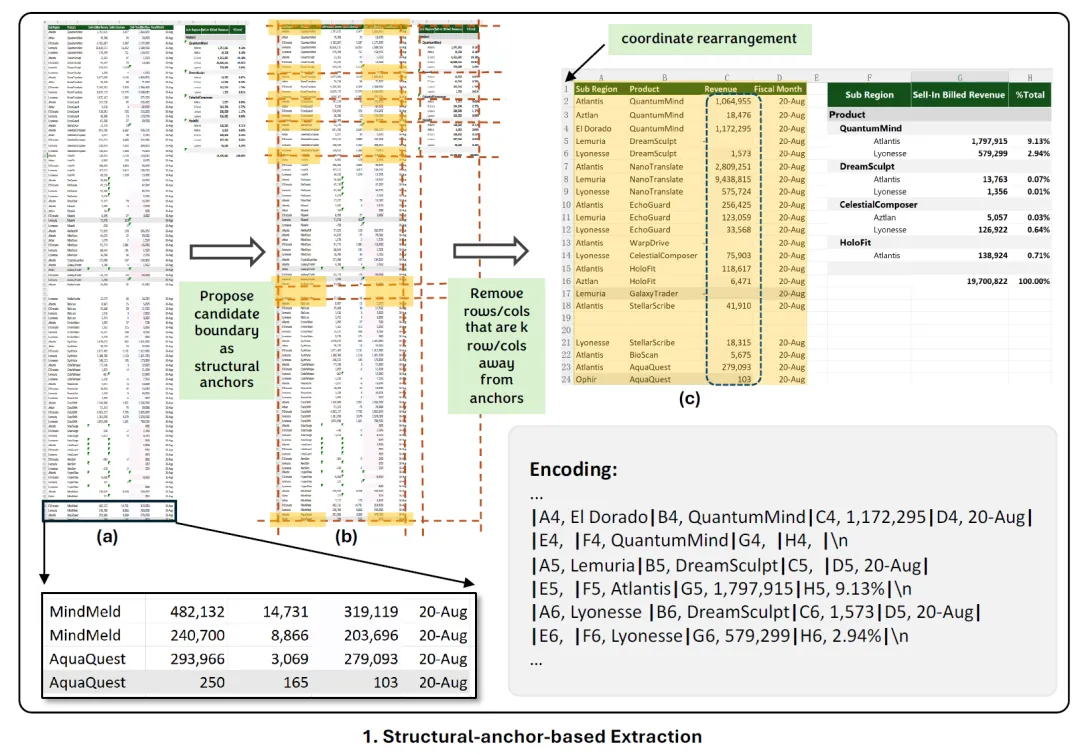

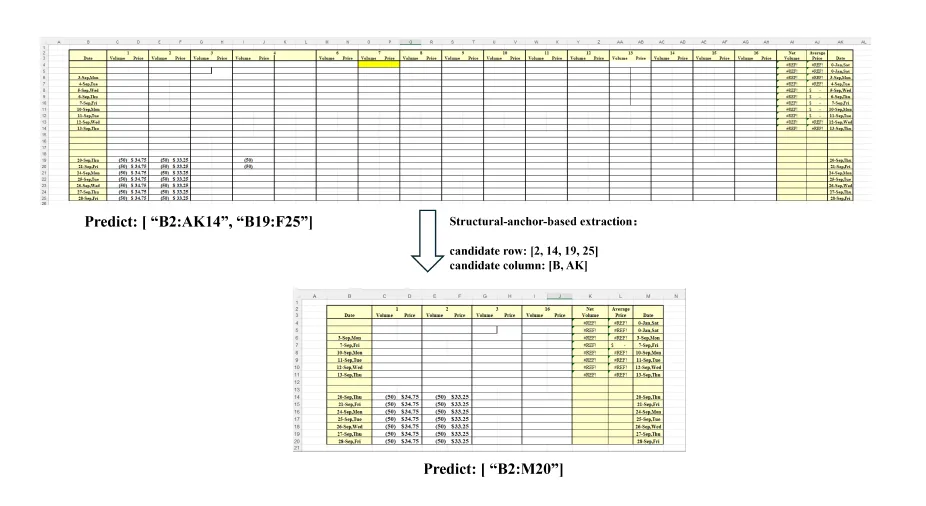

首先在在整個電子表格中放置“結構錨點”,以幫助LLM更好地了解正在發生什么。

然后,刪除“遙遠的、均勻的行和列”,以生成電子表格的壓縮“骨架”版本,如上圖所示。

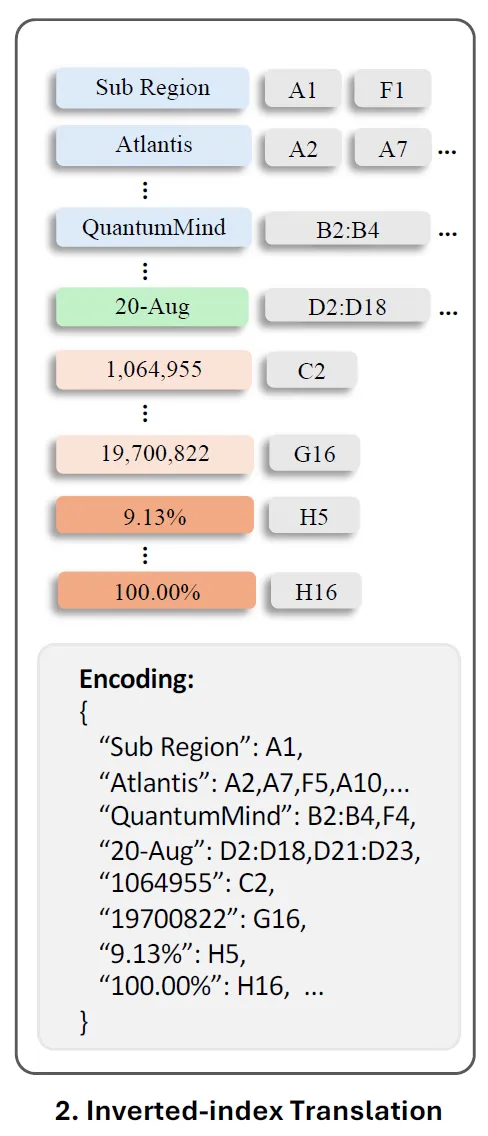

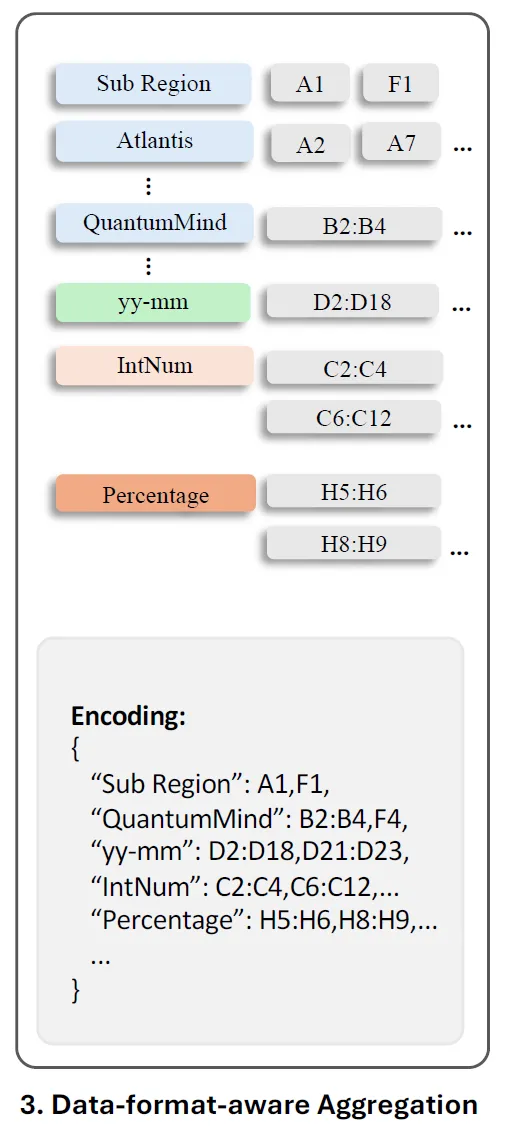

索引轉換解決了由具有大量空單元格和重復值的電子表格引起的挑戰。“為了提高效率,SheetCompressor擺脫了傳統的逐行和逐列序列化,采用JSON格式的無損倒排索引翻譯,” 研究人員表示 “這種方法創建了一個字典,該字典為非空單元格文本編制索引,并將具有相同文本的地址合并,在保證數據完整性的同時且優化Token長度。”

<輸入Token的長度很重要,因為這些經過編碼的Token下一步就會被送到各種大模型學習,而大模型對于輸入Token是有限制的!>

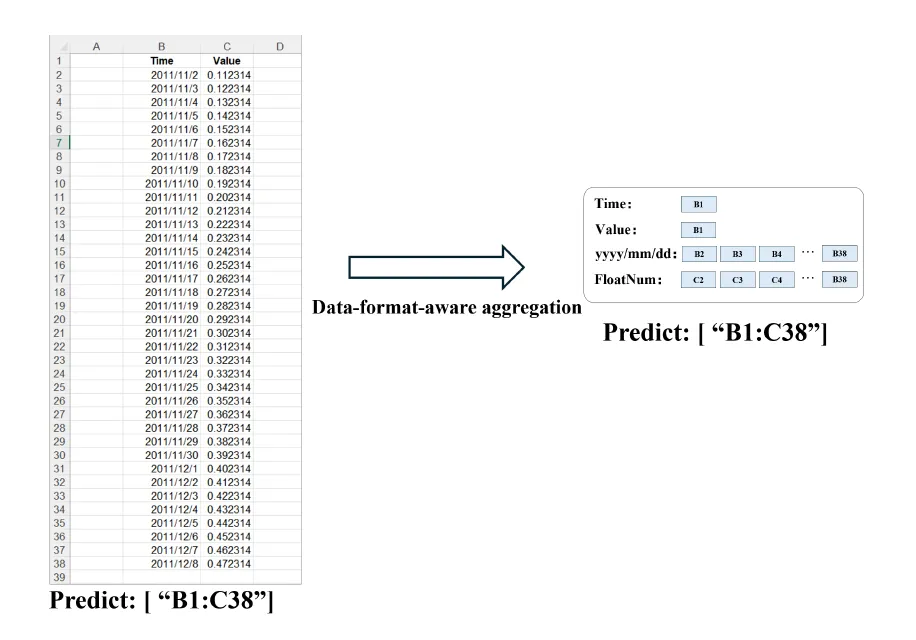

認識到精確的數值對于掌握電子表格結構不太重要,研究人員從這些單元格中提取數字格式字符串和數據類型。

然后具有相同格式或類型的相鄰單元格聚集在一起,進而簡化對數值數據分布的理解,而不會浪費Token長度。

通過上面三種辦法的疊加組合,SheetCompressor顯著減少了96%的電子表格的Enbedding Token。在文中的一個示例中,電子表格由576行和23列組成,原始編碼為61,240個標記。按照新的技術首先使用結構錨提取單元格,將它們重新排列成一個較小的24×8工作表。隨后執行索引反轉,刪除空單元格。最后根據數據格式聚合單元格,實現電子表格的極其緊湊的表示,其中僅包含708個標記!

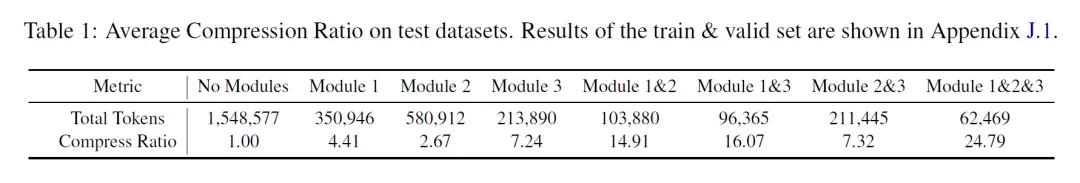

上表為三個組件在測試數據集上面的各種組合壓縮比率清單,第一列為沒有運用任何手段,所以壓縮比率為1(原始的Token長度/壓縮的Token長度)。可以觀察到三種方法組合可以達到24.79的壓縮比例。

3.性能對比

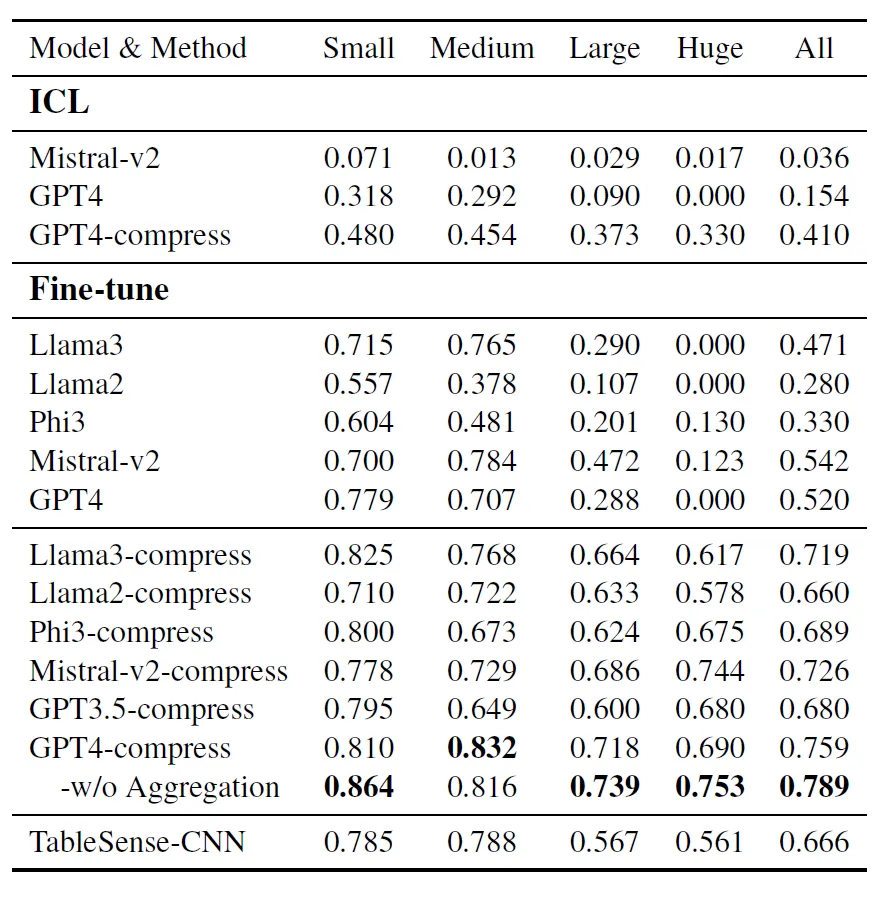

為了評估SpreadsheetLLM的性能,研究人員選擇了TableSense-CNN作為基線,因為之前在電子表格檢測任務中證明了有效性。本次采用F1分數作為主要指標來評估和比較不同模型的性能,它平衡了精確度和召回率,提供了模型準確性的整體視圖。

微調后GPT4模型在所有數據集上獲得了約 76%的F1分數,而利用本文涉及的不帶聚合編碼的方法在所有數據集上獲得了約79%的F1分數。

這標志著與在原始數據上微調的相同模型相比提高了27%,比 TableSense-CNN提高了13%,并成為新的王(SOTA)。整個編碼方法在可容忍的范圍內略微降低了F1分數,但取得了良好的壓縮結果。

此外基于本文的壓縮方法,Llama3的分數加了25%,Phi3增加了36%,Llama2增加了38%,Mistral-v2增加了18%。這些結果突顯了編碼方法顯著增強了性能,也就是說它改善了上下文學習(In-Context Learning)。同時還節省了大量的成本,這種方法的成本幾乎與輸入Token成正比,根據ICL中GPT4和GPT3.5-turbo型號的價格,在測試集中降低了96%的成本。