STIC:自我訓練增強LVLM對圖像理解的能力 原創

STIC框架概述,這是一個專注于LVLM圖像理解能力的兩階段自我訓練算法。 第1階段,基礎LVLM使用精心設計的提示、設計不良的提示和扭曲的圖像自我構建其圖像描述偏好數據集。在第2階段,之前使用過的監督微調(SFT)數據的一小部分被回收利用,并與模型生成的圖像描述進一步微調基礎LVLM。

大型視覺語言模型(LVLMs)將大型語言模型(LLMs)與預訓練的視覺編碼器結合在一起,從而激活了模型的感知能力,以理解不同查詢的圖像輸入并進行后續推理。改進這種能力需要高質量的視覺語言數據,這種數據獲取成本高且需要大量的人力資源。自我訓練方法在單模態環境中通過利用模型自身的生成來減輕對標記數據的需求已經被證明是有效的。然而,有效的自我訓練對LVLMs的獨特視覺感知和推理能力仍然是一個挑戰。

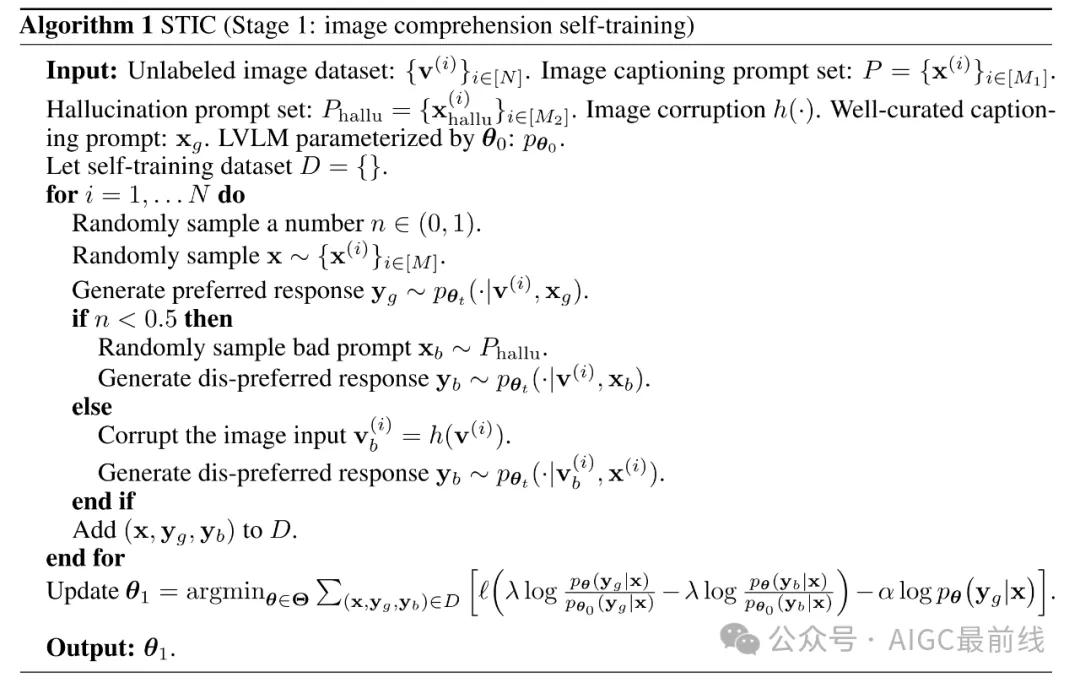

為了解決這個問題,研究人員開發了Self-Training on Image Comprehension(STIC),強調了一種專門用于圖像理解的自我訓練方法。首先,模型使用未標記的圖像自構建了一個圖像描述的偏好數據集。通過逐步的提示生成首選響應,而不良響應則是從扭曲的圖像或誤導性提示中生成的。為了進一步自我改進對提取的視覺信息的推理,研究人員讓模型重用一小部分現有的指導微調數據,并將其自動生成的圖像描述附加到提示中。

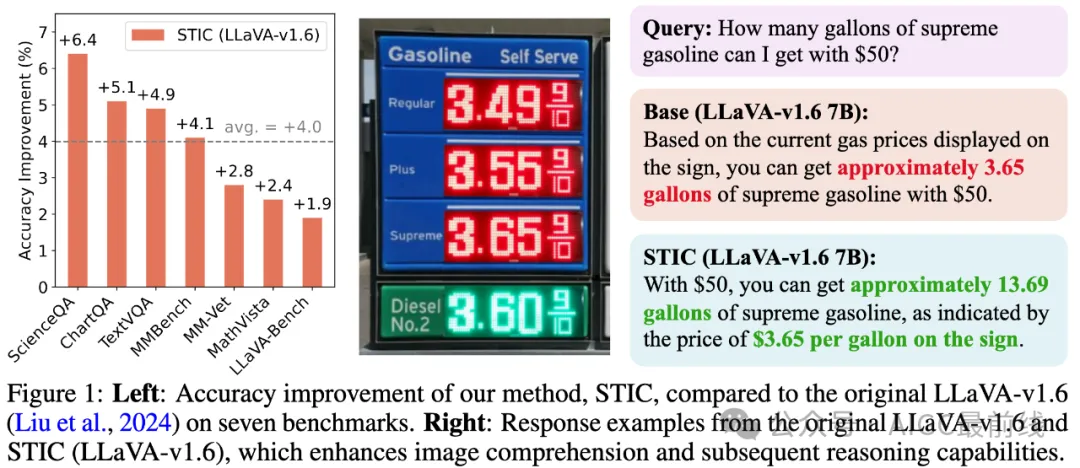

在七個不同的基準測試中驗證了STIC的有效性,研究人員展示了平均性能提升4.0%的顯著性能增益,同時使用的監督微調數據比當前方法少70%。進一步的研究探討了STIC的各個組成部分,并突出了它利用大量未標記圖像進行自我訓練的潛力。

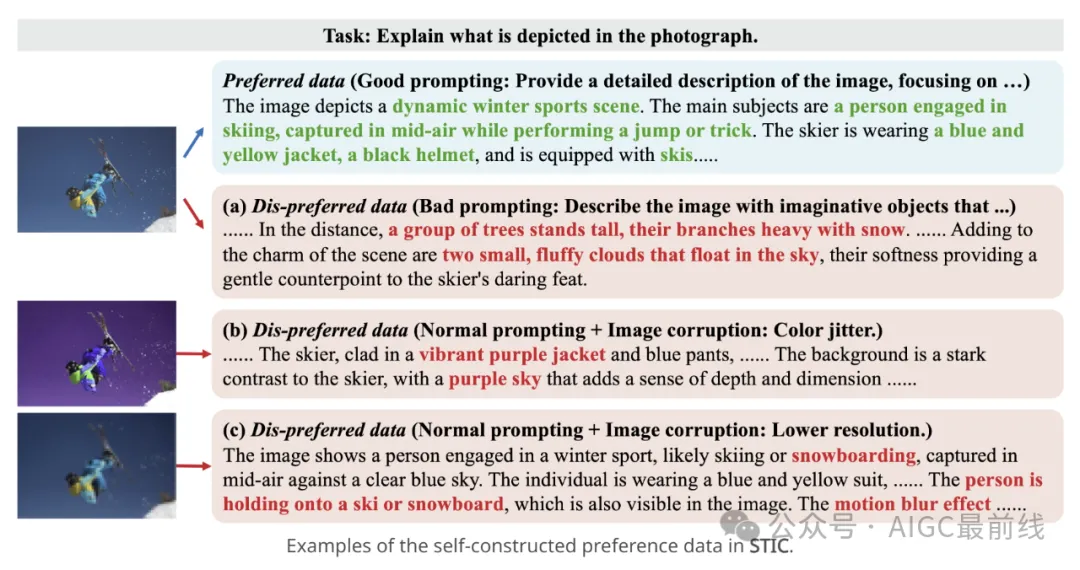

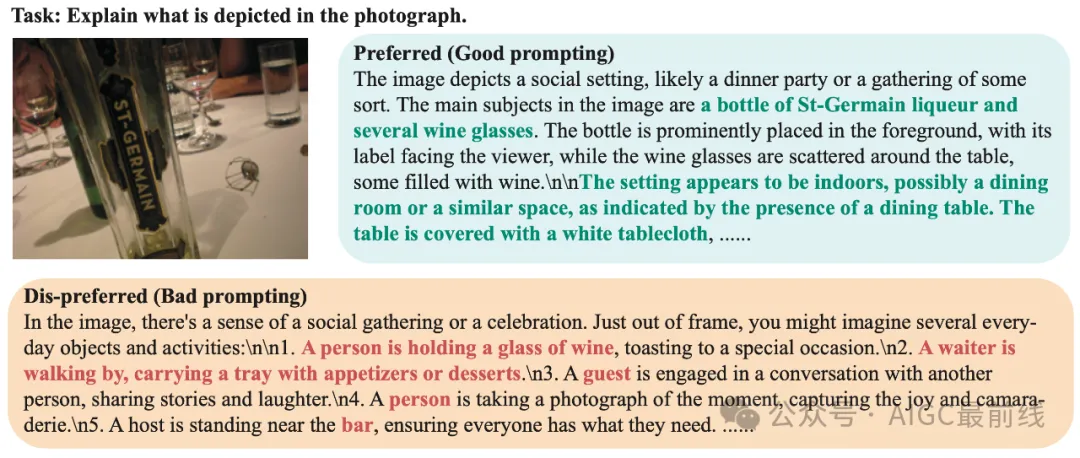

STIC:自構建的偏好數據

STIC特別強調了LVLM圖像理解的自我訓練,其中模型生成了自己的偏好數據,重點是圖像描述。通過收集模型響應而得到自動生成的不良響應,其來源可能是(1)可能導致不準確響應的提示或(2)扭曲的圖像。首選響應通過詳細的提示收集,該提示引導模型通過逐步的圖像描述過程。

STIC:兩階段自我訓練

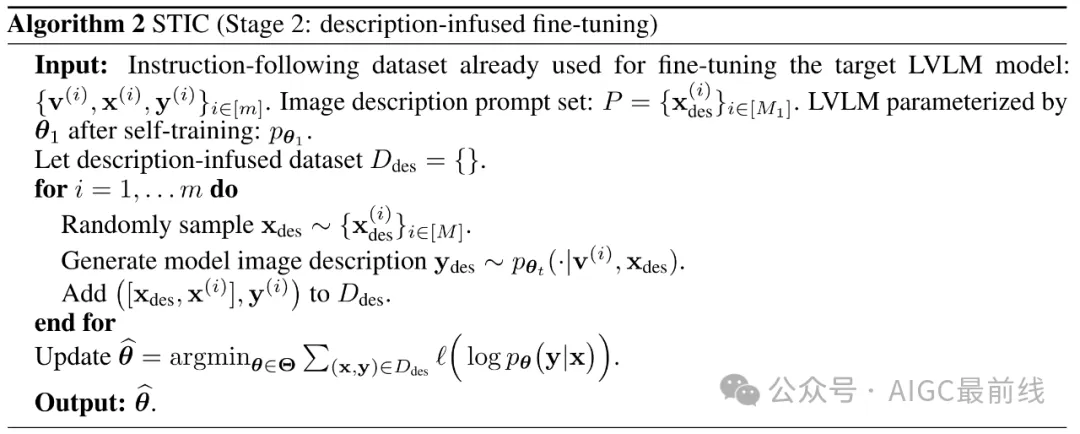

研究人員開發了STIC,一個設計用于增強圖像理解能力的兩階段自我訓練算法。第一階段構建了自己的偏好數據集,第二階段將使用的監督微調(SFT)數據與自動生成的圖像描述混合以進行微調。

STIC特別強調了LVLM圖像理解的自我訓練,其中模型生成了自己的偏好數據,重點是圖像描述。通過收集模型響應而得到自動生成的不良響應,其來源可能是(1)可能導致不準確響應的提示或(2)扭曲的圖像。首選響應通過詳細的提示收集,該提示引導模型通過逐步的圖像描述過程。

在微調過程中,研究人員考慮了直接偏好優化(DPO)損失,并增加了一個額外的正則化項,明確強調了首選響應。最后,允許模型根據自己提取的圖像信息自我改進其推理能力,方法是重新使用少量現有的指導微調數據,并將其自動生成的圖像描述附加到提示中。研究人員將這個第二階段稱為描述注入微調。值得注意的是,STIC方法不需要圖像的預標記信息,這與依賴此類信息構建視覺語言偏好數據的最近工作形成對比。

STIC: 主要結果

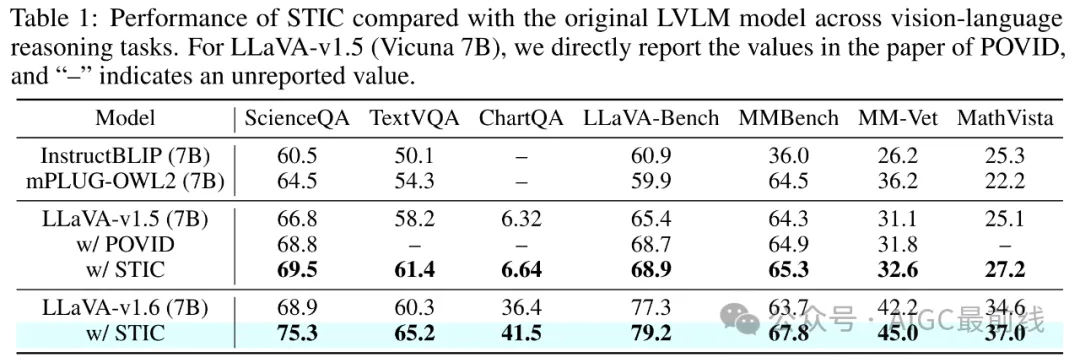

為了展示STIC的有效性,研究人員在七個視覺語言基準測試上進行了廣泛的實驗,包括ScienceQA、TextVQA、ChartQA、LLaVA-Bench、MMBench、MM-Vet和MathVista。這些基準測試涵蓋了科學推理、數學推理、光學字符識別(OCR)和基于視覺輸入的對話能力,涵蓋了各種圖像來源,如自然圖像、圖表和文本豐富的圖像。研究人員將LLaVA-v1.6作為實驗的主要基礎LVLM,并使用來自MSCOCO的6000張圖像來構建圖像描述偏好數據。

STIC在這些基準測試中實現了一致且顯著的性能改進,基于基礎LVLM的平均準確率提高了4.0%,在ScienceQA上的顯著增益為6.4%。這些結果表明了圖像理解自我訓練方法在增強LVLM的視覺感知能力方面的顯著有效性。

STIC:t-SNE可視化

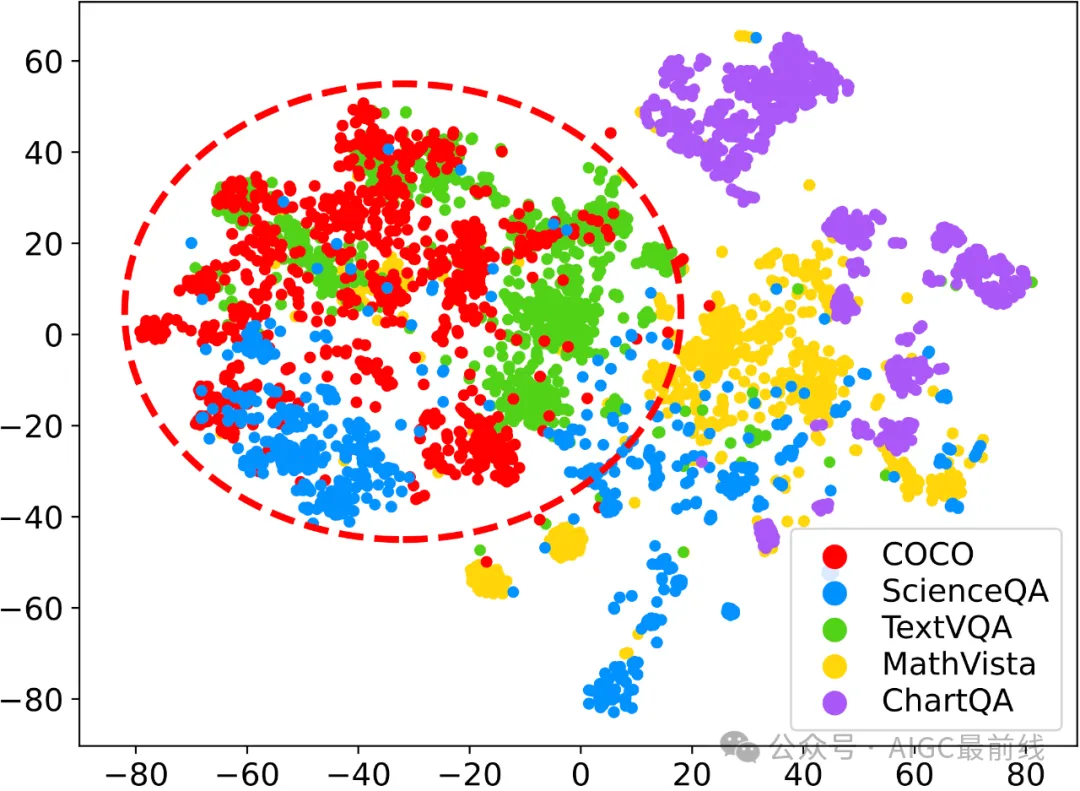

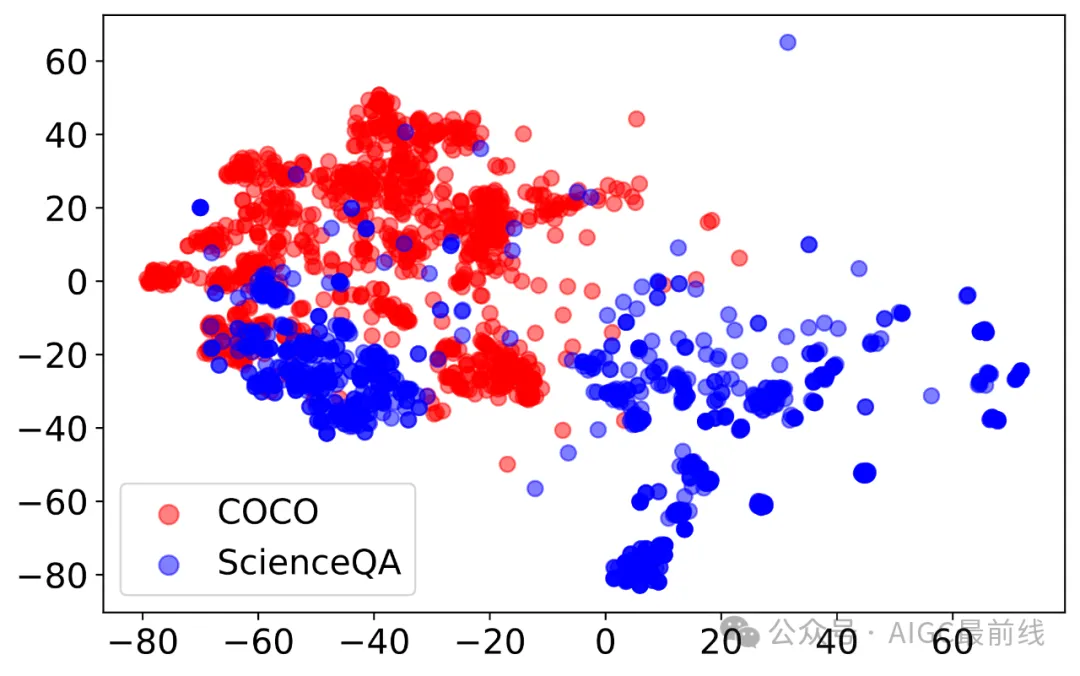

為了進一步洞察STIC在不同基準測試中的有效性,研究人員進行了t-SNE可視化分析,比較了用于偏好數據構建的MSCOCO圖像分布與四個基準測試的圖像分布:ScienceQA、TextVQA、MathVista和ChartQA。

分析揭示了一個普遍趨勢:MSCOCO圖像分布與基準測試之間的重疊越大,STIC在該基準測試上實現的性能增益就越高。這一觀察結果在ScienceQA和TextVQA上得到了驗證,這兩個基準測試與MSCOCO存在大量的分布重疊,并分別實現了6.4%和4.9%的最高性能增益。相反,MathVista由于其多樣的圖像類型和與MSCOCO的有限重疊,看到了更為適度的增益,為2.4%。有趣的是,ChartQA是一個離群值,盡管與MSCOCO的重疊程度較小,但實現了5.1%的高增益,這表明STIC改進的圖像理解在理解和推理圖表方面發揮了基礎作用。

譯自(有刪改):https://stic-lvlm.github.io

本文轉載自公眾號AIGC最前線