基于Mamba架構的,狀態空間音頻分類模型AUM

Transformer憑借強大的自注意力機制,成為文本、音頻、視頻等模型的基礎架構之一。但其計算復雜度隨著序列長度的增加而呈指數級增長,這在處理長序列數據時會出現嚴重的效率問題。

韓國高等科學技術院的研究人員受最新的Mamba架構啟發,開發了首個沒有自注意力機制純粹狀態空間的音頻分類模型Audio Mamba(下面簡稱“AUM”)。

狀態空間是Mamba架構的核心功能之一,這是一種用于描述和預測系統狀態隨時間變化的數學模型,通過維護一個隱藏狀態來映射輸入序列到輸出,可幫助模型能夠以線性時間復雜度高效處理數據,無論序列多長都沒有問題。

論文地址:https://arxiv.org/abs/2406.03344

AUM架構簡單介紹

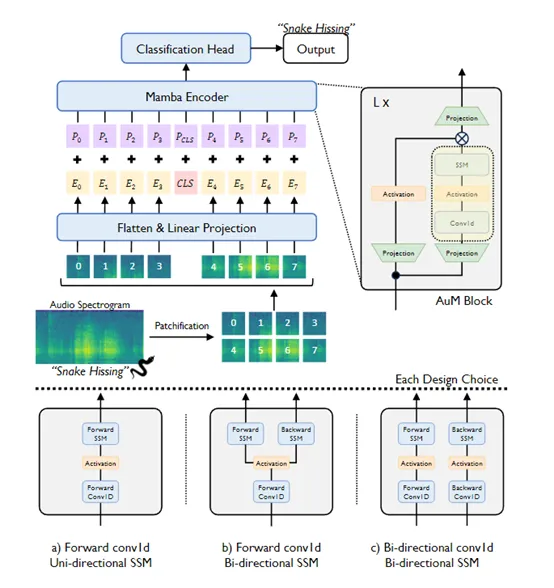

在AUM架構中,先通過傅里葉變換方法,將原始的音頻波形首先被轉換成頻譜圖。把得到的頻譜圖隨后被劃分成一系列規則的 “patches”塊。每個patch都是一個正方形矩陣,代表了音頻信號的一個局部特征區域。通過這種方式,將音頻信號被分解為一系列的局部特征,為后續的數據處理奠定了基礎。

接著,每個patch通過一個線性投影層被嵌入到一個高維空間中。在這個嵌入過程不僅將原始的音頻特征轉換為模型可以處理的形式,而且還通過引入一個特殊的分類標記來增強模型的分類能力。

這個分類標記被放置在嵌入序列的中間位置,將作為模型訓練和推理過程中的關鍵元素,幫助模型集中注意力于音頻數據中最重要的部分。

再從序列的末尾開始,通過反向卷積層和狀態空間模型來提取特征,幫助AUM模型能從不同的角度理解音頻數據,增強了模型對音頻信號全局上下文的理解能力。

此外,AUM還采用了一種現代化的硬件優化掃描方法,能夠從輸入序列的開始到結束進行單向掃描,同時更新模型的隱藏狀態。不僅提高了模型的處理效率,還使得模型能夠選擇性地更新其隱藏狀態,從而更有效地捕捉輸入序列中的相關信息。

實驗測試與數據集

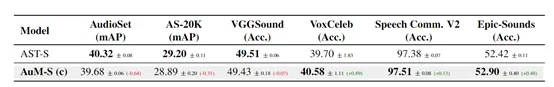

為了測試AUM的性能,研究人員使用了AudioSet、VGGSound、VoxCeleb、Speech Commands V2和EPIC-SOUNDS等多個知名音頻數據集進行了綜合評估。

這些數據集不僅在規模上有所不同,在音頻樣本的多樣性和復雜性上也各有特點。例如,AudioSet數據集包含了超過200萬個10秒長的音頻剪輯,涵蓋了527個不同的標簽;而VGGSound則包含了近20萬個視頻剪輯,每個剪輯都有10秒長,標注了309種不同的聲音類別。

結果顯示,AuM在AudioSet上的平均精準度達到了32.43%,比知名的Audio Spectrogram Transformers(簡稱“AST”)模型高出3.33%;在VGGSound上,準確率提高到42.58%,比AST提升了5.33%。

在VoxCeleb、Epic-Sounds和Speech Commands V2,AuM也顯示出了卓越的數據序列處理性能。

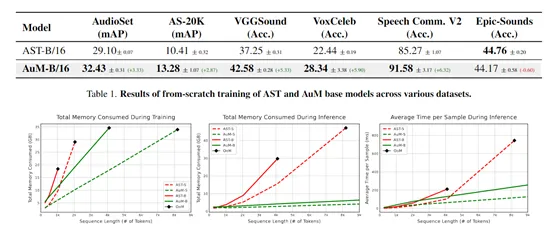

除了性能優秀,AuM對計算效率和內存消耗也比AST強很多。在處理長序列音頻數據時,AuM顯示出了顯著的內存效率,這得益于其基于狀態空間模型的架構,能夠在保持性能的同時減少內存使用。

此外,AuM在推理階段的效率也比AST快,這意味著在實際應用中,AuM能夠提供更快的推理響應,對于需要實時音頻處理的業務場景尤為重要。

本文轉自AIGC開放社區 ,作者:AIGC開放社區