首個基于Mamba的MLLM來了!模型權重、訓練代碼等已全部開源

引言

近年來,多模態大型語言模型(MLLM)在各個領域的應用取得了顯著的成功。然而,作為許多下游任務的基礎模型,當前的 MLLM 由眾所周知的 Transformer 網絡構成,這種網絡具有較低效的二次計算復雜度。為了提高這類基礎模型的效率,大量的實驗表明:(1)Cobra 與當前計算效率高的最先進方法(例如,LLaVA-Phi,TinyLLaVA 和 MobileVLM v2)具有極具競爭力的性能,并且由于 Cobra 的線性序列建模,其速度更快。(2)有趣的是,封閉集挑戰性預測基準的結果顯示,Cobra 在克服視覺錯覺和空間關系判斷方面表現良好。(3)值得注意的是,Cobra 甚至在參數數量只有 LLaVA 的 43% 左右的情況下,也取得了與 LLaVA 相當的性能。

大語言模型(LLMs)受限于僅通過語言進行交互,限制了它們處理更多樣化任務的適應性。多模態理解對于增強模型有效應對現實世界挑戰的能力至關重要。因此,研究人員正在積極努力擴展大型語言模型,以納入多模態信息處理能力。視覺 - 語言模型(VLMs)如 GPT-4、LLaMA-Adapter 和 LLaVA 已經被開發出來,以增強 LLMs 的視覺理解能力。

然而,先前的研究主要嘗試以類似的方法獲得高效的 VLMs,即在保持基于注意力的 Transformer 結構不變的情況下減少基礎語言模型的參數或視覺 token 的數量。本文提出了一個不同的視角:直接采用狀態空間模型(SSM)作為骨干網絡,得到了一種線性計算復雜度的 MLLM。此外,本文還探索和研究了各種模態融合方案,以創建一個有效的多模態 Mamba。具體來說,本文采用 Mamba 語言模型作為 VLM 的基礎模型,它已經顯示出可以與 Transformer 語言模型競爭的性能,但推理效率更高。測試顯示 Cobra 的推理性能比同參數量級的 MobileVLM v2 3B 和 TinyLLaVA 3B 快 3 倍至 4 倍。即使與參數數量更多的 LLaVA v1.5 模型(7B 參數)相比,Cobra 仍然可以在參數數量約為其 43% 的情況下在幾個基準測試上實現可以匹配的性能。

圖 Cobra 和 LLaVA v1.5 7B 在生成速度上的 Demo

本文的主要貢獻如下:

- 調查了現有的多模態大型語言模型(MLLMs)通常依賴于 Transformer 網絡,這表現出二次方的計算復雜度。為了解決這種低效問題,本文引入了 Cobra,一個新穎的具有線性計算復雜度的 MLLM。

- 深入探討了各種模態融合方案,以優化 Mamba 語言模型中視覺和語言信息的整合。通過實驗,本文探索了不同融合策略的有效性,確定了產生最有效多模態表示的方法。

- 進行了廣泛的實驗,評估 Cobra 與旨在提高基礎 MLLM 計算效率的并行研究的性能。值得注意的是,Cobra 甚至在參數更少的情況下實現了與 LLaVA 相當的性能,突顯了其效率。

- 原文鏈接:https://arxiv.org/pdf/2403.14520v2.pdf

- 項目鏈接:https://sites.google.com/view/cobravlm/

- 論文標題:Cobra: Extending Mamba to Multi-Modal Large Language Model for Efficient Inference

方法介紹

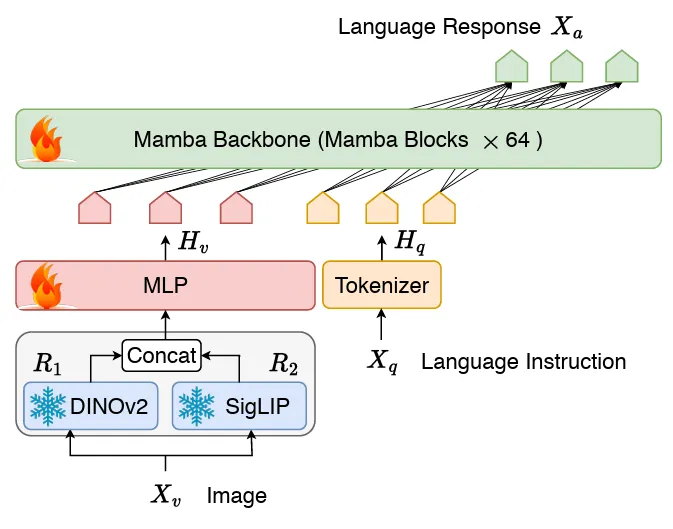

模型架構

Cobra 采用了經典的視覺編碼器、連接兩個模態的投影器和 LLM 語言主干組成的 VLM 結構。LLM 主干部分采用了 2.8B 參數預訓練的 Mamba 語言模型,該模型在 600B token 數量的 SlimPajama 數據集上進行了預訓練并經過了對話數據的指令微調。

圖 Cobra 網絡結構圖

與 LLaVA 等工作不同的是,Cobra 采用了 DINOv2 和 SigLIP 融合的視覺表征,通過將兩個視覺編碼器的輸出拼接在一起送入投影器,模型能夠更好的捕捉到 SigLIP 帶來的高層次的語義特征和 DINOv2 提取的低層次的細粒度圖像特征。

訓練方案

最近的研究表明,對于基于 LLaVA 的現有訓練范式(即,只訓練投影層的預對齊階段和 LLM 骨干的微調階段各一次),預對齊階段可能是不必要的,而且微調后的模型仍處于欠擬合狀態。因此,Cobra 舍棄了預對齊階段,直接對整個 LLM 語言主干和投影器進行微調。這個微調過程在一個組合數據集上隨機抽樣進行兩個周期,該數據集包括:

- 在 LLaVA v1.5 中使用的混合數據集,其中包含總計 655K 視覺多輪對話,包括學術 VQA 樣本,以及 LLaVA-Instruct 中的視覺指令調優數據和 ShareGPT 中的純文本指令調優數據。

- LVIS-Instruct-4V,其中包含 220K 張帶有視覺對齊和上下文感知指令的圖片,這些指令由 GPT-4V 生成。

- LRV-Instruct,這是一個包含 400K 視覺指令數據集,覆蓋了 16 個視覺語言任務,目的是減輕幻覺現象。

整個數據集大約包含 120 萬張圖片和相應的多輪對話數據,以及純文本對話數據。

實驗

定量實驗

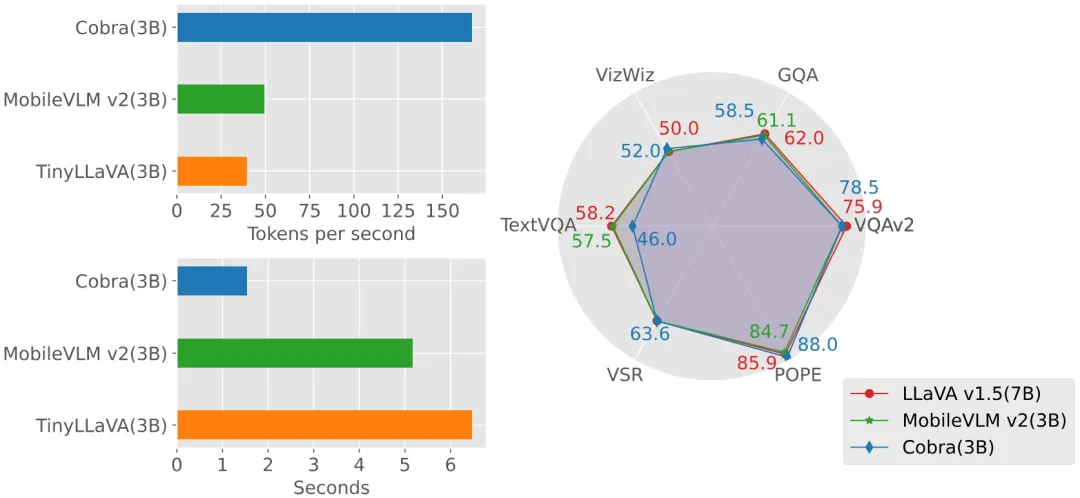

實驗部分,本文對提出的 Cobra 模型和開源的 SOTA VLM 模型在基礎 benchmark 上進行了比較,并對比了與同量級基于 Transformer 架構的 VLM 模型的回答速度。

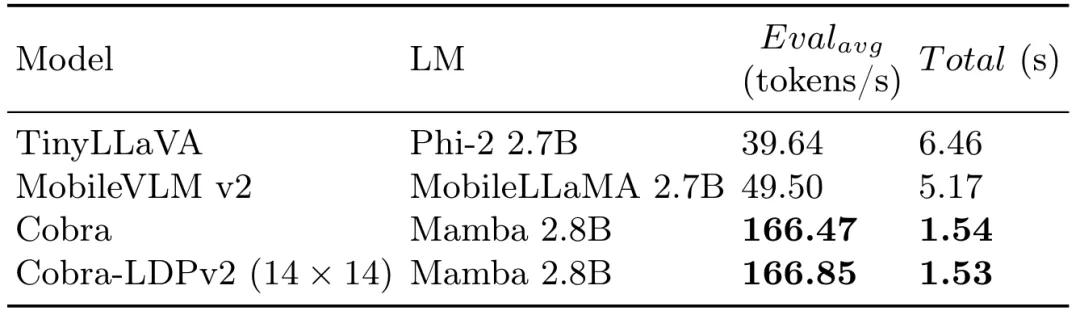

圖 生成速度和性能對比圖

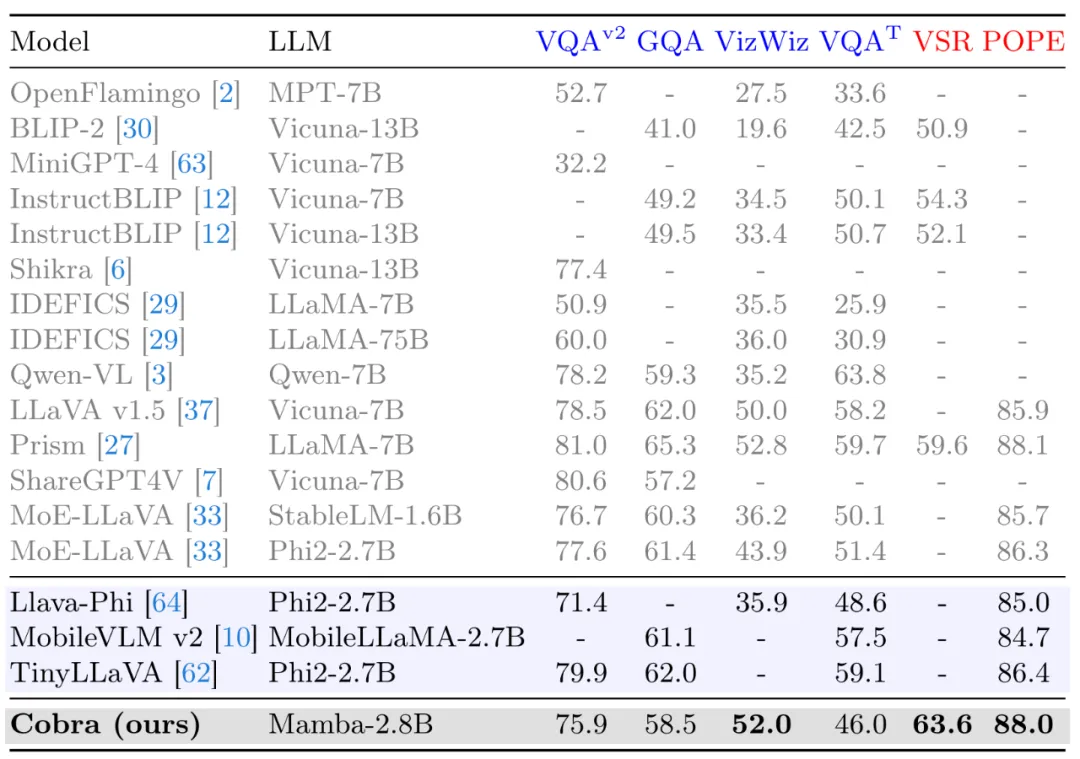

同時,Cobra 也與更多的模型在 VQA-v2,GQA,VizWiz,TextVQA 四個開放 VQA 任務以及 VSR,POPE 兩個閉集預測任務,共 6 個 benchmark 上進行了分數對比。

圖 在 Benchmark 上和其他開源模型的對比

定性試驗

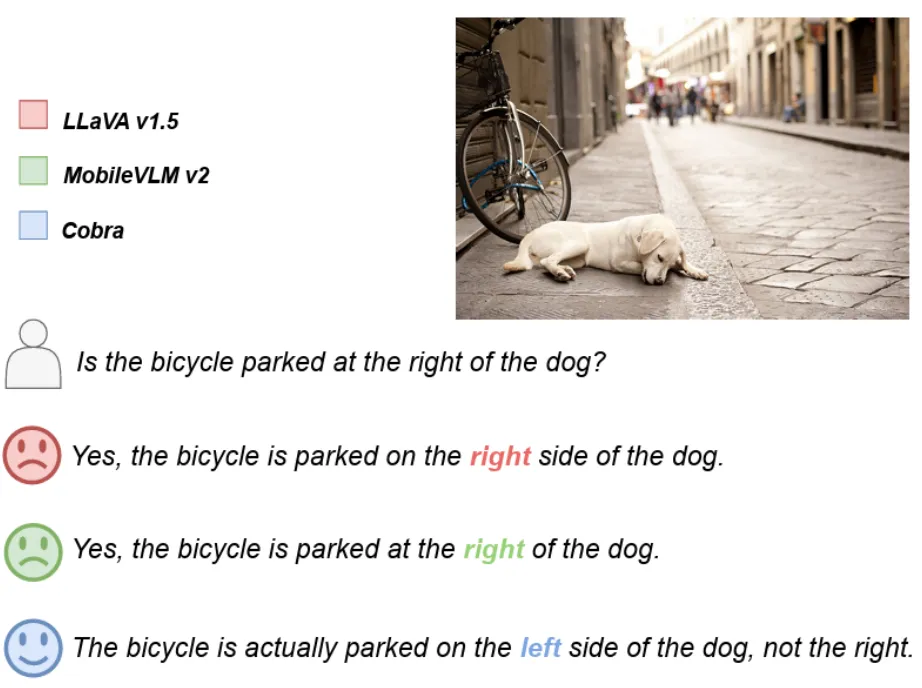

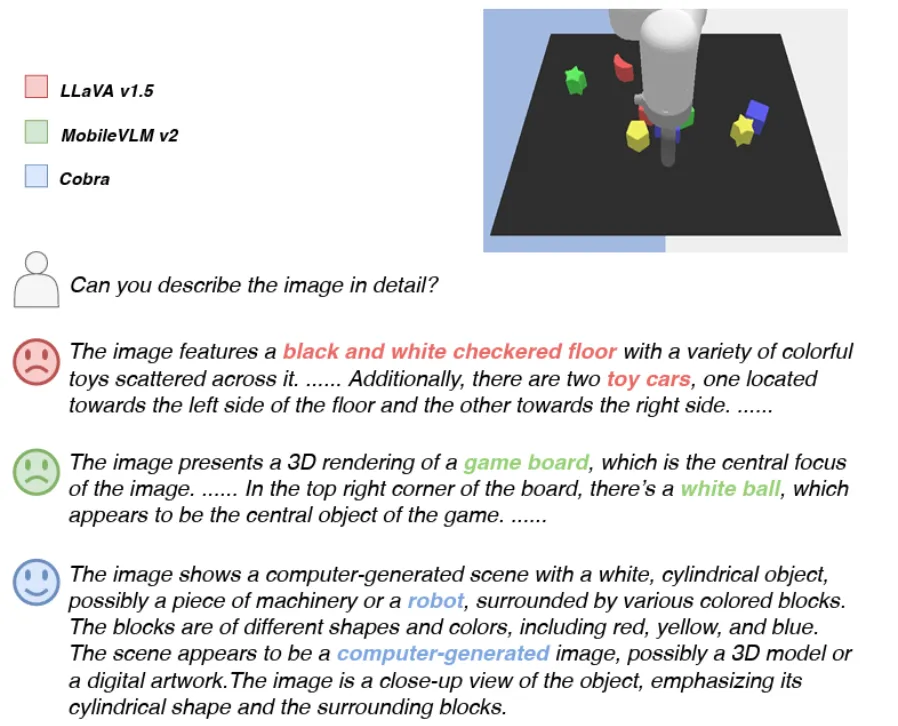

此外 Cobra 也給出了兩個 VQA 示例以定性說明 Cobra 在物體的空間關系認知和減輕模型幻覺兩個能力上的優越性。

圖 Cobra 和其他基線模型在物體空間關系判斷的示例

圖 Cobra 和其他基線模型在關于視覺錯覺現象的示例

在示例中,LLaVA v1.5 和 MobileVLM 均給出了錯誤答案,而 Cobra 則在兩個問題上都做出了準確的描述,尤其在第二個實例中,Cobra 準確的識別出了圖片是來自于機器人的仿真環境。

消融實驗

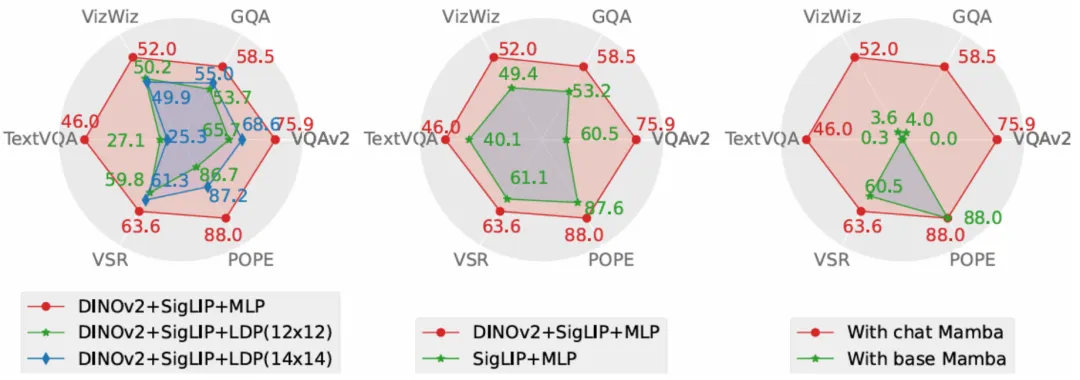

本文從性能和生成速度這兩個維度對 Cobra 采取的方案進行了消融研究。實驗方案分別對投影器、視覺編碼器、LLM 語言主干進行了消融實驗。

圖 消融實驗的性能對比圖

投影器部分的消融實驗結果顯示,本文采取的 MLP 投影器在效果上顯著優于致力于減少視覺 token 數量以提升運算速度的 LDP 模塊,同時,由于 Cobra 處理序列的速度和運算復雜度均優于 Transformer,在生成速度上 LDP 模塊并沒有明顯優勢,因此在 Mamba 類模型中使用通過犧牲精度減少視覺 token 數量的采樣器可能是不必要的。

圖 Cobra 和其他模型在生成速度上的數值對比

視覺編碼器部分的消融結果表明,DINOv2 特征的融合有效的提升了 Cobra 的性能。而在語言主干的實驗中,未經過指令微調的 Mamba 語言模型在開放問答的測試中完全無法給出合理的答案,而經過微調的 Mamba 語言模型則可以在各類任務上達到可觀的表現。

結論

本文提出了 Cobra,它解決了現有依賴于具有二次計算復雜度的 Transformer 網絡的多模態大型語言模型的效率瓶頸。本文探索了具有線性計算復雜度的語言模型與多模態輸入的結合。在融合視覺和語言信息方面,本文通過對不同模態融合方案的深入研究,成功優化了 Mamba 語言模型的內部信息整合,實現了更有效的多模態表征。實驗表明,Cobra 不僅顯著提高了計算效率,而且在性能上與先進模型如 LLaVA 相當,尤其在克服視覺幻覺和空間關系判斷方面表現出色。它甚至顯著減少了參數的數量。這為未來在需要高頻處理視覺信息的環境中部署高性能 AI 模型,如基于視覺的機器人反饋控制,開辟了新的可能性。

本文轉自 機器之心 ,作者:機器之心