量化成為時代標準!AI大神賈揚清銳評Llama3.1:很難盈利、成本巨高、速度卻馬馬虎虎 原創

編輯 | 言征

出品 | 51CTO技術棧(微信號:blog51cto)

不管開源還是閉源模型,最近量化小模型的風頭正在蓋過大模型!

就在Llama3.1昨天正式發布以后,市面上一片興奮:開源模型可以比肩GPT-4o,國內幾乎所有供應商紛紛宣布接入Llama3.1的同時,我們也看到了圈內人士另一種聲音:

“405B模型太大了”、“難以盈利、成本很高、速度一般。”

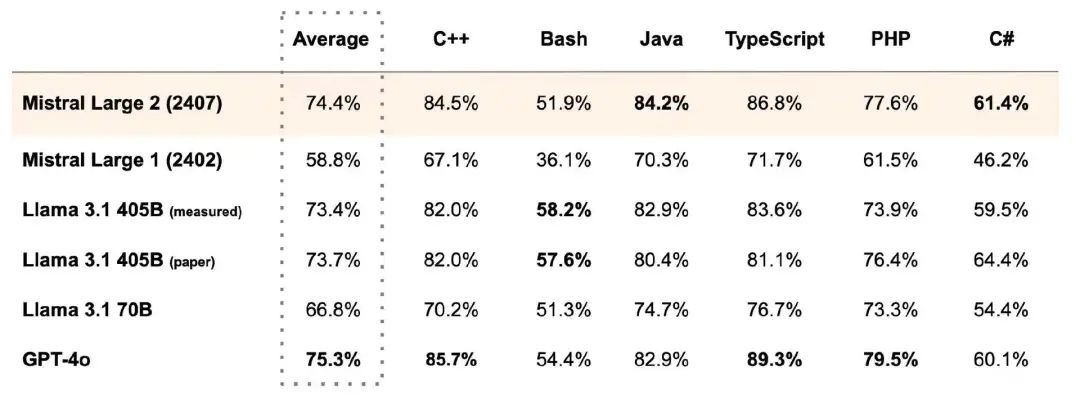

緊接著,素以小模型著稱的Mistral AI也再一次用實力證明:Llama3.1真沒必要那么“參數浪費”!

其今天剛剛發布的最新模型Mistral Large 2,參數只有123B,用不到三分之一的參數量性能就可以媲美Llama 3.1 405B,也不遜于GPT-4o、Claude 3 Opus等閉源模型。

這讓“大模型頂流er”們哪里說理去!

圖片

圖片

1.AI大神、博主:模型太大不會被采用!量化才是正解!

事實真相就是這樣。

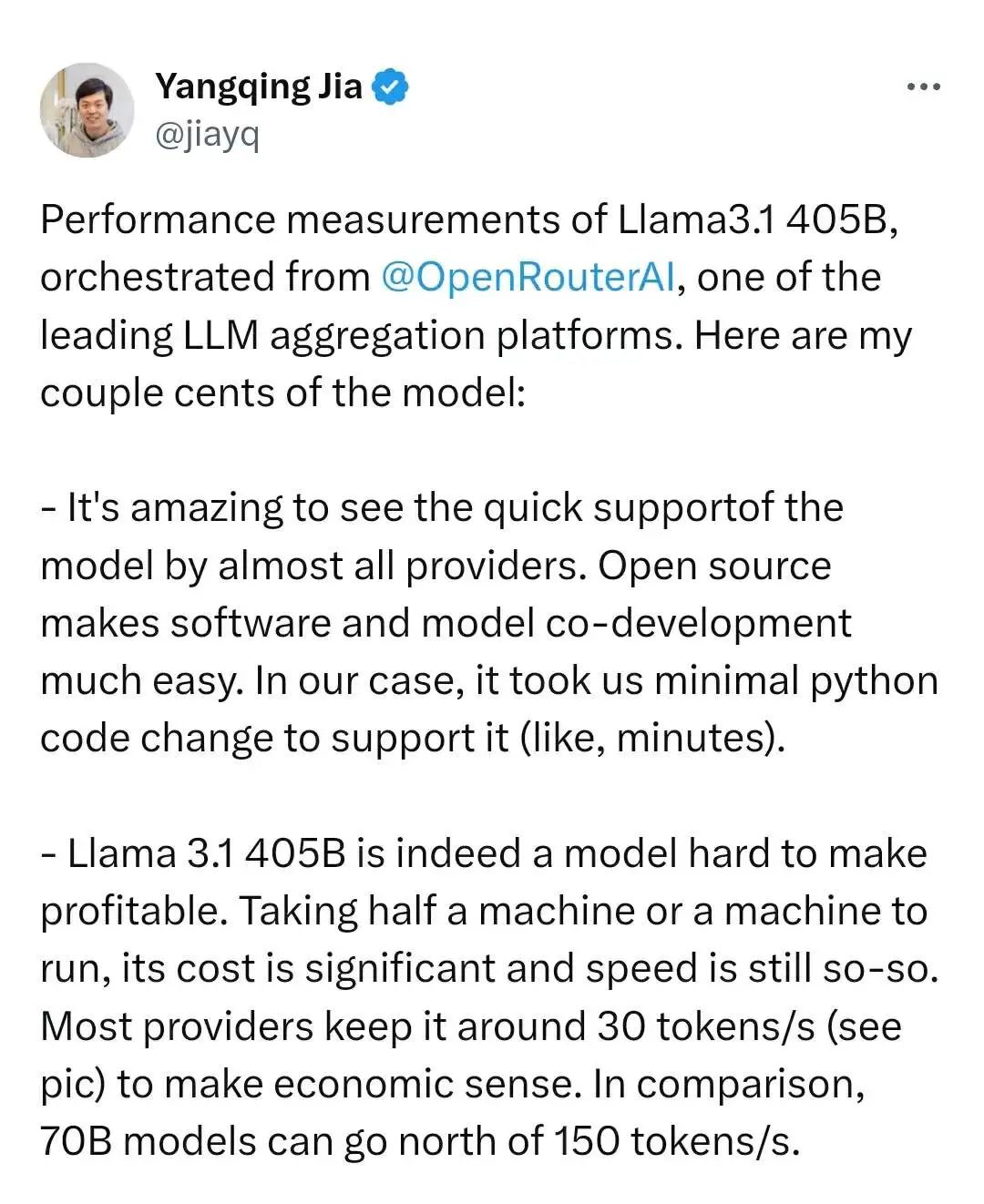

AI大神賈揚清今天發推文表示:Llama 3.1 405B 確實是一款難以盈利的機型。

如果你用一臺或半臺機器去運行Llama3.1 405B,就會發現成本significant(巨高),速度卻so-so(馬馬虎虎)。

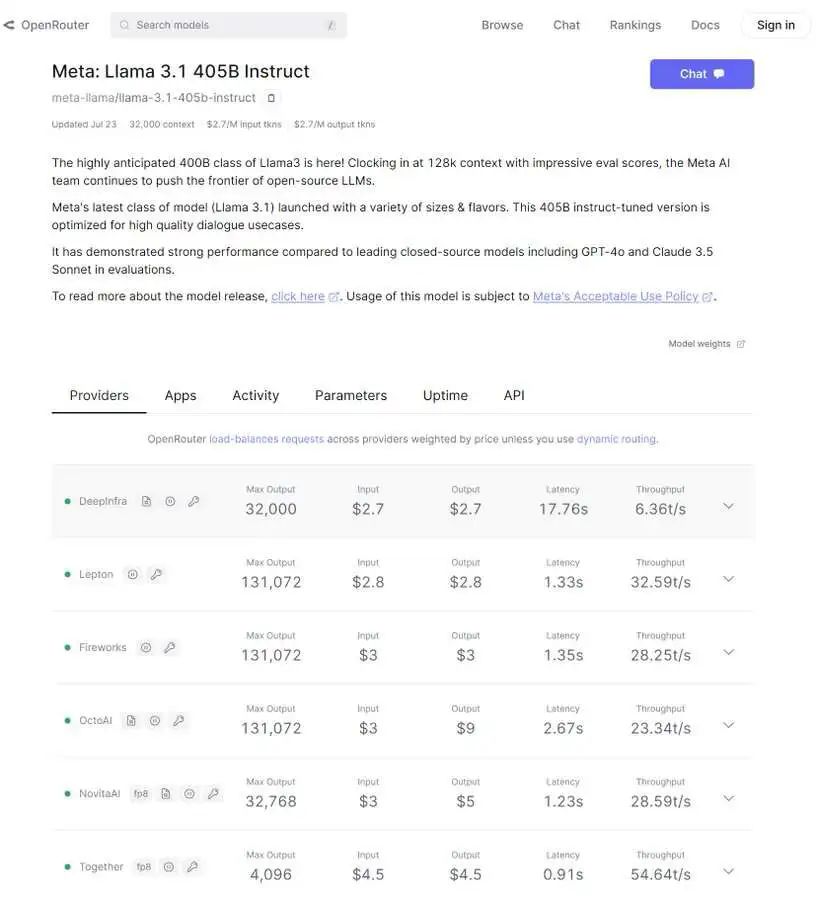

那好,既然自己運行太高,我調用云廠商的接口還不行嗎?

圖片

圖片

賈揚清又幫各位大模型愛好者們算了一筆賬,目前大多數供應商調用405B的定價保持在30個tokens/s左右,才能覆蓋住商業價值。對比來看,70B模型則更實惠多了,能達到150tokens/s以上。

圖片

圖片

不過賈揚清,表示即便405B的性價比不高,“但依然可以收支平衡,這取決于良好的優化和良好的工作量飽和度”,并同時提醒VC朋友們:“對于這個價格的純API服務,不要期望像傳統SaaS那樣獲得80%的利潤率。”

這還沒完,大神賈揚清最后下結論了:量化(模型)將成為標準! 忘掉FP16吧,Int8/FP8才是出路!PS:Int8/FP8是指更小的神經張量的數值類型,代表著大模型所需的空間資源和算力資源。

并給出了一定的量化建議:量化需要謹慎。一個尺度足以處理整個張量的時代一去不復返了,而是需要進行channel/group的量化,以保證質量不會下降。

同時,賈揚清還預測405B會因為速度和價格的原因,采用和接受度會受到持續的影響。當然也Cue到了Mistral Large 2(123B),非常期待業內的測試效果。

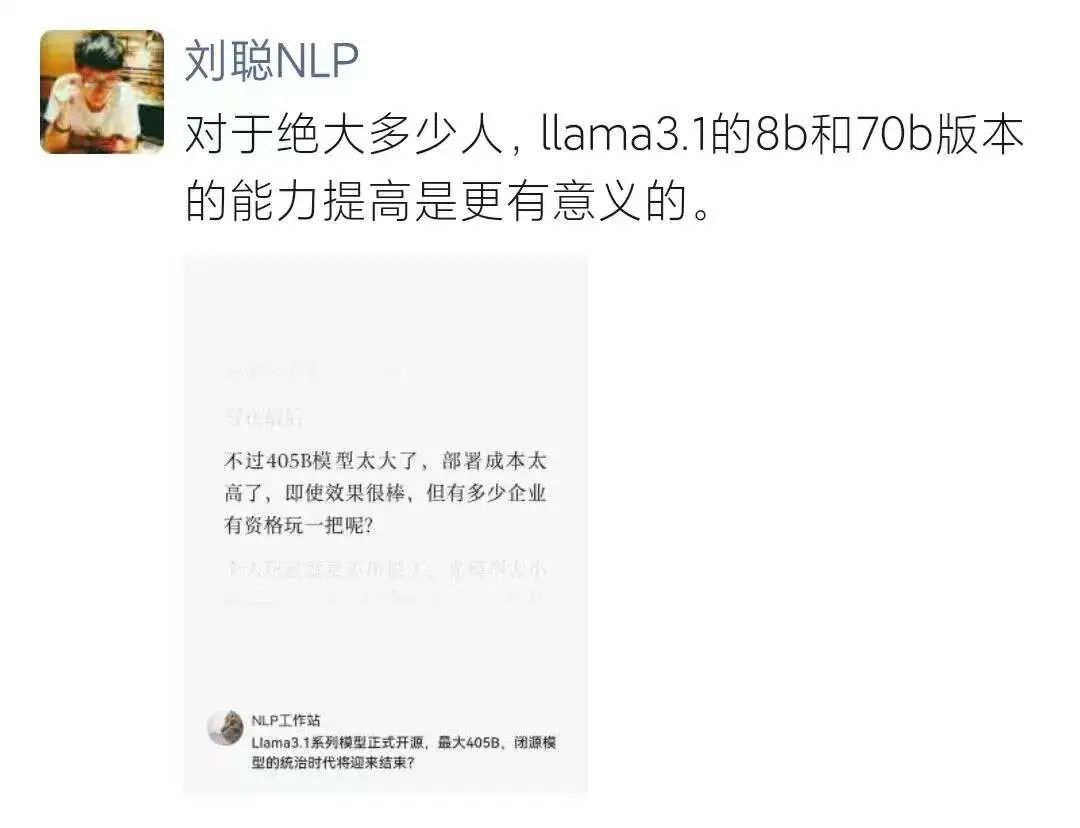

NLP博主“劉聰NLP”也表示對于Llama3.1的成本有一種無力感:對于絕大多數開發者,Llama3.1的8B和70B版本的能力的提高才更有意義。

圖片

圖片

劉聰指出:405B即使效果很棒,但是有多少企業有資格玩一把呢?個人玩家就更不用說了,光模型大小就820G,別說有沒有顯卡,也許都沒有820G磁盤空間下載都沒資格,太難了!

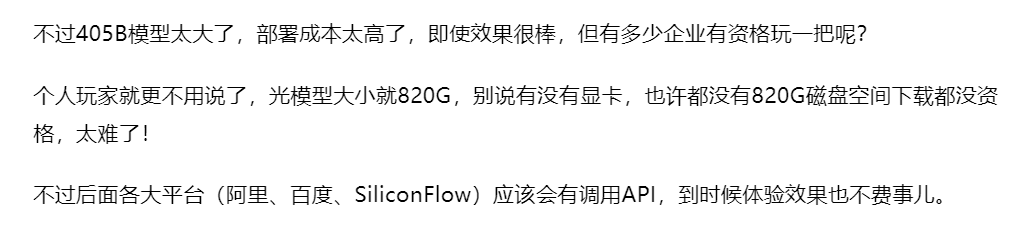

2.OpenAI也發現了這一點奧特曼不禁夸贊GPT-4o mini登頂

奧特曼也開始注意到mini模型更受開發者歡迎!

24日,就在Llama3.1讓市場興奮的同時,奧特曼一條推特讓mini掰回了一局。

“我們盡量不對任何一次評估感到太過興奮,但很高興看到GPT-4o mini 在 lmsys 上的性能如此接近GPT-4o,而價格僅為其二十分之一。”

圖片

圖片

開放研究組織lmsys,昨天放出了一個Chatbot競技場榜單更新,結果顯示:GPT-4o mini一躍排行榜榜首,與GPT-4o并列第一,但價格更便宜,只有后者的1/20!而且各項性能都要由于早期版本。

這個榜單通過4000+用戶的投票得到的,其中值得注意的是,在Hard Prompts和Coding Arena項中,GPT-4o mini依舊強悍。在數學任務上,GPT-4o mini也也跟turbo持平。

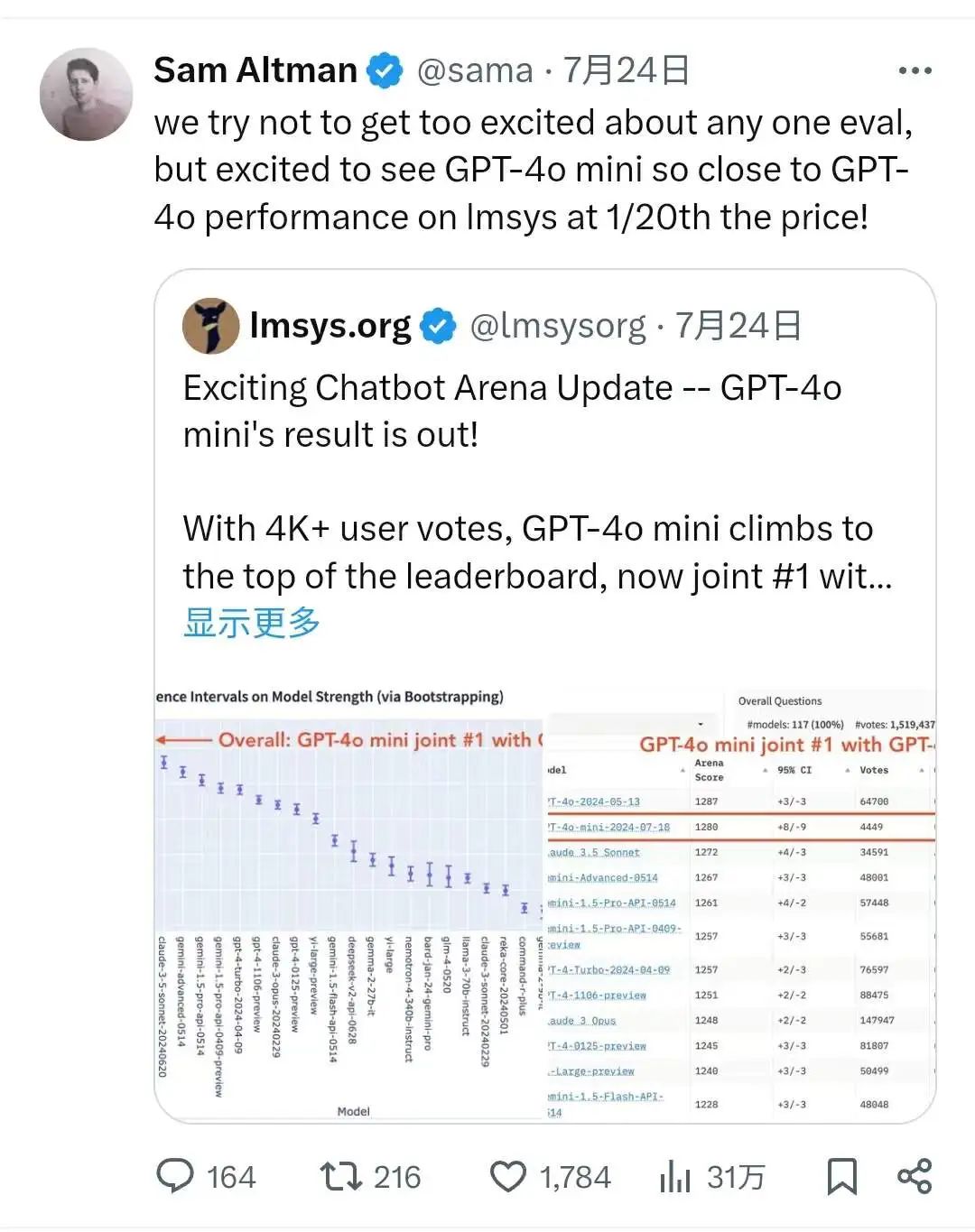

OpenAI創始成員 Karpathy在7月19日就曾發出一條推文表示:未來大模型的競爭態勢是:先變小之后才能變大!

圖片

圖片

總結一下,量化模型的時代已經來了!至于原因,小編認為有兩點:一、大模型側訓練所需的數據和算力已經出現了增長瓶頸,二、在盈利之前,絕大多數開發者難以負擔大參數規模的成本。

最后,為各位奉上更小參數的Mistral Large 2下載鏈接,諸位不妨體驗一把:

??https://huggingface.co/mistralai/Mistral-Large-Instruct-2407??

本文轉載自??51CTO技術棧???,作者:言征????