微軟開源Phi-3.5:支持手機、平板電腦,性能超Llama 3.1

微軟開源了最新Phi-3.5系列模型,共有mini指令微調、專家混合和視覺微調三種模型。

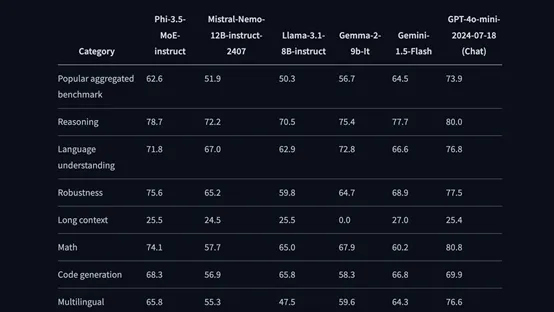

Phi-3.5系列的參數非常小,但性能卻超過了Meta最新開源的Llama 3.1 8B和Mistral 7B等知名開源模型,也是目前開源大模型排行榜中唯一入選前10名的小參數模型。

所以,微軟開源的Phi-3.5系列是專門面向那些算力、硬件有限的中小企業和個人開發者,同時可以部署在手機、平板電腦等移動設備中使用。

Mini開源地址:https://huggingface.co/microsoft/Phi-3.5-mini-instruct

專家混合:https://huggingface.co/microsoft/Phi-3.5-MoE-instruct

視覺:https://huggingface.co/microsoft/Phi-3.5-vision-instruct

微軟其他模型開源地址:https://huggingface.co/microsoft

Phi-3.5架構簡單介紹

Phi-3.5是2.0、3.0版本的延伸,使用的是Transformer解碼器,有3072維隱藏層、32個注意力頭以及32層架構。具有4K的默認上下文長度,并通過 LongRope擴展至128K,使得模型能夠處理更長的文本序列,支持中文、英文、法文等。

此外,還使用了組查詢注意力機制,每個注意力頭的KV緩存中使用4個查詢共享1個鍵。為了進一步提高訓練和推理速度,微軟使用了塊稀疏注意力模塊,能根據不同的稀疏模式有效地劃分上下文,減少KV緩存的使用量。

Phi-3.5之所以能夠實現如此出色的性能,主要原因之一是其使用了超過3.3萬億token高質量訓練數據集。這個數據集是 phi-2 使用的數據集的擴展版本,由經過嚴格篩選的公開網絡數據以及合成數據組成,在模型的預訓練過程中發揮了巨大作用。

在安全優化方面,使用了監督微調、近端策略優化和直接偏好優化等方法,使Phi-3.5的輸出更符合人類預期,極大減少非法、錯誤的內容輸出。

三款模型

Phi-3.5-mini指令微調模型支持128K上下文,能生成文本/代碼、數學推理、解讀長文檔、總結會議摘要等。在MMLU、MGSM、MEGA TyDi QA、MEGA XCOPA等測試基準中,整體性能超過Llama-3.1-8B、Mistral-7B。

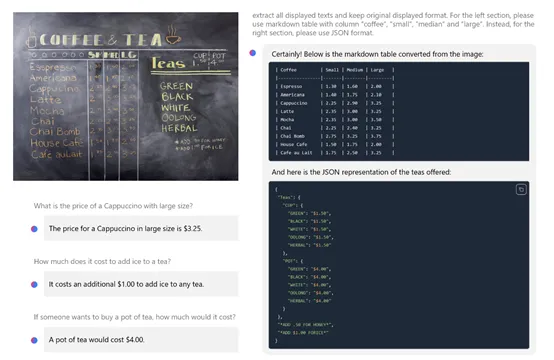

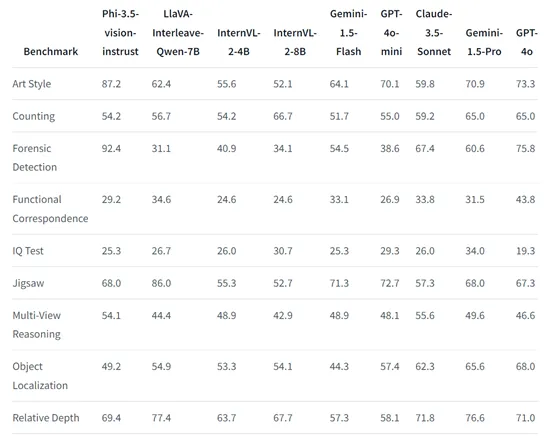

Phi-3.5視覺模型除了文本生成之外,還支持圖像識別、光學字符識別、圖表/表格解讀、圖像比較、剪輯視頻摘要等。

在Art Style、Counting、Forensic Detection、Jigsaw、Relative Depth、Visual Correspondence等視覺基準測試中,其性能超過了InternVL-2-4B/8B、GPT-4o-mini、Claude-3.5-Sonnet、Gemini-1.5-Flash等知名開閉源模型,僅次于GPT-4o。

Phi-3.5專家混合模型共有420億參數,但在推理的過程中只有66億參數處于激活狀態,其性能大幅度超過了同類開閉源模型,但對資源的消耗卻非常低。

而專家混合模型可以根據不同場景的復雜任務,調動切換不同的專家模塊來處理,進一步提升了對資源的合理分配。

專家混合模型之所以能夠實現這種效率和性能的平衡,源于其獨特的技術原理。在專家混合模型架構中,模型不是由單一的神經網絡構成,而是由多個小型網絡或專家組成。

每個專家負責處理其擅長的特定類型的任務。當模型接收到輸入數據時,會通過 “門控網絡”來決定哪些專家需要被激活,以及每個專家應該對最終的輸出貢獻多少。

專家混合模型的另一個技術優勢是其可擴展性。隨著開發人員對模型進行進一步的訓練和優化,可以輕松地增加更多的專家來提升模型在特定領域的表現,或者通過改進門控網絡來優化模型的決策過程。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區